O que é Robots.txt: definição, importância e exemplos

Publicados: 2022-07-14Você pode ter ouvido falar sobre o Google rastreando nosso site e as páginas na Internet e exibindo-as em sua página de resultados de pesquisa.

Bem, o robots.txt informa ao Google quais sites estão seguindo seus algoritmos e quais não estão. Neste guia, compartilhamos tudo o que você precisa saber sobre robots.txt, exemplos e como eles funcionam.

O que é Robots.txt?

Robots.txt é o arquivo de texto de um webmaster para orientar robôs da web (geralmente robôs de mecanismos de pesquisa) no rastreamento de páginas em seu domínio. Um arquivo robots.txt, em outras palavras, é um conjunto de instruções para bots.

Robots.txt estão incluídos no código-fonte da maioria dos sites.

O arquivo robots.txt faz parte do Robots Exclusion Protocol (REP). Ele define como os robôs rastreiam páginas da Web, encontram e indexam conteúdo e fornecem essas informações às pessoas que as desejam.

Robots.txt ajuda os bots de mecanismos de pesquisa a entender quais URLs eles devem rastrear em seu site.

Por que o Robots.txt é importante?

Existem basicamente três razões para que o how.txt possa ajudá-lo:

- Maximize o orçamento de rastreamento: o orçamento de rastreamento é o número de páginas que os bots do Google indexam em um período de tempo. Robots.txt pode ajudar a bloquear páginas de conteúdo sem importância ou duplicadas e focar apenas em páginas que são importantes para você, maximizando seu orçamento de rastreamento e aumentando a visibilidade.

- Evite indexação de recursos: Robots.txt pode indexar ou desindexar os recursos, como PDFs ou imagens. Assim, páginas noindex ou protegidas por senha podem ser usadas para bloquear as páginas ou recursos. Você pode verificar as páginas indexadas usando o console de pesquisa do Google e ver se os bots rastreiam as páginas que você deseja indexar.

- Bloquear páginas não importantes: existem algumas páginas em seu site que você não deseja exibir nos resultados de pesquisa do Google. Eles podem ser a página de login ou a versão de teste/teste do seu site. Usando o robots.txt, você pode bloquear essas páginas e focar apenas nas páginas que importam.

Exemplos de robots.txt

Alguns exemplos de robots.txt são:

Agente do usuário: Googlebot

Não permitir: /nogooglebot/

Agente de usuário: *

Permitir: /

Mapa do site: http://www.example.com/sitemap.xml

Da mesma forma, para o mecanismo de pesquisa do Bing, é assim:

Agente do usuário: Bingbot

Não permitir: /example-subfolder/blocked-page.html

A sintaxe ajuda o rastreador a evitar o rastreamento de uma determinada página.

Vale a pena notar que cada subdomínio precisa de seu próprio arquivo robots.txt.

Por exemplo, embora www.cloudflare.com tenha seu próprio arquivo, todos os subdomínios da Cloudflare (blog.cloudflare.com, community.cloudflare.com e assim por diante) também exigem seus próprios.

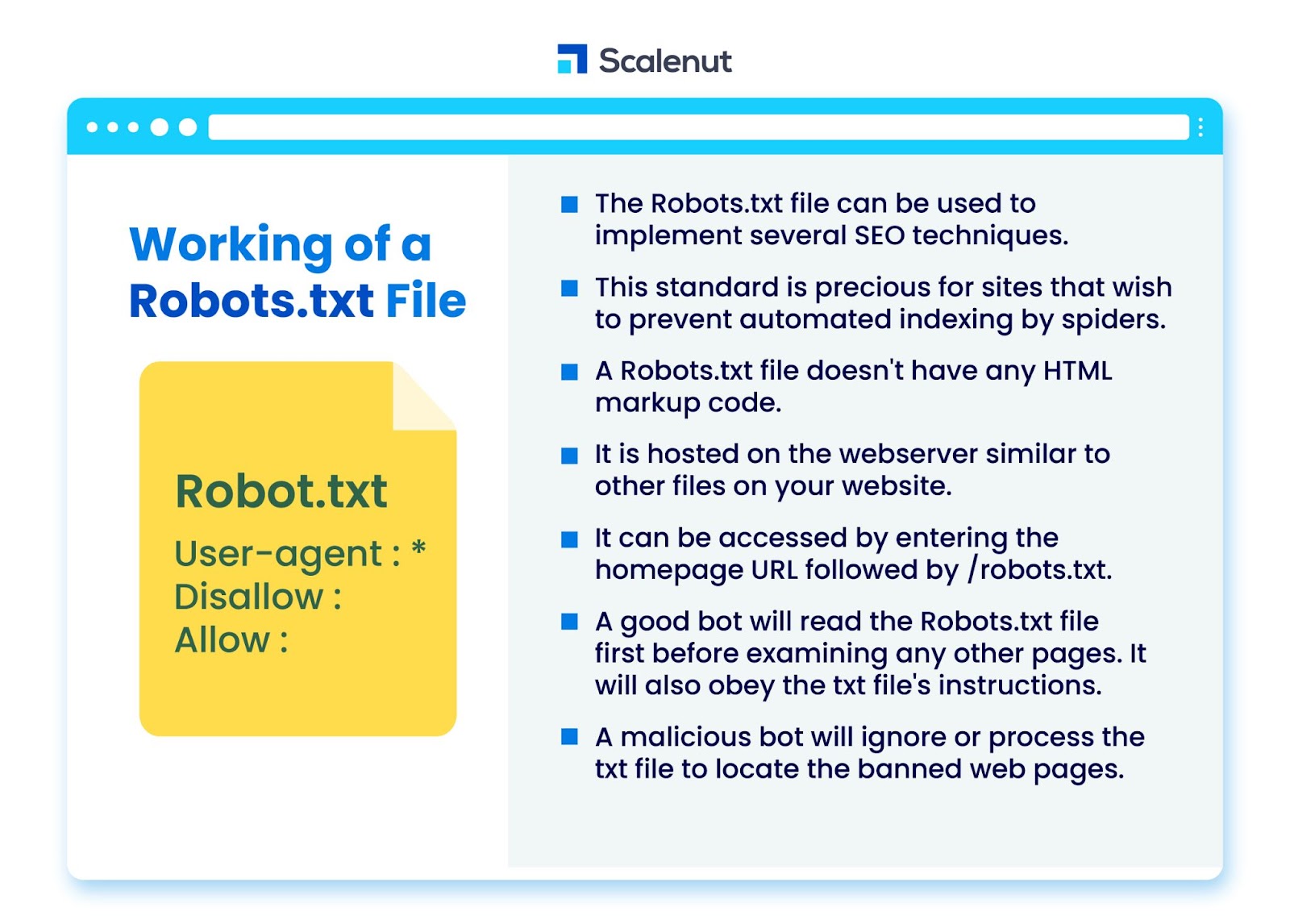

Como funciona um arquivo Robots.txt?

O arquivo robots.txt pode ser usado para implementar diversas técnicas de Search Engine Optimization (SEO), como páginas não indexadas ou robots txt que não permitem a totalidade ou partes específicas do site por programas bot.

O padrão é particularmente valioso para sites que desejam impedir que os spiders indexem seu conteúdo por meio de processos automatizados, como software de pesquisa e classificação de páginas usando rastreadores automáticos da web.

Um robots.txt é um arquivo sem código de marcação HTML. Ele está hospedado no servidor web, assim como outros arquivos em seu site.

Ele pode ser acessado digitando o URL da página inicial seguido por /robots.txt. Um exemplo geral é https://www.xyz.com/robots.txt.

Como o arquivo não está vinculado a nenhum outro lugar do site, é improvável que os visitantes o encontrem, mas a maioria dos bots rastreadores da Web o procurará antes de indexar o restante do site.

Um bom bot, como um rastreador do Google ou um bot de feed de notícias, lerá o arquivo robots.txt primeiro antes de examinar qualquer outra página em um site e obedecerá às instruções.

Um bot malicioso irá ignorar ou processar o arquivo robots.txt para encontrar as páginas da web banidas.

Bloqueio de Robots.txt

Robots.txt consiste em instruções para informar os robôs sobre quaisquer regras de bloqueio em um site pesquisável indexado pelo Googlebot, que se destinam a impedir que o rastreador acesse páginas com determinado conteúdo.

Ele não afeta usuários comuns ou bots que apenas navegam em sites sem rastreá-los.

Com o tempo, os sites bloquearam aplicativos móveis, JavaScript e outras partes do site usando esse método, mas ainda permitindo alguns elementos, como imagens.

Quais protocolos são usados em um arquivo Robots.txt?

Um protocolo é um formato para transmitir instruções ou ordens em rede. Os arquivos Robots.txt empregam uma variedade de protocolos. O protocolo principal é conhecido como Protocolo de Exclusão de Robôs.

Ele instrui os bots sobre quais sites e recursos devem ser evitados.

O protocolo de sitemaps é outro protocolo usado para arquivos robots.txt. Isso pode ser pensado como um protocolo para inclusão de robôs.

Os Sitemaps informam aos rastreadores da Web sobre quais páginas eles podem acessar. Isso ajuda a garantir que um bot rastreador não ignore nenhuma página crucial.

O que é Mapa do Site?

O mapa do site é um arquivo XML que descreve as informações usadas pelos rastreadores da Web para exibir as páginas do seu site. O mapa do site lista todos os URLs do seu site, incluindo seus títulos e descrições e outras informações relacionadas.

Este documento ajuda os mecanismos de pesquisa a indexar esses itens corretamente para que os visitantes possam encontrá-los rapidamente usando mecanismos de pesquisa ou outros sistemas de navegação.

O que é um User Agent?

User-agent user-agent: *disallow: /nogooglebot/ user-agent user-agent: Googlebot

Não permita todas as regras do robots.txt, independentemente do agente do usuário. Isso impedirá que qualquer rastreador da Web acesse seu site. Isso é usado com mais frequência por sites sensíveis a questões de privacidade (e, portanto, não desejam que os dados de seus usuários sejam expostos).

Os nomes comuns de agente de usuário de bot de mecanismo de pesquisa incluem:

Google :

- Googlebot

- Googlebot-Image (para imagens)

- Googlebot-News (para notícias)

- Googlebot-Video (para vídeo)

Bing:

- Bingbot

- MSNBot-Media (para imagens e vídeo)

Baidu:

- Baiduspider

O que é um arquivo .txt?

TXT é uma extensão de arquivo de texto suportada por muitos editores de texto.

Não existe essa definição estática de um arquivo de texto, embora existam vários formatos populares, incluindo ASCII (um formato multiplataforma) e ANSI (usado em plataformas DOS e Windows). TXT é uma abreviação de TeXT. Text/plain é o tipo MIME.

No arquivo de texto robots.txt, cada regra especifica um padrão de URLs que podem ser acessados por todos os rastreadores ou apenas por rastreadores especificados.

Cada linha deve começar com dois pontos (:) e conter de 1 a 3 linhas, ignorando as linhas em branco. Cada linha é interpretada como um nome de arquivo, que pode ser absoluto ou relativo ao diretório em que se encontra.

Robôs da Web são o mesmo que Robots.txt?

Alguns mecanismos de pesquisa podem não suportar diretivas txt.

As instruções nos arquivos robots.txt não podem obrigar os rastreadores a visitar seu site; cabe ao rastreador segui-los. Por outro lado, o Googlebot e outros rastreadores da Web conhecidos seguem as regras em um arquivo robots.txt.

Como implementar Robots.txt?

Um arquivo robots.txt pode ser implementado em praticamente qualquer editor de texto. Notepad, TextEdit, vi e emacs, por exemplo, podem gerar arquivos robots.txt legítimos.

A seguir estão as regras para seguir o robots.txt:

- O nome do arquivo deve ser robots.txt.

- Um arquivo robots.txt pode ser usado para restringir o acesso a subdomínios (por exemplo, https://website.example.com/robots.txt) ou portas não padrão.

- Um arquivo robots.txt deve estar no formato UTF-8 (que inclui ASCII). O Google pode rejeitar caracteres que não estejam no intervalo UTF-8, potencialmente invalidando os regulamentos do robots.txt.

- O arquivo robots.txt geralmente é encontrado no diretório raiz do host do site ao qual é aplicado. Para habilitar o rastreamento em todos os URLs como este- https://www.example.com/, o arquivo robots.txt deve ser encontrado em https://www.example.com/robots.txt. Ele não pode ser colocado em um subdiretório (por exemplo, https://example.com/pages/robots.txt).

Limitações de um arquivo Robots.txt

Aqui estão as limitações do arquivo robots.txt:

- Todos os mecanismos de pesquisa não suportam Robots.txt: os arquivos Robots.txt não podem obrigar os rastreadores a visitar seu site; cabe ao rastreador segui-los. Embora o Googlebot e outros rastreadores da Web confiáveis sigam as instruções em um arquivo robots.txt, outros rastreadores não.

- Diferentes rastreadores interpretam a sintaxe de maneira diferente: embora os web spiders respeitáveis sigam as diretivas em um arquivo robots.txt, cada rastreador pode interpretar as diretivas de maneira diferente.

- Uma página não permitida pode ser indexada se estiver vinculada a outras páginas: embora o Google não rastreie ou indexe o conteúdo que um arquivo robots.txt restringiu, ele pode encontrar e indexar um URL não permitido se estiver vinculado a partir de outros locais na Internet.

Como resultado, o endereço de URL e talvez outras informações publicamente disponíveis, como texto âncora em links para a página, ainda podem aparecer nos resultados de pesquisa do Google.

Perguntas frequentes

Q1. Onde o robots.txt vai em um site?

Resposta: Um arquivo robots.txt normalmente é colocado no diretório raiz do seu site, mas pode estar em qualquer lugar do site ao qual você deseja restringir o acesso.

Q2. É necessário um arquivo robots.txt?

Resposta: A resposta curta é não. Um arquivo robots.txt não é necessário para um site. Se um bot visitar seu site e não tiver um arquivo robots.txt, ele rastreará e indexará as páginas como faria normalmente. O arquivo .txt só é necessário se você quiser ter mais controle sobre o que é rastreado.

Q3. O robots.txt é seguro?

Resposta: O arquivo robots.txt não é um risco de segurança por si só, e seu uso adequado pode representar uma boa prática por motivos não relacionados à segurança. Você não deve esperar que todos os robôs da web sigam as instruções no arquivo.

Q4. É ilegal acessar robots.txt?

Resposta: Um arquivo robots.txt é uma licença implícita pelo proprietário do site. Se você estiver ciente do arquivo robots.txt, continuar a raspar o site sem permissão pode ser visto como acesso não autorizado ou invasão.

Q5. O que é o atraso de rastreamento no robots txt?

Resposta: A diretiva de atraso de rastreamento é uma maneira de dizer aos rastreadores para diminuir a velocidade para que o servidor da Web não fique sobrecarregado.

Conclusão

Robots.txt é um arquivo simples que tem muito poder. Se você souber como usá-lo bem, pode ajudar o SEO. Criar o tipo certo de robots.txt significa que você está melhorando seu SEO e a experiência do usuário também.

Os bots poderão apresentar seu conteúdo nas SERPs da maneira que você deseja que seja visto, se você permitir que eles rastreiem as coisas corretas.

Se você estiver disposto a aprender mais sobre SEO e fatores importantes, confira muitos outros blogs do Scalenut.