A ascensão da pesquisa multimodal e multilíngue

Publicados: 2022-01-06Estender a pesquisa além das consultas textuais e remover as barreiras linguísticas são tendências recentes que moldam o futuro dos mecanismos de pesquisa. Com novos recursos alimentados por IA, os mecanismos de pesquisa buscam promover uma melhor experiência de pesquisa e, ao mesmo tempo, trazer novas ferramentas para ajudar os usuários a recuperar informações específicas. Neste artigo, abordaremos o tema emergente dos sistemas de busca multimodais e multilíngues . Também mostraremos os resultados de uma ferramenta de pesquisa de demonstração que construímos no Wordlift.

A próxima geração de motores de busca

Uma boa experiência do usuário abrange vários aspectos de interação entre usuários e mecanismos de pesquisa. Desde o design da interface do usuário e sua usabilidade até o entendimento da intenção de pesquisa e resolução de suas consultas ambíguas, os grandes motores de busca estão preparando a próxima geração de ferramentas de busca .

Pesquisa multimodal

Uma maneira de descrever um mecanismo de busca multimodal é pensar em um sistema capaz de lidar com texto e imagens em uma única consulta . Esses mecanismos de pesquisa permitiriam que os usuários expressassem suas consultas de entrada por meio de uma interface de pesquisa multimodal e, como resultado, permitiriam uma experiência de pesquisa mais natural e intuitiva.

Em um site de comércio eletrônico, um mecanismo de busca multimodal permitiria a recuperação de documentos relevantes de um banco de dados indexado. A relevância é avaliada medindo a semelhança dos produtos disponíveis com uma determinada consulta em mais de um formato, como texto, imagem, áudio ou vídeo. Como resultado, esse mecanismo de busca é um sistema multimodal, pois seus mecanismos subjacentes são capazes de lidar com diferentes modais de entrada, ou seja, formatos, ao mesmo tempo.

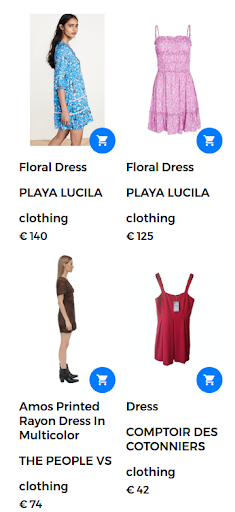

Por exemplo, uma consulta de pesquisa pode assumir a forma de “vestido floral”. Nesse caso, um grande número de vestidos florais está disponível na loja virtual. No entanto, o mecanismo de pesquisa retorna vestidos que não são realmente satisfatórios para o usuário, conforme mostrado na figura a seguir.

Resultados retornados para a consulta “vestido floral”.

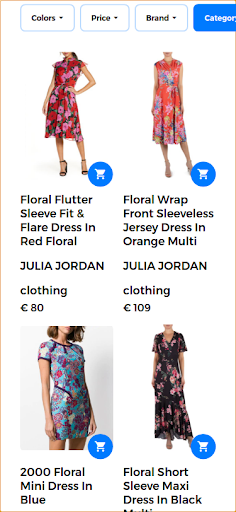

Para fornecer uma boa experiência de pesquisa e retornar resultados altamente relevantes, um mecanismo de pesquisa multimodal é capaz de combinar um texto e uma imagem em uma única consulta . Neste caso, o usuário fornece a imagem de amostra do produto desejado. Ao executar esta pesquisa como uma pesquisa multimodal, a imagem de entrada é um vestido floral que é mostrado na imagem a seguir.

Imagem fornecida pelo usuário para a consulta multimodal.

Nesse cenário, a primeira parte da consulta permanece a mesma (vestido floral) e a segunda parte adiciona o aspecto visual à consulta multimodal. Os resultados retornados geram vestidos semelhantes ao vestido floral que o usuário forneceu. Nesse caso de uso, exatamente o mesmo vestido está disponível e, portanto, é o primeiro resultado retornado junto com outros vestidos semelhantes.

Resultados de pesquisa relevantes retornados em resposta à consulta multimodal.

MÃE

O Google introduziu uma nova tecnologia para ajudar os usuários com tarefas de pesquisa complexas. Essa nova tecnologia, chamada MUM, significa Multitask Unified Model e é capaz de quebrar as barreiras linguísticas e interpretar informações em diferentes formatos de conteúdo , como páginas da web e imagens.

O Google Lens é um dos primeiros produtos a aproveitar a vantagem de combinar imagens e texto em uma única consulta. Em um contexto de pesquisa, o MUM tornaria mais fácil para os usuários encontrar padrões como um padrão floral específico em uma imagem fornecida pelo usuário.

O MUM é um novo marco de IA para entender as informações apresentadas aqui:

“Embora estejamos nos primeiros dias de exploração do MUM, é um marco importante em direção a um futuro em que o Google possa entender todas as diferentes maneiras pelas quais as pessoas naturalmente se comunicam e interpretam as informações.”

Para saber mais sobre a pesquisa multimodal MUM do Google, confira esta história na web:

Estendendo a pesquisa entre idiomas

Embora a imagem seja independente de idioma, os termos de pesquisa são específicos do idioma. A tarefa de projetar um sistema multilíngue se resume a construir modelos de linguagem em uma ampla variedade de idiomas.

Pesquisa multilíngue

Uma limitação importante dos sistemas de pesquisa atuais é que eles recuperam documentos escritos ou anotados no idioma em que o usuário escreveu a consulta de pesquisa. Em geral, esses mecanismos são somente em inglês. Esses mecanismos de pesquisa monolíngues limitam a utilidade desses sistemas para encontrar informações úteis escritas em um idioma diferente.

Por outro lado, os sistemas multilíngues aceitam uma consulta em um idioma e recuperam documentos indexados em outros idiomas. Na realidade, um sistema de pesquisa é multilíngue se for capaz de recuperar documentos relevantes do banco de dados combinando o conteúdo do documento, ou legendas, escritas em um idioma com a consulta de texto em outro idioma. As técnicas de correspondência variam de mecanismos sintáticos a abordagens de busca semântica.

O emparelhamento de frases em diferentes idiomas com conceitos visuais é um primeiro passo para promover o uso de modelos de linguagem de visão multilíngue . A boa notícia é que os conceitos visuais são interpretados quase da mesma maneira por todos os humanos. Esses sistemas, capazes de incorporar informações de mais de uma fonte e em mais de um idioma, são chamados de sistemas multimodais multilíngues . No entanto, emparelhar imagem-texto nem sempre é viável para todos os idiomas em grande escala, conforme discutido na seção a seguir.

[Estudo de caso] Impulsionando o crescimento em novos mercados com SEO na página

Da MÃE ao MURAL

Há esforços crescentes para aplicar técnicas avançadas de aprendizado profundo e processamento de linguagem natural aos mecanismos de pesquisa. O Google apresentou um novo trabalho de pesquisa que permite aos usuários expressar palavras usando imagens. Por exemplo, a palavra “valiha” refere-se a um instrumento feito de cítara de tubo e é tocado pelo povo malgaxe. Esta palavra não tem uma tradução direta para a maioria dos idiomas, mas pode ser facilmente descrita usando imagens.

O novo sistema, chamado MURA, significa Multimodal, Multi-task Retrieval Across Languages. Permite abordar o problema de palavras em um idioma que podem não ter uma tradução direta para um idioma de destino. Com esses problemas, muitos modelos multilíngues pré-treinados não conseguiriam encontrar palavras semanticamente relacionadas ou traduzir palavras com precisão de ou para um idioma com poucos recursos. Na verdade, o MURAL pode resolver muitos problemas do mundo real:

- Palavras que transmitem diferentes significados mentais em diferentes idiomas: Um exemplo é a palavra “casamento” em inglês e hindi que transmite diferentes imagens mentais, conforme mostrado na imagem a seguir do blog do Google.

- Escassez de dados para idiomas com poucos recursos na web: 90% dos pares de texto-imagem na web pertencem aos 10 principais idiomas com muitos recursos.

As imagens são retiradas da wikipedia, creditadas a Psoni2402 (esquerda) e David McCandless (direita) com licença CC BY-SA 4.0.

Reduzir a ambiguidade das consultas e fornecer uma solução para o problema da escassez de pares imagem-texto para idiomas com poucos recursos é outra melhoria em direção à próxima geração de mecanismos de pesquisa alimentados por IA.

Pesquisa multilíngue e multimodal em ação

Neste trabalho, usamos ferramentas existentes e modelos de linguagem e visão disponíveis para projetar um sistema multimodal multilíngue que vai além de um único idioma e pode lidar com mais de uma modalidade ao mesmo tempo .

Em primeiro lugar, para projetar um sistema multilíngue é importante conectar semanticamente palavras que vêm de diferentes idiomas. Em segundo lugar, para tornar o sistema multimodal, é necessário relacionar a representação das linguagens às imagens. Como resultado, este é um grande passo em direção ao objetivo de longa data de uma busca multimodal multilíngue.

O contexto

O principal caso de uso deste sistema multilíngue multimodal é retornar imagens relevantes do conjunto de dados dada uma consulta combinando uma imagem e um texto ao mesmo tempo. Nesse sentido, mostraremos alguns exemplos que ilustram vários cenários multimodais e multilíngues.

A espinha dorsal deste aplicativo de demonstração é alimentada por Jina AI, um ecossistema de pesquisa neural de código aberto. A busca neural, alimentada pela recuperação de informações de redes neurais profundas (ou IR neural), é uma solução atraente para a construção de um sistema multimodal. Nesta demonstração, usamos a arquitetura MPNet Transformer da Hugging Face, multilíngue-mpnet-base-v2, para processar descrições textuais e legendas. Quanto à parte visual utilizamos MobileNetV2.

A seguir, apresentamos uma série de testes para mostrar o poder dos mecanismos de busca multilíngue e multimodal . Antes de apresentar os resultados da nossa ferramenta de demonstração, aqui está uma lista dos principais elementos que descrevem esses testes:

- O banco de dados consiste em 1k imagens que retratam pessoas tocando música. Essas imagens são tiradas do conjunto de dados público Flickr30K.

- Cada imagem tem uma legenda escrita em inglês.

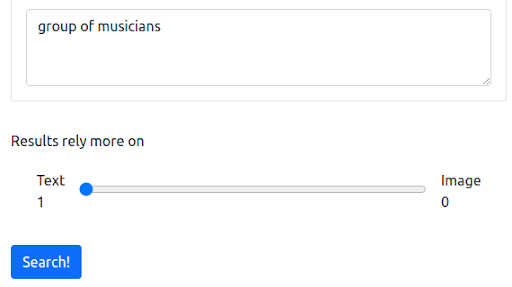

Etapa 1: começando com uma consulta textual em inglês

Primeiro, começamos com uma consulta textual que reflete a maneira atual em que a maioria dos mecanismos de pesquisa opera. A consulta é “grupo de músicos”.

A pergunta

Os resultados

Nosso mecanismo de pesquisa de demonstração baseado em Jina retorna imagens de músicos semanticamente relacionados à consulta de entrada. No entanto, este pode não ser o tipo de músicos que queremos.

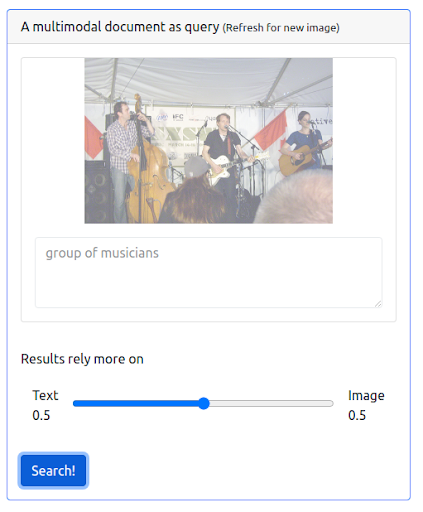

Etapa 2: adicionar multimodalidade

Vamos agora adicionar alguma multimodalidade emitindo uma consulta que combina a consulta textual anterior e uma imagem. A imagem representa uma representação mais precisa dos músicos que estamos procurando.

Em primeiro lugar, a interface do usuário precisa dar suporte à emissão desses tipos de consultas. Em seguida, temos que atribuir um peso para equilibrar a importância de cada modalidade na recuperação dos resultados. Nesse caso, tanto o texto quanto a imagem têm o mesmo peso (0,5). Como podemos ver abaixo, os novos resultados da pesquisa incluem várias imagens visualmente semelhantes à consulta de imagem de entrada.

A pergunta

Os resultados

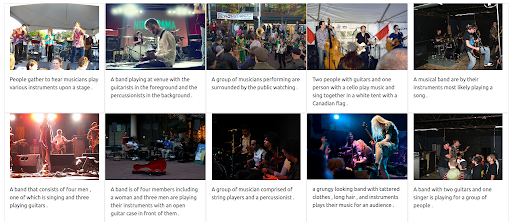

Etapa 3: atribuir um peso máximo à imagem

Também é possível dar um peso máximo à imagem. Isso excluiria o texto de entrada da consulta. Nesse caso, mais imagens visualmente semelhantes à imagem de entrada são retornadas e classificadas nas primeiras posições. Uma coisa a ter em mente é que os resultados são limitados às imagens disponíveis no conjunto de dados.

A pergunta

Os resultados

Etapa 4: testar a pesquisa multilíngue

Agora vamos tentar emitir a mesma consulta, mas usando linguagens diferentes. O peso do texto é maximizado para ilustrar todo o poder deste sistema multilíngue. Lembre-se de que as legendas das imagens estão apenas em inglês. A pesquisa é repetida para cobrir os seguintes idiomas:

- Francês: Groupe de musiciens

- Italiano: Gruppo di musicisti

- Alemão: Gruppe von Musikern

Independentemente do idioma da consulta de entrada, os resultados retornados são relevantes e consistentes nos três idiomas. Os resultados são mostrados abaixo.

Os resultados da consulta em francês

Os resultados da consulta em italiano

Os resultados da consulta em alemão

O futuro multimodal multilíngue da pesquisa

Nos próximos anos, a inteligência artificial transformará cada vez mais a pesquisa e desbloqueará maneiras inteiramente novas para as pessoas expressarem suas consultas e explorarem informações. Como o Google já anunciou, entender as informações com o MUM representa um marco da IA. Mais sistemas baseados em IA no futuro incluirão recursos e melhorias que vão desde fornecer uma melhor experiência de pesquisa até responder a perguntas sofisticadas e quebrar barreiras de idioma até combinar diferentes modos de pesquisa em uma única consulta.