7 etapas-chave para aprender e melhorar com os resultados do seu teste A/B

Publicados: 2021-04-13

Seu teste A/B acabou de terminar, mas você não está vendo os resultados esperados.

Todos os outros estão compartilhando estudos de caso em que viram um grande aumento com apenas uma mudança na cor do botão ou um pequeno ajuste, mas seu teste não obteve nenhuma melhoria na conversão ou, pior, parece ter perdido dinheiro, e agora você precisa apresente isso ao seu chefe.

Bem, e se o seu teste não for realmente um perdedor?

E se for um vencedor disfarçado?

E se for um perdedor, e se um teste perdedor for realmente uma coisa boa?

Neste guia, vamos ajudá-lo a ter uma perspectiva mais profunda dos resultados do seu teste A/B para que você possa analisá-los e dividi-los para encontrar o ouro.

Abordaremos por que aprender com seus testes A/B é tão importante e por que os perdedores podem gerar vendas. Compartilhamos um processo que você pode seguir para analisar completamente seus testes passo a passo e se sentir confiante sobre o que está vendo, ganhando ou falhando.

Melhor ainda, vamos ajudá-lo a passar da ansiedade de dados e não querer verificar suas análises, para a confiança em compartilhar seus resultados com seus colegas.

Então vamos mergulhar…

Por que você precisa aprender com os testes A/B?

Para começar, há o custo óbvio envolvido. Cada teste custa dinheiro para configurar. Se você tiver variantes perdedoras, também verá uma queda nas vendas dessa variante.

Aqui está a coisa:

O teste A/B (e CRO em geral) não é apenas para ganhar mais dinheiro. Trata-se de comprar dados . Os dados sobre seu público podem ajudar você a entendê-los melhor e fornecer um produto e serviço melhores. Isso leva a mais vendas e uma melhor experiência do cliente, e até mesmo insights sobre novas ofertas de produtos.

Quanto mais você aprende sobre as pessoas a quem serve, melhor você se sai. É por isso que é tão importante testar e testar com frequência — mesmo quando a maioria dos testes falha.

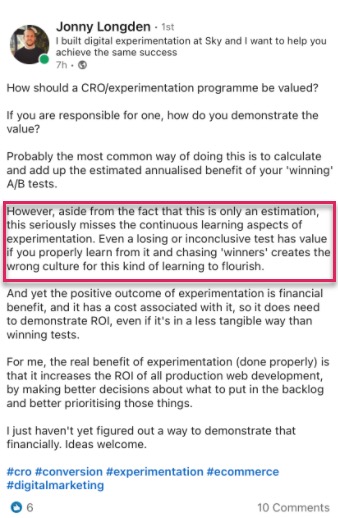

Também não estamos sozinhos nesse pensamento.

Na verdade, quando analisamos nossos dados internos de 28.304 testes com nossa ferramenta, juntamente com conversas com agências de testes especializadas, descobrimos que a maioria das empresas encontra apenas 1 vencedor em cada 10 testes, enquanto as agências geralmente veem 1 vencedor em cada 4.

E eu sei o que você está pensando,

Certamente isso significa que estou perdendo dinheiro 90% do tempo com cada teste?

Sim, mas apenas para metade do seu público de teste. A outra metade ainda está vendo seu site e convertendo como de costume.

Além disso, os dados que você está obtendo estão ajudando você a descobrir o que não funciona, para que você possa saber o que funciona. Você testa, aprende, testa novamente e continua até encontrar o que funciona.

E aqueles testes de 10% que vencem?

Eles podem fornecer um aumento incremental contínuo que pode ser aprimorado repetidamente, antes de ser expandido em todo o site em todas as páginas semelhantes para um impacto maior.

Essa é a beleza de ver um aumento nas conversões em uma plataforma digital. A simples escala de um aumento de apenas 1% pode ter um enorme impacto em seus negócios, tanto agora quanto com todo o tráfego futuro. Na verdade, Jeff Bezos pensa nessa mesma linha, chamando a Amazon e seu objetivo de testar e melhorar “o melhor lugar do mundo para falhar” durante seu relatório anual de acionistas:

Dada uma chance de 10% de um pagamento de 100 vezes, você deve fazer essa aposta todas as vezes. Mas você ainda vai errar nove em cada dez vezes .

Jeff Bezos, Amazon

Mais vendas e melhores insights não são os únicos benefícios dos testes A/B.

A execução de testes permite que você se afaste de tópicos de bloqueio e teoria de grupo. Em vez de passar meses discutindo possíveis mudanças no design da web e não fazer nada, tome medidas e teste-as, liberando sua equipe para se concentrar em outras coisas. (Apenas certifique-se de testar seu efeito antes de colocá-lo ao vivo!)

Não apenas isso, mas você pode aprender algo novo sobre seu público que APENAS os testes A/B podem lhe dizer.

A elaboração de teorias e pesquisas com clientes são ótimas, mas é o que seu público realmente faz em seu site que mais importa, não apenas o que eles dizem. Compreender seus testes ajuda você a provar ou refutar essas ideias e comentários.

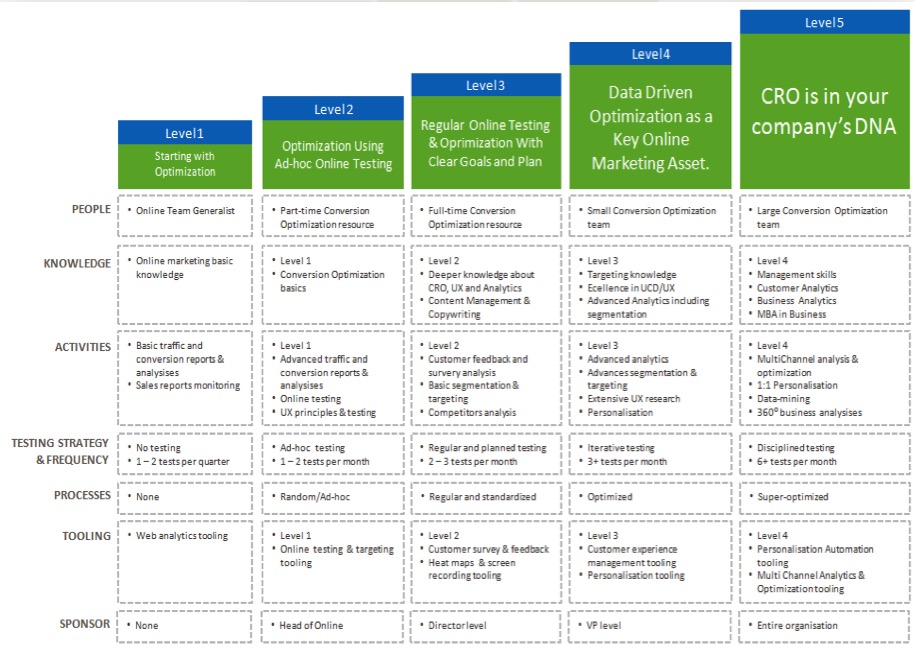

Quanto mais você entender seus resultados, mais confiante ficará em seus testes, permitindo que você 'madureça' seus esforços de CRO e execute testes com mais frequência, e talvez até comece a construir uma equipe de testes interna.

Agora que você vê o benefício de aprender com cada teste A/B, vamos orientá-lo em um processo simples para analisar cada novo teste executado…

O processo de 7 etapas para aprender com seus testes A/B (juntamente com sistemas que você pode usar para melhorar em testes futuros)

Nós dividimos isso em 7 etapas principais a serem seguidas.

Você pode não ter todos os métodos ou ferramentas que recomendamos aqui, mas, vendo como eles se encaixam, você pode avaliar seu valor e decidir se deseja integrá-los em seus testes futuros.

Etapa 1: verifique se seus dados são precisos, válidos + significativos

Esta é a parte mais importante de todo este processo. Certifique-se de que as informações que você tem em seu teste são precisas e válidas para que você possa ter confiança nos resultados.

Então, como você garante que os resultados dos seus testes estão fornecendo dados confiáveis?

Bem, existem algumas coisas que você pode fazer…

Verifique a precisão da sua ferramenta

Agora, a maioria das pessoas sente falta disso. Sinta-se à vontade para pular se o seu site não receber mais de 10.000 visitantes por mês. Tecnicamente, não é necessário começar com CRO e funciona melhor com sites com um grande volume de tráfego, mas eu seria negligente em não incluí-lo aqui, pois sites grandes podem realmente ver a diferença.

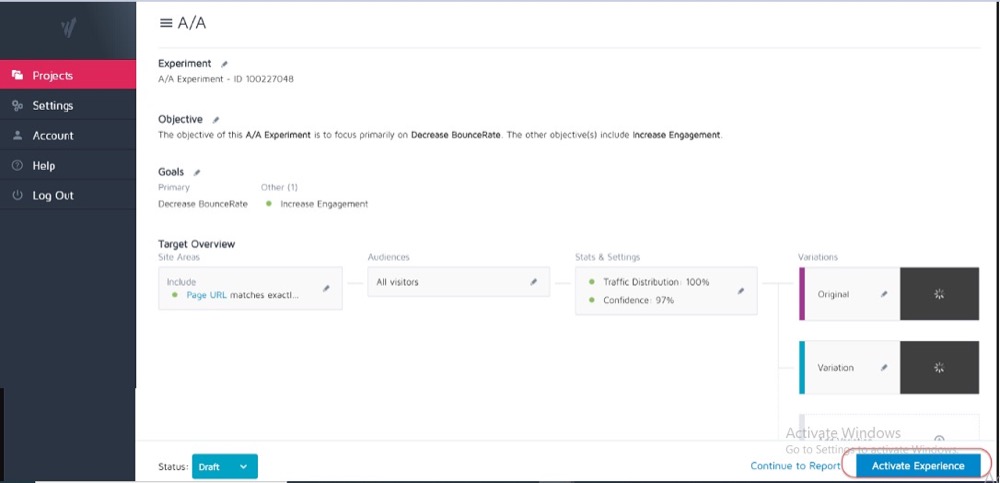

Idealmente, você já executou um teste A/A em sua ferramenta de teste atual para ver a precisão e se há algum problema.

Como?

Você executa um teste de divisão simples com 2 cópias idênticas de uma página da Web e, em seguida, acompanha os resultados nessas 2 páginas idênticas.

Como não há diferenças entre eles, seus resultados devem ser os mesmos para cada página. No entanto, pode haver algumas discrepâncias causadas pela ferramenta e como ela mede ou rastreia seus dados.

Saber isso com antecedência pode ajudá-lo a obter uma tolerância para a precisão dos resultados de seus testes e usá-lo como uma diretriz para todos os testes futuros.

Exemplo

Se você notou que seu teste A/A mostrou uma diferença de 0,5% na taxa de conversão entre duas páginas idênticas, você pode desconfiar de qualquer resultado de teste que mostre um vencedor quando houver apenas uma diferença de 0,5% entre o controle e a variante.

Você pode definir diretrizes internas que digam que um teste deve mostrar um aumento de 1% ou mais antes de você acreditar no resultado. Novamente, você só precisa executar um teste A/A uma vez quando estiver testando uma nova ferramenta ou se achar que sua ferramenta atual pode ter alguns problemas com relatórios ou está configurada incorretamente.

Os testes A/A funcionam melhor com sites de grande tráfego, pois os dados de amostra necessários para verificar com precisão podem ser muito grandes, mas a diferença em um erro de 1% pode ser enorme.

Execute seu teste por tempo suficiente para obter uma visão válida de como seus clientes interagem com seu site

Portanto, agora que você confia em sua ferramenta, deseja executar seu teste por 2 a 4 semanas, mesmo que obtenha conversões suficientes para poder desativá-la estatisticamente antes.

Por quê?

Porque seu público geralmente interage com seu site de maneira diferente, dependendo do dia da semana ou de determinados estágios do mês.

Exemplo

Se as pessoas em seu público fossem pagas às quintas-feiras, você veria um aumento que poderia perder se seu teste fosse executado apenas de segunda a quarta-feira, certo?

Da mesma forma, outros usuários podem ser pagos quinzenalmente ou mensalmente, novamente distorcendo seus resultados se seus testes não forem executados por tempo suficiente para incluí-los. Você simplesmente assumiria vendas ou tráfego mais baixos para as vezes que você perdeu.

Como você sabe quando terminar um teste? Leia mais sobre Significado estatístico do teste A/B: como e quando terminar um teste

Esteja ciente de quaisquer fatores internos ou externos que possam afetar seus resultados

Esses são eventos exclusivos ou programados que podem distorcer seus dados.

Por exemplo, se o seu CEO ou empresa foi notícia ou se você está realizando campanhas ou promoções de marketing atuais, bem como quaisquer fatores externos, como feriados nacionais ou até mesmo picos de tráfego aleatórios.

Tudo isso pode afetar o tráfego do seu site e alterar a precisão dos resultados durante esse período.

História verdadeira:

Cerca de 6 anos atrás, eu era dono de uma empresa de roupas de surf.

Um dia, nosso tráfego aumentou cerca de 800% do nada e nossa taxa de rejeição disparou. Não havíamos feito nenhuma nova campanha de marketing, então investiguei um pouco para descobrir de onde vinha o tráfego.

Acontece que uma de nossas camisetas tinha um nome de produto que era o mesmo nome de uma nova música de uma banda pop coreana, e por 2 dias estávamos ranqueando e recebendo seus visitantes.

É claro que esse novo público não estava nem um pouco interessado em nosso produto e logo foi embora.

Louco, certo?

Outra vez, meu blog de marketing começou a ser classificado para a marca de uma empresa de TV e aconteceu a mesma coisa. Temos picos de tráfego do público errado.

Por mais aleatório que seja, esse tipo de coisa pode acontecer, então fique atento a eventos externos ou internos como esse. Você sempre pode verificar suas análises para ver de onde veio o tráfego e reiniciar seu teste quando tudo voltar ao normal.

Certifique-se de obter dados suficientes

Você quer ter certeza de que seu teste tem conversões suficientes para ter uma ideia válida de seu desempenho.

Ter um controle e uma variante com apenas 50 conversões totais e apenas uma pequena diferença entre eles não é suficiente para obter qualquer insight sobre seu público - mesmo que os resultados do teste tenham sido estatisticamente significativos. A maioria dos especialistas concorda que cerca de 300+ conversões por variante geralmente é uma boa regra geral (com ainda mais se você quiser segmentar mais tarde).

Quanto maior o conjunto de dados, mais fácil será encontrar insights em sua análise pós-teste.

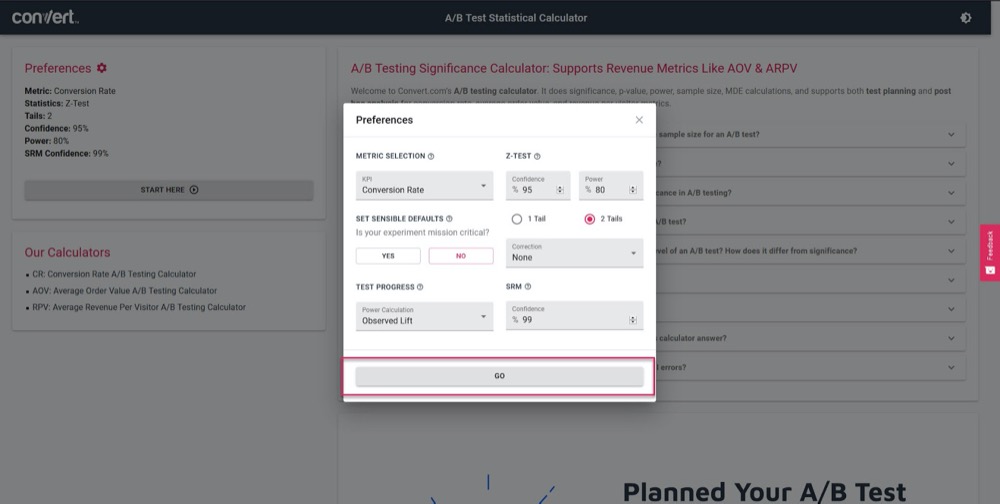

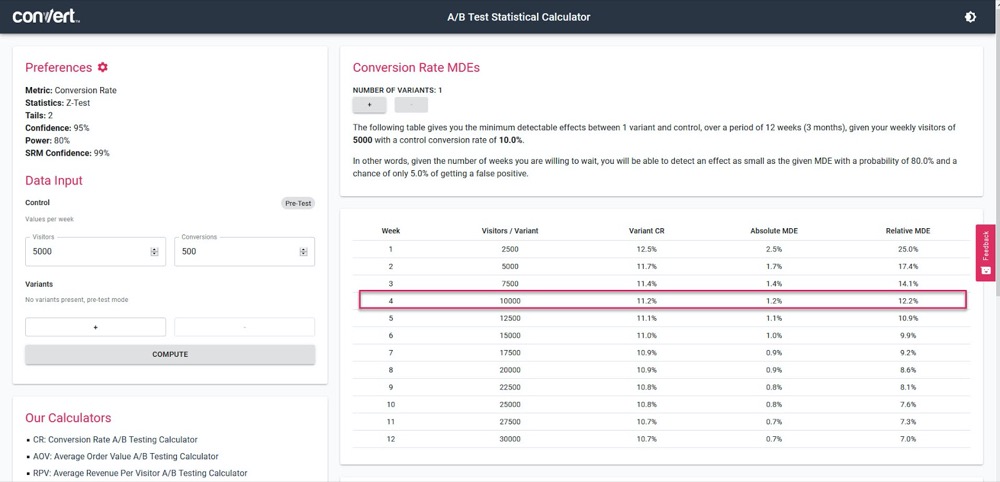

Use nossa calculadora de significância de teste A/B para ter uma ideia de quão preciso será seu teste, com base em um ciclo de vendas de 4 semanas e nas informações da sua página de 'controle' atual.

Basta definir seus parâmetros de teste:

Em seguida, insira a quantidade de tráfego que seu teste deve receber por semana, juntamente com o número de conversões da sua página atual e, em seguida, descubra a precisão e a porcentagem de aumento que seu teste poderá calcular.

No exemplo acima, podemos medir um aumento de apenas 1,2% após 4 semanas. (Se quisermos obter maior precisão, basta executar o teste por mais tempo ou aumentar o volume de tráfego no teste.)

Obtenha resultados estatisticamente significativos

Veja por que a significância estatística é importante, mas não o fator mais importante ao testar.

Sim, você deseja garantir que seu teste seja executado por tempo suficiente para obter uma classificação de confiança de 95 a 99% nos resultados, mas também deseja garantir que todos os outros fatores abordados acima sejam atingidos.

Por quê?

Mesmo um teste A/A pode mostrar 95% de confiança em uma versão sendo melhor do que sua cópia idêntica se não for executado por tempo suficiente.

(Ele poderia ver aleatoriamente todas as conversões em uma versão em um dia e nenhuma no outro.)

Muitos novos testadores interromperão uma campanha assim que atingir o 'stat sig', fazendo com que obtenham dados falsos. É por isso que recomendamos que você obtenha uma significância estatística de 95% ou mais, mas TAMBÉM execute o teste em 2 a 4 ciclos de vendas, com mais de 300 conversões e com um tamanho de amostra grande o suficiente.

Se você fizer tudo isso, pode ter certeza de que pode confiar que seu teste fornecerá resultados válidos e precisos.

Eu não posso enfatizar o suficiente o quão importante é deixar o teste ser executado para que você atenda a esses critérios.

Chamar um teste muito cedo pode fornecer informações falsas que podem levar a:

- Não encontrar um vencedor em potencial, pois você não tem informações suficientes,

- Executando campanhas com desempenho inferior porque você acha que elas são vencedoras, mas na verdade têm uma taxa de conversão mais baixa,

- Ou pior, você pode obter uma falsa confiança nesses resultados e, em seguida, usar o que aprendeu para escaloná-lo para outras partes do seu site, aumentando assim esses efeitos negativos.

Você sabe como sua ferramenta de teste A/B chega a conclusões sobre variantes vencedoras? Clique aqui para usar nossa Calculadora de Significância de Testes A/B.

Nota:

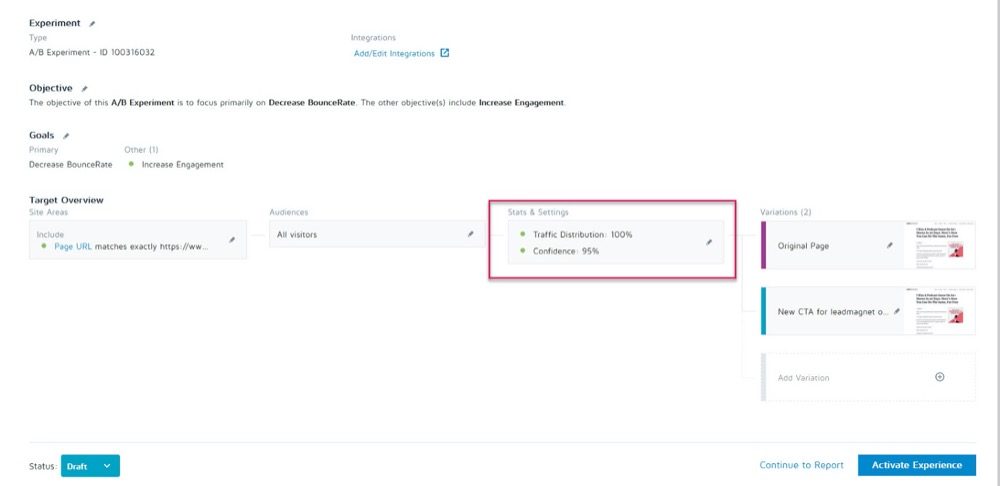

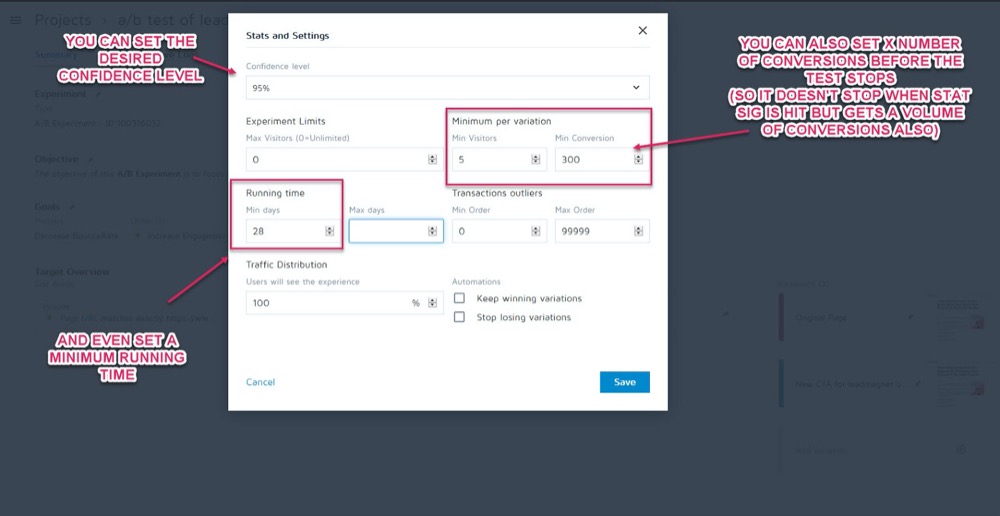

Você pode configurá-los como parâmetros antes da execução do teste na seção Estatísticas e configurações do seu experimento no aplicativo Converter experiências.

Em seguida, você pode definir o nível de confiança desejado, o tempo mínimo de execução e o número de conversões a serem alcançados antes que o teste possa ser chamado.

Quando tiver certeza de que seus dados estão corretos, é hora de analisá-los…

Etapa 2: verifique suas métricas de micro, macro e guardrail

A maioria das pessoas olhará para um teste e considerará o vencedor ou o perdedor pelo valor de face, seja o que for que a ferramenta lhes diga.

O problema, claro, é que a ferramenta só pode dizer como seu teste funciona com base nos critérios que você configurou para ele. Como testadores de CRO, sempre queremos entender o “como” e “por que” que causaram esses resultados para que possamos aprender com eles.

Agora vamos fazer algumas verificações, mas primeiro vou abordar três das mais importantes. É aí que entra o rastreamento de resultados micro e macro.

Deixe-me explicar:

- Microrastreamento refere-se ao rastreamento da meta para a qual você otimizou seu teste, que pode ser mais cliques, inscrições etc.

- O rastreamento de macro está analisando o efeito na métrica Northstar para o seu negócio, que geralmente é vendas.

Por que isso importa?

Às vezes, um aumento no micro evento em sua página de teste não afeta a macro da maneira que você imagina.

Exemplo

Digamos que você teste o CTA em uma página de captura de leads e o perdedor recebe menos leads do que o controle.

Parece óbvio qual teste ganhou, certo?

Mas em uma inspeção mais aprofundada em sua análise, você percebe que os leads que passaram nesse teste de 'perda', na verdade, converteram muito mais no back-end e criaram um ROI muito maior.

Por que isso aconteceria?

Pode ser que sua página atual seja atraente para um público mais amplo e converta mais leads, mas sua nova variante 'perdedora' é realmente atraente para pessoas que estão prontas para comprar agora.

No exemplo, a campanha perdedora seria na verdade a página com a qual você deseja veicular, pois está convertendo muito melhor com sua métrica Northstar.

Lembre-se do seu objetivo final e concentre seus esforços no que mais o afeta.

Os resultados micro e macro não são tudo o que você precisa procurar.

Se ainda não o fez, considere adicionar 'Métricas de proteção' às suas campanhas.

Essas são as principais métricas nas quais você deve ficar de olho ao fazer outras alterações, para que, se elas começarem a cair, você possa reverter ou interromper determinados métodos de teste porque seu desempenho é muito importante.

Na Uber, realizamos centenas de experimentos a qualquer momento. O objetivo desses experimentos é melhorar continuamente nossos produtos e a experiência do usuário. No entanto, às vezes um experimentador pode ter algumas métricas importantes em mente e pode não estar ciente do impacto em algumas outras métricas importantes para a equipe e a empresa em geral e, à medida que o experimento é executado, essas métricas não monitoradas podem regredir.

Para detectar e mitigar tais cenários, construímos nossa plataforma de monitoramento de experimentação. O objetivo é identificar e monitorar algumas métricas de proteção que não queremos degradar durante as execuções do experimento. Aplicamos uma variação da metodologia sequencial A/B para monitorar continuamente essas métricas de proteção e detectar qualquer regressão entre o tratamento e o grupo de controle de um experimento. Se a regressão for detectada, enviaremos alertas ao proprietário do experimento .

Suman Bhattacharya, Cientista de Dados Sênior, Uber

Exemplo

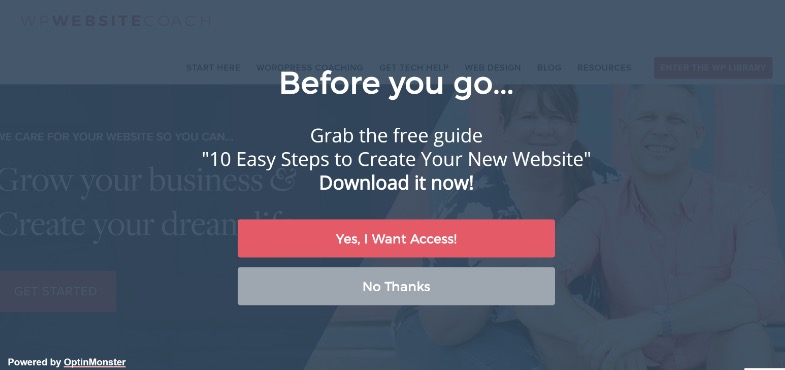

Digamos que você queira coletar mais leads usando pop-ups de tela cheia.

Para alguns sites, eles funcionam muito bem, mas nem sempre. (É por isso que testamos!)

Talvez você tenha instalado um pop-up de tela cheia e tenha começado a obter mais leads nessa página, mas seus emails de boas-vindas para esses novos assinantes estão sendo devolvidos e não estão sendo entregues.

Acontece que as pessoas estavam optando por e-mails falsos apenas para que os pop-ups parassem de aparecer.

Você não quer leads falsos em sua lista de e-mail, pois eles podem diminuir seus resultados de entrega de e-mail para assinantes reais. Você também não deve querer diminuir tanto a experiência do usuário que seu público sinta que precisa falsificar seu e-mail.

Como o marketing por e-mail é uma parte essencial do seu processo de vendas, você decide configurar um alerta para saber se a taxa de rejeição de e-mail ultrapassar um ponto definido durante a execução de testes A/B em sua página de captura de leads.

Essa seria sua métrica de proteção. Neste exemplo, você pode ver que está quebrado e decide usar métodos de captura de leads menos intrusivos.

Isso faz sentido?

As métricas de guardrail não são apenas captura de leads e taxa de rejeição. São métricas-chave nas quais você não deseja ver uma queda que afeta a experiência do usuário.

Para evitar uma degradação da experiência do usuário e ao mesmo tempo garantir que você também está melhorando as métricas que importam, defina algumas métricas de proteção que, se caíssem em um determinado limite, impediriam que você avançasse com o lançamento do suposto “ variante vencedora”. Isso também ajuda a encerrar o debate entre otimização de conversão e UX ou diretrizes de marca .

Alex Birkett, Onisciente Digital

Cabe a você decidir quais são essas métricas para o seu negócio. Use-os para ver se você tem um vencedor real ou se está simplesmente negociando o aumento de um resultado por uma perda em uma área mais importante.

Se precisar de inspiração, confira a lista de Ben Labay de métricas comuns de proteção em experimentação e teste:

Em seguida, faça essas alterações de acordo.

Contanto que você tenha o aplicativo Convert Experiences configurado com suas análises e segmentos avançados, você poderá encontrar essas informações com uma rápida olhada. Verifique o efeito de cada variação em sua métrica Northstar, bem como seus 'guardrails' para que você não escolha apenas o vencedor da ferramenta de teste.

Agora que você tem suas principais métricas cobertas, vamos analisar um pouco mais profundamente seus resultados…

Passo #3: Vá mais fundo e segmente seus resultados

Lembre-se que quando se trata de testes, a média é uma mentira .

O resultado médio só pode fornecer informações amplas com base em uma combinação de vários pontos de dados. Cabe a você entender por que esse resultado ocorreu e depois olhar mais fundo porque nem sempre é o que parece.

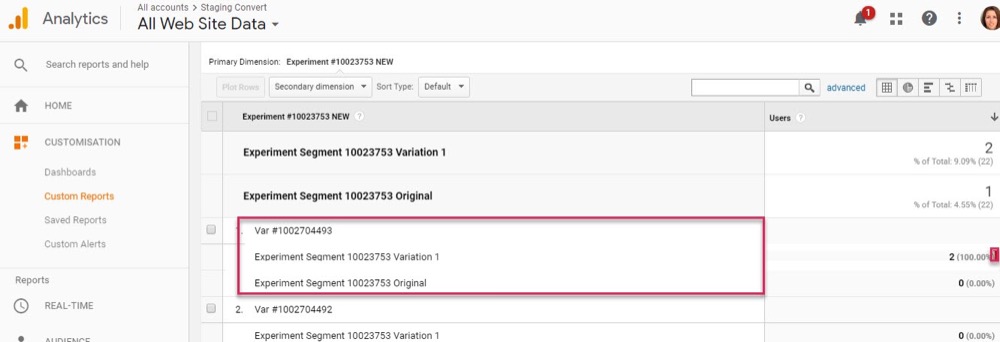

Já vimos isso com resultados de macro sendo afetados por alterações de microteste, mas seus segmentos de análise podem fornecer insights ainda mais profundos.

Exemplo

Digamos que você esteja executando um teste para mais leads. À primeira vista, o controle e a variante têm a mesma taxa de conversão de visitantes para assinantes.

No entanto, em uma inspeção mais profunda, você percebe que no desktop, a nova variação é quase o dobro da taxa de conversão do controle, mas no celular é zero, fazendo com que a média da página pareça idêntica ao controle.

Claramente, algo está errado, mas por que isso aconteceria?

Pode ser que a nova variante simplesmente não carregue corretamente no celular, ou talvez o formulário não funcione em dispositivos específicos, então nenhum usuário móvel que quisesse se inscrever poderia. E se você corrigiu esse problema, pode ser que sua variante de 'resultado igual' seja realmente capaz de superar em muito o controle.

Você só pode encontrar essas coisas quando trabalha para obter mais informações por trás de seus resultados.

Com cada teste, você experimentará insights, que informarão uma segmentação mais inteligente, que levará a novos insights, que eventualmente o levarão a uma estratégia mais significativa .

Shanelle Mullins, Shopify

A segmentação não é apenas encontrar erros, mas também encontrar outros insights do usuário.

Talvez a página e o controle estejam funcionando bem, mas quando você olha mais a fundo, percebe que certos canais de tráfego estão convertendo muito mais neste novo teste do que outros?

Muitas vezes, você terá alguns segmentos com desempenho inferior e outros com desempenho superior. Isso pode informar novas campanhas de personalização ou estratégias de tráfego pago ou orgânico.

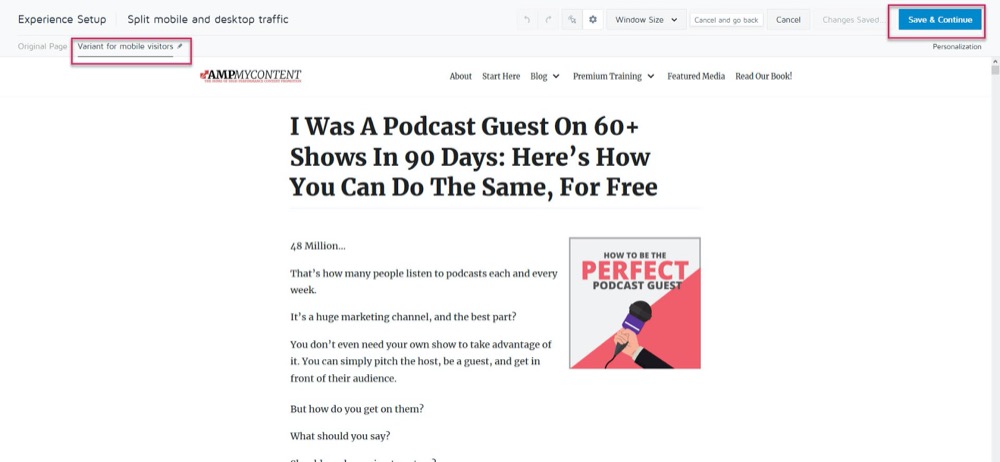

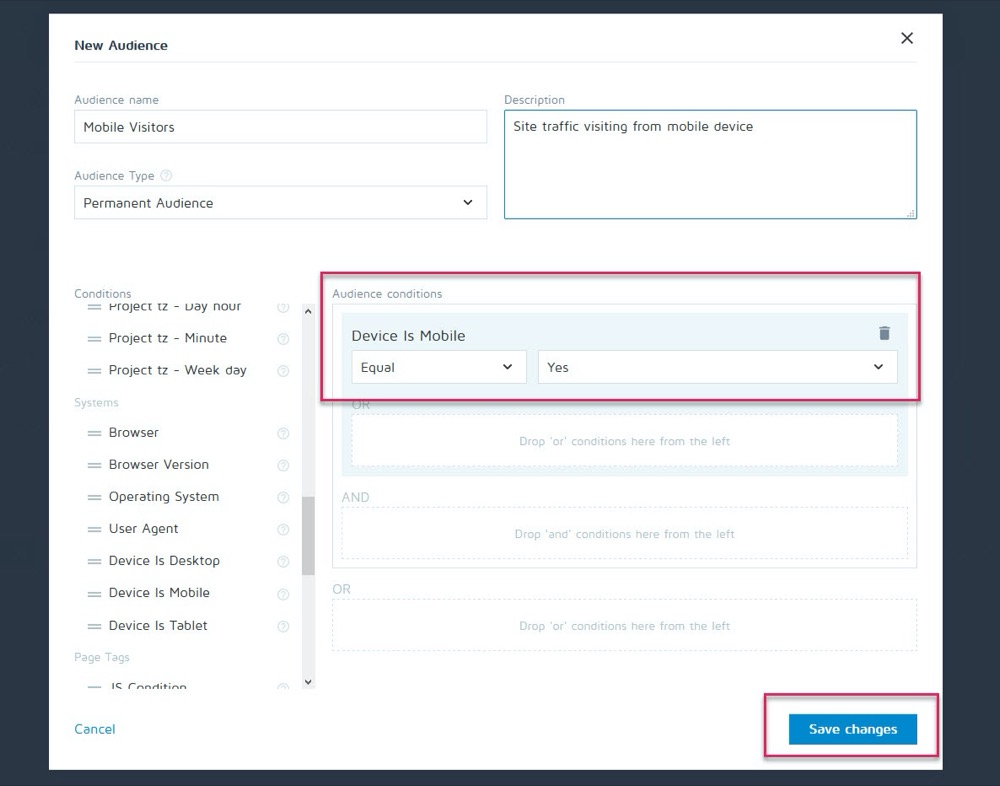

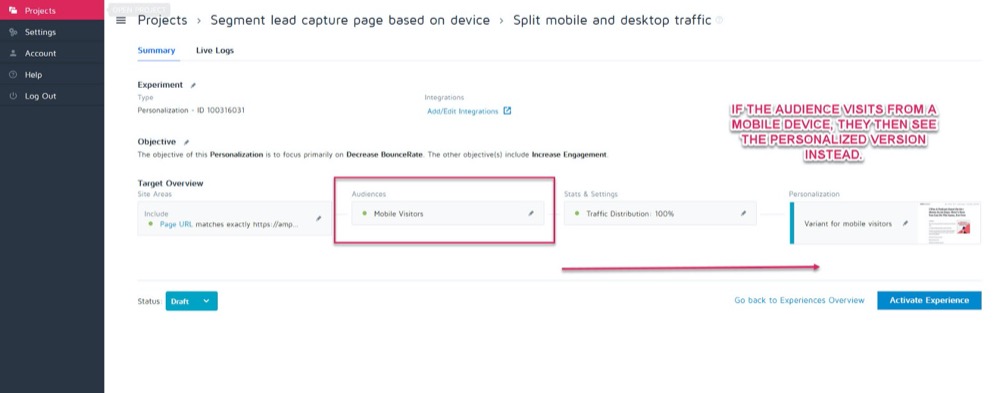

Talvez o controle converta melhor no desktop, mas a nova variante converte mais no celular. Digamos, por exemplo, que você queira escolher qual versão é exibida com base em como o espectador está vendo seu site.

Usando o recurso de personalização do Convert, você pode configurar essa variação vencedora para dispositivos móveis como uma personalização apenas para esse público.

Então, você pode mostrar a nova versão quando o visitante estiver vindo de qualquer dispositivo móvel.

Mas se eles se depararem com um desktop, eles verão a versão para desktop.

Há vários métodos de personalização diferentes que você pode usar, mas apenas depois de obter alguns insights de suas campanhas.

A chave para analisar segmentos é sempre analisar seus resultados para saber POR QUE algo aconteceu.

Olhe para:

- Público novo x recorrente . Uma variação está trazendo as pessoas de volta com mais frequência? Alguém está convertendo mais membros frios/novos da audiência?

- Origem do tráfego. Um canal está se saindo melhor do que outros? Você poderia se concentrar mais aqui?

- Visualizações de página. Especialmente se sua página de teste estiver tentando direcionar tráfego para sua página de vendas. A falta de cliques em uma versão pode significar que você tem um botão quebrado ou um problema de CTA.

- Taxa de rejeição. Isso pode indicar um link quebrado/carregamento lento/má experiência de UX ou até mesmo direcionar o público errado.

- Sistema operacional,

- Móvel vs Desktop.

- Dispositivo usado.

Um pequeno aviso:

Para obter um reflexo preciso de cada canal ao segmentar assim, você precisa de MUITOS dados. Uma boa regra geral é fazer um teste com cerca de 10 vezes o volume de conversões que você normalmente faria (ou 300 conversões por canal, não apenas por página de variante).

Você pode estar pensando: “Não há como obter tráfego suficiente para executar um teste como esse ”. Ou se você fizer isso, pode levar meses para que isso aconteça.

Mesmo que seja esse o caso, não deixe de analisar sua análise de segmento.

Por quê?

Mesmo que você não tenha conversões suficientes em cada segmento para tirar conclusões baseadas em dados, isso pode fornecer algumas informações claras se você começar a ver problemas como visualizações de página com zero cliques ou uma taxa de rejeição imediata .

Estas são todas as coisas que podem indicar um teste quebrado e ajudá-lo a encontrar um vencedor potencialmente perdido. Vá em frente e procure por quaisquer desistências e problemas importantes. Tudo estava funcionando em cada plataforma e dispositivo?

Idealmente, você verificou todos eles antes do teste, mas as coisas podem quebrar no meio do teste, então verifique novamente.

Eu pessoalmente fiz o WordPress se atualizar automaticamente no meio da campanha, o que fez com que os formulários de captura de leads parassem de funcionar repentinamente durante o meio de um teste. Sempre faça o check-in e, se vir algo que está prejudicando a precisão dos resultados, interrompa o teste, repare o problema e execute novamente.

E se tudo estivesse funcionando bem?

Vamos dar uma olhada e descobrir POR QUE as pessoas não tomaram sua ação…

Etapa 4: verifique o comportamento do usuário para obter mais informações

Idealmente, você deve ter um rastreamento qualitativo em cima de sua ferramenta de teste.

Por quê?

Porque isso muitas vezes pode fornecer informações sobre sua variante que você perderia com apenas testes regulares.

Lembrar:

Ferramentas de teste quantitativo , como o Convert, informam o que aconteceu. Podemos fornecer os dados numéricos brutos entre quantas pessoas clicaram ou não clicaram e ajudá-lo a configurar cada teste A/B.

Mas adicionar ferramentas qualitativas ajuda a entender POR QUE uma ação aconteceu. Eles permitem que você veja o que o usuário estava fazendo e obtenha mais informações sobre suas ações.

(Os testes geralmente falham devido à má execução ou compreensão do público e é apenas vendo o que deu errado que podemos resolvê-lo.)

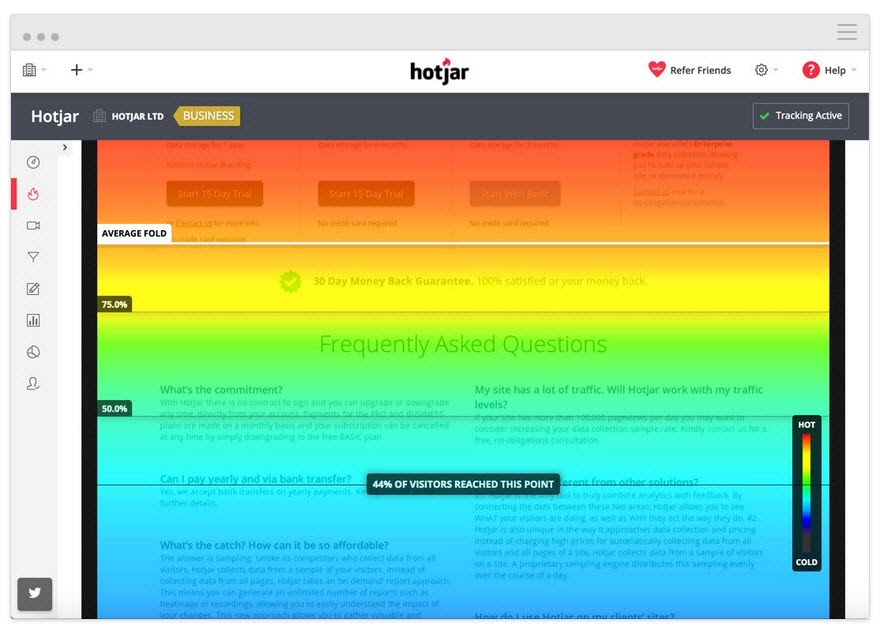

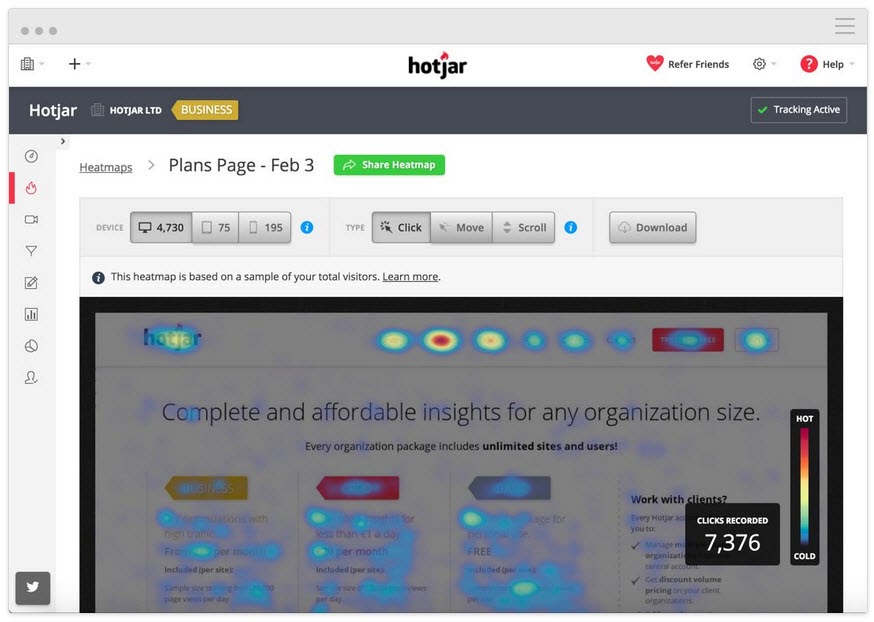

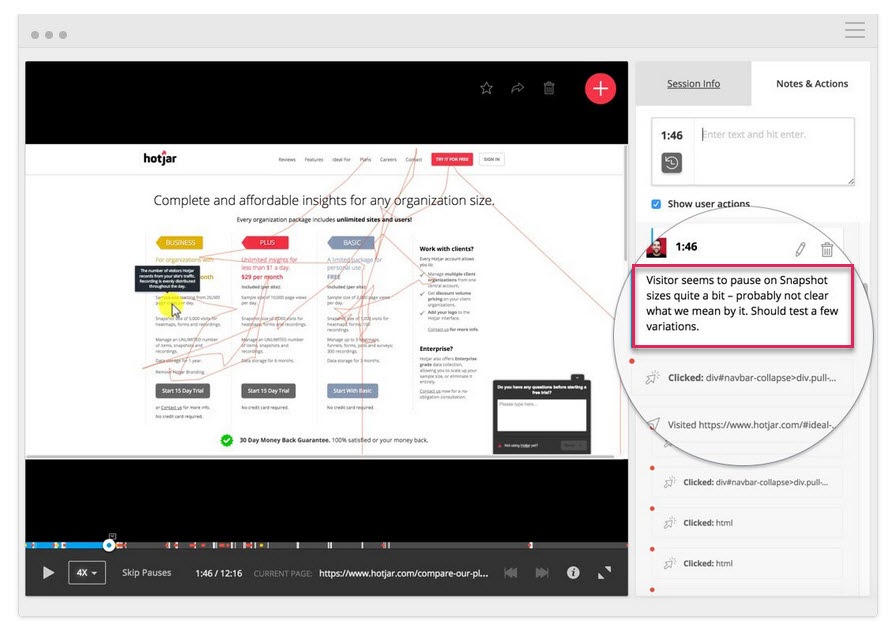

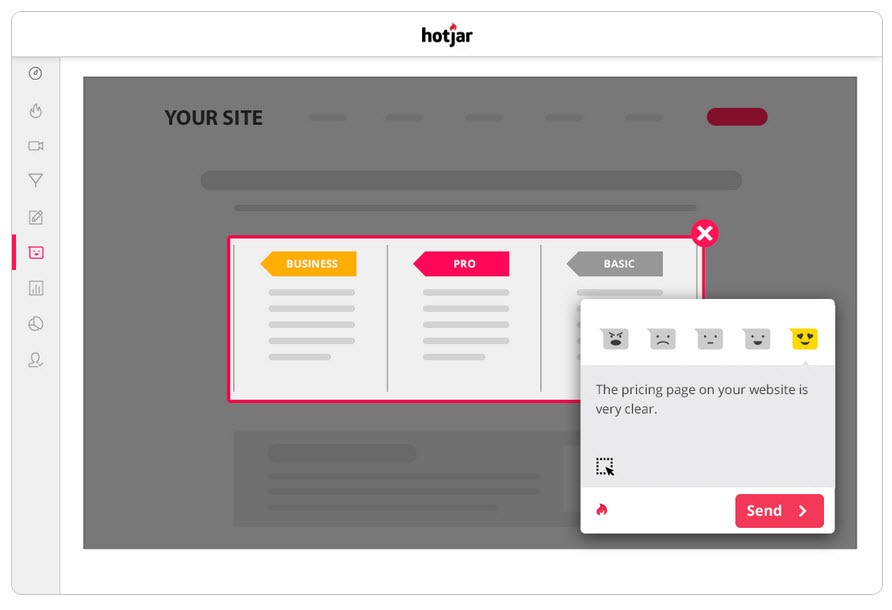

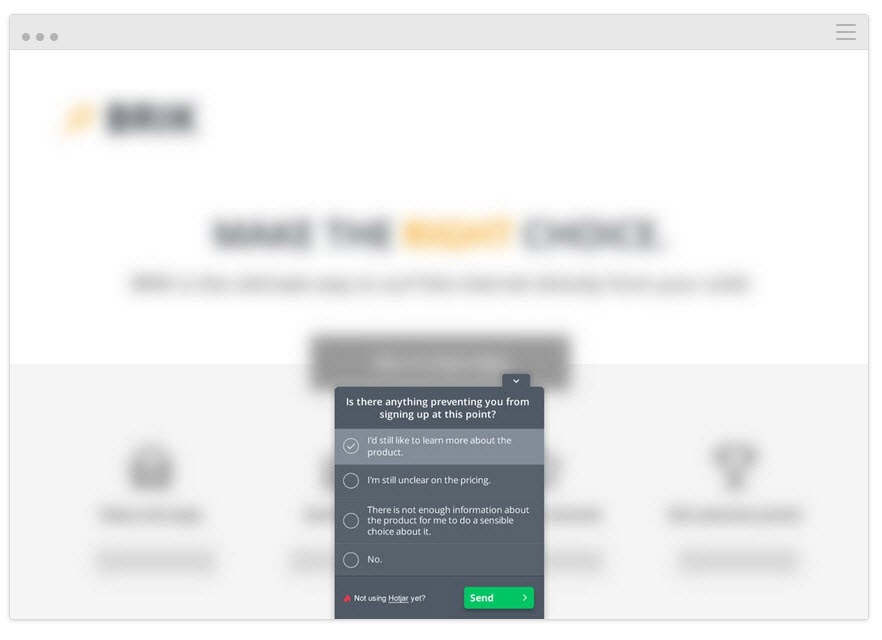

Usando uma ferramenta como o Hotjar, você pode executar vários testes qualitativos e até mesmo extrair os dados diretamente para o painel do Convert com nossa integração integrada.

Para obter insights mais profundos, configure a integração Hotjar – Convert e experimente as táticas abaixo.

Rastreie até onde o usuário lê

Adicione uma ferramenta de mapa de calor à sua página para ver se o seu público chega até o seu CTA. Caso contrário, você pode executar seu teste novamente e mover o CTA para cima na página.

Acompanhe o que os usuários clicam, mas não devem

Eles clicam em CTAs estratégicos ou é um texto aleatório que eles acham que pode ser um link?

Assista às gravações de tela para ver o que eles não clicam, mas devem

Eles não estão clicando no seu botão CTA mesmo que rolem o suficiente para vê-lo? Eles estão clicando, mas não está abrindo? Eles vêem, mas não percebem que é um botão para ser clicado?

Você pode assistir a tudo isso e até adicionar notas quando essas coisas aparecerem.

Não são apenas as ferramentas de mapeamento de calor e rastreamento de cliques que podem ajudar.

Execute pesquisas para seu público

As pesquisas ajudam você não apenas a obter feedback sobre o que levou seu público a agir (ou impedi-lo), mas também fornece a linguagem que ele usa para descrever isso.

Em redação, chamamos isso de 'linguagem de espelho' e é incrivelmente eficaz na conexão com o usuário. Parece que você não apenas reconhece o problema deles, mas o entende melhor do que qualquer outra pessoa, ao descrevê-lo com as mesmas palavras que eles usam.

Duas ótimas maneiras de usar pesquisas junto com sua ferramenta de teste A/B são:

- Enquetes de intenção de saída . Identifique aqueles que não aceitam a nova versão, para que você possa descobrir o que os impediu.

Existe algum motivo para você não ter optado/comprado hoje?

- Pesquisas pós-compra/conversão. Encontre aqueles que aceitam a variante e veja se houve pontos de atrito e fatores motivadores.

O que fez você decidir agir hoje?” Houve alguma coisa que quase o impediu de decidir?

Você pode até executar pesquisas semelhantes no controle se quiser mais informações. Tudo isso ajudará você a entender como o teste foi executado para que você possa iterar e melhorar.

Falando nisso…

Etapa 5: Aprenda com os testes perdidos

A coisa mais importante quando se trata de obter um teste perdedor é aprender algo com o resultado. Não existe um teste ruim, desde que você possa tirar insights dele para melhorar ou entender melhor seu público.

O teste A/B é um processo interativo. Nós falhamos para a frente enquanto ganhamos entendimento. Muitas vezes, você pode aprender muito mais fazendo um teste perdedor para um vencedor do que apenas obtendo um vencedor definitivo.

Até agora fizemos 3 coisas:

- Certificando-se de que os dados de teste são precisos,

- Olhando para os resultados brutos para quaisquer problemas, e

- Tentando entender nossos usuários e suas ações.

Esta etapa é mais uma abordagem heurística para ajudá-lo a entender os problemas comuns que podem causar uma falha (supondo que os dados de teste sejam precisos e os botões de CTA funcionem) e analise sua abordagem e hipótese.

Sua hipótese estava errada ou seu teste estava desalinhado?

Este é um problema comum, especialmente entre os novos testadores.

Você executou seu teste de algumas métricas ou ideias 'woo woo' que não estavam alinhadas com um KPI real?

Exemplo

Digamos que você queira mais vendas de uma página, mas, por algum motivo, decidiu testar ajustes em seus botões de compartilhamento social. (Mesmo que você tenha zero dados para mostrar que mais compartilhamentos sociais afetam suas vendas.)

Parece loucura, mas você ficará surpreso com a frequência com que algo assim acontece.

Pergunte a si mesmo:

Minha meta de teste se alinhou com um KPI principal e de uma maneira que pode afetá-lo?

Se isso não acontecer, tudo bem, mas certifique-se de que o próximo teste se alinha melhor.

Falhamos, aprendemos, tentamos novamente.

Com seu próximo teste, certifique-se de se concentrar em suas principais métricas de KPI e como você pode afetá-las, e também dê ao teste um cenário claro de vitória/falha.

Queremos que esta página obtenha mais leads, por isso estamos testando o que faz com que eles aceitem, o que significa que queremos criar um CTA melhor.

ou

Queremos que esta página obtenha mais leads e descobrimos que os usuários não rolam até o nosso CTA, por isso estamos testando o aumento da página.

Ter seu teste alinhado com seu objetivo o colocará no caminho certo, mas mesmo assim, ainda pode não ver mais conversões…

A hipótese estava correta e o teste foi alinhado, mas ainda não houve alteração nos resultados

Isso pode acontecer 90% das vezes e é por isso que a maioria dos testes falha.

Exemplo 1

Seus dados de usuário mostram que os usuários não confiam o suficiente em seu site. Você adicionou fatores de confiança como prova social, depoimentos de usuários, certificados SSL, mas as conversões ainda não aumentaram.

Isso significa que você deve parar e tentar um novo teste ou ângulo?

De jeito nenhum…

Sua hipótese inicial pode estar certa, mas seu teste só precisa ser aprimorado ou executado melhor antes que você possa ver qualquer efeito.

Você pode tentar adicionar mais fatores de confiança ou até mesmo mudar os que você tem para que eles se destaquem mais. Talvez reformule a linguagem usada neles para ajudá-los a se conectar melhor com seu público.

Todas essas coisas ainda se alinham com a hipótese inicial, você só precisa testar mais versões para encontrar o vencedor.

Exemplo #2

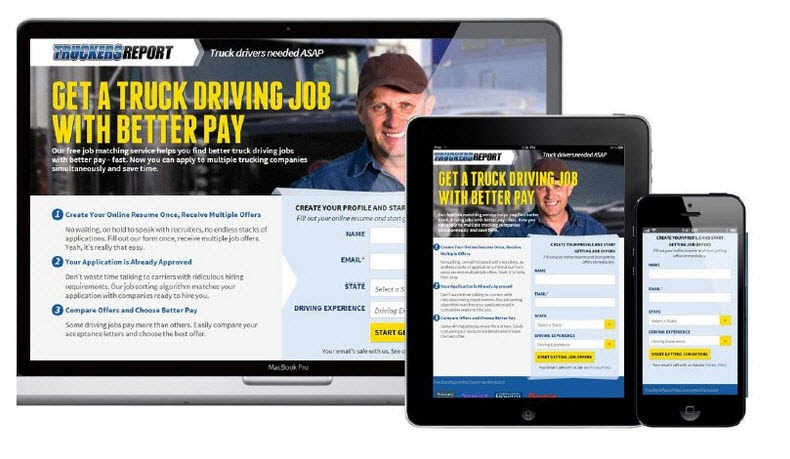

A CXL executou 6 campanhas de teste diferentes nesta página de destino para obter mais leads para certificações de motoristas de caminhão.

Eles aumentaram a taxa de adesão de 12,1% para 79,3%, tudo por continuar melhorando a página.

(Quase todas essas campanhas de teste fizeram várias tentativas usando a mesma hipótese antes de ver um aumento. Só então, eles seguiram em frente e testaram para melhorar os outros elementos da página.)

O teste A/B é um processo iterativo. Você precisa continuar testando e aprimorando para encontrar melhorias, e mesmo os melhores do ramo podem encontrar um vencedor apenas 10% das vezes.

Se hipoteticamente você fosse uma organização e todos os testes que você executasse fossem um sucesso, então isso seria realmente uma bandeira vermelha na minha opinião.

Parece contra-intuitivo, mas me mostra que você está apenas testando coisas óbvias e não há risco suficiente para realmente mover a agulha .

Deborah O'Malley, Adivinhe O Teste

É sempre bom aprender com os melhores e estamos animados em compartilhar a entrevista que fizemos com a Deborah. Conversamos sobre por que os testes nunca são um fracasso e a importância de ter a mentalidade certa nos testes. Para ajudá-lo a começar com o pé direito, ouça nossa entrevista aqui.

Isso significa que você pode precisar de 9 testes antes de ver um aumento positivo, então continue.

Seus testes devem seguir um sistema de prioridade do maior para o menor impacto. Ao executar mais testes e alterações para melhorar sua campanha atual, você verá muito mais impacto do que pular para um teste de menor importância porque não está vendo resultados imediatos com o atual.

E se ainda não houver um aumento com alterações menores, considere executar um teste inovador em que você executa um design diferente.

Pode ser um balanço para a cerca, mas às vezes pode ser a mudança que você precisa fazer.

E se depois de todos esses testes e ajustes, a variante ainda for uma perdedora?

Portanto, os dados estão corretos e você tentou todos os ajustes e até fez grandes alterações inovadoras em toda a página e ainda não terá um desempenho melhor do que o controle.

Pode não parecer, mas na verdade isso é uma COISA BOA.

Por quê?

Porque você descobriu o que não funciona com seu público!

Tantos sites fazem grandes mudanças radicais sem testar nada e simplesmente o lançam independentemente.

Pergunte a si mesmo isto:

Se essa variante de página tiver uma conversão apenas 1% pior do que o seu controle atual, quanto dinheiro você economizou testando isso primeiro e não implementando?

Back in 2014, Marks and Spencer decided to update their entire website without testing it with a sample audience first.

O resultado?

Their online sales dropped by 8.1% in 3 months, causing a loss of $55 million.

This is why testing and finding losers is a really good thing because even losing tests can save you money.

What if the Test and the Variant Have Identical Results?

You checked everything, it all works, you've segmented down and gone into the nitty-gritty, but there's just no discernible difference between your current page and your new variant.

You've even tried complete page overhauls but through some fluke of math, your new page still converts at the same rate as the old one.

In this case, it's simply the dealer's choice.

Does the new variation more actively represent your brand and style?

If so, choose whichever you wish to use. The results are still the same but you are happier with the design.

Note: This should be the only time that you do this. Branding should not sacrifice results; it should aid them, as seen in the previous example.

Step #6: Double Down on Winners and Continue to Improve Them

So far we've been covering losing campaigns, but what if you got a winner right out of the gate?

First off, congratulations!

Second, let's make sure you actually have a winner. Oftentimes, things can happen to affect your results and give you a false positive (ie we think it's a winner but we implement it and nothing happens.)

Go ahead and run the test again with just your control and the winning variant and prove the lift in results first before you make any changes to your site.

Then if it really is a winner? Don't stop there, continue to improve it!

Iterative improvements of a new winning campaign are the easiest new test to run. With each new improvement, you'll see more ongoing ROI. You can even take what you learned with your winning test and then roll it out across similar pages on your site for further tests and see if it also adds lift there too.

Step #7: Create a Learning Repository for Future Tests

This step is relevant to both winning and losing tests.

Not only will it help you with future tests, but it will also help your QA team diagnose any broken campaigns faster, as they can see where issues have appeared in the past.

Better still?

It will help you document your results for clients or your boss, while also standardizing your reporting processes and ramping up your test velocity.

Veja como funciona:

You're going to create a master archive or learning repository of all past tests. A place to document your previous wins and losses that you can use to both reference for new campaigns and share with stakeholders or customers.

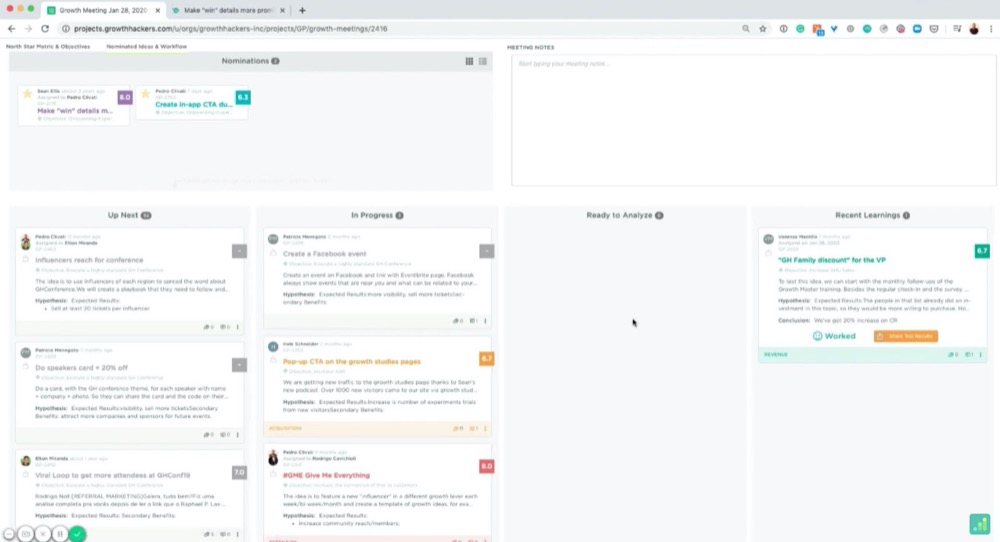

You can use a folder on your computer for this, but, if you really want to get organized, there's a great tool called GrowthHackers experiments.

Its main goal is to help marketing growth teams communicate and organize campaigns, but you can easily use it to manage your CRO testing and learnings. It will even pull in results from your test tool and allows you to archive each test. (You can simply tag and then add them to the repository.)

Whatever you decide to use, here are some best practices:

Organizing Your Tests

You probably have your own naming conventions but if you're just starting, I recommend naming each test like so:

“Goal – Campaign – Test Date”

Por exemplo:

“CTR lift test – XYZ client – March 1st-14th 2021”

This way, you can organize tests by goals to get inspiration for future tests, search through and find them for client campaigns, or look back on your experiments month by month.

Then, if you wanted to run a CTR test later on, you can swipe through them and see what ideas worked or failed in the past.

How Do We Create Documents for the Learning Repository?

Feel free to add screenshots of your testing tools graphs, confidence, and power level or any data that you think is relevant.

However, I highly recommend creating a slide with the following information:

- The hypothesis and how you came up with the idea (any survey data or information).

- A headline with the test goal.

- A screenshot of the control, the winning variant, and any other failed versions/tests that got some lift but not as much. (Highlight the key elements so you can spot what changed without having to look too hard.)

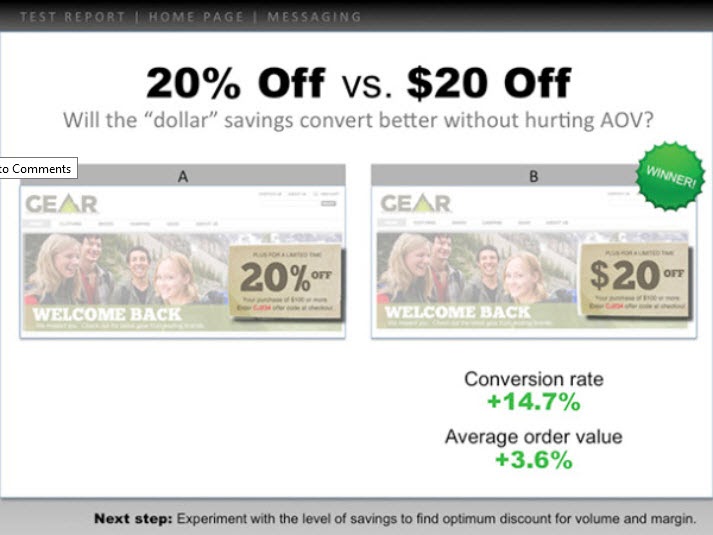

- Add the micro goal and its percentage lift. (Perhaps 3.2% CTR)

- Then add the macro goal and its percentage lift. (AVG order value up 2.2%, etc.)

Aqui está um exemplo:

You can use these slides to present the test information to anyone else who needs them, while also having a simple file to understand the test at a moment's notice.

Pretty handy, right?

Now that you've analyzed your test and recorded the results, let's walk you through how to present this to your boss in a way that even if the test failed, they're still happy to see your findings…

How To Present This Information To Your Boss (Even When Your Campaigns Failed)

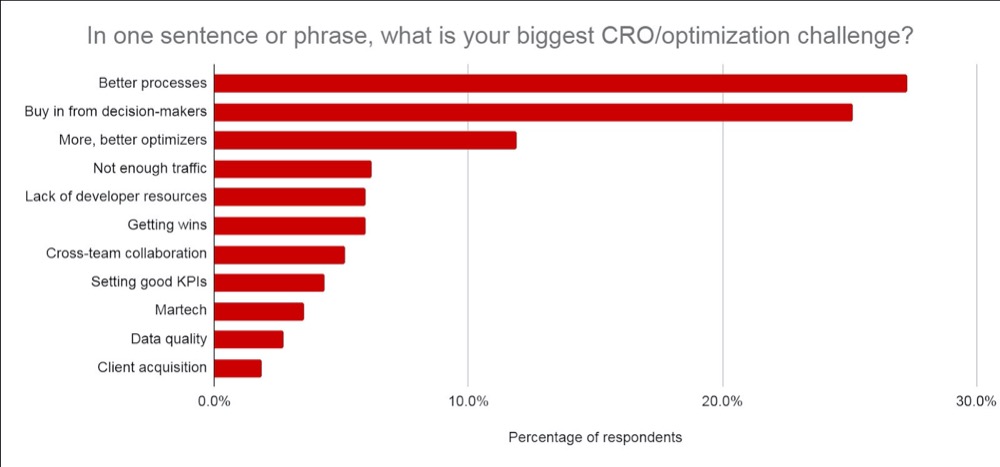

Don't worry if you feel anxious about this, you're not alone. In fact, according to CXL's state of the industry report, presenting test information or getting buy-in from your stakeholders is consistently one of the biggest struggles CROs face.

We've covered the best ways to communicate this information before, but I want to give you a few extra tips on how to get your test results across (even if your test failed).

Tip #1: Get Everyone On Board With CRO and Its Realities as Soon as Possible

Ideally, you covered this when you first broached the topic of running A/B tests but it never hurts to recap.

Make sure they understand that A/B testing is a continual learning process that's more about understanding your audience and improving their experience. The lift in ROI is simply a byproduct of taking action on each test and implementing what you learn, regardless of if it wins or fails.

Winners give lift and losers give insight into where to improve.

No test is ever wasted but the majority of them do fail. You're looking at roughly 1/10 winners for most people's tests and agencies are around 1/4.

Be clear on how many tests fail and the need to run more tests to find winners.

Tip #2: Present the Information as Simply as You Can

Not everyone can read graphs easily. Even if they can, it still means that it takes effort to understand the context of what they are seeing.

The more effort it takes to understand something, the more frustrating it can be and can cause you to lose the other person's attention.

(Top tip for landing pages btw ^^)

Break it down nice and simple by using the slides from your learning repository.

It should already include:

- O que você aprendeu antes e como chegou à ideia do teste.

- O que você testou. Mostre o controle, as variações e o vencedor.

- Como funcionou em um nível micro e macro. Inclua os resultados.

Finally, add any insights you drew from tests to decide on your next important action to take. (Improve execution, test new variations, new hypothesis, etc.)

Providing insight into what happened is HUGE.

Seu chefe se preocupa mais com o que você aprendeu do que com os resultados, pois isso pode ser posto em prática. Compartilhar isso e dar ideias sobre o que fazer a seguir os ajudará a ver que você está no controle da situação e os ajudará a se sentirem confiantes sobre outros testes.

Dica nº 3: Faça com que pareçam bons

Dê um passo adiante e adicione dados importantes para eles:

- Se o teste falhou, forneça informações sobre por que você acha que ele falhou . Adicione o ROI salvo por não implementar o teste com falha e como isso afetaria o MRR e o ARR.

- Se ganhou, forneça informações sobre o ROI obtido e como isso afeta a receita/MRR e ARR ano após ano , juntamente com qualquer oportunidade de escaloná-lo ainda mais e obter mais aumento no ROI. (ou seja, você pode ter testado uma página de captura de leads e visto um aumento ao ajustar o layout. Você pode ter 30 outras páginas semelhantes às quais você poderia aplicar este teste que poderiam ver um aumento potencial.)

- Se o teste foi simples, compartilhe insights sobre o que você acha que aconteceu e o que fazer a seguir. (Melhor execução, uma nova variante, uma mudança total ou um teste mais bem alinhado, etc.)

Claro, o impacto ARR + MRR ou YOY é uma estimativa aproximada, mas mostra o impacto potencial e o valor do seu teste. É com isso que seu chefe se preocupa e com o que ele possivelmente está pensando quando vê seus resultados.

Confie em mim, quando você apresenta suas informações assim, você notará que é muito mais fácil. Você deixa de enquadrar o teste como 'dinheiro perdido' ou perda de tempo para se concentrar em economias potenciais, ganhos reais e potencial de crescimento adicional.

Não apenas isso, mas você também poderá provar o valor ao executar ainda mais testes, amadurecendo seus esforços de CRO e aumentando sua velocidade de teste.

Conclusão

Aí está.

Até agora, você deve se sentir muito mais confiante em como analisar e aprender com os resultados do seu teste A/B e ser capaz de apresentar essas informações ao seu chefe ou a qualquer outra pessoa, independentemente do desempenho dos seus testes.

Basta seguir este guia para otimizar a análise pós-teste de cada novo teste A/B que você executar!