Tudo sobre testes A/A: por que e quando você deve executar testes A/A?

Publicados: 2022-07-07

O teste A/A permite que você teste duas páginas idênticas entre si e pode ser extremamente útil ao configurar uma nova ferramenta de teste A/B.

O teste A/A pode ser usado para

- avaliar a precisão de uma plataforma de teste A/B,

- determinar se sua plataforma de teste A/B está totalmente integrada com suas análises internas,

- identificar possíveis problemas técnicos com sua ferramenta de teste A/B,

- fornecer uma taxa de conversão de linha de base para uma página ou funil,

- determinar o tamanho de amostra apropriado para usar em seu teste A/B e

- avalie o desempenho de suas páginas e funis.

O Convert fornece recursos de teste A/A e A/B, para garantir que você tenha tudo o que precisa para projetar e desenvolver com sucesso um site de alta conversão.

Continue lendo para saber mais sobre a importância dos testes A/A e como configurar sua primeira experiência!

- O que é teste A/A?

- Por que executar testes A/A?

- Verifique a precisão da plataforma de testes A/B

- Determine a extensão da integração com sua análise interna

- Identificar possíveis problemas técnicos

- Forneça a taxa de conversão de linha de base para qualquer página ou funil

- Encontre o tamanho de amostra necessário

- Compare o desempenho de suas páginas e funis

- Configurando uma experiência A/A

- Como interpretar os resultados do teste A/A?

- Esperamos resultados inconclusivos em uma experiência A/A

- O que significa se você obtiver variações não idênticas?

- Quais são os desafios dos testes A/A?

- Aleatoriedade

- Tamanho de amostra grande

- Converter experiências e testes A/A

- Como configurar testes A/A dentro do Convert Experiences?

- A experiência pura A/A

- A Experiência Calibrada A/A/B ou A/A/B/B

- Execute muitas experiências A/A

- Posso executar uma experiência A/A ao mesmo tempo que uma experiência A/B?

- Processo de controle de qualidade pré-teste: uma alternativa interessante ao teste A/A

- O SRM pode existir em testes A/A?

- Como configurar testes A/A dentro do Convert Experiences?

- As vantagens do teste A/A superam as desvantagens?

Talvez algo assim tenha acontecido com você antes…

- Você executa um teste A/B para ver se seu novo botão e título de CTA aumentarão as conversões.

- No mês seguinte, você envia a mesma quantidade de tráfego para suas páginas de destino de controle e variação.

- Seu software declara que sua variação é a vencedora (com 99% de confiança), então você para.

- Você então lança seu design “vencedor”, mas depois de vários ciclos de negócios, você vê que o aumento de 50% em sua taxa de conversão teve pouco efeito em seu lucro líquido.

A explicação mais provável é um resultado de teste falso positivo. Felizmente, existem vários métodos para lidar com testes incorretos.

Um que você já deve ter ouvido falar é o teste A/A.

O que é teste A/A?

Antes de mergulharmos nos testes A/A, vamos falar sobre os testes A/B, para que possamos apontar as diferenças.

Em uma experiência A/B típica, o tráfego é dividido entre duas ou mais variações alternativas.

Uma variação é geralmente designada como “controle” ou “original”. Todas as outras variações da experiência são comparadas ao controle, para determinar qual produz o maior aumento em uma determinada métrica.

O teste A/A, por outro lado, exige que o tráfego seja alocado para duas variações idênticas, geralmente usando uma divisão 50/50.

Em um teste A/B normal, o objetivo é encontrar uma taxa de conversão mais alta, enquanto que, em um teste A/A, o objetivo geralmente é examinar se as variações têm o mesmo aumento.

Em um teste A/A, o tráfego é dividido aleatoriamente, com os dois grupos exibidos na mesma página.

Em seguida, as taxas de conversão relatadas, as taxas de cliques e as estatísticas associadas para cada grupo são registradas, na esperança de aprender algo.

Teste A/A = 2 páginas idênticas testadas uma contra a outra

Agora, vamos dar uma olhada em alguns exemplos de onde as experiências A/A podem ser usadas para determinar se elas serão úteis para você.

Por que executar testes A/A?

A execução de um teste A/A pode ser particularmente eficaz em vários estágios do processo de design e desenvolvimento da web, como:

- Quando você terminar de instalar uma nova ferramenta de teste A/B,

- Quando a configuração da sua ferramenta de teste A/B atual for atualizada ou alterada,

- Ao criar um novo site ou aplicativo,

- Quando você notar discrepâncias entre os relatórios de dados do seu teste A/B e outras ferramentas de análise que você usa.

Vamos nos aprofundar em cada um desses casos de uso.

Verifique a precisão da plataforma de testes A/B

Uma experiência A/A pode ser lançada por uma empresa que deseja adquirir uma plataforma de teste A/B ou por uma empresa que deseja experimentar um novo software de teste (para confirmar que está configurado corretamente).

Em uma experiência A/A, comparamos duas versões completamente idênticas da mesma página, com o objetivo de obter valores de conversão semelhantes.

O resultado esperado é inconclusivo se não houver diferença entre o controle e a variação.

Mesmo assim, às vezes é declarado um “vencedor” em duas cópias idênticas.

Quando isso ocorre, é fundamental avaliar a plataforma de teste A/B, pois a ferramenta pode ter sido configurada incorretamente ou pode ser ineficaz.

Como próximo passo, você deve:

- Verifique se você instalou o código de acompanhamento A/B corretamente

- Verifique a área do seu site

- Verifique seus públicos

- Verifique seus objetivos

- Entre em contato com a equipe de suporte de testes A/B para descobrir se é algo que pode ser resolvido antes de abandonar sua plataforma.

Espero que o problema seja um dos acima. Se você não conseguir descobrir o problema, isso provavelmente significa que o teste A/A é conclusivo e sua plataforma de teste A/B é imprecisa.

Determine a extensão da integração com sua análise interna

Ao verificar a precisão de uma plataforma de teste A/B, você pode usar um teste A/A para avaliar se a plataforma está totalmente integrada à sua ferramenta de análise.

Esteja você usando o Google Analytics, Heap Analytics, Adobe Analytics, Plausible, Matomo ou qualquer outro, você pode comparar os resultados do teste A/A com sua ferramenta de análise interna para determinar se a integração funcionou conforme o esperado.

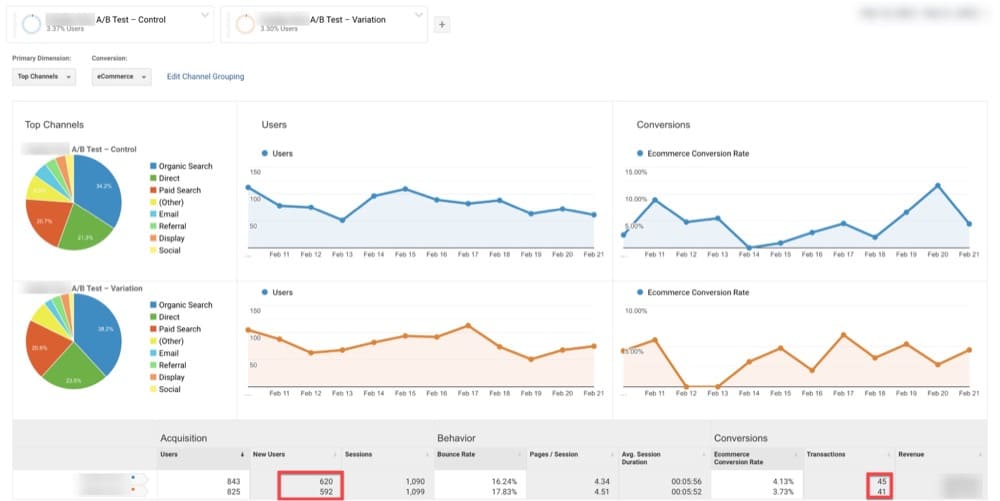

Por exemplo abaixo, o GA identificou 620 visitantes no Original e 592 na Variação (página idêntica ao Original).

Para o mesmo intervalo de datas, o Convert revelou 972 visitantes no Original e 980 na Variation (página idêntica ao Original).

Isso pode ser um sinal de que a integração entre as duas plataformas não está funcionando como esperado.

Identificar possíveis problemas técnicos

Você também pode usar um teste A/A para identificar possíveis problemas técnicos.

A maioria dos softwares de teste A/B usa métodos que são um pouco diferentes e podem resultar em variações significativas, dependendo de quão longe o programa é empurrado.

Isso pode parecer uma anomalia, mas também pode sugerir um problema subjacente mais sério com um dos seguintes:

- Fórmulas matemáticas e estatísticas

- Algoritmos de randomização

- Cookies do navegador

Você pode usar as experiências A/A para revelar os problemas acima.

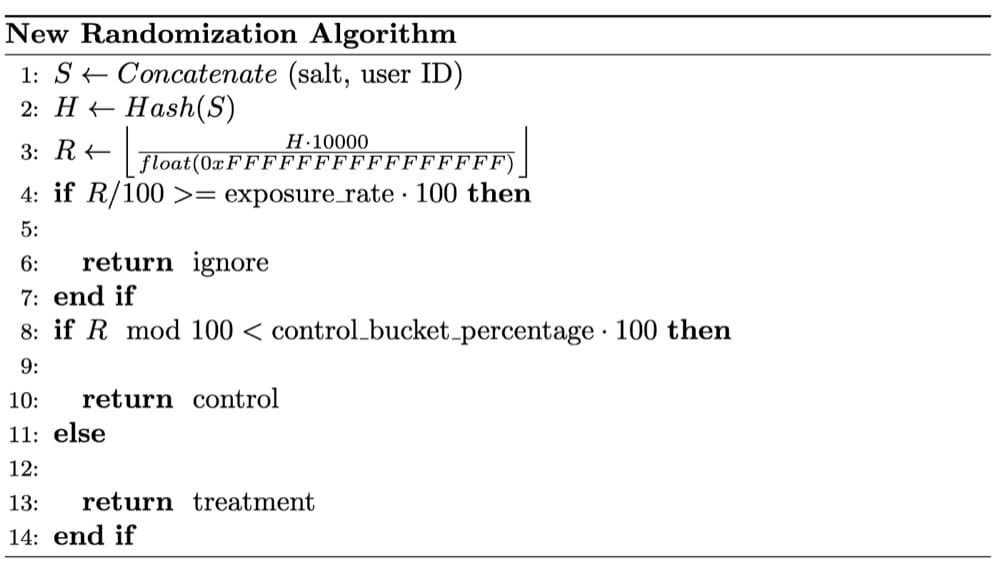

No caso abaixo, os cientistas de dados do Wish notaram preocupações de SRM em um teste A/A. Após um exame minucioso, foi determinado que o SRM foi causado por sua randomização não ser completamente aleatória.

A técnica de randomização é fundamental para resultados de experimentos confiáveis.

O uso de amostras aleatórias é um pressuposto essencial dos testes estatísticos empregados nos testes A/B.

A randomização equilibra os fatores de usuário observados e não observados entre os intervalos de experimentos. Ele estabelece uma relação causal entre o recurso do produto que está sendo testado e quaisquer alterações nos resultados do teste.

Forneça a taxa de conversão de linha de base para qualquer página ou funil

Se você quiser melhorar qualquer número, você deve primeiro entender como é sua linha de base. Pode ser sua velocidade, peso ou tempo de execução.

Da mesma forma, antes de realizar qualquer teste A/B, você deve primeiro determinar a taxa de conversão com a qual comparará os resultados. Esta é a sua taxa de conversão de linha de base .

Você provavelmente já ouviu falar de aumento de receita proveniente de uma única experiência, mas isso pode ser enganoso. Uma única experiência não lhe dirá se a conversão do seu site melhorou.

É importante conhecer sua taxa de conversão de linha de base porque, se você não puder quantificar o aumento de cada experiência, precisará comparar as conversões gerais esperadas e realizadas com frequência.

Com alguma sorte, toda experiência considerada uma “vitória” ajudará suas conversões a superar as expectativas.

E se você fizer isso com frequência suficiente, suas conversões continuarão a melhorar!

O teste A/A é o que o ajudará a conseguir isso.

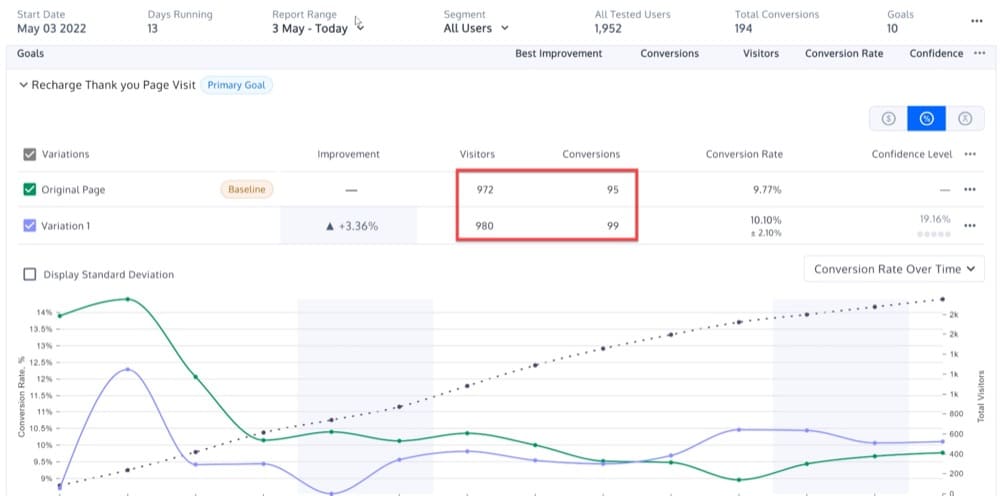

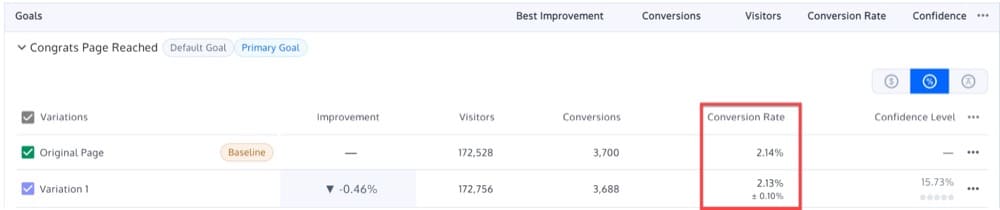

Digamos que você esteja executando um teste A/A em uma de suas páginas de destino, com o Original A e a Variação B fornecendo resultados quase idênticos: 2,14% e 2,13%.

Como resultado, a taxa de conversão de linha de base pode ser definida em 2,13-2,14%.

Com isso em mente, você pode realizar futuros testes A/B, com o objetivo de superar esse benchmark.

O resultado não é estatisticamente significativo se você executar um teste A/B em uma nova versão da página de destino e receber uma taxa de conversão de 2,15%.

Encontre o tamanho de amostra necessário

Antes de executar uma experiência A/B, verifique novamente os tamanhos de amostra, assim como faria antes de fazer uma viagem.

Você não observará o efeito da experiência se não houver amostras suficientes (usuários). Por outro lado, se você tiver muitas amostras, corre o risco de retardar o progresso de sua equipe, expondo continuamente as pessoas a uma experiência ruim.

Idealmente, você nunca deve começar uma experiência sem primeiro determinar quantas amostras você coletará.

Para entender o porquê, considere o seguinte:

Digamos que você tenha uma moeda e sua hipótese é que ela tem 50/50 de chance de dar cara ou coroa. Para provar isso, você joga cem vezes.

Mas digamos que você obteve dez coroas nas primeiras dez jogadas e decidiu parar o experimento ali.

Rejeitar a hipótese nula (de que a moeda é justa) pode parecer estatisticamente significativo, mas você encerrou o experimento prematuramente. Você não tem ideia de quanto tempo o experimento deveria ter levado para começar.

Se você não estimar o tamanho da amostra, também não poderá determinar por quanto tempo conduzirá a experiência.

Então, como abordamos isso?

O teste A/A pode ajudá-lo a descobrir o tamanho da amostra que você precisará dos visitantes do seu site.

Talvez seus visitantes de segunda-feira de manhã sejam estatisticamente completamente diferentes dos visitantes de sábado à noite. E talvez, seus compradores de férias sejam estatisticamente diferentes daqueles que compram fora da temporada de férias.

Seus clientes de desktop podem diferir estatisticamente de seus clientes de celular. E seus clientes que vêm por meio de anúncios patrocinados não são os mesmos que vêm de referências boca a boca.

Ao visualizar seus resultados, em categorias como dispositivos e navegadores, você ficará surpreso com as tendências que descobrirá com o tamanho de amostra correto.

Obviamente, se o tamanho da amostra for muito pequeno, os resultados podem não ser confiáveis. Você pode perder algumas porções, o que pode afetar os resultados da sua experiência.

Um tamanho de amostra maior aumenta a probabilidade de incluir todos os segmentos que influenciam o teste.

Ao executar um teste A/A, você poderá determinar qual tamanho de amostra permite a igualdade ideal entre suas variações idênticas.

Resumindo, um teste A/A ajuda a determinar o tamanho de amostra apropriado que pode ser usado para futuros testes A/B.

Compare o desempenho de suas páginas e funis

Quantos visitantes chegam à sua página inicial, página de carrinho, páginas de produtos e outras páginas?

Você não está preocupado se encontrará ou não um vencedor quando fizer isso. Em vez disso, você está procurando padrões maiores para uma determinada página.

Essas experiências podem ajudá-lo a responder perguntas como:

- Qual é a taxa de conversão macro da página inicial?

- Qual é a divisão dessa taxa de conversão por segmento de visitantes?

- Qual é a divisão dessa taxa de conversão por segmento de dispositivo?

As experiências A/A fornecem uma linha de base com a qual você pode comparar novas experiências A/B para qualquer parte do seu site.

Pode-se argumentar que você pode receber as mesmas informações por meio da análise do site.

Mas, isso é verdadeiro e falso.

A ferramenta de teste A/B é usada principalmente para declarar um vencedor (enquanto envia dados de teste para o Google Analytics ou realiza outros cálculos), portanto, você ainda desejará observar as métricas do site quando estiver em execução.

Configurando uma experiência A/A

As experiências A/A são uma ferramenta muito importante para a otimização da taxa de conversão.

No entanto, o desafio de uma experiência A/A é decidir qual página usar ao conduzir a experiência.

Certifique-se de que a página escolhida para sua página de experiência A/A tenha estas duas qualidades:

- Um grande volume de tráfego. Quanto mais pessoas visitarem uma página, mais cedo você perceberá o alinhamento entre as variações.

- Os visitantes podem comprar ou se inscrever . Você vai querer ajustar sua solução de teste A/B até a linha de chegada.

Esses requisitos são a razão pela qual geralmente realizamos testes A/A na página inicial de um site.

Na próxima seção, explicarei com mais detalhes como criar uma campanha de teste A/A, mas, em poucas palavras, veja como configurar um teste A/A na página inicial de um site:

- Faça duas versões idênticas da mesma página: um controle e uma variação. Após terminar de criar suas variações, escolha seus públicos-alvo com tamanhos de amostra idênticos.

- Determine seu KPI. Um KPI é uma métrica que mede o desempenho ao longo do tempo. Por exemplo, seu KPI pode ser o número de visitantes que clicam em uma frase de chamariz.

- Divida seu público de maneira uniforme e aleatória usando sua ferramenta de teste, enviando um grupo para o controle e o outro para a variação. Execute a experiência até que o controle e a variação atinjam um determinado número de visitas.

- Acompanhe os KPIs de ambos os grupos. Como ambos os grupos são expostos ao mesmo conteúdo, eles devem agir de forma semelhante.

- Conecte sua ferramenta de teste A/B ao seu software de análise. Isso permitirá que você verifique novamente se seus dados estão sendo coletados com precisão em seu programa de análise.

Como interpretar os resultados do teste A/A?

Esperamos resultados inconclusivos em uma experiência A/A

Embora seja improvável que a sazonalidade altere os resultados de um teste A/A, um dos objetivos é detectar resultados inesperados. Por esse motivo, recomendamos executar o teste por pelo menos uma semana antes de analisar o resultado.

Ao final de uma semana, você deve observar o seguinte comportamento ao examinar os resultados do seu teste A/A:

- Com o tempo, sua significância estatística se estabelecerá em torno de um determinado valor. 10% das vezes, a significância estatística ficará acima de 90%.

- À medida que mais dados são coletados, os intervalos de confiança para seu experimento diminuirão, descartando valores diferentes de zero.

- O original e a variação podem ter um desempenho diferente em vários pontos durante os resultados do teste, mas nenhum deles deve ser oficialmente rotulado como vencedor estatisticamente significativo.

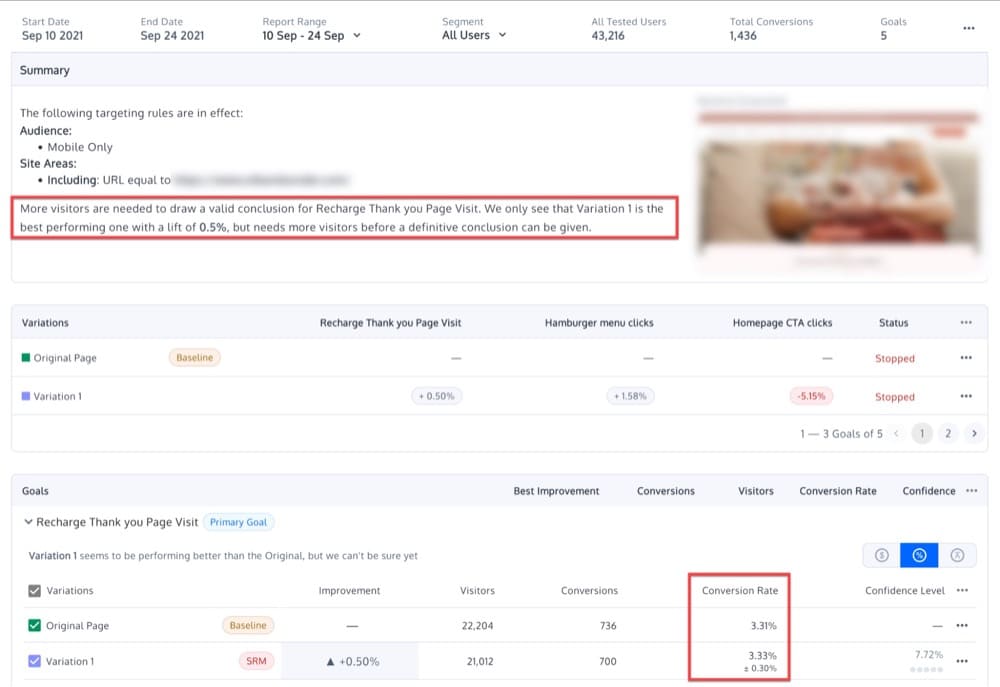

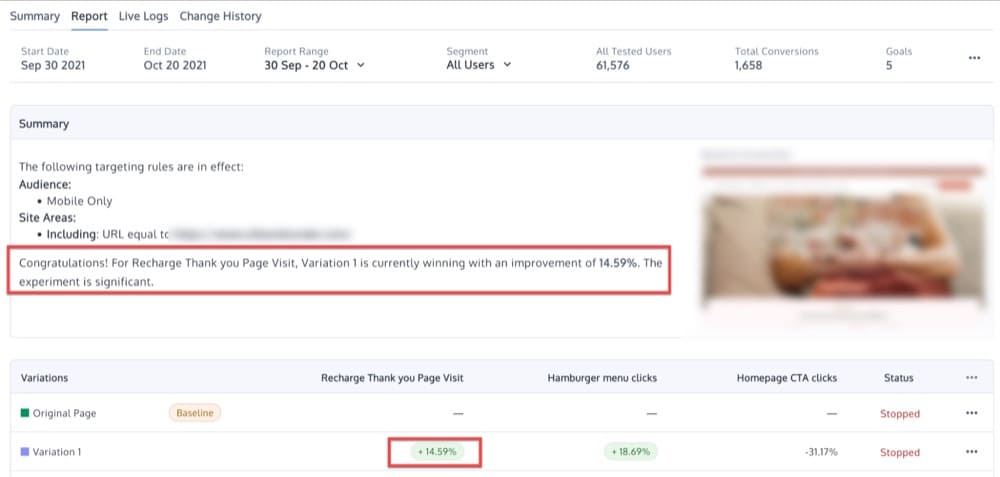

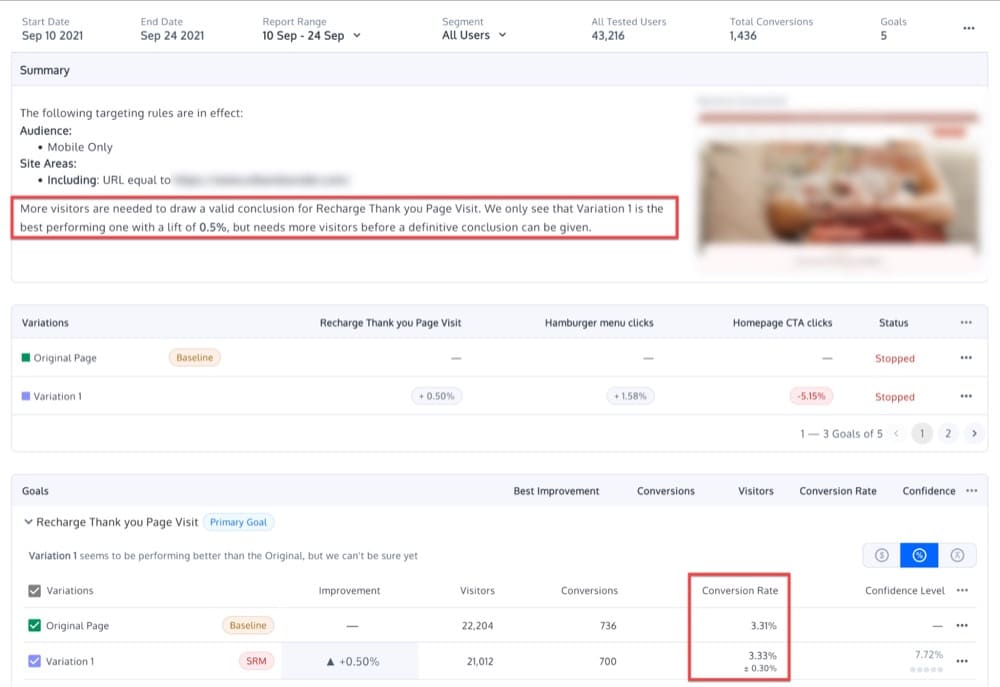

Como não deve haver diferença entre as variações, você deve esperar apenas diferenças modestas e nenhum resultado estatisticamente significativo. Talvez você veja algo nesse sentido:

O que significa se você obtiver variações não idênticas?

Se houver uma diferença considerável entre as duas variações idênticas em uma experiência A/A, isso pode significar que seu software de teste A/B não foi implementado corretamente ou que a ferramenta de teste é ineficiente .

No entanto, também é possível que a experiência não tenha sido conduzida adequadamente , ou que os resultados sejam devidos a variações aleatórias . Esse tipo de erro de amostragem ocorre naturalmente quando uma amostra é medida, em vez de medir todos os visitantes.

Por exemplo, um nível de confiança de 95% sugere que um resultado vencedor ocorrerá em uma em cada 20 ocorrências, devido ao erro de amostragem, em vez de uma diferença significativa no desempenho entre duas variações.

Outra razão pela qual uma experiência A/A executada corretamente pode não validar a identidade das variações é devido à heterogeneidade de um público-alvo .

Por exemplo, digamos que realizamos uma experiência A/A em um grupo de mulheres, com taxas de conversão variadas para mulheres de diferentes idades.

Mesmo se executarmos um teste corretamente, usando uma ferramenta de teste A/B precisa, ainda poderá revelar uma diferença significativa entre duas variações idênticas. Por quê? Neste exemplo, 50% dos visitantes podem ter entre 20 e 90 anos, enquanto os outros 50% podem ter entre 20 e 50 anos. Em vez de um erro da plataforma, o resultado incongruente é simplesmente um sinal de que os dois públicos estão muito diferente.

Finalmente, outro erro comum, ao executar qualquer tipo de teste, incluindo um teste A/A, é continuar verificando os resultados e encerrar prematuramente o teste assim que a significância estatística for detectada.

Essa prática de declarar uma variação vencedora muito cedo é chamada de “espreitar dados” e pode levar a resultados inválidos.

A espionagem de dados em um teste A/A pode levar os analistas a ver um aumento em uma variação, quando as duas são, de fato, idênticas.

Para evitar isso, você deve decidir com antecedência o tamanho da amostra que deseja usar. Tome essa decisão com base em:

- Tamanho mínimo do efeito: o aumento mínimo abaixo do qual um efeito não é significativo para sua organização

- Poder

- Níveis de significância que você considera aceitáveis

O objetivo de um teste A/A seria, então, evitar ver um resultado estatisticamente significativo uma vez que o tamanho da amostra tenha sido alcançado.

Quais são os desafios dos testes A/A?

Além dos muitos benefícios que um teste A/A pode trazer para sua estratégia de experimentação, há duas grandes desvantagens do teste A/A:

- Uma configuração experimental A/A contém um elemento de imprevisibilidade.

- Um tamanho de amostra alto é necessário.

Vamos dar uma olhada em cada um desses desafios separadamente.

Aleatoriedade

Como dito anteriormente, uma das principais razões para realizar um teste A/A é avaliar a precisão de uma ferramenta de teste.

Mas, digamos que você descubra uma diferença entre suas conversões de controle e de variação.

O problema com o teste A/A é que sempre há algum elemento de aleatoriedade envolvido.

Em outras circunstâncias, a significância estatística é alcançada apenas por acaso. Isso significa que a diferença nas taxas de conversão entre duas variações é probabilística e não absoluta.

Tamanho de amostra grande

Ao comparar variações semelhantes, é necessário um grande tamanho de amostra para determinar se uma é favorecida em relação à sua contraparte idêntica.

Isso requer uma quantidade extensa de tempo.

A execução de testes A/A pode consumir tempo de teste 'real'.

O truque de um programa de otimização em larga escala é reduzir o custo do recurso em relação à oportunidade, para garantir a velocidade do rendimento dos testes e o que você aprende, removendo completamente o desperdício, a estupidez e a ineficiência do processo.

A execução de experimentos em seu site é um pouco como administrar uma companhia aérea movimentada em um grande aeroporto internacional - você tem horários de decolagem limitados e precisa garantir que os use de maneira eficaz.

Craig Sullivan para CXL

Converter experiências e testes A/A

O teste A/A frequentemente aparece em solicitações de suporte mais “avançadas”.

As seguintes sugestões dos agentes de suporte do Convert são baseadas em dezenas de casos resolvidos:

- Para testar sua plataforma de teste A/B, primeiro faça uma experiência A/A. Se a diferença entre os dois for estatisticamente significativa no nível escolhido, sua plataforma pode estar quebrada.

- Realize um teste A/A/B ou A/A/B/B (mais sobre isso abaixo) e descarte os resultados se as duas variações A ou duas variações B produzirem diferenças estatisticamente significativas no nível escolhido.

- Configure muitos testes A/A. Se mais testes do que o esperado mostrarem diferenças estatisticamente significativas, sua plataforma está quebrada.

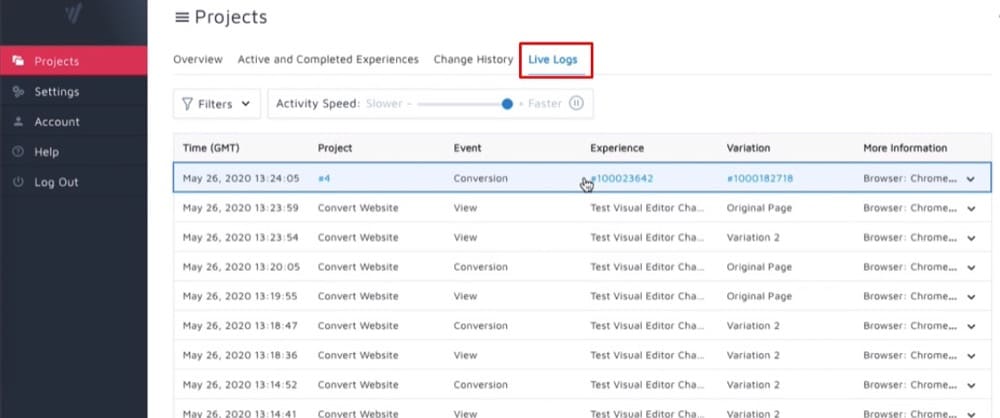

Como configurar testes A/A dentro do Convert Experiences?

Agora vamos ver como configurar alguns tipos diferentes de testes A/A (sim, no plural) usando o Convert Experiences.

A experiência pura A/A

A configuração A/A mais comum é uma divisão 50/50 entre duas páginas idênticas.

O objetivo é validar a configuração da experiência garantindo que cada variação tenha aproximadamente o mesmo desempenho.

Você está verificando a mesma coisa em relação a si mesma para descobrir se os dados contêm ruído em vez de informações úteis.

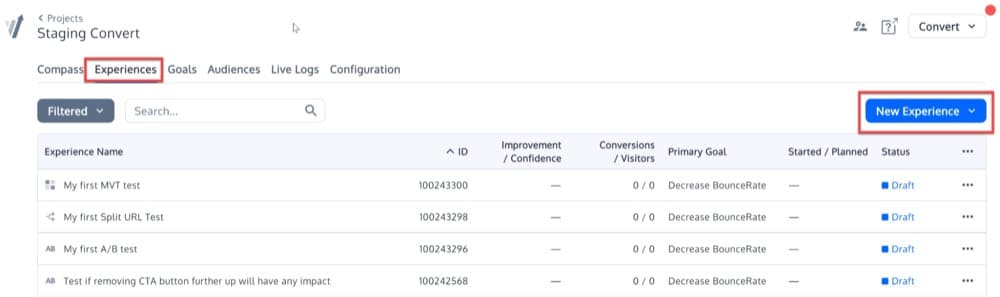

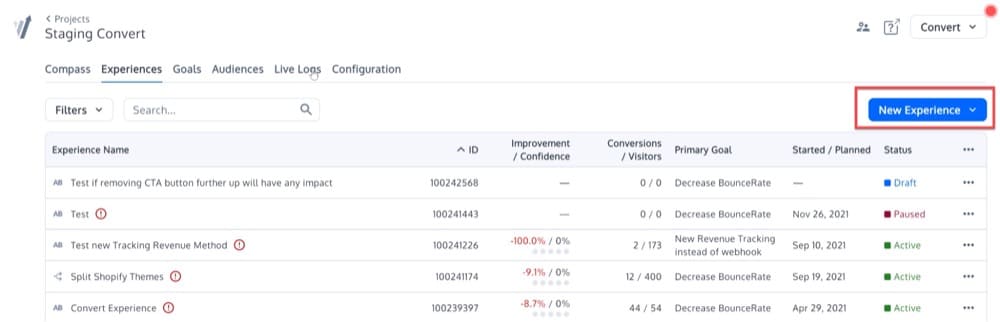

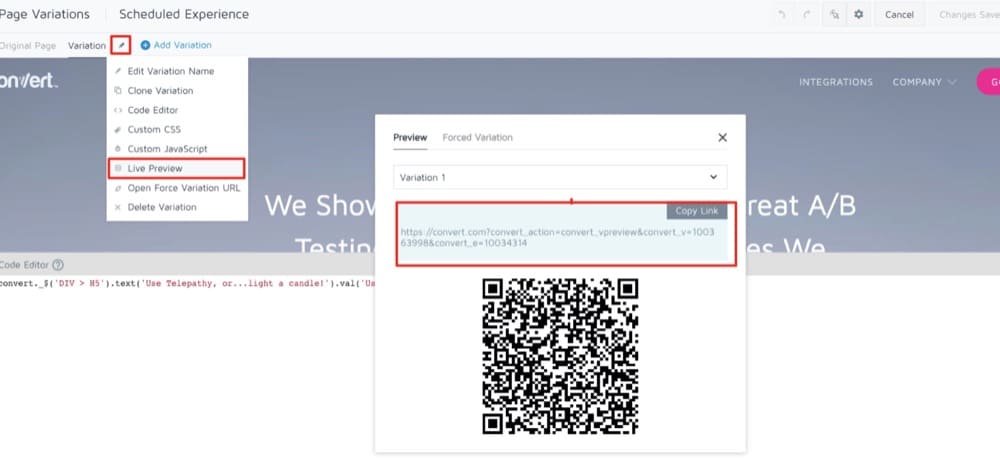

Para configurar essa experiência A/A simples, clique no menu Experiências. Em seguida, clique no botão “Nova experiência” no canto superior direito.

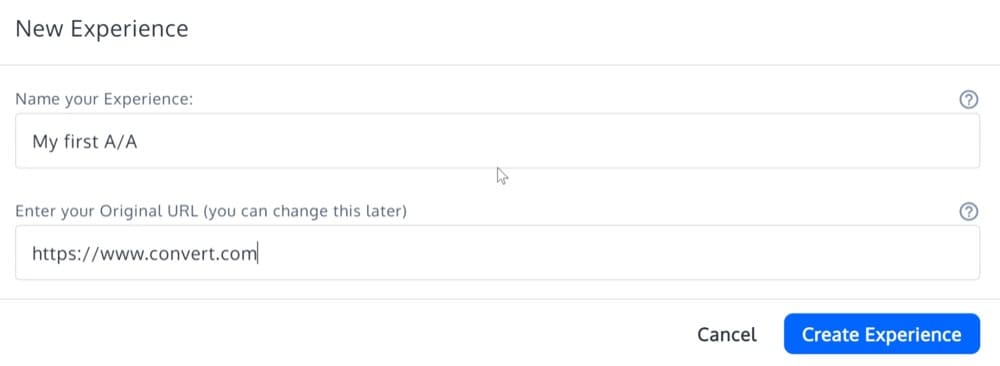

Preencha os detalhes do "Assistente de criação de experiência" e selecione o tipo de experiência "Experiência A/A".

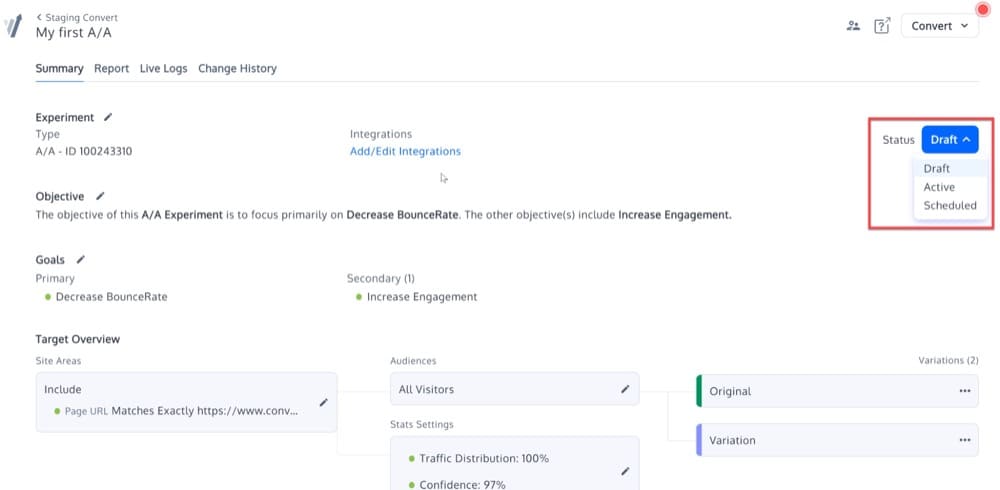

Agora, sua experiência A/A deve ser criada. Será idêntico a outros tipos de experimentos na plataforma, além de não ter opções de “Editar Variações”.

Ative a experiência alterando seu status:

A Experiência Calibrada A/A/B ou A/A/B/B

A ideia por trás desse teste A/A/B ou A/A/B/B calibrado é que as variações A ou B replicadas fornecem uma medida da precisão do teste A/B.

Se a diferença entre A e A ou B e B for estatisticamente significativa, o teste é considerado inválido e os resultados são descartados.

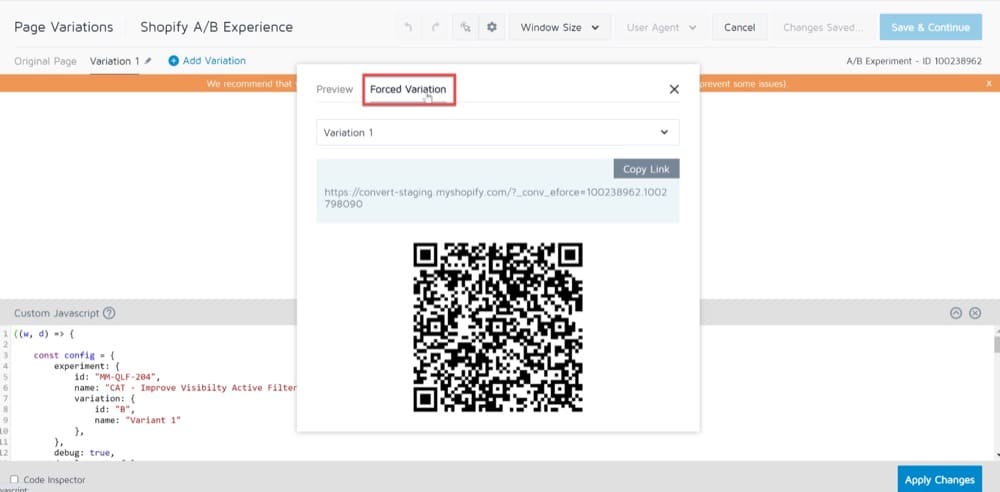

Para configurar esse teste, você precisará iniciar uma experiência A/B, em vez de uma A/A.

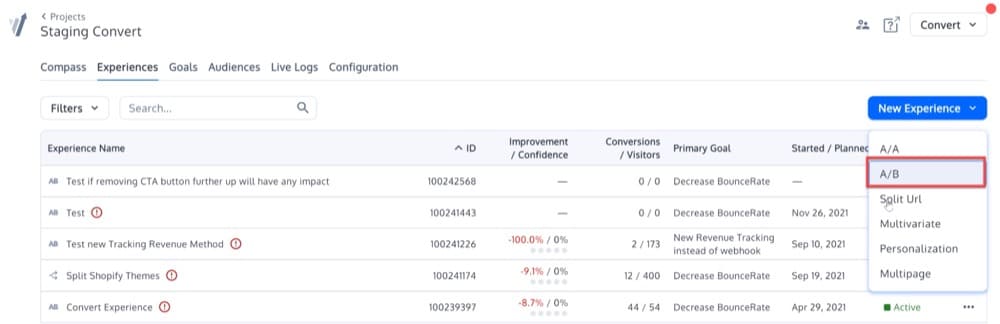

Clique no botão “Nova experiência” à direita da tela, para começar a criar uma nova experiência.

Depois de clicar nesse botão, você verá este menu pop-up. Selecione a opção A/B:

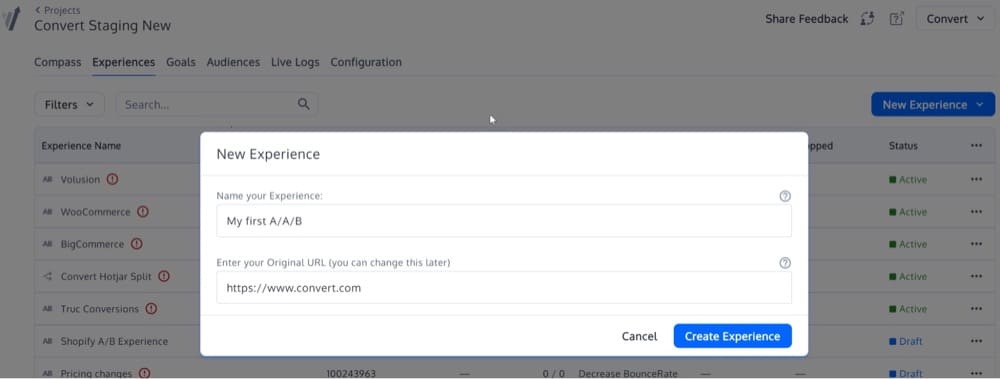

Em seguida, insira seu URL na segunda caixa.

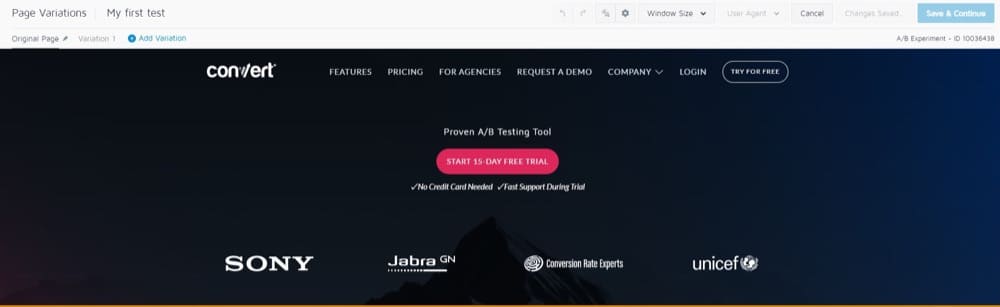

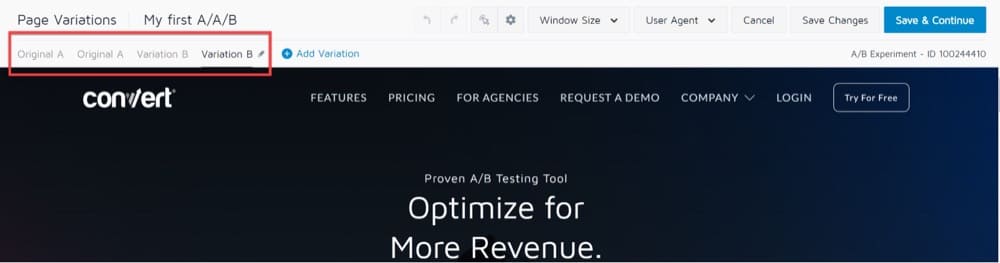

Você será levado ao Editor Visual que exibe a URL que você escolheu e uma barra de ferramentas na parte superior:

Na seção Variações de página no canto superior esquerdo, você notará que “Variação 1” é selecionada por padrão.

Isso significa que quaisquer alterações que fizermos nesta versão do URL não afetarão o URL original.

Isso resultará em um teste A/B clássico, no qual a versão “A” é a página original e a versão “B” é a Variação 1.

Para A/A/B ou A/A/B/B, você precisará adicionar outra variação A e outra variação B que sejam idênticas à variação A e variação B, respectivamente.

Deve ficar assim:

Clique no botão “Salvar e continuar” e pronto!

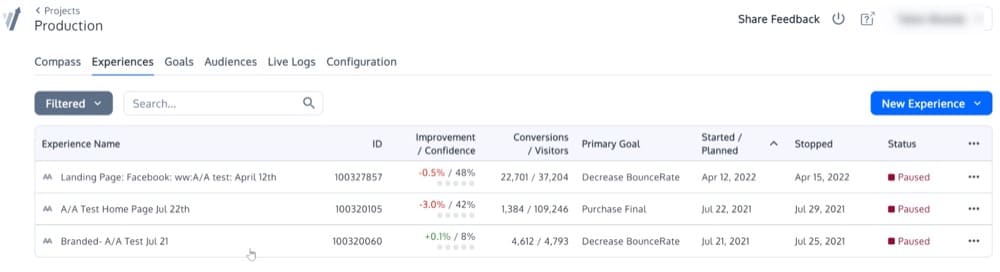

Execute muitas experiências A/A

Já abordamos isso, mas se você realizar 1.000 testes A/A sucessivos com grandes públicos, seguir todos os requisitos e obter resultados estatisticamente significativos com muito mais frequência do que o previsto, é possível que sua estrutura de teste A/B seja quebrada.

Pode ser que as amostras não estejam devidamente randomizadas. Ou talvez as duas variações não sejam mutuamente exclusivas.

Veja como isso pode parecer:

Posso executar uma experiência A/A ao mesmo tempo que uma experiência A/B?

Há uma chance de você precisar executar um teste A/A ao mesmo tempo que um teste A/B, no mesmo site.

Nesse caso, aqui estão algumas possibilidades:

- Você não terá que se preocupar com os testes conflitantes entre si se os executar simultaneamente.

- Você poderia conduzir os experimentos simultaneamente, mas com públicos distintos.

- Você pode realizar os testes na ordem correta (complete o teste 1 (teste A/A) antes de passar para o teste 2 (teste A/B)).

A opção 3 é a mais segura, mas limita drasticamente as capacidades da sua experiência.

É totalmente possível executar várias experiências na mesma página ou conjunto de páginas ao mesmo tempo.

Mas lembre-se de que o agrupamento em um experimento pode afetar os dados de outro experimento que ocorre simultaneamente.

Aqui estão as duas técnicas de conversão mais importantes para usar ao executar testes paralelos:

- Aloque 50% do tráfego para o teste A/A, enquanto permite que os outros 50% do tráfego entrem nas outras experiências A/B em execução.

- Exclua visitantes A/A de outros testes A/B.

Processo de controle de qualidade pré-teste: uma alternativa interessante ao teste A/A

Ao decidir se deve ou não fazer um teste A/A, as respostas variam dependendo de quem você perguntar. Não há dúvida de que o teste A/A é uma questão controversa.

Um dos argumentos mais comuns contra o teste A/A é que ele demora muito.

O teste A/A consome uma quantidade significativa de tempo e geralmente requer um tamanho de amostra consideravelmente maior do que o teste A/B.

Ao comparar duas versões idênticas de um site, é necessário um tamanho de amostra alto para demonstrar um viés significativo.

Como resultado, o teste levará mais tempo para ser concluído, potencialmente reduzindo o tempo gasto em outros testes importantes.

Nesses casos em que você não tem muito tempo ou tráfego intenso, é melhor considerar a realização de um processo de controle de qualidade pré-teste.

Neste artigo do blog, orientamos você em todas as etapas que você precisa seguir para realizar um processo completo de controle de qualidade. Os métodos que você usa são com você e dependem de quanto tempo você tem em suas mãos.

O SRM pode existir em testes A/A?

Pergunte a si mesmo: o número real de usuários observados durante o teste A/A está próximo da proporção 50/50 (ou proporção 90/10 ou qualquer outra proporção) se você os dividir pela metade?

Caso contrário, você se depara com um de dois problemas: ou há um problema com a forma como você está invocando a infraestrutura de teste de dentro do seu código (tornando-o “vazado” de um lado) ou há um problema com a infraestrutura de teste mecanismo de atribuição.

Um erro de incompatibilidade de proporção de amostra (erro SRM) é um defeito que um teste A/A pode detectar.

Se sua proporção for algo como 65/35, você deve investigar o problema antes de executar outro teste A/B usando a mesma estratégia de segmentação.

As vantagens do teste A/A superam as desvantagens?

Embora o teste A/A não deva ser feito mensalmente, vale a pena testar seus dados ao configurar uma nova ferramenta A/B.

Se você pegar os dados defeituosos agora, terá mais confiança nos resultados do seu teste A/B mais tarde.

Embora a decisão seja sua, é altamente recomendável que você realize testes A/A se estiver começando com uma nova ferramenta. Caso contrário, recomendamos que você configure um procedimento rigoroso de controle de qualidade pré-teste, pois o teste A/B economizará tempo, dinheiro e tráfego.

Esperamos que as capturas de tela acima tenham respondido às suas perguntas, mas se não, inscreva-se para uma demonstração para ver por si mesmo como é fácil configurar um teste A/A com o Convert Experiences.