57 erros comuns de teste A/B e como evitá-los

Publicados: 2021-06-15

Você está executando testes A/B, mas não tem certeza se eles estão funcionando corretamente?

Você quer aprender os erros comuns ao testar A/B para não perder tempo valioso em uma campanha quebrada?

Bem, boas notícias! Neste artigo, vamos orientá-lo através de 57 erros comuns (e às vezes incomuns) de teste A/B que vemos, para que você possa evitá-los ou perceber quando eles estão acontecendo e corrigi-los rapidamente.

Nós os dividimos em 3 seções principais:

- Erros antes de começar a testar,

- Problemas que podem acontecer durante o teste,

- E erros que você pode cometer quando o teste estiver concluído.

Você pode simplesmente ler e ver se você está fazendo algum desses você mesmo.

E lembre-se:

Cada falha é uma lição valiosa, tanto nos testes quanto nos erros de configuração. A chave é aprender com eles!

Então vamos mergulhar…

- Erros comuns de teste A/B que podem ser cometidos antes mesmo de você executar seu teste

- #1. Empurrando algo ao vivo antes de testar!

- #2. Não executando um teste A/B real

- #3. Não testando para ver se a ferramenta funciona

- #4. Usando uma ferramenta de baixa qualidade e conteúdo piscando

- #5. Nenhum teste de controle de qualidade

- #6. O novo tratamento/variação funciona?

- #7. Não seguir uma hipótese e apenas testar qualquer coisa antiga

- #8. Ter uma hipótese não testável

- #9. Não definir uma meta clara para seu teste com antecedência

- #10. Foco em métricas superficiais

- #11. Usando apenas dados quantitativos para formar ideias de teste

- #12. Copiando seus concorrentes

- #13. Apenas testando as "melhores práticas do setor"

- #14. Concentrando-se em tarefas de pequeno impacto primeiro, quando grandes recompensas de alto impacto/frutas de baixo impacto estão disponíveis

- #15. Testar várias coisas ao mesmo tempo e não saber qual alteração causou o resultado

- #16. Não executar uma análise de pré-teste adequada

- #17. Rotulagem incorreta dos testes

- #18. Executando testes para o URL errado

- #19. Adicionando regras de exibição arbitrárias ao seu teste

- #20. Testando o tráfego errado para sua meta

- #21. Não excluir visitantes recorrentes em um teste e distorcer os resultados

- #22. Não remover seus IPs do teste

- #23. Não segmentar as variações do grupo de controle (Efeito Rede)

- #24. Execução de testes durante eventos sazonais ou grandes eventos de site/plataforma

- #25. Ignorando as diferenças culturais

- #26. Executando várias campanhas conectadas ao mesmo tempo

- #27. Ponderação de tráfego desigual

- Erros comuns de teste A/B que você pode cometer durante o teste

- #28. Não executar por tempo suficiente para obter resultados precisos

- #29. Monitoramento/espreitadela de helicóptero

- #30. Não rastrear o feedback do usuário (especialmente importante se o teste estiver afetando uma ação direta e imediata)

- #31. Fazendo alterações no meio do teste

- #32. Alterando a porcentagem de alocação de tráfego no meio do teste ou removendo os de baixo desempenho

- #33. Não interromper um teste quando você tem resultados precisos

- #34. Estar emocionalmente investido em perder variações

- #35. Executando testes por muito tempo e o rastreamento cai

- #36. Não usar uma ferramenta que permita interromper/implementar o teste!

- Erros comuns de teste A/B que você pode cometer após o término do teste

- #37. Desistindo depois de um teste!

- #38. Desistir de uma boa hipótese antes de testar todas as versões dela

- #39. Esperando grandes vitórias o tempo todo

- #40. Não verificar a validade após o teste

- #41. Não ler os resultados corretamente

- #42. Não olhar os resultados por segmento

- #43. Não aprender com os resultados

- #44. Tomando os perdedores

- #45. Não agir sobre os resultados

- #46. Não iterar e melhorar as vitórias

- #47. Não compartilhar descobertas vencedoras em outras áreas ou departamentos

- #48. Não testar essas mudanças em outros departamentos

- #49. Muita iteração em uma única página

- #50. Não testando o suficiente!

- #51. Não documentar testes

- #52. Esquecer os falsos positivos e não checar duas vezes grandes campanhas de aumento

- #53. Não acompanhar os resultados da linha descendente

- #54. Deixar de levar em conta os efeitos de primazia e novidade, o que pode influenciar os resultados do tratamento

- #55. Alterações no período de consideração em execução

- #56. Não reteste após o tempo X

- #57. Apenas testando o caminho e não o produto

- Conclusão

Erros comuns de teste A/B que podem ser cometidos antes mesmo de você executar seu teste

#1. Empurrando algo ao vivo antes de testar!

Você pode ter uma nova página ou design de site fantástico e está realmente ansioso para colocá-lo ao vivo sem testá-lo.

Espere!

Faça um teste rápido para ver como funciona primeiro. Você não quer promover uma mudança radical ao vivo sem obter alguns dados, ou pode perder vendas e conversões.

Às vezes, essa nova mudança pode ser uma queda substancial no desempenho. Então faça um teste rápido primeiro.

#2. Não executando um teste A/B real

Um teste A/B funciona executando uma única fonte de tráfego para uma página de controle e uma variação dessa página. O objetivo é descobrir se a mudança que você implementou faz com que o público se converta melhor e entre em ação.

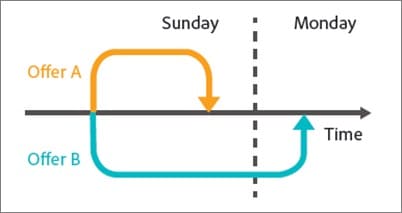

O problema é que, para garantir que esse teste seja controlado e justo, precisamos executar esse teste com parâmetros específicos. Precisamos que as mesmas origens de tráfego visualizem a campanha durante o mesmo período de tempo para que não haja fatores externos que afetem um teste e não o outro.

Algumas pessoas cometem o erro de executar um teste em sequência. Eles executam sua página atual por um período X de tempo, depois a nova versão por um tempo X depois disso e, em seguida, medem a diferença.

Esses resultados não são totalmente precisos, pois muitas coisas podem ter acontecido durante essas janelas de teste. Você pode obter uma explosão de novo tráfego, executar um evento, fazendo com que as duas páginas tenham públicos e resultados totalmente diferentes.

Portanto, verifique se você está executando um teste A/B real em que está dividindo o tráfego entre suas duas versões e testando-as exatamente ao mesmo tempo.

#3. Não testando para ver se a ferramenta funciona

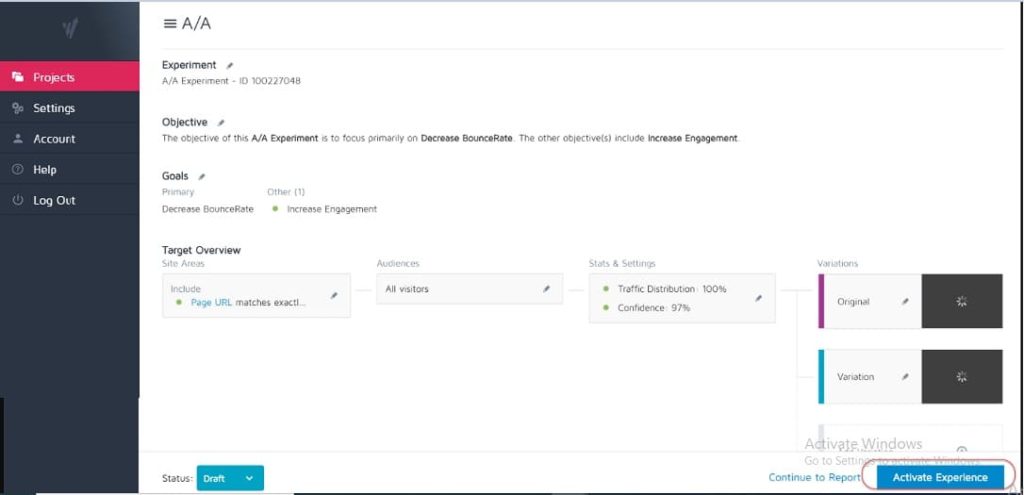

Nenhuma ferramenta de teste é 100% precisa. A melhor coisa que você pode fazer ao começar é executar um teste A/A para ver a precisão da sua ferramenta.

Como? Basta executar um teste em que você divide o tráfego 50:50 entre uma única página. (Certifique-se de que é uma página na qual seu público pode converter para que você possa medir um resultado específico.)

Por quê?

Como os dois grupos do seu público estão visualizando exatamente a mesma página, os resultados da conversão devem ser idênticos nos dois lados do teste, certo?

Bem, às vezes não são, o que significa que sua ferramenta pode estar configurada incorretamente. Portanto, vá em frente e verifique sua ferramenta de teste antes de executar qualquer campanha.

#4. Usando uma ferramenta de baixa qualidade e conteúdo piscando

Algumas ferramentas simplesmente não são tão boas quanto outras. Eles fazem o trabalho, mas lutam sob a carga de tráfego ou 'piscam' e piscam.

Isso pode fazer com que seu teste falhe, mesmo se você tiver uma variante vencedora em potencial.

Digamos que você esteja testando uma imagem em sua página. A página de controle carrega bem, mas a variação oscila entre a nova imagem de teste e a original por apenas uma fração de segundo. (Ou talvez toda vez que o usuário rolar a página para cima e para baixo.)

Isso pode distrair e causar problemas de confiança, diminuindo sua taxa de conversão.

Na verdade, sua nova imagem pode até converter melhor em teoria, mas a oscilação da ferramenta está diminuindo os resultados, dando a você um teste impreciso dessa imagem.

Certifique-se de ter uma ferramenta boa o suficiente para testar.

(Este é um fator de experiência do usuário tão importante que o Google está atualmente ajustando suas classificações para sites que não possuem elementos oscilantes ou móveis).

#5. Nenhum teste de controle de qualidade

Um erro super simples, mas você já verificou se está tudo funcionando?

- Você já passou pelo processo de vendas?

- Tem outros? (E em dispositivos sem cache, porque às vezes o que é salvo em seu navegador não é a aparência da página.)

- As páginas estão carregando bem? Eles são lentos? Os desenhos estão bagunçados?

- Todos os botões funcionam?

- O rastreamento de receita está funcionando?

- Você verificou se a página funciona em vários dispositivos?

- Você tem relatórios de erros no local se algo quebrar?

Vale a pena conferir tudo isso ANTES de começar a gerar tráfego para qualquer campanha.

Obtenha nossa lista de verificação de garantia de qualidade para testes A/B. É um PDF preenchível ao qual você vai querer voltar toda vez que fizer o controle de qualidade de um teste.

#6. O novo tratamento/variação funciona?

Da mesma forma, você passou e testou se sua nova variação funciona antes de executar um teste?

Pode ser uma parte negligenciada do teste de controle de qualidade, mas as campanhas geralmente podem ser executadas com botões quebrados, links antigos e muito mais. Verifique primeiro, depois teste.

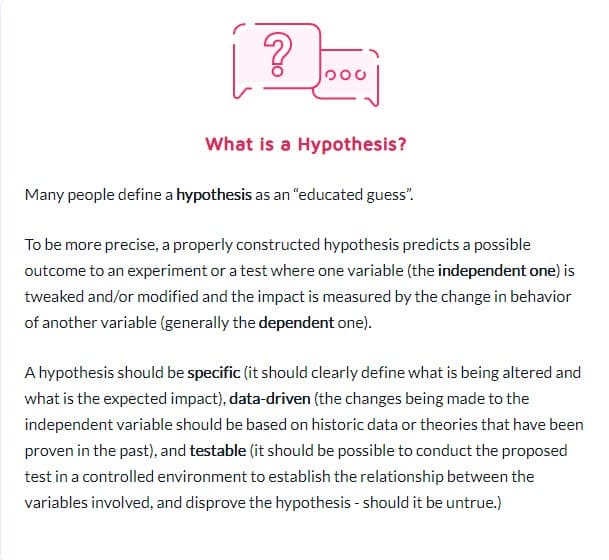

#7. Não seguir uma hipótese e apenas testar qualquer coisa antiga

Algumas pessoas simplesmente testam qualquer coisa sem realmente pensar nisso.

Eles têm uma ideia para uma mudança e querem testá-la, mas sem uma análise real de como a página converte atualmente, ou mesmo por que a mudança que estão testando pode fazer a diferença. (Pode ser que eles diminuam a conversão, mas nem saibam, pois ainda não têm um resultado de linha de base rastreado).

Formar uma hipótese de onde está um problema, a causa dele e como você pode resolvê-lo fará uma enorme diferença no seu programa de testes.

#8. Ter uma hipótese não testável

Nem todas as hipóteses estão corretas. Isto é bom. Na verdade, a palavra significa literalmente 'tenho uma ideia baseada na informação X e acho que Y pode acontecer na circunstância Z'.

Mas você precisará de uma hipótese que seja testável, o que significa que pode ser comprovada ou refutada por meio de testes. As hipóteses testáveis colocam a inovação em movimento e promovem a experimentação ativa. Eles podem resultar em sucesso (nesse caso, seu palpite estava correto) ou fracasso – mostrando que você estava errado o tempo todo. Mas eles vão te dar insights. Isso pode significar que seu teste precisa ser executado melhor, seus dados estavam incorretos / lidos errados ou você encontrou algo que não funcionou, o que geralmente fornece informações sobre um novo teste que pode funcionar muito melhor.

#9. Não definir uma meta clara para seu teste com antecedência

Depois de ter uma hipótese, você pode usá-la para se alinhar a um resultado específico que deseja alcançar.

Às vezes, as pessoas apenas executam uma campanha e veem o que muda, mas você definitivamente obterá mais leads/conversões ou vendas se tiver clareza sobre qual elemento específico deseja ver um aumento.

(Isso também impede que você veja uma queda em um elemento importante, mas considere o teste uma vitória porque "obteve mais compartilhamentos".)

Falando nisso…

#10. Foco em métricas superficiais

Seu teste deve estar sempre vinculado às métricas do Guardrail ou algum elemento que afete diretamente suas vendas. Se for mais leads, você deve saber exatamente quanto vale um lead e o valor de aumentar essa taxa de conversão.

Ao mesmo tempo, as métricas que não se conectam ou conduzem a um resultado mensurável geralmente devem ser evitadas. Mais curtidas no Facebook não significam necessariamente mais vendas. Remova esses botões de compartilhamento social e observe quantos leads a mais você obtém. Tenha cuidado com as métricas de vaidade e lembre-se de que só porque um vazamento foi corrigido não significa que não haja outro em outro lugar para resolver também!

Aqui está a lista de Ben Labay de métricas comuns de proteção para programas de experimentação:

#11. Usando apenas dados quantitativos para formar ideias de teste

Usar dados quantitativos para obter ideias é ótimo, mas também é um pouco falho. Especialmente se os únicos dados que usamos são de nossas análises.

Por quê?

Podemos saber a partir de nossos dados que uma quantidade X de pessoas não clicaram, mas talvez não saibamos por quê.

- O botão está muito baixo na página?

- Não está claro?

- Alinha-se com o que o espectador quer?

- Está funcionando mesmo?

Os melhores testadores também ouvem seu público. Eles descobrem o que precisam, o que os move para frente, o que os impede, e então usam isso para formular novas ideias, testes e textos escritos.

Às vezes, seus usuários são retidos por problemas de confiança e dúvidas. Outras vezes, é clareza e formas quebradas ou designs ruins. A chave é que essas são coisas que os dados quantitativos nem sempre podem lhe dizer, então sempre pergunte ao seu público e use-o para ajudá-lo a planejar.

#12. Copiando seus concorrentes

Pronto para um segredo?

Na maioria das vezes, seus concorrentes estão apenas improvisando. A menos que eles tenham alguém que executou campanhas de aumento de longo prazo, eles podem estar apenas tentando coisas para ver o que funciona, às vezes sem usar nenhum dado para suas ideias.

E mesmo assim, o que funciona para eles, pode não funcionar para você. Então, sim, use-os como inspiração, mas não limite suas ideias de teste apenas ao que você os vê fazendo. Você pode até sair do seu setor em busca de inspiração e ver se isso gera algumas hipóteses.

#13. Apenas testando as "melhores práticas do setor"

Novamente, o que funciona para um não é o que sempre funciona para outro.

Por exemplo, as imagens deslizantes geralmente têm um desempenho terrível, mas, em alguns sites, elas podem gerar mais conversões. Teste tudo. Você não tem nada a perder e tudo a ganhar.

#14. Concentrando-se em tarefas de pequeno impacto primeiro, quando grandes recompensas de alto impacto/frutas de baixo impacto estão disponíveis

Todos nós podemos ser culpados de nos concentrarmos nas minúcias. Podemos ter uma página que queremos ter um desempenho melhor e testar designs de layout e imagens e até cores de botões. (Pessoalmente, tenho uma página de vendas que está em sua 5ª iteração.)

O problema é que provavelmente existem páginas muito mais importantes para você testar agora.

Priorize o impacto acima de tudo:

- Esta página afetará diretamente as vendas?

- Existem outras páginas no processo de vendas com desempenho muito abaixo do esperado?

Se sim, concentre-se neles primeiro.

Um aumento de 1% em uma página de vendas é ótimo, mas um aumento de 20% na página que os leva até lá pode ser muito mais importante. (Especialmente se essa página em particular é onde você está perdendo a maior parte do seu público.)

Às vezes, não estamos apenas procurando por mais impulso, mas para consertar algo que é um gargalo.

Teste e melhore o maior impacto, o menor fruto pendurado primeiro. É isso que as agências fazem e é por isso que realizam o mesmo número de testes que as equipes internas, mas com um ROI maior. As agências obtêm 21% mais vitórias para o mesmo volume de testes!

#15. Testar várias coisas ao mesmo tempo e não saber qual alteração causou o resultado

Não há nada de errado em fazer testes radicais em que você altera várias coisas ao mesmo tempo e faz um redesenho de página inteira.

Na verdade, essas reformulações radicais às vezes podem ter o maior impacto em seu ROI, mesmo se você for um site de baixo tráfego e, especialmente, se estiver estagnado e não conseguir mais impulso.

Mas tenha em mente que nem todo teste A/B deve ser para uma mudança radical como essa. 99% do tempo estamos apenas testando uma mudança de uma única coisa, como

- Novas manchetes

- Novas imagens

- Novo layout do mesmo conteúdo

- Novos preços, etc.

A chave ao fazer um teste de elemento único é apenas isso. Mantenha seu teste com apenas UM elemento de mudança para que você possa ver o que está fazendo a diferença e aprender com isso. Muitas mudanças e você não sabe o que funcionou.

#16. Não executar uma análise de pré-teste adequada

Você tem visitantes suficientes em seu grupo de teste? O teste vale mesmo a pena?

Faça as contas! Certifique-se de ter tráfego suficiente antes de executar um teste – caso contrário, é apenas perda de tempo e dinheiro. Muitos testes falham devido ao tráfego insuficiente ou baixa sensibilidade (ou ambos).

Realize uma análise de pré-teste para determinar o tamanho da amostra e o efeito mínimo detectável para seu experimento. Uma calculadora de significância de teste A/B como a do Convert informará o tamanho da amostra e o MDE para o seu teste, o que o ajudará a decidir se vale a pena executá-lo. Você também pode usar essas informações para determinar quanto tempo o teste deve ser executado e quão pequeno é um levantamento que você não gostaria de perder antes de concluir que um teste foi bem-sucedido ou não.

#17. Rotulagem incorreta dos testes

Um erro super simples, mas acontece. Você rotula incorretamente os testes e obtém os resultados errados. A variação ganha, mas é chamada de controle, e então você nunca implementa a vitória e fica com o perdedor!

Verifique sempre duas vezes!

#18. Executando testes para o URL errado

Outro erro simples. O URL da página foi inserido incorretamente ou o teste está sendo executado em um 'site de teste' onde você fez suas alterações e não na versão ativa.

Pode parecer bom para você, mas na verdade não será carregado para o seu público.

#19. Adicionando regras de exibição arbitrárias ao seu teste

Novamente, você precisa testar uma coisa com seu tratamento e nada mais.

Se for uma imagem, teste a imagem. Todo o resto deve ser igual, incluindo a hora do dia em que as pessoas podem ver as duas páginas!

Algumas ferramentas permitem que você teste diferentes horários do dia para ver o desempenho do tráfego em diferentes intervalos de tempo. Isso é útil se você quiser ver quando seu melhor tráfego está em seu site, mas não é útil se as páginas estiverem sendo divididas por quem as vê E com variações diferentes.

Por exemplo, o tráfego do nosso próprio blog diminui nos fins de semana (como a maioria dos blogs de negócios).

Imagine se fizéssemos um teste de segunda a quarta na página de controle e mostrássemos o tráfego de sexta a domingo no tratamento? Teria um tráfego muito menor para testar e provavelmente resultados muito diferentes.

#20. Testando o tráfego errado para sua meta

Idealmente, ao executar um teste, você quer ter certeza de que está testando apenas um único segmento de seu público. Normalmente, são novos visitantes orgânicos, para ver como eles respondem pela primeira vez em seu site.

Às vezes, você pode querer testar visitantes repetidos, assinantes de e-mail ou até mesmo tráfego pago. O truque é testar apenas um deles de cada vez para que você possa obter uma representação precisa de como esse grupo se comporta com essa página.

Ao configurar seu teste, selecione o público com o qual deseja trabalhar e remova quaisquer outros que possam poluir o resultado, como visitantes recorrentes.

#21. Não excluir visitantes recorrentes em um teste e distorcer os resultados

Chamamos essa amostra de poluição.

Basicamente, se um visitante vê a página do seu site, retorna e vê sua variação, ele responderá de maneira muito diferente do que se apenas visse um deles.

Eles podem ficar confusos, rejeitar ou até mesmo converter mais, simplesmente por causa dessas interações extras.

O problema é que isso faz com que seus dados fiquem poluídos e menos precisos. Idealmente, você deseja usar uma ferramenta que randomize qual página eles veem, mas sempre mostre a mesma versão até que o teste termine.

#22. Não remover seus IPs do teste

Falando em poluição de amostra, aqui está outra maneira de poluir seus dados (e é uma boa prática para análise de qualquer maneira).

Certifique-se de bloquear você e os endereços IP de sua equipe de sua ferramenta de análise e teste. A última coisa que você quer é que você ou um membro da equipe 'check-in' em uma página e seja marcado em seu teste.

#23. Não segmentar as variações do grupo de controle (Efeito Rede)

Outra opção de poluição que é rara, mas pode acontecer, principalmente se você tiver uma rede para seu público.

Aqui está um exemplo.

Digamos que você tenha uma plataforma onde seu público possa se comunicar. Talvez uma página do Facebook ou seção de comentários, mas TODOS podem acessá-la.

Nessa situação, você pode ter pessoas vendo uma página e outras vendo uma variação, mas todas elas estão na mesma rede social. Isso pode realmente distorcer seus dados, pois eles podem afetar as escolhas e interações de cada um com a página. O Linkedin vem segmentando seu público ao testar novos recursos para evitar problemas de efeito de rede.

Idealmente, você deseja separar a comunicação entre os 2 grupos de teste até que o teste seja concluído.

#24. Execução de testes durante eventos sazonais ou grandes eventos de site/plataforma

A menos que você esteja testando para um evento sazonal, você nunca deseja executar uma campanha de teste durante as férias ou qualquer outro evento importante, como uma venda especial ou evento mundial.

Às vezes você não pode evitar. Você fará um teste e o Google apenas implementará uma nova atualização principal e mexerá com suas fontes de tráfego no meio da campanha *tosse*.

A melhor coisa a fazer é simplesmente executar novamente depois que tudo acabar.

#25. Ignorando as diferenças culturais

Você pode ter uma meta para uma página, mas também está executando uma campanha global com várias variações exibidas em diferentes idiomas e países.

Você precisa levar isso em consideração ao executar seu teste. Algumas mudanças podem ser feitas globalmente, como uma simples mudança de layout ou adição de sinais de confiança, etc.

Outras vezes, você precisa levar em conta os pontos de diferença culturais. Como as pessoas veem o layout, como veem as imagens e os avatares em sua página.

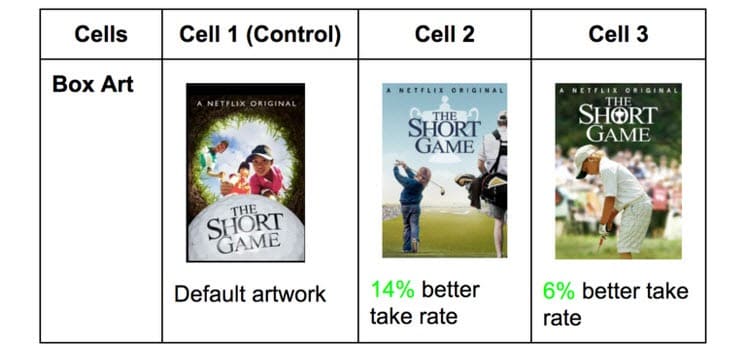

A Netflix faz isso com as miniaturas de todos os seus programas, testando diferentes elementos que podem atrair diferentes públicos (apresentando atores específicos famosos naquele país).

O que recebe cliques em um país pode ser incrivelmente diferente em outros. Você não sabe até que você teste embora!

#26. Executando várias campanhas conectadas ao mesmo tempo

É fácil ficar animado e querer executar vários testes ao mesmo tempo.

Apenas lembre-se: você pode executar vários testes para pontos semelhantes no processo de vendas ao mesmo tempo, mas não execute vários testes para vários pontos conectados no funil.

Aqui está o que quero dizer.

Você pode facilmente executar testes em todas as páginas de geração de leads que você possui, tudo ao mesmo tempo.

No entanto, você não gostaria de testar páginas de leads, páginas de vendas e páginas de checkout de uma só vez, pois isso pode introduzir muitos elementos diferentes em seu processo de teste, exigindo grandes volumes de tráfego e conversões para obter informações úteis.

Não só isso, mas cada elemento pode causar efeitos diferentes na página seguinte, tanto bons quanto ruins. A menos que você tenha centenas de milhares de visitantes por semana, provavelmente terá dificuldades para obter resultados precisos.

Portanto, seja paciente e teste apenas uma etapa de cada vez ou páginas que não estejam conectadas no processo.

Nota:

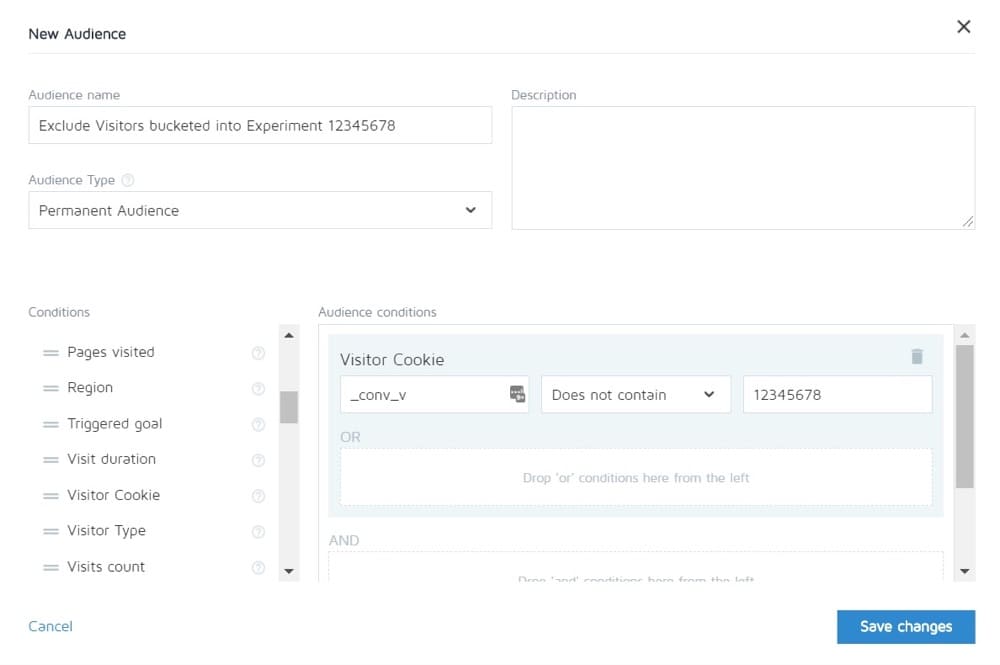

Converter permite que você exclua pessoas em um experimento de ver outros. Assim você pode, em teoria, testar todo o ciclo de vendas e depois ver apenas o controle das demais páginas.

#27. Ponderação de tráfego desigual

Não importa se você está executando um teste A/B, A/B/n ou multivariado. Você precisa alocar um volume de tráfego igual para cada versão para obter uma medição precisa.

Configure-os para serem iguais desde o início. A maioria das ferramentas permitirá que você faça isso.

Erros comuns de teste A/B que você pode cometer durante o teste

#28. Não executar por tempo suficiente para obter resultados precisos

Existem 3 fatores importantes a serem levados em consideração quando você deseja testar e obter resultados precisos:

- Significado estatístico,

- Ciclo de vendas e

- Tamanho da amostra.

Então vamos decompô-lo.

A maioria das pessoas termina os testes uma vez que sua ferramenta de teste lhes diz que um resultado é melhor que o outro E o resultado é estatisticamente significativo, ou seja, se o teste continuar a funcionar assim, então este é um vencedor definitivo.

A coisa é que você pode bater 'stat sig' muito rápido às vezes com apenas uma pequena quantidade de tráfego. Aleatoriamente todas as conversões acontecem em uma página e nenhuma na outra.

Mas nem sempre vai ficar assim. Pode ser que o teste foi lançado, é dia de pagamento e você conseguiu um monte de vendas naquele dia.

É por isso que precisamos levar em conta o ciclo de vendas. As vendas e o tráfego podem flutuar dependendo do dia da semana ou do mês. Para obter uma representação mais precisa de como seu teste está sendo executado, o ideal é que você execute entre 2 a 4 semanas.

Finalmente, você tem o tamanho da amostra.

Se você estiver executando seu teste por um mês, provavelmente obterá tráfego suficiente para obter resultados precisos. Muito pouco e o teste simplesmente não será capaz de lhe dar um nível de confiança de que ele funcionará como deveria.

Então, como regra geral,

- Ir para uma classificação de confiança de 95%.

- Corra por um mês.

- Descubra o tamanho da amostra que você precisa com antecedência e não pare o teste até que seja atingido OU você obtenha um resultado incrível que prova sem sombra de dúvida que você tem um vencedor.

#29. Monitoramento/espreitadela de helicóptero

Espreitar é um termo usado para descrever quando um testador dá uma olhada em seu teste para ver como ele está se saindo.

Idealmente, nunca queremos olhar para o nosso teste uma vez em execução, e nunca tomamos uma decisão sobre ele até que termine um ciclo completo, com o tamanho de amostra correto e tenha atingido a significância estatística.

No entanto... E se o teste não estiver em execução?

E se algo estiver quebrado?

Bem, nesse caso, você realmente não quer esperar um mês para ver que está quebrado, certo? É por isso que sempre verifico se um teste está obtendo resultados no controle e na variação, 24 horas depois de configurá-lo para ser executado.

Se eu puder ver que eles estão recebendo tráfego e recebendo cliques/conversões, então eu saio e deixo isso acontecer. Não tomo nenhuma decisão até que o teste tenha terminado.

#30. Não rastrear o feedback do usuário (especialmente importante se o teste estiver afetando uma ação direta e imediata)

Digamos que o teste está recebendo cliques e o tráfego é distribuído, então *parece* que está funcionando, mas de repente você começa a receber relatórios de que as pessoas não conseguem preencher o formulário de vendas. (Ou melhor ainda, você recebeu um alerta automatizado de que uma métrica de proteção caiu muito abaixo dos níveis aceitáveis.)

Bem, então seu primeiro pensamento deve ser que algo está quebrado.

Não é sempre. Você pode estar recebendo cliques de um público que não combina com sua oferta, mas, por precaução, vale a pena verificar esse formulário.

Se estiver quebrado, conserte e reinicie.

#31. Fazendo alterações no meio do teste

Pode ter ficado claro a partir desses últimos pontos, mas nunca queremos fazer alterações em um teste depois que ele estiver ativo.

Claro, algo pode quebrar, mas essa é a única mudança que devemos fazer. Não alteramos o design, nem copiamos, nem nada.

Se o teste estiver funcionando, deixe-o rodar e deixe os dados decidirem o que funciona.

#32. Alterando a porcentagem de alocação de tráfego no meio do teste ou removendo os de baixo desempenho

Assim como não alteramos as páginas que estão sendo testadas, também não removemos nenhuma variação nem alteramos a distribuição de tráfego no meio do teste.

Por quê?

Digamos que você esteja executando um teste A/B/n com um controle e 3 variações. Você começa o teste e depois de uma semana você dá uma espiada e percebe que 2 versões estão indo muito bem e uma está indo mal.

Agora seria tentador desligar a variação 'perdedora' e redistribuir o tráfego entre as outras variações, certo? Caramba… você pode até querer pegar esses 25% extras do tráfego e apenas enviá-lo para o melhor desempenho, mas não faça isso.

Por quê?

Essa redistribuição não apenas afetará o desempenho do teste, mas também afetará diretamente os resultados e como eles aparecem na ferramenta de relatórios.

Todos os usuários que foram previamente agrupados para a variante removida precisarão ser realocados para uma variante e verão uma página da Web alterada em um curto período de tempo, o que pode afetar o comportamento e as escolhas subsequentes.

É por isso que você nunca altera o tráfego ou desativa as variações no meio do caminho. (E também por que você não deveria estar espiando!)

#33. Não interromper um teste quando você tem resultados precisos

Às vezes você simplesmente esquece de parar um teste!

Ele continua funcionando e alimentando 50% do seu público para uma página mais fraca e 50% para o vencedor. Ops!

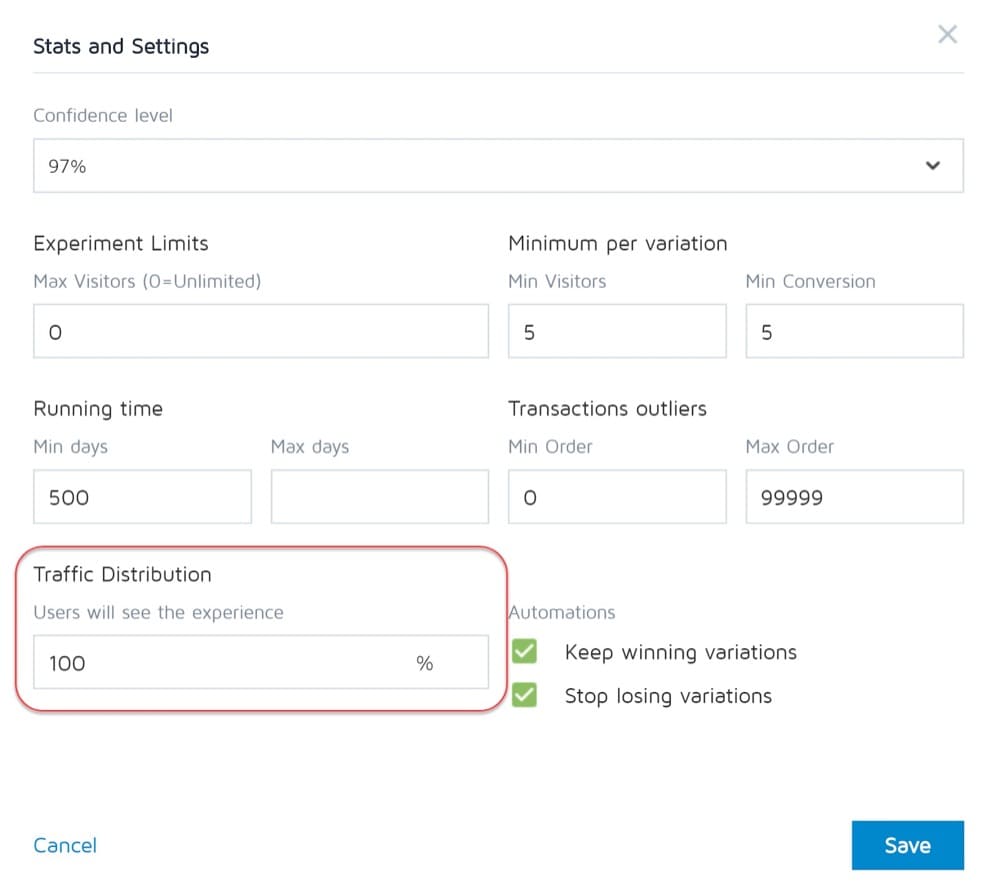

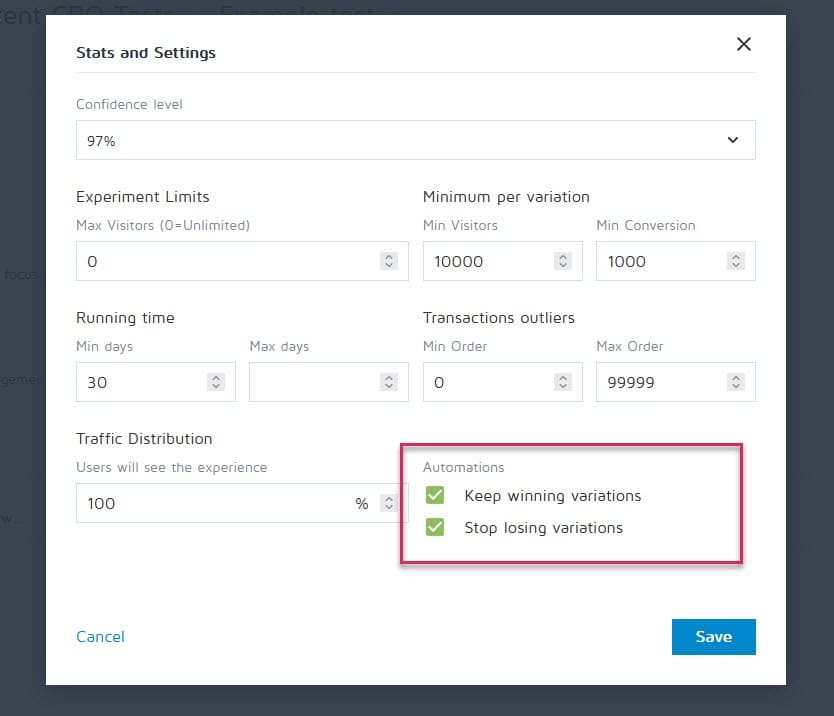

Felizmente, ferramentas como o Convert Experiences podem ser configuradas para interromper uma campanha e mostrar automaticamente o vencedor assim que atingir determinados critérios (como tamanho da amostra, estatísticas, conversões e prazo).

#34. Estar emocionalmente investido em perder variações

Como testadores, precisamos ser imparciais. Às vezes, no entanto, você pode ter um design ou ideia em particular que adora e está convencido de que deveria ter vencido, então continua estendendo o teste cada vez mais para ver se ele avança.

Puxe o curativo.

Você pode ter uma boa ideia que só precisa melhorar, mas não pode fazer isso até terminar o teste atual.

#35. Executando testes por muito tempo e o rastreamento cai

Aqui está outro problema de poluição de amostra potencial.

Se você executar um teste por mais de 4 semanas, é possível que os cookies dos usuários caiam. Isso pode causar falta de rastreamento de eventos, mas eles podem até retornar e poluir os dados da amostra novamente.

#36. Não usar uma ferramenta que permita interromper/implementar o teste!

Outro problema raro.

Alguns programas de teste insistem em criar testes codificados. ou seja, um desenvolvedor e um engenheiro criam a campanha do zero.

Não é ótimo, no entanto, quando o teste termina e você precisa esperar que o mesmo desenvolvedor o desligue e instale a variação vencedora. Isso não é apenas frustrante, mas pode diminuir seriamente o número de testes que você pode executar e até mesmo o ROI da página enquanto espera que ela seja lançada.

Erros comuns de teste A/B que você pode cometer após o término do teste

#37. Desistindo depois de um teste!

9 em cada 10 testes são geralmente um fracasso.

Isso significa que você precisa executar 10 testes para obter esse vencedor. É preciso esforço, mas sempre vale a pena, então não pare depois de uma campanha!

#38. Desistir de uma boa hipótese antes de testar todas as versões dela

Uma falha pode simplesmente significar que sua hipótese está correta, mas precisa ser melhor executada.

Experimente novas formas, novos designs, novo layout, novas imagens, novos avatares, nova linguagem. Você tem a ideia e vê se consegue executá-la melhor.

Foram necessárias 21 iterações do CXL para melhorar a página do cliente, mas levaram de uma taxa de conversão de 12,1% para 79,3%.

#39. Esperando grandes vitórias o tempo todo

O fato é que você só pode obter uma grande vitória 1 em cada 10 ou mais campanhas vencedoras.

Isso está bem. Continuamos testando e melhorando, porque até 1% aumenta os compostos ao longo do tempo. Melhore-o e chegue a 2% e agora você dobrou a eficácia.

Quais tipos de testes produzem os melhores resultados?

A verdade é que diferentes experimentos têm efeitos variados. De acordo com a pesquisa de Jakub Linowski em mais de 300 testes, os experimentos de layout tendem a levar a melhores resultados.

Qual é o tipo de tela mais difícil de otimizar? A mesma pesquisa revela suas telas de checkout (com um efeito médio de +0,4% em 25 testes).

#40. Não verificar a validade após o teste

Assim, o teste está terminado. Você correu por tempo suficiente, viu resultados e obteve estatísticas, mas pode confiar na precisão dos dados?

Pode ser que algo tenha quebrado no meio do teste. Nunca é demais verificar.

#41. Não ler os resultados corretamente

O que seus resultados estão realmente lhe dizendo? Deixar de lê-los corretamente pode facilmente levar um vencedor em potencial e parecer um fracasso completo.

- Mergulhe profundamente em suas análises.

- Olhe para todos os dados qualitativos que você tem.

O que funcionou e o que não funcionou? Por que aconteceu?

Quanto mais você entender seus resultados, melhor.

#42. Não olhar os resultados por segmento

Sempre vale a pena mergulhar um pouco mais fundo.

Por exemplo, uma nova variante pode parecer estar convertendo mal, mas em dispositivos móveis, ela tem um aumento de 40% nas conversões!

Você só pode descobrir isso segmentando-o em seus resultados. Olhe para os dispositivos usados e os resultados lá. Você pode encontrar alguns insights valiosos!

Apenas esteja ciente da importância do tamanho do seu segmento. Você pode não ter tráfego suficiente para cada segmento para confiar totalmente nele, mas sempre pode executar um teste somente para dispositivos móveis (ou qualquer canal) e ver como ele se comporta.

#43. Não aprender com os resultados

Perder testes pode fornecer informações sobre onde você precisa melhorar ainda mais ou fazer mais pesquisas. A coisa mais irritante como CRO é ver clientes que se recusam a aprender com o que acabaram de ver. Eles têm os dados, mas não os usam...

#44. Tomando os perdedores

Ou pior, eles assumem a variação perdedora.

Talvez eles prefiram o design e a taxa de conversão seja apenas 1% diferente, mas com o tempo esses efeitos se agravam. Tome essas pequenas vitórias!

#45. Não agir sobre os resultados

Pior ainda?

Conseguir uma vitória, mas não implementá-la! Eles têm os dados e simplesmente não fazem nada com eles. Sem mudanças, sem insights e sem novos testes.

#46. Não iterar e melhorar as vitórias

Às vezes você pode pegar uma carona, mas há mais a ser feito. Como dissemos anteriormente, é muito raro que cada vitória lhe dê um aumento de dois dígitos.

Mas isso não significa que você não pode chegar lá executando novas iterações e melhorias e subindo 1% de cada vez.

Tudo se soma, então continue melhorando!

#47. Não compartilhar descobertas vencedoras em outras áreas ou departamentos

Uma das maiores coisas que vemos com equipes de CRO hiper-bem-sucedidas/maduras é que elas compartilham seus ganhos e descobertas com outros departamentos da empresa.

Isso dá a outros departamentos insights sobre como eles também podem melhorar.

- Encontre alguma cópia da página de vendas vencedora? Pré-enquadre-o em seus anúncios para levá-los à página!

- Encontre um estilo de isca digital que funcione muito bem? Teste-o em todo o site.

#48. Não testar essas mudanças em outros departamentos

E essa é a chave aqui. Mesmo que você compartilhe insights com outros departamentos, você ainda deve testar para ver como funciona.

Um design de estilo que dá sustentação em uma área pode dar uma queda em outras, então sempre teste!

#49. Muita iteração em uma única página

Chamamos isso de atingir o 'máximo local'.

A página em que você está executando os testes atingiu um platô e você simplesmente não consegue obter mais impulso com isso.

Você pode tentar redesenhos radicais, mas e depois?

Basta passar para outra página no processo de vendas e melhorar isso. (Ironicamente, isso pode realmente fornecer um ROI mais alto de qualquer maneira.)

Tirar uma página de vendas de uma conversão de 10% a 11% pode ser menos importante do que levar a página que direciona o tráfego para ela de 2% a 5%, pois você basicamente mais que dobrará o tráfego na página anterior.

Em caso de dúvida, encontre o próximo teste mais importante da sua lista e comece a melhorar lá. Você pode até achar que isso ajuda na conversão nessa página travada, simplesmente alimentando melhores perspectivas para ela.

#50. Não testando o suficiente!

Os testes levam tempo e há apenas tantos que podemos executar de uma só vez.

Então o que nós podemos fazer?

Simplesmente reduza o tempo de inatividade entre os testes!

Conclua um teste, analise o resultado e repita ou execute um teste diferente. (Idealmente, coloque-os na fila e prontos para ir).

Desta forma, você verá um retorno muito maior para o seu investimento de tempo.

#51. Não documentar testes

Outro hábito que as equipes de CRO maduras têm é criar um banco de dados interno de testes, que inclui dados sobre a página, a hipótese, o que funcionou, o que não funcionou, o aumento, etc.

Não apenas você pode aprender com os testes mais antigos, mas também pode impedir que você execute novamente um teste por acidente.

#52. Esquecer os falsos positivos e não checar duas vezes grandes campanhas de aumento

Às vezes, um resultado é bom demais para ser verdade. Ou algo foi configurado ou gravação errada, ou isso acontece de 1 em 20 testes que dão um falso positivo.

Então o que você pode fazer?

Simplesmente execute novamente o teste, defina um nível de confiança alto e certifique-se de executá-lo por tempo suficiente.

#53. Não acompanhar os resultados da linha descendente

Ao acompanhar os resultados do seu teste, também é importante lembrar seu objetivo final e acompanhar as métricas da linha descendente antes de decidir sobre um vencedor.

Uma nova variante pode tecnicamente obter menos cliques, mas gera mais vendas das pessoas que clicam.

Nesse caso, essa página seria realmente mais lucrativa de ser executada, supondo que o tráfego que os cliques continuem a converter também…

#54. Deixar de levar em conta os efeitos de primazia e novidade, o que pode influenciar os resultados do tratamento

Digamos que você não esteja apenas segmentando novos visitantes com uma alteração, mas todo o tráfego.

Ainda estamos segmentando-os para que 50% vejam o original e 50% vejam a nova versão, mas estamos permitindo que visitantes anteriores entrem na campanha. Isso significa que as pessoas que viram seu site antes, leram seu conteúdo, viram suas chamadas para ação etc.

Além disso, durante a campanha, eles veem apenas sua versão de teste específica.

Quando você faz uma nova mudança, ela pode realmente ter um efeito de novidade em seu público anterior.

Talvez eles vejam o mesmo CTA o tempo todo e agora simplesmente ignorem, certo? Nesse caso, um novo botão ou design de CTA pode realmente ver um aumento de visitantes anteriores, não porque eles querem mais agora, mas porque é novo e interessante.

Às vezes, você pode até receber mais cliques porque o layout mudou e eles estão explorando o design.

Por causa disso, você geralmente obterá um aumento inicial em resposta, mas que diminui com o tempo.

A chave ao executar seu teste é segmentar o público depois e ver se os novos visitantes estão respondendo tão bem quanto os antigos.

Se for muito menor, pode ser um efeito de novidade com os usuários antigos clicando ao redor. Se estiver em um nível semelhante, você pode ter um novo vencedor em suas mãos.

De qualquer forma, deixe-o funcionar por todo o ciclo e equilibre-se.

#55. Alterações no período de consideração em execução

Outra coisa a considerar ao testar é qualquer variante que possa alterar o período de consideração do público.

O que quero dizer?

Digamos que você normalmente não consiga vendas imediatas. Os leads podem estar em um ciclo de vendas de 30 dias ou até mais.

Se você estiver testando uma chamada para ação que afeta diretamente o tempo de reflexão e compra, isso irá distorcer seus resultados. Por um lado, seu controle pode obter vendas, mas estar fora do período de teste, então você as perde.

Outro cenário é se você tiver um CTA que oferece um acordo, um preço de qualquer outra coisa que os faça querer agir agora, então isso quase sempre distorcerá seus resultados para fazer com que esta versão pareça estar convertendo muito melhor.

Tenha isso em mente e analise suas análises durante e após o teste para ter certeza.

#56. Não reteste após o tempo X

Isso é menos sobre uma certa página ou erro de teste, mas mais sobre a filosofia de teste.

Sim, você pode ter uma página incrível e sim, você pode ter feito 20 iterações para chegar onde está hoje.

O problema é que em alguns anos você pode precisar revisar toda a página novamente. Mudança de ambientes, linguagem e termos utilizados, o produto pode ser ajustado.

Esteja sempre pronto para voltar a uma campanha antiga e testar novamente. (Outra razão pela qual ter um repositório de testes funciona muito bem.)

#57. Apenas testando o caminho e não o produto

Quase todos nós nos concentramos no caminho para a venda e testamos isso. Mas a realidade é que o produto também pode ser testado e aprimorado A/B e pode até oferecer um aumento maior.

Pense no iPhone.

A Apple testou seu site e melhorou nele, mas são as iterações e melhorias do produto que continuam a impulsionar ainda mais.

Agora, você pode não ter um produto físico. Você pode ter um programa ou oferta digital, mas aprender mais sobre as necessidades do seu público e testá-lo e levá-lo de volta à sua página de vendas pode ser ENORME em termos de aumento.

Conclusão

Então aí está. Os 57 erros de teste A/B comuns e incomuns que vemos e como você pode evitá-los.

Você pode usar este guia para evitar esses problemas em todas as campanhas futuras.