Nowhere Left to Hide: Bloqueando o conteúdo das aranhas do mecanismo de pesquisa

Publicados: 2022-06-12TL;DR

- Se você está pensando em excluir conteúdo dos mecanismos de pesquisa, primeiro verifique se está fazendo isso pelos motivos certos.

- Não cometa o erro de supor que você pode ocultar conteúdo em um idioma ou formato que os bots não compreenderão; essa é uma estratégia míope. Seja honesto com eles usando o arquivo robots.txt ou a tag Meta Robots.

- Não se esqueça de que só porque você está usando os métodos recomendados para bloquear conteúdo, você está seguro. Entenda como o bloqueio de conteúdo fará com que seu site apareça para os bots.

Quando e como excluir conteúdo de um índice de mecanismo de pesquisa

Uma faceta importante do SEO é convencer os mecanismos de pesquisa de que seu site é respeitável e fornece valor real para os pesquisadores. E para que os mecanismos de busca determinem o valor e a relevância do seu conteúdo, eles precisam se colocar no lugar do usuário.

Agora, o software que analisa seu site tem certas limitações que os SEOs tradicionalmente exploram para manter certos recursos ocultos dos mecanismos de pesquisa. Os bots continuam a se desenvolver, no entanto, e estão cada vez mais sofisticados em seus esforços para ver sua página da web como um usuário humano faria em um navegador. É hora de reexaminar o conteúdo do seu site que não está disponível para os robôs dos mecanismos de pesquisa, bem como os motivos pelos quais ele está indisponível. Ainda existem limitações nos bots e os webmasters têm motivos legítimos para bloquear ou externalizar determinados conteúdos. Como os mecanismos de busca estão procurando por sites que forneçam conteúdo de qualidade aos usuários, deixe a experiência do usuário guiar seus projetos e o resto se encaixará.

Por que bloquear conteúdo?

- Conteúdo privado. Obter páginas indexadas significa que elas estão disponíveis para serem exibidas nos resultados de pesquisa e, portanto, visíveis ao público. Se você tiver páginas privadas (informações de contas de clientes, informações de contato de indivíduos, etc.), você deseja mantê-las fora do índice. (Alguns sites do tipo whois exibem informações do registrante em JavaScript para impedir que bots raspadores roubem informações pessoais.)

- Conteúdo duplicado. Sejam snippets de texto (informações de marca registrada, slogans ou descrições) ou páginas inteiras (por exemplo, resultados de pesquisa personalizados em seu site), se você tiver conteúdo que aparece em vários URLs em seu site, os spiders do mecanismo de pesquisa poderão ver isso como de baixa qualidade . Você pode usar uma das opções disponíveis para impedir que essas páginas (ou recursos individuais em uma página) sejam indexadas. Você pode mantê-los visíveis para os usuários, mas bloqueados nos resultados da pesquisa, o que não prejudicará suas classificações para o conteúdo que você deseja que apareça na pesquisa.

- Conteúdo de outras fontes. Conteúdo, como anúncios, que são gerados por fontes de terceiros e duplicados em vários lugares da Web, não fazem parte do conteúdo principal de uma página. Se o conteúdo do anúncio for duplicado muitas vezes em toda a web, um webmaster pode querer impedir que os anúncios sejam visualizados como parte da página.

Isso cuida do porquê, que tal como?

Estou tão feliz que você perguntou. Um método que tem sido usado para manter o conteúdo fora do índice é carregar o conteúdo de uma fonte externa bloqueada usando uma linguagem que os bots não podem analisar ou executar; é como quando você soletra palavras para outro adulto porque não quer que a criança na sala saiba do que você está falando. O problema é que a criança nessa situação está ficando mais esperta. Por muito tempo, se você quisesse ocultar algo dos mecanismos de pesquisa, poderia usar JavaScript para carregar esse conteúdo, o que significa que os usuários o entendem, os bots não.

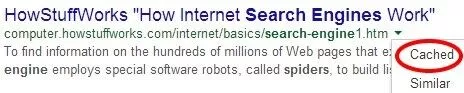

Mas o Google não está sendo tímido sobre seu desejo de analisar JavaScript com seus bots. E eles estão começando a fazer isso; a ferramenta Fetch as Google nas Ferramentas do Google para webmasters permite que você veja páginas individuais como os bots do Google as veem.

Se você estiver usando JavaScript para bloquear conteúdo em seu site, verifique algumas páginas nesta ferramenta; as chances são, o Google vê.

No entanto, lembre-se de que só porque o Google pode renderizar conteúdo em JavaScript não significa que o conteúdo está sendo armazenado em cache. A ferramenta “Fetch and Render” mostra o que o bot pode ver; para descobrir o que está sendo indexado, você ainda deve verificar a versão em cache da página.

Existem muitos outros métodos para externalizar conteúdo que as pessoas discutem: iframes, AJAX, jQuery. Mas já em 2012, experimentos mostravam que o Google podia rastrear links colocados em iframes; então lá vai essa técnica. Na verdade, os dias de falar uma língua que os bots não conseguiam entender estão chegando ao fim.

Mas e se você pedir educadamente aos bots para evitar olhar para certas coisas? Bloquear ou não permitir elementos em seu robots.txt ou uma tag Meta Robots é a única maneira certa (exceto diretórios de servidor de proteção por senha) de impedir que elementos ou páginas sejam indexados.

John Mueller comentou recentemente que o conteúdo gerado com feeds AJAX/JSON seria “invisível para [Google] se você não permitisse o rastreamento de seu JavaScript”. Ele ainda esclarece que simplesmente bloquear CSS ou JavaScript não necessariamente prejudicará sua classificação: “Definitivamente, não há um relacionamento simples de 'CSS ou JavaScript não permitido de rastreamento, portanto, os algoritmos de qualidade veem o site negativamente'”. Portanto, a melhor maneira de manter o conteúdo fora do índice é simplesmente pedir aos mecanismos de pesquisa que não indexem seu conteúdo. Isso pode ser URLs individuais, diretórios ou arquivos externos.

Isso, então, nos traz de volta ao início: por quê. Antes de decidir bloquear qualquer conteúdo seu, certifique-se de saber por que está fazendo isso, bem como os riscos. Em primeiro lugar, bloquear seus arquivos CSS ou JavaScript (especialmente aqueles que contribuem substancialmente para o layout do seu site) é arriscado; ele pode, entre outras coisas, impedir que os mecanismos de pesquisa vejam se suas páginas estão otimizadas para celular. Não apenas isso, mas após o lançamento do Panda 4.0, alguns sites que foram duramente atingidos conseguiram se recuperar desbloqueando seu CSS e JavaScript, o que indicaria que eles foram especificamente visados pelo algoritmo do Google para bloquear esses elementos de bots.

Mais um risco que você corre ao bloquear conteúdo: os spiders dos mecanismos de pesquisa podem não conseguir ver o que está sendo bloqueado, mas eles sabem que algo está sendo bloqueado, então eles podem ser forçados a fazer suposições sobre o que é esse conteúdo. Eles sabem que os anúncios, por exemplo, muitas vezes estão ocultos em iframes ou mesmo em CSS; portanto, se você tiver muito conteúdo bloqueado perto do topo de uma página, corre o risco de ser atingido pelo algoritmo de layout de página “Top Heavy”. Qualquer webmaster que esteja lendo isso e esteja pensando em usar iframes deve considerar fortemente consultar um SEO respeitável primeiro. (Insira uma promoção sem vergonha do BCI aqui.)