Otimize seus esforços de SEO com as melhores ferramentas de gerador de txt para robôs: as 5 principais opções para profissionais

Publicados: 2023-06-15A otimização do mecanismo de pesquisa (SEO) continua sendo parte integrante do sucesso online no cenário digital em constante evolução. Como os profissionais de SEO se esforçam para melhorar a visibilidade do site e as classificações nas páginas de resultados do mecanismo de pesquisa (SERPs), eles contam com várias estratégias e ferramentas para otimizar seus sites. Uma dessas ferramentas essenciais no arsenal de SEO é o arquivo Robots.txt.

O arquivo Robots.txt desempenha um papel crucial ao orientar os rastreadores dos mecanismos de pesquisa sobre como navegar e indexar o conteúdo de um site.

Ao utilizar esse arquivo, os proprietários de sites podem controlar com eficiência quais partes do site devem ser acessíveis aos mecanismos de pesquisa e quais devem ser mantidas privadas. A criação de um arquivo Robots.txt bem otimizado requer precisão e atenção aos detalhes, e é por isso que os profissionais de SEO geralmente recorrem às ferramentas geradoras do Robots.txt.

Este blog explorará as cinco principais ferramentas e diretórios geradores de Robots.txt que todo profissional de SEO deve considerar incorporar em seu fluxo de trabalho.

Compreendendo a importância dos arquivos robots.txt

Robots.txt é um arquivo vital que orienta os mecanismos de pesquisa sobre como rastrear e indexar sites. Colocado na pasta raiz de um site, ele permite que os proprietários do site se comuniquem com rastreadores de mecanismos de pesquisa, como o Googlebot, especificando quais partes do site devem ser rastreadas e indexadas e quais devem ser excluídas.

Ao gerenciar adequadamente os arquivos robots.txt, os proprietários de sites podem garantir que seus sites sejam indexados com eficiência e mantenham uma boa experiência do usuário.

5 melhores ferramentas de gerador de texto de robôs

A criação manual de um arquivo robots.txt pode ser demorada e sujeita a erros. Para tornar o processo mais fácil e preciso, várias ferramentas geradoras de robots.txt estão disponíveis para fazer o trabalho para você. Aqui estão as 5 principais ferramentas geradoras de robots.txt:

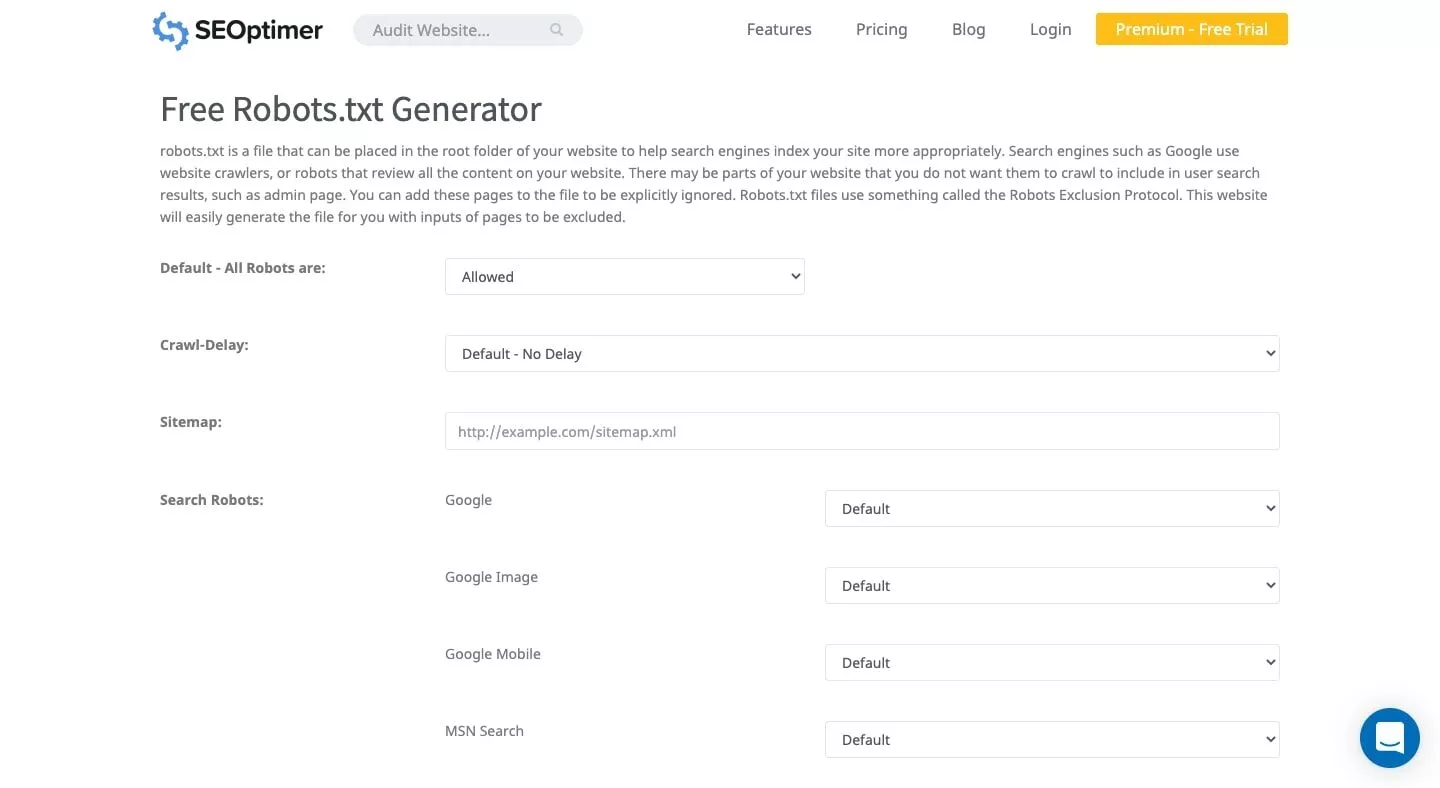

1. SEOptimer

O SEOptimer oferece uma interface de usuário limpa, permitindo que você crie um arquivo robots.txt gratuitamente. Você pode definir um período de atraso de rastreamento e especificar quais bots são permitidos ou recusados a rastrear seu site usando esta ferramenta fácil de usar. O arquivo gerado pode ser baixado e adicionado à pasta raiz do seu site.

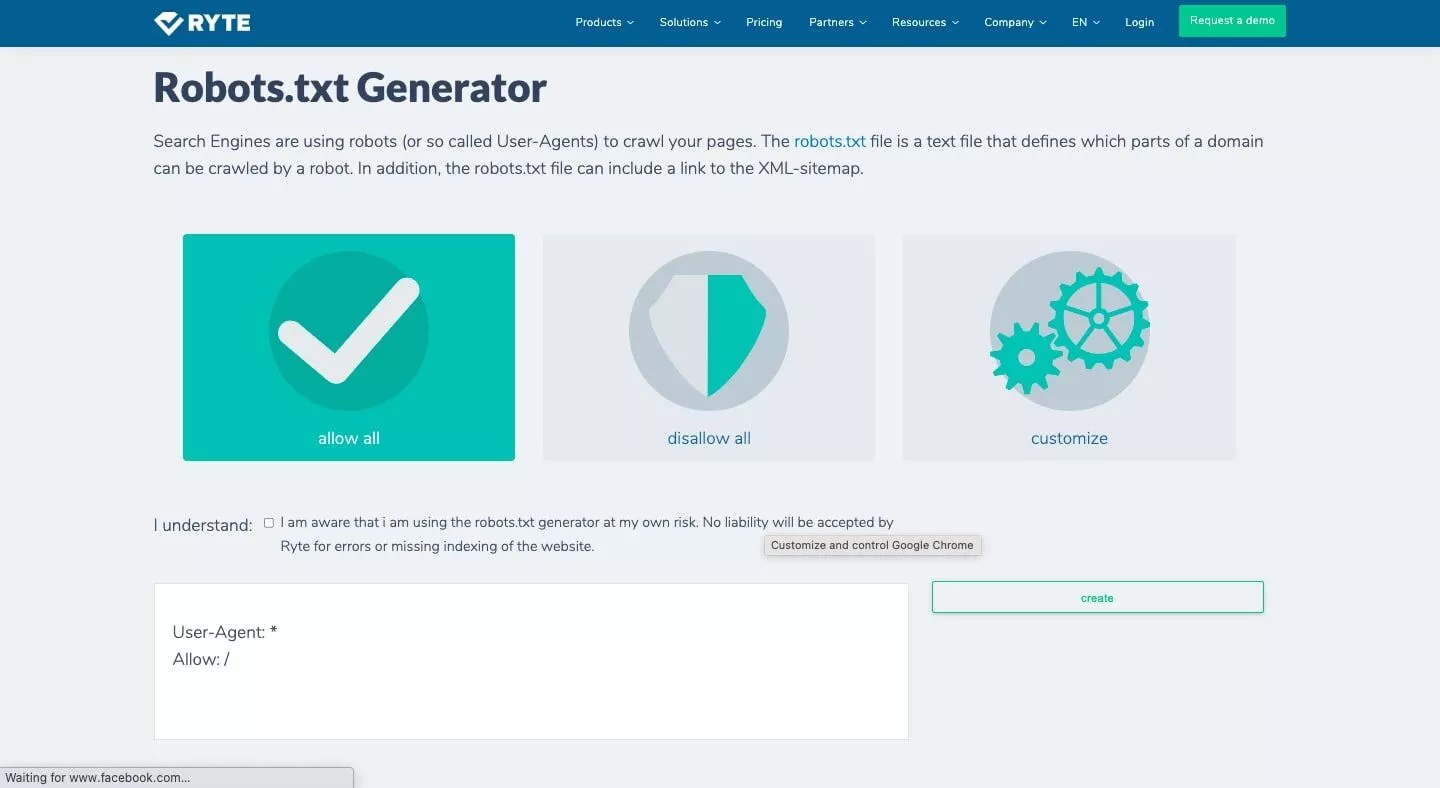

2. Ryte

O gerador/verificador gratuito do Ryte oferece três opções para gerar um arquivo robots.txt: permitir tudo, proibir tudo e personalizar. A opção de personalização permite especificar quais bots você deseja afetar e inclui instruções passo a passo. Este gerador de arquivo robots txt garante uma análise abrangente do seu site e ajuda a criar um arquivo robots.txt bem estruturado.

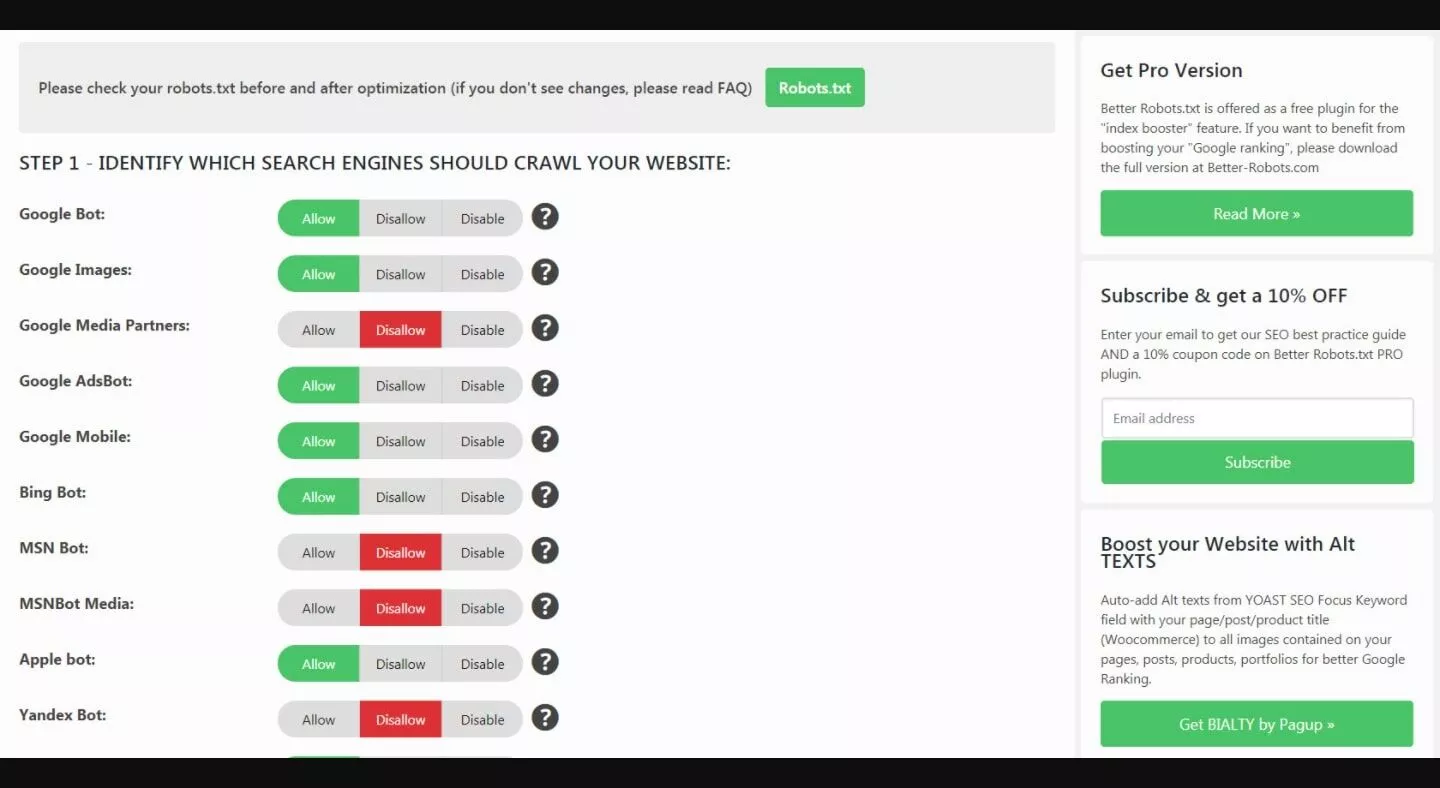

3. Melhor Robots.txt (WordPress)

O plug-in Better Robots.txt WordPress ajuda a impulsionar o SEO do seu site e os recursos de carregamento. Suportado em 7 idiomas, pode proteger seus dados e conteúdo de bots ruins. Este plug-in foi projetado especificamente para sites WordPress, tornando-o uma excelente opção para proprietários de sites que usam a plataforma WordPress.

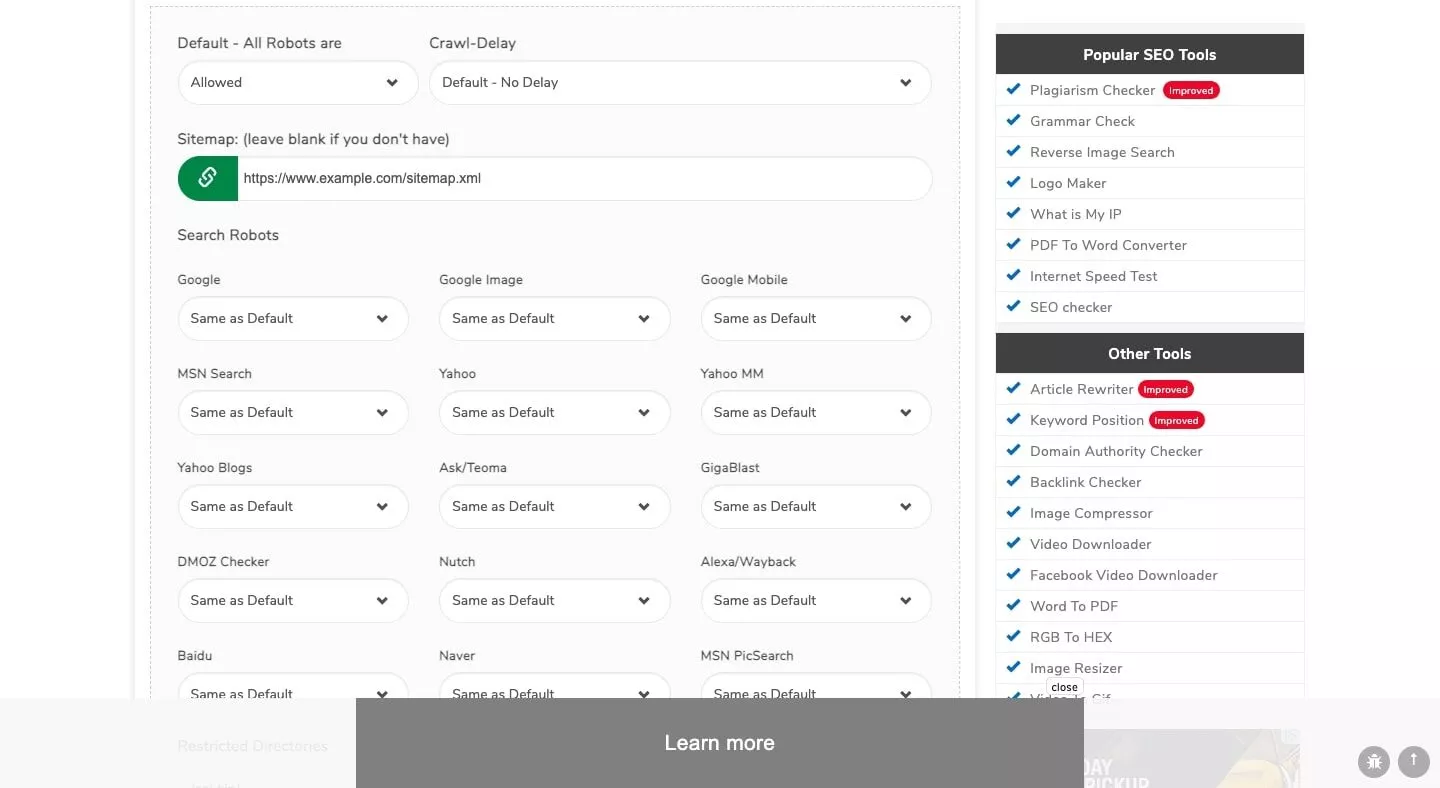

4. Pequenas ferramentas de SEO

O gerador do Small SEO Tools vem com uma interface simples, permitindo que você crie um arquivo robots.txt sem esforço. A ferramenta usa barras suspensas para as preferências de cada bot diferente, permitindo que você selecione 'permitido' ou 'recusado' para cada bot. Este gerador faz parte de um conjunto de ferramentas e recursos de SEO fornecidos pelo Small SEO Tools.

5. Testador de robots.txt do Google Search Console

O Google Search Console apresenta um testador de robots.txt que você pode usar depois de gerar seu arquivo robots.txt. Envie o URL do seu site para a ferramenta do testador para verificar se ele está formatado corretamente para bloquear o Googlebot de determinados elementos que você deseja ocultar.

Essa ferramenta oficial do Google e um dos melhores verificadores de mapa do site garante que seu arquivo de texto esteja em conformidade com as diretrizes do Google e seja eficaz no gerenciamento do acesso do rastreador.

Principais recursos a serem procurados em um gerador Robots.txt

Ao selecionar uma ferramenta geradora de robots.txt, considere os seguintes recursos:

1. Facilidade de uso: A ferramenta deve ter uma interface amigável, permitindo que você crie e gerencie seu arquivo robots.txt com o mínimo de esforço.

2. Opções de personalização: O gerador deve oferecer opções de personalização, como especificar quais bots podem acessar seu site e definir períodos de atraso de rastreamento.

3. Compatibilidade : certifique-se de que a ferramenta seja compatível com a plataforma do seu site, como WordPress, para integração e funcionalidade perfeitas.

4. Suporte a idiomas: se o seu site atende a um público que não fala inglês, a ferramenta deve oferecer suporte a vários idiomas.

5. Recursos adicionais: Alguns geradores vêm com ferramentas e recursos adicionais de SEO que podem ajudá-lo a otimizar ainda mais o desempenho do seu site.

Fatores a considerar ao escolher um gerador de robots.txt

Além dos principais recursos mencionados acima, considere os seguintes fatores ao selecionar uma ferramenta geradora de robots.txt:

1. Os requisitos específicos do seu site: Dependendo da estrutura e do conteúdo do seu site, você pode precisar de uma ferramenta que ofereça opções de personalização mais avançadas ou melhor integração com a sua plataforma.

2. Seu nível de especialização: Se você é novo em SEO ou no gerenciamento de arquivos robots.txt, opte por uma ferramenta com uma interface direta e instruções claras. Por outro lado, usuários experientes podem preferir uma ferramenta que ofereça recursos mais avançados e opções de personalização.

3. Suporte e atualizações: escolha uma ferramenta que receba atualizações regulares e ofereça suporte confiável ao cliente para solucionar quaisquer problemas que você possa encontrar.

4. Orçamento: Embora muitas ferramentas geradoras de robots.txt estejam disponíveis gratuitamente, algumas ferramentas premium podem oferecer recursos e benefícios adicionais. Considere seu orçamento ao selecionar a ferramenta certa para suas necessidades.

O Papel do Robots.txt na Otimização de Mecanismos de Busca (SEO)

Robots.txt desempenha um papel crítico no SEO, ajudando os rastreadores do mecanismo de pesquisa a indexar seu site com mais eficiência. O gerenciamento adequado do arquivo robots.txt garante que os mecanismos de pesquisa deem prioridade às páginas mais importantes do site, excluindo conteúdo irrelevante ou duplicado.

Isso ajuda a melhorar a visibilidade do seu site nos resultados de pesquisa, levando ao aumento do tráfego orgânico e a uma melhor experiência do usuário. Além disso, um arquivo robots.txt bem estruturado ajuda a economizar o orçamento de rastreamento, evitando que os rastreadores dos mecanismos de pesquisa sobrecarreguem seu servidor ou percam tempo em páginas sem importância.

Isso, por sua vez, garante uma indexação mais rápida do conteúdo importante do seu site e contribui positivamente para o desempenho geral de SEO do seu site.

Conclusão

O gerenciamento do arquivo robots.txt do seu site é crucial para otimizar o rastreamento e a indexação do mecanismo de pesquisa. Ao usar uma ferramenta geradora de robots.txt confiável, você pode criar e gerenciar seu arquivo com eficiência, garantindo um melhor desempenho de SEO para seu site.

As ferramentas geradoras de robots.txt mencionadas acima, como SEOptimer, Ryte, Better Robots.txt (WordPress), Small SEO Tools e Google Search Console Robots.txt Tester, podem ajudá-lo a criar um arquivo robots.txt eficaz que atenda às suas requisitos específicos do site.

Considere os principais recursos, preços e fatores adicionais mencionados neste artigo ao escolher a melhor ferramenta geradora de robots.txt para suas necessidades.

Sobre Scalenut

Scalenut é uma plataforma de SEO e marketing de conteúdo com inteligência artificial que revolucionou o processo de criação e otimização de conteúdo. Essa ferramenta flexível otimiza todo o fluxo de trabalho, incluindo formulação de estratégia de conteúdo, geração precisa de resumos, criação de conteúdo cativante e otimização de SEO eficiente. Ao oferecer um período de avaliação de 7 dias , o Scalenut permite que os usuários explorem sua ampla gama de recursos e desbloqueiem todo o seu poder.