Apresentando Fin: o inovador chatbot AI da Intercom, construído em GPT-4

Publicados: 2023-03-15A chegada do ChatGPT da OpenAI transformou tudo – as enormes implicações para o atendimento ao cliente ficaram imediatamente óbvias.

Rapidamente lançamos uma coleção de recursos de IA para nosso Inbox, aplicando essa tecnologia para entregar ganhos de eficiência. Mas a primeira coisa que nos perguntaram foi “O ChatGPT pode apenas responder às perguntas dos meus clientes?” Era tão claro que era melhor entender a linguagem natural do que qualquer coisa que tínhamos visto antes.

Infelizmente, nossas explorações iniciais mostraram que as alucinações eram um problema muito grande. O GPT-3.5, que alimentava o ChatGPT, era muito propenso a inventar coisas quando não sabia a resposta.

Mas o recente anúncio do GPT-4 mudou as coisas – este modelo foi projetado para reduzir alucinações. Estamos empolgados em compartilhar o que construímos com o GPT-4 em nossos primeiros testes.

Apresentamos nosso novo chatbot de IA: Fin

Hoje estamos anunciando que construímos um bot de atendimento ao cliente com inteligência artificial que possui os benefícios dessa nova tecnologia e é adequado para as necessidades de negócios. Chama-se Fin e acreditamos que ele tem a capacidade de se tornar um parceiro valioso para sua equipe de suporte.

Quando começamos a experimentar a construção de um chatbot com tecnologia GPT, tínhamos vários objetivos de design em mente. Queríamos construir um bot que pudesse:

- Converse naturalmente, usando a tecnologia GPT.

- Responda a perguntas sobre o seu negócio, usando as informações que você controla.

- Reduzir alucinações e respostas imprecisas a níveis aceitáveis.

- Requer configuração e instalação mínimas.

Acreditamos que conseguimos isso. Nosso novo chatbot AI funciona "fora da caixa", reduzindo instantaneamente o volume de suporte e os tempos de resolução.

Ele pode conversar com muito mais naturalidade sobre consultas de suporte do que os bots existentes – trazendo a capacidade natural de conversação da IA moderna para o atendimento ao cliente.

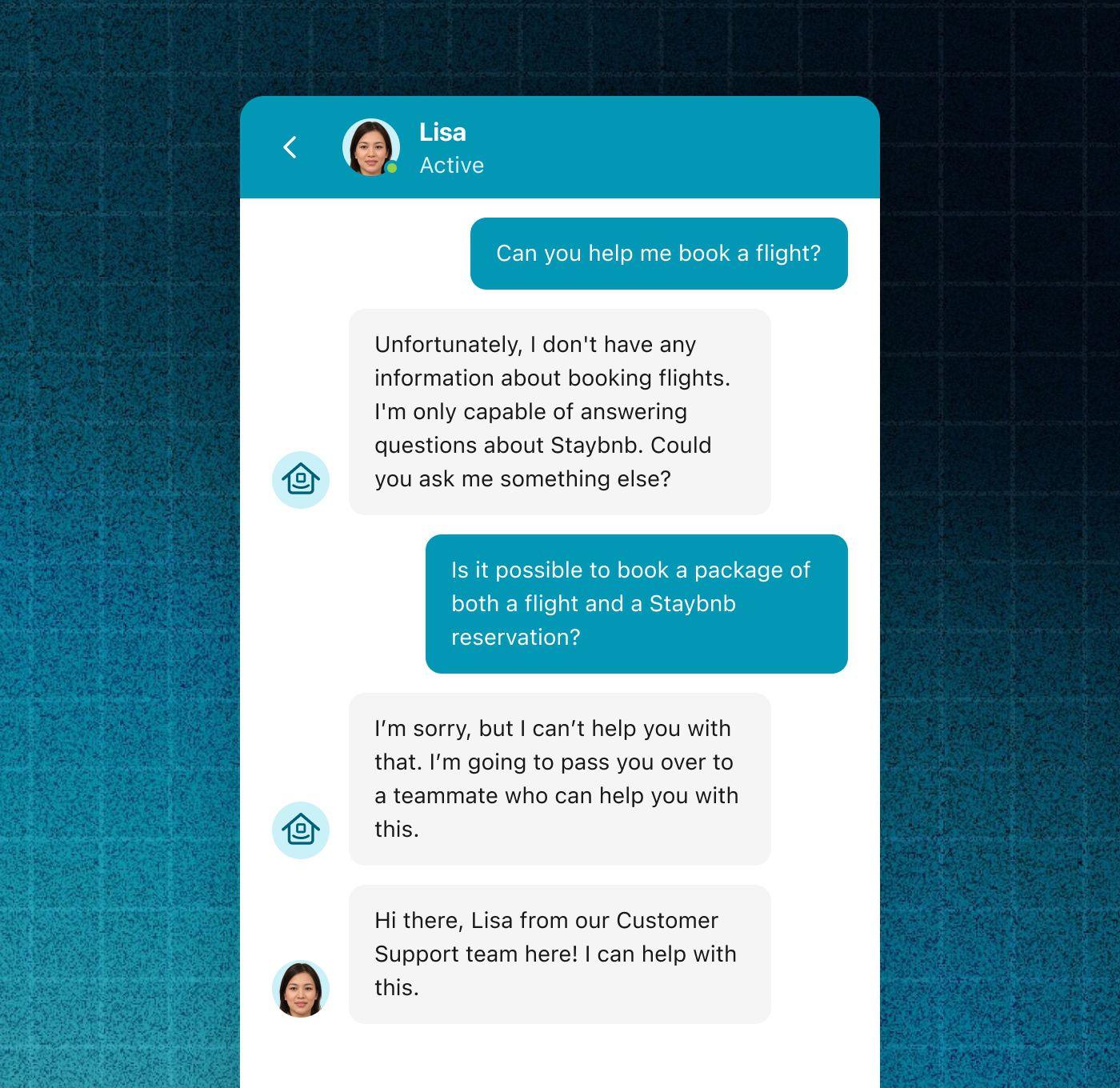

Ele pode entender as consultas que abrangem vários turnos de conversa, permitindo que seus clientes façam perguntas de acompanhamento e obtenham esclarecimentos adicionais.

Fin se envolve em conversas naturais com os clientes

Ampliamos o GPT-4 com recursos e proteções especificamente adaptados para fornecer suporte ao cliente, onde a confiança e a confiabilidade são cruciais.

Fin se recusa a responder a perguntas fora do domínio

O Fin foi projetado para fornecer apenas respostas com base no conteúdo de sua central de ajuda existente, aumentando a precisão e a confiabilidade. Para reforçar esse sentimento de confiança, ele sempre faz links para seus artigos de origem, para que seus clientes possam validar as respostas.

Não é perfeito, como discutiremos abaixo, mas acreditamos que agora está pronto para muitas empresas.

Fin não requer praticamente nenhum tempo de configuração inicial. Ele ingere as informações em seu centro de ajuda Intercom ou Zendesk existente – usando o poder da IA para interpretar imediatamente as perguntas complexas dos clientes e aplicar seu conhecimento do centro de ajuda para respondê-las.

Inevitavelmente, o chatbot não será capaz de responder a todas as perguntas dos clientes. Nessas situações, ele pode passar perguntas mais difíceis para as equipes de suporte humano sem problemas. Ele funciona efetivamente como parte da equipe de atendimento ao cliente, usando todos os fluxos de trabalho que o Intercom permite.

Se Fin não puder responder a uma pergunta, ela pode passar para um representante de CS que pode

Como construímos este chatbot de IA

Para criar o Fin, combinamos a tecnologia existente por trás do nosso Resolution Bot com o novo GPT-4 da OpenAI.

Lançamos o Resolution Bot há mais de quatro anos e ele funciona muito bem quando configurado, mas requer que as “Respostas” ou “Intenções” sejam selecionadas manualmente. Infelizmente, sabemos que alguns clientes lutam para superar esse obstáculo inicial.

“Projetamos o Fin para rodar usando o conhecimento que já existe em sua central de ajuda”

Para nosso novo bot, queríamos reduzir esse atrito.

Por isso, o projetamos para ser executado usando o conhecimento que já foi criado para sua central de ajuda. Ele consumirá os artigos da central de ajuda e usará as informações para responder diretamente às perguntas dos clientes.

Quando uma pergunta é feita, o chatbot usa sua IA para reformular as informações do artigo em uma resposta natural, automaticamente. E, quando você atualiza um artigo, a resposta do bot é atualizada quase imediatamente. Isso significa que você só precisa manter seu conteúdo de ajuda em um só lugar, e a versão mais atualizada pode ser fornecida aos clientes automaticamente.

Isso fornece uma maneira de as empresas realmente aproveitarem os benefícios da IA moderna, de maneira segura e previsível, e usando seus processos existentes para criar o conteúdo da central de ajuda.

No futuro, planejamos ir além e integrar nossa outra tecnologia de aprendizado de máquina para ajudar o bot de IA a responder a perguntas usando os dados primários que você possui sobre seus clientes.

Fazendo um chatbot confiável

Projetamos este chatbot para responder a perguntas usando apenas o conteúdo de ajuda que você já criou para evitar o risco de respostas imprecisas ou inesperadas. Isso lhe dá um alto grau de controle sobre o que Fin pode dizer.

“Alguns outros bots GPT baseiam suas respostas em grandes quantidades de informações da web, mas, na verdade, restringir as informações que o bot pode usar aumenta radicalmente sua previsibilidade e confiabilidade”

Se alguém fizer uma pergunta que não seja abordada em sua central de ajuda, ela dirá que não sabe a resposta. Esta é uma característica importante. Alguns outros bots GPT baseiam suas respostas em grandes quantidades de informações da web, mas, na verdade, restringir as informações que o bot pode usar aumenta radicalmente sua previsibilidade e confiabilidade.

Mitigamos ainda mais a imprecisão ao projetar uma nova interface de usuário para o Fin com confiabilidade em mente – ela é claramente vinculada ao artigo de origem quando uma resposta é fornecida, o que permite ao usuário verificar se a fonte é relevante, reduzindo o impacto de pequenos erros.

A Fin sempre fornecerá uma fonte para suas respostas, permitindo que os clientes verifiquem suas respostas

Também tomamos medidas para reduzir a capacidade do usuário de fazer o bot dialogar sobre qualquer tópico que não esteja contido no centro de ajuda.

Limitações

Precisão

Pode ser possível que os usuários finais contornem intencionalmente as restrições que projetamos e façam o chatbot de IA dizer coisas inapropriadas. Se isso ocorrer, acreditamos que será apenas após determinadas tentativas, e não em interações naturais com os clientes.

Devemos salientar que a IA não é perfeita. Existem alguns clientes para os quais qualquer risco de fornecer informações irrelevantes ou incorretas é inaceitável. Eles podem não querer adotar esse chatbot com IA ainda.

Atualmente, os modelos de linguagem grandes têm um modo de falha diferente dos bots anteriores que criamos, como o Resolution Bot. Embora o Resolution Bot possa às vezes fornecer uma resposta irrelevante , nosso AI bot às vezes pode fornecer uma resposta incorreta . Por exemplo, pode ficar confuso com o conteúdo de um artigo e fazer uma declaração ao usuário que não é verdadeira. Embora essa chance tenha diminuído muito com os modelos recentes, ela não é zero.

Para permitir que você quantifique essa limitação, estamos criando uma experiência em que você pode importar sua central de ajuda existente para o bot e testá-la manualmente.

“Acreditamos que esses modelos continuarão a melhorar e, como resultado, a precisão melhorará”

No geral, com melhorias recentes no GPT-4 e as restrições de projeto que construímos, estamos confiantes de que seu desempenho está acima da barra de precisão exigida por muitas empresas.

Olhando para o futuro, acreditamos que esses modelos continuarão a melhorar e, como resultado, a precisão melhorará. Também acreditamos que a compreensão do usuário sobre as limitações dessa tecnologia aumentará com o tempo; nossas respostas de bot AI são claramente rotuladas como “AI” para permitir isso.

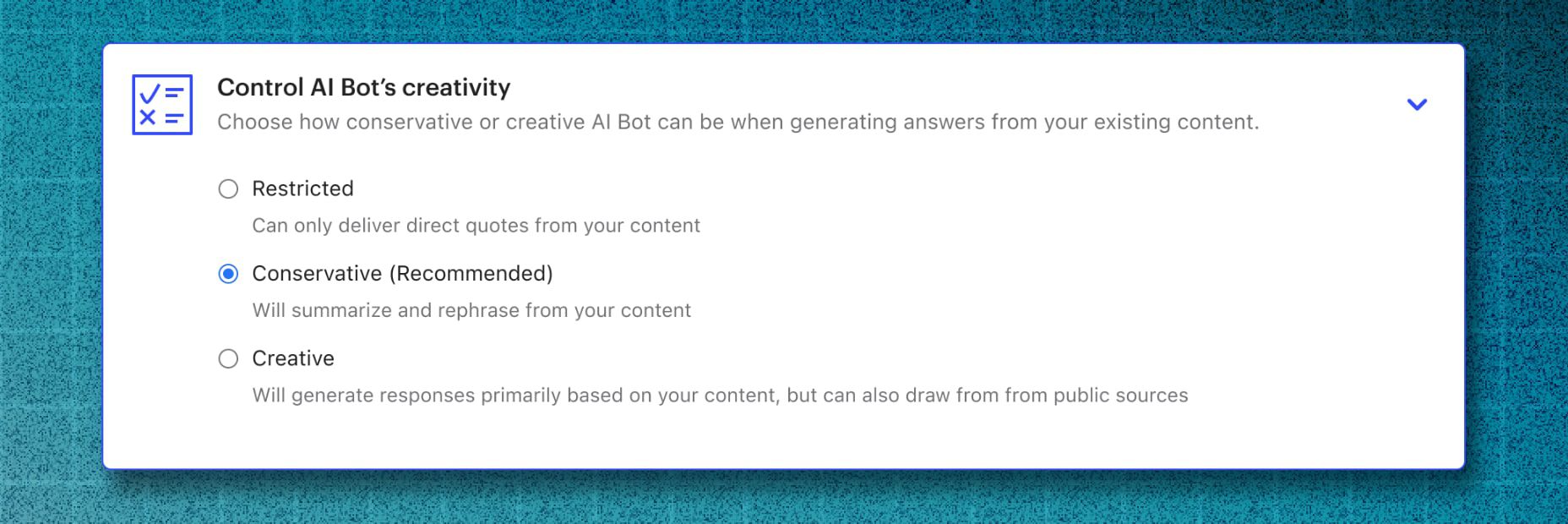

Por fim, acreditamos que diferentes empresas terão naturalmente diferentes compensações nessa área. Nesse sentido, estamos construindo definições de configuração que permitem às empresas definir a compensação que desejam fazer, como pode ser visto neste protótipo de design.

Estamos explorando definições de configuração para controlar o nível de criatividade de Fin

Custo dos modelos GPT

É importante observar que os modelos de linguagem grandes usados para alimentar esse chatbot são caros para serem executados. Esta é uma tecnologia de ponta que requer muito poder de computação. No entanto, acreditamos que essa despesa provavelmente diminuirá com o tempo.

Estamos confiantes de que, para muitas empresas, a implementação do nosso chatbot de IA será um ROI positivo, em comparação com os representantes de suporte respondendo às mesmas perguntas.

Latência

Por fim, modelos avançados de linguagem grande, como GPT-4, têm latência inerente. Isso pode ser visto ao interagir com o bot – 10 ou mais segundos de latência não é incomum. Também esperamos que isso melhore com o tempo.

Em quanto tempo o Fin estará disponível?

Construímos uma versão inicial do Fin, que usamos para testes internos até agora, e lançaremos um beta limitado em breve. No momento, nossas principais restrições são custo e preço.

Ainda continuamos a iterar e aprimorar a experiência do usuário com base em testes e a iterar a integração entre o Fin e o Resolution Bot. Acreditamos que os clientes avançados continuarão a usar o Resolution Bot e tecnologia semelhante, especialmente em situações em que uma ação deve ser tomada para resolver totalmente a consulta do usuário – como cancelar um pedido, por exemplo.

“Na Intercom, há muito tempo construímos um futuro em que a maioria das conversas dos clientes são resolvidas com sucesso sem a necessidade de suporte humano”

Esperamos passar pelo processo de teste rapidamente nas próximas semanas e meses. Para referência, os recursos do Inbox AI com tecnologia GPT que anunciamos no final de janeiro agora estão disponíveis para todos os nossos clientes e já estão sendo usados por milhares deles.

Inscreva-se para o futuro do atendimento ao cliente

Na Intercom, há muito tempo construímos um futuro em que a maioria das conversas com clientes são resolvidas com sucesso sem a necessidade de suporte humano, liberando sua equipe para trabalhar em conversas de clientes de maior valor.

Acreditamos que o anúncio de hoje marca uma mudança de paradigma na área de atendimento ao cliente – o futuro está acontecendo agora.

Você pode aprender mais sobre o novo bot com tecnologia de IA e inscrever-se na lista de espera aqui.