Uma introdução à análise de arquivos de log de SEO

Publicados: 2021-05-17A análise de log é a maneira mais completa de analisar como os mecanismos de pesquisa lêem nossos sites. Todos os dias, SEOs, profissionais de marketing digital e especialistas em análise da web usam ferramentas que mostram diagramas sobre tráfego, comportamentos do usuário e conversões. Os SEOs geralmente tentam entender como o Google rastreia seu site por meio do Google Search Console.

Então… por que um SEO deveria analisar outras ferramentas para verificar se um mecanismo de busca está lendo corretamente o site? Ok, vamos começar com o básico.

O que são arquivos de log?

Um arquivo de log é um arquivo em que a Web do servidor grava uma linha para cada recurso no site solicitado por bots ou usuários. Cada linha contém dados sobre a solicitação, que podem incluir:

IP do chamador, data, recurso necessário (página, .css, .js, …), agente do usuário, tempo de resposta, …

Uma linha ficará mais ou menos assim:

66.249.**.** - - [13/Apr/2021:00:07:31 +0200] "GET /***/x_*** HTTP/1.1" 200 40960 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)" "www.***.it" "-"

Rastreabilidade e capacidade de atualização

Cada página tem três status básicos de SEO:

- rastreável

- indexável

- classificável

Do ponto de vista da análise de log, sabemos que uma página, para ser indexada, deve ser lida por um bot. Da mesma forma, o conteúdo já indexado por um mecanismo de pesquisa deve ser rastreado novamente para ser atualizado nos índices do mecanismo de pesquisa.

Infelizmente, no Google Search Console, não temos esse nível de detalhe: podemos verificar quantas vezes o Googlebot leu uma página do site nos últimos três meses e a rapidez com que o servidor web respondeu.

Como podemos verificar se um bot leu uma página? Claro, usando arquivos de log e um analisador de arquivos de log.

Por que os SEOs precisam analisar arquivos de log?

A análise do arquivo de log permite que os SEOs (e administradores de sistema também) entendam:

- Exatamente o que um bot lê

- Com que frequência o bot lê

- Quanto custam os rastreamentos, em termos de tempo gasto (ms)

Uma ferramenta de análise de log permite que os logs sejam analisados agrupando as informações por “caminho”, por tipo de arquivo ou por tempo de resposta. Uma ótima ferramenta de análise de log também nos permite unir informações obtidas de arquivos de log com outras fontes de dados como Google Search Console (cliques, impressões, posições médias) ou Google Analytics.

Analisador de registro do Oncrawl

O que procurar nos arquivos de log?

Uma das principais informações importantes nos arquivos de log é o que não está nos arquivos de log. Realmente, não estou brincando. A primeira etapa para entender por que uma página não está indexada ou não é atualizada para sua versão mais recente é verificar se o bot (por exemplo, Googlebot) a leu.

Depois disso, se a página for atualizada com frequência, pode ser importante verificar com que frequência um bot lê a página ou a seção do site.

O próximo passo é verificar quais páginas são lidas com mais frequência pelos bots. Ao rastreá-los, você pode verificar se essas páginas:

- merecem ser lidos com tanta frequência

- ou são lidos com tanta frequência porque algo na página causa mudanças constantes e fora de controle

Por exemplo, alguns meses atrás, um site em que eu estava trabalhando tinha uma frequência muito alta de leituras de bot em uma URL estranha. O bot revelou que esta página era de uma URL criada por um script JS, e que esta página estava carimbada com alguns valores de depuração que mudavam cada vez que a página era carregada… rastejar buraco no orçamento.

Orçamento de rastreamento

Rastrear orçamento? O que é isso? Todo site tem seu orçamento metafórico relacionado aos mecanismos de busca e seu bot. Sim: o Google define uma espécie de orçamento para o seu site. Isso não é registrado em nenhum lugar, mas você pode “calcular” de duas maneiras:

- verificando o relatório de estatísticas de rastreamento do Google Search Console

- verificando os arquivos de log, grepping ( filtrando ) eles pelo user-agent que contém “Googlebot” ( Você obterá melhores resultados se garantir que esses user-agents correspondam aos IPs corretos do Google… )

O orçamento de rastreamento aumenta quando o site é atualizado com conteúdo interessante, quando ele atualiza conteúdo regularmente ou quando o site recebe bons backlinks.

Como o orçamento de rastreamento é gasto em seu site pode ser gerenciado por:

- links internos (follow / nofollow também!)

- noindex / canônico

- robots.txt (cuidado: isso “bloqueia” o user-agent)

Páginas de zumbis

Para mim “páginas zumbis” são todas as páginas que não tiveram nenhum tráfego orgânico ou visitas de bot por um período considerável de tempo, mas que possuem links internos apontando para elas.

Esse tipo de página pode usar muito orçamento de rastreamento e pode receber page rank desnecessariamente devido a links internos. Esta situação pode ser resolvida:

- Se essas páginas forem úteis para os usuários que visitam o site, podemos defini-las como noindex e definir os links internos para elas como nofollow ( ou use disallow robots.txt, mas tenha cuidado com isso… )

- Se essas páginas não forem úteis para os usuários que acessarem o site, podemos removê-las (e retornar um código de status de 410 ou 404) e remover todos os links internos.

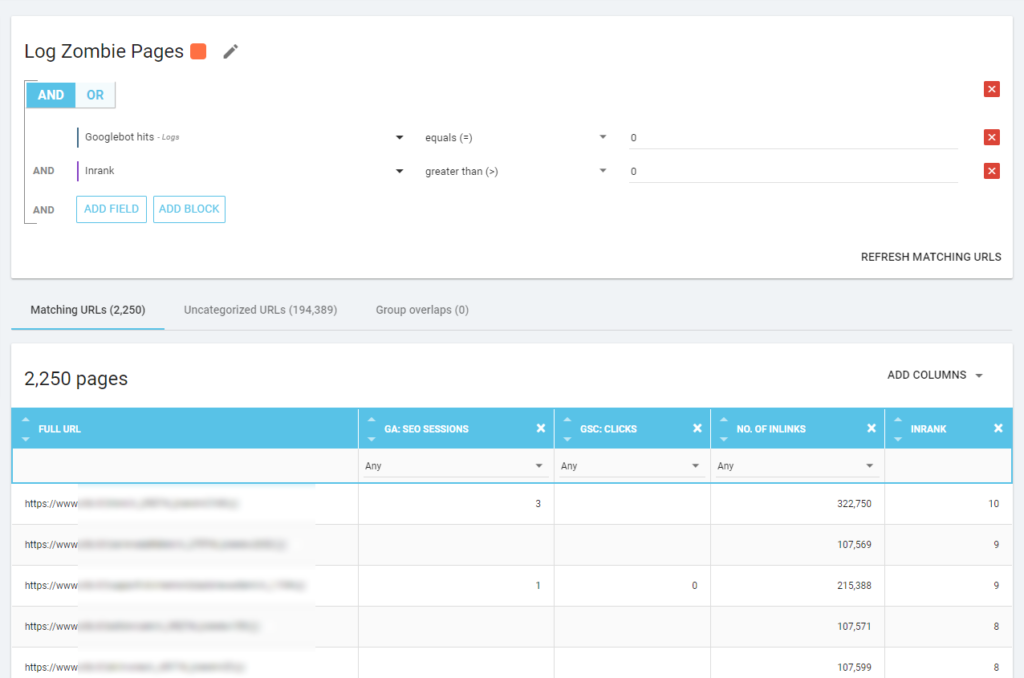

Com o Oncrawl podemos criar um “relatório zumbi” baseado em:

- Impressões do GSC

- Cliques do GSC

- Sessões do GA

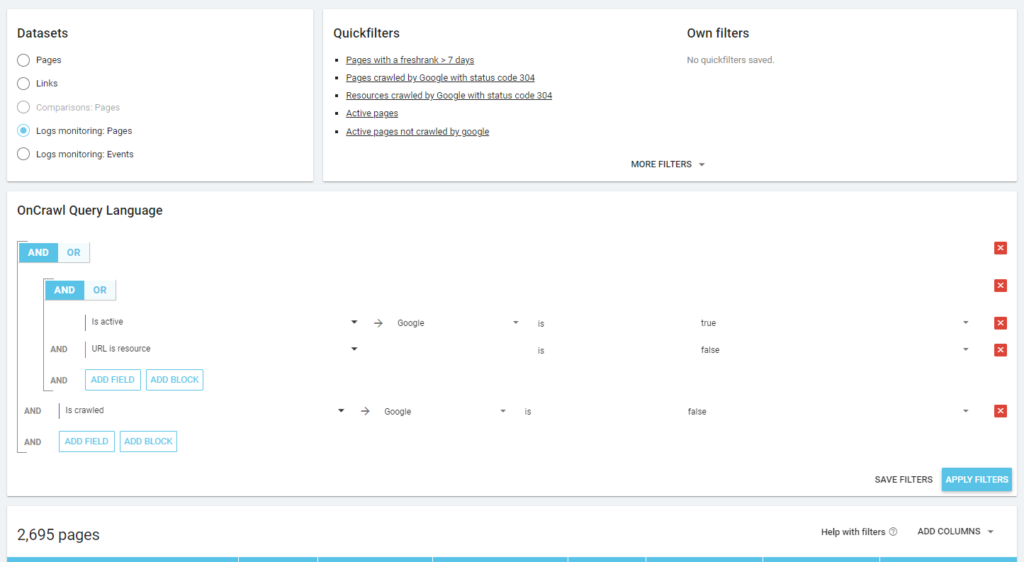

Também podemos usar eventos de log para descobrir páginas zumbis: podemos definir um filtro de evento 0, por exemplo. Uma das maneiras mais fáceis de fazer isso é criar uma segmentação. No exemplo abaixo, filtrei todas as páginas com os seguintes critérios: nenhum hit do Googlebot mas com um Inrank (isso significa que essas páginas possuem links internos que apontam para elas).

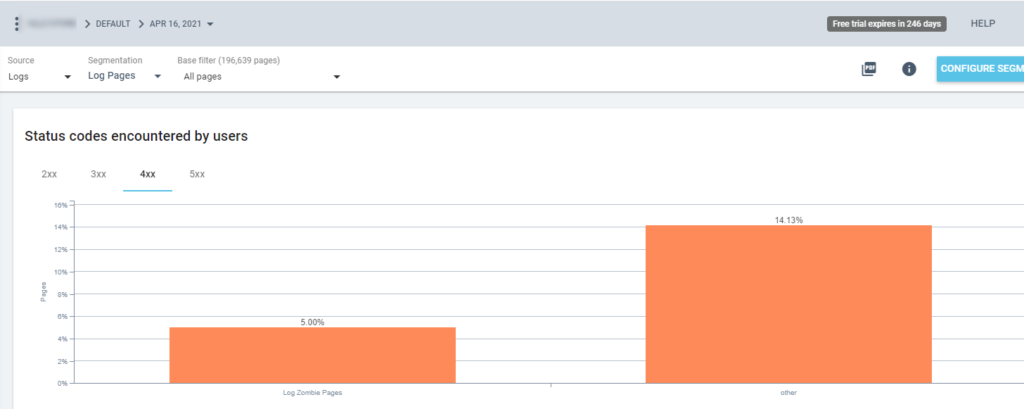

Então agora podemos usar essa segmentação em todos os relatórios do Oncrawl. Isso nos permite obter insights de qualquer gráfico, por exemplo: quantas “páginas de log zombie” retornam um código de status 200?

Páginas órfãs

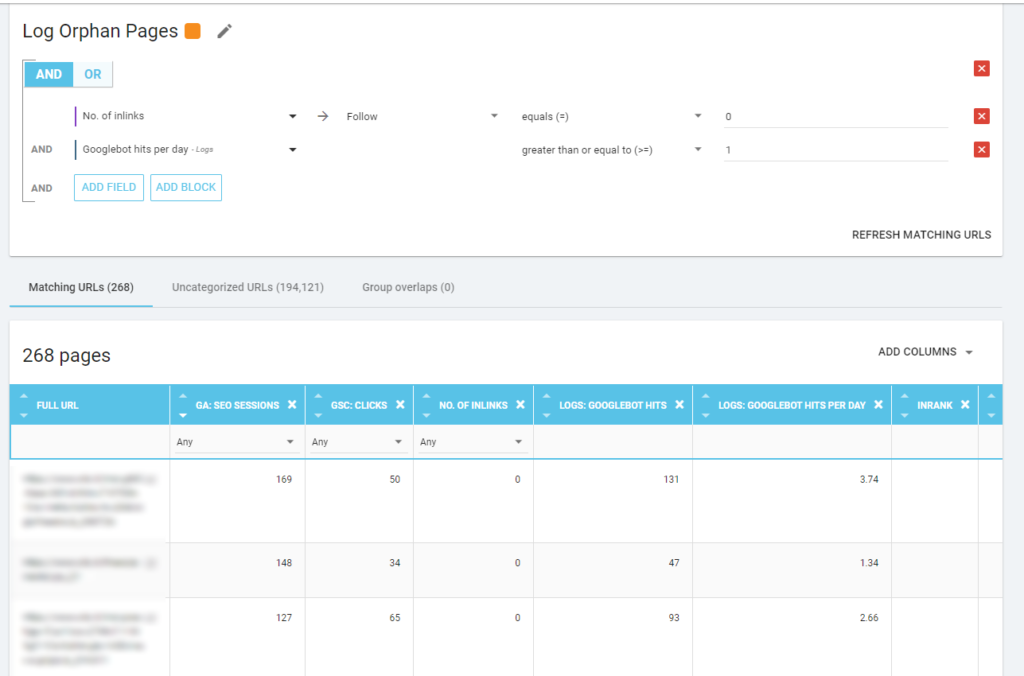

Para mim, as “páginas órfãs” que vale a pena olhar com atenção são todas as páginas que têm alto valor em métricas importantes (sessão GA, impressão GSC, acessos de log, …) que não possuem links internos apontando para elas para compartilhar o page rank e indique a importância da página.

Assim como nas “páginas Zumbi”, para criar um relatório baseado em log, a melhor maneira é criar uma nova segmentação.

UAU, quantas páginas com sessões e acessos e sem inlinks!

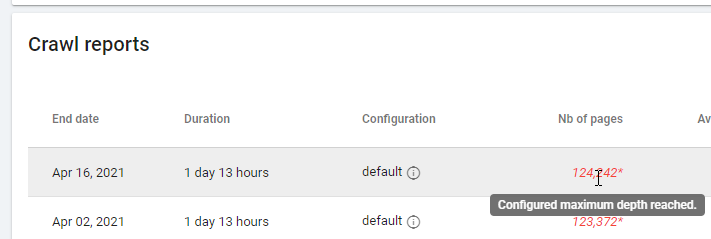

Ao verificar um relatório baseado em “Zero Follow Inlinks”, preste atenção ao status do rastreamento: o Oncrawl conseguiu rastrear todo o site ou apenas algumas páginas? Você pode ver isso na página principal do projeto:

Se a profundidade máxima foi atingida:

- Verifique sua configuração de rastreamento

- Verifique a estrutura do seu site

Arquivos de log e Oncrawl

O que o Oncrawl oferece em seus painéis padrão?

Registro ao vivo

Esse painel é útil para verificar as principais informações sobre como os bots estão lendo seus sites, assim que os bots visitam o site e antes que as informações dos arquivos de log sejam completamente processadas. Para aproveitar ao máximo, recomendo fazer upload de arquivos de log com frequência: você pode fazer isso via FTP, por meio de conectores como o do Amazon S3, ou pode fazê-lo manualmente pela interface web.

O primeiro gráfico mostra a frequência com que seu site é lido e por qual bot. No exemplo que você pode ver abaixo, podemos verificar os acessos desktop vs mobile. Nesse caso, enviamos para o Oncrawl os arquivos de log filtrados apenas para o Googlebot:

É interessante ver como a quantidade de mobile reads ainda é muito alta: é normal? Depende… O site que estamos analisando ainda está no “mobile-first index”, mas não é um site totalmente responsivo: é um site de serviço dinâmico (como o Google o chama) e o Google ainda verifica as duas versões!

Outro diagrama interessante é “Acessos de bot por grupo de páginas”. Por padrão, o Oncrawl cria grupos com base em caminhos de URL. Mas podemos definir grupos manualmente para agrupar as URLs que fazem mais sentido analisar em conjunto.

Como você pode ver, o amarelo vence! Ele representa URLs com um caminho de produto, por isso é normal que tenha um impacto tão alto, principalmente porque temos campanhas do Shopping pagas do Google.

E... sim, acabamos de confirmar que o Google usa o Googlebot padrão para verificar o status do produto relacionado ao feed do comerciante!

Comportamento de rastreamento

Este painel mostra informações semelhantes ao “Registro ao vivo”, mas essas informações foram totalmente processadas e agregadas por dia, semana ou mês. Aqui você pode definir um período de data (início/fim), que pode voltar no tempo o quanto quiser. Há dois novos diagramas para aprofundar a análise de log:

- Comportamento do rastreamento: para verificar a proporção entre as páginas rastreadas e as páginas rastreadas recentemente

- Frequência de rastreamento por dia

A melhor maneira de ler esses diagramas é conectar os resultados às ações do site:

- Você moveu as páginas?

- Você atualizou algumas seções?

- Publicou novo conteúdo?

Impacto SEO

Para SEO, é importante monitorar se as páginas otimizadas são lidas por bots ou não. Como escrevemos sobre “páginas órfãs”, é importante garantir que as páginas mais importantes/atualizadas sejam lidas por bots para que as informações mais atualizadas estejam disponíveis para os mecanismos de busca serem ranqueáveis.

O Oncrawl utiliza o conceito de “Páginas ativas” para indicar as páginas que recebem tráfego orgânico dos motores de busca. A partir desse conceito, mostra alguns números básicos, como:

- Visitas de SEO

- Páginas ativas de SEO

- Proporção ativa de SEO (a proporção de páginas ativas entre todas as páginas rastreadas)

- Fresh Rank (o tempo médio que passa entre quando o bot lê a página pela primeira vez e a primeira visita orgânica)

- Páginas ativas não rastreadas

- Páginas recentemente ativas

- Frequência de rastreamento por dia de páginas ativas

Como é a filosofia do Oncrawl, com um único clique, podemos ir fundo no lago de informações, filtrado pela métrica em que clicamos! Por exemplo: quais são as páginas ativas não rastreadas? Um clique…

Sanidade de exploração

Este último dashboard permite-nos verificar a qualidade do rastreamento do bo, ou mais precisamente, quão bem o site se apresenta aos motores de busca:

- Análise do código de status

- Análise de código de status por dia

- Análise do código de status por grupo de páginas

- Análise do tempo de resposta

É obrigatório para um bom trabalho de SEO:

- reduzir o número de respostas 301 de links internos

- remova as respostas 404/410 de links internos

- otimize o tempo de resposta, pois a qualidade do rastreamento do Googlebot está diretamente relacionada ao tempo de resposta: tente reduzir o tempo de resposta em seu site pela metade e você verá (em poucos dias) que a quantidade de páginas rastreadas dobrará.

A ciência do Log Analysis e o Data Explorer do Oncrawl

Até agora vimos os relatórios padrão do Oncrawl e como usá-los para obter informações personalizadas por meio de segmentações e grupos de páginas.

Mas o núcleo da análise de log é entender como encontrar algo errado. Normalmente, o ponto de partida da análise é verificar os picos e compará-los com o tráfego e com seus objetivos:

- páginas mais rastreadas

- páginas menos rastreadas

- recursos mais rastreados (não páginas)

- frequências de rastreamento por tipo de arquivo

- impacto dos códigos de status 3xx / 4xx

- impacto dos códigos de status 5xx

- páginas rastreadas mais lentas

- …

Você quer ir mais fundo? Bom… você precisa adicionar dados. E Oncrawl oferece uma ferramenta realmente poderosa como o Data Explorer.

Como você pode ver em uma captura de tela anterior (páginas ativas não rastreadas), você pode criar todos os relatórios que desejar com base em sua estrutura de análise.

Por exemplo:

- piores páginas de tráfego orgânico com muito rastreamento por bots

- melhores páginas de tráfego orgânico com muito rastreamento por bots

- páginas mais lentas com muitas impressões SERP

- …

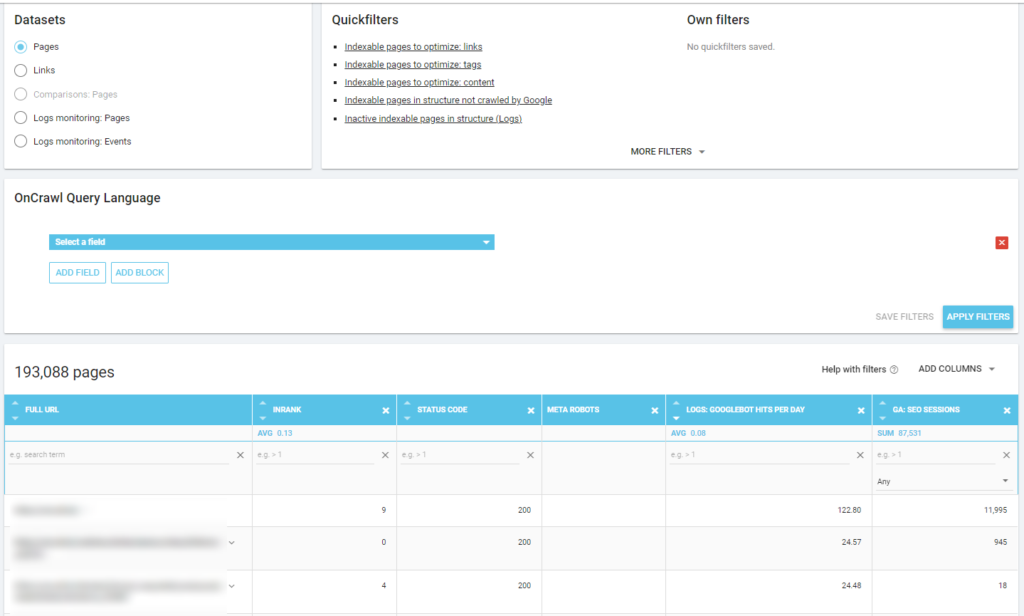

Abaixo você pode ver como verifiquei quais são as páginas mais rastreadas relacionadas ao número de sessões de SEO:

Aprendizado

A análise de log não é estritamente técnica: para fazê-la da melhor maneira possível, precisamos combinar habilidades técnicas, habilidades de SEO e habilidades de marketing.

Muitas vezes, uma análise é excluída de uma “lista de verificação de SEO” porque nosso cliente não tem acesso aos arquivos de log ou porque pode ser uma análise cara.

A realidade é que os logs são as únicas fontes para realmente verificar onde os bots estão indo em nossos sites e saber como nossos servidores estão respondendo a eles.

Uma ferramenta como o Oncrawl pode reduzir bastante os requisitos técnicos: basta fazer o upload dos arquivos de log e começar a analisá-los!