5 dicas para economizar tempo usando o OnCrawl

Publicados: 2017-06-21Como aproveitar os recursos avançados do OnCrawl para melhorar sua eficiência durante o monitoramento diário de SEO.

OnCrawl é uma poderosa ferramenta de SEO que ajuda você a monitorar e otimizar a visibilidade do mecanismo de pesquisa de sites de comércio eletrônico, editores online ou aplicativos. A ferramenta foi construída em torno de um princípio simples: ajudar os gerentes de tráfego a economizar tempo em seu processo de análise e no gerenciamento diário de projetos de SEO.

Além de ser uma ferramenta de auditoria onsite, baseada em uma plataforma SaaS suportada por uma API que combina todos os dados dos sites, também é um analisador de logs que simplifica a extração e análise de dados dos arquivos do servidor de logs.

As possibilidades do OnCrawl são bastante amplas, mas precisam ser dominadas. Neste artigo, compartilharemos 5 dicas de economia de tempo para o uso diário do nosso rastreador de SEO e analisador de logs.

1# Como categorizar URLs HTTP e HTTPS

A migração HTTPS é um tema quente na esfera de SEO. Para lidar perfeitamente com essa etapa importante, é importante seguir com precisão o comportamento dos bots em ambos os protocolos.

A experiência mostrou que os bots levam mais ou menos tempo para mudar completamente de HTTP para HTTPS. Em média, essa transição leva algumas semanas ou meses, dependendo de fatores externos e internos relacionados à qualidade e migração do site.

Para entender com precisão essa fase de transição, em que seu orçamento de rastreamento é fortemente afetado, é inteligente monitorar os acessos de bots. Portanto, é necessário analisar os logs do servidor. O bot, como usuário comum, deixa marcas em cada página, recurso e solicitação que faz. Seus logs possuem as portas que entregaram essas chamadas. Assim, você pode validar a qualidade de migração do seu site HTTPS.

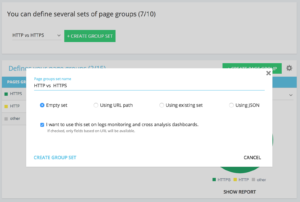

Métodos para configurar um conjunto de páginas http vs https dedicado

Na página inicial do seu projeto avançado, você pode encontrar no canto superior direito um botão de “configurações”. Em seguida, selecione o menu “Configurar grupo de páginas”. Uma vez aqui, crie um novo “Criar conjunto de grupos” e nomeie-o como “HTTP vs HTTPS”.

Para acessar seus logs, é importante selecionar a opção “Quero usar este conjunto nos painéis de monitoramento de logs e análise cruzada” .

- HTTPS : “URL completo” / “começar com” / https

- HTTP: “URL completo” / “não começar com” / https

Uma vez salvo, você acessará uma visualização de sua migração HTTPS (se você adicionou a porta de solicitação em suas linhas de log. Você pode dar uma olhada em nosso guia.)

Nossos QuickFilters podem ser encontrados no Data Explorer. Eles foram construídos para facilitar o acesso a algumas métricas importantes de SEO, como links apontando para 404, 500 ou 301/302, páginas muito lentas ou muito ruins, etc.

Aqui está a lista completa:

- erros 404

- erros 5xx

- Páginas ativas

- Páginas ativas não rastreadas pelo Google

- Páginas ativas com código de status encontrado pelo Google diferente de 200

- Canonical não corresponde

- Canônico não definido

- Páginas indexáveis

- Nenhuma página indexável

- Páginas ativas órfãs

- Páginas órfãs

- Páginas rastreadas pelo Google

- Páginas rastreadas pelo Google e OnCrawl

- Páginas na estrutura não rastreadas pelo Google

- Páginas que apontam para erros 3xx

- Páginas apontando para erros 4xx

- Páginas que apontam para erros 5xx

- Páginas com h1 ruim

- Páginas com h2 ruim

- Páginas com meta descrição ruim

- Páginas com título ruim

- Páginas com problemas de duplicação de HTML

- Páginas com menos de 10 inlinks

- Redirecionar 3xx

- Páginas muito pesadas

- Páginas muito lentas

Mas, às vezes, esses QuickFilters não respondem a todas as suas preocupações comerciais. Nesse caso, você pode começar por um deles e criar seu “Filtro Próprio” adicionando peças no filtro e salvando-as para encontrar rapidamente seus filtros sempre que se conectar à ferramenta.

Por exemplo, a partir de links apontando para 4xx, você pode optar por filtrar links que tenham uma âncora vazia: “Âncora“ / “é” / “” e salvar esse filtro. Uma vez salvo, pode ser modificado quantas vezes for necessário.

Agora você tem acesso direto a esse “Quickfilter” específico na lista “Select a Quickfilter” na parte inferior da parte “Own” como visto na captura de tela abaixo.

3# Como configurar campos personalizados relacionados ao DataLayer?

Você pode usar uma segmentação de seus tipos de páginas relacionadas ao definir suas tags de ferramentas de análise, por exemplo. Esse código em particular é muito interessante para segmentar ou cruzar dados do OnCrawl com seus dados externos.

Para permitir que você crie uma “coluna pivô” para sua análise, podemos extrair esses códigos durante os rastreamentos e trazê-los de volta como um tipo de dado do seu projeto.

A opção “Campos personalizados” permite extrair qualquer elemento das páginas de código-fonte graças a um regex ou XPath. Essas linguagens têm sua própria definição e regras. Você pode encontrar informações sobre XPath aqui e sobre regex aqui.

Caso de uso 1: extrair os dados da camada de dados do código-fonte das páginas

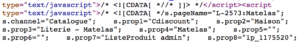

Código para analisar:

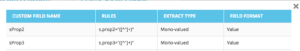

Solução: Use um “regex”: s.prop2=”([^”]+)” / Extrair: Valor único / Formato de campo: Valor

- Encontre a cadeia de caracteres s.prop2="

- Raspe todos os caracteres que não são “ (o primeiro caractere após os dados a serem extraídos)

- A string a ser extraída pode ser encontrada antes do fechamento “

Após o rastreamento, no explorador de dados, você encontrará na coluna sProp2, sProp3 ou em seu campo Nome, os dados extraídos:

Use um XPATH

Código para analisar:

Você só precisa copiar/colar o elemento Xpath que deseja extrair diretamente do analisador de código do Chrome. Tenha cuidado, se o código for renderizado em JavaScript, você precisará configurar um projeto de raspagem personalizado. A linguagem Xpath é muito poderosa e pode ser difícil de manipular, portanto, se precisar de ajuda, ligue para nossos especialistas.

Caso de uso 3: testar a presença de uma tag de análise durante uma fase de recepção

Usar um regex

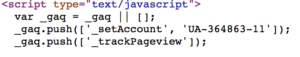

Código para analisar:

Solução: Use um “regex”: '_setAccount', 'UA-364863-11' / Extract: Verifique se existe

Você obterá no Data Explorer um “true” se a string for encontrada, “false” pelo contrário.

4# Como visualizar a frequência de rastreamento do Google em cada parte do seu site

O orçamento de rastreamento está no centro de qualquer preocupação de SEO. Está profundamente ligado ao conceito de “Importância da página” e ao agendamento de rastreamento do Google. Sabemos que esses princípios, introduzidos na patente do Google desde 2012, permitem que a sociedade de Mountain View otimize os recursos dedicados ao rastreamento da web.

O Google não gasta a mesma energia em todas as partes do seu site. A frequência de rastreamento em cada parte do seu site fornece informações precisas sobre a importância de suas páginas aos olhos do Google.

Páginas importantes são mais rastreadas pelos bots do Google porque o orçamento de rastreamento está profundamente ligado às habilidades de classificação de uma página.

Os projetos OnCrawl Advanced permitem que você veja nativamente o orçamento de rastreamento na parte "Monitoramento de log" / "Comportamento de rastreamento" / "Comportamento de rastreamento por grupo".

Você pode ver que o grupo "Página inicial" tem a maior frequência de rastreamento. É normal porque o Google está constantemente procurando por novos artigos e eles geralmente estão listados na página inicial. A ideia de Importância da Página está profundamente relacionada ao conceito do Google Freshness. Sua página inicial é a página mais importante para priorizar seu orçamento de rastreamento do Google. Em seguida, a otimização é espalhada para outras páginas em relação à profundidade e popularidade.

No entanto, é difícil ver as diferenças de frequência. Assim, você precisa clicar nos grupos que deseja remover (clicando na legenda) e ver os dados aparecerem.

5# Como testar códigos de status de uma lista de URLs após uma migração

Quando você deseja testar rapidamente os códigos de status de um conjunto de URLs, é possível modificar as configurações de um novo rastreamento:

- Adicione todos os URLs iniciais (botão "adicionar URL inicial")

- Defina a profundidade máxima para 1

Esse rastreamento personalizado retornará dados qualitativos sobre esse conjunto de URLs.

Você poderá verificar se os redirecionamentos estão bem configurados ou acompanhar a evolução dos códigos de status ao longo do tempo. Pense na vantagem de rastrear regularmente, você poderá seguir automaticamente urls antigas.

Por que você não cria um painel automatizado por meio de nossa API e cria um monitoramento de teste automatizado sobre esses aspectos.

Esperamos que esses hacks ajudem você a melhorar sua eficiência usando o OnCrawl. Ainda temos muitos truques avançados para mostrar a você. Por favor, compartilhe conosco no Twitter seus #oncrawlhacks, por exemplo, estamos felizes que nossos usuários possam se divertir tanto quanto nós com nossa ferramenta.