As 5 chaves de análise de arquivos de log que todo SEO precisa

Publicados: 2018-12-13Os arquivos de log são um reflexo preciso da vida do seu site. Seja por usuários ou bots, em páginas ou em recursos, toda a atividade em seu site é armazenada em seus logs.

Contendo informações como endereços IP, códigos de status, agentes do usuário, referenciadores e outros dados técnicos, cada linha nos logs (dados baseados no servidor) pode ajudá-lo a complementar a análise do seu site, que geralmente é baseada principalmente em dados analíticos (usuário- dados orientados).

Os dados que você encontrará em seus logs podem, por si só, ajudá-lo a focar sua estratégia de SEO.

1. Estado de saúde do seu site

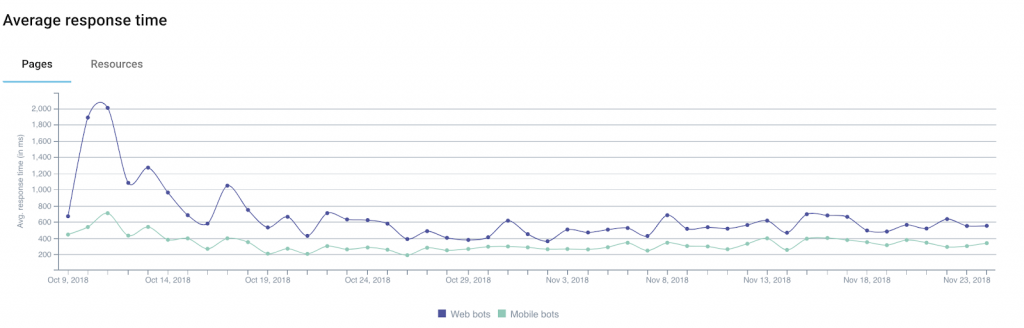

Entre as informações que você pode obter por meio de seus logs, o código de status , o tamanho da resposta e o tempo de resposta são excelentes indicadores da saúde do seu site.

Na verdade, é comum perder tráfego ou conversões sem realmente entender o porquê. Isso porque a explicação às vezes pode ser técnica.

Entre as pistas a considerar estão várias que estão diretamente relacionadas com os 3 campos que acabamos de mencionar.

Exemplo 1: um aumento no número de erros do servidor (“5xx”) pode indicar problemas técnicos que podem não ser detectados se você simplesmente navegar de uma página para outra.

Exemplo 2: vários estudos mostraram o impacto do tempo de carregamento na taxa de conversão de sites de comércio eletrônico. Uma queda em sua receita de vendas pode estar relacionada a um aumento no tempo de carregamento de suas páginas.

Além disso, o Google oferece uma calculadora que permite simular a relação entre o tempo de carregamento e as receitas (a ser considerada com um grão de sal).

Exemplo 3: às vezes pode acontecer que seu servidor, após vários problemas técnicos, retorne páginas vazias. Nesse caso, o simples monitoramento de seus códigos de status não será suficiente para alertá-lo. É por isso que pode ser útil adicionar tamanho de resposta aos dados que você monitora: essas páginas vazias (ou em branco) geralmente são mais claras que o normal.

Ao segmentar seu site com base nos vários tipos de URLs/páginas, você poderá isolar as origens dos problemas técnicos com mais facilidade, o que tornará a solução do problema mais simples.

2. Frequência de acertos do bot

Para os membros da comunidade de SEO, os logs representam uma riqueza de informações úteis sobre como os bots dos mecanismos de pesquisa “consomem” seus sites.

Por exemplo, eles nos informam quando os bots visitaram uma página pela primeira ou última vez.

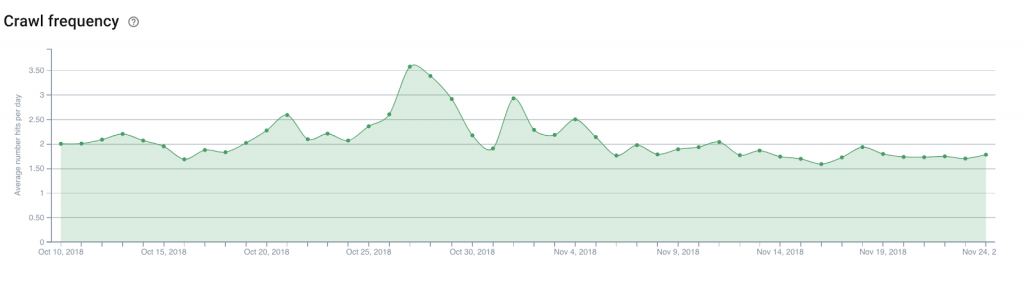

Tomemos o exemplo de um site de notícias que logicamente precisa de mecanismos de busca para localizar e indexar rapidamente seu novo conteúdo. A análise dos campos dos logs que indicam a data e hora permite definir o tempo médio entre a publicação de um artigo e a sua descoberta pelos motores de busca.

A partir daí, seria interessante analisar o número de acessos diários de bot (ou frequência de rastreamento ) na página inicial do site, nas páginas de categorias… Isso facilitará determinar onde colocar links para novos artigos que precisam ser descobertos.

A mesma teoria pode ser aplicada a um site de comércio eletrônico para descobrir novos produtos no catálogo, como aqueles que você deseja destacar para se manter atualizado sobre as tendências emergentes.

3. Rastrear orçamento

O orçamento de rastreamento (uma espécie de crédito de largura de banda de rastreamento que o Google e seus pares dedicam a um site) é um assunto favorito dos especialistas em SEO, e sua otimização tornou-se uma tarefa obrigatória.

Fora dos logs, apenas o Google Search Console (a versão antiga no momento) lhe dará uma ideia básica do orçamento que os mecanismos de busca concedem ao seu site. Mas o nível de precisão no Search Console não ajudará você a saber onde concentrar seus esforços. Especialmente porque os dados relatados são, na verdade, dados agregados acumulados de todos os Googlebots.

Os logs, no entanto, graças a uma análise dos campos user-agent e URL , podem identificar quais páginas (ou recursos) os bots estão visitando e a que taxa.

Essas informações permitirão que você saiba se os Googlebots navegam excessivamente em partes do seu site que não são importantes para SEO, desperdiçando um orçamento que pode ser útil para outras páginas.

Esse tipo de análise pode ser usado para estruturar sua estratégia de links internos, seu gerenciamento de arquivos robots.txt, seu uso de meta tags direcionadas a bots…

4. Mobile-First e migração

Alguns mal podem esperar, outros ficam apavorados com isso, mas certamente chegará o dia em que você receberá um e-mail do Google informando que seu site foi mudado para o famoso mobile-first index.

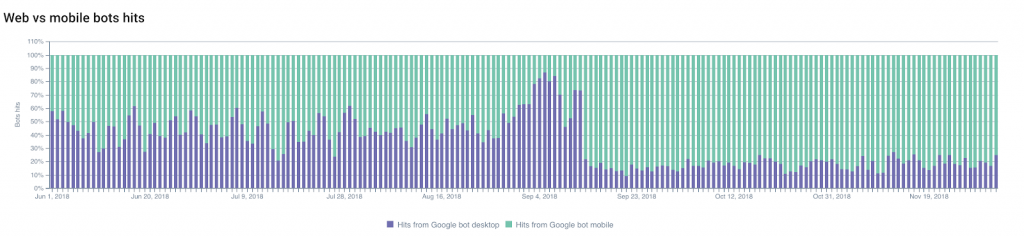

Você pode prever quando a mudança acontecerá seguindo as alterações na proporção entre os resultados do Googlebot para computador e os resultados do Googlebot para celular .

A parte do rastreamento por Googlebots móveis geralmente aumentará, permitindo que você preveja e planeje a mudança.

Por outro lado, não ver mudanças nessa proporção também pode ser uma indicação significativa da conformidade do seu site com os critérios do Google para troca de índices.

Você também pode monitorar outras alterações: migrações (de HTTP para HTTPS , por exemplo) ou modificações na estrutura do seu site .

Se nos concentrarmos no primeiro exemplo — em uma modificação do protocolo usado — a indexação das URLs e redirecionamentos seguros, bem como o “declínio” progressivo das antigas URLs, podem ser facilmente monitorados graças aos logs.

Monitorar as mudanças nos códigos de status será seu melhor aliado!

5. Vizinhos intrometidos

Você é um excelente SEO e seus esforços estão valendo a pena!

Isso despertou a curiosidade de seus concorrentes (e outras pessoas intrometidas) que querem entender como você conseguiu e que decidiram rastrear todo o seu site.

Isto é mau. Mas não é incomum (muito pelo contrário).

Seu trabalho agora é localizar os bisbilhoteiros.

Os mais sutis deles tentarão passar seus bots como Googlebots usando user-agents do Google . E é aqui que o endereço IP armazenado nos logs pode ser muito útil.

Mas, na verdade, os Googlebots oficiais usam apenas intervalos de endereços IP bem documentados. O Google aconselha os webmasters a realizar uma pesquisa reversa de DNS para verificar as origens dos bots.

Se esse teste falhar, os resultados (ou os resultados do rastreamento geográfico de IP) podem ajudá-lo a decidir o que fazer.

Só para constar, o especialista em segurança digital da Imperva Incapsula liderou um estudo publicado em 2016 que mostra que 28,9% da largura de banda analisada foi consumida por “bots ruins” (contra 22,9% por “bots bons” e 48,2% por usuários ). Analisar seus logs pode ajudá-lo a evitar uma drenagem excessiva de seus recursos ao detectar bots indesejados.