5 ótimos motivos para combinar seus dados de rastreamento e registros

Publicados: 2018-03-27A compreensão dos dados dos arquivos de log em SEO tem aumentado cada vez mais na comunidade de SEO. Os arquivos de log são, na verdade, a única representação qualitativa do que acontece em um site. Mas ainda precisamos ser capazes de fazê-los falar de forma eficaz.

As visitas exatas de SEO e o comportamento dos bots estão presentes em seus arquivos de log. Por outro lado, os dados do seu relatório de rastreamento podem fornecer um bom conhecimento do seu desempenho no local. Você precisa combinar seus arquivos de log e dados de rastreamento para destacar novas dimensões ao analisar seu site.

Este artigo mostrará cinco maneiras excelentes de combinar dados de arquivos de rastreamento e log. Obviamente, há muitos mais que você pode usar.

1# Detecção de páginas órfãs e otimização do orçamento de rastreamento

O que é uma página órfã? Se uma URL aparecer nos logs sem estar na arquitetura do site, essa URL é chamada de órfã.

O Google tem um índice colossal! Com o tempo, ele manterá todas as URLs que já descobriu em seu site, mesmo que não estejam mais presentes na arquitetura (mudança de slug, páginas excluídas, migração completa do site, links externos com erro ou transformados). Obviamente, permitir que o Google rastreie essas chamadas páginas órfãs pode ter um impacto na otimização do seu orçamento de rastreamento. Se URLs obsoletos consumirem seu orçamento de rastreamento, isso impedirá que outros URLs sejam rastreados com mais regularidade e necessariamente terá um impacto no seu SEO.

Ao rastrear seu site, o OnCrawl percorre todos os links para descobrir, profundidade por profundidade, a arquitetura completa do seu site. Por outro lado, durante o monitoramento dos arquivos de log, o OnCrawl compila dados de acessos de bots do Google e visitas de SEO.

A diferença entre as URLs conhecidas pelo Google e aquelas que estão vinculadas na arquitetura pode ser muito importante. Otimizações de SEO que visam corrigir links esquecidos ou quebrados e reduzir páginas órfãs são essenciais.

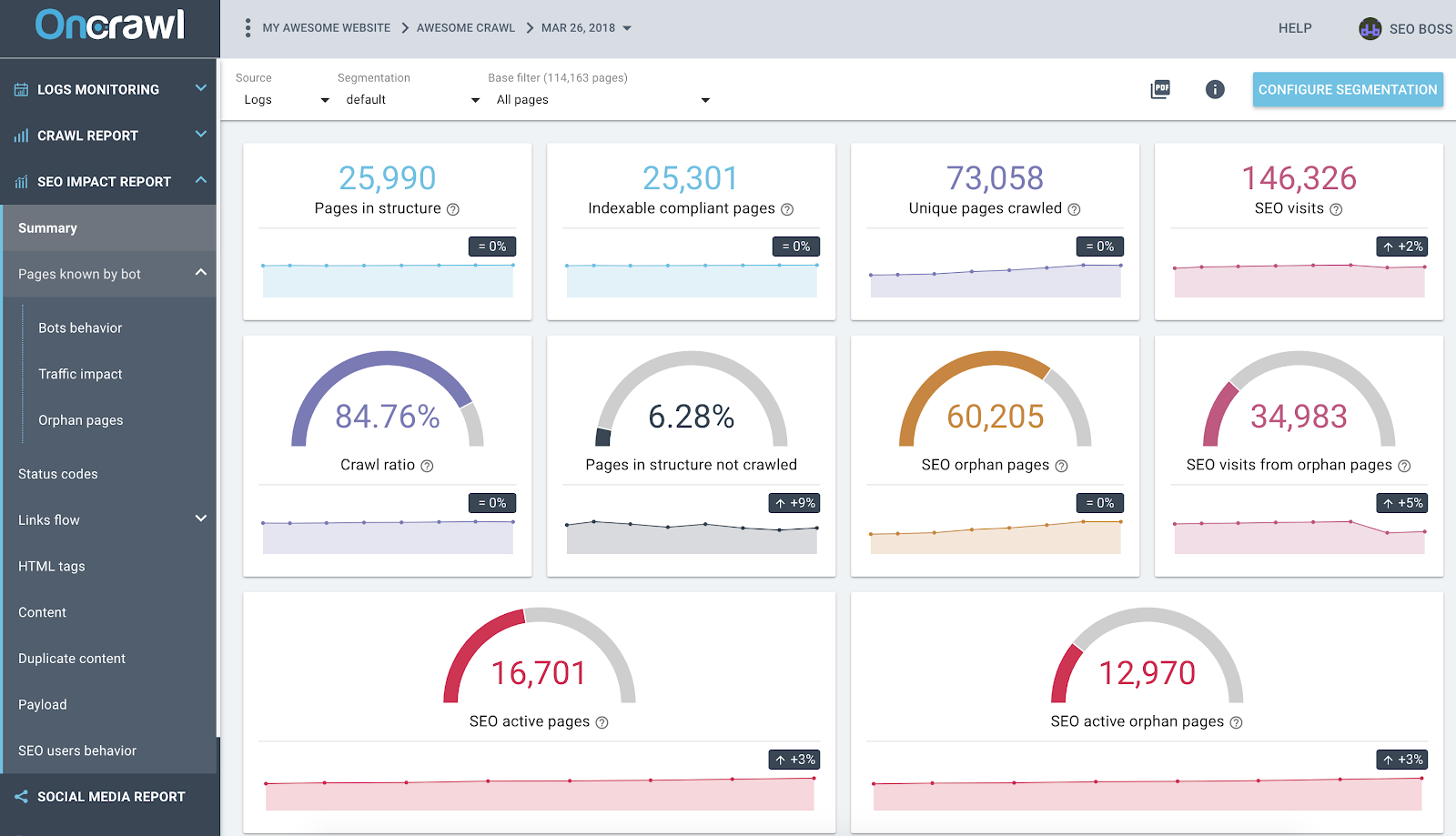

Relatório de impacto de SEO do OnCrawl com base na análise de dados cruzados de logs e rastreamento

A captura de tela acima fornece um estado da arte de seus registros e dados de rastreamento. Você pode notar rapidamente que:

- 25.990 páginas estão na estrutura – encontradas pelo nosso rastreador e levando em consideração todos os links que ele seguiu no site;

- 73.058 páginas são rastreadas pelo Google – isso é 3x mais do que na estrutura;

- Uma taxa de rastreamento de 84% – (páginas rastreadas OnCrawl + páginas ativas de logs + páginas rastreadas do Google) / páginas rastreadas do Google;

- Mais de 6% das páginas internas não são rastreadas – basta clicar no balde preto para ter a lista dessas páginas no Data Explorer;

- 60 mil páginas órfãs – o delta entre as páginas na estrutura e as páginas rastreadas pelo Google;

- 34 mil visitas de SEO nessas páginas – parece que há um problema na vinculação interna!

Prática recomendada: o OnCrawl oferece a vantagem de explorar os dados por trás de cada gráfico ou métrica apenas clicando nele. Dessa forma, você obterá uma lista para download de URLs que são filtradas diretamente no escopo que você está explorando.

2# Descubra quais URLs consomem mais (ou menos) orçamento de rastreamento

Todos os eventos de visitas de bots do Google são conhecidos pela plataforma de dados OnCrawl. Isso permite que você conheça – para cada URL – todos os dados compilados de acordo com o tempo.

No Data Explorer, você pode adicionar colunas de acessos de bot de cada URL (durante um período de 45 dias) e acessos por dia e por bots, que é um valor médio por dia. Essas informações são valiosas para avaliar o consumo do orçamento de rastreamento do Google. Muitas vezes você descobrirá que esse orçamento não é uniforme em todos os sites.

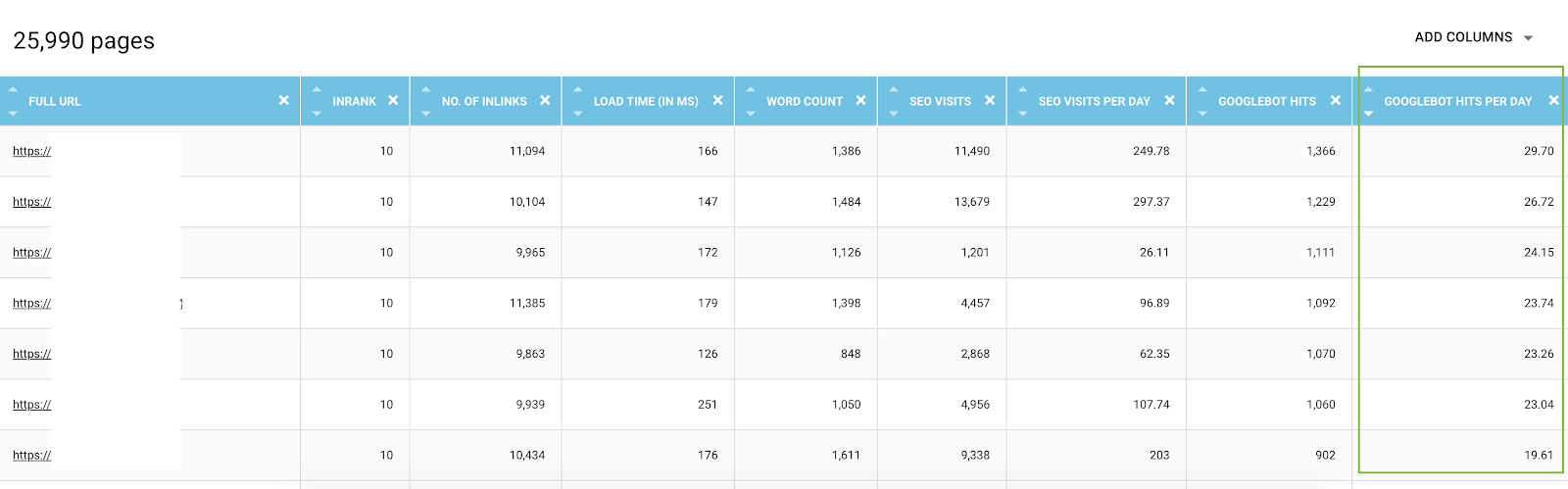

Lista de todos os URLs do Data Explorer com métricas de rastreamento e filtrados por acessos de bot por dia

Na verdade, alguns fatores podem desencadear ou reduzir o orçamento de rastreamento. Em seguida, estabelecemos uma lista das métricas mais importantes neste artigo sobre a importância da página do Google. Profundidade, número de links que apontam para uma página, número de palavras-chave, velocidade da página, InRank (popularidade interna) influenciam o rastreamento dos bots. Você aprenderá mais no parágrafo a seguir.

3# Conheça suas melhores páginas de SEO, suas piores páginas de SEO e determine os fatores de sucesso das páginas

Ao usar o Data Explorer, você tem acesso às principais métricas sobre páginas – mas pode ser complicado comparar centenas de linhas e métricas juntas. Usar colunas para segmentar os acessos de bot por dia e as visitas de SEO por dia é um aliado na sua mineração de dados.

- Baixe os arquivos JSON CS – Bot Hits by Day e CS – SEO visit by day;

- Adicione-os como novas segmentações.

Na verdade, você pode criar segmentações com base nesses dois valores resultantes da análise de logs para ter uma primeira distribuição de suas páginas por grupos. Mas você também pode filtrar cada grupo dessas segmentações para detectar rapidamente – em cada relatório OnCrawl – quais páginas não estão atingindo os valores esperados.

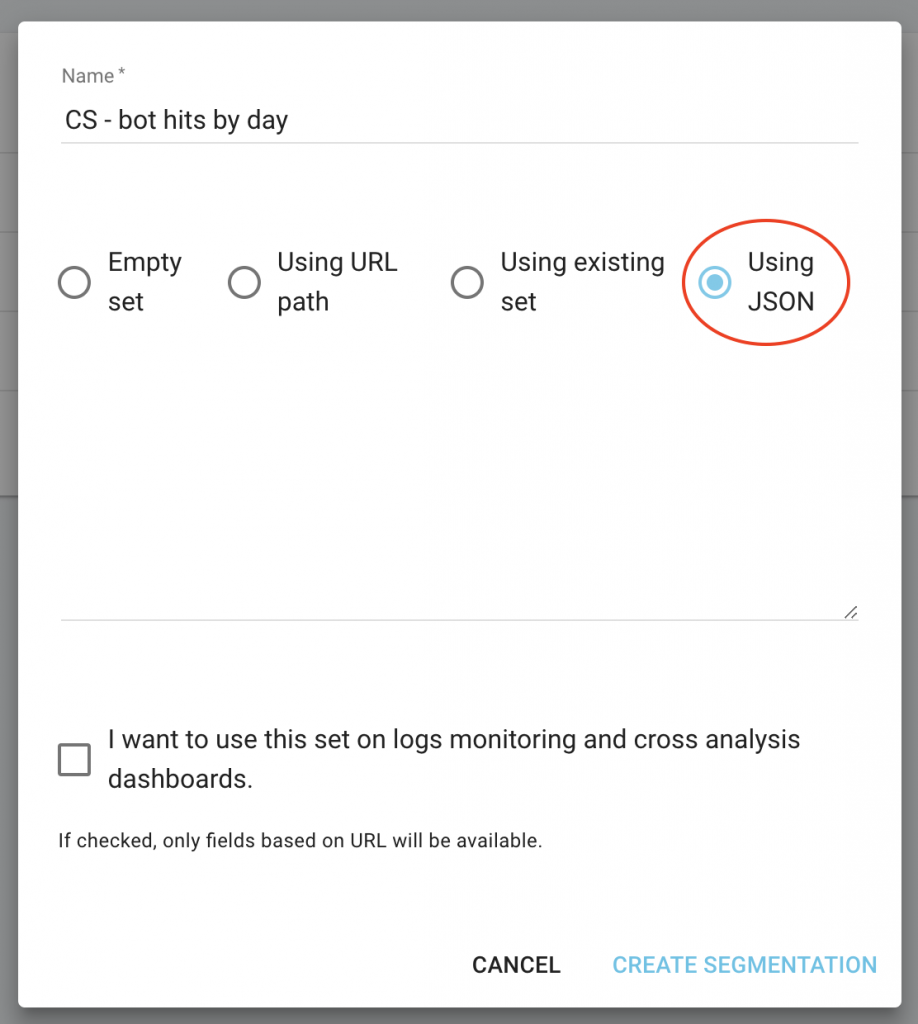

Na página inicial do seu projeto, clique no botão “Configurar segmentação”.

Em seguida, crie uma nova segmentação

Use a importação JSON escolhendo a capacidade “Usando JSON” e copie/cole os arquivos que você baixou.

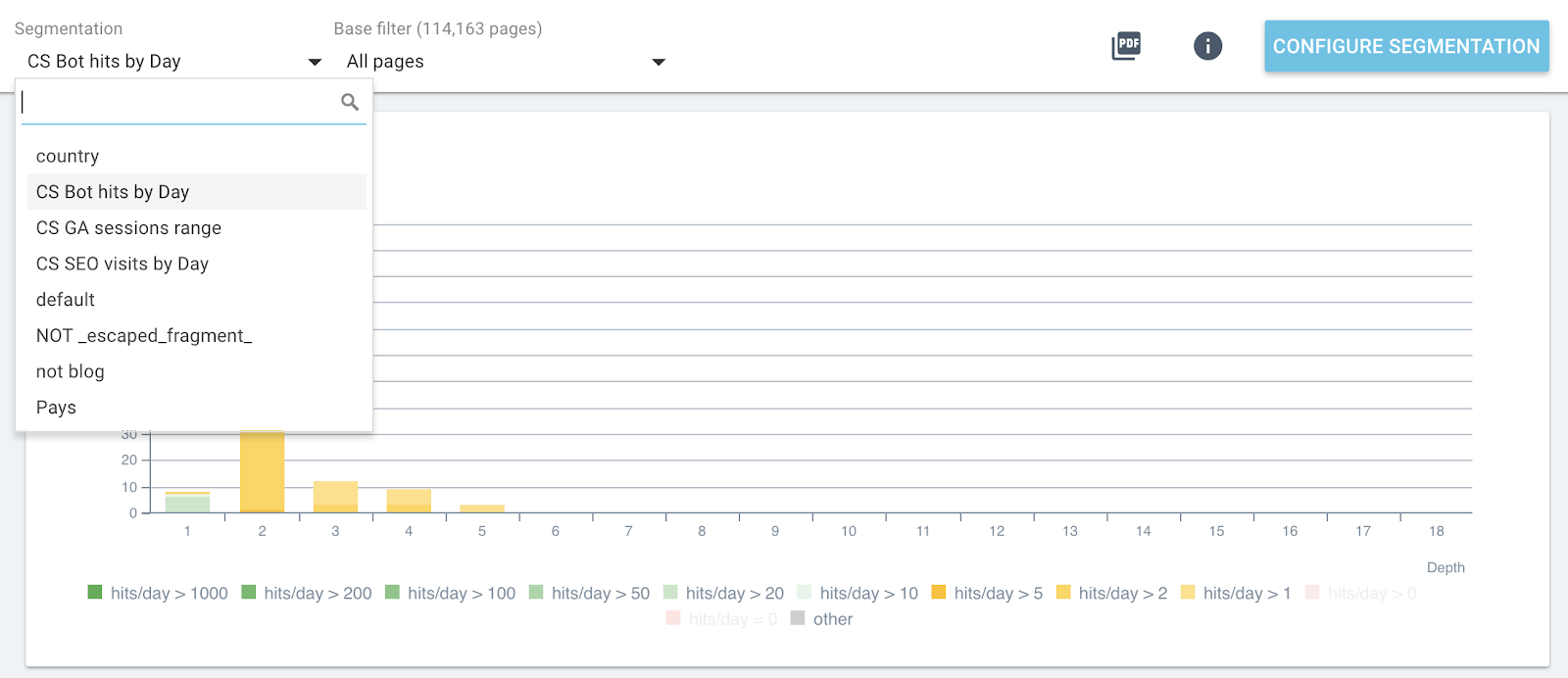

Agora você pode alternar as segmentações usando o menu superior de cada relatório.

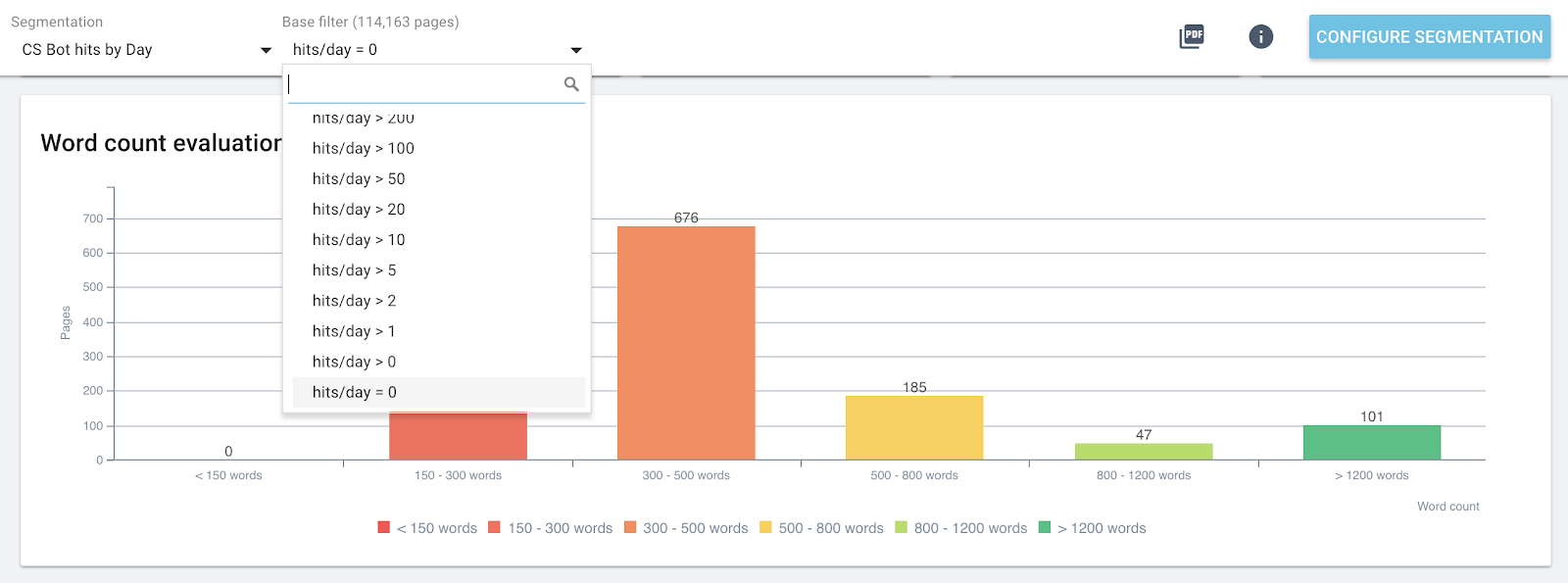

Mudança de segmentação ao vivo em todos os relatórios do OnCrawl

Isso lhe dará em cada gráfico o impacto das métricas que você está analisando e relacionadas a páginas agrupadas por acessos de bot ou visitas de SEO.

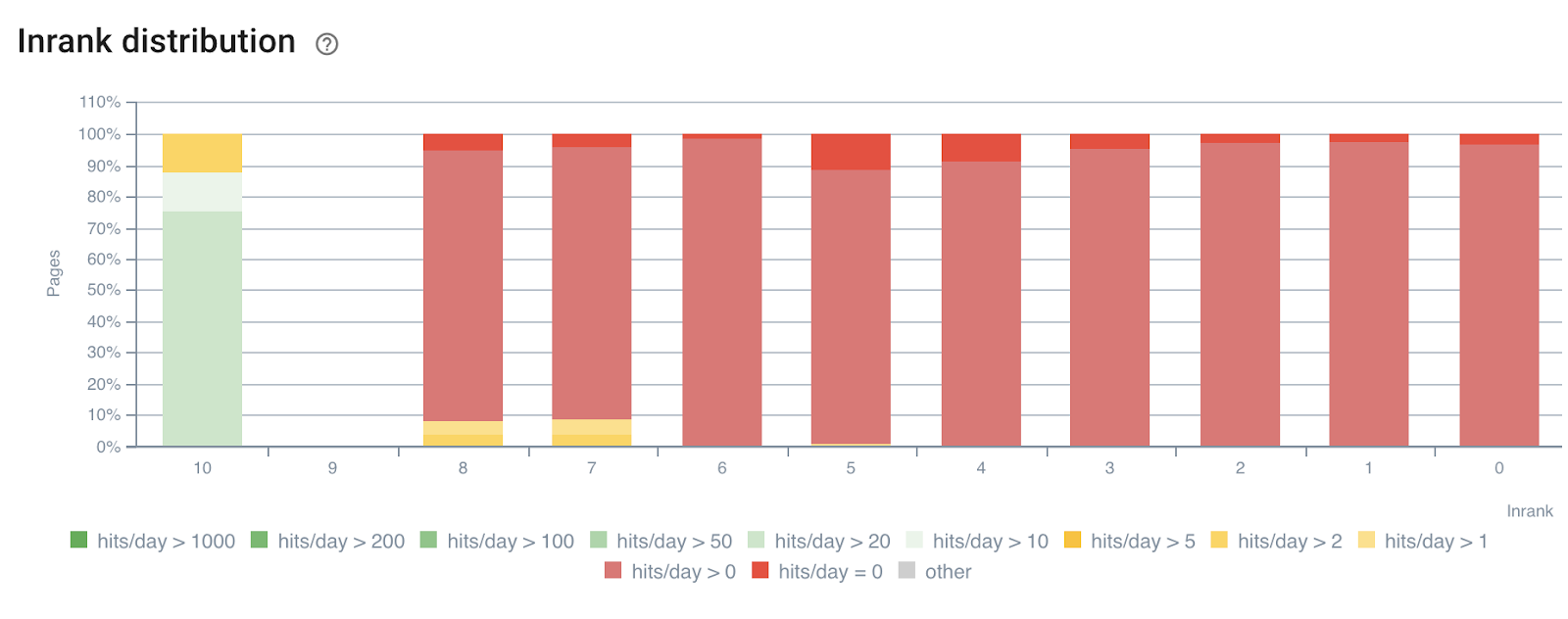

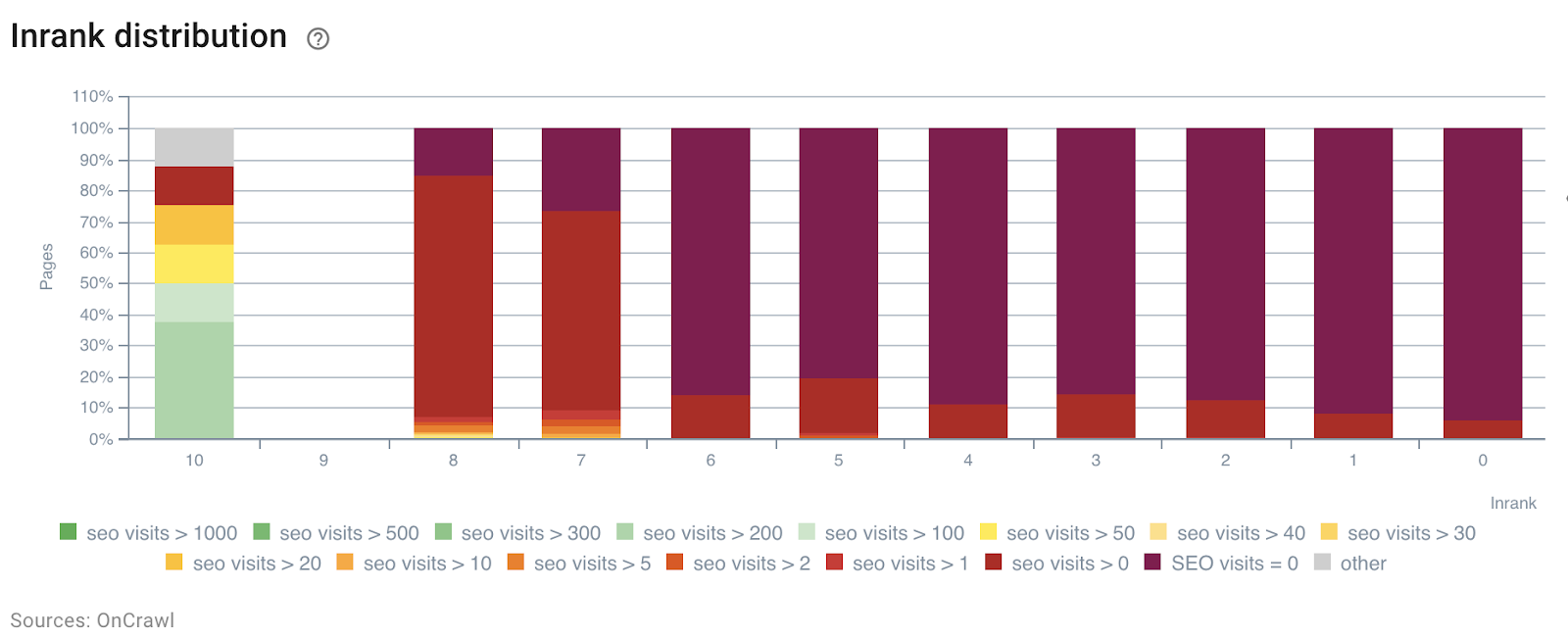

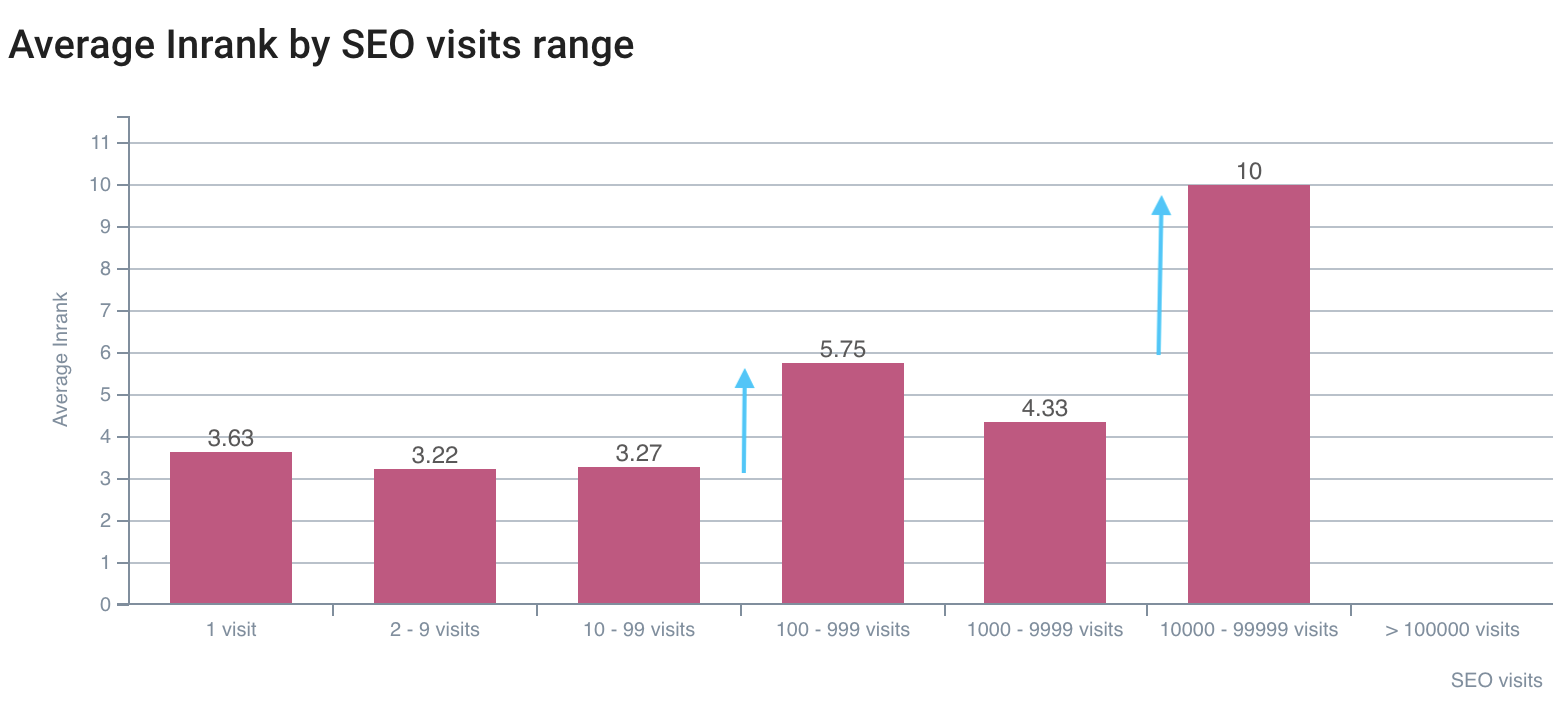

No exemplo a seguir, usamos esses segmentos para entender o impacto da popularidade interna do InRank – com base no poder dos links por profundidade. Além disso, os acessos de bot e as visitas de SEO são correlacionados no mesmo eixo.

Distribuição InRank por acertos de bot por dia

Distribuição InRank por visitas de SEO por dia

A profundidade (o número de cliques da página inicial) tem claramente um impacto nos acessos de bots e nas visitas de SEO.

Da mesma forma, cada grupo de páginas pode ser selecionado de forma independente para destacar os dados das páginas mais acessadas ou visitadas.

Isso permite detectar rapidamente páginas que poderiam ter um desempenho melhor se fossem otimizadas, número de palavras na página, profundidade ou número de links recebidos, por exemplo.

Basta escolher a segmentação correta e o grupo de páginas que deseja analisar.

Distribuição de palavras na página para o grupo contendo 0 bot hit por dia

4# Determine valores de limite para maximizar o orçamento de rastreamento e as visitas de SEO

Para ir além, o Relatório de Impacto SEO – rastreamento e análise de dados cruzados de registro – pode detectar valores de limite que ajudam a aumentar as visitas de SEO, a frequência de rastreamento ou a descoberta de páginas.

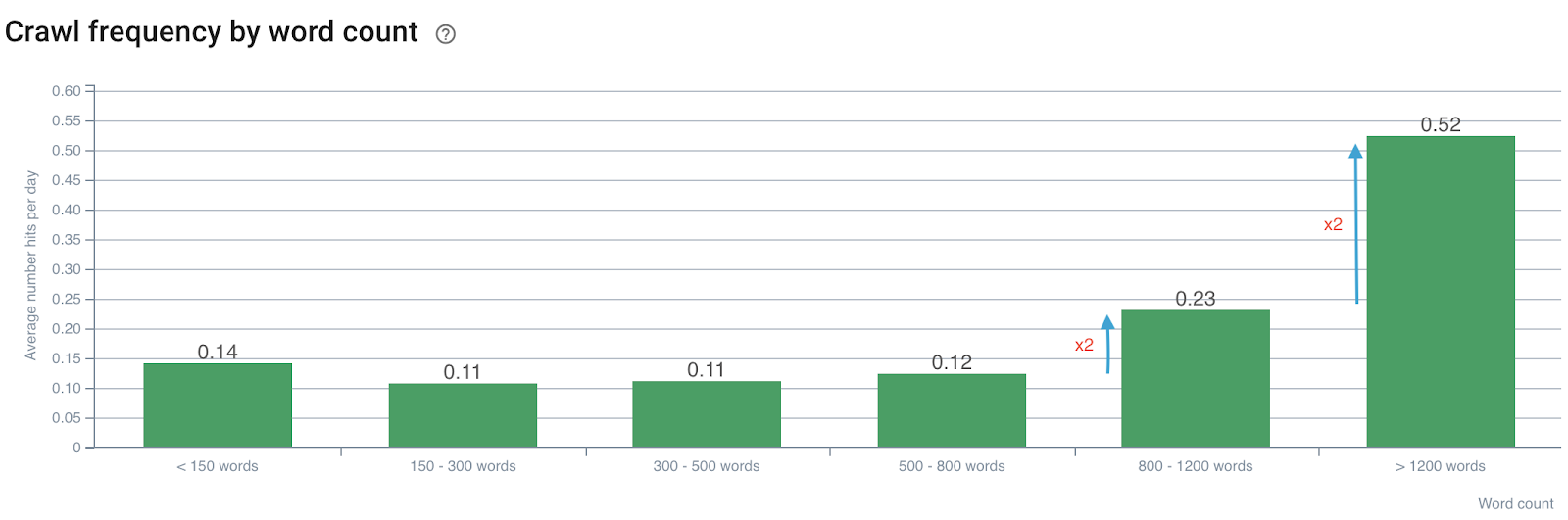

Impacto da contagem de palavras na frequência de rastreamento

Frequência de rastreamento por número de palavras

Observamos que a frequência de rastreamento é dobrada quando o número de palavras excede 800. Então, também dobra quando o número de palavras na página excede 1200 palavras.

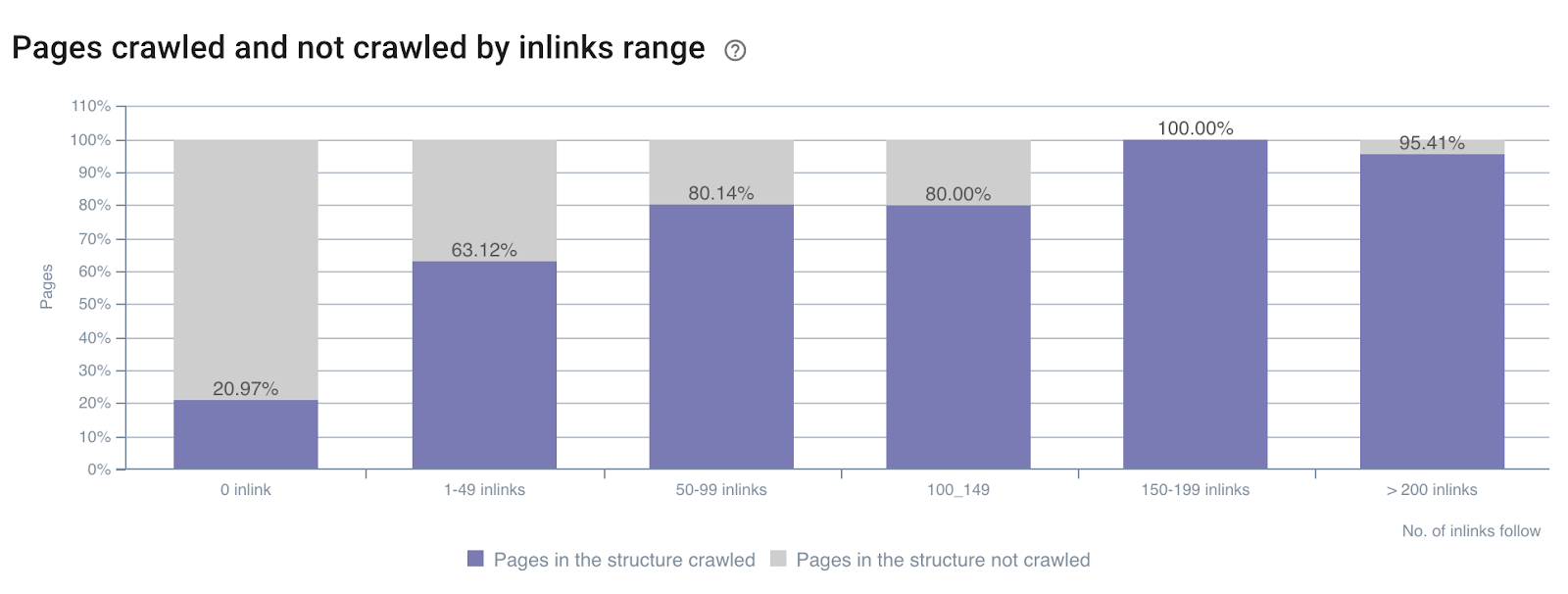

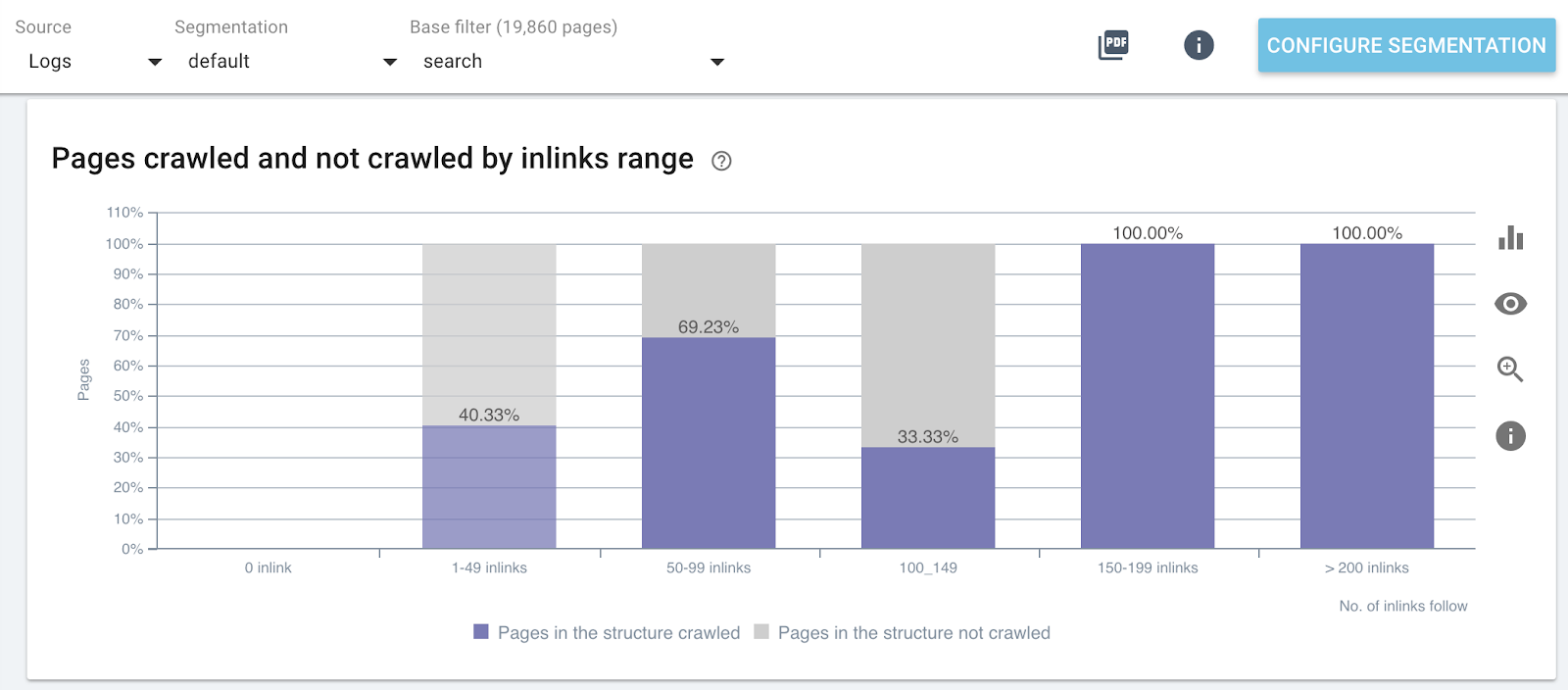

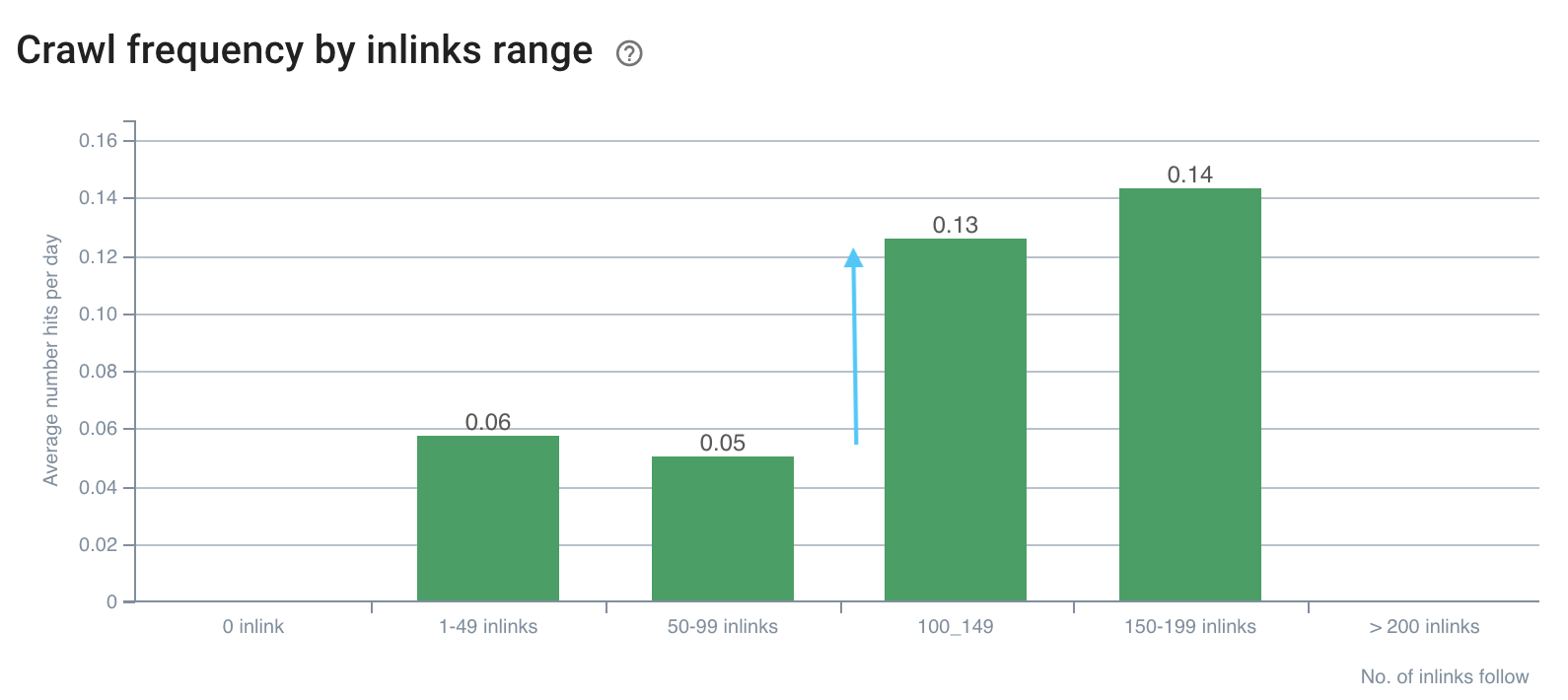

Impacto do número de inlinks na taxa de rastreamento

Taxa de rastreamento por número de inlinks em todo o site

Taxa de rastreamento por número de inlinks em partes específicas do site (páginas de pesquisa)

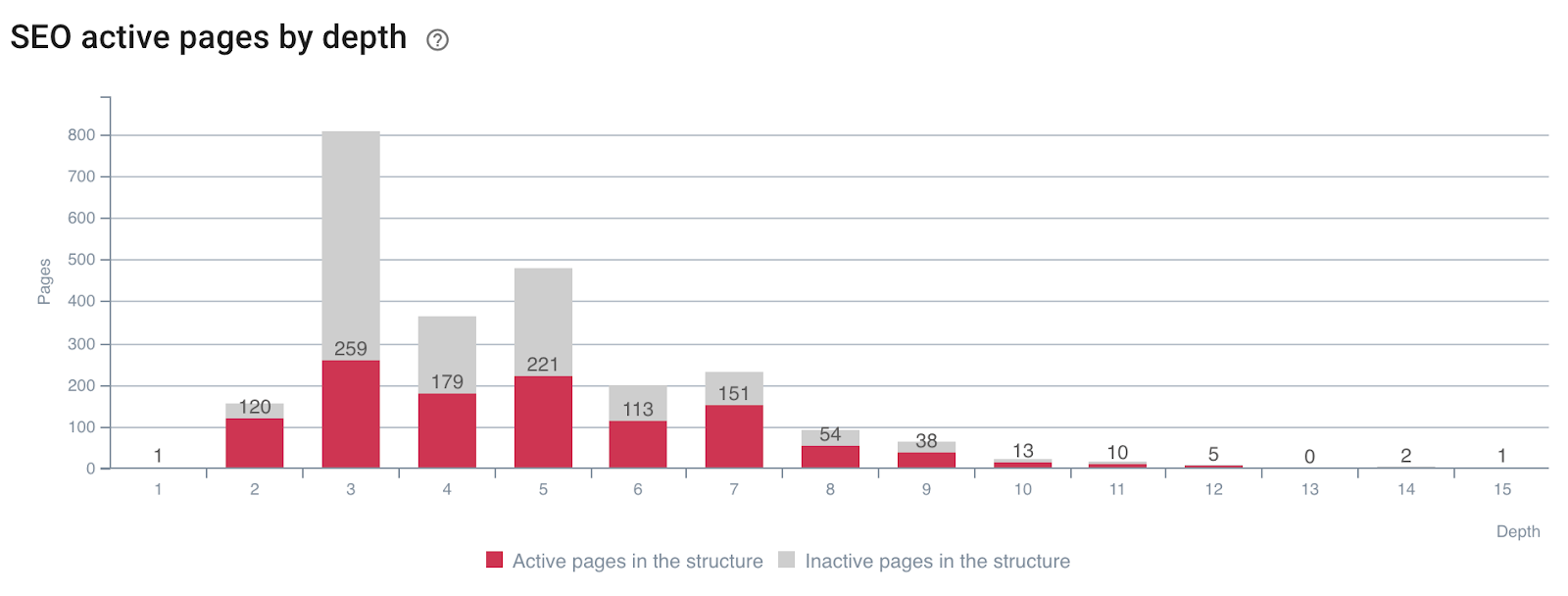

Impacto da profundidade na atividade das páginas

Páginas que geram visitas de SEO (ou não) por profundidade

Você pode ver que ter as métricas corretas do site durante um rastreamento e cruzar dados de logs permite detectar imediatamente quais otimizações de SEO são necessárias para manipular o rastreamento do Google e melhorar suas visitas de SEO.

5# Determine como os fatores de classificação de SEO influenciam sua frequência de rastreamento

Imagine se você pudesse saber quais valores segmentar para maximizar seu SEO? É para isso que serve a análise de dados cruzados! Ele permite determinar com precisão, para cada métrica, em qual frequência limite de rastreamento, taxa de rastreamento ou atividade são maximizadas.

Vimos acima – no exemplo sobre o número de palavras por página e a frequência de rastreamento – que existem valores de gatilho de frequência de rastreamento. Essas lacunas devem ser analisadas e comparadas para cada tipo de página, pois estamos procurando picos no comportamento dos bots ou visitas de SEO.

Como os apresentados abaixo:

A frequência de rastreamento tem uma lacuna em mais de 100 inlinks

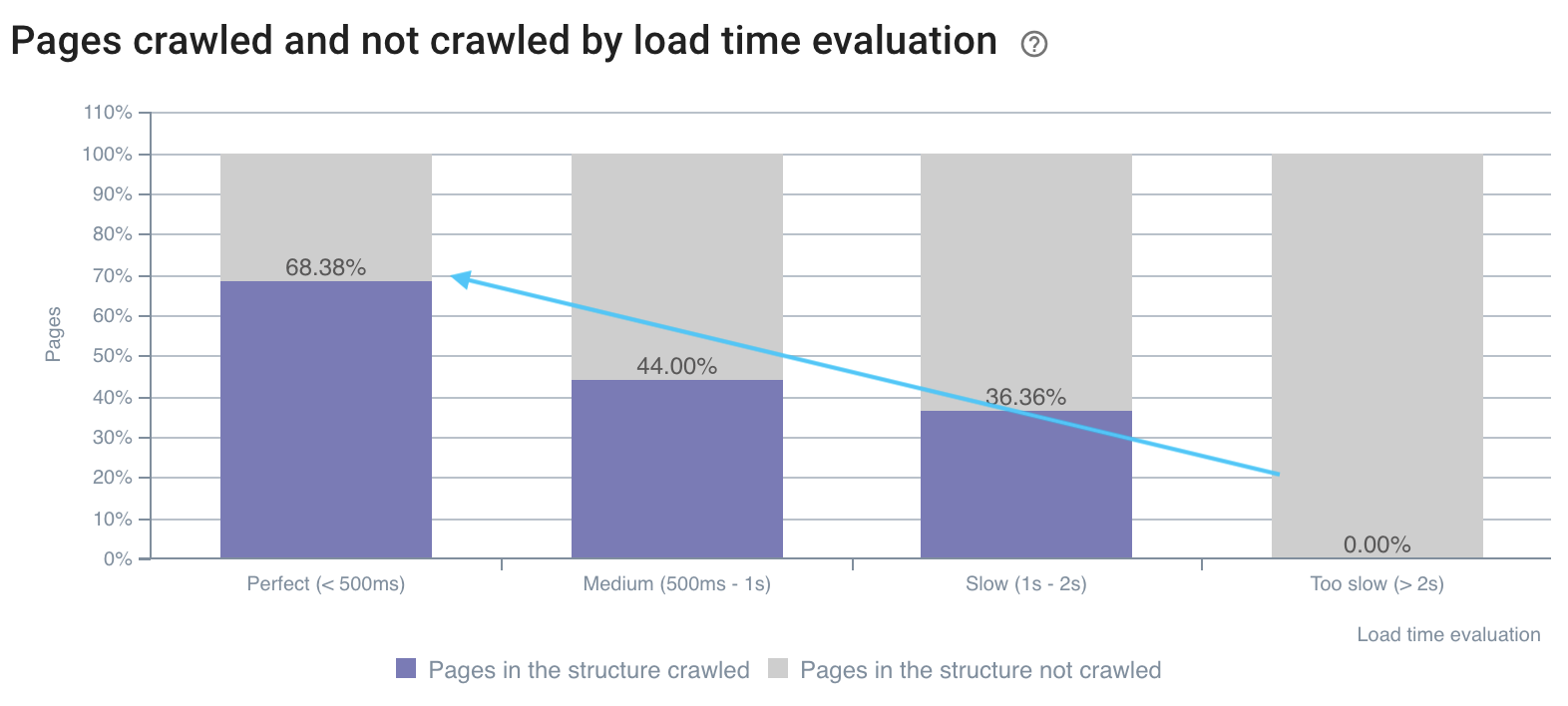

A taxa de rastreamento é melhor em páginas rápidas

A primeira lacuna nas visitas de SEO está no InRank 5,75, a melhor está no InRank 10 (página inicial)

A combinação de dados de rastreamento e registros permite que você abra a caixa preta do Google e determine exatamente o impacto de suas métricas no rastreamento e visitas de bots. Ao implementar suas otimizações nessas análises, você pode melhorar seu SEO na hora de cada um de seus lançamentos. Esse uso avançado é durável no tempo, pois você pode detectar novos valores a serem alcançados em cada análise de dados cruzados.

Algum outro truque com análise de dados cruzados que você gostaria de compartilhar?