Co to jest Robots.txt: definicja, znaczenie i przykłady

Opublikowany: 2022-07-11Być może słyszałeś o tym, że Google indeksuje naszą witrynę i strony w Internecie, a następnie wyświetla je na stronie wyników wyszukiwania.

Cóż, robots.txt informuje Google, które witryny stosują się do ich algorytmów, a które nie. W tym przewodniku udostępniliśmy wszystko, co musisz wiedzieć o pliku robots.txt, przykładach i sposobie ich działania.

Co to jest plik Robots.txt?

Robots.txt to plik tekstowy webmastera, który pomaga robotom internetowym (zwykle robotom wyszukiwarek) indeksować strony w ich domenie. Innymi słowy, plik robots.txt to zestaw instrukcji dla botów.

Plik robots.txt znajduje się w kodzie źródłowym większości witryn.

Plik robots.txt jest częścią protokołu Robots Exclusion Protocol (REP). Określa, w jaki sposób roboty przemierzają strony internetowe, znajdują i indeksują treści oraz udostępniają te informacje osobom, które tego chcą.

Plik robots.txt pomaga robotom wyszukiwarek zrozumieć, które adresy URL powinny zaindeksować w Twojej witrynie.

Dlaczego plik Robots.txt jest ważny?

Istnieją głównie trzy powody, dla których how.txt może ci pomóc:

- Maksymalizuj budżet indeksowania: budżet indeksowania to liczba stron indeksowanych przez boty Google w określonym przedziale czasowym. Robots.txt może pomóc zablokować nieważne lub zduplikowane strony z treścią i skupić się tylko na stronach, które są dla Ciebie ważne, maksymalizując budżet indeksowania i zwiększając widoczność.

- Unikaj indeksowania zasobów: plik Robots.txt może indeksować lub usuwać indeksowanie zasobów, takich jak pliki PDF lub obrazy. W ten sposób do blokowania stron lub zasobów można użyć stron chronionych hasłem lub noindex. Możesz sprawdzić zindeksowane strony za pomocą konsoli wyszukiwania Google i sprawdzić, czy boty indeksują strony, które chcesz zaindeksować.

- Blokuj nieważne strony: w Twojej witrynie są strony, których nie chcesz wyświetlać w wynikach wyszukiwania Google. Może to być strona logowania lub wersja testowa/testowa Twojej witryny. Korzystając z pliku robots.txt, możesz blokować te strony i skupiać się tylko na stronach, które mają znaczenie.

Przykłady pliku robots.txt

Oto kilka przykładów pliku robots.txt:

Klient użytkownika: Googlebot

Nie zezwalaj: /niegooglebot/

Agent użytkownika: *

Umożliwić: /

Mapa witryny: http://www.example.com/sitemap.xml

Podobnie w przypadku wyszukiwarki Bing wygląda to:

Klient użytkownika: Bingbot

Disallow: /example-subfolder/blocked-page.html

Składnia pomaga robotowi indeksującemu uniknąć indeksowania określonej strony.

Warto zauważyć, że każda subdomena potrzebuje własnego pliku robots.txt.

Na przykład, podczas gdy www.cloudflare.com ma swój własny plik, wszystkie subdomeny Cloudflare (blog.cloudflare.com, community.cloudflare.com itd.) również wymagają własnych.

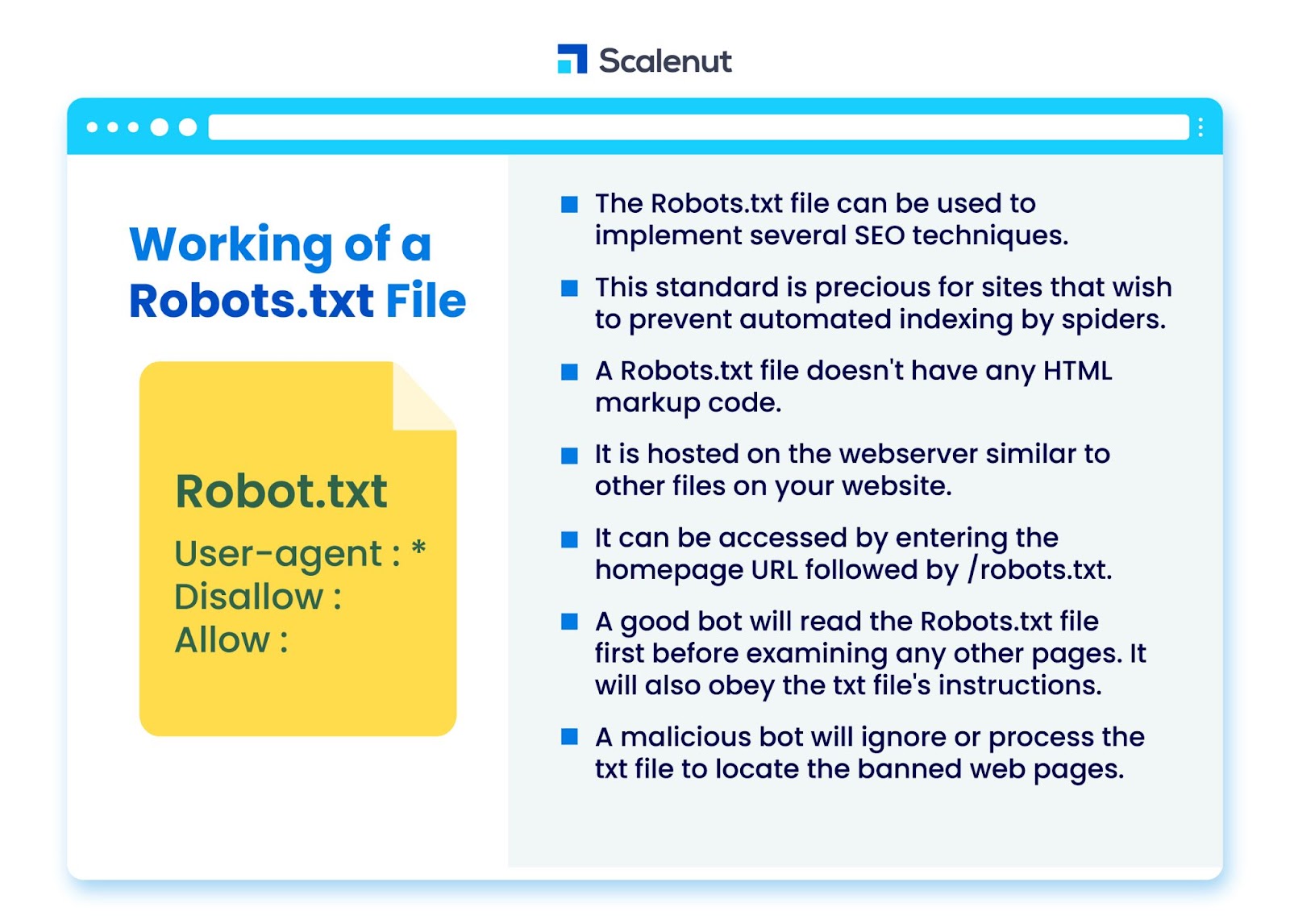

Jak działa plik Robots.txt?

Plik robots.txt może być wykorzystany do wdrożenia kilku technik optymalizacji pod kątem wyszukiwarek (SEO), takich jak nieindeksowane strony lub plik robots txt, który blokuje dostęp do wszystkich lub określonych części witryny przez programy typu boty.

Norma jest szczególnie cenna w przypadku witryn, które chcą uniemożliwić pająkom indeksowanie ich treści za pomocą zautomatyzowanych procesów, takich jak wyszukiwanie i oprogramowanie do rankingu stron za pomocą automatycznych robotów indeksujących.

Plik robots.txt to plik bez kodu znaczników HTML. Jest hostowany na serwerze WWW, podobnie jak inne pliki w Twojej witrynie.

Dostęp do niego można uzyskać, wprowadzając adres URL strony głównej, a następnie /robots.txt. Ogólnym przykładem jest https://www.xyz.com/robots.txt.

Ponieważ plik nie jest połączony nigdzie indziej w witrynie, użytkownicy raczej nie natkną się na niego, ale większość robotów indeksujących będzie go szukać przed zindeksowaniem reszty witryny.

Dobry bot, taki jak robot Google lub bot kanału informacyjnego, najpierw odczyta plik robots.txt przed zbadaniem innych stron w witrynie i zastosuje się do instrukcji.

Złośliwy bot zignoruje lub przetworzy plik robots.txt, aby znaleźć zakazane strony internetowe.

Blokowanie pliku robots.txt

Plik robots.txt zawiera instrukcje informowania robotów o wszelkich regułach blokowania w witrynie, którą można przeszukiwać w inny sposób, zindeksowanej przez Googlebota, które mają na celu uniemożliwienie robotowi dostępu do stron o określonej zawartości.

Nie dotyczy zwykłych użytkowników ani botów, które po prostu przeglądają witryny bez ich indeksowania.

Z biegiem czasu witryny blokowały aplikacje mobilne, JavaScript i inne części swojej witryny przy użyciu tej metody, jednocześnie zezwalając na niektóre elementy, takie jak obrazy.

Jakie protokoły są używane w pliku Robots.txt?

Protokół to format przesyłania instrukcji lub rozkazów w sieci. Pliki robots.txt wykorzystują różne protokoły. Protokół podstawowy jest znany jako Protokół Wykluczenia Robotów.

Instruuje boty, których stron internetowych i zasobów należy unikać.

Protokół sitemaps to kolejny protokół używany w plikach robots.txt. Można to traktować jako protokół włączenia robota.

Mapy witryn informują roboty indeksujące o stronach, do których mogą uzyskać dostęp. Dzięki temu robot indeksujący nie przeoczy żadnych kluczowych stron.

Co to jest mapa witryny?

Mapa witryny to plik XML opisujący informacje używane przez roboty indeksujące do wyświetlania stron Twojej witryny. Mapa witryny zawiera wszystkie adresy URL w Twojej witrynie, w tym ich tytuły i opisy oraz inne powiązane informacje.

Ten dokument pomaga wyszukiwarkom w prawidłowym indeksowaniu tych elementów, aby odwiedzający mogli je szybko znaleźć za pomocą wyszukiwarek lub innych systemów nawigacji.

Co to jest klient użytkownika?

User-agent user-agent: *disallow: /nogooglebot/ user-agent user-agent: Googlebot

Nie zezwalaj na wszystkie reguły w pliku robots.txt, niezależnie od klienta użytkownika. Uniemożliwi to żadnemu robotowi indeksującemu dostęp do Twojej witryny. Jest to najczęściej używane przez strony internetowe wrażliwe na obawy dotyczące prywatności (i dlatego nie chcą ujawniać danych swoich użytkowników).

Typowe nazwy agentów użytkownika bota wyszukiwarki obejmują:

Google :

- Googlebot

- Obraz Googlebota (dla obrazów)

- Googlebot-Wiadomości (dla wiadomości)

- Googlebot-wideo (dla wideo)

Bing:

- Bingbot

- MSNBot-Media (dla obrazów i wideo)

Baidu:

- Baiduspider

Co to jest plik .txt?

TXT to rozszerzenie pliku tekstowego obsługiwane przez wiele edytorów tekstu.

Nie ma takiej statycznej definicji pliku tekstowego, natomiast istnieje kilka popularnych formatów, w tym ASCII (format wieloplatformowy) i ANSI (używany na platformach DOS i Windows). TXT to skrót od TeXT. Tekst/zwykły to typ MIME.

W pliku tekstowym robots.txt każda reguła określa wzorzec adresów URL, do których mają dostęp wszystkie lub tylko określone roboty.

Każdy wiersz powinien zaczynać się od jednego dwukropka (:) i zawierać 1–3 wiersze, ignorując puste wiersze. Każda linia jest interpretowana jako nazwa pliku, która może być bezwzględna lub względna w stosunku do katalogu, w którym jest umieszczona.

Czy roboty internetowe są takie same jak robots.txt?

Niektóre wyszukiwarki mogą nie obsługiwać dyrektyw txt.

Instrukcje zawarte w plikach robots.txt nie mogą zmusić robotów indeksujących do odwiedzenia Twojej witryny; od robota zależy, czy będzie je śledził. Z kolei Googlebot i inne dobrze znane roboty internetowe przestrzegają reguł zawartych w pliku robots.txt.

Jak zaimplementować plik Robots.txt?

Plik robots.txt można zaimplementować w prawie każdym edytorze tekstu. Na przykład Notatnik, TextEdit, vi i emacs mogą generować prawidłowe pliki robots.txt.

Poniżej znajdują się zasady postępowania z plikiem robots.txt:

- Nazwa pliku powinna brzmieć robots.txt.

- Plik robots.txt może służyć do ograniczania dostępu do subdomen (na przykład https://website.example.com/robots.txt) lub niestandardowych portów.

- Plik robots.txt musi być w formacie UTF-8 (w tym ASCII). Google może odrzucać znaki spoza zakresu UTF-8, potencjalnie unieważniając przepisy dotyczące pliku robots.txt.

- Plik robots.txt zwykle znajduje się w katalogu głównym hosta witryny, do którego jest stosowany. Aby umożliwić indeksowanie pod wszystkimi adresami URL, takimi jak ten – https://www.example.com/, plik robots.txt musi znajdować się pod adresem https://www.example.com/robots.txt. Nie można go umieścić w podkatalogu (np. https://example.com/pages/robots.txt).

Ograniczenia pliku Robots.txt

Oto ograniczenia pliku robots.txt:

- Wszystkie wyszukiwarki nie obsługują pliku Robots.txt: pliki Robots.txt nie mogą zmusić robotów indeksujących do odwiedzenia Twojej witryny; od robota zależy, czy będzie je śledził. Podczas gdy Googlebot i inne godne zaufania roboty indeksujące będą postępować zgodnie z instrukcjami zawartymi w pliku robots.txt, inne roboty mogą tego nie robić.

- Różne przeszukiwacze różnie interpretują składnię: chociaż renomowane roboty-pająki internetowe stosują się do dyrektyw zawartych w pliku robots.txt, każdy przeszukiwacz może inaczej interpretować dyrektywy.

- Niedozwolona strona może zostać zindeksowana, jeśli jest połączona z innymi stronami: chociaż Google nie będzie pobierać ani indeksować treści objętych ograniczeniami w pliku robots.txt, może znaleźć i zaindeksować niedozwolony adres URL, jeśli jest do niego link z innych lokalizacji w internecie.

W rezultacie adres URL i być może inne publicznie dostępne informacje, takie jak tekst kotwicy w linkach do strony, mogą nadal pojawiać się w wynikach wyszukiwania Google.

FAQ

Q1. Gdzie w witrynie znajduje się plik robots.txt?

Odp.: Plik robots.txt jest zwykle umieszczany w katalogu głównym Twojej witryny, ale może znajdować się w dowolnym miejscu witryny, do którego chcesz ograniczyć dostęp.

Q2. Czy potrzebny jest plik robots.txt?

Odp.: Krótka odpowiedź brzmi: nie. W przypadku witryny internetowej plik robots.txt nie jest konieczny. Jeśli bot odwiedzi Twoją witrynę i nie ma pliku robots.txt, będzie przemierzał i indeksował strony w normalny sposób. Plik .txt jest wymagany tylko wtedy, gdy chcesz mieć większą kontrolę nad tym, co jest indeksowane.

Q3. Czy plik robots.txt jest bezpieczny?

Odp.: Plik robots.txt sam w sobie nie stanowi zagrożenia bezpieczeństwa, a jego właściwe użycie może stanowić dobrą praktykę ze względów niezwiązanych z bezpieczeństwem. Nie należy oczekiwać, że wszystkie roboty internetowe będą postępować zgodnie z instrukcjami zawartymi w pliku.

Q4. Czy dostęp do pliku robots.txt jest nielegalny?

Odp.: Plik robots.txt to licencja dorozumiana przez właściciela witryny. Jeśli znasz plik robots.txt, dalsze skanowanie witryny bez pozwolenia może zostać uznane za nieautoryzowany dostęp lub włamanie.

P5. Co to jest opóźnienie indeksowania w robots txt?

Odp.: Dyrektywa o opóźnieniu indeksowania to sposób na nakazanie robotom indeksującym spowolnienia, aby serwer WWW nie był przeciążony.

Wniosek

Robots.txt to prosty plik, który ma dużą moc. Jeśli wiesz, jak go dobrze wykorzystać, może pomóc w SEO. Utworzenie odpowiedniego typu pliku robots.txt oznacza, że poprawiasz również swoje SEO i doświadczenie użytkownika.

Boty będą mogły prezentować Twoje treści w SERPach tak, jak chcesz, aby były widziane, jeśli pozwolisz im indeksować właściwe rzeczy.

Jeśli chcesz dowiedzieć się więcej o SEO i ważnych czynnikach, sprawdź wiele innych blogów Scalenut.