Metaanaliza w kontrolowanych eksperymentach online: bezstronne spojrzenie na moc i ograniczenia tej metody naukowej

Opublikowany: 2022-09-28

Jak przydatna jest metaanaliza w testach A/B i innych eksperymentach online?

Czy jest to pomocne w wykorzystaniu przeszłej nauki w celu poprawy generowania hipotez? A może metaanaliza to tylko leniwa wymówka, aby po prostu polegać na „sprawdzonych wzorcach”, zamiast budować na danych specyficznych dla sytuacji, aby wprowadzać innowacje w firmie dzięki doświadczeniu?

To gorący temat debaty. Niektórzy są za, a niektórzy są temu przeciwni. Ale jak możesz skorzystać z obu punktów widzenia i wnieść namacalną wartość do swojego programu eksperymentów?

O tym jest ten post. W nim będziesz

- Zrozum, czym właściwie jest metaanaliza

- Zobacz przykłady metaanalizy w działaniu

- Dowiedz się, dlaczego metaanalizę jako koncepcję należy traktować z ostrożnością (i szacunkiem) oraz

- Dowiedz się, jak zespoły eksperymentujące mogą przeprowadzać metaanalizę we właściwy sposób

I z premią: zobaczysz również, jak dwóch znanych ekspertów ds. optymalizacji współczynnika konwersji omawia to z przeciwnych stron.

Przejdźmy do tego.

- Co to jest metaanaliza?

- Przykłady metaanalizy w kontrolowanych eksperymentach online

- Chcesz przeprowadzić własną metaanalizę testów A/B?

- Metaanaliza – tak lub nie

- Metaanaliza — stąpać ostrożnie?

- Nie rezygnuj z rygoru testowania i dążenia do innowacji

- Metaanaliza — smarowanie eksperymentalnego koła zamachowego?

- Metaanaliza — stąpać ostrożnie?

- Jeśli zdecydujesz się przeprowadzić (i wykorzystać) metaanalizę – pamiętaj o następujących kwestiach

- Niska jakość eksperymentów uwzględnionych w analizie

- Niejednorodność

- Stronniczość publikacji

Co to jest metaanaliza?

Metaanaliza wykorzystuje statystyki do podjęcia decyzji o przeanalizowaniu wyników wielu eksperymentów. Pochodzi ze świata nauki, gdzie badacze zbierają wyniki badań medycznych dotyczących tego samego problemu i wykorzystują analizę statystyczną, aby ocenić, czy efekt jest rzeczywiście obecny i jak istotny.

W kontrolowanych eksperymentach online, w których stosujemy testy A/B, testy na wielu odmianach i testy dzielone służące do podejmowania decyzji i znajdowania najskuteczniejszych sposobów realizacji celów biznesowych, pożyczyliśmy metaanalizę, aby wykorzystać to, czego nauczyliśmy się już z poprzednich testy informujące o przyszłych testach.

Zobaczmy różne przykłady na wolności.

Przykłady metaanalizy w kontrolowanych eksperymentach online

Oto 3 przykłady metaanalizy w testach A/B, w jaki sposób została wykorzystana i co znaleziono w każdym wysiłku:

- Empiryczna metaanaliza strategii testowania A/B w e-commerce autorstwa Alexa P. Millera i Kartika Hosanagara

Ta metaanaliza testów A/B została opublikowana w marcu 2020 r. Analitycy przeanalizowali testy specjalnie z branży e-commerce, korzystając z danych zebranych z platformy testowej SaaS A/B. Składał się on z 2732 testów A/B przeprowadzonych przez 252 amerykańskie firmy e-commerce w 7 branżach w okresie 3 lat.

Przeanalizowali te testy, aby zapewnić solidną analizę tego, jak testy są pozycjonowane na różnych etapach lejka konwersji e-commerce.

To, co znaleźli, to:

- W porównaniu z innymi typami eksperymentów, testy na promocjach cenowych i te pozycjonowane na stronach kategorii są związane z największymi rozmiarami efektów.

- Dowody na to, że reakcja konsumentów na różne promocje zależy od umiejscowienia tych promocji w witrynie handlu elektronicznego.

- Podczas gdy promocje dotyczące cen produktów są najskuteczniejsze na początku ścieżki konwersji, promocje związane z wysyłką są najskuteczniejsze pod koniec ścieżki konwersji (na stronach produktów i w kasie).

Spójrzmy na inny przykład i to, co odkryli badacze…

- Co działa w e-commerce — metaanaliza 6700 eksperymentów Willa Browne'a i Mike'a Swarbricka Jonesa

Na podstawie danych z 6700 dużych eksperymentów e-commerce, głównie w sektorach handlu detalicznego i podróży, Browne i Jones zbadali wpływ 29 różnych rodzajów zmian i oszacowali ich skumulowany wpływ na przychody. Został opublikowany w czerwcu 2017 roku.

Jak sugeruje tytuł artykułu, celem było zbadanie, co działa w e-commerce poprzez przeprowadzenie dużej metaanalizy. W ten sposób mogli dojść do tego potężnego podsumowania: zmiany w wyglądzie witryny miały znacznie mniejszy wpływ na przychody niż zmiany oparte na psychologii behawioralnej.

Do pomiaru tego wpływu używany jest wskaźnik przychodu na użytkownika (RPV). Tak więc w ich wynikach wzrost o +10% z eksperymentu oznacza, że RPV w tym eksperymencie wzrósł o 10%.

Oto kilka innych ustaleń z analizy:

- Najlepsze wyniki (według kategorii) to:

- Niedobór (wskaźniki giełdowe, na przykład „Pozostały tylko 3”): +2,9%

- Dowód społeczny (informowanie użytkowników o zachowaniu innych): +2,3%

- Pilność (odliczanie czasu): +1,5%

- Odzyskiwanie porzucenia (wysyłanie wiadomości do użytkowników, aby zatrzymać ich na stronie): +1,1%

- Rekomendacje produktów (up-sell, cross-sell itp.): +0,4%

- Ale kosmetyczne zmiany w interfejsie użytkownika, takie jak te poniżej, nie były skuteczne:

- Kolor (zmiana koloru elementów strony): +0.0%

- Przyciski (modyfikacja przycisków strony): -0,2%

- Wezwania do działania (zmiana tekstu): -0,3%

- 90% eksperymentów miało mniej niż 1,2% wpływ na przychody, pozytywny lub negatywny

- Niewiele dowodów na to, że testy A/B prowadzą do dwucyfrowych wzrostów przychodów, które często pojawiają się w studiach przypadków.

Teraz czekaj. Zanim uznasz te wyniki metaanalizy za ewangelię, musisz wiedzieć, że metaanaliza eksperymentów online ma swoje ograniczenia. Zajmiemy się tym później.

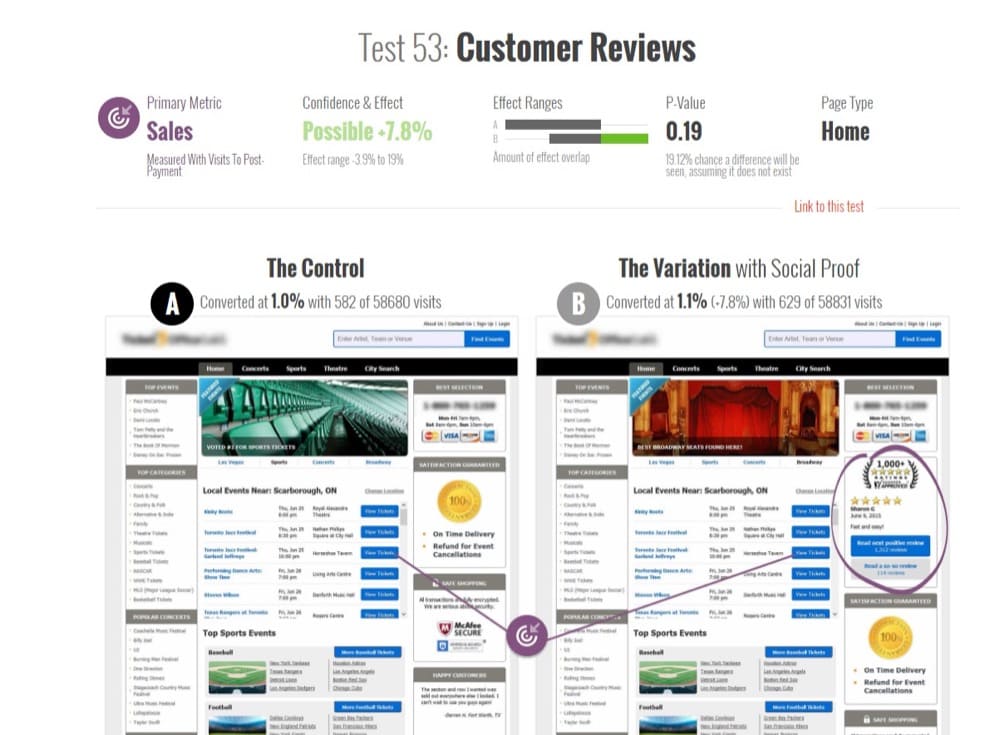

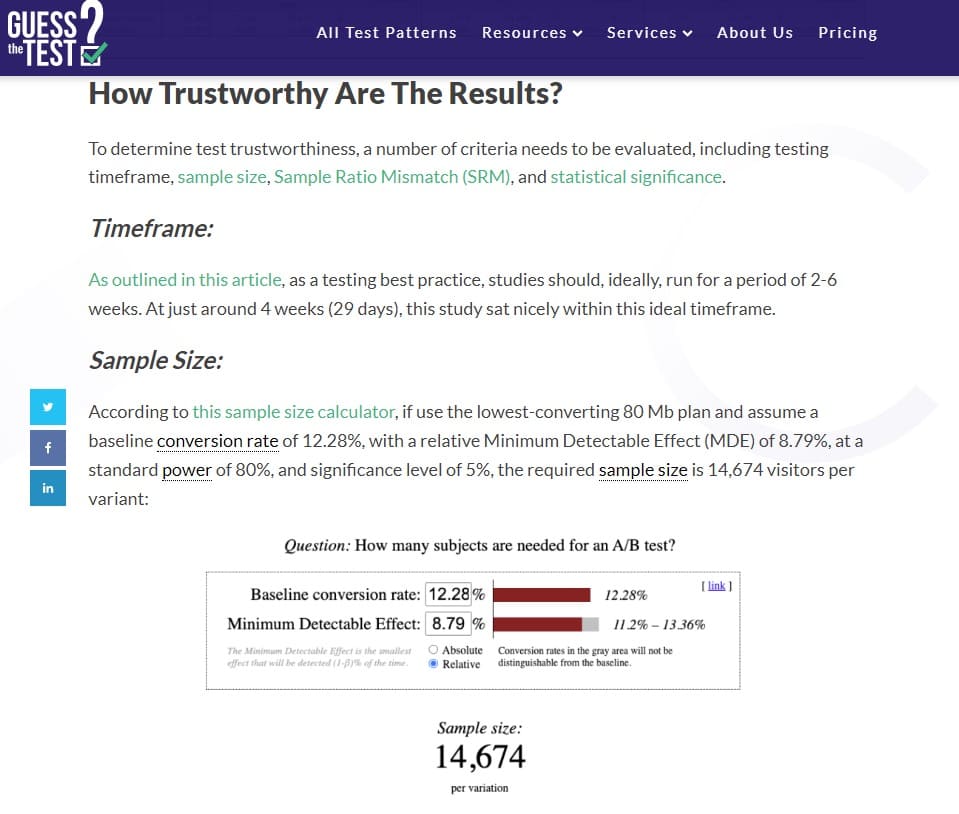

- Metaanaliza 115 testów A/B na GoodUI.org autorstwa Georgi Georgiev

W czerwcu 2018 r. ekspert od eksperymentów online i autor „Metod statystycznych w testowaniu A/B online”, Georgi Georgiev, przeanalizował 115 publicznie dostępnych testów A/B na GoodUI.org.

GoodUI.org publikuje zbiór wyników eksperymentów, w tym nowo odkryte wzorce interfejsu użytkownika oraz to, czego firmy eksperymentujące, takie jak Amazon, Netflix i Google, uczą się na podstawie swoich testów.

Celem Georgi było zebranie i przeanalizowanie tych danych w celu ujawnienia średnich wyników testów i przedstawienia pomysłów na lepsze praktyki statystyczne podczas projektowania i przeprowadzania metaanalizy testów A/B.

Zaczął od przycięcia początkowego zestawu danych i dokonania pewnych korekt statystycznych. Obejmowały one usunięcie:

- Testy z nierównowagą między liczbą użytkowników wysłanych w celu wypróbowania kontroli a tymi wysłanymi w celu przetestowania wyzwania, oraz

- Zakłócone testy (zauważone przez ich nierealistycznie niską moc statystyczną).

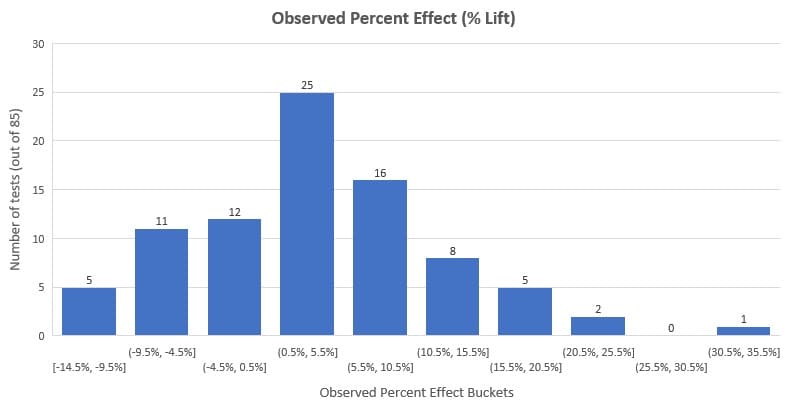

Przeanalizował pozostałe 85 testów i stwierdził, że średni wzrost procentowy wyniósł 3,77%, a mediana 3,92%. Patrząc na poniższy rozkład, zobaczysz, że 58% testów (to większość) dało zaobserwowany efekt (wzrost %) między -3% a +10%.

Należy zauważyć, że reprezentuje to ten zestaw danych, a nie wszystkie testy A/B, jakie kiedykolwiek przeprowadzono. Dodatkowo musimy uwzględnić stronniczość publikacji (jedna z wad metaanalizy, którą omówimy później).

Ta metaanaliza jest jednak pomocna dla optymalizatorów współczynnika konwersji i innych interesariuszy optymalizacji, aby mieć poczucie, jakie są zewnętrzne testy porównawcze w testach A/B.

Chcesz przeprowadzić własną metaanalizę testów A/B?

Otrzymasz dostęp do tego samego zestawu danych, z którego korzysta Georgi. Jest publicznie dostępny na GoodUI.org — repozytorium wydestylowanych wyników testów A/B przeprowadzonych na różnych platformach, branżach i dla różnych podstawowych problemów.

Istnieją inne kolekcje wyników testów A/B, takie jak ta (możesz nawet stworzyć swoje, pobierając dane z licznych przykładów testów A/B i studiów przypadków), ale GoodUI jest wyjątkowy. Otrzymasz dodatkowe informacje statystyczne o teście, które w innym przypadku są niemożliwe lub trudne do uzyskania, jeśli surfujesz i zbierasz studia przypadków.

Jeszcze kilka rzeczy sprawia, że GoodUI jest wyjątkowy:

- Nie dyskryminuje na podstawie wyników eksperymentu. Obejmuje zwycięskie, niejednoznaczne, płaskie i negatywne testy mające na celu zwalczanie stronniczości publikacji w metaanalizie, co jest prawdziwym problemem, jak stwierdzono w „Metaanalizie, wykresach lejka i analizie wrażliwości” Johna Copasa i Jian Qing Shi.

Stronniczość publikacyjna to preferencja publikowania małych badań, jeśli ich wyniki są „istotne”, w porównaniu z badaniami z wynikami negatywnymi lub niejednoznacznymi. Nie możesz tego naprawić bez robienia niesprawdzalnych założeń.

- GoodUI idzie o krok dalej. Często wyniki metaanaliz są ukryte w artykułach naukowych. Rzadko kiedy trafiają do praktycznego zastosowania, zwłaszcza w przypadku zespołów eksperymentujących, które nie są zbyt dojrzałe.

Dzięki wzorcom GoodUI ciekawscy optymalizatorzy mogą zagłębić się w obserwowaną zmianę procentową, obliczenia istotności statystycznej i przedziały ufności. Mogą również wykorzystać ocenę GoodUI dotyczącą tego, jak silny jest wynik, z możliwymi wartościami „Nieistotne”, „Możliwe”, „Znaczące” i „Silne”, idące w obu kierunkach dla każdego wzorca konwersji. Można powiedzieć, że „demokratyzuje” spostrzeżenia z metaanaliz testów A/B.

- Jest jednak pewien problem. Eksperymentatorzy, którzy mogą nie być świadomi problemów nękających metaanalizę – heterogeniczności i stronniczości publikacji – oraz faktu, że wyniki metaanalizy zależą od jakości samej metaanalizy, mogą skręcić w obszar ślepego kopiowania wzorców.

Powinni raczej przeprowadzić własne badania i przeprowadzić testy A/B. Nieprzestrzeganie tego ostatnio (słusznie) było powodem do niepokoju w przestrzeni CRO.

Innym źródłem analizy przypadków testów A/B, w którym możesz zagłębić się w podobną szczegółowość niektórych testów, takich jak GoodUI, jest GuessTheTest.

OŚWIADCZENIE : Nie piszemy tego bloga z zamiarem panoramowania lub chwalenia metaanaliz i wzorców konwersji. Przedstawimy tylko plusy i minusy, o których dyskutują eksperci z dziedziny CRO. Chodzi o to, by metaanalizę przedstawić jako narzędzie, aby można było z niej korzystać według własnego uznania.

Metaanaliza – tak lub nie

Inteligentny umysł szuka wzorców. W ten sposób skracasz drogę od problemu do rozwiązania, gdy następnym razem pojawi się podobny problem.

Te wzorce prowadzą do odpowiedzi w rekordowym czasie. Dlatego jesteśmy skłonni wierzyć, że możemy zebrać to, czego nauczyliśmy się z eksperymentów, i wywnioskować wzór.

Ale czy jest to wskazane dla zespołów eksperymentujących?

Jakie są argumenty za i przeciw metaanalizie w kontrolowanych eksperymentach online? Czy potrafisz znaleźć kompromis, który łączy to, co najlepsze z obu światów?

Zapytaliśmy dwa najgłośniejsze głosy w dziedzinie eksperymentowania z (z całym szacunkiem) różnymi punktami widzenia o ich podejście do metaanalizy.

Jonny Longden i Jakub Linowski to głosy, którym można zaufać.

Metaanaliza — stąpać ostrożnie?

W powyższej dyskusji Jonny wskazał na dwa potencjalne problemy z wykorzystaniem danych metaanalizy w testach online, które wymagają od praktyków CRO ostrożności.

- Zagadnienie 1: Korzystanie z wyniku bez testowania

„Jeśli to zadziałało dla tej firmy, powinno zadziałać również dla nas”. Może to okazać się błędnym myśleniem, ponieważ istnieją niuanse związane z testowaniem, które nie trafiają do fragmentu sprawdzanych wyników.

Kilka testów może zademonstrować bezproblemowe rozwiązanie, ale jest to tylko prawdopodobieństwo, że może działać nieco lepiej niż inne rozwiązania, a nie ostateczna odpowiedź, że będzie działać w Twojej witrynie.

- Zagadnienie #2: Nie da się tak łatwo sklasyfikować testów

Jak wspomniano w punkcie 1, wyniki te nie pokazują pełnej, zniuansowanej historii kryjącej się za testami. Nie widzisz, dlaczego testy zostały przeprowadzone, skąd pochodzą, jakie były wcześniejsze problemy na stronie itp.

Widzisz tylko, że był to test na przykład na wezwaniu do działania na stronie produktu. Ale bazy danych metaanalizy posortują je według określonych wzorców, nawet jeśli nie pasują do tych wzorców.

Co to oznacza dla Ciebie, użytkownika bazy danych metaanaliz A/B testów lub badacza CRO, który tworzy własną bazę danych metaanaliz, aby wyodrębnić wnioski?

Nie oznacza to, że metaanaliza jest niedostępna, ale podczas korzystania z niej należy zachować ostrożność. Jaką ostrożność należy zachować?

Nie rezygnuj z rygoru testowania i dążenia do innowacji

Przypomnijmy, że metaanaliza jest statystycznym pomysłem społeczności medycznej, w której eksperymenty są ściśle kontrolowane, aby zapewnić powtarzalność wyników.

Środowisko i inne czynniki związane z obserwacją powtarzają się w kilku eksperymentach, ale to nie to samo w przypadku eksperymentów online. Metaanaliza eksperymentów online łączy ich dane bez względu na te różnice.

Jedna strona internetowa jest radykalnie i całkowicie różna od innej, ponieważ ma bardzo różnych odbiorców i bardzo różne rzeczy się tam dzieją. Nawet jeśli wydaje się stosunkowo podobny, nawet jeśli to ten sam produkt, to wciąż jest zupełnie inny na miliony i miliony sposobów, więc po prostu nie możesz tego kontrolować.

Jonny Longden

Między innymi wpływa to na jakość tego, co wolno nam nazwać prawdziwą metaanalizą.

Tak więc tam, gdzie nie masz pewności co do poziomu statystycznego wigoru, który wszedł w testy i metaanalizę testów, możesz używać tylko z najwyższą ostrożnością, jak radzi Shiva Manjunath.

Celem metaanalizy nie powinno być kopiowanie konkurentów. Przeskok od wykorzystywania metaanalizy do prostego kopiowania przesuwa granice wiarygodności. Za „kopiowaniem” kryją się pewne niuanse, więc nie jest to czarno-biała sytuacja.

Komentarze do powyższego postu Debory były różne. Kopiowanie do pewnego stopnia jest w porządku, ale przesadzanie jest niebezpieczne:

Jak zgadza się Jakub, musimy być ostrożni z kopiowaniem, zwłaszcza jeśli chodzi o walidację wzorców, które zaobserwowaliśmy w eksperymentach.

Jednak to, przed czym powinniśmy się wystrzegać, to utowarowianie eksperymentów . Oznacza to wykorzystanie wzorców i spostrzeżeń z metaanalizy jako najlepszych praktyk w celu zastąpienia badań w eksperymentach, zamiast uzupełniania tego, co mają do powiedzenia dane specyficzne dla sytuacji.

Zacznij więc od zrozumienia problemu, który chcesz rozwiązać i wskaż rodzaj interwencji, która ma największe szanse powodzenia. Właśnie tam metaanaliza starszych danych eksperymentalnych najlepiej wspiera unikalną strategię optymalizacji.

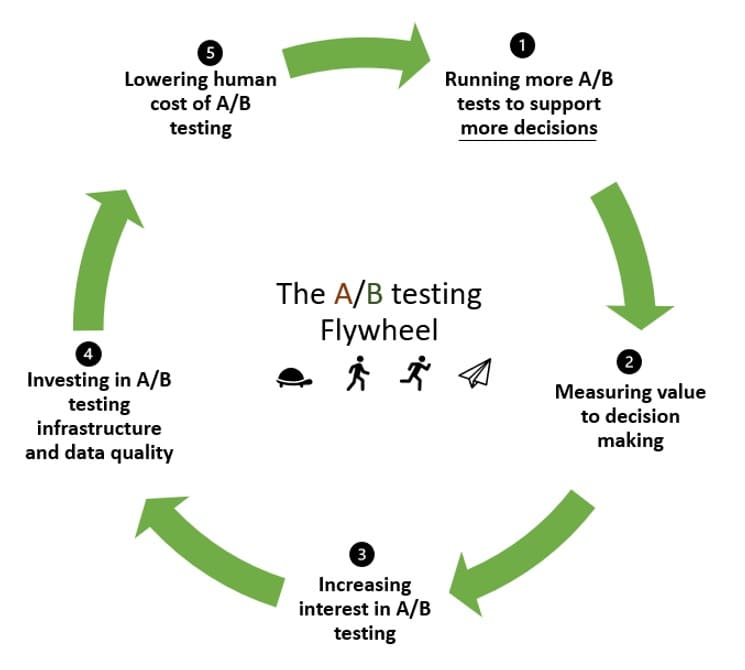

Metaanaliza — smarowanie eksperymentalnego koła zamachowego?

Eksperymentalne koło zamachowe ma sposób na ponowne wykorzystanie pędu. Kiedy eksperymentujesz po raz pierwszy, potrzebujesz dużej bezwładności, aby wprawić rzeczy w ruch.

Pomysł z eksperymentalnym kołem zamachowym polega na tym, aby wykorzystać ten impet, aby przeprowadzić więcej testów i przejść ponownie, coraz lepszy i lepszy, przeprowadzając coraz więcej testów.

I tu może pomóc metaanaliza. W kole zamachowym:

- Przeprowadzasz testy, aby, miejmy nadzieję, zweryfikować swoje hipotezy (i być może odrzucić niektóre w trakcie).

- Mierz wartość, jaką dodali do podejmowania decyzji.

- Zachęć do większego zainteresowania i wpisowego do testów A/B.

- Zainwestuj w infrastrukturę do testów A/B oraz w poprawę jakości swoich danych.

- Obniż koszty ludzkie testów A/B, aby następny krok rozpoczął się z mniejszym wysiłkiem niż poprzednia runda.

Ale jako organizacja oparta na danych nie poprzestajesz na tym, ponieważ dostrzegasz moc testów A/B. Zamiast tego chcesz oprzeć się na początkowej inwestycji w eksperymenty, aby zweryfikować lub odrzucić więcej hipotez.

Jeśli nie ma początkowego wglądu lub wiedzy, aby rozpocząć, bezwładność, aby wprawić w ruch twoje koło zamachowe, będzie zbyt duża. Dzielenie się tą wiedzą (demokratyzacja danych z testów A/B) inspiruje i umożliwia innym podjęcie eksperymentalnego podejścia poprzez obniżenie bariery wiedzy.

To prowadzi nas do punktu 1, w którym metaanaliza smaruje eksperymentalne koło zamachowe:

- Metaanaliza może skrócić czas na stawianie hipotez.

Możesz wykorzystać to, czego się nauczyłeś, spostrzeżenia i wszystko, z poprzednich testów, aby łatwo generować nowe hipotezy. Zwiększa to liczbę przeprowadzanych testów i jest doskonałym sposobem na przyspieszenie koła zamachowego testów A/B.

Spędzamy mniej czasu na przerabianiu tego, co już ustaliło wzorce, a więcej na wytyczaniu nowych ścieżek w oparciu o to, czego nauczyliśmy się w poprzednich eksperymentach.

- Metaanaliza może prowadzić do lepszych wskaźników przewidywania na podstawie danych z przeszłości.

Innym sposobem, w jaki przeszłe uczenie się oparte na eksperymentach może przyspieszyć eksperymentalne obroty koła zamachowego, jest połączenie go z aktualnymi danymi w celu sformułowania nowych hipotez.

Potencjalnie poprawia to, jak obserwowany wpływ testu A/B przenosi się na przyszłość.

Wdrożenie testu A/B nie gwarantuje uzyskania pożądanego wyniku, ponieważ współczynnik fałszywych odkryć (FDR) dla testów o istotności 95% wynosi od 18% do 25%. I tylko 70% przebadanych testów, które doprowadziły do tego wniosku, miało odpowiednią moc.

Współczynnik fałszywych odkryć to ułamek znaczących wyników testów A/B, które w rzeczywistości są zerowymi efektami. Nie mylić z fałszywym alarmem lub błędem typu I.

- Wreszcie metaanaliza może być sposobem na zbudowanie zaufania do wyników testów, które są zasadniczo niejednoznaczne.

Poziomy ufności pomagają ufać, że wyniki testu nie wynikają z przypadku. Jeśli nie masz go wystarczająco dużo, możesz być skłonny oznaczyć ten test jako „niejednoznaczny”, ale nie spiesz się tak bardzo.

Czemu? Statystycznie możesz gromadzić nieistotne wartości p, aby uzyskać znaczący wynik. Zobacz poniższy post:

Metaanaliza ma dwie główne zalety: 1) poprawia dokładność oszacowań efektów i 2) zwiększa możliwość uogólniania wyników.

Źródło: Dobre, złe i brzydkie: metaanalizy Madelon van Wely

Biorąc pod uwagę, że metaanaliza koryguje i koryguje zarówno wielkość efektu, jak i poziomy istotności, można użyć wyników o wyższym standardzie w taki sam sposób, jak każdy inny eksperyment (eksperymenty), w tym:

1) dokonywać obliczeń mocy/oszacowań wielkości próby dla własnych eksperymentów (przy użyciu rzeczywistych danych zamiast subiektywnych domysłów)

2) podjąć decyzję o wykorzystaniu-eksperymencie. W przypadkach, gdy ktoś uważa, że potrzebna jest dodatkowa pewność siebie, może zdecydować się na samodzielne przeprowadzenie dodatkowych eksperymentów. W przypadkach, gdy ktoś uzna, że dowody z metaanalizy są wystarczająco mocne, może po prostu podjąć działania wcześniej bez przeprowadzania dodatkowych eksperymentów.

Jakub Linowski

Biorąc pod uwagę wszystkie sposoby, w jakie metaanaliza może pomóc Twojemu programowi eksperymentalnemu nabrać większego tempa, należy pamiętać, że ma on pewne dobrze znane ograniczenia.

Jeśli zdecydujesz się przeprowadzić (i wykorzystać) metaanalizę – pamiętaj o następujących kwestiach

Tak, połączenie wyników eksperymentów za pomocą metod metaanalitycznych może poprawić precyzję statystyczną, ale nie usuwa podstawowych problemów z początkowym zbiorem danych, takich jak…

Niska jakość eksperymentów uwzględnionych w analizie

Jeśli eksperymenty uwzględnione w metaanalizie były źle skonfigurowane i zawierają błędy statystyczne, niezależnie od dokładności metaanalizy, uzyskają nieprawidłowe wyniki.

Być może w testach A/B wystąpiła nierówna alokacja wielkości próby, moc lub wielkość próby była niewystarczająca lub istniały dowody na podglądanie — niezależnie od przypadku, wyniki te są błędne.

To, co możesz zrobić, aby ominąć to ograniczenie, to staranne dobranie wyników testu. Wyeliminuj wątpliwe wyniki ze swojego zestawu danych. Możesz również ponownie obliczyć istotność statystyczną i przedziały ufności dla testów, które chcesz uwzględnić, i użyć nowych wartości w metaanalizie.

Niejednorodność

Jest to połączenie wyników testów, których nie należy umieszczać w tym samym pojemniku. Na przykład, gdy metodologia użyta do przeprowadzenia testów różni się (analiza statystyczna bayesowska i częsta, różnice specyficzne dla platformy testowej A/B itp.).

Jest to powszechne ograniczenie metaanalizy, w której analityk świadomie lub nieświadomie ignoruje kluczowe różnice między badaniami.

Możesz spojrzeć na surowe dane ilościowe, aby zwalczyć heterogeniczność. To lepsze niż połączenie tylko podsumowania wyników testu. Oznacza to ponowne obliczenie wyników każdego testu A/B, zakładając, że masz dostęp do danych.

Stronniczość publikacji

Znany również jako „problem szuflady z plikami”, jest to najbardziej niesławny problem związany z metaanalizą. Przeprowadzając metaanalizę na publicznie dostępnych danych, ograniczasz się do łączenia wyników, które trafiły do publikacji.

A co z tymi, którym się nie udało? Publikacje zazwyczaj faworyzują wyniki, które są statystycznie istotne i gdzie występuje istotny efekt leczenia. Jeśli te dane nie są reprezentowane w metaanalizie, wyniki przedstawiają tylko to, co zostało opublikowane.

Stronniczość publikacji można wykryć za pomocą wykresów lejkowych i odpowiednich statystyk.

Gdzie więc udać się, aby znaleźć testy A/B, które nie trafiły do baz danych zawierających metaanalizy studiów przypadku lub testów A/B? Platformy testowe A/B są w najlepszej pozycji do dostarczania danych o testach niezależnie od wyników. W tym miejscu szczęśliwe są przykłady 1 i 2 w tym artykule.