Czym są testy A/A i dlaczego marketerzy powinni się tym przejmować?

Opublikowany: 2017-05-18Czy przeszedłeś przez ten scenariusz? Przygotowujesz test A/B, aby sprawdzić, czy nowa kombinacja przycisku i nagłówka wygeneruje więcej konwersji…

Kierujesz taki sam ruch na obie strony docelowe po kliknięciu — kontrolę i odmianę — i zatrzymujesz się po miesiącu, kiedy oprogramowanie ogłasza zwycięzcę Twojej odmiany z 99% pewnością…

Wdrażasz nowy „zwycięski” projekt, ale kilka cykli biznesowych później ten 50-procentowy wzrost współczynnika konwersji nie ma wpływu na Twoje wyniki finansowe. Jesteś zdezorientowany. jesteś zły…

I prawdopodobnie jesteś ofiarą fałszywie pozytywnego wyniku testu.

Co to jest fałszywie dodatni wynik testu?

Dlaczego wzrost współczynnika konwersji o 50% nie przekłada się na większą sprzedaż? Powodem, mówi Lance Jones z Copyhackers, jest to, że prawdopodobnie nie istniał.

Jest całkiem możliwe (nawet prawdopodobne), że nie widzisz wzrostu sprzedaży lub przychodów z testu, ponieważ nigdy go nie było. Być może nieświadomie otrzymałeś w swoim teście „fałszywie dodatni wynik” – znany jako błąd statystyczny typu I, inaczej znany jako nieprawidłowe odrzucenie prawdziwej hipotezy zerowej. To kęs, więc po prostu pamiętam to jako fałszywy alarm.

Uczciwe czy nie, te błędy statystyczne typu 1 są częstsze niż myślisz. Szacuje się, że około 80% wyników testów AB jest urojonych.

Kliknij, aby tweetować

Jeśli podejmujesz kluczowe decyzje na podstawie fałszywych alarmów, w najlepszym przypadku pozostawiasz optymalizację przypadkowi. W najgorszym przypadku pogarszasz współczynnik konwersji stron docelowych po kliknięciu.

Na szczęście istnieje kilka sposobów walki z trującymi danymi. Jedna z nich jest podobna do metody testowania, którą prawdopodobnie już znasz…

Co to są testy A/A?

Testy A/B polegają na skierowaniu ruchu na dwie różne strony — oryginalną (twój element kontrolny) i inną wersję (twój wariant) — w celu sprawdzenia, która z nich ma lepsze wyniki.

Podobnie testy A/A polegają na kierowaniu ruchu na dwie strony, aby zobaczyć, która działa lepiej. Ale w przeciwieństwie do testu A/B, w teście A/A porównuje się dwie identyczne strony — i zamiast odkryć wzrost, ich celem jest znalezienie braku różnicy między kontrolą a odmianą.

Dlaczego miałbyś przeprowadzać testy A/A?

Nie obwiniamy Cię za drapanie się w głowę i zastanawianie się: „Co u licha dałoby się porównać ze sobą dwóch identycznych stron?”

Może to zabrzmieć głupio, ale jest to technika, której używają niektórzy profesjonalni testerzy do testowania swoich testów A/B przed testowaniem. (Hę?)

Dokładne wyniki testów wymagają więcej niż istotności statystycznej

Każdy może przeprowadzić test A/B, ale niewielu może przeprowadzić prawidłowy test A/B (pamiętaj: tylko około 20% wyników testów jest rzeczywiście wiarygodnych).

Tworzenie dokładnych danych testowych to coś więcej niż osiągnięcie istotności statystycznej przy dużej i reprezentatywnej wielkości próby. Aby mieć pewność co do swoich wyników, musisz upewnić się, że próbka nie jest skażona wieloma zagrożeniami ważności.

Jedno z tych zagrożeń, efekt instrumentu, jest tym, z czym testy A/A są najbardziej pomocne w walce.

Jaki jest efekt instrumentu?

Ochrona przed zagrożeniami ważności zaczyna się jeszcze przed rozpoczęciem testów A/B. Efekt instrumentu, mówi Peep Laja z CXL, jest tym, co zatruwa większość wyników testów:

To najczęstszy problem. Dzieje się tak, gdy coś dzieje się z narzędziami testowymi (lub instrumentami), które powodują błędne dane w teście. Często wynika to z niewłaściwej implementacji kodu na stronie internetowej i powoduje zniekształcenie wszystkich wyników.

Dlatego podczas konfigurowania testu ważne jest, aby upewnić się, że narzędzia są poprawnie skonfigurowane i działają tak, jak powinny. Jeśli tak nie jest, mogą pojawić się następujące typowe problemy:

- Błędne raportowanie kluczowych wskaźników wydajności. Tylko jeden błąd w jednym narzędziu może pomieszać Twoje dane, dlatego nigdy nie powinieneś polegać na pojedynczej platformie do śledzenia wszystkich informacji testowych. Przynajmniej zintegruj się z Google Analytics, aby dokładnie sprawdzić, czy dane widoczne w oprogramowaniu do testowania i śledzeniu witryny są dokładne. Aby uzyskać jeszcze lepsze wyniki, sprawdź trzykrotnie innym narzędziem. Podejrzliwie podchodź do wszelkich raportów, które nie pasują do siebie stosunkowo blisko.

- problemy z wyświetlaniem strony docelowej po kliknięciu. Małe błędy w kodowaniu mogą powodować duże zagrożenia ważności, takie jak problemy z wyświetlaniem, podczas testu A/B. Dlatego tak ważne jest upewnienie się, że strony docelowe po kliknięciu wyglądają tak, jak powinny na wszystkich urządzeniach i we wszystkich przeglądarkach oraz że na odwiedzających nie ma wpływu coś, co nazywa się „efektem migotania”. Między innymi powolna strona internetowa może powodować ten problem, który pojawia się, gdy kontrolka jest chwilowo wyświetlana odwiedzającemu tuż przed zmianą.

- Zbyt wczesne przerwanie testu. Niektóre programy testujące przedwcześnie ogłaszają zwycięską stronę — gdy wielkość próbki nie jest wystarczająco duża lub reprezentatywna dla klienta docelowego. Pamiętaj: osiągnięcie istotności statystycznej nie oznacza, że czas przerwać test. Im dłużej go uruchomisz, tym dokładniejsze będą twoje wyniki.

Każdy z tych problemów (i więcej) może prowadzić do fałszywego pozytywnego wyniku testu, dlatego Peep ostrzega testerów, aby zachowali czujność:

Podczas konfigurowania testu obserwuj go jak jastrząb. Zwróć uwagę, że każdy cel i śledzone dane są rejestrowane. Jeśli niektóre dane nie wysyłają danych (np. dodaj dane do koszyka), przerwij test, znajdź i napraw problem, a następnie zacznij od nowa, resetując dane.

Ale nie każdy czuje się komfortowo, od razu wskakując do testów A/B obiema nogami — szczególnie w przypadku korzystania z nowego oprogramowania. Tak więc, jako dodatkowy środek ostrożności, niektórzy praktycy przeprowadzają testy A/A, aby ocenić swoje narzędzia przed rozpoczęciem testów A/B.

Jeśli eksperyment został prawidłowo skonfigurowany, po zakończeniu testu A/A obie strony powinny mieć podobny współczynnik konwersji. Jak pokazują poniższe testery, nie zawsze tak się dzieje.

Przykłady testów A/A

Czy fałszywe alarmy są naprawdę tak powszechne? Czy jedna strona naprawdę może przewyższyć swój klon? Ci faceci wykorzystali testy A/A, aby dowiedzieć się i ujawnić swoje ustalenia w następujących postach na blogu…

1. Test podziału strony głównej ujawnia poważne wady popularnych narzędzi testowych

11 listopada 2012 r. zespół Copyhackers rozpoczął test podziału A/A na swojej stronie głównej, jak pokazano poniżej:

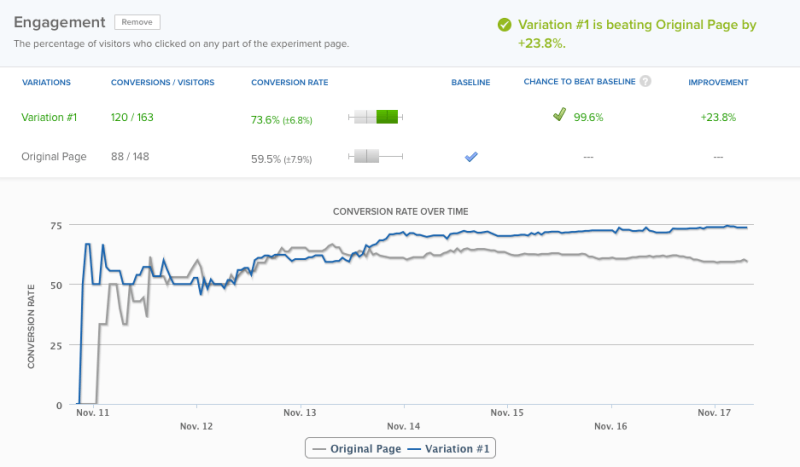

18-go — 6 dni później — ich narzędzie do testowania ogłosiło zwycięzcę z 95% pewnością. Jednak ze względu na dokładność zespół zdecydował, że test potrwa jeszcze jeden dzień — w tym momencie ich oprogramowanie ogłosiło zwycięzcę na poziomie ufności 99,6%:

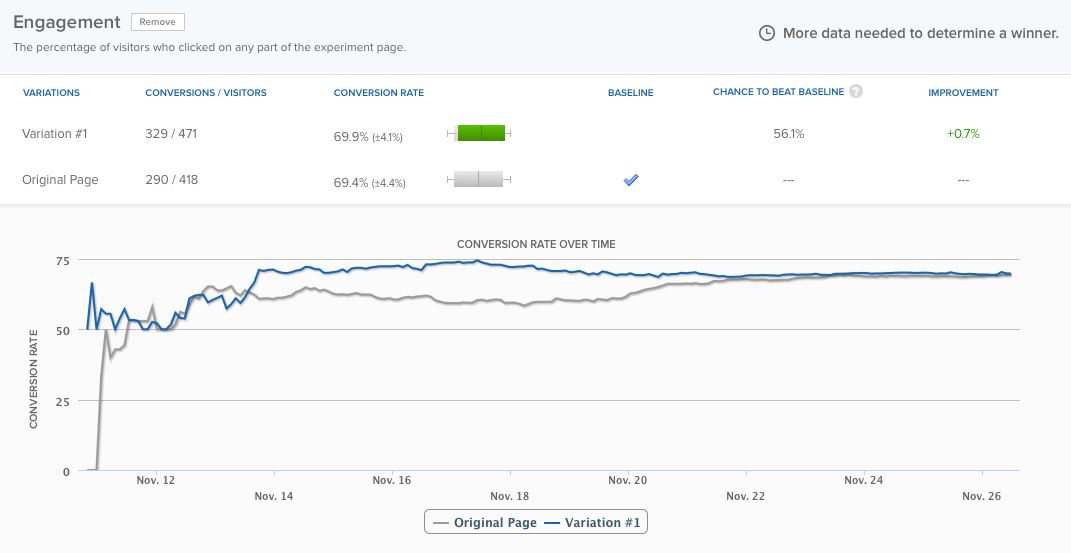

Według oprogramowania ich strona główna działała prawie o 24% lepiej niż dokładnie ta sama strona , a prawdopodobieństwo, że wynik był fałszywym alarmem, wynosiło tylko 0,4%. Mimo to zespół pozwolił, aby test trwał jeszcze około trzech dni, a różnice ostatecznie się wyrównały:

Ale nie o to chodzi. Chodzi o to, że narzędzie do testowania za wcześnie ogłosiło zwycięzcę. Gdyby zespół Copyhackers nie utrzymywał go w ruchu, błędnie założyłby, że wystąpił problem z ich eksperymentem. Więcej o teście przeczytasz tutaj.

2. Testy A/A: Jak zwiększyłem liczbę konwersji o 300%, nie robiąc absolutnie nic

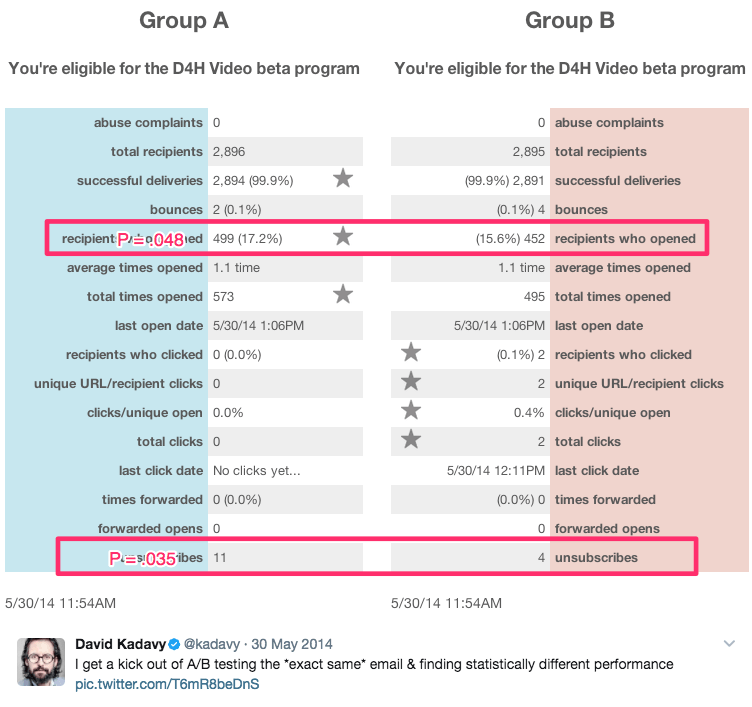

Ten sarkastyczny tytuł został napisany przez autora i samozwańczego „odzyskiwacza niedoszłego przedsiębiorcy”, Davida Kadavy'ego, który w ciągu 8 miesięcy przeprowadził szereg testów A/A na 750 000 subskrybentów poczty e-mail. W tym czasie wygenerował statystycznie istotne wyniki, takie jak te:

Wśród tych wyników były:

- 9% wzrost liczby otwieranych wiadomości e-mail

- Wzrost kliknięć o 300%.

- O 51% niższy wskaźnik rezygnacji z subskrypcji

On mówi:

Dla wielu początkujących przedsiębiorców (w tym dla mnie) wygląda to jak „och, wow, zwiększyłeś liczbę otwarć o 10%!” Mogą nawet wpisać to do kalkulatora istotności Visual Website Optimizer i zobaczyć, że p=0,048. „To statystycznie istotne!” oni (lub ja) mogą wykrzyknąć.

Prawda jest jednak taka, że to wszystko były testy A/A. Zawartość testowana względem siebie była identyczna. Zobacz więcej jego wyników tutaj.

Czy należy przeprowadzać testy A/A?

Odpowiedź na to pytanie zależy od tego, kogo zapytasz.

Neil Patel, który wciąż obserwował duże wzrosty konwersji, które nie oznaczały większych przychodów, mówi: „Bardzo ważne jest, aby najpierw przeprowadzić test A/A, ponieważ pomoże to uniknąć marnowania czasu na niedokładne oprogramowanie”.

Z drugiej strony Peep Laja z CXL mówi, że same testy A/A to strata czasu. Więc kto ma rację?

Dwa główne problemy z testami A/A

Z teoretycznego punktu widzenia testy A/A mają sens. Przede wszystkim dokładność jest najważniejsza podczas przeprowadzania testu A/B, a przetestowanie testu to tylko jeden z wielu sposobów, aby to zapewnić.

Jednak w rzeczywistych środowiskach testowych testy A/A mogą wyrządzić więcej szkody niż pożytku. Craig Sullivan wyjaśnia:

Dla mnie problemem jest zawsze zjadanie rzeczywistego ruchu i czasu testowania, przez konieczność wstępnego załadowania czasu uruchomienia testu z okresem testów A/A. Jeśli próbuję przeprowadzić 40 testów miesięcznie, osłabi to moją zdolność do uruchamiania rzeczy. Wolałbym spędzić pół dnia na testach kontroli jakości eksperymentu niż przeprowadzić 2-4 tygodnie testów A/A, aby sprawdzić, czy wszystko się zgadza.

To problem pierwszy. Testy A/A kosztują czas rzeczywisty i ruch, który możesz wykorzystać, aby dowiedzieć się więcej o użytkownikach witryny za pomocą testów A/B.

Problem drugi jest zilustrowany w studium przypadku z Copyhackers. Podobnie jak testy A/B, testy A/A muszą być starannie zaprojektowane i monitorowane, ponieważ są również podatne na fałszywe alarmy.

Innymi słowy, Twój test A/A może powiedzieć, że jedna strona działa lepiej niż druga, kiedy tak nie jest (ta szansa jest znacznie wyższa niż myślisz — około 50%)

Gdyby zespół Copyhackers posłuchał swojego narzędzia do testowania i ogłosił zwycięzcę zaledwie po sześciu dniach, spędziliby jeszcze więcej czasu próbując dowiedzieć się, dlaczego ich strona główna działa lepiej niż jej identyczny bliźniak (kiedy tak naprawdę nie było) .

Główna zaleta testów A/A

Pomimo tych problemów testy A/A mogą pomóc w wykryciu jeszcze większych problemów podczas prawdziwych testów. Gdy wyniki tych testów są tymi, na których opierasz ważne decyzje biznesowe, jest to potężna korzyść do rozważenia.

Jeśli zdecydujesz się na test A/A, istnieje potencjalnie mniej marnotrawny sposób, aby to zrobić, zwany testowaniem A/A/B.

Testy A/A/B a testy A/A

Tradycyjna metoda testów A/A marnuje ruch, ponieważ po zakończeniu nie mówi nic o odwiedzających. Ale jeśli dodasz odmianę „B” do tego testu, może. Oto różnica między nimi:

- Test A/A = 2 identyczne strony porównane ze sobą

- Test A/A/B = 2 identyczne strony i jedna odmiana przetestowane względem siebie

Test A/A/B dzieli ruch na trzy segmenty, co oznacza, że osiągnięcie istotności statystycznej zajmie więcej czasu. Ale zaletą jest to, że gdy już to zrobisz, będziesz mieć dane zarówno o swoim narzędziu do testowania, jak io odwiedzających.

Porównaj wyniki testu A i A, aby określić, czy możesz ufać swojemu testowi. Jeśli są statystycznie podobne, porównaj wyniki A z B. Jeśli jednak nie, będziesz musiał odrzucić wyniki całego testu (którego przeprowadzenie trwało dłużej niż w przypadku tradycyjnego testu A/A ponieważ Twój ruch jest podzielony na trzy segmenty).

Czy zalety testów A/A przeważają nad wadami?

Niektórzy eksperci mówią „tak”, podczas gdy inni mówią „nie”. Andrew First z Leadplum wydaje się uważać, że odpowiedź mieści się gdzieś pomiędzy:

Testy A/A prawdopodobnie nie powinny być comiesięczną sprawą, ale kiedy konfigurujesz nowe narzędzie, warto poświęcić czas na przetestowanie danych. Jeśli teraz przechwycisz złe dane, będziesz mieć większą pewność co do wyników testów za kilka miesięcy.

Ostatecznie to zależy od Ciebie. Jeśli używasz nowego narzędzia, warto skorzystać z rady Andrew. Jeśli jednak nie, prawdopodobnie najlepiej będzie pójść w ślady Craiga Sullivana i zamiast tego ustanowić rygorystyczny proces kontroli jakości przed testami. Oszczędzaj czas, zasoby i ruch na testach A/B.

Wykorzystaj w pełni swoje testy i cyfrowe kampanie reklamowe, zarejestruj się już dziś, aby skorzystać z demonstracji Instapage Enterprise.