Pozycjonowanie w świecie dwóch algorytmów: Przemówienie do Pubconu autorstwa Randa Fishkina

Opublikowany: 2022-06-12 Rand dedykuje tę prezentację Danie Lookadoo, która zawsze będzie z nami.

Rand dedykuje tę prezentację Danie Lookadoo, która zawsze będzie z nami.

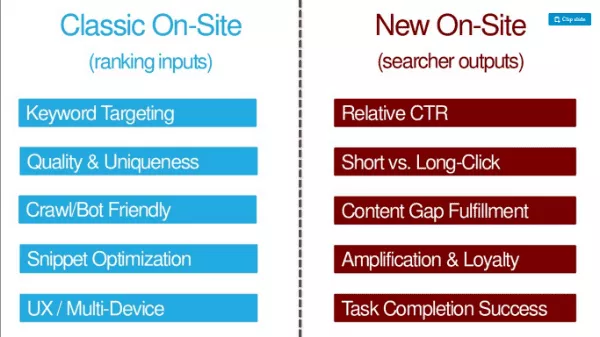

TL:DR tego autora: Oprócz tradycyjnych czynników optymalizacji SEO (wpisów rankingowych, takich jak kierowanie na słowa kluczowe, jakość i wyjątkowość, przyjazność dla indeksowania/bota, optymalizacja fragmentów, optymalizacja UX/wielu urządzeń), SEO muszą optymalizować wyniki wyszukiwania ( takie jak CTR, długie kliknięcia, wypełnienie luki w treści, wzmocnienie i lojalność, powodzenie realizacji zadań).

Tutaj możesz uzyskać prezentację: http://bit.ly/twoalgo

Pamiętasz, jak mieliśmy tylko jedną pracę? Musieliśmy stworzyć perfekcyjnie zoptymalizowane strony. Zespół ds. jakości wyszukiwania umieściłby go w rankingu i użył linków jako głównego sygnału. Do 2007 roku spam linkami był wszechobecny. Każdy SEO ma obsesję na punkcie gier typu tower defense, ponieważ uwielbiamy optymalizować. Nawet w 2012 roku wydawało się, że Google robił kłamców ze świata SEO białych kapeluszy (-Wil Reynolds).

Rand mówi dzisiaj, że to stwierdzenie nie jest już prawdziwe. Autentyczne, świetne treści są nagradzane przez Google lepiej niż kiedykolwiek. Google wymazało stare praktyki szkolne, zwalczając takie rzeczy, jak spam linkami. I wykorzystali strach i niepewność kar, aby utrzymać strony w ryzach. Używanie zrzekań jest często tak niebezpieczne, że wielu z nas zabija linki, które zapewniają wartość naszym witrynom, ponieważ tak bardzo boimy się kar.

Google stał się mądrzejszy

Google stał się również dobry w określaniu intencji. Patrzą na język, a nie tylko na słowa kluczowe.

Przewidują różne wyniki.

Zorientowali się, kiedy chcemy świeżości.

Mogą oddzielić zapytania nawigacyjne od zapytań informacyjnych. Łączą podmioty z tematami i słowami kluczowymi. Nawet marki stały się formą bytów. Bill Sławski zauważył, że Google wymienia marki w wielu zgłoszonych patentach.

Google znacznie bardziej zgadza się z ich publicznymi oświadczeniami. W większości mają zasady, które pasują do najlepszego sposobu prowadzenia marketingu w wyszukiwarkach.

Stanowisko Google w sprawie uczenia maszynowego uległo zmianie

Podczas tych postępów zespół Google ds. jakości wyszukiwania przeszedł rewolucję. Na początku Google odrzucił uczenie maszynowe w swoim organicznym algorytmie rankingu. Google powiedział, że uczenie maszynowe nie pozwoliło im posiadać, kontrolować i rozumieć czynników w algorytmie. Ale ostatnio komentarze Amita Singhala sugerują, że niektóre z nich się zmieniły.

W 2012 roku Google opublikował artykuł o tym, jak wykorzystują systemy uczące się do przewidywania współczynnika klikalności reklam. Inżynierowie Google zadzwonili do swojego systemu SmartASS (podobno jest to WŁAŚCIWIE nazwa systemu!). Do 2013 roku Matt Cutts mówił w Pubcon o tym, jak Google może publicznie wykorzystywać uczenie maszynowe (ML) w bezpłatnych wynikach wyszukiwania.

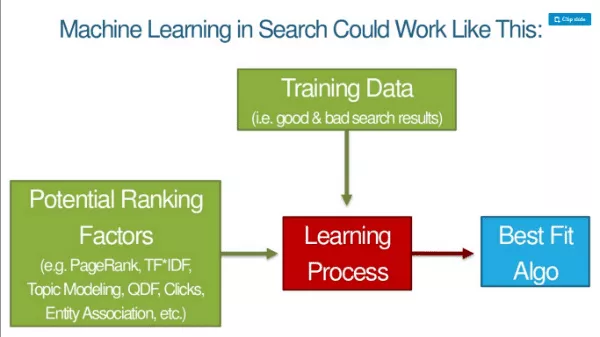

W miarę jak ML przejmuje większą część algorytmu Google, zmieniają się podstawy rankingu. Google publicznie informuje, w jaki sposób używają ML do rozpoznawania i klasyfikacji obrazów. Biorą czynniki, które mogą wykorzystać do klasyfikowania obrazów, a następnie dodają dane treningowe (rzeczy, które mówią maszynie, że coś jest kotem, psem, małpą itp.), a proces uczenia się prowadzi do najlepszego dopasowania algorytmu. Następnie mogą zastosować ten wzór do wszystkich danych na żywo.

Prezentacja slajdowa przedstawiciela Google, Jeffa Deana, dotycząca głębokiego uczenia się, jest obowiązkową lekturą dla SEO. Rand mówi, że jest to lektura niezbędna i niezbyt trudna do skonsumowania. Jeff Dean jest pracownikiem Google i kimś, z kogo w Google lubią się śmiać: „Prędkość światła w próżni wynosiła około 35 mil na godzinę. Dopóki Jeff Dean nie spędził weekendu na optymalizacji fizyki”.

Odbicia, kliknięcia, czas przebywania — wszystkie te rzeczy są cechami procesu uczenia maszynowego, a algorytm stara się naśladować dobre doświadczenia SERP. Mówimy o algorytmie do budowania algorytmów. Googlersi nie uwzględniają czynników rankingowych. Maszyna sama je określa. Dane treningowe to dobre wyniki wyszukiwania.

Co oznacza głębokie uczenie dla SEO?

Googlersi nie będą wiedzieć, dlaczego coś jest w rankingu ani czy w algorytmie znajduje się zmienna. Pomiędzy czytelnikiem a Randem, czy nie brzmi to podobnie do tego, co mówią teraz Googlersi? ;)

Dla maszyn liczy się tylko metryka powodzenia zapytania:

- Stosunek kliknięć od długiego do krótkiego

- Względny CTR a inne wyniki

- Wskaźnik osób wyszukujących przeprowadzających dodatkowe powiązane wyszukiwania

- Współczynnik udostępniania/wzmocnienia w porównaniu z innymi wynikami

- Wskaźniki zaangażowania użytkowników w całej domenie

- Wskaźniki zaangażowania użytkownika na stronie (Jak? Używając Chrome i Androida)

Jeśli wiele wyników w SERP spełnia wszystkie powyższe wymagania, będą to uwzględniać. Będziemy bardziej optymalizować wyniki wyszukiwania. Prawdopodobnie będą to kryteria SEO w witrynie w przyszłości.

OK — ale czy te wskaźniki mają na nas wpływ? W 2014 roku Moz przeprowadził test zapytań i kliknięć. Od tego czasu znacznie trudniej jest poruszać igłę za pomocą surowych zapytań i kliknięć. Google łapie surowe kliknięcia i manipulacje zapytaniami.

Na SMX Advanced Gary Illyes powiedział, że używanie kliknięć bezpośrednio w rankingach nie miałoby większego sensu w przypadku tego szumu. Powiedział, że są ludzie generujący hałas w kliknięciach, wołający Randa Fishkina. - Sprawa zamknięta! Albo to jest … ?

Ale co, gdybyśmy spróbowali długich kliknięć zamiast krótkich kliknięć? O godzinie 11:39 21 czerwca Rand poprosił ludzi o wykonanie testu, w którym szybko kliknęli z powrotem na wynik nr 1, a następnie kliknęli i zatrzymali się na wyniku nr 4. Wynik nr 4 utrzymywał się na pozycji nr 1 w SERP przez około 12 godzin. To mówi nam, że wyniki wyszukiwania wpływają na rankingi. (PS Trudno to powtórzyć. Nie rób tego, bo to czarna magia.)

To, co powinieneś robić, to rzeczy, które naturalnie sprawią, że ludzie będą chcieli kliknąć Twój wynik w SERP.

Wybór dwóch algorytmów

Dlatego Rand mówi, że optymalizujemy dla dwóch algorytmów. Musimy wybrać, w jaki sposób równoważymy naszą pracę. Uderzać w stare sygnały? Nadal działają. Linki nadal działają. Tekst zakotwiczenia nadal porusza igłą. Ale wyraźniej niż kiedykolwiek widzimy na horyzoncie, dokąd zmierza Google.

Klasyczne SEO On-Site (dane rankingowe) vs. Nowe SEO On-Site (wyniki wyszukiwarki):

Korzystanie z obu spraw, ponieważ istnieją dwa algorytmy.

Nowe elementy SEO

Porozmawiajmy o pięciu nowych elementach nowoczesnego SEO.

1. Uderzanie powyżej średniego CTR

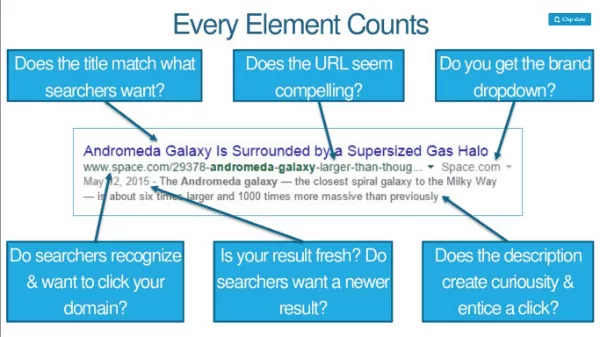

Optymalizacja tytułu, opisu meta i adresu URL trochę pod kątem słów kluczowych, ale dużo pod kątem kliknięć. Jeśli zajmujesz trzecie miejsce, ale możesz zwiększyć swój CTR, możesz zyskać wyższą pozycję w rankingu. Liczy się każdy element. Czy osoby wyszukujące rozpoznają i chcą kliknąć Twoją domenę? Czy adres URL wydaje się atrakcyjny? Czy otrzymujesz listę rozwijaną marki?

Zwiększ CTR poprzez branding lub branded searchs, a to może dać Ci dodatkowy impuls. Działania brandingowe (takie jak reklama w telewizji, radiu, PPC) mają wpływ na CTR. Budżet marki pomaga w względnym współczynniku klikalności i wszelkim innym sygnałom rankingowym, a ten wzrost w pewnym stopniu jest tego przyczyną.

Dzięki dokładniejszym zakresom Google Trends, które można dostosowywać, możesz faktycznie obserwować wpływ wydarzeń i reklam na liczbę wyszukiwanych haseł. Na przykład nastąpił wzrost liczby zapytań „fitbit” po tym, jak Fitbit wyświetlał reklamy w niedzielę NFL.

2. Pokonanie innych list SERP dotyczących zaangażowania

Przyklejanie się do pogo i długie kliknięcia mogą w dużej mierze determinować Twoją pozycję w rankingu (i jak długo). Co na nich wpływa? Oto lista kontrolna SEO dla lepszego zaangażowania:

- Treści, które spełniają świadome i nieświadome potrzeby poszukiwacza

- Prędkość, prędkość i jeszcze więcej prędkości

- Dostarczanie najlepszego UX w każdej przeglądarce

- Zachęcanie odwiedzających do zagłębienia się w Twoją witrynę

- Unikanie funkcji, które denerwują lub zniechęcają odwiedzających

Przykład: New York Times ma bardzo angażującą grafikę, która prosi odwiedzających o narysowanie najbardziej zgadywanego zakończenia wykresu.

3. Uzupełnianie luk w wiedzy zwiedzających

Google szuka sygnałów, które pokazują, że strona spełnia wszystkie potrzeby osoby wyszukującej. Modele ML mogą zauważyć, że obecność określonych słów, fraz i tematów pozwala przewidzieć skuteczniejsze wyszukiwania. Rankingi trafiają do stron/witryn, które wypełniają luki w wiedzy wyszukiwarek. WSKAZÓWKA: Sprawdź Alchemy API lub MonkeyLearn. Przepuszczaj przez nie swoje treści, aby zobaczyć, jak działa z perspektywy ML.

4. Zarabianie większej ilości akcji, linków i lojalności na wizytę

Dane z Buzzsumo i Moz pokazują, że bardzo niewiele artykułów otrzymuje udostępnienia/linki i że te dwa elementy nie są ze sobą skorelowane. Ludzie dzielą się wieloma rzeczami, których nigdy nie czytali. Google prawie na pewno inaczej klasyfikuje różne rodzaje SERP. Na przykład duża ilość udostępnionych informacji medycznych nie spowoduje przesunięcia wyniku w górę rankingu; dokładność będzie ważniejsza.

Nowy KPI: udostępnienia i linki na 1000 wizyt. Unikalne wizyty na udostępnieniach + linkach.

Wiedza o tym, co sprawia, że ludzie wracają lub uniemożliwia im to, również ma kluczowe znaczenie.

Nie potrzebujemy lepszej zawartości, potrzebujemy zawartości 10X (tj. zawartości, która jest 10 razy lepsza niż obecnie najlepsza).

5. Wypełnianie zadania poszukiwacza (nie tylko jego zapytania)

Zadanie = co chcą osiągnąć, gdy wykonają to zapytanie. Google nie chce ścieżki multisearch zawierającej stale skoncentrowane zapytania. Chcą szerokiego wyszukiwania, w którym wypełniają wszystkie kroki, a Ty wykonujesz swoje zadanie.

Wyszukiwarka może wykorzystać dane strumienia kliknięć, aby poprawić pozycję witryny, nawet jeśli nie ma ona tradycyjnych sygnałów rankingowych. Strona, która odpowiada na początkowe zapytanie, może nie wystarczyć, zwłaszcza jeśli konkurencja pozwala na wykonanie zadania.

Algo 1: Google

Algo 2: Podzbiór człowieczeństwa, który wchodzi w interakcję z Twoimi treściami (w wynikach wyszukiwania i poza nimi)

„Twórz strony dla ludzi, a nie silników” to straszna rada.

Silniki potrzebują wielu rzeczy, które zawsze robiliśmy i lepiej to robić dalej. Ludzie potrzebują dodatkowych rzeczy i lepiej to zrobimy.

Linki bonusowe:

- http://bit.ly/10Xcontent

- http://bit.ly/sharesvslinks