Analiza pliku dziennika: inteligentna alternatywa dla Google Analytics

Opublikowany: 2022-03-08Czy wiesz, co dzieje się na Twojej stronie każdego dnia? Pierwszą rzeczą, jaka przychodzi do głowy, odpowiadając na to pytanie, najprawdopodobniej jest skorzystanie z narzędzi do śledzenia odbiorców i zachowań. Na rynku dostępnych jest wiele takich narzędzi, m.in. Google Analytics, At Internet, Matomo, Fathom Analytics, Simple Analytics. Chociaż narzędzia te pozwalają nam mieć całkiem dobry przegląd tego, co dzieje się w danym momencie w naszych witrynach, ponownie kwestionowane są praktyki etyczne stosowane przez te narzędzia, a dokładniej Google Analytics.

Sugeruje to, że istnieją inne źródła danych, które obecnie nie są w wystarczającym stopniu wykorzystywane przez wszystkich właścicieli witryn: logi.

Narzędzia analityczne i RODO (koncentracja na Google Analytics)

Dane osobowe stały się wrażliwym tematem we Francji od czasu wdrożenia ogólnego rozporządzenia o ochronie danych (RODO) i utworzenia Krajowej Komisji ds. Informatyki i Wolności (CNIL). Ochrona danych stała się priorytetem.

Czy Twoja witryna jest nadal „przyjazna dla RODO”?

Jeśli przyjrzymy się wszystkim witrynom, zauważymy, że wiele z nich znalazło sposób na obejście zasad, wykorzystując swoje pliki cookie (banery do zbierania danych) w celu zebrania potrzebnych im informacji, podczas gdy inne nadal ściśle przestrzegają oficjalnych przepisów.

Gromadząc te informacje, narzędzia do analizy danych pozwalają nam przeanalizować, skąd pochodzi publiczność i zachowanie odwiedzających. Ten rodzaj analizy wymaga nienagannego planu tagowania, aby zebrać możliwie najbardziej wiarygodne i dokładne dane, a ostatecznie zebrane dane są wynikiem każdego działania i zdarzenia w witrynie.

Po wielu skargach CNIL postanowiła zawiadomić Google Analytics, czyniąc na razie nielegalnym we Francji. Ta sankcja wynika z widocznego braku nadzoru nad przekazywaniem danych osobowych służbom wywiadowczym w Stanach Zjednoczonych, chociaż informacje o odwiedzających były wcześniej gromadzone za zgodą. Rozwój sytuacji powinien być ściśle monitorowany.

W tym kontekście, przy ograniczonym dostępie lub braku dostępu do Google Analytics, interesujące może być przyjrzenie się innym opcjom gromadzenia danych. Zestawienie historycznych wydarzeń witryny i stosunkowo łatwe do odzyskania pliki dziennika są doskonałym źródłem informacji.

Pomimo tego, że pliki dziennika zapewniają dostęp do interesującego archiwum informacji do analizy, nie pozwalają nam one wyświetlać wartości biznesowych ani rzeczywistego zachowania odwiedzającego witrynę, takiego jak nawigacja w witrynie od początku do momentu zatwierdzenia koszyka lub opuszczenia strony strona. Aspekt behawioralny pozostaje jednak specyficzny dla narzędzi wymienionych powyżej; analiza logów może nam pomóc zajść całkiem daleko.

Zrozumienie plików dziennika

Co to są pliki dziennika? Logi to rodzaj pliku, którego główną misją jest przechowywanie historii zdarzeń.

O jakich wydarzeniach mówimy? Zasadniczo „zdarzenia” to użytkownicy i roboty, które codziennie uzyskują dostęp do Twojej witryny.

Google Search Console również może zbierać te informacje, ale z kilku powodów – w szczególności ze względu na ochronę prywatności – stosuje bardzo specyficzny filtr.

(Źródło: https://support.google.com/webmasters/answer/7576553. „Różnice między Search Console a innymi narzędziami”.)

W związku z tym będziesz mieć tylko próbkę tego, co może dostarczyć analiza dziennika. Dzięki plikom dziennika masz dostęp do 100% danych!

Analiza wierszy plików dziennika może pomóc w ustaleniu priorytetów przyszłych działań.

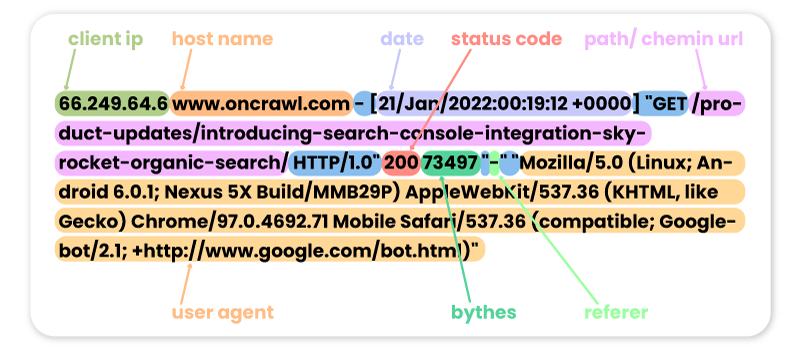

Oto kilka przykładów poprzednich wizyt w witrynie Oncrawl przez różne roboty:

FACEBOOK:

66.220.149.10 www.oncrawl.com - [07/Feb/2022:00:18:35 +0000] "GET /feed/ HTTP/1.0" 200 298008 "-" "facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php)"

SEMRUSH:

185.191.171.20 fr.oncrawl.com - [13/Feb/2022:00:18:27 +0000] "GET /infographie/mises-jour-2017-algorithme-google/ HTTP/1.0" 200 50441 "-" "Mozilla/5.0 (compatible; SemrushBot/7~bl; +http://www.semrush.com/bot.html)"

BING:

207.46.13.188 www.oncrawl.com - [22/Jan/2022:00:18:40 +0000] "GET /wp-content/uploads/2018/04/url-detail-word-count.png HTTP/1.0" 200 156829 "-" "Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)"

GOOGLE BOT:

66.249.64.6 www.oncrawl.com - [21/Jan/2022:00:19:12 +0000] "GET /product-updates/introducing-search-console-integration-skyrocket-organic-search/ HTTP/1.0" 200 73497 "-" "Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

Pamiętaj, że niektóre wizyty botów mogą być fałszywe. Należy pamiętać, aby zweryfikować adresy IP, aby wiedzieć, czy są to prawdziwe wizyty Googlebota, Bingbota itp. Za tymi fałszywymi agentami użytkownika mogą znajdować się profesjonaliści, którzy czasami uruchamiają roboty, aby uzyskać dostęp do Twojej witryny i sprawdzić ceny, zawartość lub inne informacje, które uznają za przydatne. W ich rozpoznaniu pomocny będzie tylko adres IP!

Oto kilka przykładów odwiedzin witryny Oncrawl przez internautów:

Z Google.com:

41.73.11x.xxx fr.oncrawl.com - [13/Feb/2022:00:25:29 +0000] "GET /seo-technique/predire-trafic-seo-prophet-python/ HTTP/1.0" 200 57768 "https://www.google.com/" "Mozilla/5.0 (Linux; Android 10; Orange Sanza touch) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.98 Mobile Safari/537.36"

Z UTM Google Ads:

199.223.xxx.x www.oncrawl.com - [11/Feb/2022:15:18:30 +0000] "GET /?utm_source=sea&utm_medium=google-ads&utm_campaign=brand&gclid=EAIaIQobChMIhJ3Aofn39QIVgoyGCh332QYYEAAYASAAEgLrCvD_BwE HTTP/1.0" 200 50423 "https://www.google.com/" "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/96.0.4664.110 Safari/537.36"

Z LinkedIn dzięki polecającemu:

181.23.1xx.xxx www.oncrawl.com - [14/Feb/2022:03:54:14 +0000] "GET /wp-content/uploads/2021/07/The-SUPER-SEO-Game-Building-an-NLP-pipeline-with-BigQuery-and-Data-Studio.pdf HTTP/1.0" 200 3319668 "https://www.linkedin.com/"

[Ebook] Cztery przypadki użycia do wykorzystania analizy dzienników SEO

Po co analizować zawartość dziennika?

Skoro już wiemy, co właściwie zawierają dzienniki, co możemy z tym zrobić? Odpowiedź: przeanalizuj je, jak każde inne narzędzie analityczne.

Boty czy roboty

Tutaj możemy zadać sobie następujące pytanie:

Które roboty spędzają najwięcej czasu na mojej stronie?

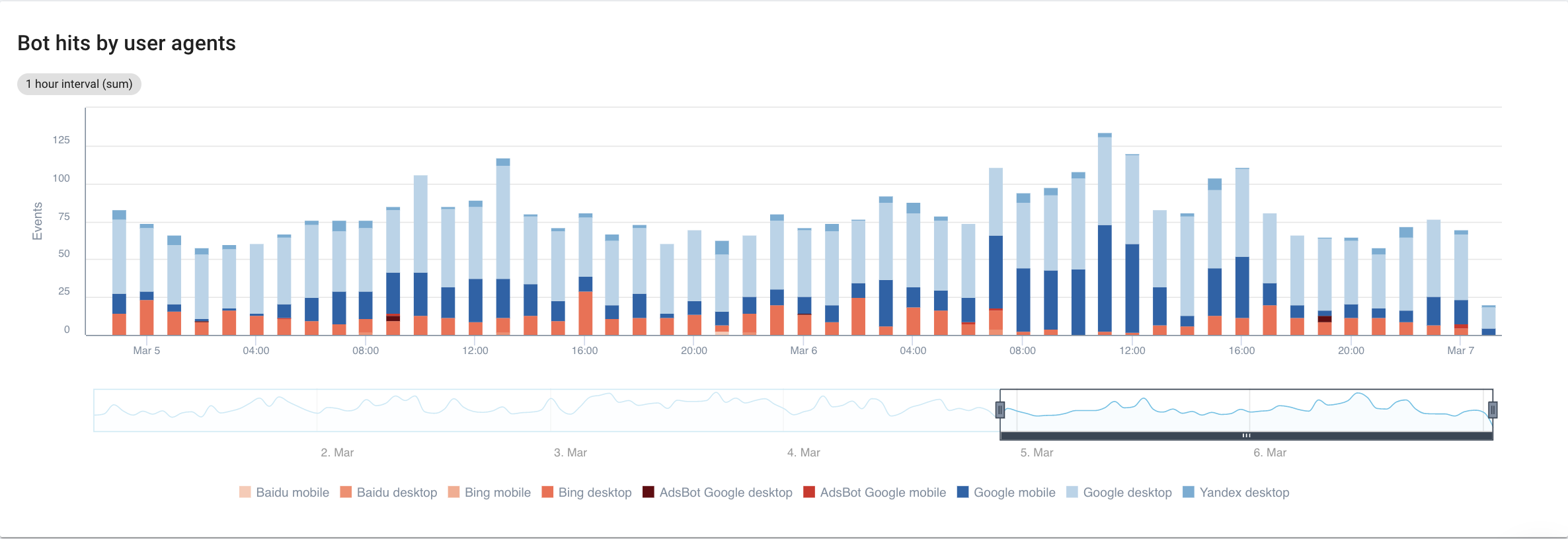

Jeśli skupimy się na wyszukiwarkach, ze szczegółowym oglądem każdego bota, oto co możemy zobaczyć:

Źródło: aplikacja Oncrawl

Najwyraźniej Google Mobile i Desktop spędzają znacznie więcej czasu na indeksowaniu niż boty Bing lub Yandex. Googlebot ma ponad 90% udział w rynku globalnym.

Jeśli Google indeksuje moje strony, czy są one automatycznie indeksowane? Nie, niekoniecznie.

Jeśli cofniemy się o kilka lat, Google zastosował automatyczny odruch do indeksowania stron bezpośrednio po ich odwiedzeniu. Dziś już tak nie jest, biorąc pod uwagę ilość stron, które musi przetworzyć. W rezultacie dochodzi do bitwy SEO o budżet indeksowania.

Biorąc to wszystko pod uwagę, możesz zapytać: po co wiedzieć, który bot spędza na mojej stronie więcej czasu niż inny?

Odpowiedź na to pytanie zależy od każdego z algorytmów botów. Każdy z nich jest trochę inny i niekoniecznie wracają z tych samych powodów.

Każda wyszukiwarka ma swój własny budżet indeksowania, który dzieli między te boty . Innymi słowy, oznacza to, że Google dzieli swój budżet indeksowania między wszystkie te boty. Dlatego całkiem interesujące staje się przyjrzenie się bliżej temu, co robi GooglebotAds, zwłaszcza jeśli mamy błędy 404. Oczyszczenie ich to sposób na optymalizację budżetu indeksowania i ostatecznie SEO.

Analizator logów Oncrawl

Porównywanie danych Googlebota z danymi Oncrawl Crawler

Aby zagłębić się w analizę zachowania Googlebota, Oncrawl porównuje dane dziennika z danymi indeksowania, aby uzyskać najbardziej szczegółowe i dokładne informacje.

Celem jest również potwierdzenie lub odrzucenie hipotez powiązanych z kilkoma KPI, takimi jak głębokość, treść, wydajność itp.

W związku z tym musisz zadać sobie właściwe pytania:

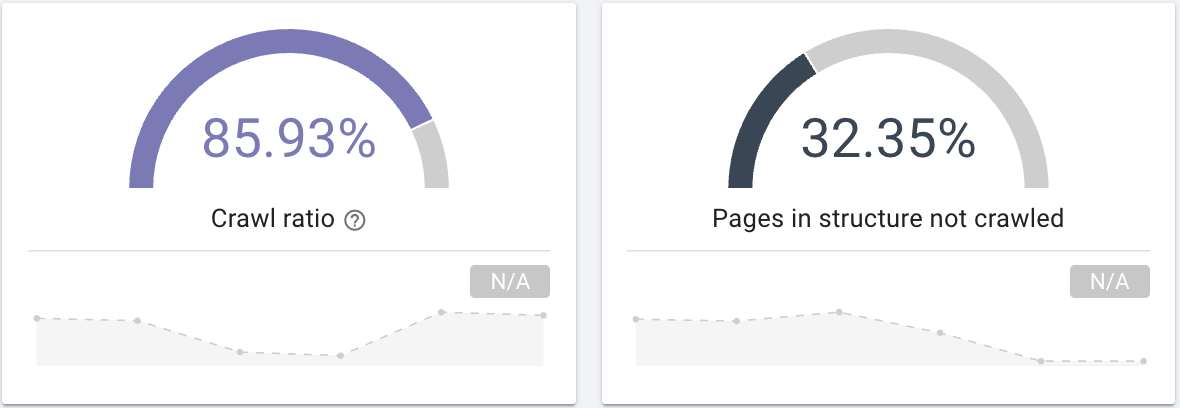

- Czy Googlebot indeksuje wszystkie strony w Twojej witrynie? Zainteresuj się współczynnikiem indeksowania, który wyraźnie dostarcza tych informacji, które możesz również filtrować za pomocą segmentacji swoich stron.

Źródło: aplikacja Oncrawl

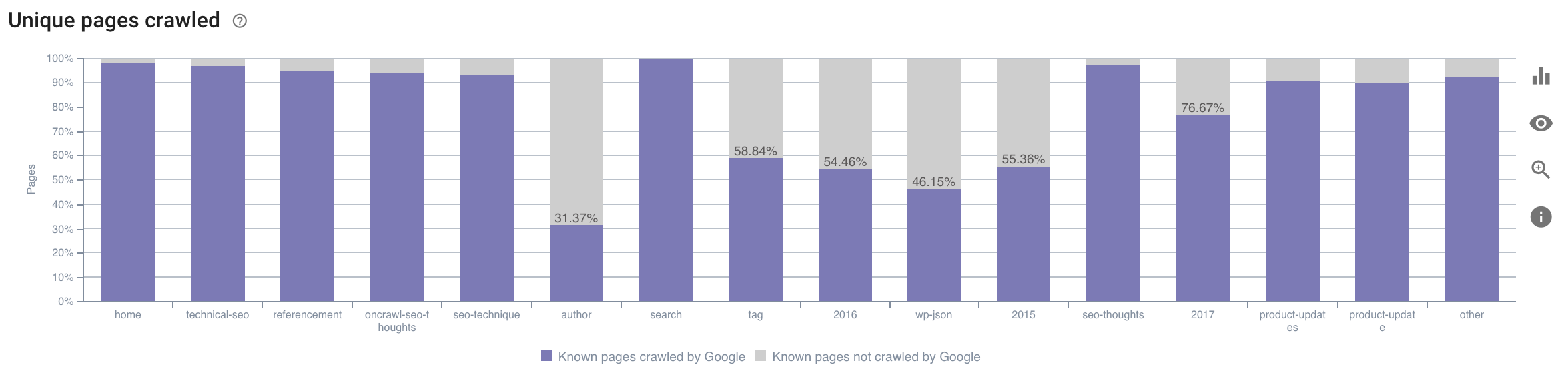

- W której kategorii spędza czas Googlebot? Czy to optymalne wykorzystanie budżetu indeksowania? Ten wykres w raporcie SEO Impact Report firmy Oncrawl zawiera odniesienia do danych i dostarcza tych informacji.

Źródło: aplikacja Oncrawl

Źródło: aplikacja Oncrawl

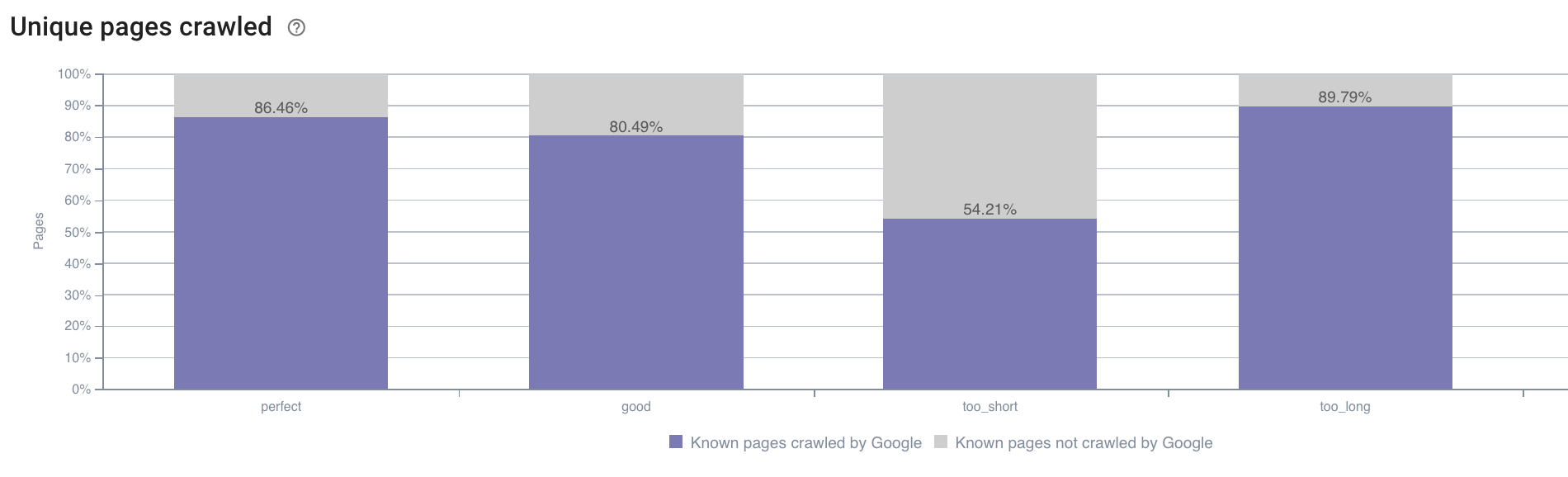

- Możemy również mieć pytania spoza zakresu tego, co domyślnie oferuje raport indeksowania Oncrawl. Na przykład, czy długość opisu ma wpływ na zachowanie Googlebota? Dane na ten temat mamy dzięki crawlowaniu, więc możemy je wykorzystać do stworzenia segmentacji tak jak poniżej:

Źródło: aplikacja Oncrawl

Opisy, które są zbyt krótkie, są indeksowane znacznie rzadziej niż te, które mają idealny rozmiar oznaczony jako „idealny” lub „dobry” przez aplikację Oncrawl (od 110 do 169 znaków).

Jeśli opis spełnia między innymi kryteria trafności i rozmiaru, Googlebot z radością zwiększy budżet indeksowania odpowiednich stron.

Uwaga: strony uznane za zbyt długie są czasami przepisywane przez Google.

Analizuj wizyty na stronie za pomocą logów

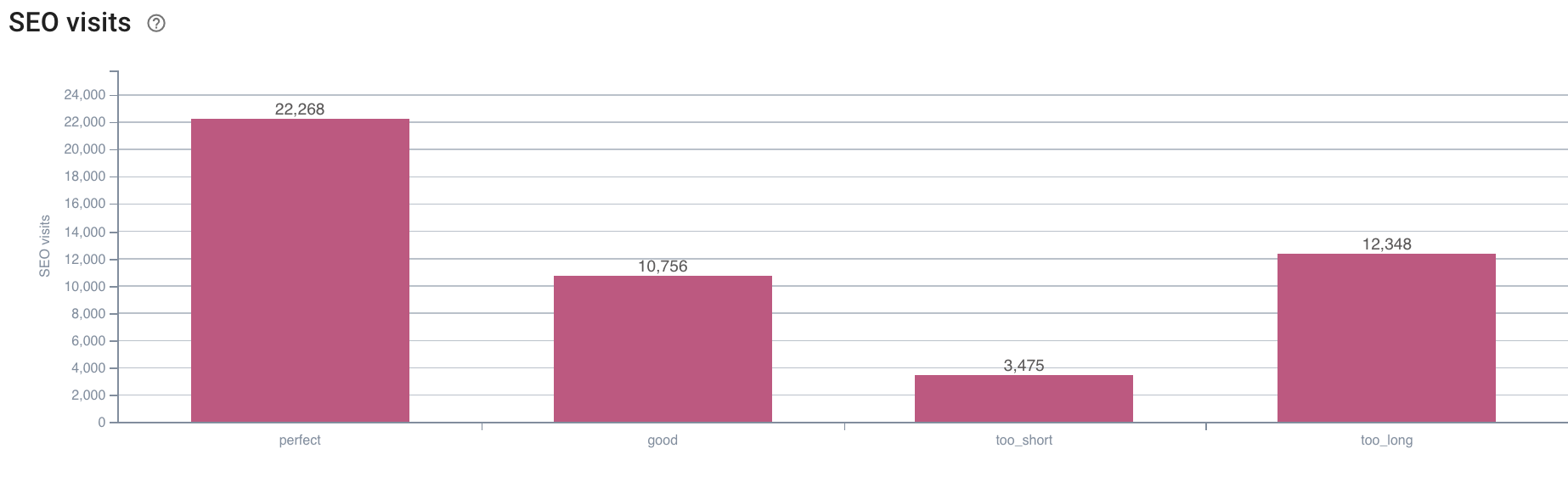

Następnie, jeśli spojrzymy na przykład SEO, ponieważ to właśnie próbujemy analizować za pomocą Oncrawl, proponuję zadać sobie kolejne pytanie:

- Jaka jest korelacja między zachowaniem Googlebota a wizytami SEO?

Oncrawl ma te same wykresy, które odwołują się do danych między indeksowaniem a wizytami SEO pobranymi z dzienników.

Źródło: aplikacja Oncrawl

Źródło: aplikacja Oncrawl

Odpowiedź jest bardzo jasna: strony, które mają „doskonałą” długość opisu, to te, które wydają się generować najwięcej wizyt SEO. Dlatego musimy skoncentrować nasze wysiłki na tej osi. Oprócz „karmienia” Googlebota użytkownicy zdają się doceniać trafność opisu.

Aplikacja Oncrawl dostarcza podobnych danych dla wielu innych wskaźników KPI. Zapraszam do weryfikacji swoich hipotez!

Podsumowując

Teraz, gdy już znasz i rozumiesz możliwość eksplorowania na co dzień tego, co dzieje się na Twojej stronie dzięki logom, zachęcam Cię do przeanalizowania internautów i odwiedzin robotów w celu znalezienia różnych sposobów na optymalizację Twojej strony. Odpowiedzi mogą być techniczne lub merytoryczne, ale pamiętaj, że dobra segmentacja jest kluczem do dobrej analizy.

Tego rodzaju analiza nie jest jednak możliwa w przypadku narzędzi Google Analytics; ich dane mogą czasami zostać pomylone z danymi naszego robota. Dobrym rozwiązaniem jest również dysponowanie jak największą ilością danych.

Aby uzyskać jeszcze więcej z danych dzienników i analiz indeksowania, zapoznaj się z badaniem przeprowadzonym przez zespół Oncrawl, który zestawia 5 wskaźników KPI SEO związanych z dziennikami w witrynach e-commerce.