7 kluczowych kroków do nauki i doskonalenia się na podstawie wyników testu A/B

Opublikowany: 2021-04-13

Twój test A/B właśnie się zakończył, ale nie widzisz oczekiwanych wyników.

Wszyscy inni dzielą się studiami przypadków, w których zauważyli ogromny wzrost dzięki zmianie koloru przycisku lub niewielkim poprawkom, ale Twój test nie poprawił konwersji lub, co gorsza, wydaje się, że zamiast tego stracił pieniądze, a teraz musisz przedstaw to swojemu szefowi.

A co, jeśli twój test nie jest tak naprawdę przegrany?

A jeśli to zwycięzca w przebraniu?

A jeśli jest to przegrany, co jeśli test na przegraną jest rzeczywiście dobrą rzeczą?

W tym przewodniku pomożemy Ci uzyskać głębszą perspektywę na wyniki testu A/B, abyś mógł je przeanalizować i podzielić, aby znaleźć złoto.

Omówimy, dlaczego uczenie się na podstawie testów A/B jest tak ważne i dlaczego przegrani mogą zapewnić Ci sprzedaż. Udostępniamy proces, który możesz śledzić, abyś mógł w pełni przeanalizować swoje testy krok po kroku i mieć pewność, że widzisz, co widzisz, wygrywasz lub przegrywasz.

Co więcej, pomożemy Ci przejść od niespokojnych danych i nie chcących sprawdzać swoich analiz, do pewności w udostępnianiu wyników innym użytkownikom.

Zanurzmy się więc w…

Dlaczego musisz uczyć się na testach A/B?

Po pierwsze, wiąże się to z oczywistymi kosztami. Konfiguracja każdego testu kosztuje. Jeśli masz warianty przegrywające, zauważysz również spadek sprzedaży dla tego wariantu.

Oto jednak rzecz:

Testy A/B (i ogólnie CRO) to nie tylko zarabianie większych pieniędzy. Chodzi o kupowanie danych . Dane o Twoich odbiorcach mogą pomóc Ci lepiej ich zrozumieć i zapewnić lepszy produkt i usługę. To z kolei prowadzi do większej sprzedaży i lepszej obsługi klienta, a nawet wglądu w nowe oferty produktów.

Im więcej dowiesz się o ludziach, którym służysz, tym lepiej robisz. Dlatego tak ważne jest częste testowanie i testowanie — nawet jeśli większość testów kończy się niepowodzeniem.

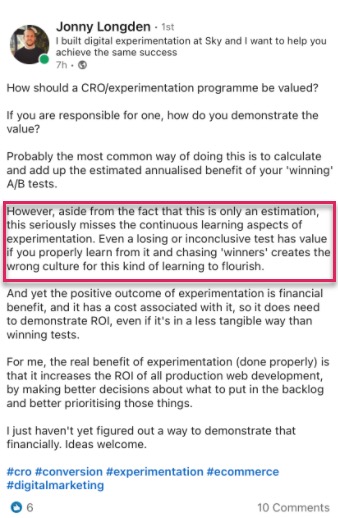

W tym myśleniu też nie jesteśmy osamotnieni.

W rzeczywistości, kiedy przejrzeliśmy nasze wewnętrzne dane z 28 304 testów za pomocą naszego narzędzia, wraz z rozmowami z ekspertami agencji testujących, stwierdziliśmy, że większość firm znajduje tylko 1 zwycięzcę na każde 10 testów, podczas gdy agencje zwykle zobaczą 1 zwycięzcę na każde 4.

I wiem o czym myślisz

Z pewnością oznacza to, że z każdym testem tracę pieniądze przez 90% czasu?

Tak, ale tylko do połowy odbiorców testowych. Druga połowa nadal widzi Twoją witrynę i dokonuje konwersji w zwykły sposób.

Ponadto dane, które otrzymujesz, pomagają dowiedzieć się, co nie działa, dzięki czemu możesz dowiedzieć się, co działa. Testujesz, uczysz się, testujesz ponownie i kontynuujesz, aż znajdziesz to, co działa.

A te 10% testów, które wygrywają?

Mogą zapewnić stały przyrostowy wzrost, który można ciągle ulepszać, zanim zostaną skalowane w całej witrynie na każdej podobnej stronie, aby uzyskać większy efekt.

Na tym polega piękno wzrostu liczby konwersji na platformie cyfrowej. Sama skala zaledwie 1% wzrostu może mieć ogromny wpływ na Twoją firmę, zarówno teraz, jak i przy całym przyszłym ruchu. W rzeczywistości Jeff Bezos myśli w ten sam sposób, nazywając Amazon i ich cel testowania i ulepszania „najlepszym miejscem na świecie, w którym można ponieść porażkę” podczas dorocznego raportu dla akcjonariuszy:

Biorąc pod uwagę 10-procentową szansę na 100-krotną wypłatę, powinieneś stawiać ten zakład za każdym razem. Ale nadal będziesz się mylił dziewięć razy na dziesięć .

Jeff Bezos, Amazonka

Większa sprzedaż i lepszy wgląd to jednak nie jedyne korzyści płynące z testów A/B.

Prowadzenie testów pozwala odejść od tematów blokad i teorii grup. Zamiast spędzać miesiące na omawianiu możliwych zmian w projektowaniu stron internetowych i nic nie robić, podejmij działania i przetestuj je, dzięki czemu Twój zespół może skupić się na innych rzeczach. (Pamiętaj tylko, aby przetestować jego działanie przed uruchomieniem go na żywo!)

Nie tylko to, ale możesz dowiedzieć się czegoś nowego o swoich odbiorcach, co TYLKO testy A/B mogą ci powiedzieć.

Tworzenie teorii i ankiety wśród klientów są świetne, ale najważniejsze jest to, co Twoi odbiorcy faktycznie robią w Twojej witrynie, a nie tylko to, co mówią. Zrozumienie testów pomaga udowodnić lub obalić te pomysły i opinie.

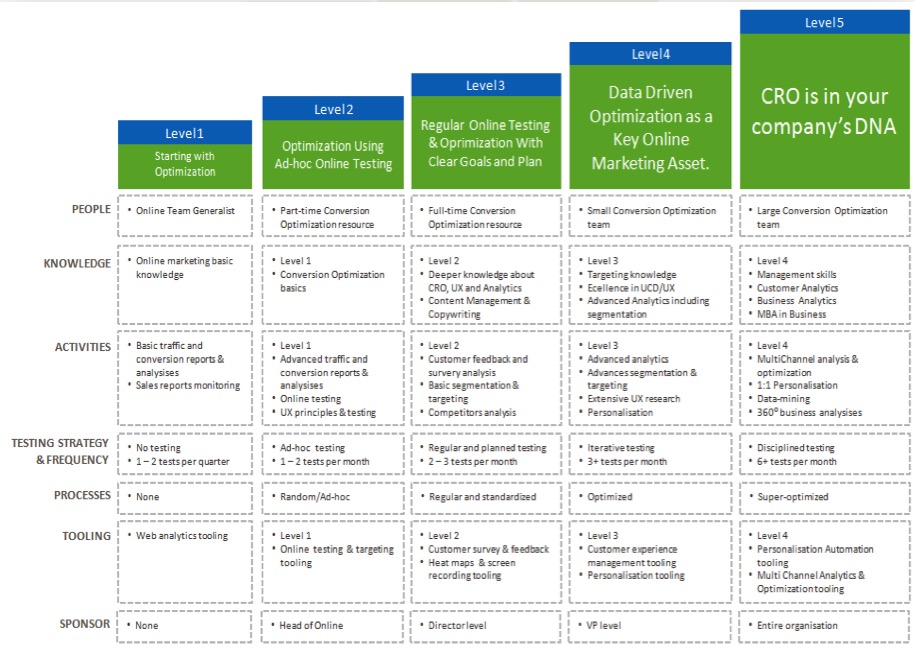

Im lepiej rozumiesz swoje wyniki, tym bardziej pewny siebie stajesz się podczas testów, co pozwala ci „dojrzeć” swoje wysiłki CRO i częściej przeprowadzać testy, a być może nawet zacząć budować wewnętrzny zespół testowy.

Teraz, gdy dostrzegasz korzyści płynące z uczenia się z każdego testu A/B, przejdźmy przez prosty proces analizy każdego nowego testu…

7-etapowy proces uczenia się na podstawie testów A/B (wraz z systemami, które możesz wykorzystać do ulepszenia przyszłych testów)

Podzieliliśmy to na 7 kluczowych kroków do naśladowania.

Być może nie masz wszystkich zalecanych przez nas metod lub narzędzi, ale widząc, jak pasują, możesz ocenić ich wartość i zdecydować, czy chcesz je włączyć do przyszłych testów.

Krok #1: Sprawdź, czy Twoje dane są dokładne, ważne + istotne

To najważniejsza część tego całego procesu. Upewnij się, że informacje, które masz w swoim teście, są zarówno dokładne, jak i prawidłowe, abyś mógł być pewny wyników.

Jak więc upewnić się, że wyniki testów dostarczają danych, którym możesz zaufać?

Cóż, jest kilka rzeczy, które możesz zrobić…

Sprawdź dokładność narzędzia

Większość ludzi za tym tęskni. Możesz go pominąć, jeśli Twoja witryna nie ma więcej niż 10 000 odwiedzających miesięcznie. Technicznie rzecz biorąc, nie trzeba zaczynać od CRO i działa najlepiej w witrynach o dużym natężeniu ruchu, ale byłoby błędem nie uwzględniać go tutaj, ponieważ duże witryny naprawdę widzą różnicę.

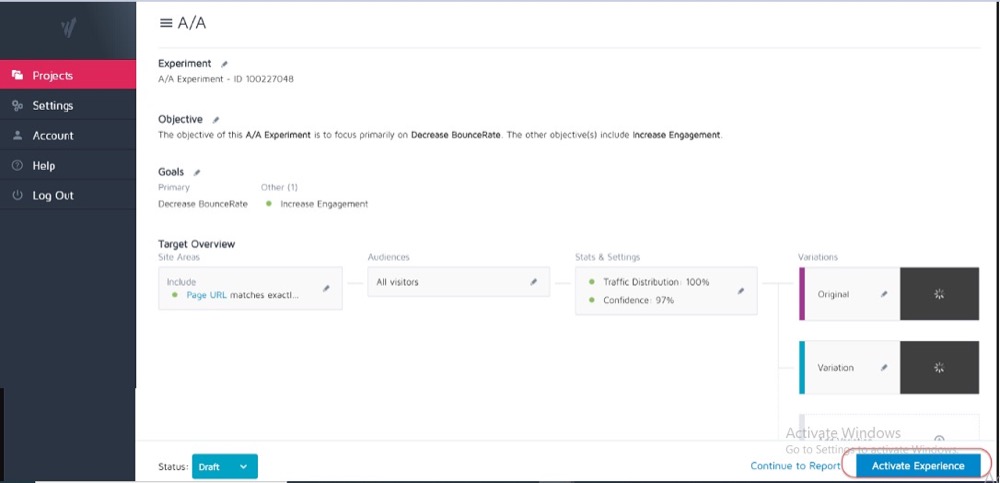

Najlepiej, jeśli uruchomiłeś już test A/A na swoim obecnym narzędziu testowym, aby sprawdzić, jaka jest jego dokładność i czy występują jakiekolwiek problemy.

Jak?

Uruchamiasz prosty test podziału z 2 identycznymi kopiami strony internetowej, a następnie śledzisz wyniki na tych 2 identycznych stronach.

Ponieważ nie ma między nimi różnic, wyniki powinny być takie same dla każdej strony. Mogą jednak wystąpić pewne rozbieżności spowodowane przez narzędzie i sposób, w jaki mierzy lub śledzi Twoje dane.

Wiedząc o tym z wyprzedzeniem, możesz uzyskać tolerancję dla dokładności wyników testów i wykorzystać je jako wytyczne dla wszystkich przyszłych testów.

Przykład

Jeśli zauważysz, że Twój test A/A wykazał 0,5% różnicy we współczynniku konwersji między dwiema identycznymi stronami, możesz obawiać się wyników testu, które wskazują zwycięzcę, gdy między kontrolą a wariantem jest tylko 0,5% różnicy.

Możesz ustawić wewnętrzne wytyczne, które mówią, że test musi wykazać wzrost o 1% lub więcej, zanim uwierzysz w wynik. Ponownie, tak naprawdę wystarczy przeprowadzić test A/A tylko raz, gdy wypróbowujesz nowe narzędzie lub jeśli uważasz, że obecne narzędzie może mieć problemy z raportowaniem lub jest nieprawidłowo skonfigurowane.

Testy A/A działają najlepiej w witrynach o dużym natężeniu ruchu, ponieważ przykładowe dane potrzebne do dokładnego sprawdzenia mogą być dość duże, ale różnica w 1% błędzie może być ogromna.

Przeprowadź test wystarczająco długo, aby uzyskać prawidłowy obraz interakcji klientów z Twoją witryną

Teraz, gdy ufasz swojemu narzędziu, chcesz przeprowadzić test przez 2-4 tygodnie, nawet jeśli uzyskasz wystarczającą liczbę konwersji, aby statystycznie móc je wcześniej wyłączyć.

Czemu?

Ponieważ Twoi odbiorcy często wchodzą w interakcję z Twoją witryną w różny sposób w zależności od dnia tygodnia lub niektórych etapów miesiąca.

Przykład

Gdyby ludzie z Twojej widowni otrzymywali wypłatę w czwartki, zauważyłbyś wzrost, który mógłbyś przegapić, gdyby Twój test odbywał się tylko od poniedziałku do środy, prawda?

Podobnie inni użytkownicy mogą otrzymywać zapłatę co dwa tygodnie lub co miesiąc, ponownie zniekształcając wyniki, jeśli testy nie trwały wystarczająco długo, aby je uwzględnić. Po prostu zakładałbyś niższą sprzedaż lub ruch w czasie, który przegapiłeś.

Skąd wiesz, kiedy zakończyć test? Przeczytaj więcej na temat istotności statystycznej testów A/B: jak i kiedy zakończyć test

Bądź świadomy wszelkich wewnętrznych lub zewnętrznych czynników, które mogą mieć wpływ na Twoje wyniki

Są to niepowtarzalne lub zaplanowane zdarzenia, które mogą zniekształcić Twoje dane.

Na przykład, jeśli Twój dyrektor generalny lub firma była w wiadomościach lub jeśli prowadzisz bieżące kampanie marketingowe lub promocje, a także wszelkie czynniki zewnętrzne, takie jak święta państwowe lub nawet losowe skoki ruchu.

Wszystko to może wpłynąć na ruch w witrynie, a następnie zmienić dokładność wyników w tym okresie.

Prawdziwa historia:

Około 6 lat temu byłem właścicielem firmy produkującej odzież surfingową.

Pewnego dnia nasz ruch znikąd wzrósł o około 800%, a nasz współczynnik odrzuceń wzrósł. Nie prowadziliśmy żadnych nowych kampanii marketingowych, więc zbadałem trochę, skąd pochodzi ruch.

Okazuje się, że jeden z naszych t-shirtów miał nazwę produktu, która była taka sama jak nowa piosenka koreańskiego zespołu popowego i przez 2 dni robiliśmy dla niej ranking i zdobywaliśmy odwiedzających.

Oczywiście ta nowa publiczność w ogóle nie była zainteresowana naszym produktem i wkrótce odeszła.

Szalony, prawda?

Innym razem mój blog marketingowy zaczął rankingować markę firmy telewizyjnej i stało się to samo. Mamy skoki w ruchu ze strony niewłaściwych odbiorców.

Tak przypadkowe, jak to jest, tego rodzaju rzeczy mogą się zdarzyć, więc bądź świadomy zewnętrznych lub wewnętrznych wydarzeń, takich jak to. Zawsze możesz sprawdzić swoje statystyki, aby zobaczyć, skąd pochodzi ruch, a następnie ponownie uruchomić test, gdy wszystko wróci do normy.

Upewnij się, że masz wystarczająco dużo danych

Chcesz się upewnić, że Twój test ma wystarczającą liczbę konwersji, aby uzyskać prawidłowe wyobrażenie o jego skuteczności.

Posiadanie kontroli i wariantu z zaledwie 50 łącznymi konwersjami i tylko niewielką różnicą między nimi nie wystarczy, aby uzyskać wgląd w odbiorców — nawet jeśli wyniki testu były w jakiś sposób istotne statystycznie. Większość ekspertów zgadza się, że około 300+ konwersji na wariant jest zwykle dobrą zasadą (a nawet więcej, jeśli chcesz podzielić na segmenty później).

Im większy zbiór danych, tym łatwiej jest znaleźć szczegółowe informacje w analizie post-testowej.

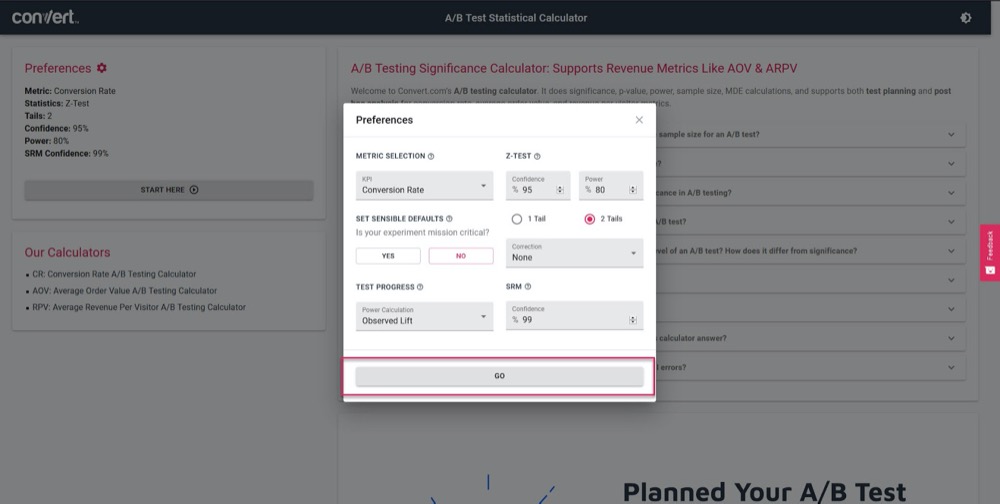

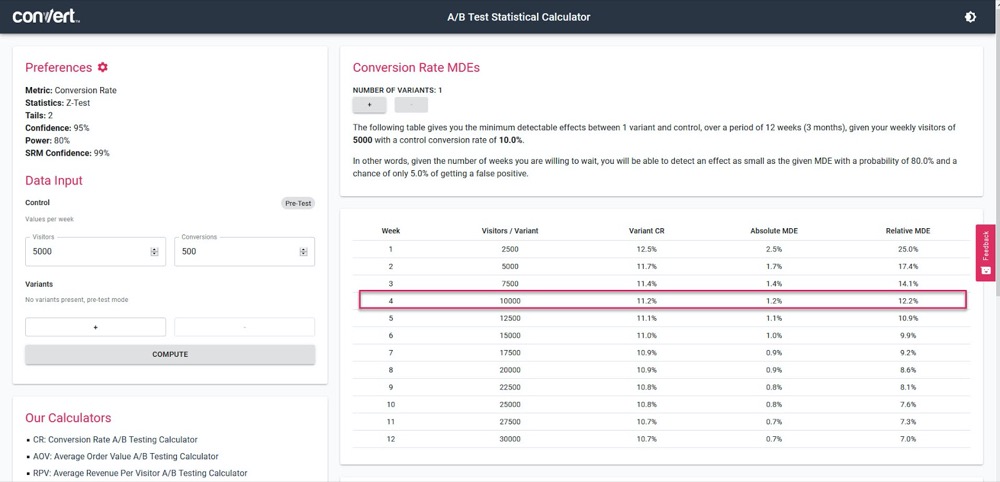

Skorzystaj z naszego kalkulatora istotności testów A/B, aby dowiedzieć się, jak dokładny będzie Twój test, na podstawie 4-tygodniowego cyklu sprzedaży i informacji z bieżącej strony „kontrolnej”.

Po prostu ustaw parametry testu:

Następnie podaj, jaki ruch powinien uzyskiwać Twój test tygodniowo, wraz z liczbą konwersji na bieżącej stronie, a następnie sprawdź, jaką dokładność i wzrost procentowy będzie w stanie obliczyć test.

W powyższym przykładzie możemy zmierzyć zaledwie 1,2% wzrostu po 4 tygodniach. (Jeśli chcemy uzyskać większą dokładność, po prostu uruchom test na dłużej lub zwiększ natężenie ruchu w teście).

Uzyskaj wyniki istotne statystycznie

Oto dlaczego istotność statystyczna jest ważna, ale nie jest najważniejszym czynnikiem podczas testowania.

Tak, chcesz mieć pewność, że Twój test będzie działał wystarczająco długo, aby zobaczyć 95-99% zaufania w wynikach, ale chcesz również upewnić się, że każdy inny czynnik, który omówiliśmy powyżej, został trafiony.

Czemu?

Nawet test A/A może wykazać 95% pewności, że jedna wersja jest lepsza niż jej identyczna kopia, jeśli nie będzie działać wystarczająco długo.

(Może losowo zobaczyć wszystkie konwersje w jednej wersji jednego dnia i żadnych w drugiej).

Zbyt wielu nowych testerów zatrzyma kampanię, gdy trafi ona na „sygnał statystyk”, co spowoduje, że otrzymają fałszywe dane. Dlatego zalecamy uzyskanie istotności statystycznej 95% lub wyższej, ale RÓWNIEŻ przeprowadzaj test w 2-4 cyklach sprzedaży, z ponad 300 konwersjami i na odpowiednio dużej próbce.

Jeśli zrobisz to wszystko, możesz być pewien, że możesz ufać, że twój test da ci prawidłowe i dokładne wyniki.

Nie mogę wystarczająco podkreślić, jak ważne jest przeprowadzenie testu, aby spełnić te kryteria.

Zbyt wczesne zwołanie testu może dać fałszywe informacje, które mogą prowadzić do:

- Nie znalezienie potencjalnego zwycięzcy, ponieważ nie masz wystarczających informacji,

- Prowadzenie kampanii o mniejszej skuteczności, ponieważ uważasz, że są zwycięzcami, ale w rzeczywistości mają niższy współczynnik konwersji,

- Albo, co gorsza, możesz uzyskać fałszywe zaufanie do tych wyników, a następnie wykorzystać to, czego się nauczyłeś, aby skalować je do innych części witryny, zwiększając w ten sposób negatywne efekty.

Czy wiesz, w jaki sposób Twoje narzędzie do testowania A/B wyciąga wnioski dotyczące wygrywających wariantów? Kliknij tutaj, aby skorzystać z naszego kalkulatora istotności testów A/B.

Dygresja:

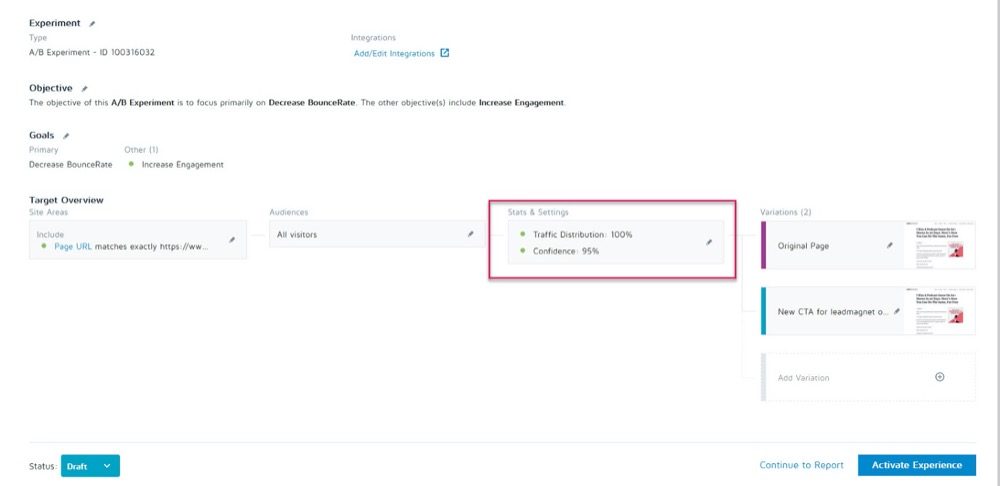

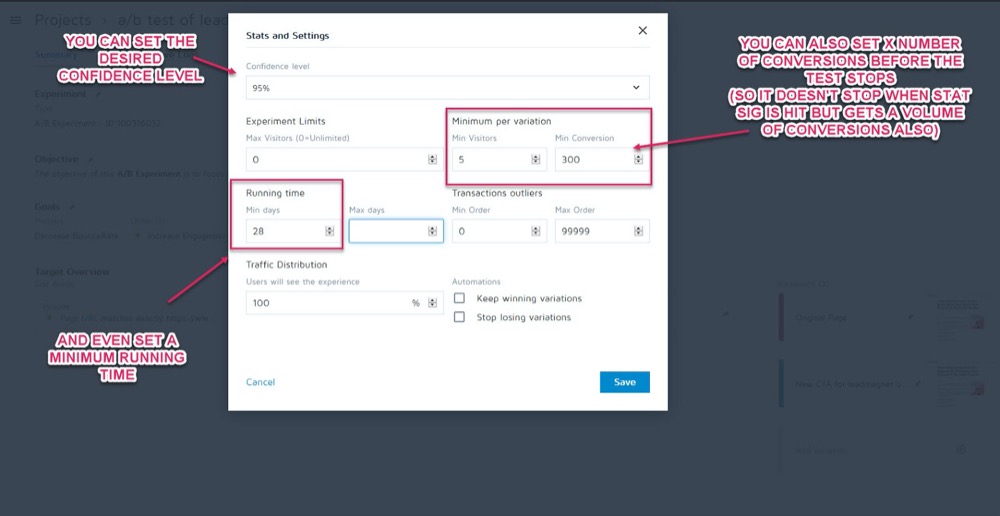

Możesz ustawić je jako parametry przed uruchomieniem testu w sekcji Statystyki i ustawienia eksperymentu w aplikacji Konwertuj doświadczenia.

Następnie możesz ustawić żądany poziom ufności, minimalny czas wykonywania i liczbę konwersji do osiągnięcia przed wywołaniem testu.

Gdy upewnisz się, że Twoje dane są dokładne, czas je przeanalizować…

Krok 2: Sprawdź swoje wskaźniki mikro, makro i poręczy

Większość ludzi spojrzy na test i weźmie zwycięzcę lub przegranego według wartości nominalnej z tego, co im podpowiada narzędzie.

Problem polega oczywiście na tym, że narzędzie może tylko powiedzieć, jak działa Twój test, na podstawie kryteriów, które dla niego ustawiłeś. Jako testerzy CRO zawsze chcemy zrozumieć „jak” i „dlaczego”, które spowodowały te wyniki, abyśmy mogli się od nich uczyć.

Teraz zrobimy kilka sprawdzeń, ale najpierw omówię trzy najważniejsze. Tu właśnie pojawia się śledzenie wyników w skali mikro i makro.

Pozwól mi wyjaśnić:

- Mikrośledzenie odnosi się do śledzenia celu, dla którego zoptymalizowałeś swój test, którym może być więcej kliknięć, rejestracji itp.

- Śledzenie makr sprawdza wpływ na dane Northstar dla Twojej firmy, którym zwykle jest sprzedaż.

Dlaczego to ma znaczenie?

Czasami wzrost zdarzenia mikro na stronie testowej nie wpływa na makro tak, jak mogłoby się wydawać.

Przykład

Załóżmy, że testujesz CTA na stronie przechwytywania potencjalnych klientów, a przegrany otrzymuje mniej potencjalnych klientów niż kontrola.

Wydaje się oczywiste, który test wygrał, prawda?

Ale po dalszej inspekcji w swoich analizach zauważysz, że potencjalni klienci, którzy przeszli w tym teście „przegrywania”, w rzeczywistości przekonwertowali znacznie wyżej na zapleczu i wygenerowały znacznie większy zwrot z inwestycji.

Dlaczego tak się stało?

Możliwe, że Twoja obecna strona jest atrakcyjna dla szerszego grona odbiorców i konwertuje więcej potencjalnych klientów, ale Twoja nowa „przegrywająca” wersja jest w rzeczywistości atrakcyjna dla osób, które są gotowe do zakupu w tej chwili.

W tym przykładzie przegrywającą kampanią byłaby w rzeczywistości strona, na której chciałbyś uruchomić, ponieważ konwersja jest znacznie lepsza dzięki danym Northstar.

Zapamiętaj swój cel końcowy i skoncentruj swoje wysiłki na tym, co ma na niego największy wpływ.

Wyniki w skali mikro i makro to jednak nie wszystko, czego potrzebujesz.

Jeśli jeszcze tego nie zrobiłeś, rozważ dodanie danych Guardrail do swoich kampanii.

Są to podstawowe wskaźniki, na które należy zwracać uwagę podczas wprowadzania jakichkolwiek innych zmian, aby jeśli zaczną spadać, można cofnąć lub zatrzymać niektóre metody testowe, ponieważ ich wydajność jest po prostu zbyt ważna.

W Uber przeprowadzamy setki eksperymentów w dowolnym momencie. Celem tych eksperymentów jest ciągłe ulepszanie naszych produktów i doświadczeń użytkowników. Czasami jednak eksperymentator może mieć na uwadze kilka kluczowych danych i może nie być świadomy wpływu na kilka innych parametrów ważnych dla zespołu i całej firmy, a w miarę prowadzenia eksperymentu te niemonitorowane dane mogą się cofać.

Aby wykrywać i łagodzić takie scenariusze, zbudowaliśmy platformę monitorowania eksperymentów. Celem jest zidentyfikowanie i monitorowanie kilku wskaźników bariery ochronnej, których nie chcemy obniżać podczas trwania eksperymentu. Stosujemy odmianę sekwencyjnej metodologii A/B, aby stale monitorować te metryki bariery ochronnej i wykrywać wszelkie regresje między grupą leczoną a grupą kontrolną eksperymentu. W przypadku wykrycia regresji wysyłamy alerty do właściciela eksperymentu .

Suman Bhattacharya, starszy analityk danych, Uber

Przykład

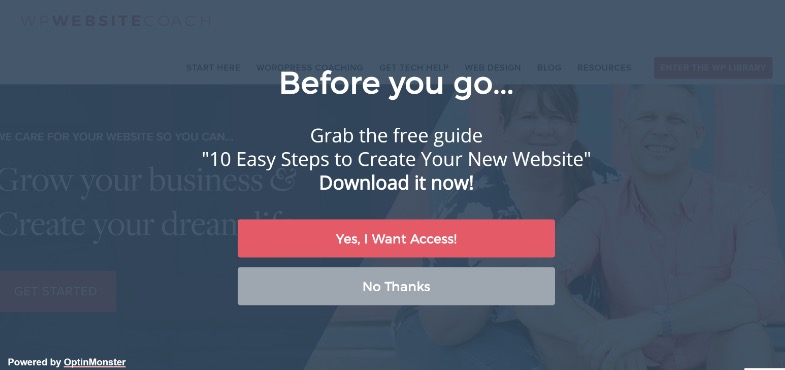

Załóżmy, że chcesz zebrać więcej potencjalnych klientów, korzystając z wyskakujących okienek na pełnym ekranie.

W przypadku niektórych witryn działają one świetnie, ale nie zawsze. (Dlatego testujemy!)

Być może zainstalowałeś pełnoekranowe wyskakujące okienko i zacząłeś uzyskiwać więcej potencjalnych klientów na tej stronie, ale Twoje e-maile powitalne do nowych subskrybentów odbijają się i nie dostarczają.

Okazuje się, że ludzie zapisywali fałszywe e-maile tylko po to, by wyskakujące okienka przestały się wyświetlać.

Nie chcesz, aby fałszywe leady znajdowały się na Twojej liście e-mailowej, ponieważ mogą one obniżyć wyniki dostarczania wiadomości e-mail do rzeczywistych subskrybentów. Nie powinieneś też chcieć obniżać komfortu użytkownika tak bardzo, aby Twoi odbiorcy poczuli, że muszą sfałszować swój e-mail.

Ponieważ marketing e-mailowy jest podstawową częścią procesu sprzedaży, decydujesz się ustawić alert, aby poinformować Cię, jeśli współczynnik odrzuceń wiadomości e-mail przekroczy ustalony punkt podczas przeprowadzania testów A/B na stronie przechwytywania potencjalnych klientów.

To byłby twój wskaźnik poręczy. W tym przykładzie widać, że jest zepsuty i decydujesz się na użycie mniej inwazyjnych metod przechwytywania potencjalnych klientów.

Czy to ma sens?

Wskaźniki Guardrail to jednak nie tylko przechwytywanie leadów i współczynnik odrzuceń. Są to kluczowe wskaźniki, w których nie chcesz widzieć spadku, który wpływa na wrażenia użytkownika.

Aby zapobiec pogorszeniu doświadczenia użytkownika, a jednocześnie zapewnić poprawę istotnych metryk, zdefiniuj kilka metryk bariery ochronnej, których spadek o pewien próg uniemożliwiłby Ci przejście do przodu z wprowadzeniem rzekomego „ zwycięski”. Pomaga to również zakończyć debatę między optymalizacją konwersji a wytycznymi dotyczącymi UX lub marki .

Alex Birkett, Wszechwiedzący Cyfrowy

To Ty decydujesz, jakie dane są dla Twojej firmy. Użyj ich, aby sprawdzić, czy masz rzeczywistego zwycięzcę, czy po prostu handlujesz wzrostem jednego wyniku na stratę w ważniejszym obszarze.

Jeśli potrzebujesz inspiracji, zapoznaj się z listą Ben Labay'a typowych wskaźników poręczy podczas eksperymentowania i testowania:

Następnie wprowadź odpowiednie zmiany.

Dopóki masz skonfigurowaną aplikację Convert Experiences ze swoimi analizami i zaawansowanymi segmentami, powinieneś być w stanie znaleźć te informacje po szybkim rozejrzeniu się. Sprawdź wpływ każdej odmiany na metrykę Northstar, a także swoje „bariery ochronne”, aby nie tylko wybrać zwycięzcę narzędzia testowego.

Teraz, gdy masz już omówione podstawowe dane, przyjrzyjmy się nieco dokładniej Twoim wynikom…

Krok 3: Idź głębiej i posegmentuj swoje wyniki

Pamiętaj, że jeśli chodzi o testowanie, średnia to kłamstwo .

Średni wynik może dać tylko szerokie informacje na podstawie kombinacji wielu punktów danych. Od Ciebie zależy, czy zrozumiesz, dlaczego ten wynik wystąpił, a następnie zajrzysz głębiej, ponieważ nie zawsze jest taki, na jaki wygląda.

Widzieliśmy już to, gdy zmiany w mikrotestach wpływają na wyniki makro, ale segmenty analityczne mogą dać jeszcze głębszy wgląd.

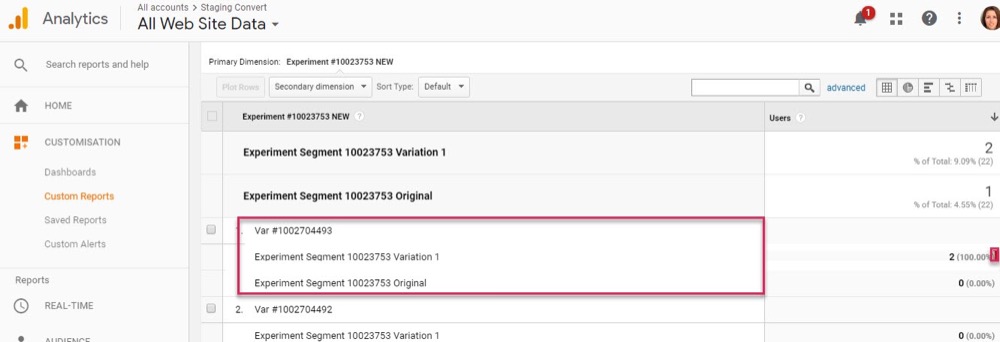

Przykład

Załóżmy, że przeprowadzasz test dla większej liczby potencjalnych klientów. Na pierwszy rzut oka kontrola i wariant mają ten sam współczynnik konwersji odwiedzających do subskrybentów.

Jednak po głębszej analizie zauważysz, że na komputerach nowa odmiana jest prawie dwukrotnie wyższa od współczynnika konwersji kontrolki, ale na urządzeniach mobilnych wynosi zero, przez co średnia strony wydaje się identyczna z kontrolką.

Najwyraźniej coś jest nie tak, ale dlaczego tak się stało?

Możliwe, że nowy wariant po prostu nie ładuje się poprawnie na urządzeniach mobilnych, a może formularz nie działa na określonych urządzeniach, więc żaden użytkownik mobilny, który chciał subskrybować, w rzeczywistości nie mógł. A jeśli naprawisz ten problem, może się okazać, że wariant o równym wyniku jest w stanie znacznie przewyższyć kontrolę.

Te rzeczy możesz znaleźć tylko wtedy, gdy pracujesz, aby uzyskać więcej informacji na temat swoich wyników.

W każdym teście będziesz eksperymentować, aby uzyskać szczegółowe informacje, które umożliwią inteligentniejszą segmentację, co doprowadzi do nowych informacji, które ostatecznie zaprowadzą Cię do bardziej sensownej strategii .

Shanelle Mullins, Shopify

Segmentacja to nie tylko znajdowanie błędów, ale także znajdowanie innych spostrzeżeń użytkowników.

Może strona i kontrolka działają dobrze, ale gdy zajrzysz głębiej, zauważysz, że niektóre kanały ruchu konwertują znacznie więcej w tym nowym teście niż inne?

Często zdarza się, że niektóre segmenty będą słabsze, a inne zbyt skuteczne. Może to następnie pomóc w nowych kampaniach personalizacyjnych lub strategiach płatnego lub organicznego ruchu.

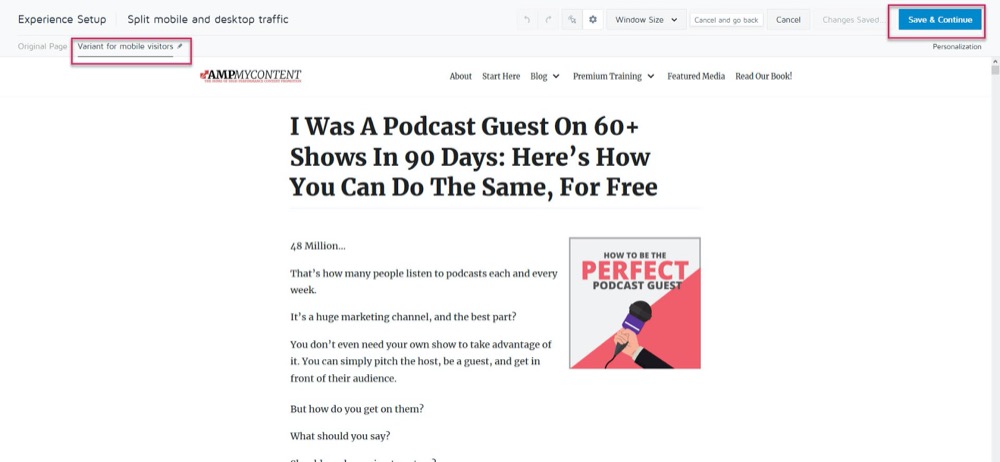

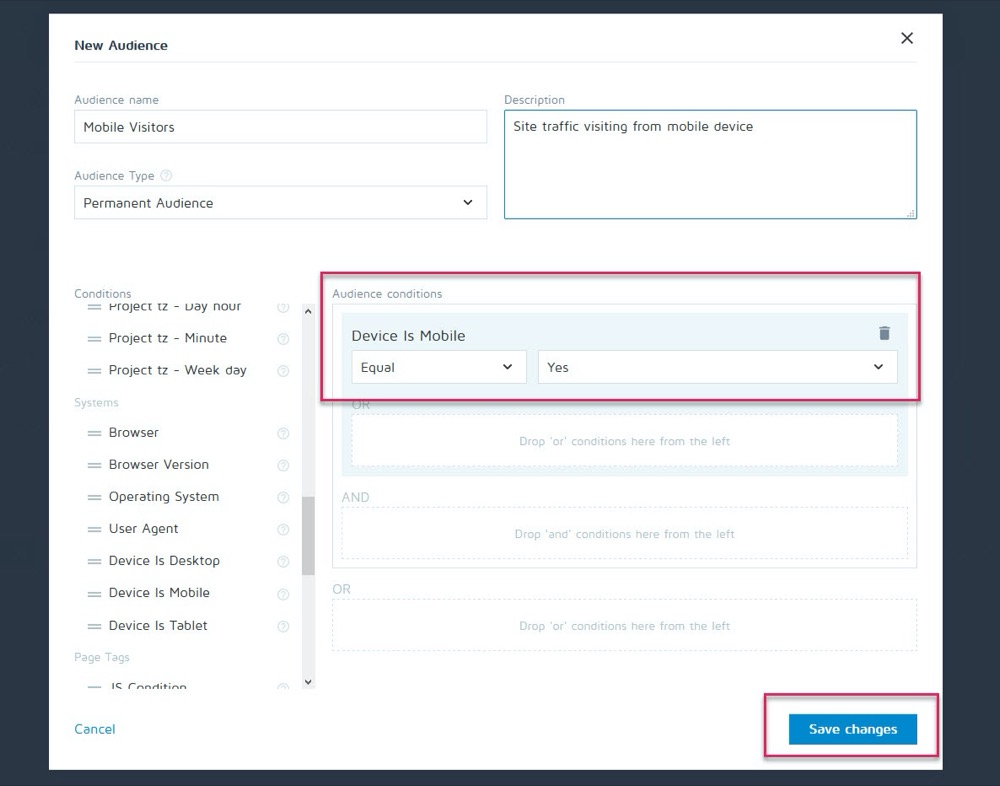

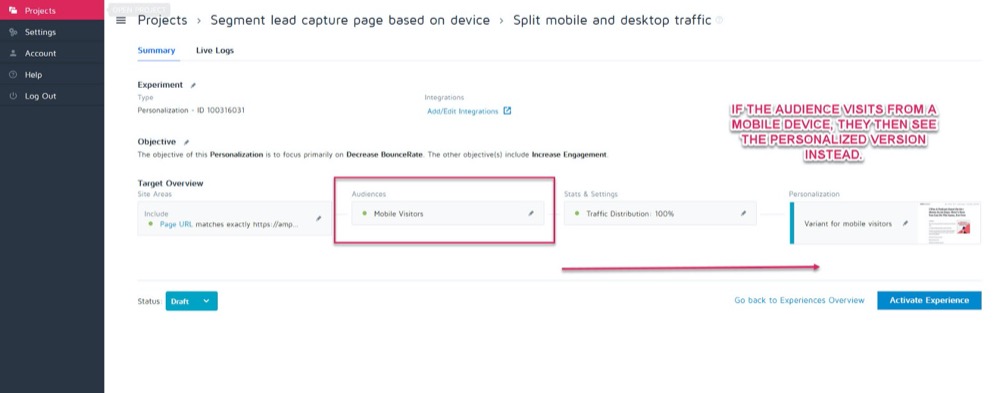

Być może sterowanie najlepiej konwertuje na komputerach stacjonarnych, ale nowy wariant daje wyższą konwersję na urządzeniach mobilnych. Załóżmy na przykład, że chcesz wybrać wyświetlaną wersję na podstawie tego, jak widz widzi Twoją witrynę.

Korzystając z funkcji personalizacji Convert, możesz skonfigurować tę zwycięską odmianę mobilną jako personalizację tylko dla tej grupy odbiorców.

Następnie możesz wyświetlić nową wersję, gdy odwiedzający pochodzi z dowolnego urządzenia mobilnego.

Ale jeśli natkną się na komputer stacjonarny, zamiast tego zobaczą wersję komputerową.

Istnieje cała masa różnych metod personalizacji, z których możesz skorzystać, ale tylko wtedy, gdy uzyskasz wgląd w swoje kampanie.

Kluczem do analizy segmentów jest zawsze sprawdzanie wyników, aby dowiedzieć się, DLACZEGO coś się wydarzyło.

Patrzeć na:

- Nowi kontra powracający odbiorcy . Czy jeden z wariantów powoduje, że ludzie wracają częściej? Czy jeden konwertuje więcej zimnych/nowych odbiorców?

- Źródło ruchu. Czy jeden kanał radzi sobie lepiej niż inne? Czy mógłbyś się tutaj bardziej skupić?

- Wyświetlenia strony. Zwłaszcza jeśli Twoja strona testowa próbuje przyciągnąć ruch do Twojej strony sprzedaży. Brak kliknięć w jedną wersję może oznaczać, że masz uszkodzony przycisk lub problem z CTA.

- Współczynnik odrzuceń. Może to wskazywać na uszkodzony link/wolne ładowanie/złe wrażenia UX, a nawet kierowanie do niewłaściwych odbiorców.

- System operacyjny,

- Mobilny a komputer stacjonarny.

- Używane urządzenie.

Niewielkie zastrzeżenie:

Aby uzyskać dokładne odzwierciedlenie każdego kanału podczas takiego segmentowania, potrzebujesz DUŻO danych. Dobrą praktyczną zasadą jest przeprowadzenie testu z około 10-krotnością liczby konwersji w porównaniu z normalną liczbą (lub 300 konwersji na kanał, a nie tylko na stronę wariantu).

Być może myślisz: „Nie ma możliwości, aby uzyskać wystarczający ruch, aby przeprowadzić taki test ”. A jeśli to zrobisz, może minąć kilka miesięcy, zanim to się stanie.

Nawet jeśli tak jest, nie pomijaj analizy segmentów.

Czemu?

Nawet jeśli liczba konwersji w każdym segmencie może być niewystarczająca, aby wyciągnąć wnioski poparte danymi, może to dać pewne rzucające się w oczy informacje, jeśli zaczniesz dostrzegać problemy, takie jak wyświetlenia strony bez kliknięć lub natychmiastowy współczynnik odrzuceń .

Są to wszystkie rzeczy, które mogą wskazywać na zepsuty test i pomóc w znalezieniu potencjalnie przeoczonego zwycięzcy. Śmiało i szukaj wszelkich poważnych porażek i problemów. Czy wszystko działało na każdej platformie i urządzeniu?

Najlepiej, jeśli sprawdziłeś je wszystkie przed testem, ale rzeczy mogą się zepsuć w trakcie testu, więc sprawdź ponownie.

Osobiście WordPress aktualizował się automatycznie w trakcie kampanii, co powodowało, że formularze przechwytywania leadów nagle przestały działać w trakcie testu. Zawsze sprawdzaj, a jeśli zauważysz coś, co psuje dokładność wyników, zatrzymaj test, napraw problem, a następnie uruchom ponownie.

A czy wszystko działało dobrze?

Przyjrzyjmy się i dowiedzmy się, DLACZEGO ludzie nie podjęli Twojej akcji…

Krok 4: Sprawdź zachowanie użytkownika, aby uzyskać dalsze informacje

W idealnym przypadku powinieneś mieć śledzenie jakościowe na szczycie swojego narzędzia testowego.

Czemu?

Ponieważ często może to dać wgląd w Twój wariant, który mógłbyś przegapić przy regularnym testowaniu.

Pamiętać:

Narzędzia do testowania ilościowego , takie jak Convert, informują o tym, co się stało. Możemy podać surowe dane liczbowe między liczbą osób, które kliknęły lub nie kliknęły, i pomóc w skonfigurowaniu każdego testu A/B.

Jednak dodanie narzędzi jakościowych pomaga zrozumieć, DLACZEGO doszło do działania. Pozwalają zobaczyć, co robi użytkownik i uzyskać lepszy wgląd w jego działania.

(Testy zwykle kończą się niepowodzeniem z powodu złego wykonania lub zrozumienia odbiorców i tylko poprzez zobaczenie, co poszło nie tak, możemy to rozwiązać.)

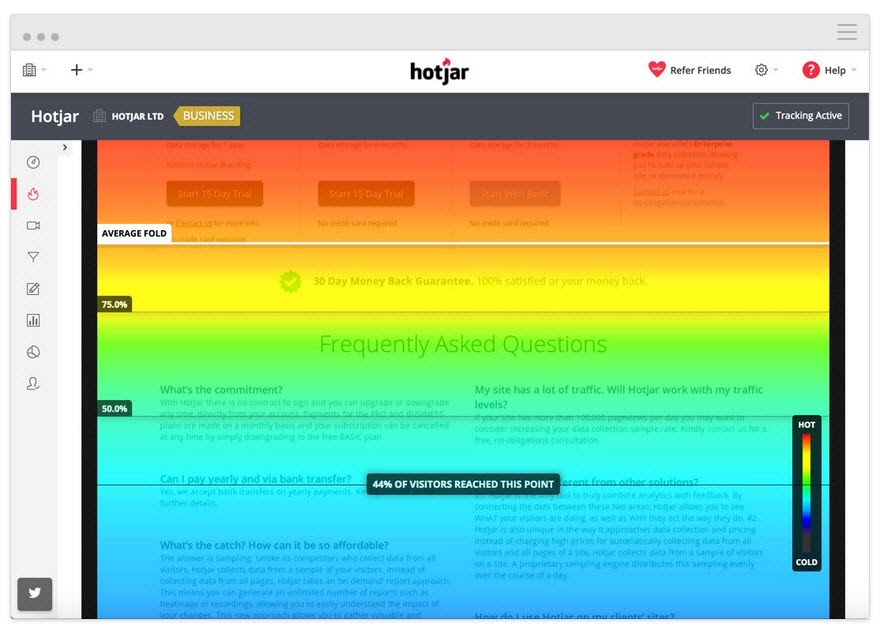

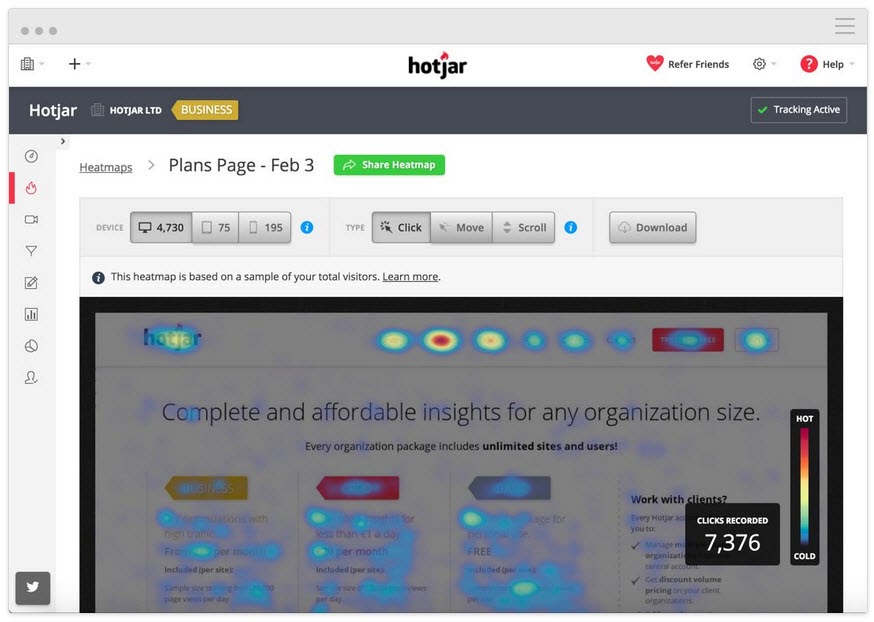

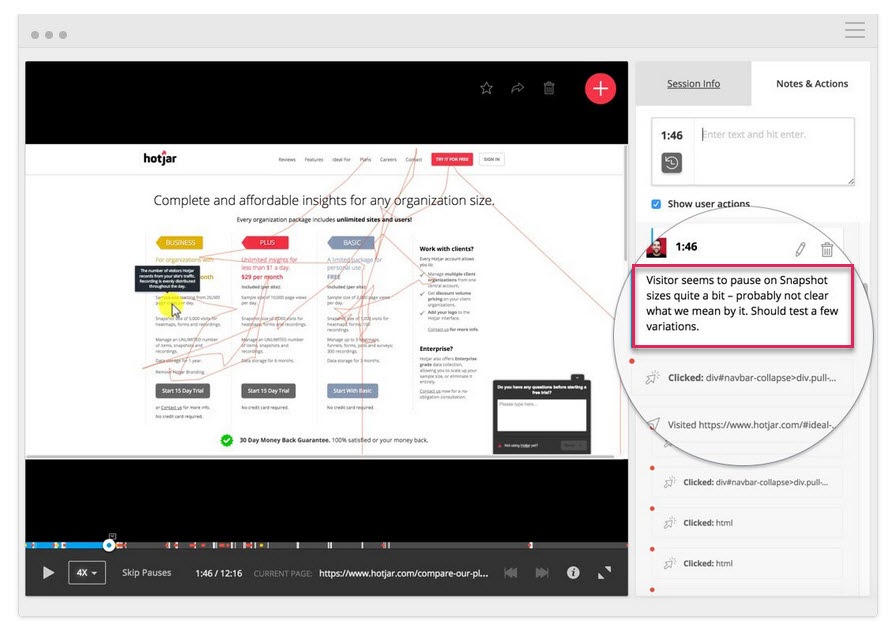

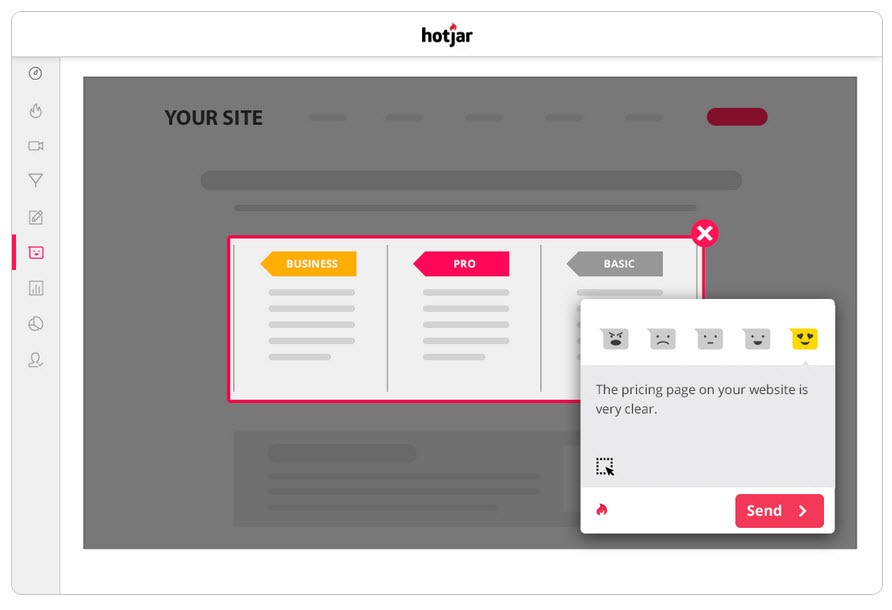

Korzystając z narzędzia takiego jak Hotjar, możesz przeprowadzić szereg testów jakościowych, a nawet pobrać dane bezpośrednio do pulpitu Convert dzięki naszej wbudowanej integracji.

Aby uzyskać głębszy wgląd, skonfiguruj integrację Hotjar – Konwertuj i wypróbuj poniższe taktyki.

Śledź, jak daleko czyta użytkownik

Dodaj do swojej strony narzędzie mapy termicznej, aby sprawdzić, czy Twoi odbiorcy dotrą do Twojego CTA. Jeśli nie, możesz uruchomić test ponownie i przenieść wezwanie do działania wyżej na stronie.

Śledź, co użytkownicy klikają, ale nie powinni

Czy klikają strategiczne CTA, czy jest to losowy tekst, który według nich może być linkiem?

Oglądaj nagrania z ekranu, aby zobaczyć, czego nie klikają, ale powinny

Czy nie klikają przycisku wezwania do działania, mimo że przewijają wystarczająco daleko, aby go zobaczyć? Czy klikają, ale się nie otwierają? Czy widzą to, ale nie zdają sobie sprawy, że jest to przycisk, który należy kliknąć?

Możesz to wszystko oglądać, a nawet dodawać notatki, gdy te rzeczy wyskoczą.

Pomocne mogą być nie tylko narzędzia do mapowania ciepła i śledzenia kliknięć.

Przeprowadzaj ankiety wśród swoich odbiorców

Ankiety pomagają nie tylko uzyskać informacje zwrotne na temat tego, co skłoniło odbiorców do podjęcia działań (lub ich powstrzymać), ale także podać język, którego używa do opisania tego.

W copywritingu nazywamy to „językiem lustra” i jest on niezwykle skuteczny w łączeniu się z użytkownikiem. Wydaje się, że nie tylko rozpoznajesz ich problem, ale rozumiesz go lepiej niż ktokolwiek inny, ponieważ opisujesz go tymi samymi słowami, których używają.

Dwa świetne sposoby korzystania z ankiet wraz z narzędziem do testowania A/B to:

- Wyjdź z ankiet zamiaru . Zidentyfikuj tych, którzy nie korzystają z nowej wersji, aby dowiedzieć się, co ich powstrzymało.

Czy jest jakiś powód, dla którego dzisiaj nie zdecydowałeś się/zakupiłeś?

- Ankiety po zakupie/konwersji. Znajdź tych, którzy biorą ten wariant i sprawdź, czy są jakieś problemy i czynniki motywujące.

Co skłoniło Cię do podjęcia działań dzisiaj?” Czy było coś, co prawie powstrzymało cię przed podjęciem decyzji?

Możesz nawet przeprowadzić podobne ankiety na kontrolce, jeśli chcesz uzyskać więcej informacji. Wszystko to pomoże ci zrozumieć, jak test się sprawdził, dzięki czemu możesz iterować i ulepszać.

A propos…

Krok #5: Ucz się na przegranych testach

Najważniejszą rzeczą, jeśli chodzi o uzyskanie testu przegrywającego, jest nauczenie się czegoś z wyniku. Nie ma czegoś takiego jak zły test, o ile możesz wyciągnąć z niego spostrzeżenia, aby poprawić lub lepiej zrozumieć swoich odbiorców.

Testy A/B to proces interaktywny. Przegrywamy, zdobywając zrozumienie. Często można nauczyć się znacznie więcej z przegranego testu do zwycięzcy, niż po prostu zwycięzcy.

Do tej pory robiliśmy 3 rzeczy:

- upewnienie się, że dane testowe są dokładne,

- Patrząc na surowe wyniki pod kątem wszelkich problemów, i

- Próbując zrozumieć naszych użytkowników i ich działania.

Ten krok jest bardziej podejściem heurystycznym, które pomaga zrozumieć typowe problemy, które mogą spowodować niepowodzenie (zakładając, że dane testowe są dokładne i wszystkie przyciski CTA działają) oraz przeanalizować podejście i hipotezę.

Czy twoja hipoteza była błędna, czy też test był źle ustawiony?

To częsty problem, zwłaszcza wśród nowych testerów.

Czy przeprowadziłeś test na podstawie niektórych wskaźników lub pomysłów „woo woo”, które nie były zgodne z rzeczywistym wskaźnikiem KPI?

Przykład

Załóżmy, że chcesz zwiększyć sprzedaż ze strony, ale z jakiegoś powodu zdecydowałeś się zamiast tego przetestować ulepszenia przycisków udostępniania społecznościowego. (Nawet jeśli nie masz żadnych danych, aby pokazać, że więcej akcji społecznościowych wpływa na sprzedaż).

Brzmi to szalenie, ale zdziwisz się, jak często coś takiego się dzieje.

Zapytaj siebie:

Czy mój cel testu był zgodny z kluczowym KPI i w sposób, który może na niego wpłynąć?

Jeśli tak się nie stało, to w porządku, ale upewnij się, że następny test pasuje lepiej.

Zawodzimy, uczymy się, próbujemy ponownie.

Przy następnym teście skoncentruj się na podstawowych wskaźnikach KPI i na tym, jak możesz na nie wpłynąć, a także nadaj testowi jasny scenariusz wygranej/porażki.

Chcemy, aby ta strona pozyskiwała więcej potencjalnych klientów, więc testujemy to, co zachęca ich do wyrażenia zgody, co oznacza, że chcemy stworzyć lepsze wezwanie do działania.

lub

Chcemy, aby ta strona pozyskiwała więcej potencjalnych klientów. Odkryliśmy, że użytkownicy nie przewijają aż do naszego CTA, więc testujemy podnoszenie jej w górę strony.

Dopasowanie testu do celu wprowadzi Cię na właściwą ścieżkę, ale nawet wtedy może nie odnotować większej liczby konwersji…

Hipoteza była poprawna, a test zgodny, ale wyniki nadal nie uległy zmianie

Może się to zdarzyć w 90% przypadków i dlatego większość testów kończy się niepowodzeniem.

Przykład 1

Twoje dane użytkowników pokazują, że użytkownicy nie ufają wystarczająco Twojej witrynie. Dodano czynniki zaufania, takie jak dowód społeczny, referencje użytkowników, certyfikaty SSL, ale konwersje nadal nie wzrosły.

Czy to oznacza, że powinieneś się zatrzymać i spróbować nowego testu lub nowego kąta?

Zupełnie nie…

Twoja początkowa hipoteza mogła być słuszna, ale twój test wymaga tylko poprawy lub lepszego wykonania, zanim zobaczysz jakikolwiek efekt.

Możesz spróbować dodać więcej czynników zaufania, a nawet przesunąć te, które masz, aby bardziej się wyróżniały. Być może przeformułować używany w nich język, aby pomóc im lepiej nawiązać kontakt z odbiorcami.

Wszystkie te rzeczy nadal są zgodne z początkową hipotezą, wystarczy przetestować więcej wersji, aby znaleźć zwycięzcę.

Przykład #2

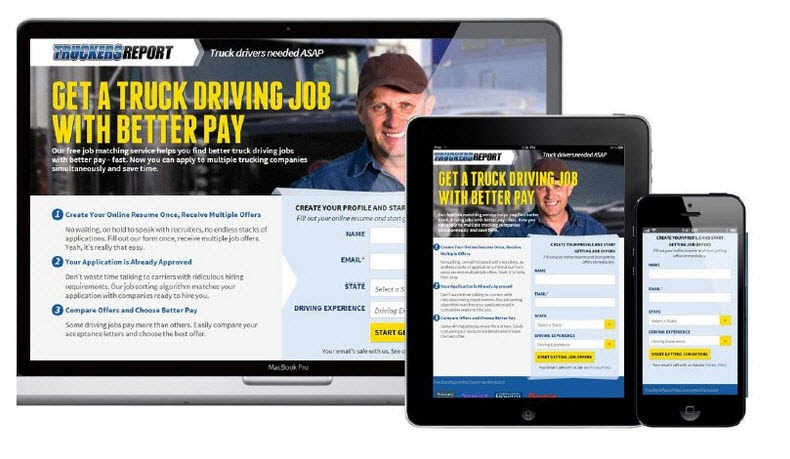

Firma CXL przeprowadziła 6 różnych kampanii testowych na tej stronie docelowej, aby uzyskać więcej potencjalnych klientów do certyfikatów kierowców ciężarówek.

Podnieśli współczynnik opt-in z 12,1% do 79,3%, a wszystko to dzięki ciągłemu ulepszaniu strony.

(Prawie wszystkie te kampanie testowe podjęły wiele prób, korzystając z tej samej hipotezy, zanim odnotowały wzrost. Dopiero wtedy przeszły i przetestowały, aby poprawić inne elementy na stronie).

Testy A/B to proces iteracyjny. Musisz ciągle testować i poprawiać, aby znaleźć ulepszenia, a nawet najlepsi w branży mogą znaleźć zwycięzcę tylko w 10% przypadków.

Gdybyś hipotetycznie był organizacją i każdy test, który przeprowadziłeś, był sukcesem, to moim zdaniem byłaby to czerwona flaga.

Brzmi to sprzecznie z intuicją, ale pokazuje mi, że testujesz tylko oczywiste rzeczy i nie podejmujesz wystarczającego ryzyka, aby naprawdę poruszyć igłą .

Deborah O'Malley, Zgadnij test

Zawsze wspaniale jest uczyć się od najlepszych i cieszymy się, że możemy podzielić się wywiadem, który przeprowadziliśmy z Deborah. Rozmawialiśmy o tym, dlaczego testy nigdy nie kończą się niepowodzeniem oraz o znaczeniu posiadania właściwej mentalności podczas testowania. Aby pomóc Ci zacząć na właściwej stopie, posłuchaj naszego wywiadu tutaj.

Oznacza to, że możesz potrzebować 9 testów, zanim zobaczysz pozytywny wzrost, więc trzymaj się tego.

Twoje testy powinny przebiegać według systemu priorytetów od największego wpływu do najmniejszego. Przeprowadzając więcej testów i zmian, aby ulepszyć obecną kampanię, zobaczysz znacznie większy wpływ niż przejście do testu o niższej ważności, ponieważ nie widzisz natychmiastowych wyników w bieżącym.

A jeśli nadal nie widać wzrostu z mniejszymi zmianami, rozważ przeprowadzenie innowacyjnego testu, w którym uruchamiasz inny projekt.

Może to być huśtawka dla ogrodzenia, ale czasami może to być zmiana, której musisz dokonać.

Co się stanie, jeśli po tych wszystkich testach i poprawkach wariant nadal jest przegrany?

Tak więc dane są poprawne i wypróbowałeś każdą poprawkę, a nawet dokonałeś dużych innowacyjnych zmian na całej stronie i nadal nie będzie ona działać lepiej niż kontrola.

Może się na to nie wydawać, ale w rzeczywistości jest to DOBRA RZECZ.

Czemu?

Ponieważ dowiedziałeś się, co nie działa z twoją publicznością!

Tak wiele witryn wprowadza ogromne zmiany bez testowania czegokolwiek i po prostu je wprowadza.

Zadaj sobie to pytanie:

Jeśli konwersja tego wariantu strony jest tylko o 1% gorsza niż Twoja obecna kontrola, ile pieniędzy zaoszczędziłeś, testując ją najpierw i nie wprowadzając jej?

Back in 2014, Marks and Spencer decided to update their entire website without testing it with a sample audience first.

Wynik?

Their online sales dropped by 8.1% in 3 months, causing a loss of $55 million.

This is why testing and finding losers is a really good thing because even losing tests can save you money.

What if the Test and the Variant Have Identical Results?

You checked everything, it all works, you've segmented down and gone into the nitty-gritty, but there's just no discernible difference between your current page and your new variant.

You've even tried complete page overhauls but through some fluke of math, your new page still converts at the same rate as the old one.

In this case, it's simply the dealer's choice.

Does the new variation more actively represent your brand and style?

If so, choose whichever you wish to use. The results are still the same but you are happier with the design.

Note: This should be the only time that you do this. Branding should not sacrifice results; it should aid them, as seen in the previous example.

Step #6: Double Down on Winners and Continue to Improve Them

So far we've been covering losing campaigns, but what if you got a winner right out of the gate?

First off, congratulations!

Second, let's make sure you actually have a winner. Oftentimes, things can happen to affect your results and give you a false positive (ie we think it's a winner but we implement it and nothing happens.)

Go ahead and run the test again with just your control and the winning variant and prove the lift in results first before you make any changes to your site.

Then if it really is a winner? Don't stop there, continue to improve it!

Iterative improvements of a new winning campaign are the easiest new test to run. With each new improvement, you'll see more ongoing ROI. You can even take what you learned with your winning test and then roll it out across similar pages on your site for further tests and see if it also adds lift there too.

Step #7: Create a Learning Repository for Future Tests

This step is relevant to both winning and losing tests.

Not only will it help you with future tests, but it will also help your QA team diagnose any broken campaigns faster, as they can see where issues have appeared in the past.

Better still?

It will help you document your results for clients or your boss, while also standardizing your reporting processes and ramping up your test velocity.

Oto jak to działa:

You're going to create a master archive or learning repository of all past tests. A place to document your previous wins and losses that you can use to both reference for new campaigns and share with stakeholders or customers.

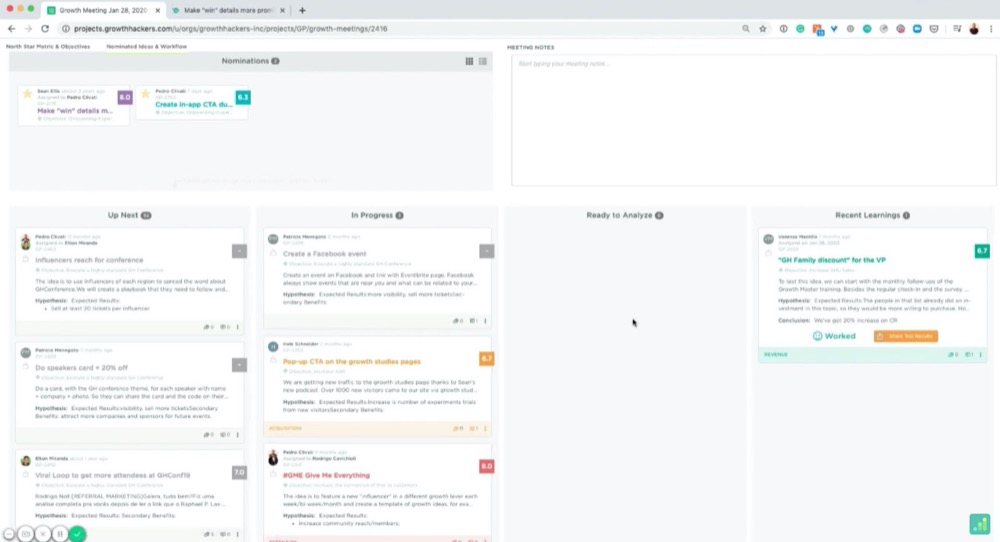

You can use a folder on your computer for this, but, if you really want to get organized, there's a great tool called GrowthHackers experiments.

Its main goal is to help marketing growth teams communicate and organize campaigns, but you can easily use it to manage your CRO testing and learnings. It will even pull in results from your test tool and allows you to archive each test. (You can simply tag and then add them to the repository.)

Whatever you decide to use, here are some best practices:

Organizing Your Tests

You probably have your own naming conventions but if you're just starting, I recommend naming each test like so:

“Goal – Campaign – Test Date”

Na przykład:

“CTR lift test – XYZ client – March 1st-14th 2021”

This way, you can organize tests by goals to get inspiration for future tests, search through and find them for client campaigns, or look back on your experiments month by month.

Then, if you wanted to run a CTR test later on, you can swipe through them and see what ideas worked or failed in the past.

How Do We Create Documents for the Learning Repository?

Feel free to add screenshots of your testing tools graphs, confidence, and power level or any data that you think is relevant.

However, I highly recommend creating a slide with the following information:

- The hypothesis and how you came up with the idea (any survey data or information).

- A headline with the test goal.

- A screenshot of the control, the winning variant, and any other failed versions/tests that got some lift but not as much. (Highlight the key elements so you can spot what changed without having to look too hard.)

- Add the micro goal and its percentage lift. (Perhaps 3.2% CTR)

- Then add the macro goal and its percentage lift. (AVG order value up 2.2%, etc.)

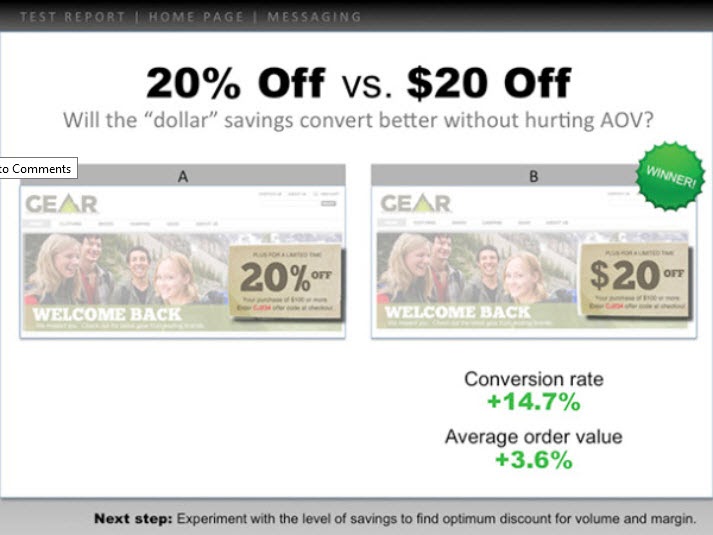

Oto przykład:

You can use these slides to present the test information to anyone else who needs them, while also having a simple file to understand the test at a moment's notice.

Pretty handy, right?

Now that you've analyzed your test and recorded the results, let's walk you through how to present this to your boss in a way that even if the test failed, they're still happy to see your findings…

How To Present This Information To Your Boss (Even When Your Campaigns Failed)

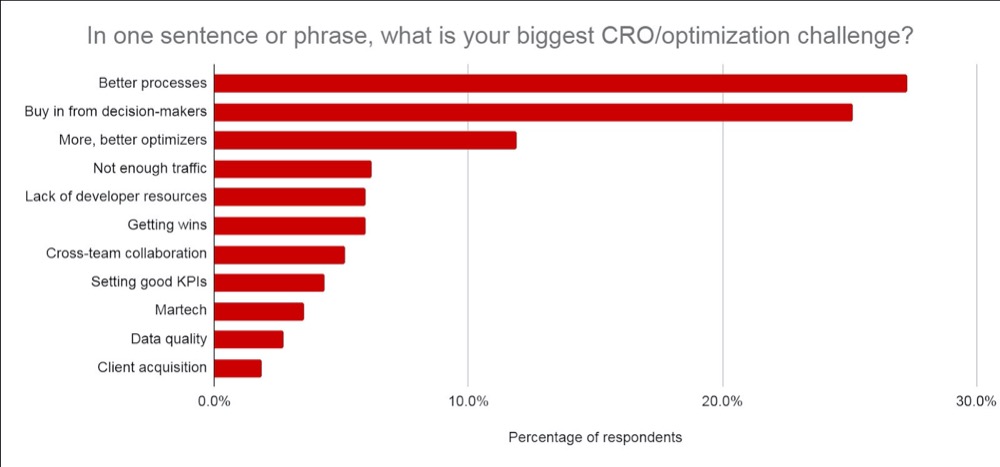

Don't worry if you feel anxious about this, you're not alone. In fact, according to CXL's state of the industry report, presenting test information or getting buy-in from your stakeholders is consistently one of the biggest struggles CROs face.

We've covered the best ways to communicate this information before, but I want to give you a few extra tips on how to get your test results across (even if your test failed).

Tip #1: Get Everyone On Board With CRO and Its Realities as Soon as Possible

Ideally, you covered this when you first broached the topic of running A/B tests but it never hurts to recap.

Make sure they understand that A/B testing is a continual learning process that's more about understanding your audience and improving their experience. The lift in ROI is simply a byproduct of taking action on each test and implementing what you learn, regardless of if it wins or fails.

Winners give lift and losers give insight into where to improve.

No test is ever wasted but the majority of them do fail. You're looking at roughly 1/10 winners for most people's tests and agencies are around 1/4.

Be clear on how many tests fail and the need to run more tests to find winners.

Tip #2: Present the Information as Simply as You Can

Not everyone can read graphs easily. Even if they can, it still means that it takes effort to understand the context of what they are seeing.

The more effort it takes to understand something, the more frustrating it can be and can cause you to lose the other person's attention.

(Top tip for landing pages btw ^^)

Break it down nice and simple by using the slides from your learning repository.

It should already include:

- Czego nauczyłeś się wcześniej i jak wpadłeś na pomysł testu.

- Co testowałeś. Pokaż kontrolę, wariacje i zwycięzcę.

- Jak to działało na poziomie mikro i makro. Dołącz wyniki.

Finally, add any insights you drew from tests to decide on your next important action to take. (Improve execution, test new variations, new hypothesis, etc.)

Providing insight into what happened is HUGE.

Twój szef bardziej dba o to, czego się nauczyłeś, niż o wyniki, ponieważ można na tym zareagować. Dzielenie się tym i dawanie pomysłów, co dalej, pomoże im zobaczyć, że kontrolujesz sytuację i pomoże im czuć się pewnie w dalszych testach.

Porada 3: Spraw, aby wyglądały dobrze

Pójdź o krok dalej i dodaj dane, na których im zależy:

- Jeśli test się nie powiódł, wyjaśnij, dlaczego uważasz, że się nie powiódł . Dodaj zwrot z inwestycji zaoszczędzony dzięki niewdrożeniu nieudanego testu i jego wpływ na MRR i ARR.

- Jeśli wygra, daj wgląd w osiągnięty ROI i jego wpływ na roczne przychody / MRR i ARR , a także wszelkie możliwości dalszego skalowania i uzyskania większego wzrostu ROI. (tj. mogłeś przetestować stronę przechwytywania potencjalnych klientów i zauważyłeś wzrost podczas poprawiania układu. Możesz mieć 30 innych podobnych stron, na których możesz zastosować ten test, aby zobaczyć potencjalny wzrost).

- Jeśli test był płaski, podziel się spostrzeżeniami na temat tego, co Twoim zdaniem się wydarzyło i co dalej. (Lepsza realizacja, nowy wariant, całkowita zmiana lub lepiej dopasowany test itp.)

Oczywiście, wpływ ARR + MRR lub rok do roku jest przybliżonym szacunkiem, ale pokazuje potencjalny wpływ i wartość twoich testów. To jest to, na czym zależy Twojemu szefowi i o czym prawdopodobnie myśli, gdy zobaczy Twoje wyniki.

Zaufaj mi, kiedy przedstawisz swoje informacje w ten sposób, zauważysz, że przechodzi to znacznie łatwiej. Zamiast określać test jako „stracone pieniądze” lub stratę czasu, zamiast tego skupiasz się na potencjalnych oszczędnościach, rzeczywistych zarobkach i potencjalnym dalszym wzroście.

Nie tylko to, ale będziesz także w stanie udowodnić swoją wartość w przeprowadzaniu jeszcze większej liczby testów, dojrzewaniu wysiłków CRO i zwiększaniu szybkości testu.

Wniosek

Masz to.

Do tej pory powinieneś czuć się znacznie pewniej, jak analizować i uczyć się na podstawie wyników testów A/B i być w stanie przedstawić te informacje swojemu szefowi lub komukolwiek innemu, niezależnie od tego, jak wykonane zostały twoje testy.

Po prostu postępuj zgodnie z tym przewodnikiem, aby usprawnić analizę potestową każdego nowego testu A/B, który przeprowadzasz!