Jak głębokie uczenie się zmienia opiekę zdrowotną, część 1: Diagnoza

Opublikowany: 2022-05-07Sztuczna inteligencja może wywrzeć głęboki i trwały wpływ na opiekę zdrowotną, kierując się trzema potężnymi trendami:

1. Procesory graficzne (GPU) stają się coraz szybsze i bardziej energooszczędne.

Do niedawna uruchamianie algorytmów AI rzadko było opłacalne.

2. Algorytmy stają się coraz bardziej wyrafinowane.

Ponieważ możemy teraz korzystać z modeli głębokiego uczenia się za ułamek dotychczasowych kosztów, innowacyjność eksploduje.

3. Mnóstwo danych dotyczących opieki zdrowotnej.

Dzięki EHR i innym wysiłkom w zakresie cyfryzacji mamy więcej danych dotyczących opieki zdrowotnej do wykorzystania do uczenia algorytmów niż kiedykolwiek wcześniej.

Według CB Insights kilka lat temu mniej niż dwa tuziny start-upów AI koncentrowały się na opiece zdrowotnej. Obecnie istnieje ponad 100 startupów AI związanych z opieką zdrowotną.

To sprawiło, że wielu lekarzy drapało się po głowach, jak mogą przygotować się na to, co nadejdzie jutro, już dziś. Oto sposoby, w jakie uczenie głębokie zmienia obecnie opiekę zdrowotną, oraz wskazówka dotycząca kupowania odpowiedniego sprzętu, aby przygotować się na nadchodzącą rewolucję sztucznej inteligencji.

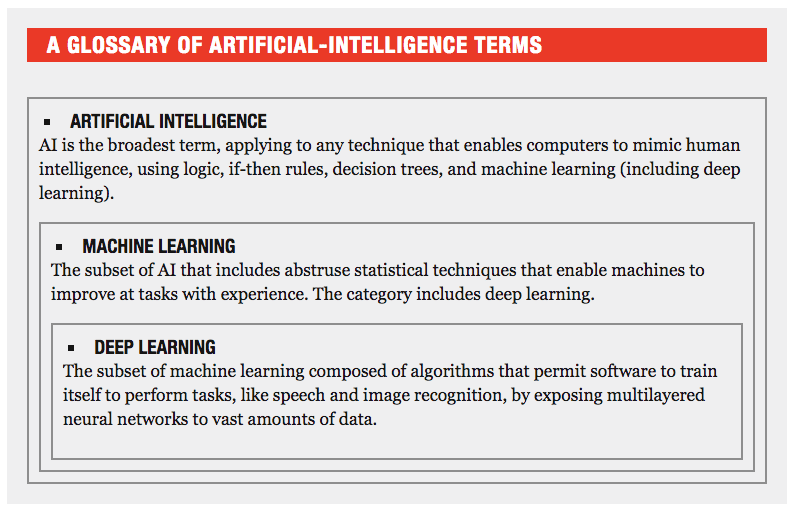

Przegląd terminologii

Słowniczek terminów AI (poprzez Fortune)

Szybsza, dokładniejsza diagnostyka dzięki głębokiemu uczeniu

Kiedy się nad tym zastanowić, diagnozowanie chorób to idealne zadanie dla sztucznej inteligencji. Głębokie uczenie polega na identyfikowaniu wzorców poprzez łączenie kropek.

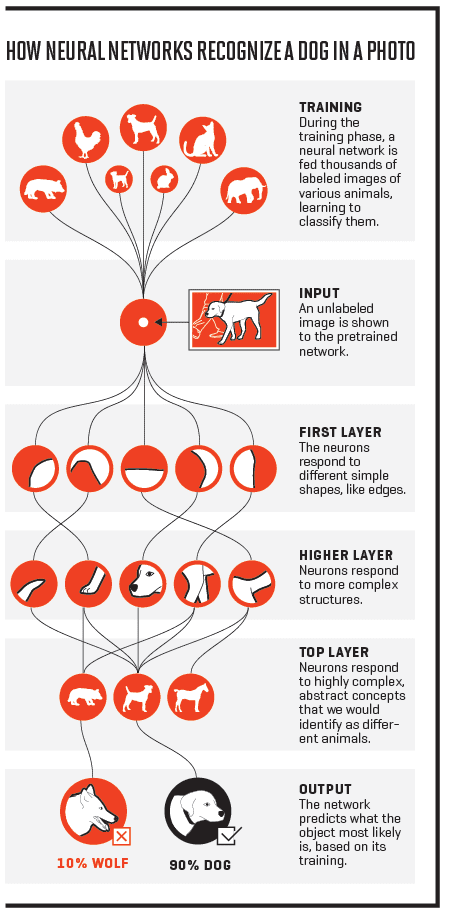

Rozważ psa. Składniki: włochaty, dwoje oczu, cztery nogi, ogon. Mniejszy niż człowiek, większy niż kot. Algorytm głębokiego uczenia „uczy się” — przez wiele cykli wprowadzania danych, analizy i testowania — czym jest każdy z nich, a następnie może zidentyfikować psa na podstawie jego części składowych.

W przypadku choroby kropkami są objawy i związane z nimi zaburzenia. Kaszel, kichanie, ból gardła: musi być przeziębienie.

Algorytmy głębokiego uczenia stają się lepsze w diagnozowaniu w taki sam sposób, jak robią to lekarze: z praktyką. Podobnie jak lekarz, algorytm zgaduje i dowiaduje się, czy był poprawny, czy nie, na podstawie tego, czy pacjent zareaguje na leczenie, czy też pojawią się nowe objawy wskazujące, że początkowa diagnoza była nieprawidłowa. Informacje te są wprowadzane do algorytmu za pośrednictwem danych EHR.

Jak uczy się głęboka sieć neuronowa (poprzez Fortune)

Jedną z ważnych różnic między lekarzem a algorytmem głębokiego uczenia się jest to, że lekarz musi spać. Po nauczeniu algorytmu może on działać (i poprawiać) w sposób ciągły.

Lekarz zobaczy i będzie uczyć się na podstawie tysięcy obrazów MRI w ciągu swojego życia. Algorytm mógłby zobaczyć biliony. Jak wszyscy ludzie, lekarze są podatni na błędy. Dzięki sztucznej inteligencji nie ma ryzyka choroby, zmęczenia lub zaabsorbowania. Nie będzie praktykował medycyny obronnej ani nie utknie na swoich drogach.

Jak to wygląda w praktyce?

Uczenie maszynowe może już określić, czy zmiany skórne są rakowe, tak dokładnie, jak dermatolog posiadający certyfikat zarządu, co wykazali naukowcy z Uniwersytetu Stanforda na początku tego roku.

Kiedy współlokator Hossama Haicka z college'u zdiagnozowano białaczkę, zainspirował go do stworzenia czujnika do leczenia raka. „Ale potem zdałem sobie sprawę, że wczesna diagnoza może być równie ważna jak samo leczenie” – powiedział Haick dla New York Times. Zbudował więc maszynę, która wykorzystuje sztuczną inteligencję, aby dowiedzieć się, jak pachną różne choroby. Z każdym powąchaniem algorytm staje się dokładniejszy. Do grudnia ubiegłego roku był w stanie zidentyfikować 17 różnych chorób z dokładnością do 86%.

Enlitic wykorzystuje głębokie uczenie do wykrywania guzków w płucach na radiogramach oraz skanach CT i MRI i określania, czy są one łagodne, czy złośliwe. Dyrektor generalny Igor Barani, były profesor radiologów onkologicznych na Uniwersytecie Kalifornijskim w San Francisco, twierdzi, że algorytmy Enlitic przewyższają w testach czterech radiologów. Barani powiedział Medical Futurist:

„Do niedawna diagnostyczne programy komputerowe były pisane przy użyciu szeregu predefiniowanych założeń dotyczących cech charakterystycznych dla choroby. Należało zaprojektować specjalistyczny program dla każdej części ciała i tylko ograniczony zestaw chorób mógł zostać zidentyfikowany, co uniemożliwiało ich elastyczność i skalowalność. Programy te często nadmiernie upraszczały rzeczywistość, co skutkuje słabą wydajnością diagnostyczną, przez co nigdy nie osiągnęły powszechnego zastosowania klinicznego. W przeciwieństwie do tego, uczenie głębokie może z łatwością poradzić sobie z szerokim spektrum chorób całego ciała i wszystkimi metodami obrazowania (prześwietlenia, tomografia komputerowa itp.).”

Freenome wykorzystuje głębokie uczenie, aby znaleźć raka w próbkach krwi, a dokładniej fragmentów DNA, które komórki krwi emitują podczas śmierci. Firma venture capital Andreessen Horowitz wysłała firmie pięć próbek krwi do analizy w ramach testu przedinwestycyjnego. Firma przystąpiła do inwestycji po tym, jak Freenome poprawnie zidentyfikował wszystkie pięć – dwa normalne i trzy rakowe. Założyciel, Gabriel Otte, powiedział Fortune, że jego algorytm głębokiego uczenia wykrywa sygnatury raka, których biolodzy zajmujący się nowotworami jeszcze nie scharakteryzowali.

W maju założyciel i dyrektor generalny Babylon Health, Ali Parsa, powiedział w internetowym programie technologicznym „Hot Topics”, że jego zespół niedawno poddał pierwszy na świecie system segregacji klinicznej oparty na sztucznej inteligencji do testów akademickich, podczas których jego system okazał się o 13% dokładniejszy niż lekarz i 17% dokładniejszy niż pielęgniarka.

Jak realistyczne jest wdrożenie?

Podczas gdy uczenie maszynowe szybko staje się lepszym sposobem diagnozowania chorób, dopiero niedawno stało się bardziej wykonalne w powszechnym użyciu. Do tej pory wdrożenie w jakikolwiek powszechny sposób było po prostu zbyt drogie.

Dzięki nowszym procesorom, które działają szybciej niż kiedykolwiek, a jednocześnie wymagają mniej energii, uczenie maszynowe rozwija się w szybkim i bardziej przystępnym tempie.

Jak zauważa Para w powyższym filmie, dziesięć lat temu spojrzenie na każdą część ciała w celu znalezienia i zdiagnozowania choroby kosztowało milion dolarów. Obecnie koszt ten spadł do 10 000 USD i obejmuje sekwencjonowanie genów.

Jedna z firm zajmujących się obrazowaniem medycznym uzyskała zgodę FDA na sprzedaż lekarzom oprogramowania opartego na sztucznej inteligencji. W styczniu firma Arterys uzyskała zielone światło dla swojego „DeepVentricle”, algorytmu głębokiego uczenia, który może obliczyć pojemność serca pacjenta tak dokładnie, jak lekarz w mniej niż 30 sekund. Z kolei ręczne przeanalizowanie obrazów MRI w celu wykonania obliczeń zajmuje około godziny.

Inżynier biomedyczny i profesor Cristina Davis przewiduje, że w ciągu trzech do pięciu lat lekarze uzyskają dostęp do algorytmów głębokiego uczenia, które pomogą w diagnozie.

Przygotuj się na głębokie uczenie z odpowiednim sprzętem

Duża część wzrostu mocy obliczeniowej od późnych lat 2000 jest spowodowana układami zaprojektowanymi przez Nvidię w celu zwiększenia realizmu wizualnego gier wideo. Wykorzystanie procesorów graficznych (GPU) do głębokiego uczenia okazało się od 20 do 50 razy wydajniejsze niż korzystanie z jednostek centralnych (CPU).

W sierpniu 2016 r. Nvidia ogłosiła, że jej kwartalne przychody w segmencie centrów danych wzrosły ponad dwukrotnie rok do roku, osiągając 151 mln USD. Dyrektor finansowy Colette Kress powiedział inwestorom, że „Zdecydowana większość wzrostu pochodzi z głębokiego uczenia się”.

W 2016 r. firma Intel kupiła startupy zajmujące się głębokim uczeniem, Nervana Systems i Movidius, podczas gdy Google zaprezentował jednostki przetwarzania tensorów (TPU) zaprojektowane specjalnie w celu ułatwienia uczenia głębokiego.

Dziś Nvidia celuje w branżę medyczną. Kierownik ds. rozwoju biznesowego firmy, Kimberley Powell, chce, aby procesory Nvidii były wykorzystywane w celu zaspokojenia potrzeby analizy głębokiego uczenia obrazowania medycznego.

Futurism donosi, że „Sprzęt Nvidii odegrał swoją cichą, ale znaczącą rolę w mariażu głębokiego uczenia się z medycyną”. Firma buduje potężne komputery zaprojektowane do szybkiego i wydajnego wykonywania obliczeń, które mogą sprawić, że diagnoza będzie szybsza i dokładniejsza. Powell ma nadzieję, że urządzenie Nvidia DGX-1 zostanie zainstalowane w szpitalach i ośrodkach badań medycznych na całym świecie.

Niektóre szpitale — takie jak nowe centrum badań danych klinicznych w Massachusetts General Hospital — już używają tego nowego sprzętu do celów zdrowotnych populacji, porównując wyniki badań pacjentów i historię medyczną, aby zidentyfikować korelacje w danych.

Wniosek

Głębokie sieci neuronowe zmieniają sposób, w jaki lekarze diagnozują choroby, czyniąc diagnostykę szybszą, tańszą i dokładniejszą niż kiedykolwiek wcześniej. Skorzystanie z tych postępów wymaga wykonania pewnych czynności przygotowawczych, takich jak modernizacja sprzętu.

Kiedy będziesz gotowy do aktualizacji, zainwestuj w systemy, które sprostają wymaganiom obliczeniowym głębokiego uczenia i zdrowia populacji.

W przyszłym tygodniu omówimy inny sposób, w jaki uczenie głębokie zmienia opiekę zdrowotną: zapobieganie chorobom. Porozmawiamy również o oprogramowaniu do zarządzania praktyką medyczną i EHR, którego będziesz potrzebować, aby zacząć korzystać z głębokiego uczenia się w swojej praktyce.

Aby dowiedzieć się więcej o sztucznej inteligencji i opiece zdrowotnej, sprawdź te posty:

- Co to jest medycyna precyzyjna? Proste wprowadzenie dla zdezorientowanych lekarzy

- 5 start-upów AI w służbie zdrowia dla małych i średnich firm

- 5 sposobów, w jakie sztuczna inteligencja wpływa na telezdrowie