Nigdzie nie ma do ukrycia: blokowanie treści od pająków wyszukiwarek

Opublikowany: 2022-06-12TL; DR

- Jeśli zastanawiasz się nad wykluczeniem treści z wyszukiwarek, najpierw upewnij się, że robisz to z właściwych powodów.

- Nie popełnij błędu, zakładając, że możesz ukryć treść w języku lub formacie, którego boty nie zrozumieją; to krótkowzroczna strategia. Bądź z nimi na bieżąco, używając pliku robots.txt lub tagu Meta Robots.

- Nie zapominaj, że tylko dlatego, że używasz zalecanych metod blokowania treści, jesteś bezpieczny. Dowiedz się, w jaki sposób blokowanie treści spowoduje, że Twoja witryna będzie wyświetlana botom.

Kiedy i jak wykluczyć treść z indeksu wyszukiwarki

Głównym aspektem SEO jest przekonanie wyszukiwarek, że Twoja witryna ma dobrą reputację i zapewnia prawdziwą wartość dla osób wyszukujących. Aby wyszukiwarki mogły określić wartość i trafność Twoich treści, muszą postawić się w sytuacji użytkownika.

Teraz oprogramowanie, które przegląda Twoją witrynę, ma pewne ograniczenia, które SEO tradycyjnie wykorzystywali do ukrywania niektórych zasobów przed wyszukiwarkami. Jednak boty wciąż się rozwijają i stale stają się coraz bardziej wyrafinowane w swoich wysiłkach, aby zobaczyć Twoją stronę internetową tak, jak człowiek w przeglądarce. Czas ponownie sprawdzić zawartość witryny, która jest niedostępna dla robotów wyszukiwarek, a także powody, dla których jest ona niedostępna. Nadal istnieją ograniczenia dotyczące botów, a webmasterzy mają uzasadnione powody do blokowania lub uzewnętrzniania niektórych treści. Ponieważ wyszukiwarki szukają witryn, które zapewniają użytkownikom wysokiej jakości treści, pozwól, aby doświadczenie użytkownika pokierowało Twoimi projektami, a reszta się ułoży.

Po co w ogóle blokować treści?

- Treści prywatne. Zaindeksowanie stron oznacza, że są one dostępne do wyświetlania w wynikach wyszukiwania, a zatem są widoczne publicznie. Jeśli masz strony prywatne (informacje o kontach klientów, dane kontaktowe osób prywatnych itp.), nie chcesz ich umieszczać w indeksie. (Niektóre witryny typu whois wyświetlają informacje o abonentach w JavaScript, aby uniemożliwić robotom skrobakowym kradzież danych osobowych).

- Zduplikowana treść. Niezależnie od tego, czy są to fragmenty tekstu (informacje o znakach towarowych, slogany lub opisy), czy całe strony (np. niestandardowe wyniki wyszukiwania w Twojej witrynie), jeśli masz treść wyświetlaną pod kilkoma adresami URL w Twojej witrynie, roboty wyszukiwarek mogą uznać to za niską jakość . Możesz użyć jednej z dostępnych opcji, aby zablokować indeksowanie tych stron (lub poszczególnych zasobów na stronie). Możesz sprawić, by były widoczne dla użytkowników, ale zablokowane w wynikach wyszukiwania, co nie zaszkodzi Twoim rankingom treści, które chcesz wyświetlać w wynikach wyszukiwania.

- Treści z innych źródeł. Treść, taka jak reklamy, które są generowane przez źródła zewnętrzne i powielane w kilku miejscach w sieci, nie są częścią podstawowej treści strony. Jeśli ta treść reklamy jest wielokrotnie powielana w całej sieci, webmaster może chcieć uniemożliwić wyświetlanie reklam jako części strony.

Który dba o dlaczego, jak o jak?

Tak się cieszę, że zapytałeś. Jedną z metod, która została użyta do utrzymania zawartości poza indeksem, jest załadowanie zawartości z zablokowanego źródła zewnętrznego przy użyciu języka, którego boty nie mogą przeanalizować ani wykonać; To tak, jak przeliterujesz słowa innej osobie dorosłej, ponieważ nie chcesz, aby maluch w pokoju wiedział, o czym mówisz. Problem w tym, że maluch w tej sytuacji staje się coraz mądrzejszy. Przez długi czas, jeśli chciałeś coś ukryć przed wyszukiwarkami, mogłeś użyć JavaScript do załadowania tej treści, co oznaczało, że użytkownicy to rozumieją, boty nie.

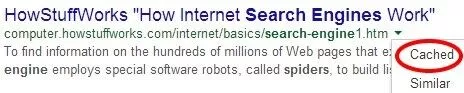

Ale Google wcale nie jest nieśmiały, jeśli chodzi o chęć parsowania JavaScriptu z botami. I zaczynają to robić; narzędzie Pobierz jako Google w Narzędziach dla webmasterów umożliwia wyświetlanie poszczególnych stron tak, jak widzą je boty Google.

Jeśli używasz JavaScript do blokowania treści w swojej witrynie, powinieneś sprawdzić niektóre strony w tym narzędziu; są szanse, Google to widzi.

Pamiętaj jednak, że tylko dlatego, że Google może renderować zawartość w JavaScript, nie oznacza, że zawartość jest buforowana. Narzędzie „Pobierz i zrenderuj” pokazuje, co bot może zobaczyć; aby dowiedzieć się, co jest indeksowane, powinieneś sprawdzić wersję strony w pamięci podręcznej.

Istnieje wiele innych metod uzewnętrzniania treści, o których ludzie dyskutują: iframe, AJAX, jQuery. Ale już w 2012 roku eksperymenty pokazywały, że Google może indeksować linki umieszczone w ramkach iframe; więc idzie ta technika. W rzeczywistości dni mówienia w języku, którego boty nie potrafiły zrozumieć, dobiegają końca.

Ale co, jeśli grzecznie poprosisz roboty, aby nie patrzyły na pewne rzeczy? Blokowanie lub blokowanie elementów w pliku robots.txt lub tagu Meta Robots to jedyny pewny sposób (bez katalogów serwerów chroniących hasłem) zapobiegania indeksowaniu elementów lub stron.

John Mueller niedawno skomentował, że treść generowana za pomocą kanałów AJAX/JSON byłaby „niewidoczna dla [Google], gdyby zabroniono indeksowania kodu JavaScript”. Dalej wyjaśnia, że samo zablokowanie CSS lub JavaScript niekoniecznie zaszkodzi twojemu rankingowi: „Zdecydowanie nie ma prostego„CSS lub JavaScript jest zabronione do indeksowania, dlatego algorytmy jakości postrzegają witrynę negatywnie”. Dlatego najlepszym sposobem na utrzymanie treści poza indeksem jest po prostu poproszenie wyszukiwarek, aby nie indeksowały treści. Mogą to być pojedyncze adresy URL, katalogi lub pliki zewnętrzne.

To sprowadza nas więc z powrotem do początku: dlaczego. Przed podjęciem decyzji o zablokowaniu jakichkolwiek treści upewnij się, że wiesz, dlaczego to robisz, a także ryzyko. Po pierwsze, blokowanie plików CSS lub JavaScript (zwłaszcza tych, które znacząco wpływają na układ witryny) jest ryzykowne; może między innymi uniemożliwić wyszukiwarkom sprawdzenie, czy Twoje strony są zoptymalizowane pod kątem urządzeń mobilnych. Nie tylko to, ale po wdrożeniu Pandy 4.0 niektóre witryny, które mocno ucierpiały, były w stanie odzyskać siły, odblokowując swoje CSS i JavaScript, co wskazywałoby, że były one specjalnie celem algorytmu Google do blokowania tych elementów przed botami.

Jeszcze jedno ryzyko, które podejmujesz podczas blokowania treści: roboty-pająki wyszukiwarek mogą nie być w stanie zobaczyć, co jest blokowane, ale wiedzą, że coś jest blokowane, więc mogą być zmuszone do przyjęcia założeń dotyczących treści. Wiedzą, że na przykład reklamy są często ukryte w elementach iframe, a nawet w CSS; więc jeśli masz zbyt dużo zablokowanych treści w górnej części strony, ryzykujesz trafieniem przez algorytm układu strony „Top Heavy”. Każdy czytający to webmaster, który rozważa użycie ramek iframe, powinien najpierw rozważyć konsultację z renomowanym SEO. (Wstaw bezwstydną promocję BCI tutaj.)