Jak radzić sobie z paczkowaniem botów i walką pająków o rankingi?

Opublikowany: 2020-01-23

Roboty indeksujące Google indeksują każdy element treści, który publikujesz w swojej witrynie. Te roboty to zaprogramowane oprogramowanie, które podąża za linkami i kodami i dostarcza je do algorytmu. Następnie algorytm indeksuje je i dodaje Twoje treści do ogromnej bazy danych. W ten sposób za każdym razem, gdy użytkownik szuka słowa kluczowego, wyszukiwarka wyodrębnia i klasyfikuje powiązane wyniki z bazy danych już zaindeksowanych stron.

Google przypisuje budżet indeksowania do każdej witryny, a roboty indeksujące odpowiednio wykonują indeksowanie Twojej witryny. Musisz zarządzać budżetem indeksowania i wykorzystywać go, aby zapewnić inteligentne przeszukiwanie i indeksowanie całej witryny.

W tym poście możesz dowiedzieć się o sztuczkach i narzędziach, jak radzić sobie z tym, w jaki sposób boty/pająki lub roboty indeksujące wyszukiwarki indeksują i indeksują Twoją witrynę.

1. Optymalizacja dyrektywy Disallow dla Robot.txt:

Robots.txt to plik tekstowy o ścisłej składni, który działa jak przewodnik dla robotów-pająków określający sposób indeksowania witryny. Plik robots.txt jest zapisywany w repozytoriach hostów Twojej witryny, z których roboty wyszukują adresy URL. Aby zoptymalizować ten plik Robots.txt lub „Protokół wykluczania robotów”, możesz użyć kilku sztuczek, które mogą pomóc w indeksowaniu adresów URL Twojej witryny przez roboty Google w celu uzyskania wyższych pozycji w rankingu.

Jedną z tych sztuczek jest użycie „dyrektywy zakazującej” , to jest jak umieszczenie szyldu „Obszar zastrzeżony” w określonych sekcjach witryny. Aby zoptymalizować dyrektywę Disallow, musisz zrozumieć pierwszą linię obrony: „Agenty użytkownika”.

Co to jest dyrektywa dotycząca klienta użytkownika?

Każdy plik Robots.txt składa się z co najmniej jednej reguły, a spośród nich najważniejsza jest reguła klienta użytkownika. Ta reguła zapewnia robotom dostęp i brak dostępu do określonej listy w witrynie.

Tak więc dyrektywa klienta użytkownika jest używana do zwracania się do konkretnego robota indeksującego i przekazywania mu instrukcji, jak wykonać indeksowanie.

Typy najczęściej używanych robotów Google:

Nie zezwalaj na dyrektywę:

Teraz, po zapoznaniu się z botem, który jest przypisany do indeksowania Twojej witryny, możesz zoptymalizować jej różne sekcje w zależności od typu klienta użytkownika. Oto kilka podstawowych sztuczek i przykładów, które można zastosować, aby zoptymalizować dyrektywę zakazu w witrynie:

- Użyj pełnej nazwy strony, która może być wyświetlana w przeglądarce, aby można było używać jej w dyrektywie disallow.

- Jeśli chcesz przekierować robota indeksującego ze ścieżki katalogu, użyj znaku „/”.

- Użyj * dla prefiksu ścieżki, sufiksu lub całego ciągu.

Przykłady użycia dyrektyw disallow to:

# Przykład 1: Blokuj tylko Googlebota

Klient użytkownika: Googlebot

Uniemożliwić: /

# Przykład 2: Zablokuj Googlebota i Adsbota

Klient użytkownika: Googlebot

Klient użytkownika: AdsBot-Google

Uniemożliwić: /

# Przykład 3: Blokuj wszystkie roboty oprócz robotów AdsBot

Agent użytkownika: *

Uniemożliwić: /

2. Dyrektywa bez indeksu dla pliku Robots.txt:

Gdy inne witryny prowadzą do Twojej witryny, istnieje prawdopodobieństwo, że adres URL, którego indeksowanie nie ma być indeksowane przez robota indeksującego, może zostać ujawniony. Aby rozwiązać ten problem, możesz użyć dyrektywy bez indeksu. Zobaczmy, jak możemy zastosować dyrektywę non-index do pliku Robots.txt:

Istnieją dwie metody zastosowania dyrektywy bez indeksu w witrynie:

<Meta> Tagi:

Metatagi to fragmenty tekstu opisujące zawartość Twojej strony w krótki, przejrzysty sposób, który pozwala odwiedzającym wiedzieć, co ma nadejść? Możemy użyć tego samego, aby uniknąć indeksowania strony przez roboty.

Najpierw umieść metatag „<meta name= „robots” content=”noindex”>” w sekcji „<head>” swojej strony, której roboty indeksujące nie mają indeksować.

W przypadku robotów Google możesz użyć „<meta name=”googlebot” content=”noindex”/>” w sekcji „<head>”.

Ponieważ różne roboty wyszukiwarek szukają Twoich stron, mogą różnie interpretować dyrektywę niebędącą indeksem. Z tego powodu Twoje strony mogą pojawiać się w wynikach wyszukiwania.

Pomogłoby więc zdefiniowanie dyrektyw dla stron zgodnie z robotami lub agentami użytkownika.

Aby zastosować dyrektywę do różnych robotów, możesz użyć następujących metatagów:

<nazwa meta=”googlebot” content=”noindex”>

<meta name=”googlebot-news” content=”nosnippet”>

Znacznik X-Robotów:

Wszyscy wiemy o nagłówkach HTTP, które są używane jako odpowiedź na żądanie klienta lub wyszukiwarki dodatkowych informacji związanych z Twoimi stronami internetowymi, takich jak lokalizacja lub serwer, który je udostępnia. Teraz, aby zoptymalizować te odpowiedzi nagłówka HTTP pod kątem dyrektywy bez indeksu, możesz dodać tagi X-Robots jako element odpowiedzi nagłówka HTTP dla dowolnego adresu URL Twojej witryny.

Możesz łączyć różne tagi X-Robots z odpowiedziami nagłówka HTTP. Możesz podać różne dyrektywy na liście oddzielonej przecinkiem. Poniżej znajduje się przykład odpowiedzi nagłówka HTTP z różnymi dyrektywami w połączeniu z tagami X-Robots.

HTTP/1.1 200 OK

Data: wt., 25.01.2020 21:42:43 GMT

(…)

X-Robots-Tag: noarchive

X-Robots-Tag: niedostępny_po: 25 lipca 2020 15:00:00 PST

(…)

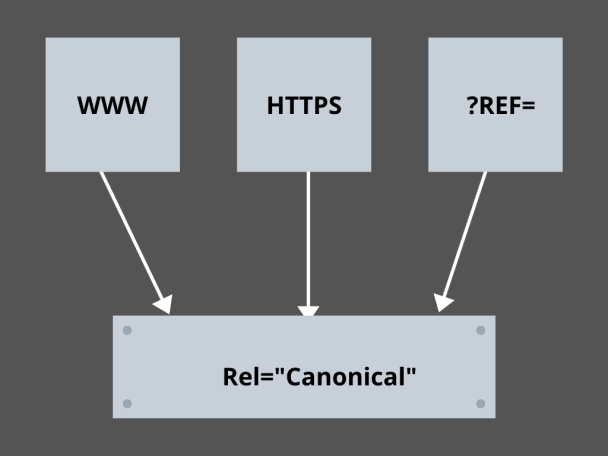

3. Opanowanie linków kanonicznych:

Jaki jest obecnie najbardziej przerażający czynnik w SEO? Rankingi? Ruch drogowy? Nie! To strach, że wyszukiwarki będą karać Twoją witrynę za zduplikowane treści. Tak więc, gdy planujesz swój budżet indeksowania, musisz uważać, aby nie ujawnić duplikatów treści.

Tutaj opanowanie linków kanonicznych pomoże Ci poradzić sobie ze zduplikowanymi problemami z treścią. Słowo zduplikowana treść nie jest tym, co oznacza. Weźmy przykład dwóch stron witryny e-commerce:

Na przykład masz witrynę e-commerce z parą identycznych stron dla smartwatcha i obie mają podobną zawartość. Gdy roboty wyszukiwarek indeksują Twój adres URL, sprawdzają, czy nie ma duplikatów treści, i mogą wybrać dowolny z adresów URL. Aby przekierować je do adresu URL, który jest dla Ciebie niezbędny, można ustawić link kanoniczny dla stron. Zobaczmy, jak możesz to zrobić:

- Wybierz jedną stronę z dwóch stron dla swojej wersji kanonicznej.

- Wybierz ten, który przyjmuje więcej odwiedzających.

- Teraz dodaj rel=”canonical” do swojej strony niekanonicznej.

- Przekieruj link do strony niekanonicznej na stronę kanoniczną.

- Spowoduje połączenie obu linków do stron w jeden link kanoniczny.

4. Strukturyzacja Serwisu:

Roboty indeksujące potrzebują znaczników i szyldów, które pomogą im odkryć ważne adresy URL Twojej witryny, a jeśli nie ustrukturyzujesz witryny, roboty indeksujące będą miały trudności z indeksowaniem Twoich adresów URL. W tym celu używamy map witryn, ponieważ zapewniają one robotom indeksującym linki do wszystkich ważnych stron Twojej witryny.

Standardowe formaty map witryn dla witryn internetowych, a nawet aplikacji opracowanych w procesach tworzenia aplikacji mobilnych to mapy witryn XML, Atom i RSS. Aby zoptymalizować indeksowanie, musisz połączyć mapy witryn XML i kanały RSS/Atom.

- Ponieważ mapy witryn XML zapewniają robotom indeksującym wskazówki do wszystkich stron w Twojej witrynie lub aplikacji.

- Kanał RSS/Atom zapewnia aktualizacje na Twoich stronach witryny dla robotów indeksujących.

- Ponieważ mapy witryn XML zapewniają robotom indeksującym wskazówki do wszystkich stron w Twojej witrynie lub aplikacji.

5. Nawigacje po stronach:

Nawigacja na stronie jest niezbędna dla pająków, a nawet dla odwiedzających Twoją witrynę. Te buty wyszukują strony w Twojej witrynie, a wstępnie zdefiniowana struktura hierarchiczna może pomóc robotom indeksującym znaleźć strony, które są ważne dla Twojej witryny. Inne kroki, które należy wykonać, aby uzyskać lepszą nawigację po stronie, to:

- Zachowaj kodowanie w HTML lub CSS.

- Hierarchicznie uporządkuj swoje strony.

- Użyj płytkiej struktury witryny, aby lepiej nawigować po stronie.

- Utrzymuj menu i karty w nagłówku, aby były minimalne i konkretne.

- Pomoże to ułatwić nawigację po stronie.

6. Unikanie pułapek na pająki:

Pułapki pająków to nieskończone adresy URL wskazujące tę samą treść na tych samych stronach, gdy roboty indeksują Twoją witrynę. To bardziej przypomina strzelanie ślepakami. Ostatecznie pochłonie to twój budżet indeksowania. Ten problem nasila się z każdym indeksowaniem, a Twoja witryna ma zduplikowaną treść, ponieważ każdy adres URL, który jest indeksowany w pułapce, nie będzie unikalny.

Pułapkę można przełamać, blokując sekcję w pliku Robots.txt lub użyć jednej z dyrektyw follow lub no follow , aby zablokować określone strony. Na koniec możesz rozwiązać problem technicznie, zatrzymując występowanie nieskończonych adresów URL.

7. Struktura łączenia:

Interlinking jest jednym z podstawowych elementów optymalizacji indeksowania. Roboty indeksujące mogą lepiej znajdować Twoje strony dzięki dobrze ustrukturyzowanym linkom w Twojej witrynie. Niektóre z kluczowych sztuczek do świetnej struktury linkowania to:

- Korzystanie z linków tekstowych, ponieważ wyszukiwarki łatwo je indeksują: <a href=”new-page.html”>link tekstowy</a>

- Używanie opisowego tekstu kotwicy w linkach

- Załóżmy, że prowadzisz witrynę siłowni i chcesz połączyć wszystkie filmy z siłowni, możesz użyć takiego linku. Zachęcamy do przeglądania wszystkich naszych <a href=”videos.html”>filmów z siłowni</a>.

8. Błogość HTML:

Czyszczenie dokumentów HTML i utrzymywanie minimalnego rozmiaru ładunku dokumentów HTML jest ważne, ponieważ umożliwia robotom indeksującym szybkie indeksowanie adresów URL. Kolejną zaletą optymalizacji HTML jest to, że serwer jest mocno obciążony z powodu kilku indeksowań przez wyszukiwarki, co może spowolnić ładowanie strony, co nie jest dobrym znakiem dla SEO lub indeksowania wyszukiwarek. Optymalizacja HTML może zmniejszyć obciążenie indeksowania na serwerze, dzięki czemu strona ładuje się szybko. Pomaga również w rozwiązywaniu błędów indeksowania spowodowanych przekroczeniem limitu czasu serwera lub innymi ważnymi problemami.

9. Osadź to proste:

Żadna strona internetowa nie będzie dziś oferować treści bez świetnych obrazów i filmów, które stanowią kopię zapasową treści, ponieważ to właśnie sprawia, że ich treść jest wizualnie bardziej atrakcyjna i dostępna dla robotów wyszukiwarek. Ale jeśli ta osadzona treść nie jest zoptymalizowana, może zmniejszyć prędkość ładowania, odciągając roboty indeksujące od treści, które mogą być w rankingu.

W tym przypadku trzymanie się kodu HTML dla osadzonej treści może pomóc w osiągnięciu lepszego indeksowania z wyszukiwarek. Technologie takie jak AJAX, Javascript itp. są całkiem dobre w dostarczaniu nowych funkcji, ale sprawiają, że indeksowanie wyszukiwarek jest dość trudne.

Wniosek:

Koncentrując się bardziej na SEO i większym ruchu, każdy właściciel witryny szuka lepszych sposobów radzenia sobie z zaganianiem botów i kłótniami z pająkami. Ale rozwiązania leżą w szczegółowych optymalizacjach, które musisz wprowadzić w swojej witrynie i indeksowaniu adresów URL, które mogą sprawić, że indeksowanie w wyszukiwarkach będzie bardziej szczegółowe i zoptymalizowane, aby reprezentować to, co najlepsze w Twojej witrynie, która może uzyskać wyższą pozycję na stronach wyników wyszukiwania.