Statystyki testów A/B: dlaczego statystyki mają znaczenie w eksperymentach

Opublikowany: 2020-11-16

Krótki przewodnik po statystykach i testach A/B: terminy, które musisz znać

Przeprowadzenie rozsądnego eksperymentu A/B bez opanowania statystyk jest prawie niemożliwe.

Chociaż platforma taka jak Convert Experiences może zająć się wszystkimi pomiarami statystycznymi, wnioskowaniem i analizą za Ciebie, podstawowe zrozumienie niektórych pojęć statystycznych z pewnością Ci pomoże.

Zacznijmy od podstaw.

Próbka i populacja

Wykorzystanie całego ruchu w witrynie do testów A/B teoretycznie dałoby ogólne pojęcie o populacji. Może to jednak oznaczać nieoptymalne wykorzystanie zasobów, ponieważ całej populacji nie da się uchwycić. Tutaj przydają się próbki. Chociaż istnieją różne metody doboru próby, zastosowanie podejścia losowego pomaga zapewnić, że nie ma nieodłącznych błędów systematycznych w doborze próby. Podejście to jest inspirowane praktyką farmaceutyczno-medyczną randomizowanych badań kontrolowanych.

Średnia, mediana i tryb

Najprościej rzecz ujmując, średnia oznacza średnią, mediana oznacza wartości znajdujące się pośrodku, gdy wszystkie liczby są wyrównane liniowo (50. percentyl w rozkładzie), a mode jest wartością najczęściej powtarzaną. Te trzy terminy przydają się podczas przeglądania podsumowujących statystyk testu A/B.

Wariancja i odchylenie standardowe

Są to bardzo ważne pojęcia, które mierzą rozproszenie w punktach danych. Innymi słowy, jak daleko dane są od średniej. Odchylenie standardowe to pierwiastek kwadratowy z wariancji. Dlatego odchylenie standardowe lepiej ocenia dyspersję, ponieważ zawiera tę samą jednostkę miary co średnia. Na przykład średni wzrost dorosłego mężczyzny w USA wynosi 70 cali z odchyleniem standardowym wynoszącym 3 cale. Gdybyśmy mieli użyć wariancji w tym przykładzie, wartość wynosiłaby 9 cali do kwadratu, więc jest to mniej intuicyjne. Pomyśl o odchyleniu standardowym jako „zwykłym” odchyleniu danych.

Hipoteza zerowa i alternatywna

A Hipoteza zerowa odwołuje się do status quo. Twoja Hipoteza Zerowa stwierdzałaby, że każda zmiana, którą zaobserwowałeś w danych, na przykład wzrost, jest spowodowana czystą losowością. Hipoteza alternatywna głosi, że zmiana nie jest losowa, ale wskazuje na efekt przyczynowy, co oznacza, że zmiany miały wpływ na użytkowników.

Załóżmy na przykład, że starasz się stworzyć najlepszy nagłówek na swojej stronie docelowej. Masz wariant kontrolny i wariant alternatywny. Przeprowadzasz test A/B i uzyskujesz różne współczynniki konwersji dla obu, więc następuje wzrost (dodatni lub ujemny). Hipoteza zerowa głosiłaby, że różnica wynika z losowości. Hipoteza Alternatywna stwierdzałaby, że zmiana jest związana z pewnym wariantem.

Przeprowadzając test A/B, uzyskasz jeden z następujących czterech wyników:

- Odrzucasz Hipotezę Zerową.

- Nie udaje ci się odrzucić Hipotezy Zerowej.

- Fałszywie odrzucasz Hipotezę Zerową.

- Fałszywie nie odrzucasz Hipotezy Zerowej.

Najlepiej byłoby, gdyby wyniki a i b były tymi, do których należy dążyć, ponieważ są to scenariusze, z których można się czegoś nauczyć. W ten sposób możesz ulepszyć swój produkt i ostatecznie zwiększyć swoje zyski. Wyniki c i d odpowiadają poniższym błędom.

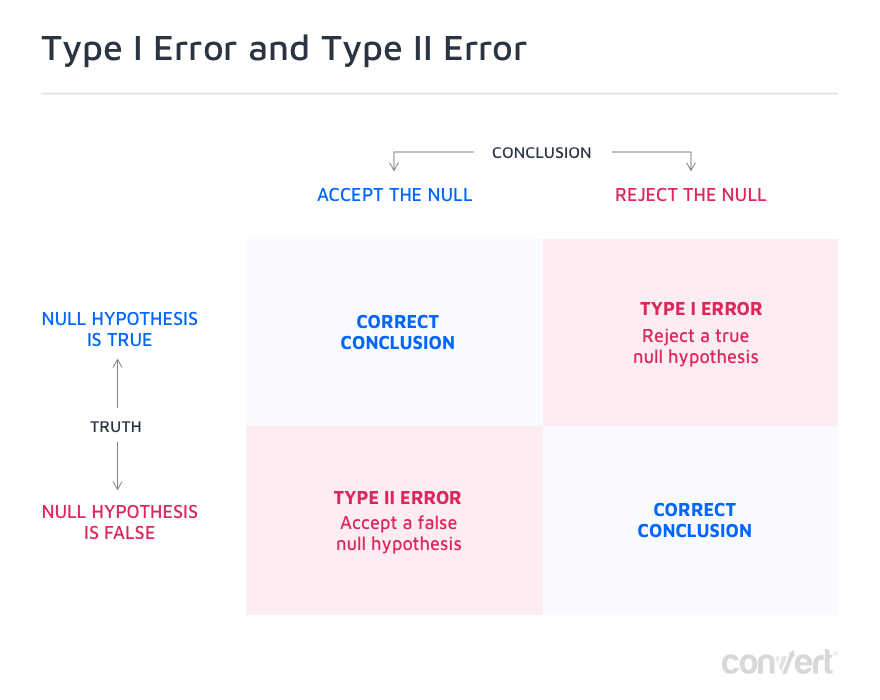

Błędy typu I i typu II

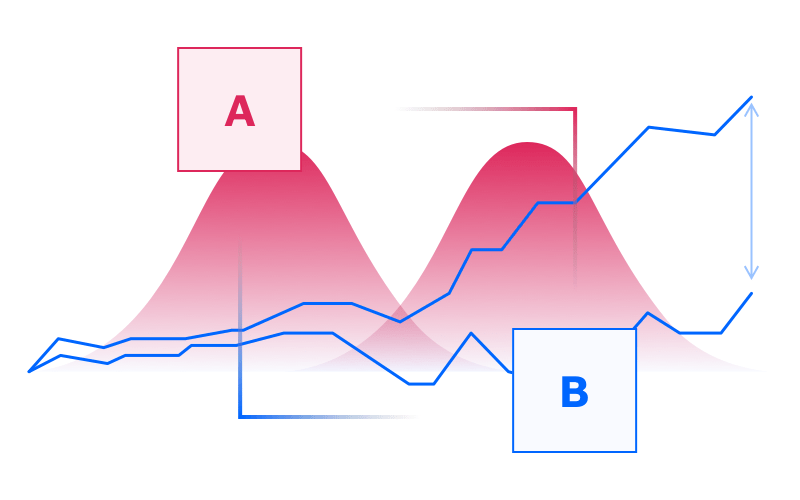

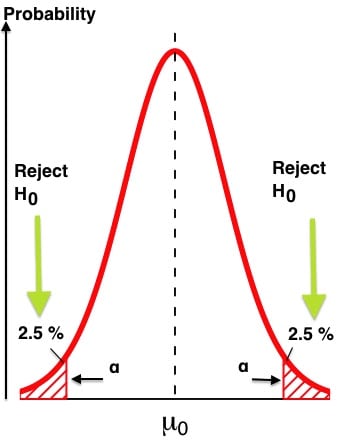

Ostatnie dwie opcje możliwych wyników testu A/B to błędy typu I i typu II, czyli fałszywie pozytywne i fałszywie negatywne.

Błąd typu I występuje wtedy, gdy fałszywie odrzucasz prawdziwą Hipotezę Zerową. Oznacza to, że zmiana, którą zaobserwowałeś, była spowodowana przypadkiem, ale stwierdziłeś inaczej, więc jest to fałszywie pozytywny wynik. W większości przypadków wszystko, co jest wymagane do zmniejszenia liczby fałszywych trafień, to zwiększenie poziomu ufności wymaganego do osiągnięcia istotności statystycznej. Zwykle jest to ustawione na 95%, ale w przypadku eksperymentów o znaczeniu krytycznym możesz chcieć ustawić ją na 99% pewności, co zmniejszy prawdopodobieństwo popełnienia takiego błędu do zaledwie 1%.

Błędy typu II są dokładnym przeciwieństwem. Tutaj nie udaje ci się odrzucić fałszywej hipotezy zerowej. Oznacza to, że był realny wpływ, pozytywny lub negatywny, na współczynnik konwersji, ale nie wydawał się on istotny statystycznie, a Ty błędnie zadeklarowałeś, że był to przypadek losowy. Najczęściej wynika to z braku mocy statystycznej.

W żargonie potęgowym grecka litera α oznacza błędy typu I, a β oznacza błędy typu II. Łatwo pomylić moc statystyczną z istotnością statystyczną.

Ta tabela wyjaśnia:

Statystyczna pewność

Im więcej odwiedzających uzyska Twój test, tym bardziej wzrośnie Twoja Statystyczna pewność siebie, aż osiągnie 99%, jeśli pozwolisz mu działać wystarczająco długo. Ale zazwyczaj, o ile nie jest to krytyczne dla misji, 95% poziom ufności jest uważany za wystarczająco dobry dla większości testów A/B (zapewnia to, że prawdopodobieństwo uzyskania fałszywego wyniku, tj. błędu typu I wynosi co najwyżej 5%).

Moc statystyczna

Moc statystyczna odnosi się do prawdopodobieństwa wykrycia efektu, gdy taki efekt występuje.

Moc statystyczna i Statystyczna pewność siebie to powiązane pojęcia, które współpracują ze sobą, aby zmierzyć ewolucję testu A/B. W idealnym przypadku oba powinny przekroczyć wartości progowe przed zakończeniem testu (więcej na ten temat poniżej).

Przedział ufności i margines błędu

Ogólnie rzecz biorąc, wynik Twojego eksperymentu testowania A/B może wyglądać tak: „Współczynnik konwersji wynosi 3% +/- 1%”. W tym stwierdzeniu „1%” oznacza margines błędu. Krótko mówiąc, jest to odchylenie w wynikach konwersji, które jest uzasadnione, aby wyniki testów były akceptowalne. Im mniejszy margines błędu, tym bardziej wiarygodne stają się wyniki Twoich testów. W miarę zwiększania wielkości próbki zauważysz, że margines błędu maleje.

Jeśli przeprowadzasz testy A/B za pomocą funkcji Konwertuj doświadczenia, uzyskasz dostęp do Raportu doświadczeń, który zawiera szczegółowe informacje o odmianach, współczynniku konwersji, poprawie, pewności i konwersjach dla unikalnych użytkowników miesięcznie . Aby ogłosić zwycięzcę, powinieneś osiągnąć co najmniej 97% pewności siebie. Domyślnie platforma Convert została zoptymalizowana tak, aby móc raportować dane analityczne eksperymentu dopiero po osiągnięciu pięciu konwersji. Aby zapewnić wiarygodność testów, Convert stosuje dwustronne testy Z.

Na początku eksperymentu, jeśli jeden z wariantów osiąga znacznie lepsze wyniki, nadal należy kontynuować z określonym czasem trwania testu. Wczesne wyniki mogą być spowodowane szumem lub przypadkowością.

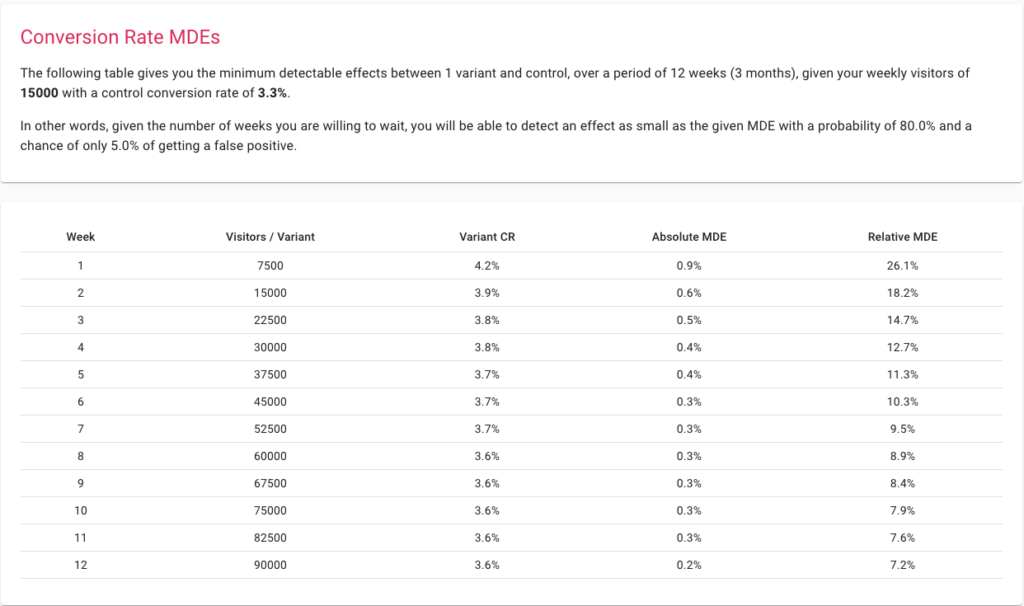

Minimalne wykrywalne efekty

MDE to minimalny wzrost do osiągnięcia, powyżej którego warto wprowadzić zmianę. Przygotowanie do testu poprzez wybranie niskiego MDE pozwala na uchwycenie w eksperymencie bardziej szczegółowych zmian. Ustawienie wyższego MDE oznacza, że eksperyment może wykryć tylko poważne zmiany, a zatem będzie działać nawet przy mniejszych próbkach. Haczyk polega na tym, że wprowadzenie drastycznych zmian, aby wygenerować wystarczająco duży wzrost, w większości przypadków nie będzie możliwe, chyba że Twoja witryna nigdy wcześniej nie była optymalizowana.

Najlepszym sposobem myślenia o MDE jest skorzystanie z naszego kalkulatora wielkości próbki. Zacznij od wprowadzenia tygodniowego ruchu i konwersji i zobacz, co można osiągnąć w danym okresie.

Wartość P

Cassie Kozyrkov, główny specjalista ds. decyzji w Google, ukuł bardzo prostą definicję wyjaśniającą wartość P: „Im niższa wartość p, tym bardziej absurdalna wygląda hipoteza zerowa!”

Jaka jest wartość P w testach A/B?

Wartość P definiuje się jako prawdopodobieństwo zaobserwowania wyniku jako skrajnego lub bardziej skrajnego niż obserwowany, przy założeniu, że hipoteza zerowa jest prawdziwa. Stąd wartość p jest matematycznym narzędziem sprawdzającym słuszność hipotezy zerowej. Im mniejsza wartość p, tym jesteśmy pewni, że powinniśmy odrzucić hipotezę zerową.

Sposób, w jaki go używamy, polega na porównaniu go z poziomem istotności. Powiedzmy, że mamy poziom istotności 5%, który bezpośrednio odpowiada poziomowi ufności 95%, a gdy tylko wartość p stanie się gorsza od 5/100 = 0,05, możemy powiedzieć, że nasz test osiągnął istotność statystyczną i może odrzucić hipotezę zerową.

Jeśli chcemy być jeszcze bardziej pewni, ustawiamy nasz poziom istotności na 1%, a następnie czekamy, aż wartość p spadnie poniżej 0,01. Oznaczałoby to 99% zaufania do naszych wyników.

Dystrybucja ruchu

Dystrybucja ruchu pomaga przydzielić pewien procent ruchu do eksperymentu. Załóżmy, że co miesiąc odwiedzasz witrynę 100 osób. Na tej podstawie możesz przydzielić eksperymentowi 30% ruchu. Domyślnie każdy wariant w teście A/B otrzyma równy udział w ruchu. Tak więc, jeśli masz dwa warianty, każdy z nich otrzyma 15% ruchu.

Korzystanie z funkcji Convert Experiences pomaga skonfigurować ten przydział ruchu za pomocą kilku kliknięć. W miarę rozwoju procesu eksperymentowania możesz tworzyć więcej wariantów i optymalizować przydział do swoich potrzeb.

Jak statystyki mogą pomóc w testowaniu A/B?

Dlaczego nie możesz po prostu porównać wydajności wariantów A i B?

Przeprowadzenie eksperymentu testowania A/B przy użyciu nawet wygodnej platformy, takiej jak Convert Experiences, wymaga pewnych zasobów pod względem czasu i energii. Czy nie byłoby więc sensowne utworzenie dwóch wariantów, zmierzenie ich współczynników konwersji i wybranie tego o lepszej skuteczności?

Choć brzmi to pragmatycznie i pomysłowo, może prowadzić do błędnych wniosków, a nawet błędnie zinterpretować wyniki, ponieważ na danych nie przeprowadzono żadnych testów statystycznych. A więc obserwacja zmiany nie wystarczy, trzeba wiedzieć, jak długo czekać na tę zmianę, a do tego trzeba wykonać test statystyczny typu Z-test, T-test lub G-test.

Samo patrzenie na wielkość liftingu lub efektu nie pomoże:

a. Określ prawdopodobne czynniki przyczynowe związane z wygraną jednego wariantu

Test A/B, z założenia, ograniczałby Cię do wyboru dwóch wariantów, które mają tylko pewne różnice materiałowe. W przypadku większego zestawu różnic zwykle wybierasz bardziej rozbudowany test wielowymiarowy.

Testy A/B działają na zasadzie, że od samego początku znasz zmienne zależne i niezależne w eksperymencie. Na przykład, jeśli utworzysz dwa zestawy z różnymi CTA umieszczonymi w tym samym układzie, wiesz, że różnica w CTA jest czynnikiem przyczynowym, jeśli możesz obalić hipotezę i zobaczyć zmianę w konwersjach.

Jeśli po prostu uruchomisz dwa zupełnie różne warianty, nawet jeśli uzyskasz stosunkowo lepszą przyczepność na jednym, nie pomoże ci to uzyskać wglądu w odbiorców ani ustalić, dlaczego to działa.

b. Rozróżnij losowość i przyczynowość

Struktura testu A/B wymagałaby Hipotezy Zerowej i Hipotezy Alternatywnej. Hipoteza zerowa generalnie zagłębiałaby się w losowość jako czynnik przyczynowy, a nie skuteczność jednego z twoich wariantów, przy określaniu współczynników konwersji. Hipoteza zerowa nie zostaje obalona, gdy istotność statystyczna nie zostanie osiągnięta na czas, a każda późniejsza zmienność jest uważana za wynik losowości. Z drugiej strony, jeśli możesz odrzucić Hipotezę Zerową, oznacza to, że istnieje duże prawdopodobieństwo (przy ustalonym poziomie ufności, np. 95% lub 99%), że odkryłeś czynnik przyczynowy mający pozytywny lub negatywny wpływ na konwersje.

c. Alokuj koszty tylko do zmian z wyższym prawdopodobieństwem ulepszonych konwersji

Przeprowadzone testy A/B obejmowałyby również miary statystyczne, takie jak poziomy istotności, przedziały ufności i marginesy błędów. Takie koncepcje analityczne nie istnieją w większości analiz ad hoc.

Weźmy na przykład porównanie dwóch stron do przesyłania formularzy z pewnymi istotnymi różnicami w układzie i wyświetlaniu informacji. Jeden działa stosunkowo lepiej niż drugi. Teraz, jak ustalisz, że będziesz w stanie powtórzyć wyniki? Ponieważ nie masz żadnych danych, które pokazują, jak istotne były wyniki eksperymentu, nie ma możliwości oceny, czy wyniki eksperymentu można powtórzyć, czy nie.

Ocena i eliminacja narażenia na błędy typu I i typu II w testach A/B

Błędy typu I (prawdziwa hipoteza zerowa zostaje odrzucona lub fałszywie dodatnia) i błędy typu II (fałszywa hipoteza zerowa nie jest odrzucana lub fałszywie negatywna) mogą mieć poważne konsekwencje dla aktywów rynkowych, które optymalizujesz za pomocą testów A/B.

Żadne narzędzie nie może jednoznacznie wskazać błędu typu I lub typu II, ale może pomóc je zminimalizować, na przykład poprzez upewnienie się, że osiągnięto poziom ufności 95% lub wyższy, a moc statystyczna osiągnęła co najmniej 80%

Załóżmy, że tworzysz dwa warianty ostatniej strony w cyklu zakupu, pokazujesz ją około 10 000 odwiedzającym w ciągu 10 dni i otrzymujesz wyniki. Widzisz lepszą wydajność dla jednego wariantu, a zatem stosujesz go w swojej witrynie e-commerce.

Problem polega na tym, że dowiesz się o błędzie typu I lub typu II w twoim eksperymencie testowania A/B po tym, jak nie uda ci się odtworzyć wyników eksperymentu w rzeczywistości. Istnieją lepsze sposoby na upewnienie się, że w teście A/B nie wystąpią błędy typu I i typu II.

Najpierw upewnij się, że wielkość próbki jest wystarczająco duża, aby zapewnić solidne statystyczne eksperymenty. Możesz użyć kalkulatora Convert, aby uzyskać odpowiednią wielkość próbki.

Następnie upewnij się, że masz poziom istotności co najmniej 95% i nie przerywaj testu, dopóki twoja moc nie osiągnie 80%. Z odpowiednim MDE i długością eksperymentu podanym przez kalkulator, możesz być praktycznie pewny kontrolowania błędów typu I lub typu II. Na pierwszą bezpośrednio wpływa ustawiony przez Ciebie poziom istotności, a na drugą siłę statystyczną, z którą chcesz żyć. Idealnie, twój poziom ufności powinien być wyższy lub równy 95%, a moc statystyczna powinna skumulować się do co najmniej 80%. W obu przypadkach im więcej tym lepiej. Jeśli oba parametry osiągną 99%, zapewnia to, że ryzyko błędów typu I lub II jest dobrze kontrolowane i mniejsze niż 1%.

Zarówno odkrycie, jak i wyeliminowanie takich problemów jest możliwe tylko dzięki myśleniu statystycznemu, na którym opiera się testowanie A/B.

Określanie, czy eksperyment testowania A/B jest skalowalny, czy nie

W powyższym przykładzie, nawet jeśli zauważysz, że jeden wariant wygrywa z alternatywą w ciągu miesiąca, nie będziesz w stanie łatwo skalować eksperymentu. Wynika to z faktu, że próba licząca 10 000 odwiedzających była dość mała.

Statystyki testów A/B dostarczają wielu przewodników heurystycznych, dzięki którym Twój test jest skalowalny, podobnie jak jego wyniki. Wyniki każdego eksperymentu testowania A/B utorują drogę do większej liczby testów w przyszłości.

Najpierw zacznij od upewnienia się, że co miesiąc masz wystarczający ruch, aby przetestować dowolny wariant interfejsu użytkownika lub elementów UX Twojej platformy. Eksperci z Convert zalecają, aby każdy z wariantów odwiedzał co najmniej 10 000 użytkowników i 1000 konwersji, aby uzyskać statystycznie poprawne wyniki. Gdy już je uzyskasz, upewnij się, że nie testujesz kilku elementów jednocześnie, pozwalasz testowi działać przez znaczny czas i może osiągnąć rozsądny poziom istotności.

Jeśli masz niewielką grupę odwiedzających, nadal możesz przeprowadzać testy A/B w kampaniach e-mailowych, kampaniach w mediach społecznościowych, a nawet w grupach reklam Google. Możesz też zdecydować się na wysoki MDE, aby uzyskać szeroki wgląd w swoich odbiorców.

Opłacalność eksperymentów

Przydzielenie dowolnego procentu ruchu do testu A/B to koszt. Wyświetlasz odbiorcom prawdopodobnie nieoptymalną stronę lub element UX, przez co możesz tracić potencjalne przychody. Chociaż test A/B da ci ostateczny pomysł na skalowanie bardziej zoptymalizowanego elementu lub strony, które mogą odzyskać utracone prawdopodobne przychody, ten koszt może być wykorzystany jako ograniczenie do optymalizacji procesu testowania.

Po przeprowadzeniu testu A/B możesz przejść do testu A/B/n, w którym będziesz mieć do przetestowania kilka dodatkowych wariantów.

Wiele darmowych kalkulatorów dostępnych online pokazuje wielkość próbki potrzebną do uzyskania dokładnych wyników tego testu. Kalkulatory te działają na prostym założeniu – obliczają wielkość próby do testu A/B, a następnie mnożą ją przez liczbę wariantów eksperymentu. Jest to nieefektywny sposób postępowania. Nasz kalkulator oferuje wydajne opcje korekty wielokrotnych porównań, takie jak Šidak, więc zawsze używaj odpowiednich narzędzi na każdym etapie eksperymentowania, aby zapewnić uzyskanie niezbędnych wyników bez utraty dodatkowych pieniędzy poniesionych w wyniku błędnych obliczeń.

Rozpocznij planowanie testów za pomocą Kalkulatora testów A/B firmy Convert

Szacowanie i kontrolowanie losowości w Twojej próbce

Chociaż istnieje kilka złożonych matematycznych zasad losowości, większość z nich wskazuje na tę samą cechę – nieprzewidywalność.

Losowość może być postrzegana jako przeciwieństwo jasno określonej przyczynowości. Zamiast wiedzieć, jakie elementy odpowiadały za wyższą konwersję, musisz polegać na pewnych nieokreślonych czynnikach zewnętrznych jako prawdopodobnych czynnikach przyczynowych dla wyników. Ponieważ nie kontrolujesz tych czynników zewnętrznych, nie możesz replikować wyników testu na dużą skalę.

Jeśli nie używasz statystycznie poprawnego procesu testowania A/B, nie zawracaj sobie głowy badaniem wpływu losowości. Ale losowość nadal będzie istnieć. Możesz w końcu wdrożyć kapitał na zasób marketingowy, który ulega konwersji podczas testu, ale nie działa na dużą skalę. Co gorsza, możesz osłabić wpływ dotychczasowej ścieżki konwersji.

Statystyki testów A/B mogą pomóc w rozwiązaniu tego problemu. Formułując hipotezę, tworzysz scenariusz, w którym przypadkowość może być przyczyną zmienionych wyników. Jeśli możesz obalić ten scenariusz, w istocie odrzuciłeś losowość jako przyczynę lepszych konwersji. Mając przed sobą więcej testów w procesie skupiających się na innych obszarach lejka konwersji, możesz jeszcze bardziej wyeliminować miejsce na losowość w procesie optymalizacji konwersji.

Idealnym rozwiązaniem byłoby zdefiniowanie ogólnego kryterium oceny (OEC) z jedną główną metryką i innymi metrykami ochronnymi oraz przeprowadzenie eksperymentów w celu optymalizacji tego pierwszego, przy jednoczesnym upewnieniu się, że te drugie nie ulegają degradacji. Na przykład chcesz zwiększyć współczynniki konwersji (dane podstawowe), ale nie chcesz zmniejszać zaangażowania użytkowników, ponieważ oznaczałoby to niezadowolonych klientów.

Świetną książką, prawdopodobnie najważniejszą jak dotąd książką na temat eksperymentów, jest Trustworthy Online Controlled Experiments: A Practical Guide to A/B Testing autorstwa Rona Kohaviego, Diane Tang, Ya Xu.

Zapewnienie, że nie potrzebujesz bardziej kompleksowego testu na wielu odmianach

Kompleksowe narzędzia, takie jak Convert Experiences, mogą pomóc w przeprowadzeniu wielu testów A/B. Choć może to brzmieć jak trywialna funkcjonalność, może pomóc Ci zrozumieć, czy potrzebujesz bardziej kompleksowego testu na wielu odmianach, czy też wyniki testu A/B są wystarczająco satysfakcjonujące.

Wszystko to zależy od tego, co zrobisz zaraz po zrozumieniu wyników testu. Rozpoczynasz wdrażanie zwycięskiej strony lub elementu, czy idziesz na dalsze testy? Jeśli wielkość próbki, poziom istotności i MDE są zadowalające, zwykle można wdrożyć zwycięską alternatywę. Jeśli jesteś po drugiej stronie, możesz przeprowadzić dalsze testy, aby znaleźć przyczynę różnych współczynników konwersji.

Załóżmy na przykład, że testujesz, czy określone wezwanie do działania na stronie docelowej pomaga w uzyskaniu lepszych konwersji, czy nie. Przeprowadzasz test A/B i masz wyraźnego zwycięzcę. Jednak niektóre miary statystyczne, takie jak poziom istotności, nie są spełnione. Tak więc bierzesz zwycięski wariant i tworzysz kolejny, aby przeprowadzić kolejny test A/B.

Jeśli wyniki są replikowane, możesz mieć większe zaufanie do zwycięskiego wariantu. Jeśli nie możesz odtworzyć poziomów konwersji z pierwszego testu, możesz potrzebować testu na wielu odmianach, aby znaleźć element odpowiedzialny za wzrost liczby konwersji.

Testy A/B mogą pomóc w uniknięciu zależności od samodzielnie zgłaszanych danych

Nawet najmniejsza zmienna może mieć duży wpływ na wykryte zachowanie użytkownika. Na przykład efekt migotania ma znaczny wpływ na współczynniki konwersji. Migotanie to sytuacja, w której domyślna strona docelowa jest wyświetlana przed wariantem strony, gdy użytkownik jest częścią przykładowego ruchu używanego do testów A/B. Może to prowadzić do zanieczyszczonych wyników – nawet jeśli prowadzisz analitycznie spójny proces.

Gdy mogą wystąpić problemy z procesami statystycznymi i analitycznymi, takimi jak testy A/B, uruchomienie samodzielnego procesu może prowadzić tylko do bardziej nieoptymalnych lub nawet fałszywych wyników. Procesy samodzielnego zgłaszania są często skażone kilkoma uprzedzeniami i zaszumionymi danymi, ponieważ cała odpowiedzialność za zapamiętywanie preferencji i ich zgłaszanie spoczywa na użytkowniku, który nie ma żadnej motywacji do uczciwości. Ponadto istnieją błędy w porządkowaniu i inne czynniki zewnętrzne, które mogą prowadzić do błędnych danych.

Testy A/B stawiają Cię w fotelu obserwacyjnym i eliminują potrzebę jakiejkolwiek formy raportowania użytkownika. Dzięki narzędziom takim jak Convert nie musisz się nawet martwić o migotanie.

Podejmowanie decyzji organizacyjnych w oparciu o dane

Eksperyment z testami A/B nie pozostawia miejsca na domysły. Na każdym kroku Twoja platforma testowa zbiera obserwacje, rejestruje dane i przeprowadza analizy. W ten sposób, niezależnie od preferencji Twoich przełożonych, inwestorów lub agencji, uzyskiwane wyniki będą oparte na danych.

Gdy w proces zaangażowanych jest kilku interesariuszy, efekt końcowy może być nieoptymalny. Testy A/B to proces analityczny, który eliminuje miejsce na takie hierarchiczne podejmowanie decyzji lub tendencyjne myślenie.

Na przykład Twoja agencja może zalecić zmianę interfejsu użytkownika na stronie docelowej, ponieważ spowoduje to zwiększenie jej rozliczeń za miesiąc, a jeśli zostanie wykonana prawidłowo, może nawet nie utrudnić konwersji. Jednak w przypadku testu A/B, jeśli Twoja Hipoteza Zerowa pozostanie silna, będziesz wiedział na pewno, że na razie żadne takie zmiany nie są konieczne. Ponieważ masz dane na poparcie swojego rozumowania, nie musisz poddawać się pozom nawet przywództwa w swojej firmie. Może to również pomóc w walce z HiPPO (Opinia Najwyższej Płatnej Osoby). Dane nie kłamią, a test A/B jest najlepszym dowodem, jaki masz do dyspozycji.

Zrozumienie wyników eksperymentu za pomocą przejrzystych obliczeń

Zrozumienie wyników testu A/B jest prawie tak samo ważne, jak przeprowadzenie rygorystycznego testu statystycznego. Każde narzędzie może przeprowadzić test, porównać alternatywy i rzucić na ciebie zwycięzcę. Potrzebujesz wskazania związku przyczynowego. Chociaż miary statystyczne mogą to podkreślić, Convert Experiences został zaprojektowany z myślą o przejrzystości obliczeń.

Platforma ma 99,99% czasu działania, umożliwia ponad 90 integracji z firmami zewnętrznymi, umożliwia śledzenie celów firm zewnętrznych oraz obsługuje sprawdzanie kodu i błędów. W ten sposób pod koniec procesu testowania będziesz mieć jasne pojęcie, który element jest zwycięzcą, dlaczego jest bardziej preferowany i czy potrzebujesz więcej testów, aby mieć większą pewność podczas skalowania.

Umieszczanie statystyk A/B w celu przejścia w kierunku dojrzałości CRO

Co to jest dojrzałość CRO i jak statystycznie brzmiące testy A/B mogą pomóc w osiągnięciu tego celu?

Chociaż optymalizacja współczynnika konwersji może wydawać się odosobnionym sposobem myślenia, wymaga zmian opartych na procesach w całej firmie, która stara się bardziej skoncentrować na konwersjach. Wyzwanie polega na tym, że CRO to stosunkowo nowa dziedzina. W badaniu z 2018 r. blisko 62% marketerów pracowało w CRO krócej niż 4 lata.

Specjalista ds. CRO z Shopify stworzył hierarchię tego, w jaki sposób firmy dążą do dojrzałości CRO. Zagłębiając się w tę hierarchię, odkryjesz, jak solidne eksperymenty statystyczne mają kluczowe znaczenie dla ewolucji procesów organizacyjnych:

1. Przeprowadzanie badań jakościowych i ilościowych w celu zidentyfikowania nieoptymalnych punktów styku

Pulpit nawigacyjny Google Analytics często pomaga w eksploracji stron lub punktów styku w obsłudze klienta, które wymagają natychmiastowej uwagi. Rozwiązanie konkretnego problemu, takiego jak wysokie współczynniki odrzuceń na stronie głównej, porzucone koszyki, niekompletne wypełnienie formularzy i pomijanie subskrypcji e-mail, może być wykorzystane jako punkt wyjścia do optymalizacji ścieżki konwersji.

2. Formułowanie pomysłów na testowanie i eksperymentowanie na podstawie wcześniej przeprowadzonych badań

Statystyki testów A/B mogą pomóc w zrozumieniu wydajności benchmarku Twojej witryny, a nawet konkurencji. Możesz to wykorzystać, aby zrozumieć, które elementy są opóźnione i rozpocząć testy A/B wariantów, które mogą działać lepiej.

3. Testowanie i eksperymentowanie z pomysłami o najwyższych priorytetach

Podczas konfigurowania pomysłów na testy A/B w programie Convert Experiences ustawisz metryki takie jak MDE. Takie metryki pomogą Ci ustalić priorytety testów, które będą miały maksymalny wpływ na Twój biznes, pod kątem alokacji zasobów niezbędnych do przeprowadzenia eksperymentu.

4. Analiza i rejestracja wyników testów

Po przeprowadzeniu testu kluczowe staje się zrozumienie, dlaczego uzyskałeś wyniki, które widzisz. W tym miejscu platformy takie jak Convert Experiences mogą pomóc w filtrowaniu między losowością a przyczynowością o wysokim prawdopodobieństwie. Dzięki przejrzystym kalkulacjom Convert Experiences pomoże Ci zrozumieć, dlaczego Twój zwycięski wariant działa lepiej.

5. Tworzenie testów uzupełniających

Po przeprowadzeniu testów A/B i uzyskaniu wyników możesz przejść do bardziej kompleksowych testów wielowymiarowych lub przeprowadzić test A/B z innym wariantem. Convert ułatwia przeprowadzenie zróżnicowanego zestawu testów statystycznych, które mogą pomóc w zwiększeniu pewności co do poparcia zwycięskiego wariantu.

Model dojrzałości CRO koncentruje się na całościowym procesie obejmującym strategię i kulturę firmy, narzędzia i technologię, ludzie i umiejętności oraz proces i metodologię, w którym postęp przedsiębiorstwa jest śledzony na różnych poziomach dojrzałości, takich jak: początkujący, aspirujący, progresywny, strategiczny, i transformacyjny.

Convert Experiences zapewnia rygorystyczną analizę danych w procesie testowania A/B, nie wymaga kodowania w celu przeprowadzenia testów, zapewnia wizualnie i analitycznie dostępne wyniki oraz jest przejrzysta w odniesieniu do wyników testów. Mając platformę w centrum planów testów A/B, dojrzałość CRO Twojego przedsiębiorstwa może z większą łatwością przejść do etapów transformacji.

Testy A/B w działaniu: porównawcze studia przypadków

1. Korzystanie z Google Analytics i konwertowanie doświadczeń do generowania hipotez

Google Analytics może być świetnym punktem wyjścia do zrozumienia potencjalnych obszarów poprawy w Twojej witrynie. Nagły spadek ruchu, wysokie współczynniki odrzuceń w porównaniu z czasem wyświetlania strony itp. mogą być silnymi wskaźnikami potencjalnych problemów.

Zaplanuj wszystkie wyzwania, które widzisz w raportach Google Analytics. Równolegle przeprowadź ankietę jakościową na swojej stronie internetowej, w mediach społecznościowych i kampaniach e-mailowych, pytając odbiorców, czego szukają. Oprócz tego możesz użyć Hotjar, aby zrozumieć, w jaki sposób odwiedzający poruszają się po elementach na każdej stronie.

Na podstawie tych wszystkich danych możesz następnie tworzyć wnikliwe warianty i przeprowadzać testy A/B. Jeśli korzystasz już z Konwertuj doświadczenia, możesz również użyć narzędzia do generowania hipotez Konwertuj kompas, aby jeszcze bardziej przyspieszyć ten proces.

2. Zwiększanie konwersji z porzuconych wózków poprzez testy A/B

Porzucone koszyki są drogie dla Twojej witryny i dość niewygodne dla odwiedzających, ponieważ oboje zainwestowaliście dużo czasu i zasobów, aby dojść do tego punktu, ale konwersja nie zadziałała.

Korzystając z funkcji Convert Experiences zintegrowanych z innymi platformami, możesz sformułować ustrukturyzowane podejście do sprostania temu wyzwaniu.

- Najpierw zacznij od integracji Convert Experiences z Shopify, WooCommerce, PrestaShop, BigCommerce lub dowolną inną platformą eCommerce, której używasz.

- Następnie użyj Google Analytics, aby ustawić cele na swoich platformach i użyj narzędzi takich jak Hotjar lub Crazy Egg, aby ocenić możliwy problem.

- Dzięki funkcji Convert Experiences możesz korzystać z tych danych, formułować hipotezy i przeprowadzać testy A/B w zorganizowany sposób. Klienci zaobserwowali wzrost przychodów o ponad 26% przy zastosowaniu podobnego podejścia.

Convert Experiences integruje się z ponad 100 narzędziami. Sprawdź naszą bazę danych, aby dowiedzieć się, czy integrujemy się z narzędziami w Twoim aktualnym stosie technologicznym. Jeśli nie, napisz do nas wiadomość, a my ją zbudujemy!

3. Optymalizacja strony docelowej

Landing pages mają kluczowe znaczenie dla całego procesu konwersji. Aby wydobyć maksymalną wartość ze swoich stron docelowych, możesz skorzystać z różnych narzędzi, takich jak Google Analytics, Adobe Analytics, Kissmetrics, Baidu Analytics lub innych wiodących narzędzi do analizy przypadków użycia. Convert Experiences bezproblemowo integruje się z tymi platformami, aby pomóc Ci filtrować strony docelowe o niskiej konwersji.

Następnie możesz użyć integracji Hotjar i Convert, aby zrozumieć, które elementy Twojej strony nie działają. Dzięki zaawansowanym narzędziom, takim jak mapy cieplne, możesz uzyskać wizualne zrozumienie, w jaki sposób użytkownicy uzyskują dostęp do różnych elementów na Twojej stronie. Poza tym możesz użyć Convert Compass do generowania hipotez, a następnie uruchamiania testów na platformie.

Po przeprowadzeniu testu możesz skorzystać z integracji między Convert a wiodącymi platformami do tworzenia stron docelowych, takimi jak LanderApp, Instapage lub Hubspot CMS. Te integracje pomogą Ci przeprowadzać łatwe eksperymenty testów A/B na Twoich stronach docelowych.

Korzystając z tego samego przepływu pracy, eksperci CRO stwierdzili, że wzrost konwersji wynosi 27%, a współczynniki dodawania do koszyka wzrosły o 13%.

Osiąganie wyższego zwrotu z inwestycji dzięki „higienicznym” testom A/B

- Próg ruchu w witrynie : Convert zaleca, aby każdy testowany wariant miał ruch co najmniej 10 000 odwiedzających i konwersje przekraczające 1000.

- Korzystanie z odpowiedniego narzędzia do testów A/B : brak odpowiedniej platformy testowej może dawać zanieczyszczone wyniki, prowadzić do nieoptymalnych testów lub powodować poważne ograniczenia zasobów. Convert Experiences został zaprojektowany w celu wyeliminowania tych kluczowych parametrów, zapewniając jednocześnie przystępność, przejrzystość i płynność procesu testowania.

Możesz teraz uruchamiać testy w Konwertuj doświadczenia za darmo przez maksymalnie 15 dni. Dowiesz się, jak wygląda płynna, pozbawiona migotania i przejrzysta platforma, która integruje się z innymi narzędziami do analizy konwersji.

- Definiowanie celów testowania : Twoje cele jako firmy muszą być zgodne. Na przykład – podczas gdy optymalizujesz pod kątem maksymalnej liczby rejestracji, niektóre inne jednostki w Twoim zespole nie powinny optymalizować kolejnych procesów pod kątem maksymalnej sprzedaży. Niespójny UX może wyrządzić więcej szkód niż nieoptymalny UX.

Dlatego utrzymuj jednolitość celów wśród całej grupy członków zespołu. Na poziomie testowania upewnij się, że jasno zdefiniowałeś wielkość próby, czas trwania, istotność statystyczną, hipotezę i MDE przed, w trakcie i po przeprowadzeniu testu A/B.

- Wykluczenie ruchu wewnętrznego: Kiedy przeprowadzasz test A/B, wielu członków Twojego zespołu odwiedza strony lub punkty na ścieżce klienta, aby obiektywnie ocenić stronę. Może to powodować zakłócenia w wynikach testów.

Convert Experiences został zaprojektowany tak, aby filtrować taki ruch i skupiać się tylko na zdefiniowanych przez Ciebie segmentach odbiorców w celu rejestrowania, agregowania i analizowania danych w procesie testowania A/B.

Końcowe przemyślenia na temat statystyk testów A/B

Testy A/B to rygorystyczne ćwiczenie analityczne, które można przeprowadzić tylko ze statystycznym rygorem. Bez statystyk wbudowanych w proces testowanie A/B jest czystym zgadywaniem.

Usługa Convert Experiences umożliwia prowadzenie sprawnych, dostępnych, niezawodnych, a jednocześnie zasobooszczędnych eksperymentów testowych A/B. While the process of A/B testing can seem a little overwhelming at first, it certainly unlocks value in the form of the right insight and analytical proven ideas it gives you. Make sure you never run an A/B test in isolation – it has to be followed up with more tests, and even multivariate tests.

With consistent optimization and unlimited tests made available by Convert Experiences, you can expect your enterprise to become a more analytical and data-driven operation in no time.