Budowanie narzędzi do zrozumienia wydajności treści

Opublikowany: 2020-09-03Treść jest jedną z głównych sił napędzających strategię marketingu przychodzącego, a SEO jest integralną częścią jej działania. Ogólnie rzecz biorąc, obejmuje to podstawy SEO na stronie: strukturę artykułu, umieszczanie słów kluczowych, metatagi, tagi tytułowe, tekst alternatywny, nagłówki, dane strukturalne i wykorzystanie formatowania do tworzenia nieformalnych danych strukturalnych na listach i tabelach.

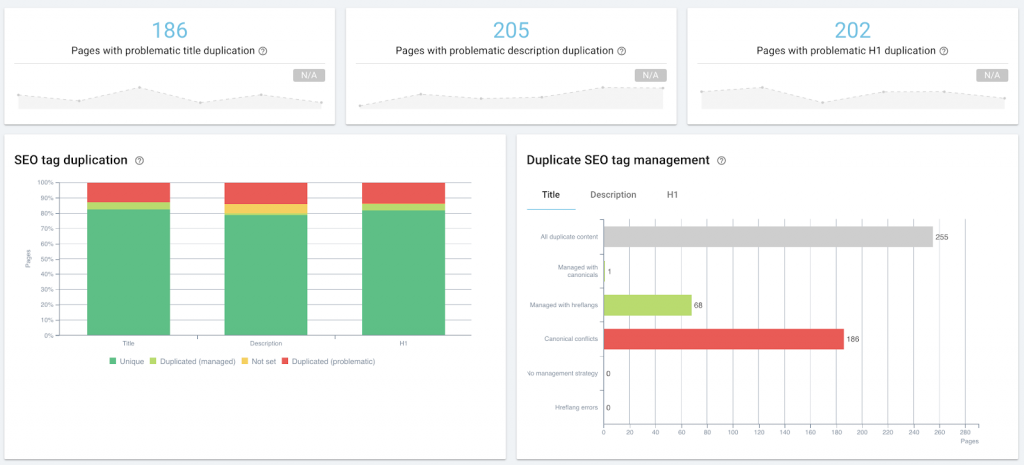

Audyt SEO na stronie w ramach zarządzania treścią przy użyciu OnCrawl.

Obejmuje to techniczne SEO, gdy zaczynasz masową optymalizację lub monitorowanie, czy to poprzez audyty witryny, czy regularne indeksowanie, za pomocą generowanych maszynowo metaopisów w języku naturalnym, tagów kontroli fragmentów lub wstrzykiwania danych strukturalnych.

Jednak przecięcie technicznego SEO i content marketingu jest jeszcze większe, jeśli chodzi o wydajność treści: patrzymy na te same podstawowe dane, takie jak pozycja strony w SERP lub liczba kliknięć, wyświetleń i sesji. Możemy wdrażać te same rozwiązania lub korzystać z tych samych narzędzi.

Co to jest wydajność treści?

Wydajność treści to wymierny wynik interakcji odbiorców z treścią. Jeśli treść generuje ruch przychodzący, pomiary tego ruchu odzwierciedlają, jak dobrze lub jak kiepsko ta treść wykonuje swoją pracę. Każda strategia treści powinna, w oparciu o konkretne cele, określać poszczególne KPI. Większość będzie zawierać następujące dane:

- Jak widoczna jest treść w wyszukiwaniu (wyświetlenia w SERP)

- Jak trafne wyszukiwarki uważają treść (ranking w SERP)

- Jak trafni użytkownicy uważają, że lista wyszukiwania treści jest (kliknięcia z SERP)

- Ile osób przegląda treść (wizyty lub sesje w rozwiązaniu analitycznym)

- Ile osób wchodzi w interakcję z treścią w sposób, który wspiera cele biznesowe (śledzenie konwersji)

Jak na razie dobrze.

Trudność polega na ustawieniu kursora: jakie liczby oznaczają dobrą wydajność treści? Co jest normalne? A skąd wiesz, że coś nie idzie dobrze?

Poniżej podzielę się moim eksperymentem mającym na celu stworzenie „weryfikacji koncepcji” narzędzia o niskiej technologii, które pomoże odpowiedzieć na te pytania.

Dlaczego wymagamy standardu wydajności treści?

Oto kilka pytań, na które chciałem odpowiedzieć w ramach mojego własnego przeglądu strategii treści:

- Czy istnieje różnica między treściami wewnętrznymi a postami gościnnymi pod względem wydajności?

- Czy są przedmioty, które naciskamy, a które nie działają dobrze?

- Jak rozpoznać posty „wiecznie zielone”, nie czekając trzy lata, aby sprawdzić, czy nadal generują cotygodniowy ruch?

- Jak mogę zidentyfikować niewielkie korzyści wynikające z promocji prowadzonej przez osoby trzecie, na przykład odebranie posta w biuletynie, którego nie było na naszym radarze promocji, aby natychmiast dostosować naszą własną strategię promocji i wykorzystać zwiększoną widoczność?

Aby jednak odpowiedzieć na którekolwiek z tych pytań, musisz wiedzieć, jak wygląda „normalna” wydajność treści w witrynie, z którą pracujesz. Bez tej linii bazowej nie można ilościowo powiedzieć, czy określony element lub rodzaj treści działa dobrze (lepiej niż linia bazowa), czy nie.

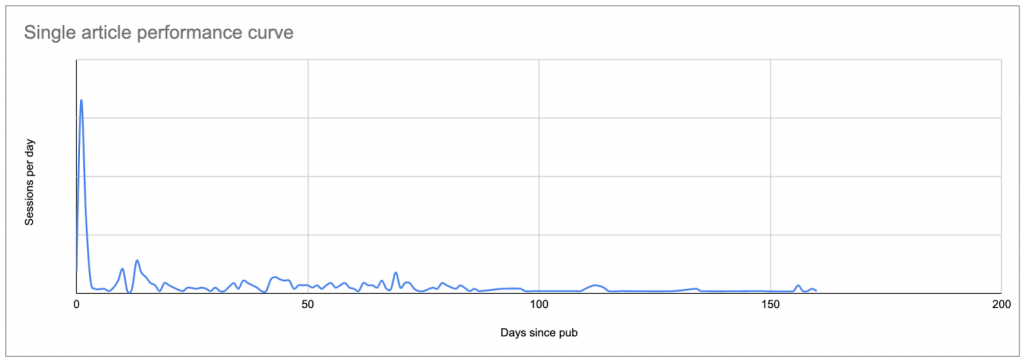

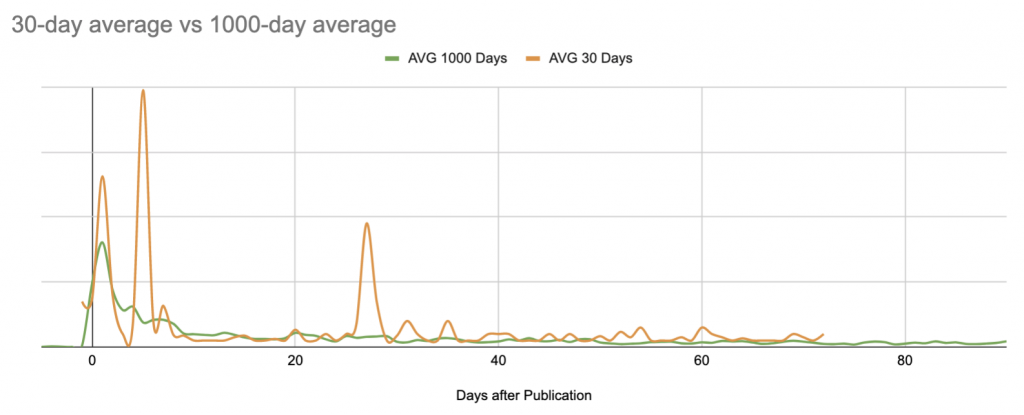

Najłatwiejszym sposobem ustalenia punktu odniesienia jest przyjrzenie się średniej sesji dziennie po publikacji artykułu, gdzie dzień zero jest datą publikacji.

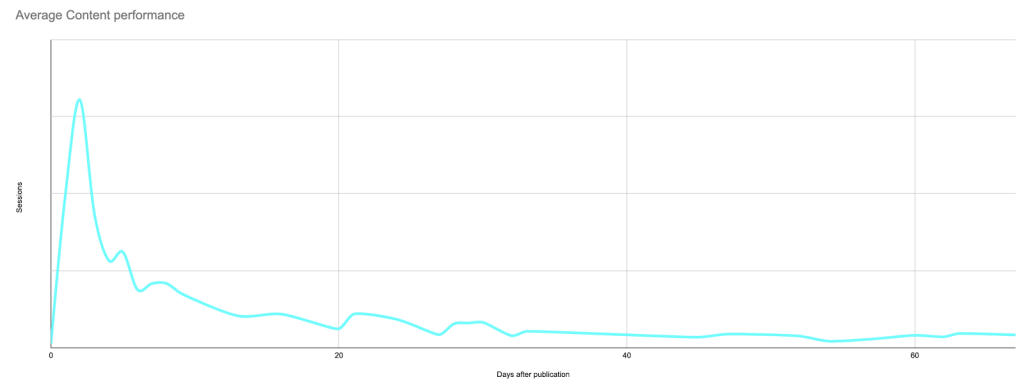

Spowoduje to powstanie krzywej, która wygląda mniej więcej tak, pokazując szczyt początkowego zainteresowania (i prawdopodobnie wyniki każdej promocji, jeśli nie ograniczyłeś swojej analizy tylko do sesji z wyszukiwarek), po której nastąpi długi ogon mniejsze zainteresowanie:

Prawdziwe dane dla typowego postu: szczyt w dniu publikacji lub krótko po dacie publikacji, po którym następuje długi ogon, który w wielu przypadkach ostatecznie przynosi więcej sesji niż pierwotny szczyt.

Gdy już wiesz, jak wygląda krzywa każdego posta, możesz porównać każdą krzywą z innymi i ustalić, co jest „normalne”, a co nie.

Jeśli nie masz narzędzia, aby to zrobić, jest to ból w karku.

Kiedy zaczynałem ten projekt, moim celem było użycie Arkuszy Google do skonstruowania dowodu koncepcji — zanim zobowiążę się do nauczenia się Pythona na tyle, aby zmienić sposób, w jaki badam wydajność treści.

Proces podzielimy na fazy i kroki:

- Znajdź swoją linię bazową

– Wymień treści, które chcesz studiować

– Dowiedz się, ile sesji każdego dnia otrzymał każdy element treści

– Zastąp datę na liście sesji liczbą dni od publikacji

– Oblicz „normalną” krzywą do wykorzystania jako punkt odniesienia - Zidentyfikuj zawartość, która nie wygląda jak punkt odniesienia

- Utrzymuj to na bieżąco

Znajdź punkt odniesienia dla treści

Wymień treści, które chcesz studiować

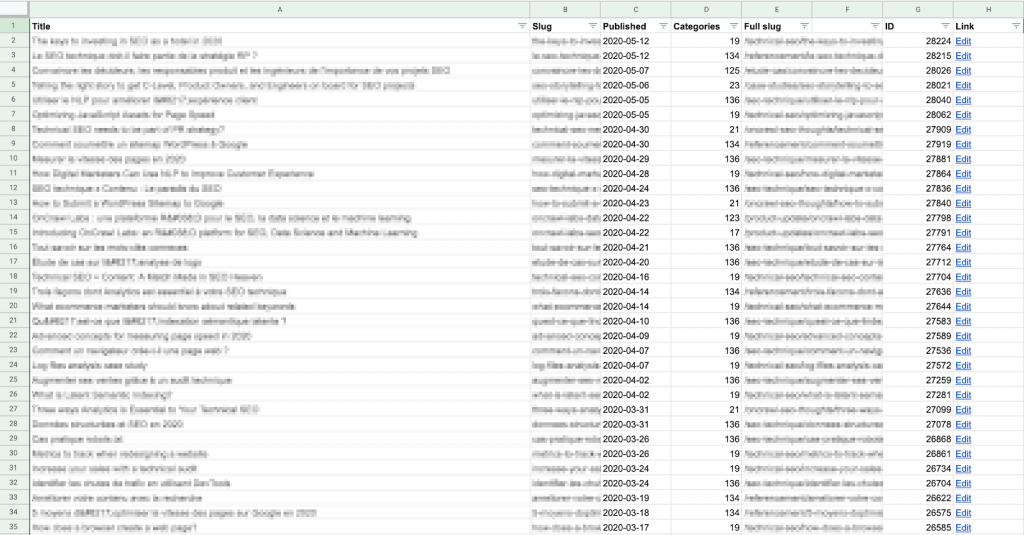

Na początek musisz ustalić listę treści, które chcesz zbadać. W przypadku każdego elementu treści potrzebny jest adres URL i data publikacji.

Możesz uzyskać tę listę w dowolny sposób, niezależnie od tego, czy tworzysz ją ręcznie, czy używasz metody automatycznej.

Użyłem skryptu Apps Script do pobrania każdego adresu URL treści i daty jego publikacji bezpośrednio z CMS (w tym przypadku WordPress) za pomocą interfejsu API i zapisałem wyniki w Arkuszu Google. Jeśli nie znasz się na skryptach lub interfejsach API, jest to nadal stosunkowo łatwe; możesz znaleźć wiele przykładów online, jak to zrobić dla WordPressa.

Pamiętaj, że będziesz chciał porównać te dane z danymi sesji dla każdego posta, więc musisz upewnić się, że „slug” w tym arkuszu odpowiada formatowi ścieżki adresu URL dostarczonej przez Twoje rozwiązanie analityczne.

Uważam, że łatwiej jest zbudować pełny slug (ścieżkę adresu URL) tutaj, w kolumnie E powyżej, niż modyfikować dane pobierane z Google Analytics. Jest też mniej obciążony obliczeniowo: na tej liście jest mniej wierszy!

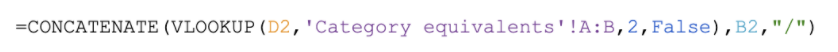

Przykładowa formuła tworzenia pełnego adresu URL dla tej witryny: wyszukaj numer kategorii podany przez CMS w tabeli i zwróć nazwę kategorii, która jest umieszczona przed slug artykułu, pasująca do wzorca adresu URL dla tej witryny (https://site .com/nazwakategorii/articleSlug/)

Jeśli nie masz dostępu do backendu, możesz utworzyć listę, pobierając te informacje z samej witryny, na przykład podczas indeksowania. Następnie możesz wyeksportować plik CSV z żądanymi danymi i zaimportować go do Arkusza Google.

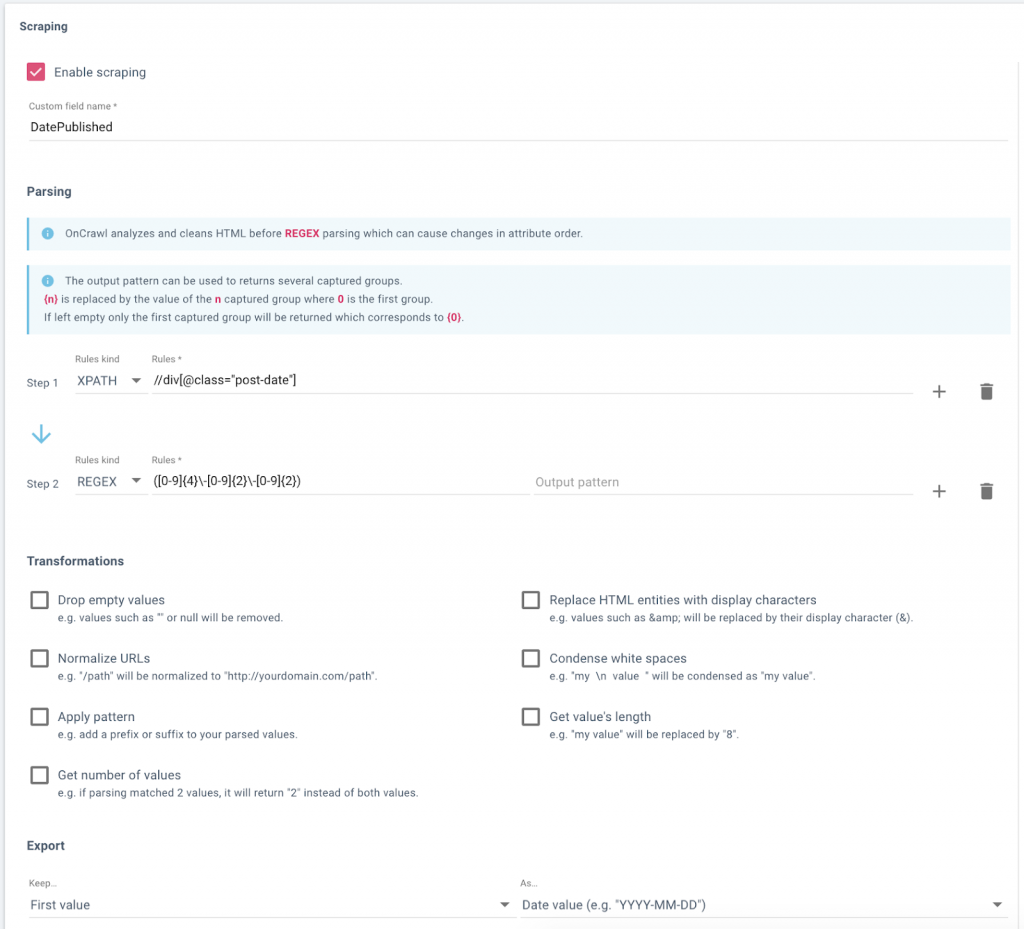

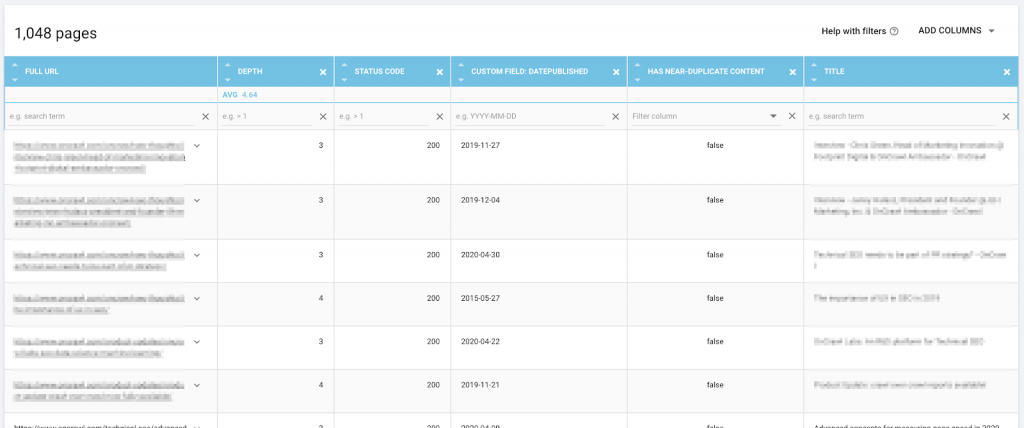

Konfigurowanie pola danych w OnCrawl do usuwania dat publikacji z bloga witryny.

Dane, w tym adres URL i data publikacji scraped, w Eksploratorze danych OnCrawl, gotowe do eksportu.

Dowiedz się, ile sesji dziennie zarobił każdy element treści

Następnie potrzebujesz listy sesji według treści i na dzień. Innymi słowy, jeśli treść ma 30 dni i była codziennie odwiedzana w tym okresie, chcesz mieć dla niej 30 wierszy – i tak dalej dla reszty treści.

Potrzebny będzie do tego osobny arkusz w tym samym dokumencie.

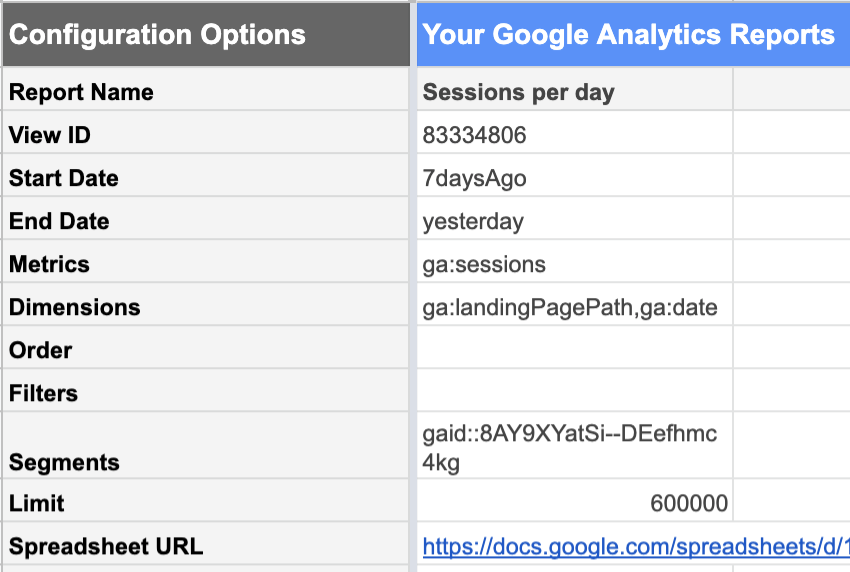

Dodatek Google Analytics do Arkuszy Google sprawia, że jest to stosunkowo łatwe.

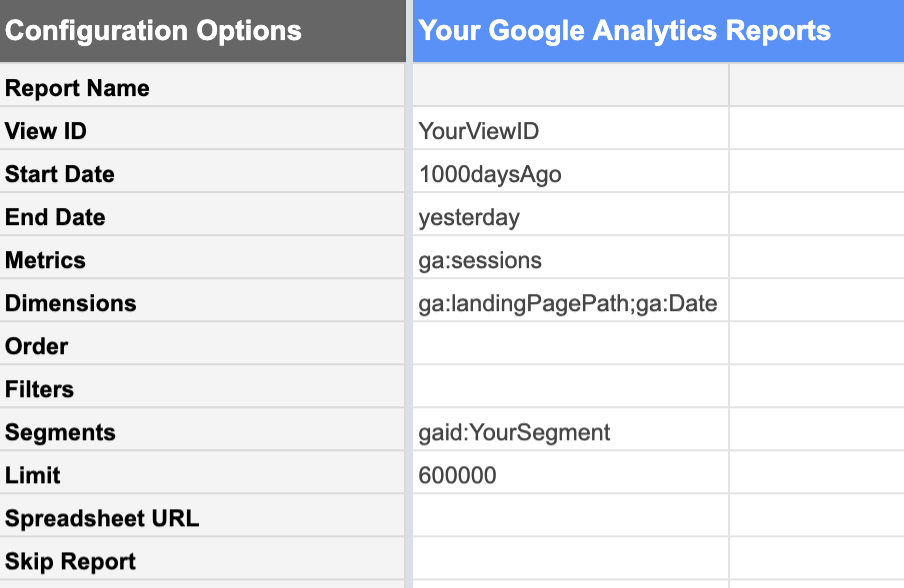

W widoku Google Analytics z wybranymi danymi możesz zażądać raportu:

| Daktyle | Metryka | Wymiary |

|---|---|---|

| Sprzed 1000 dni Do wczoraj.Dzisiejsze dane nie są jeszcze kompletne, ponieważ dzień jeszcze się nie skończył. Jeśli to uwzględnisz, nie będzie to wyglądać jak „normalny” pełny dzień i obniży wszystkie twoje statystyki. | Sesje Interesuje nas ilość sesji. | Strony docelowe Ta lista zawiera sesje dla każdej strony docelowej osobno.Data Ta lista zawiera sesje dla każdej daty osobno, zamiast podawać nam sumę 1000 dni.. |

Na tym etapie niezwykle pomocne jest korzystanie z segmentów danych Google Analytics . Możesz na przykład ograniczyć raport do segmentu zawierającego tylko adresy URL treści, które chcesz przeanalizować, a nie do całej witryny. To znacznie zmniejsza liczbę wierszy w wynikowym raporcie i znacznie ułatwia pracę z danymi w Arkuszach Google.

Co więcej, jeśli zamierzasz patrzeć wyłącznie na wyniki organiczne w celach stricte SEO, Twój segment powinien wykluczyć kanały pozyskiwania, których nie można przypisać pracy SEO: referrale, email, social…

Nie zapomnij upewnić się, że limit jest wystarczająco wysoki, aby przez pomyłkę nie skrócić swoich danych.

Oblicz liczbę dni od publikacji

Aby obliczyć liczbę dni od publikacji dla każdego punktu danych w artykule, musimy połączyć (lub, jeśli jesteś użytkownikiem Data Studio, „połączyć”) dane z raportów sesji z danymi z Twojej listy elementów treści .

Aby to zrobić, użyj jako klucza adresu URL lub ścieżki adresu URL. Oznacza to, że ścieżka adresu URL musi być sformatowana w ten sam sposób zarówno w tabeli CMS, jak i w raporcie Google Analytics.

Utworzyłem osobną tabelę, aby móc usunąć dowolne parametry ze strony docelowej w moim raporcie Analytics. Oto jak konfiguruję moje kolumny:

- Wstęp

Scrub parametry z fragmentu adresu URL w raporcie Analytics

Przykładowa formuła:

- Data

Data zarejestrowania sesji, z raportu Analytics

Przykładowa formuła:

- Sesje

Data zarejestrowania sesji, z raportu Analytics

Przykładowa formuła:

- Dni po publikacji

Wyszukuje datę publikacji tego adresu URL w kolumnie tabeli CSM, którą właśnie utworzyliśmy, i odejmuje ją od daty zarejestrowania tych sesji. Jeśli adresu URL nie można znaleźć w tabeli CMS, zgłosi pusty ciąg zamiast błędu.

Przykładowa formuła:

![]()

Zwróć uwagę, że mój klucz wyszukiwania — pełna ścieżka adresu URL — nie jest pierwszą kolumną z lewej strony w moich danych; Musiałem przesunąć kolumnę E przed kolumną C na potrzeby funkcji WYSZUKAJ.PIONOWO.

Jeśli masz zbyt wiele wierszy, aby wypełnić to ręcznie, możesz użyć skryptu takiego jak ten poniżej, aby skopiować zawartość pierwszego wiersza i wypełnić następne 3450 lub coś takiego:

funkcja FillDown() {

var arkusz kalkulacyjny = SpreadsheetApp.getActive();

arkusz kalkulacyjny.getRange('F2').activate();

arkusz kalkulacyjny.getActiveRange().autoFill(arkusz kalkulacyjny.getRange('F2:F3450), Arkusz kalkulacyjnyApp.AutoFillSeries.DEFAULT_SERIES);

};Oblicz „normalną” liczbę sesji dziennie po publikacji

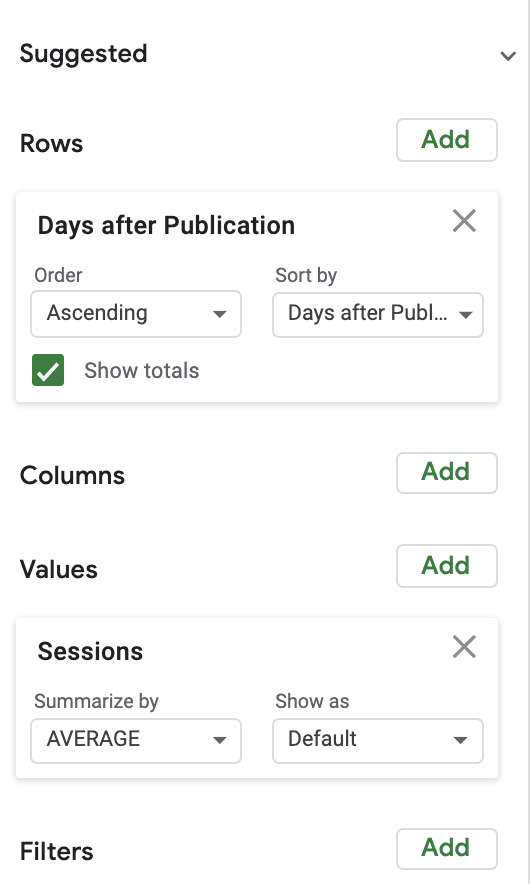

Aby obliczyć normalne liczby sesji, użyłem dość prostej tabeli przestawnej połączonej z wykresem. Dla uproszczenia zacząłem od przyjrzenia się średniej liczbie sesji dziennie po publikacji.

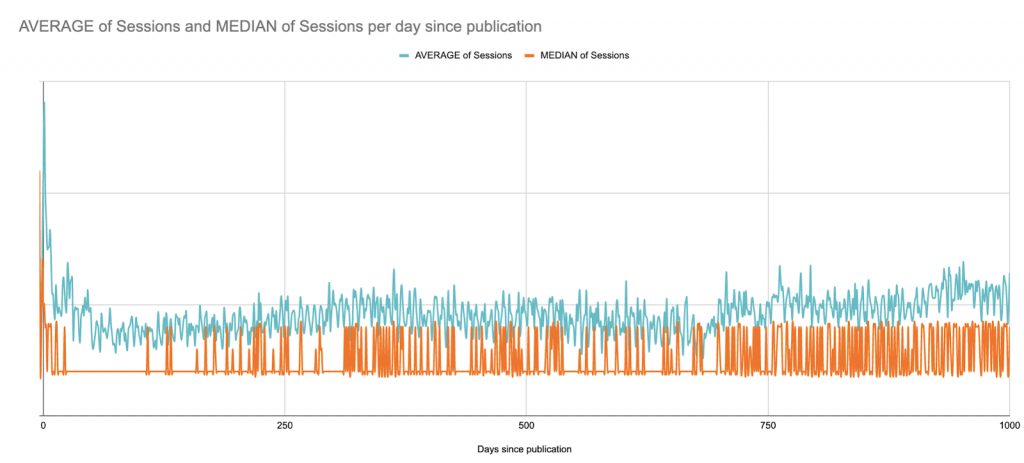

Oto średnia w porównaniu z medianą sesji w ciągu 1000 dni po publikacji. Tutaj zaczynamy (?), aby zobaczyć ograniczenia Arkuszy Google jako projektu wizualizacji danych:

Jest to witryna B2B, w której szczyty sesji w dni powszednie występują w całej witrynie; publikuje artykuły kilka razy w tygodniu, ale zawsze w te same dni. Możesz prawie zobaczyć tygodniowe wzorce.

W tym przypadku, dla celów wizualizacji, prawdopodobnie najlepiej byłoby przyjrzeć się kroczącym średnim 7-dniowym, ale oto krótka wersja, która jedynie wygładza się o tygodnie od publikacji:

Pomimo tego długoterminowego poglądu, w kolejnych krokach ograniczę wykres do 90 dni po publikacji, aby później nie przekroczyć limitów Arkuszy Google:

Poszukiwanie anomalii

Teraz, gdy wiemy, jak wygląda przeciętny wpis w danym dniu, możemy porównać dowolny wpis z punktem odniesienia, aby dowiedzieć się, czy jest zbyt skuteczny, czy zbyt słaby.

To szybko wymyka się „z ręki”, jeśli robisz to ręcznie. Odłóżmy na bok, spróbujmy przynajmniej trochę zautomatyzować.

Każdy post (mniejszy niż 90 dni) należy porównać z punktem odniesienia, który właśnie ustaliliśmy dla każdego dnia w naszym 90-dniowym oknie.

W przypadku tego weryfikacji koncepcji obliczyłem różnicę procentową od średniej dziennej.

Aby przeprowadzić rygorystyczną analizę, warto przyjrzeć się odchyleniu standardowemu sesji dziennie i ustalić, ile odchyleń standardowych wydajności poszczególnych elementów treści ma od wartości bazowej. Liczba sesji, która wynosi trzy standardowe odchylenia od średniej wydajności, jest bardziej prawdopodobna jako anomalia niż coś, co różni się od średniej z tego dnia o ponad X%.

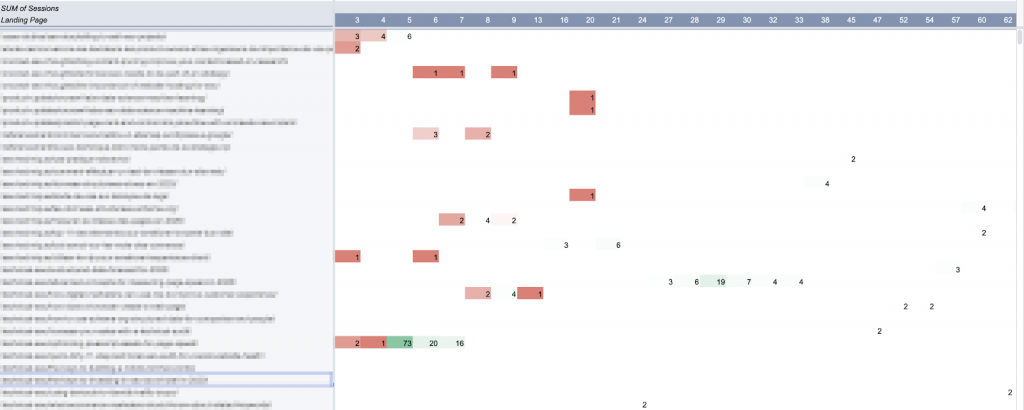

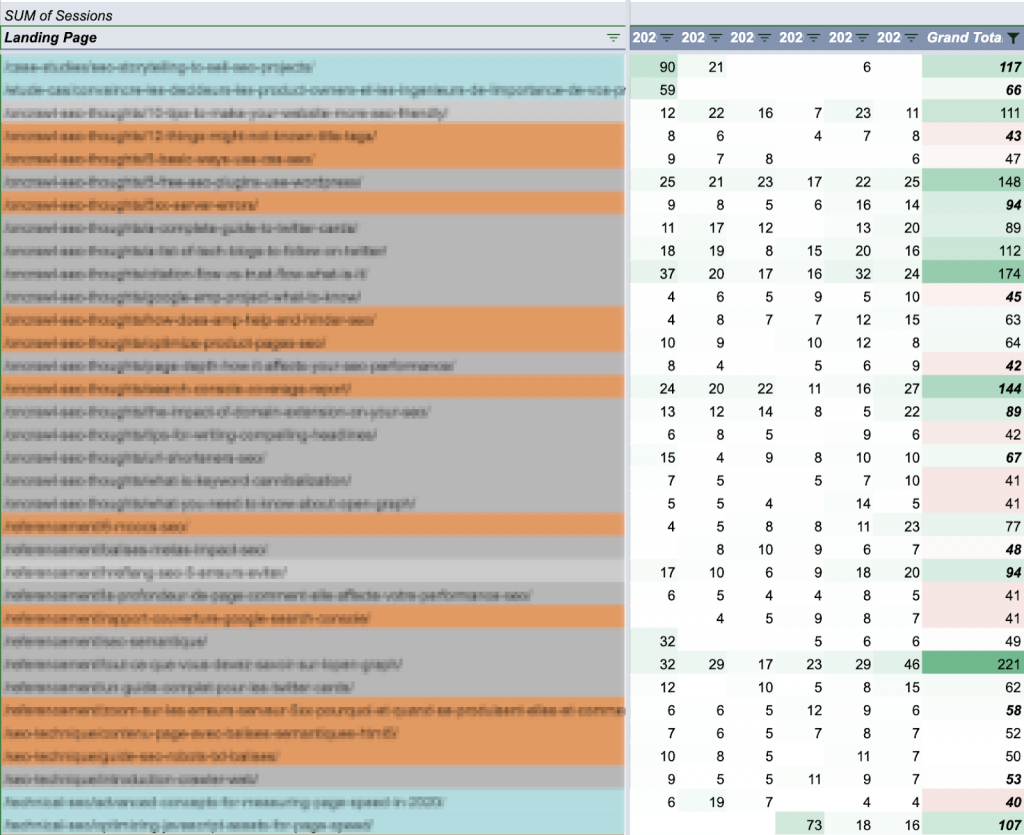

Użyłem tabeli przestawnej, aby wybrać każdy element treści (z sesjami w ciągu ostatnich 90 dni), który ma co najmniej jeden dzień anomalii w tym okresie:

W Arkuszach Google tabele przestawne nie mogą tworzyć więcej niż 100 kolumn. Stąd ograniczenie do 90 dni na tę analizę.

Sporządziłem mapę tej tabeli. (Idealnie chciałbym wykreślić całą 90-dniową krzywą dla każdego z tych artykułów, ale chciałbym również, aby arkusz odpowiadał, jeśli kliknę krzywą).

Utrzymywanie aktualnych informacji: Automatyzacja aktualizacji

Są tu trzy główne elementy:

- Linia bazowa

- Fragmenty treści, które chcesz śledzić

- Wykonanie tych fragmentów treści

Niestety żaden z nich nie jest statyczny.

Teoretycznie średnia wydajność będzie się zmieniać wraz z lepszym kierowaniem i promowaniem treści. Oznacza to, że co jakiś czas trzeba będzie ponownie obliczać linię bazową.

A jeśli Twoja witryna ma sezonowe szczyty i spadki, warto przyjrzeć się średnim z krótszych okresów czasu lub z tego samego okresu każdego roku, zamiast tworzyć połączenie, jak to zrobiliśmy tutaj.

Gdy publikujesz więcej treści, będziesz chciał również śledzić nowe treści.

A kiedy będziemy chcieli spojrzeć na datę sesji na przyszły tydzień, nie będziemy jej mieć.

Innymi słowy, ten model należy częściej lub rzadziej aktualizować. Istnieje wiele sposobów na zautomatyzowanie aktualizacji, zamiast przebudowywania całego narzędzia od podstaw za każdym razem, gdy chcesz się przyjrzeć.

Najłatwiejszym do wdrożenia jest prawdopodobnie zaplanowanie cotygodniowej aktualizacji sesji analitycznych i jednoczesne pobieranie nowych postów (wraz z datami ich publikacji).

Wykorzystywany przez nas raport Google Analytics można łatwo zaplanować, aby był uruchamiany automatycznie w regularnych odstępach czasu. Minusem jest to, że nadpisuje wcześniejsze raporty. Jeśli nie chcesz generować pełnego raportu i zarządzać nim, możesz ograniczyć go do krótszego okresu.

Dla moich celów odkryłem, że patrzenie na siedmiodniowe okno daje mi wystarczającą ilość informacji do pracy bez zbytniego przestarzałości.

Pilnowanie wiecznie zielonych postów poza 90-dniowym oknem

Korzystając z danych, które wygenerowaliśmy wcześniej, załóżmy, że udało się ustalić, że większość postów ma średnio około 50 sesji tygodniowo.

Dlatego warto mieć oko na każdy post, którego tygodniowe sesje przekraczają 50, niezależnie od daty publikacji:

Artykuły są pokolorowane według okresu publikacji: minione 90 dni (kolor niebieski), miniony rok (kolor pomarańczowy) i dziedzictwo (kolor szary). Sumy tygodniowe są oznaczone kolorami, porównując je z celem sesji 50.

Podział łącznej liczby sesji na dzień w tygodniu ułatwia szybkie rozróżnienie między wiecznie zielonymi postami o dość stałej wydajności a aktywnością opartą na zdarzeniach o nierównej wydajności:

![]()

Zawartość zimozielonej (stała wydajność ±20/dzień)

![]()

Prawdopodobna promocja zewnętrzna (ogólnie niska wydajność poza krótkoterminowym szczytem)

To, co zrobisz z tymi informacjami, będzie zależeć od Twojej strategii treści. Możesz pomyśleć o tym, w jaki sposób te posty konwertują potencjalnych klientów w Twojej witrynie lub porównać je z profilem linków zwrotnych.

Ograniczenia Arkuszy Google do analizy treści

Arkusze Google, jak zapewne już zauważyłeś, są niezwykle potężnym, ale ograniczonym narzędziem do tego rodzaju analizy. Te ograniczenia powodują, że wolałem nie udostępniać Ci szablonu: dostosowanie go do Twojego przypadku wymagałoby wiele pracy – ale wyniki, które możesz uzyskać, to nadal tylko przybliżenia namalowane szerokimi pociągnięciami.

Oto niektóre z głównych punktów, w których ten model nie działa:

- Jest zbyt wiele formuł.

Jeśli masz dużo (powiedzmy tysiące) aktywnych adresów URL treści, może to być bardzo powolne. W moich cotygodniowych skryptach aktualizacji zastępuję wiele formuł ich wartościami po ich obliczeniu, aby plik rzeczywiście odpowiadał, gdy otworzę go później do analizy. - Statyczna linia bazowa.

Wraz ze wzrostem wydajności mojej treści mam po prostu więcej elementów treści „nadmiernie skutecznych”. Wartość bazową należy przeliczać co kilka miesięcy, aby uwzględnić ewolucję. Można to łatwo rozwiązać za pomocą nienadzorowanego modelu uczenia maszynowego do obliczania średnich (lub nawet pominięcia tego kroku i bezpośredniej identyfikacji anomalii). - „Niedokładna” linia bazowa.

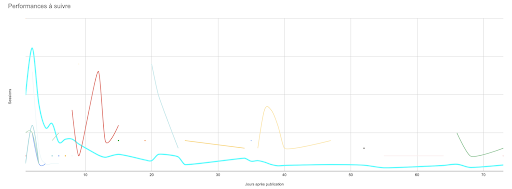

Linia bazowa nie uwzględnia zmian sezonowych ani incydentów w całej witrynie. Jest również bardzo wrażliwy na zdarzenia ekstremalne, szczególnie jeśli ograniczysz obliczenia do krótszego okresu:

Statystycznie nieprawidłowa analiza wartości odstających.

Zwłaszcza jeśli nie masz wielu sesji dziennie na element treści, twierdzenie, że różnica 10% od średniej oznacza, że niezwykła wydajność jest nieco pobieżna.

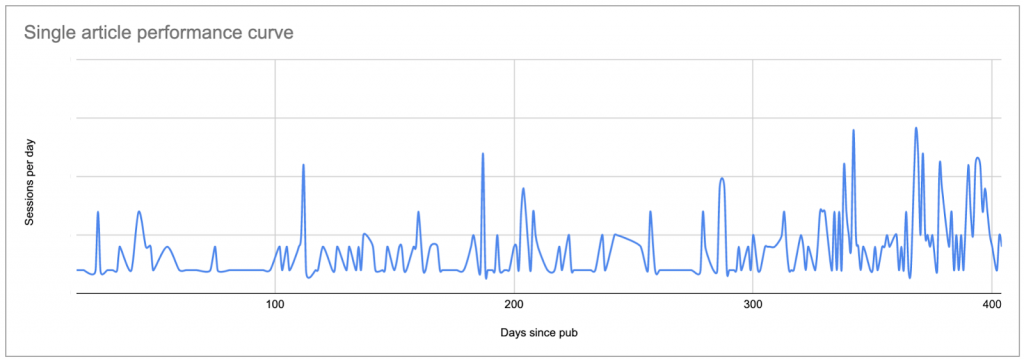

Dowolny limit do 90 dni analizy.

Każdy arbitralny limit jest problemem. W tym przypadku uniemożliwia mi to zrozumienie stale rosnącej wydajności treści i sprawia, że jestem ślepy na wszelkie szczyty ich wydajności – chociaż wiem z Google Analytics, że bardzo stare fragmenty od czasu do czasu przyciągają uwagę lub że niektóre artykuły stale przykuwają uwagę, gdy starzeją się. Nie jest to widoczne w narzędziu, ale dzieje się tak, jeśli narysujesz ich krzywą:

- Problemy z długością arkusza.

Niektóre z moich formuł i skryptów wymagają szeregu komórek. Wraz ze wzrostem witryny i wierszy w raporcie o sesjach zakresy te należy aktualizować. (Ale nie mogą przekroczyć liczby wierszy obecnych w arkuszu lub niektóre z nich powodują błędy). - Brak możliwości wykreślenia pełnych krzywych dla każdego fragmentu treści.

Chodź, chcę wszystko zobaczyć! - Ograniczona interaktywność z wynikami na wykresach.

Jeśli kiedykolwiek próbowałeś wskazać jeden punkt (lub krzywą) na wykresie z wieloma krzywymi w Arkuszach Google… wiesz, o czym mówię. Sytuacja jest jeszcze gorsza, gdy masz więcej niż dwadzieścia krzywych na tym samym wykresie, a kolory zaczynają wyglądać tak samo. - Możliwość przeoczenia słabych treści bez sesji.

Korzystając z metody, którą tu przedstawiłem, trudno jest zidentyfikować treści, które konsekwentnie nie mają sesji. Ponieważ nigdy nie pojawia się w raporcie Google Analytics, nie jest (jeszcze) odbierany w pozostałej części przepływu pracy. Treści, które stale nie są skuteczne, mają niewielką wartość, więc jeśli nie szukasz stron do przycinania, nieskuteczne treści prawdopodobnie nie mają swojego miejsca w raporcie skuteczności. - Niemożność dostosowania się do analizy w czasie rzeczywistym.

Chociaż ponowne uruchomienie skryptów raportowania, uśredniania i po aktualizacji nie jest szczególnie pracochłonne, nadal są to ręczne działania poza cotygodniową programowaną aktualizacją. Jeśli cotygodniowa aktualizacja jest w środę, a we wtorek pytasz mnie, jak się sprawy mają, nie mogę po prostu zajrzeć do arkusza. - Ograniczenia ekspansji.

Dodanie do tego raportu osi analizy — takiej jak ranking lub śledzenie słów kluczowych, a nawet opcji filtrowania według regionu geograficznego — byłoby uciążliwe. Nie tylko zaostrzyłoby to niektóre z istniejących problemów, ale byłoby również niezwykle trudne do zaimplementowania czytelnej, wykonalnej wizualizacji.

Konkluzja?

Uruchamianie tego samego typu obliczeń w środowisku uczenia maszynowego lub programistycznego rozwiązałoby prawie wszystkie te problemy. Byłby to znacznie lepszy sposób wykonywania półzłożonych operacji na dużym zestawie danych. Ponadto istnieją doskonałe biblioteki, które wykorzystują uczenie maszynowe do niezawodnego wykrywania anomalii na podstawie danego zestawu danych; istnieją lepsze narzędzia do wizualizacji danych.

Wyniki dotyczące wydajności treści

Analiza wydajności treści, nawet przy użyciu prymitywnych i wadliwych metod, wzmacnia ostrzeganie i podejmowanie decyzji w oparciu o dane w strategii treści.

Mówiąc konkretnie, zrozumienie wydajności treści pozwala:

- Zrozum wartość początkowych promocji w porównaniu z aktywnością z długiego ogona

- Szybko wykryj słabo działające posty

- Wykorzystaj zewnętrzne działania promocyjne, aby zwiększyć zasięg

- Łatwo rozpoznaj, co sprawia, że niektóre posty są tak skuteczne

- Zidentyfikuj określonych autorów lub określone tematy, które konsekwentnie przewyższają innych

- Określ, kiedy SEO zacznie mieć wpływ na sesje

Te dane, które napędzają świadome decyzje dotyczące promowania treści – oraz kiedy i jak –, wyborów tematycznych, profilowania odbiorców i nie tylko.

Eksperymenty takie jak ten pokazują, że każda domena, dla której można uzyskać dane, ma potencjalne zastosowanie do umiejętności kodowania, tworzenia skryptów i uczenia maszynowego. Ale nie musisz rezygnować z tworzenia własnych narzędzi, jeśli nie masz wszystkich tych umiejętności.