25 najlepszych narzędzi do indeksowania sieci do wydajnego wydobywania danych ze stron internetowych

Opublikowany: 2023-06-15Wprowadzenie do narzędzi indeksowania sieci

Narzędzia do indeksowania sieci, znane również jako pająki lub skrobaki sieciowe, są niezbędne dla firm, które chcą wyodrębnić cenne dane ze stron internetowych do celów analizy i eksploracji danych. Narzędzia te mają szeroki zakres zastosowań, od badań rynku po optymalizację wyszukiwarek (SEO). Zbierają dane z różnych źródeł publicznych i przedstawiają je w ustrukturyzowanym i użytecznym formacie. Korzystając z narzędzi do indeksowania sieci, firmy mogą śledzić wiadomości, media społecznościowe, obrazy, artykuły, konkurencję i wiele więcej.

25 najlepszych narzędzi do indeksowania sieci do szybkiego wyodrębniania danych ze stron internetowych

Zeskrobać

Scrapy to popularna platforma do indeksowania sieci oparta na Pythonie typu open source, która umożliwia programistom tworzenie skalowalnych robotów indeksujących. Oferuje kompleksowy zestaw funkcji, które ułatwiają wdrażanie robotów indeksujących i wyodrębnianie danych ze stron internetowych. Scrapy jest asynchroniczny, co oznacza, że nie wysyła żądań pojedynczo, ale równolegle, co skutkuje wydajnym indeksowaniem. Jako dobrze ugruntowane narzędzie do indeksowania sieci, Scrapy nadaje się do dużych projektów skrobania sieci.

Kluczowe cechy

- Generuje eksporty danych w formatach takich jak JSON, CSV i XML.

- Ma wbudowaną obsługę wybierania i wydobywania danych ze źródeł za pomocą wyrażeń XPath lub CSS.

- Umożliwia automatyczne pobieranie danych ze stron internetowych za pomocą pająków.

- Jest szybki i wydajny , ze skalowalną i odporną na błędy architekturą.

- Jest łatwo rozszerzalny , z systemem wtyczek i bogatym API.

- Jest przenośny , działa w systemach Linux, Windows, Mac i BSD.

cennik

- Jest to bezpłatne narzędzie.

ParseHub

ParseHub to narzędzie do przeszukiwania sieci, które może zbierać dane ze stron internetowych korzystających z technologii AJAX, JavaScript, plików cookie i innych. Jego technologia uczenia maszynowego może czytać, analizować, a następnie przekształcać dokumenty internetowe w odpowiednie dane. Aplikacja komputerowa ParseHub obsługuje systemy operacyjne Windows, Mac OS X i Linux. Oferując przyjazny dla użytkownika interfejs, ParseHub jest przeznaczony dla osób niebędących programistami, które chcą wyodrębnić dane ze stron internetowych.

Kluczowe cechy

- Może zeskrobać dynamiczne strony internetowe , które używają AJAX, JavaScript, nieskończonego przewijania, paginacji, list rozwijanych, logowania i innych elementów.

- Jest łatwy w użyciu i nie wymaga umiejętności kodowania.

- Jest oparty na chmurze i może przechowywać dane na swoich serwerach.

- Obsługuje rotację adresów IP , zaplanowane zbieranie , wyrażenia regularne , API i web-hooki.

- Może eksportować dane w formatach JSON i Excel .

cennik

- ParseHub ma zarówno darmowe, jak i płatne plany. Ceny płatnych planów zaczynają się od 149 USD miesięcznie i oferują ulepszone prędkości projektów, wyższy limit liczby stron zeskrobanych na przebieg oraz możliwość tworzenia większej liczby projektów.

ośmiornica

Octoparse to oparte na kliencie narzędzie do indeksowania sieci, które umożliwia użytkownikom wyodrębnianie danych sieciowych do arkuszy kalkulacyjnych bez konieczności kodowania. Dzięki interfejsowi „wskaż i kliknij”, Octoparse jest stworzony specjalnie dla osób niekodujących. Użytkownicy mogą tworzyć własne roboty indeksujące, aby zbierać dane z dowolnej witryny, a Octoparse zapewnia gotowe roboty zgarniające dla popularnych witryn, takich jak Amazon, eBay i Twitter. Narzędzie oferuje również zaawansowane funkcje, takie jak zaplanowana ekstrakcja do chmury, czyszczenie danych i omijanie blokowania za pomocą serwerów proxy IP.

Kluczowe cechy

- Interfejs typu „wskaż i kliknij” : Możesz łatwo wybrać elementy internetowe, które chcesz zeskrobać, klikając je, a Octoparse automatycznie zidentyfikuje wzorce danych i wyodrębni dane dla Ciebie.

- Tryb zaawansowany : możesz dostosować swoje zadania skrobania za pomocą różnych działań, takich jak wprowadzanie tekstu, klikanie przycisków, przewijanie stron, przeglądanie list itp. Możesz także użyć XPath lub RegEx, aby precyzyjnie zlokalizować dane.

- Usługa w chmurze : możesz uruchamiać swoje zadania skrobania na serwerach chmurowych Octoparse 24 godziny na dobę, 7 dni w tygodniu i przechowywać swoje dane na platformie chmurowej. Możesz także planować swoje zadania i korzystać z automatycznej rotacji adresów IP, aby uniknąć blokowania przez strony internetowe.

- API : Możesz uzyskać dostęp do swoich danych przez API i zintegrować je z innymi aplikacjami lub platformami. Możesz także przekształcić dowolne dane w niestandardowe interfejsy API za pomocą Octoparse.

cennik

- Ma zarówno darmowe, jak i płatne plany. Płatne plany zaczynają się od 89 USD miesięcznie.

WebHarvy

WebHarvy to oprogramowanie do skrobania stron internetowych typu „wskaż i kliknij”, przeznaczone dla osób niebędących programistami. Może automatycznie pobierać tekst, obrazy, adresy URL i e-maile ze stron internetowych i zapisywać je w różnych formatach, takich jak XML, CSV, JSON lub TSV. WebHarvy obsługuje również anonimowe indeksowanie i obsługę dynamicznych witryn internetowych, wykorzystując serwery proxy lub usługi VPN w celu uzyskania dostępu do docelowych witryn internetowych.

Kluczowe cechy

- Interfejs typu „wskaż i kliknij” do wybierania danych bez kodowania i skryptów

- Eksploracja wielu stron z automatycznym indeksowaniem i skrobaniem

- Skrobanie kategorii w celu zgarniania danych z podobnych stron lub list

- Pobieranie obrazu ze stron szczegółów produktu w witrynach handlu elektronicznego

- Automatyczne wykrywanie wzorców dla list zgarniających lub tabel bez dodatkowej konfiguracji

- Ekstrakcja oparta na słowach kluczowych poprzez przesyłanie wejściowych słów kluczowych do formularzy wyszukiwania

- Wyrażenia regularne dla większej elastyczności i kontroli nad skrobaniem

- Zautomatyzowana interakcja przeglądarki do wykonywania zadań, takich jak klikanie łączy, wybieranie opcji, przewijanie i nie tylko

cennik

- WebHarvy to oprogramowanie do skrobania stron internetowych, które ma jednorazową opłatę licencyjną.

- Ich ceny licencji zaczynają się od 139 USD za rok.

Piękna zupa

Beautiful Soup to biblioteka Pythona o otwartym kodzie źródłowym, używana do analizowania dokumentów HTML i XML. Tworzy drzewo analizy, które ułatwia wyodrębnianie danych z sieci. Chociaż nie tak szybki jak Scrapy, Beautiful Soup jest chwalony głównie za łatwość użytkowania i wsparcie społeczności w przypadku pojawienia się problemów.

Kluczowe cechy

- Parsowanie : Możesz użyć Beautiful Soup z różnymi parserami, takimi jak html.parser, lxml, html5lib itp., aby przeanalizować różne typy dokumentów internetowych.

- Nawigacja : Możesz poruszać się po drzewie analizy przy użyciu metod i atrybutów Pythona, takich jak find(), find_all(), select(), .children, .parent, .next_sibling itp.

- Wyszukiwanie : Możesz przeszukiwać drzewo analizy za pomocą filtrów, takich jak nazwy tagów, atrybuty, tekst, selektory CSS, wyrażenia regularne itp., aby znaleźć potrzebne elementy.

- Modyfikowanie : Możesz modyfikować drzewo analizy, dodając, usuwając, zamieniając lub edytując elementy i ich atrybuty.

cennik

Beautiful Soup to bezpłatna biblioteka typu open source, którą można zainstalować za pomocą pip.

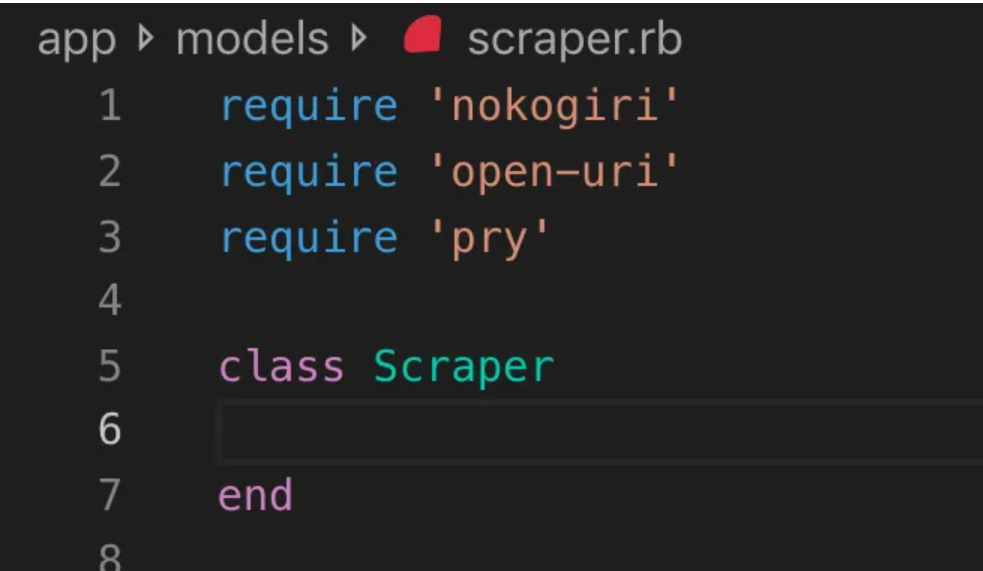

Nokogiri

Nokogiri to narzędzie do przeszukiwania sieci, które ułatwia analizowanie dokumentów HTML i XML za pomocą Ruby, języka programowania, który jest przyjazny dla początkujących w tworzeniu stron internetowych. Nokogiri opiera się na natywnych parserach, takich jak libxml2 języka C i xerces języka Java, co czyni go potężnym narzędziem do wydobywania danych ze stron internetowych. Doskonale nadaje się dla twórców stron internetowych, którzy chcą pracować z biblioteką do indeksowania sieci opartą na języku Ruby.

Kluczowe cechy

- Parser DOM dla XML, HTML4 i HTML5

- Parser SAX dla XML i HTML4

- Push Parser dla XML i HTML4

- Wyszukiwanie dokumentów za pomocą XPath 1.0

- Wyszukiwanie dokumentów za pomocą selektorów CSS3, z niektórymi rozszerzeniami podobnymi do jquery

- Walidacja schematu XSD

- Transformacja XSLT

- „Builder” DSL dla dokumentów XML i HTML

cennik

- Nokogiri to projekt typu open source, z którego można korzystać bezpłatnie.

Zyte (dawniej Scrapinghub)

Zyte (wcześniej Scrapinghub) to oparte na chmurze narzędzie do ekstrakcji danych, które pomaga tysiącom programistów pobierać cenne dane ze stron internetowych. Jego narzędzie do wizualnego skrobania o otwartym kodzie źródłowym pozwala użytkownikom na skrobanie stron internetowych bez wiedzy programistycznej. Zyte używa Crawlera, inteligentnego rotatora proxy, który obsługuje omijanie środków zaradczych botów w celu łatwego indeksowania dużych lub chronionych przez boty witryn i umożliwia użytkownikom indeksowanie z wielu adresów IP i lokalizacji bez problemów związanych z zarządzaniem proxy za pomocą prostego interfejsu API HTTP.

Kluczowe cechy

- Dane na żądanie: dostarczaj Zyte strony internetowe i wymagania dotyczące danych, a oni dostarczają żądane dane zgodnie z Twoim harmonogramem.

- Zyte AP I: automatycznie pobiera kod HTML ze stron internetowych przy użyciu najbardziej wydajnego serwera proxy i konfiguracji ekstrakcji, co pozwala skupić się na danych bez problemów technicznych.

- Scrapy Cloud : skalowalny hosting dla twoich pająków Scrapy, wyposażony w przyjazny dla użytkownika interfejs sieciowy do zarządzania, monitorowania i kontrolowania twoich robotów, wraz z narzędziami do monitorowania, rejestrowania i kontroli jakości danych.

- Interfejs API do automatycznej ekstrakcji danych : natychmiastowy dostęp do danych sieciowych za pośrednictwem interfejsu API do ekstrakcji opartego na sztucznej inteligencji firmy Zyte, szybko dostarczając ustrukturyzowane dane wysokiej jakości. Wdrażanie nowych źródeł staje się prostsze dzięki tej opatentowanej technologii.

cennik

Zyte ma elastyczny model cenowy, który zależy od złożoności i ilości potrzebnych danych. Możesz wybrać jeden z trzech planów:

- Deweloper: 49 USD miesięcznie za 250 000 żądań

- Biznes: 299 USD miesięcznie za 2 miliony żądań

- Enterprise: niestandardowe ceny dla ponad 10 milionów żądań

- Możesz także wypróbować Zyte za darmo z 10 000 żądań miesięcznie.

HTTrack

HTTrack to bezpłatne narzędzie do indeksowania sieci o otwartym kodzie źródłowym, które umożliwia użytkownikom pobieranie całych witryn lub określonych stron internetowych na ich urządzenie lokalne w celu przeglądania w trybie offline. Oferuje interfejs wiersza poleceń i może być używany w systemach Windows, Linux i Unix.

Kluczowe cechy

- Zachowuje względną strukturę linków oryginalnej witryny.

- Może aktualizować istniejącą witrynę lustrzaną i wznawiać przerwane pobieranie.

- Jest w pełni konfigurowalny i posiada zintegrowany system pomocy.

- Obsługuje różne platformy, takie jak Windows, Linux, OSX, Android itp.

- Ma wersję z wierszem poleceń i wersję z graficznym interfejsem użytkownika.

cennik

- HTTrack jest wolnym oprogramowaniem na licencji GNU GPL.

Apache Nutch

Apache Nutch to rozszerzalny robot indeksujący o otwartym kodzie źródłowym, często używany w dziedzinach takich jak analiza danych. Może pobierać zawartość za pośrednictwem protokołów, takich jak HTTPS, HTTP lub FTP, i wyodrębniać informacje tekstowe z formatów dokumentów, takich jak HTML, PDF, RSS i ATOM.

Kluczowe cechy

- Opiera się na strukturach danych Apache Hadoop, które doskonale nadają się do przetwarzania wsadowego dużych ilości danych.

- Ma wysoce modułową architekturę, umożliwiając programistom tworzenie wtyczek do analizowania multimediów, wyszukiwania danych, wykonywania zapytań i tworzenia klastrów.

- Obsługuje różne platformy, takie jak Windows, Linux, OSX, Android itp.

- Ma wersję z wierszem poleceń i wersję z graficznym interfejsem użytkownika.

- Integruje się z Apache Tika do analizowania, Apache Solr i Elasticsearch do indeksowania oraz Apache HBase do przechowywania.

cennik

- Apache Nutch to darmowe oprogramowanie licencjonowane na licencji Apache 2.0.

Skrobak helowy

Helium Scraper to wizualne narzędzie do indeksowania danych internetowych, które użytkownicy mogą dostosowywać i kontrolować bez konieczności kodowania. Oferuje zaawansowane funkcje, takie jak rotacja proxy, szybka ekstrakcja i obsługa wielu formatów danych, takich jak Excel, CSV, MS Access, MySQL, MSSQL, XML lub JSON.

Kluczowe cechy

- Szybka ekstrakcja : automatycznie deleguj zadania ekstrakcji do oddzielnych przeglądarek

- Big Data : Baza danych SQLite może pomieścić do 140 terabajtów

- Generowanie bazy danych : Relacje tabel są generowane na podstawie wyodrębnionych danych

- Generowanie SQL : Szybkie łączenie i filtrowanie tabel w celu eksportowania lub wprowadzania danych

- Wywoływanie interfejsu API : Zintegruj pobieranie danych z sieci i wywoływanie interfejsu API w jednym projekcie

- Manipulacja tekstem : Generuj funkcje dopasowujące, dzielące lub zastępujące wyodrębniony tekst

- Obsługa JavaScript: wstrzykiwanie i uruchamianie niestandardowego kodu JavaScript na dowolnej stronie internetowej

- Rotacja proxy : Wprowadź listę proxy i obracaj je w dowolnym przedziale czasu

- Wykrywanie podobnych pierwiastków : Wykrywa podobne pierwiastki z jednej lub dwóch próbek

- Wykrywanie list : Automatycznie wykrywaj listy i wiersze tabel na stronach internetowych

- Eksport danych : Eksportuj dane do CSV, Excel, XML, JSON lub SQLite

- Planowanie : uruchamiane z wiersza poleceń lub Harmonogramu zadań systemu Windows

cennik

- Podstawowa licencja kosztuje 99 USD za użytkownika.

Grabber treści (sequentum)

Content Grabber to oprogramowanie do indeksowania sieci przeznaczone dla przedsiębiorstw, umożliwiające użytkownikom tworzenie samodzielnych agentów do indeksowania sieci. Oferuje zaawansowane funkcje, takie jak integracja z aplikacjami do analizy danych lub raportowania innych firm, wydajne interfejsy do edycji skryptów i debugowania oraz obsługę eksportu danych do raportów Excel, XML, CSV i większości baz danych.

Kluczowe cechy

- Łatwy w użyciu interfejs typu „wskaż i kliknij” : Automatyczne wykrywanie działań na podstawie elementów HTML

- Solidny interfejs API : obsługuje łatwą integrację metodą „przeciągnij i upuść” z istniejącymi potokami danych

- Dostosowywanie : Dostosuj swoich agentów zgarniających za pomocą popularnych języków kodowania, takich jak Python, C#, JavaScript, wyrażenia regularne

- Integracja : integruj biblioteki AI, ML, NLP lub interfejsy API innych firm w celu wzbogacenia danych

- Niezawodność i skalowalność : obniż koszty infrastruktury, jednocześnie monitorując kompleksowe operacje w czasie rzeczywistym

- Zgodność z prawem : Zmniejsz swoją odpowiedzialność i ogranicz ryzyko związane z kosztownymi procesami sądowymi i karami regulacyjnymi

- Eksportowanie danych : Eksportuj dane do dowolnego formatu i dostarczaj do dowolnego punktu końcowego

- Planowanie : Uruchom agenty zgarniające z wiersza poleceń lub Harmonogramu zadań systemu Windows

cennik

- Licencja podstawowa kosztuje 27 500 USD rocznie i umożliwia korzystanie z oprogramowania na jednym komputerze.

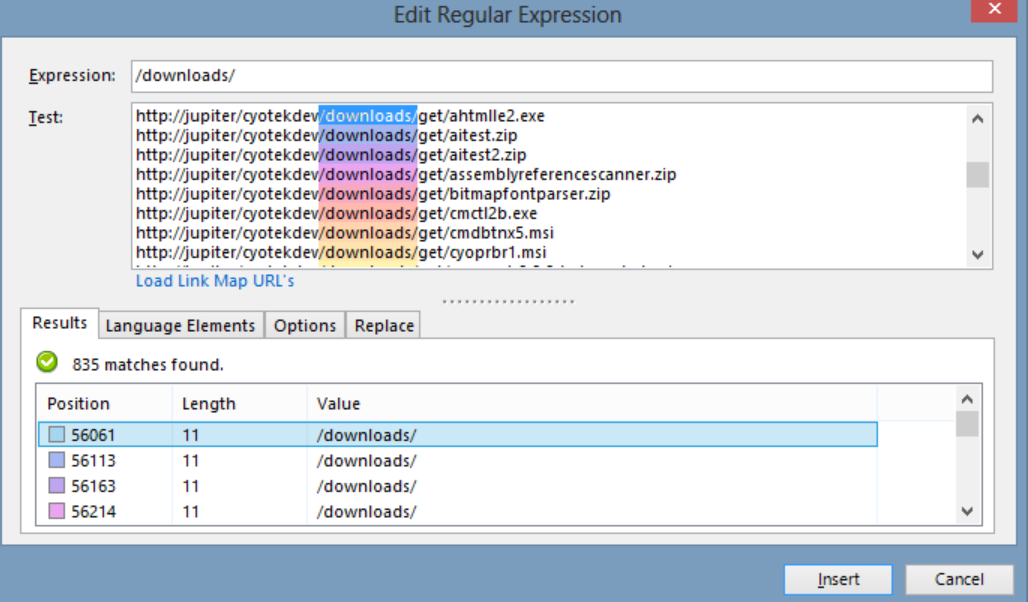

Cyotek WebCopy

Cyotek WebCopy to darmowy robot indeksujący strony internetowe, który pozwala użytkownikom kopiować częściowe lub pełne strony internetowe lokalnie na dysk twardy w celu przeglądania w trybie offline. Może wykrywać i podążać za linkami w witrynie oraz automatycznie mapować linki, aby pasowały do ścieżki lokalnej. Jednak WebCopy nie zawiera wirtualnego DOM ani żadnej formy parsowania JavaScript, więc może nieprawidłowo obsługiwać dynamiczne układy stron internetowych z powodu intensywnego używania JavaScript.

Kluczowe cechy

- Łatwy w użyciu interfejs typu „wskaż i kliknij” z automatycznym wykrywaniem akcji na podstawie elementów HTML

- Solidny interfejs API do bezproblemowej integracji z istniejącymi potokami danych dzięki prostej funkcji „przeciągnij i upuść”.

- Opcje dostosowywania przy użyciu popularnych języków kodowania, takich jak Python, C#, JavaScript i wyrażenia regularne, aby dostosować agenty zgarniające do określonych potrzeb

- Możliwości integracji z zewnętrznymi bibliotekami AI, ML, NLP lub API w celu wzbogacenia pozyskanych danych

- Niezawodna i skalowalna infrastruktura z monitorowaniem w czasie rzeczywistym dla opłacalnych operacji

- Funkcje zgodności z prawem w celu zmniejszenia odpowiedzialności i ograniczenia ryzyka pozwów sądowych i kar ustawowych

- Eksport danych do dowolnego formatu i dostarczanie do różnych punktów końcowych

- Opcje planowania umożliwiają uruchamianie agentów zgarniających z wiersza poleceń lub Harmonogramu zadań systemu Windows

cennik

- Licencja podstawowa kosztuje 27 500 USD rocznie i umożliwia korzystanie z oprogramowania na jednym komputerze.

80 nóg

80legs to potężne narzędzie do indeksowania sieci, które można skonfigurować w oparciu o niestandardowe wymagania. Obsługuje pobieranie dużych ilości danych wraz z opcją natychmiastowego pobierania wyodrębnionych danych. Narzędzie oferuje interfejs API umożliwiający użytkownikom tworzenie robotów indeksujących, zarządzanie danymi i nie tylko. Niektóre z jego głównych funkcji obejmują dostosowywanie skrobaków, serwery IP do żądań skrobania stron internetowych oraz platformę aplikacji opartą na JS do konfigurowania indeksowania sieci z niestandardowymi zachowaniami.

Kluczowe cechy

- Skalowalność i szybkość : możesz indeksować do 2 miliardów stron dziennie przy ponad 50 000 jednoczesnych żądań.

- Elastyczność i możliwość dostosowania: możesz użyć własnego kodu do sterowania logiką indeksowania i wyodrębniania danych lub skorzystać z wbudowanych narzędzi i szablonów.

cennik

- Możesz wybierać spośród różnych planów cenowych w zależności od potrzeb, od 29 USD miesięcznie za 100 000 adresów URL/indeksowanie do 299 USD miesięcznie za 10 milionów adresów URL/indeksowanie.

Webhose.io

Webhose.io umożliwia użytkownikom uzyskiwanie danych w czasie rzeczywistym poprzez indeksowanie źródeł online z całego świata i prezentowanie ich w różnych przejrzystych formatach. To narzędzie do przeszukiwania sieci może przeszukiwać dane i dalej wyodrębniać słowa kluczowe w różnych językach przy użyciu wielu filtrów obejmujących szeroki wachlarz źródeł. Użytkownicy mogą zapisywać zeskrobane dane w formatach XML, JSON i RSS oraz uzyskiwać dostęp do danych historycznych z archiwum. Webhose.io obsługuje do 80 języków dzięki wynikom indeksowania danych, umożliwiając użytkownikom łatwe indeksowanie i przeszukiwanie uporządkowanych danych indeksowanych przez narzędzie.

Kluczowe cechy

- Wiele formatów : możesz uzyskać dane w formatach XML, JSON, RSS lub Excel.

- Ustrukturyzowane wyniki : możesz uzyskać dane, które są znormalizowane, wzbogacone i skategoryzowane zgodnie z Twoimi potrzebami.

- Dane historyczne : Możesz uzyskać dostęp do zarchiwizowanych danych z ostatnich 12 miesięcy lub więcej.

- Szeroki zasięg : możesz uzyskać dane z ponad miliona źródeł w 80 językach i 240 krajach.

- Różnorodne źródła : możesz uzyskiwać dane z serwisów informacyjnych, blogów, forów, forów dyskusyjnych, komentarzy, recenzji i nie tylko.

- Szybka integracja : Możesz zintegrować Webhose.io ze swoimi systemami w ciągu kilku minut za pomocą prostego interfejsu API REST.

cennik

- Ma bezpłatny plan, który pozwala na składanie 1000 żądań miesięcznie bez żadnych kosztów. Ma również niestandardowe plany, z którymi możesz się skontaktować w celu uzyskania wyceny.

Mozenda

Mozenda to oparte na chmurze oprogramowanie do skrobania stron internetowych, które umożliwia użytkownikom wyodrębnianie danych internetowych bez pisania ani jednego wiersza kodu. Automatyzuje proces ekstrakcji danych i oferuje takie funkcje, jak zaplanowana ekstrakcja danych, czyszczenie danych i omijanie blokowania za pomocą serwerów proxy IP. Mozenda jest przeznaczona dla firm, z przyjaznym dla użytkownika interfejsem i potężnymi możliwościami skrobania.

Kluczowe cechy

- Analiza tekstu: Możesz wydobywać i analizować dane tekstowe z dowolnej witryny internetowej za pomocą technik przetwarzania języka naturalnego.

- Ekstrakcja obrazu: Możesz pobierać i zapisywać obrazy ze stron internetowych lub wyodrębniać metadane obrazu, takie jak rozmiar, format, rozdzielczość itp.

- Zbieranie różnych danych: Możesz zbierać dane z wielu źródeł i formatów, takich jak HTML, XML, JSON, RSS itp.

- Ekstrakcja dokumentów: Możesz wyodrębniać dane z plików PDF, Word, Excel i innych typów dokumentów za pomocą metod optycznego rozpoznawania znaków (OCR) lub ekstrakcji tekstu.

- Wyodrębnianie adresów e-mail : Możesz wyszukiwać i wyodrębniać adresy e-mail ze stron internetowych lub dokumentów za pomocą wyrażeń regularnych lub dopasowywania wzorców.

cennik

- Płatny plan zaczyna się od 99 USD miesięcznie.

UiPath

UiPath to oprogramowanie do automatyzacji procesów robotycznych (RPA) do bezpłatnego przeglądania stron internetowych. Automatyzuje indeksowanie danych internetowych i stacjonarnych z większości aplikacji innych firm. Kompatybilny z systemem Windows, UiPath może wydobywać dane tabelaryczne i oparte na wzorach na wielu stronach internetowych. Oprogramowanie oferuje również wbudowane narzędzia do dalszego indeksowania i obsługi złożonych interfejsów użytkownika.

Kluczowe cechy

- Analiza tekstu : wyodrębniaj i analizuj dane tekstowe przy użyciu przetwarzania języka naturalnego, wyrażeń regularnych i dopasowywania wzorców do zadań takich jak wyodrębnianie adresów e-mail.

- Ekstrakcja obrazu : pobieraj i zapisuj obrazy ze stron internetowych, wyodrębniaj metadane obrazu, w tym rozmiar, format i rozdzielczość.

- Zbieranie różnych danych : zbieraj dane z różnych źródeł i formatów, takich jak HTML, XML, JSON, RSS, z możliwością integracji w celu łączenia się z innymi usługami online i interfejsami API.

- Ekstrakcja dokumentów : Wyodrębniaj dane z plików PDF, Word, Excel i innych typów dokumentów za pomocą OCR lub metod ekstrakcji tekstu. Przetwarzaj i wyodrębniaj informacje z różnych typów dokumentów i struktur dzięki funkcjom rozumienia dokumentów.

- Automatyzacja sieci : Zautomatyzuj działania oparte na sieci, takie jak logowanie, poruszanie się po stronach, wypełnianie formularzy, klikanie przycisków. Wykorzystaj funkcję rejestratora do przechwytywania działań i generowania skryptów automatyzacji.

cennik

- Zapłacony plan zaczyna się od 420 $ miesięcznie.

Centrum OutWit

OutWit Hub to dodatek do Firefoksa z dziesiątkami funkcji ekstrakcji danych, które upraszczają wyszukiwanie w Internecie. To narzędzie do przeszukiwania sieci może przeglądać strony i przechowywać wyodrębnione informacje w odpowiednim formacie. OutWit Hub oferuje pojedynczy interfejs do skrobania niewielkich lub ogromnych ilości danych na potrzeby i może tworzyć automatycznych agentów do pobierania danych z różnych stron internetowych w ciągu kilku minut.

Kluczowe cechy

- Wyświetlanie i eksportowanie treści internetowych: Możesz przeglądać łącza, dokumenty, obrazy, kontakty, tabele danych, kanały RSS, adresy e-mail i inne elementy zawarte na stronie internetowej. Możesz także wyeksportować je do HTML, SQL, CSV, XML, JSON lub innych formatów.

- Porządkowanie danych w tabelach i na listach: Możesz sortować, filtrować, grupować i edytować dane zebrane w tabelach i na listach. Możesz także użyć wielu kryteriów, aby wybrać dane, które chcesz wyodrębnić.

- Skonfiguruj zautomatyzowane funkcje : możesz użyć funkcji skrobaka do tworzenia niestandardowych skrobaków, które mogą wyodrębniać dane z dowolnej witryny za pomocą prostych lub zaawansowanych poleceń. Możesz także użyć funkcji makr, aby zautomatyzować zadania przeglądania sieci i skrobania.

- Generuj zapytania i adresy URL: Możesz użyć funkcji zapytania do generowania zapytań na podstawie słów kluczowych lub wzorców. Możesz także użyć funkcji adresu URL do generowania adresów URL na podstawie wzorców lub parametrów.

cennik

- Licencja Light jest bezpłatna iw pełni funkcjonalna, ale nie obejmuje funkcji automatyzacji i ogranicza ekstrakcję do jednego lub kilkuset wierszy, w zależności od ekstraktora.

- Licencja Pro kosztuje 110 USD rocznie i obejmuje wszystkie funkcje licencji Light, a także funkcje automatyzacji i nieograniczoną ekstrakcję.

Skrobak wizualny

Visual Scraper, oprócz tego, że jest platformą SaaS, oferuje również usługi web scrapingu, takie jak usługi dostarczania danych i tworzenie ekstraktorów oprogramowania dla klientów. To narzędzie do indeksowania sieci obejmuje cały cykl życia robota, od pobierania, zarządzania adresami URL po wyodrębnianie treści. Pozwala użytkownikom zaplanować uruchamianie projektów w określonych porach lub powtarzać sekwencje co minutę, dzień, tydzień, miesiąc lub rok. Visual Scraper jest idealny dla użytkowników, którzy chcą często wyodrębniać wiadomości, aktualizacje i fora. Jednak oficjalna strona wydaje się nie być teraz aktualizowana, a te informacje mogą być nieaktualne.

Kluczowe cechy

- Łatwy w użyciu interfejs

- Obsługuje wiele formatów danych (CSV, JSON, XML itp.)

- Obsługuje paginację, AJAX i dynamiczne strony internetowe

- Obsługuje serwery proxy i rotację adresów IP

- Obsługuje planowanie i automatyzację

cennik

- Ma bezpłatny plan i płatne plany od 39,99 USD miesięcznie.

Importuj.io

Import.io to narzędzie do skrobania stron internetowych, które umożliwia użytkownikom importowanie danych z określonej strony internetowej i eksportowanie ich do pliku CSV bez pisania kodu. Może z łatwością zeskrobać tysiące stron internetowych w ciągu kilku minut i zbudować ponad 1000 interfejsów API w oparciu o wymagania użytkowników. Import.io integruje dane internetowe z aplikacją lub stroną internetową użytkownika za pomocą zaledwie kilku kliknięć, ułatwiając przeglądanie sieci.

Kluczowe cechy

- Wybór i szkolenie typu „wskaż i kliknij”.

- Uwierzytelniona i interaktywna ekstrakcja

- Pobieranie obrazów i zrzuty ekranu

- Proxy premium i ekstraktory specyficzne dla kraju

- Wyjście CSV, Excel, JSON i dostęp do API

- Jakość danych SLA i raportowanie

- Wsparcie przez e-mail, bilety, czat i telefon

cennik

- Starter: 199 USD miesięcznie za 5000 zapytań

Dexi.io

Dexi.io to oparty na przeglądarce robot indeksujący, który umożliwia użytkownikom pobieranie danych z dowolnej przeglądarki w oparciu o ich przeglądarkę i zapewnia trzy rodzaje robotów do tworzenia zadań zgarniających – Extractor, Crawler i Pipes. Darmowe oprogramowanie zapewnia anonimowe internetowe serwery proxy, a wyodrębnione dane będą hostowane na serwerach Dexi.io przez dwa tygodnie, zanim dane zostaną zarchiwizowane, lub użytkownicy będą mogli bezpośrednio wyeksportować wyodrębnione dane do plików JSON lub CSV. Oferuje płatne usługi dla użytkowników, którzy wymagają ekstrakcji danych w czasie rzeczywistym.

Kluczowe cechy

- Wybór i szkolenie typu „wskaż i kliknij”.

- Uwierzytelniona i interaktywna ekstrakcja

- Pobieranie obrazów i zrzuty ekranu

- Proxy premium i ekstraktory specyficzne dla kraju

- Wyjście CSV, Excel, JSON i dostęp do API

- Jakość danych SLA i raportowanie

- Wsparcie przez e-mail, bilety, czat i telefon

cennik

- Standard: 119 USD miesięcznie lub 1950 USD rocznie na 1 pracownika

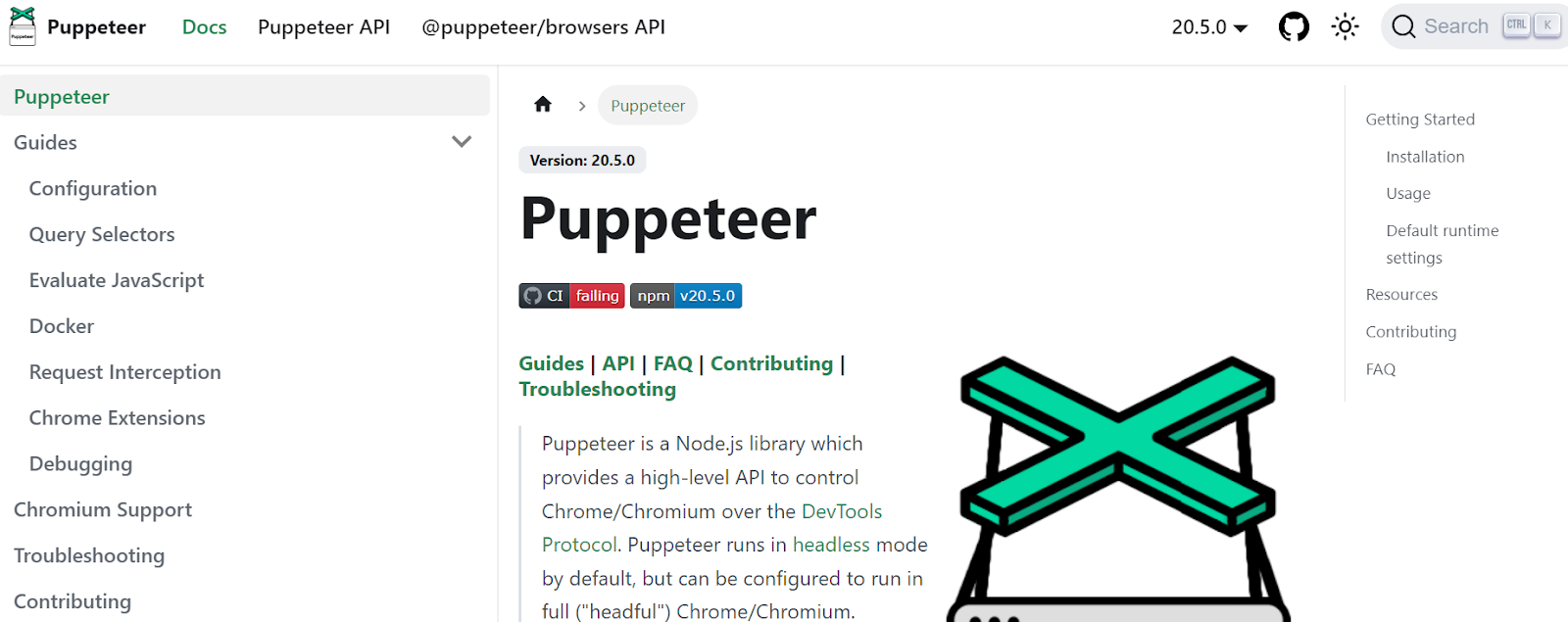

Lalkarz

Puppeteer to biblioteka Node opracowana przez Google, zapewniająca programistom API do kontrolowania Chrome lub Chromium za pośrednictwem protokołu DevTools. Umożliwia użytkownikom zbudowanie narzędzia do skrobania stron internetowych za pomocą Puppeteer i Node.js. Puppeteer może być wykorzystywany do różnych celów, takich jak robienie zrzutów ekranu lub generowanie plików PDF stron internetowych, automatyzacja przesyłania formularzy/wprowadzania danych oraz tworzenie narzędzi do automatycznego testowania.

Kluczowe cechy

- Generuj zrzuty ekranu i pliki PDF stron internetowych

- Indeksuj i zbieraj dane ze stron internetowych

- Zautomatyzuj przesyłanie formularzy, testowanie interfejsu użytkownika, wprowadzanie danych z klawiatury itp.

- Przechwytuj metryki i ślady wydajności

- Przetestuj rozszerzenia Chrome

- Biegaj w trybie headless lub headful

cennik

- Puppeteer jest darmowy i open-source.

Crawler4j

Crawler4j to robot indeksujący Java typu open source z prostym interfejsem do indeksowania sieci. Pozwala użytkownikom budować wielowątkowe roboty indeksujące, jednocześnie wydajnie wykorzystując pamięć. Crawler4j jest odpowiedni dla programistów, którzy chcą prostego i konfigurowalnego rozwiązania do przeszukiwania sieci opartego na języku Java.

Kluczowe cechy

- Pozwala określić, które adresy URL mają być indeksowane, a które ignorowane za pomocą wyrażeń regularnych.

- Pozwala obsłużyć pobrane strony i wyodrębnić z nich dane.

- Respektuje protokół robots.txt i unika indeksowania niedozwolonych stron.

- Może indeksować HTML, obrazy i inne typy plików.

- Może zbierać statystyki i uruchamiać wiele robotów indeksujących jednocześnie.

cennik

- Crawler4j to projekt Java o otwartym kodzie źródłowym, który umożliwia łatwe konfigurowanie i uruchamianie własnych robotów indeksujących.

Wspólne czołganie się

Common Crawl to narzędzie do przeszukiwania sieci, które zapewnia otwarty zbiór danych internetowych do celów badawczych, analitycznych i edukacyjnych.

Kluczowe cechy

- Oferuje użytkownikom dostęp do danych przeszukiwania sieci, takich jak nieprzetworzone dane stron internetowych, wyodrębnione metadane i tekst, a także do Common Crawl Index.

cennik

- Te bezpłatne i publicznie dostępne dane indeksowania sieci mogą być wykorzystywane przez programistów, badaczy i firmy do różnych zadań związanych z analizą danych.

Zupa Mechaniczna

MechanicalSoup to biblioteka Pythona służąca do analizowania stron internetowych, oparta na bibliotece Beautiful Soup, inspirowana biblioteką Mechanize. Świetnie nadaje się do przechowywania plików cookie, śledzenia przekierowań, hiperłączy i obsługi formularzy na stronie internetowej.

Kluczowe cechy

- MechanicalSoup oferuje prosty sposób przeglądania i wydobywania danych ze stron internetowych bez konieczności wykonywania skomplikowanych zadań programistycznych.

cennik

- Jest to bezpłatne narzędzie.

Przeszukiwacz węzłów

Node Crawler to popularny i potężny pakiet do indeksowania stron internetowych za pomocą platformy Node.js. Działa w oparciu o Cheerio i oferuje wiele opcji dostosowywania sposobu, w jaki użytkownicy przeszukują lub przeszukują sieć, w tym ograniczanie liczby żądań i czasu między nimi. Node Crawler jest idealny dla programistów, którzy wolą pracować z Node.js w swoich projektach indeksowania sieci.

Kluczowe cechy

- Łatwy w użyciu

- Interfejs API sterowany zdarzeniami

- Konfigurowalne ponawiania prób i limity czasu

- Automatyczne wykrywanie kodowania

- Automatyczna obsługa plików cookie

- Automatyczna obsługa przekierowań

- Automatyczna obsługa gzip/deflate

cennik

- Jest to bezpłatne narzędzie.

Czynniki, które należy wziąć pod uwagę przy wyborze narzędzia do indeksowania sieci

cennik

Przeanalizuj strukturę cenową wybranego narzędzia i upewnij się, że jest przejrzysta, bez ukrytych kosztów. Wybierz firmę, która oferuje przejrzysty model cenowy i dostarcza szczegółowych informacji na temat dostępnych funkcji.

Łatwość użycia

Wybierz narzędzie do indeksowania sieci, które jest przyjazne dla użytkownika i nie wymaga rozległej wiedzy technicznej. Wiele narzędzi oferuje interfejsy typu „wskaż i kliknij”, ułatwiając osobom niebędącym programistami pobieranie danych ze stron internetowych.

Skalowalność

Zastanów się, czy narzędzie do indeksowania sieci może obsłużyć ilość danych, które musisz wyodrębnić, i czy może rosnąć wraz z Twoją firmą. Niektóre narzędzia są bardziej odpowiednie do projektów na małą skalę, podczas gdy inne są przeznaczone do ekstrakcji danych na dużą skalę.

Jakość i dokładność danych

Upewnij się, że narzędzie do indeksowania sieci może wyczyścić i uporządkować wyodrębnione dane w użytecznym formacie. Jakość danych ma kluczowe znaczenie dla dokładnej analizy, więc wybierz narzędzie, które zapewnia wydajne czyszczenie i organizację danych.

Obsługa klienta

Wybierz narzędzie do indeksowania sieci z responsywną i pomocną obsługą klienta, która pomoże Ci w razie problemów. Przetestuj obsługę klienta, kontaktując się z nim i obserwując, ile czasu zajmuje im odpowiedź przed podjęciem świadomej decyzji.

Wniosek

Narzędzia do indeksowania sieci są niezbędne dla firm, które chcą wydobywać cenne dane ze stron internetowych do różnych celów, takich jak badanie rynku, SEO i analiza konkurencji. Biorąc pod uwagę takie czynniki, jak cena, łatwość obsługi, skalowalność, jakość i dokładność danych oraz obsługa klienta, możesz wybrać odpowiednie narzędzie do indeksowania sieci, które odpowiada Twoim potrzebom. Wspomniane powyżej 25 najlepszych narzędzi do indeksowania sieci jest przeznaczone dla różnych użytkowników, od osób niebędących programistami po programistów, dzięki czemu każdy znajdzie odpowiednie narzędzie. Możesz także zarejestrować się na 7-dniowy bezpłatny okres próbny w Scalenut, aby zoptymalizować zawartość witryny i poprawić pozycję w rankingu.