57 częstych błędów w testach A/B i jak ich uniknąć

Opublikowany: 2021-06-15

Czy przeprowadzasz testy A/B, ale nie masz pewności, czy działają prawidłowo?

Czy chcesz poznać typowe błędy podczas testów A/B, aby nie tracić cennego czasu na zepsutą kampanię?

Dobra wiadomość! W tym artykule przeprowadzimy Cię przez 57 powszechnych (i czasami rzadkich) błędów testów A/B, które widzimy, dzięki czemu możesz je ominąć lub zorientować się, kiedy się pojawiają i szybko je naprawić.

Podzieliliśmy je na 3 kluczowe sekcje:

- Błędy przed rozpoczęciem testów,

- Problemy, które mogą wystąpić podczas testu,

- I błędy, które możesz popełnić po zakończeniu testu.

Możesz po prostu przeczytać i zobaczyć, czy sam coś robisz.

I pamiętaj:

Każda awaria jest cenną lekcją, zarówno w testowaniu, jak i błędach konfiguracyjnych. Kluczem jest uczenie się od nich!

Zanurzmy się więc w…

- Typowe błędy w testach A/B, które można popełnić jeszcze przed uruchomieniem testu

- #1. Pchanie czegoś na żywo przed testowaniem!

- #2. Brak rzeczywistego testu A/B

- #3. Nie testuję, aby sprawdzić, czy narzędzie działa

- #4. Korzystanie z narzędzia niskiej jakości i flashowanie treści

- #5. Brak testowej kontroli jakości

- #6. Czy nowe leczenie/wariacja działa?

- 7. Nie podążanie za hipotezą i po prostu testowanie starych rzeczy

- #8. Posiadanie niesprawdzalnej hipotezy

- #9. Nie wyznaczanie z góry jasnego celu testu

- #10. Koncentrowanie się na powierzchownych metrykach

- # 11. Wykorzystywanie danych ilościowych tylko do tworzenia pomysłów na testy

- #12. Kopiowanie konkurencji

- #13. Testowanie tylko „najlepszych praktyk branżowych”

- # 14. Koncentrowanie się najpierw na zadaniach o małym wpływie, gdy dostępne są duże nagrody / nisko wiszące owoce o dużym wpływie

- #15. Testowanie wielu rzeczy na raz i niewiedza, która zmiana spowodowała rezultat

- #16. Nieprzeprowadzenie prawidłowej analizy przed testem

- #17. Błędne oznaczenie testów

- #18. Uruchamianie testów z niewłaściwym adresem URL

- # 19. Dodawanie arbitralnych reguł wyświetlania do testu

- #20. Testowanie niewłaściwego ruchu dla Twojego celu

- #21. Niewykluczenie powracających odwiedzających z testu i wypaczenie wyników

- #22. Nie usuwam swoich adresów IP z testu

- #23. Brak segmentacji odmian grupy kontrolnej (efekt sieciowy)

- #24. Przeprowadzanie testów podczas wydarzeń sezonowych lub ważnych wydarzeń w witrynie/platformie

- #25. Ignorowanie różnic kulturowych

- #26. Prowadzenie wielu połączonych kampanii jednocześnie

- #27. Nierówne ważenie ruchu

- Typowe błędy w testach A/B, które możesz popełnić podczas testu

- #28. Nie działa wystarczająco długo, aby uzyskać dokładne wyniki

- #29. Monitorowanie/podglądanie helikoptera

- #30. Brak śledzenia opinii użytkowników (szczególnie ważne, jeśli test wpływa na bezpośrednie, natychmiastowe działanie)

- # 31. Wprowadzanie zmian w trakcie testu

- #32. Zmiana alokacji ruchu % w trakcie testu lub usuwanie słabych wyników

- #33. Nie przerywanie testu, gdy masz dokładne wyniki

- #34. Bycie emocjonalnie zainwestowanym w utratę wariacji

- #35. Zbyt długie przeprowadzanie testów i brak śledzenia

- #36. Nie używanie narzędzia, które pozwala zatrzymać/wdrożyć test!

- Typowe błędy w testach A/B, które możesz popełnić po zakończeniu testu

- #37. Rezygnacja po jednym teście!

- #38. Rezygnacja z dobrej hipotezy przed przetestowaniem wszystkich jej wersji

- #39. Cały czas spodziewasz się ogromnych wygranych

- #40. Nie sprawdzanie ważności po teście

- #41. Nieprawidłowe odczytywanie wyników

- #42. Nie patrzenie na wyniki według segmentów

- #43. Nie uczenie się na podstawie wyników

- #44. Zabieranie przegranych

- #45. Niepodejmowanie działań w związku z wynikami

- #46. Brak iteracji i poprawy na wygranych

- #47. Nie udostępnianie zwycięskich wyników w innych obszarach lub działach

- #48. Nie testowanie tych zmian w innych działach

- #49. Za dużo iteracji na jednej stronie

- #50. Testowanie za mało!

- #51. Nie dokumentowanie testów

- #52. Zapominając o fałszywych alarmach i nie sprawdzając dwukrotnie dużych kampanii wzrostowych

- #53. Brak śledzenia wyników downline

- #54. Nie uwzględniać efektów prymatu i nowości, które mogą wpływać na wyniki leczenia

- #55. Bieżące zmiany okresu rozpatrywania wniosków

- #56. Brak ponownego testowania po X czasie

- #57. Testowanie tylko ścieżki, a nie produktu

- Wniosek

Typowe błędy w testach A/B, które można popełnić jeszcze przed uruchomieniem testu

#1. Pchanie czegoś na żywo przed testowaniem!

Możesz mieć fantastyczną nową stronę lub projekt witryny i naprawdę chcesz ją opublikować bez testowania.

Powstrzymać!

Najpierw uruchom szybki test, aby zobaczyć, jak to działa. Nie chcesz wprowadzać radykalnych zmian na żywo bez uzyskania pewnych danych, ponieważ możesz stracić sprzedaż i konwersje.

Czasami ta nowa zmiana może oznaczać znaczny spadek wydajności. Więc najpierw przetestuj go.

#2. Brak rzeczywistego testu A/B

Test A/B działa poprzez uruchomienie pojedynczego źródła ruchu na stronę kontrolną i odmianę tej strony. Celem jest sprawdzenie, czy wprowadzona zmiana sprawia, że odbiorcy lepiej konwertują i podejmują działania.

Chodzi o to, aby upewnić się, że ten test jest kontrolowany i uczciwy, musimy przeprowadzić ten test z określonymi parametrami. Potrzebujemy tych samych źródeł ruchu oglądających kampanię w tym samym czasie, aby nie mieć żadnych zewnętrznych czynników wpływających na jeden test, a nie na drugi.

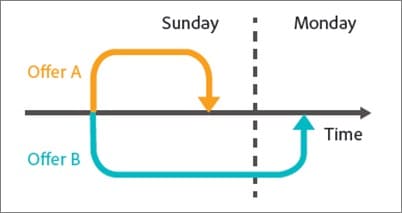

Niektórzy popełniają błąd polegający na wykonywaniu testu po kolei. Uruchamiają swoją obecną stronę przez X czasu, a następnie nową wersję przez X, a następnie mierzą różnicę.

Te wyniki nie są całkowicie dokładne, ponieważ wiele rzeczy mogło się wydarzyć podczas tych okien testowych. Możesz uzyskać nowy ruch, zorganizować wydarzenie, powodując, że dwie strony będą miały bardzo różnych odbiorców i wyniki.

Upewnij się więc, że przeprowadzasz rzeczywisty test A/B, w którym dzielisz ruch między dwie wersje i testujesz je dokładnie w tym samym czasie.

#3. Nie testuję, aby sprawdzić, czy narzędzie działa

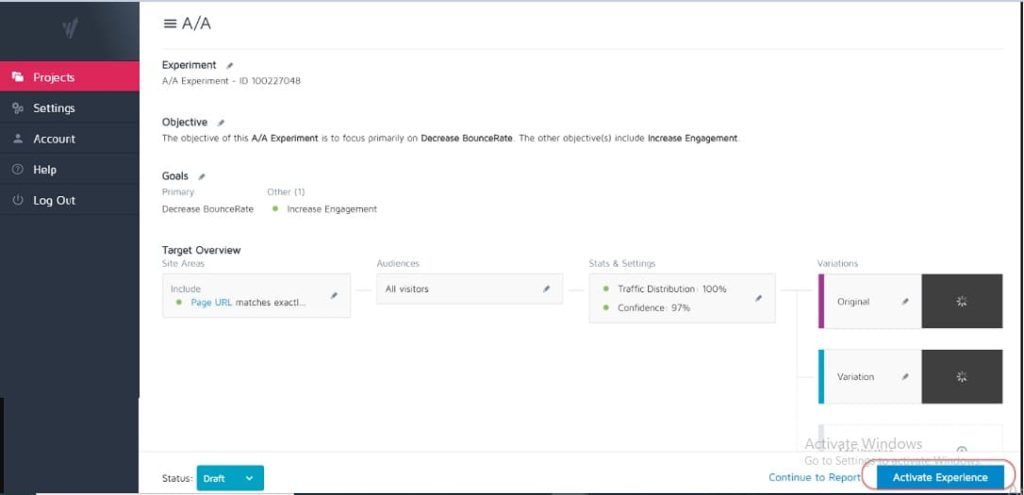

Żadne narzędzie testowe nie jest w 100% dokładne. Najlepszą rzeczą, jaką możesz zrobić na początku, jest przeprowadzenie testu A/A, aby sprawdzić, jak precyzyjne jest Twoje narzędzie.

Jak? Po prostu uruchom test, w którym dzielisz ruch 50:50 między jedną stronę. (Upewnij się, że jest to strona, na której Twoi odbiorcy mogą dokonać konwersji, abyś mógł zmierzyć konkretny wynik).

Czemu?

Ponieważ oba zestawy Twoich odbiorców widzą dokładnie tę samą stronę, wyniki konwersji powinny być identyczne po obu stronach testu, prawda?

Cóż, czasami nie są, co oznacza, że Twoje narzędzie może być nieprawidłowo skonfigurowane. Więc śmiało sprawdź swoje narzędzie testowe przed uruchomieniem jakichkolwiek kampanii.

#4. Korzystanie z narzędzia niskiej jakości i flashowanie treści

Niektóre narzędzia nie są tak dobre jak inne. Wykonują swoją pracę, ale walczą pod obciążeniem ruchu lub „mrugają” i migoczą.

Może to w rzeczywistości spowodować niepowodzenie testu, nawet jeśli masz potencjalny zwycięski wariant.

Załóżmy, że testujesz obraz na swojej stronie. Strona kontrolna ładuje się dobrze, ale różnica między nowym obrazem testowym a oryginałem migocze tylko przez ułamek sekundy. (A może za każdym razem, gdy użytkownik przewija stronę w górę iw dół).

Może to rozpraszać i powodować problemy z zaufaniem, obniżając współczynnik konwersji.

W rzeczywistości twój nowy obraz może teoretycznie nawet lepiej konwertować, ale migotanie narzędzia obniża wyniki, dając niedokładny test tego obrazu.

Upewnij się, że masz wystarczająco dobre narzędzie do testowania.

(Jest to tak ważny czynnik doświadczenia użytkownika, że Google obecnie dostosowuje swoje rankingi do witryn, które nie mają migoczących lub ruchomych elementów).

#5. Brak testowej kontroli jakości

Super prosty błąd, ale czy sprawdziłeś, że wszystko działa?

- Czy przeszedłeś proces sprzedaży?

- Masz innych? (I na urządzeniach bez pamięci podręcznej, ponieważ czasami to, co jest zapisywane w przeglądarce, nie jest tym, jak wygląda strona).

- Czy strony ładują się prawidłowo? Czy są powolne? Czy projekty są pomieszane?

- Czy wszystkie przyciski działają?

- Czy działa śledzenie przychodów?

- Czy sprawdziłeś, że strona działa na wielu urządzeniach?

- Czy masz raport o błędach, jeśli coś się zepsuje?

To wszystko warto sprawdzić ZANIM zaczniesz kierować ruch do dowolnej kampanii.

Pobierz naszą listę kontrolną zapewniania jakości dla testów A/B. Jest to plik PDF z możliwością wypełnienia, do którego będziesz chciał wracać za każdym razem, gdy przeprowadzasz kontrolę jakości testu.

#6. Czy nowe leczenie/wariacja działa?

Podobnie, czy sprawdziłeś i sprawdziłeś, czy Twoja nowa odmiana działa, zanim przeprowadzisz test?

Może to być pomijana część testów kontroli jakości, ale kampanie często mogą być uruchamiane z uszkodzonymi przyciskami, starymi linkami i nie tylko. Najpierw sprawdź, a potem przetestuj.

7. Nie podążanie za hipotezą i po prostu testowanie starych rzeczy

Niektórzy ludzie po prostu testują wszystko, nie zastanawiając się nad tym.

Wpadają na pomysł zmiany i chcą ją przetestować, ale bez rzeczywistej analizy tego, w jaki sposób strona obecnie konwertuje, ani nawet dlaczego testowana zmiana może mieć znaczenie. (Możliwe, że obniżają konwersję, ale nawet o tym nie wiedzą, ponieważ nie mają jeszcze śledzonego wyniku podstawowego).

Sformułowanie hipotezy o tym, gdzie leży problem, jego przyczyna i jak możesz go rozwiązać, będzie miało ogromny wpływ na Twój program testowy.

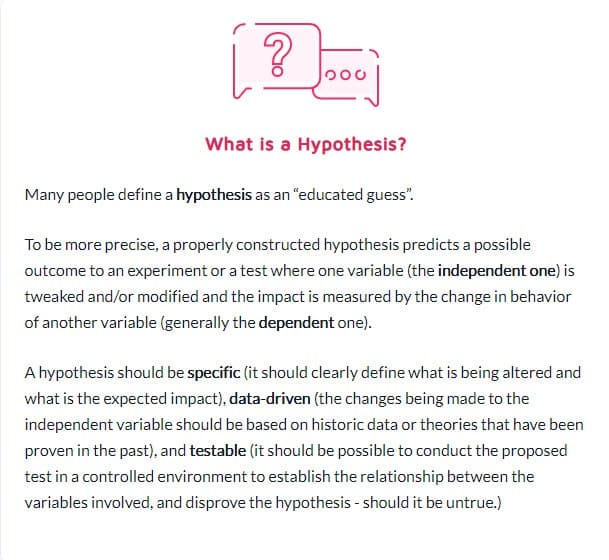

#8. Posiadanie niesprawdzalnej hipotezy

Nie każda hipoteza jest poprawna. Jest okej. W rzeczywistości słowo to dosłownie oznacza „Mam pomysł oparty na informacjach o X i myślę, że Y może się wydarzyć w okolicznościach Z”.

Ale będziesz potrzebować hipotezy, którą można przetestować, co oznacza, że można ją udowodnić lub obalić za pomocą testów. Testowalne hipotezy wprowadzają innowacje w ruch i promują aktywne eksperymentowanie. Mogą albo doprowadzić do sukcesu (w takim przypadku twoje przeczucie było poprawne) albo do porażki – pokazując, że przez cały czas się myliłeś. Ale dadzą ci wgląd. Może to oznaczać, że Twój test musi być wykonany lepiej, Twoje dane były nieprawidłowe/błędnie odczytane lub znalazłeś coś, co nie działało, co często daje wgląd w nowy test, który może działać znacznie lepiej.

#9. Nie wyznaczanie z góry jasnego celu testu

Gdy masz hipotezę, możesz jej użyć, aby dopasować ją do konkretnego wyniku, który chcesz osiągnąć.

Czasami ludzie po prostu prowadzą kampanię i widzą, co się zmienia, ale na pewno uzyskasz więcej potencjalnych klientów/konwersji lub sprzedaży, jeśli masz jasność co do tego, w którym konkretnym elemencie chcesz zobaczyć wzrost.

(To również powstrzymuje cię przed zauważeniem spadku ważnego elementu, ale uznanie testu za wygrany, ponieważ „ma więcej akcji”).

A propos…

#10. Koncentrowanie się na powierzchownych metrykach

Twój test powinien być zawsze powiązany z danymi Guardrail lub jakimś elementem, który bezpośrednio wpływa na Twoją sprzedaż. Jeśli jest więcej leadów, powinieneś wiedzieć co do dolara, ile jest wart lead i jaką wartość ma zwiększenie tego współczynnika konwersji.

Jednocześnie należy zazwyczaj unikać metryk, które nie łączą się z wymiernymi wynikami ani nie prowadzą do nich. Więcej polubień na Facebooku niekoniecznie oznacza większą sprzedaż. Usuń te przyciski udostępniania społecznościowego i po prostu obserwuj, ile więcej potencjalnych klientów pozyskujesz. Uważaj na wskaźniki próżności i pamiętaj, że to, że jeden wyciek został naprawiony, nie oznacza, że nie ma innego, którym można by się zająć!

Oto lista typowych wskaźników bariery ochronnej Bena Labaya dla programów eksperymentalnych:

# 11. Wykorzystywanie danych ilościowych tylko do tworzenia pomysłów na testy

Wykorzystywanie danych ilościowych do pozyskiwania pomysłów jest świetne, ale jest też trochę wadliwe. Zwłaszcza jeśli jedyne dane, z których korzystamy, pochodzą z naszych analiz.

Czemu?

Z naszych danych wiemy, że X osób nie kliknęło, ale możemy nie wiedzieć dlaczego.

- Czy przycisk znajduje się zbyt nisko na stronie?

- Czy to niejasne?

- Czy jest to zgodne z oczekiwaniami widza?

- Czy to w ogóle działa?

Najlepsi testerzy słuchają również swojej publiczności. Dowiadują się, czego potrzebują, co ich popycha do przodu, co ich powstrzymuje, a następnie wykorzystują to do formułowania nowych pomysłów, testów i pisemnej kopii.

Czasami Twoi użytkownicy są powstrzymywani przez problemy z zaufaniem i wątpliwości. Innym razem jest to klarowność i połamane formy lub złe projekty. Kluczem jest to, że są to rzeczy, o których dane ilościowe nie zawsze mogą ci powiedzieć, więc zawsze pytaj odbiorców i używaj ich do planowania.

#12. Kopiowanie konkurencji

Gotowy na sekret?

Przez większość czasu twoi konkurenci po prostu to robią. Jeśli nie mają kogoś, kto prowadził długoterminowe kampanie wzrostu, mogą po prostu próbować różnych rzeczy, aby zobaczyć, co działa, czasami bez wykorzystywania jakichkolwiek danych do swoich pomysłów.

A nawet wtedy to, co dla nich działa, może nie działać dla Ciebie. Więc tak, używaj ich jako inspiracji, ale nie ograniczaj swoich pomysłów na testy tylko do tego, co widzisz, robią. Możesz nawet wyjść poza swoją branżę w poszukiwaniu inspiracji i sprawdzić, czy rodzi to pewne hipotezy.

#13. Testowanie tylko „najlepszych praktyk branżowych”

Ponownie, to, co działa dla jednego, nie zawsze działa dla drugiego.

Na przykład obrazy suwaków zwykle mają straszną wydajność, ale w niektórych witrynach mogą faktycznie generować więcej konwersji. Przetestuj wszystko. Nie masz nic do stracenia i wszystko do zyskania.

# 14. Koncentrowanie się najpierw na zadaniach o małym wpływie, gdy dostępne są duże nagrody / nisko wiszące owoce o dużym wpływie

Wszyscy możemy być winni skupiania się na drobiazgach. Możemy mieć stronę, którą chcemy lepiej wykonywać i testować projekty układów i obrazy, a nawet kolory przycisków. (Osobiście mam stronę sprzedaży, która jest w piątej iteracji.)

Chodzi o to, że prawdopodobnie są teraz o wiele ważniejsze strony do przetestowania.

Priorytetowe oddziaływanie przede wszystkim:

- Czy ta strona bezpośrednio wpłynie na sprzedaż?

- Czy inne strony w procesie sprzedaży mają znacznie gorsze wyniki?

Jeśli tak, skup się najpierw na nich.

Wzrost o 1% na stronie sprzedaży jest świetny, ale wzrost o 20% na stronie, która je tam prowadzi, może być znacznie ważniejszy. (Zwłaszcza jeśli na tej konkretnej stronie tracisz większość odbiorców).

Czasami nie tylko szukamy więcej windy, ale zamiast tego naprawić coś, co jest wąskim gardłem.

Przetestuj i popraw największy wpływ, najpierw najniżej wiszące owoce. To właśnie robią agencje i dlatego wykonują taką samą liczbę testów jak zespoły wewnętrzne, ale z wyższym ROI. Agencje uzyskują o 21% więcej wygranych za taką samą liczbę testów!

#15. Testowanie wielu rzeczy na raz i niewiedza, która zmiana spowodowała rezultat

Nie ma nic złego w przeprowadzaniu radykalnych testów, w których zmieniasz wiele rzeczy naraz i przeprojektowujesz całą stronę.

W rzeczywistości te radykalne zmiany mogą czasami mieć największy wpływ na Twój zwrot z inwestycji, nawet jeśli masz witrynę o małym natężeniu ruchu, a zwłaszcza jeśli jesteś na stałym poziomie i wydaje się, że nie możesz już uzyskać większego wzrostu.

Pamiętaj jednak, że nie każdy test A/B powinien dotyczyć tak radykalnej zmiany. W 99% przypadków po prostu testujemy zmianę jednej rzeczy, na przykład

- Nowe nagłówki

- Nowe obrazy

- Nowy układ tej samej treści

- Nowe ceny itp.

Jednak kluczem do wykonania testu pojedynczego elementu jest właśnie to. Utrzymuj test tylko w JEDNYM elemencie zmiany, abyś mógł zobaczyć, co robi różnicę i wyciągnąć z tego wnioski. Za dużo zmian i nie wiesz, co zadziałało.

#16. Nieprzeprowadzenie prawidłowej analizy przed testem

Czy masz wystarczającą liczbę odwiedzających w swojej grupie testowej? Czy test jest w ogóle wart twojego czasu?

Zrobić matematykę! Upewnij się, że masz wystarczający ruch przed uruchomieniem testu – w przeciwnym razie to tylko strata czasu i pieniędzy. Wiele testów kończy się niepowodzeniem z powodu niewystarczającego ruchu lub słabej czułości (lub obu).

Wykonaj analizę przed testem, aby określić wielkość próbki i minimalny wykrywalny efekt dla twojego eksperymentu. Kalkulator istotności testów A/B, taki jak Convert, poda ci wielkość próbki i MDE dla twojego testu, co pomoże ci zdecydować, czy warto go uruchomić. Możesz również wykorzystać te informacje, aby określić, jak długo powinien trwać test i jak mały wzrost nie chciałbyś przegapić, zanim uznasz, że test był udany, czy nie.

#17. Błędne oznaczenie testów

Bardzo prosty błąd, ale się zdarza. Błędnie oznaczasz testy, a następnie otrzymujesz złe wyniki. Odmiana wygrywa, ale nazywa się kontrolą, a wtedy nigdy nie wdrażasz wygranej i pozostajesz z przegranym!

Zawsze sprawdzaj dwukrotnie!

#18. Uruchamianie testów z niewłaściwym adresem URL

Kolejny prosty błąd. Albo adres URL strony został wprowadzony niepoprawnie, albo test jest przeprowadzany w „witrynie testowej”, w której wprowadzono zmiany, a nie w opublikowanej wersji.

Dla Ciebie może wyglądać dobrze, ale w rzeczywistości nie będzie się ładować dla Twoich odbiorców.

# 19. Dodawanie arbitralnych reguł wyświetlania do testu

Ponownie, musisz przetestować jedną rzecz podczas leczenia i nic więcej.

Jeśli to obraz, przetestuj obraz. Wszystko inne powinno być takie samo, w tym pora dnia, kiedy ludzie mogą zobaczyć obie strony!

Niektóre narzędzia umożliwiają testowanie różnych pór dnia, aby sprawdzić, jak wygląda ruch w różnych ramach czasowych. Jest to przydatne, jeśli chcesz sprawdzić, kiedy w witrynie występuje największy ruch, ale nie jest przydatne, gdy strony są dzielone według tego, kto je widzi ORAZ mają różne odmiany.

Na przykład ruch na naszych własnych blogach spada w weekendy (jak większość blogów biznesowych).

Wyobraź sobie, że przeprowadzamy test od poniedziałku do środy na stronie kontrolnej, a następnie pokazujemy ruch z piątku na ndz. Miałby znacznie mniejszy ruch do testowania i prawdopodobnie inne wyniki.

#20. Testowanie niewłaściwego ruchu dla Twojego celu

Najlepiej, gdy przeprowadzając test, chcesz mieć pewność, że testujesz tylko jeden segment odbiorców. Zwykle są to nowi użytkownicy organiczni, aby zobaczyć, jak reagują po raz pierwszy w Twojej witrynie.

Czasami możesz chcieć przetestować powracających odwiedzających, subskrybentów poczty e-mail, a nawet płatny ruch. Sztuką jest przetestowanie tylko jednego z nich na raz, aby uzyskać dokładną reprezentację tego, jak ta grupa radzi sobie z daną stroną.

Podczas konfigurowania testu wybierz odbiorców, z którymi chcesz pracować, i usuń wszystkie inne, które mogą zanieczyścić wynik, takie jak powracający odwiedzający.

#21. Niewykluczenie powracających odwiedzających z testu i wypaczenie wyników

Nazywamy to zanieczyszczeniem próbki.

Zasadniczo, jeśli użytkownik zobaczy stronę Twojej witryny, powróci i zobaczy Twoją odmianę, zareaguje zupełnie inaczej, niż gdyby zobaczył tylko jedną z nich.

Mogą być zdezorientowani, odbijać się, a nawet konwertować wyżej, po prostu z powodu tych dodatkowych interakcji.

Chodzi o to, że powoduje to zanieczyszczenie danych i zmniejszenie ich dokładności. Najlepiej byłoby użyć narzędzia, które losowo wyświetla stronę, którą widzą, ale potem zawsze wyświetla tę samą wersję, dopóki test się nie zakończy.

#22. Nie usuwam swoich adresów IP z testu

Mówiąc o zanieczyszczeniu próbek, oto kolejny sposób na zanieczyszczenie danych (i tak jest to dobra praktyka dla analityki).

Upewnij się, że blokujesz adresy IP Ciebie i Twoich pracowników w narzędziu analitycznym i testowym. Ostatnią rzeczą, jakiej chcesz, jest to, abyś Ty lub członek zespołu „zameldował się” na stronie i został oznaczony w teście.

#23. Brak segmentacji odmian grupy kontrolnej (efekt sieciowy)

Kolejna opcja zanieczyszczenia, która jest rzadka, ale może się zdarzyć, zwłaszcza jeśli masz sieć dla swoich odbiorców.

Oto przykład.

Załóżmy, że masz platformę, na której Twoi odbiorcy mogą się komunikować. Być może strona na Facebooku lub sekcja komentarzy, ale KAŻDY ma do niej dostęp.

W takiej sytuacji możesz mieć osoby, które widzą jedną stronę, a inne widzą odmianę, ale wszystkie znajdują się w tej samej sieci społecznościowej. Może to w rzeczywistości zniekształcić Twoje dane, ponieważ mogą one wzajemnie wpływać na wybory i interakcje ze stroną. Linkedin segmentuje swoich odbiorców podczas testowania nowych funkcji, aby zapobiec problemom z efektem sieciowym.

Najlepiej byłoby rozdzielić komunikację między dwiema grupami testowymi do czasu zakończenia testu.

#24. Przeprowadzanie testów podczas wydarzeń sezonowych lub ważnych wydarzeń w witrynie/platformie

O ile nie testujesz na wydarzenie sezonowe, nigdy nie chcesz przeprowadzać kampanii testowej w okresie świątecznym ani żadnego innego ważnego wydarzenia, takiego jak specjalna wyprzedaż lub wydarzenie na świecie.

Czasami nie możesz na to poradzić. Przeprowadzisz test, a Google po prostu zaimplementuje nową podstawową aktualizację i namiesza w źródłach odwiedzin w połowie kampanii *kaszel*.

Najlepszą rzeczą do zrobienia jest po prostu ponowne uruchomienie po tym, jak wszystko ucichnie.

#25. Ignorowanie różnic kulturowych

Możesz mieć cel dla strony, ale prowadzisz też globalną kampanię z wieloma odmianami wyświetlanymi w różnych językach i krajach.

Musisz wziąć to pod uwagę podczas przeprowadzania testu. Niektóre zmiany można wprowadzić globalnie, takie jak proste przesunięcie układu lub dodanie sygnałów zaufania itp.

Innym razem musisz wziąć pod uwagę różnice kulturowe. Jak ludzie widzą układ, jak wyświetlają obrazy i awatary na Twojej stronie.

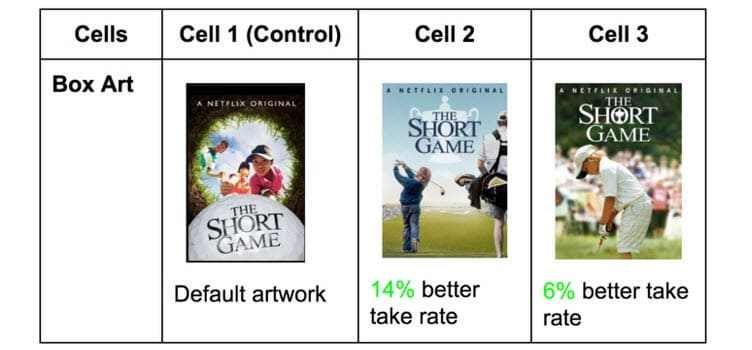

Netflix robi to z miniaturami wszystkich swoich programów, testując różne elementy, które mogą spodobać się różnym odbiorcom (zamiast tego występują konkretni aktorzy słynni z tego kraju).

To, co uzyskuje kliknięcia w jednym kraju, może być bardzo różne w innych. Nie wiesz jednak, dopóki nie przetestujesz!

#26. Prowadzenie wielu połączonych kampanii jednocześnie

Łatwo się ekscytować i chcesz przeprowadzić wiele testów naraz.

Pamiętaj tylko: możesz uruchomić wiele testów dla podobnych punktów w procesie sprzedaży w tym samym czasie, ale nie przeprowadzaj wielu testów dla wielu połączonych punktów w lejku.

Oto co mam na myśli.

Możesz całkiem łatwo uruchomić testy na każdej stronie generowania leadów, którą posiadasz, jednocześnie.

Jednak nie chciałbyś jednocześnie testować stron potencjalnych klientów, stron sprzedaży i stron kasy, ponieważ może to wprowadzić tak wiele różnych elementów do procesu testowania, wymagając ogromnych ilości ruchu i konwersji, aby uzyskać przydatny wgląd.

Nie tylko to, ale każdy element może wywołać na następnej stronie inne efekty, zarówno dobre, jak i złe. Jeśli nie masz setek tysięcy odwiedzających tygodniowo, prawdopodobnie będziesz miał trudności z uzyskaniem dokładnych wyników.

Bądź więc cierpliwy i testuj tylko jeden etap na raz lub strony, które nie są połączone w procesie.

Dygresja:

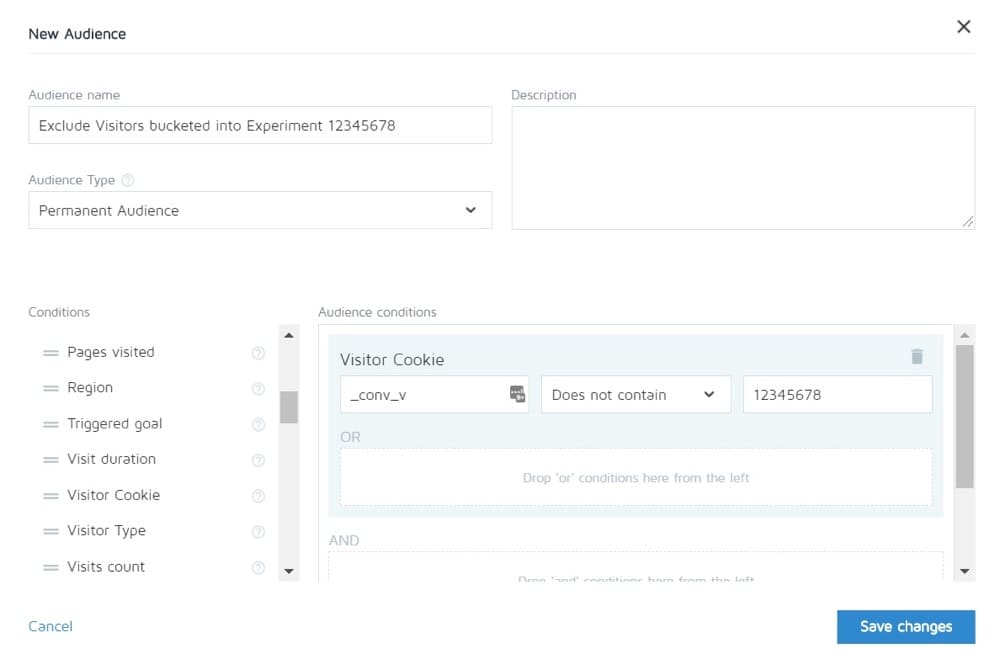

Konwertuj umożliwia wykluczenie osób biorących udział w jednym eksperymencie z oglądania innych. Możesz więc teoretycznie przetestować pełny cykl sprzedaży, a następnie zobaczyć tylko kontrolę innych stron.

#27. Nierówne ważenie ruchu

Nie ma znaczenia, czy przeprowadzasz test A/B, A/B/n czy wielowymiarowy. Musisz przydzielić jednakowy ruch do każdej wersji, aby uzyskać dokładny pomiar.

Ustaw je tak, aby były równe od samego początku. Większość narzędzi pozwoli Ci to zrobić.

Typowe błędy w testach A/B, które możesz popełnić podczas testu

#28. Nie działa wystarczająco długo, aby uzyskać dokładne wyniki

Aby przeprowadzić test i uzyskać dokładne wyniki, należy wziąć pod uwagę 3 ważne czynniki:

- Znaczenie statystyczne,

- Cykl sprzedaży oraz

- Wielkość próbki.

Więc podzielmy to.

Większość ludzi kończy testy, gdy ich narzędzie testowe powie im, że jeden wynik jest lepszy od drugiego ORAZ wynik jest statystycznie istotny, tj. jeśli test nadal działa w ten sposób, jest to zdecydowany zwycięzca.

Chodzi o to, że czasami możesz dość szybko trafić w „stat sig” przy niewielkim ruchu. Losowo wszystkie konwersje mają miejsce na jednej stronie, a żadna na drugiej.

Jednak nie zawsze tak będzie. Możliwe, że test wystartował, jest dzień wypłaty i tego dnia masz mnóstwo sprzedaży.

Dlatego musimy wziąć pod uwagę cykl sprzedaży. Sprzedaż i ruch mogą się zmieniać w zależności od dnia tygodnia lub miesiąca. Aby uzyskać dokładniejszą reprezentację przebiegu testu, najlepiej, aby trwał od 2 do 4 tygodni.

Wreszcie masz wielkość próbki.

Jeśli przeprowadzasz test przez miesiąc, prawdopodobnie uzyskasz wystarczający ruch, aby uzyskać dokładne wyniki. Za mało, a test po prostu nie da ci pewności, że będzie działał tak, jak powinien.

Więc z reguły

- Wybierz wskaźnik zaufania 95%.

- Biegaj przez miesiąc.

- Ustal z wyprzedzeniem, jakiej wielkości próbki potrzebujesz i nie przerywaj testu, dopóki nie trafisz LUB uzyskasz niesamowity wynik, który bez cienia wątpliwości dowodzi, że masz zwycięzcę.

#29. Monitorowanie/podglądanie helikoptera

Peeking to termin używany do opisania, kiedy tester przygląda się swojemu testowi, aby zobaczyć, jak działa.

Idealnie, nigdy nie chcemy patrzeć na nasz test po uruchomieniu i nigdy nie podejmujemy decyzji, dopóki nie zakończy się pełnego cyklu, z odpowiednią wielkością próbki i osiągnięciem istotności statystycznej.

Jednak… A jeśli test się nie uruchamia?

A jeśli coś się zepsuje?

Cóż, w takim razie nie chcesz czekać miesiąca, aby zobaczyć, że jest zepsuty, prawda? Dlatego zawsze sprawdzam, czy test daje wyniki w zakresie kontroli i zmienności, 24 godziny po uruchomieniu.

Jeśli widzę, że zarówno otrzymują ruch, jak i kliknięcia/konwersje, odchodzę i pozwalam, by robił swoje. Nie podejmuję ŻADNYCH decyzji, dopóki test nie zostanie ukończony.

#30. Brak śledzenia opinii użytkowników (szczególnie ważne, jeśli test wpływa na bezpośrednie, natychmiastowe działanie)

Załóżmy, że test uzyskuje kliknięcia, a ruch jest rozłożony, więc *wygląda* na to, że działa, ale nagle pojawiają się raporty, że ludzie nie mogą wypełnić formularza sprzedaży. (Lub jeszcze lepiej, otrzymasz automatyczny alert, że metryka poręczy spadła znacznie poniżej akceptowalnych poziomów).

Cóż, twoja pierwsza myśl powinna brzmieć, że coś jest zepsute.

Nie zawsze. Możesz uzyskiwać kliknięcia od odbiorców, które nie pasują do Twojej oferty, ale na wszelki wypadek warto sprawdzić ten formularz.

Jeśli jest zepsuty, napraw go i uruchom ponownie.

# 31. Wprowadzanie zmian w trakcie testu

Mogło to być jasne na podstawie ostatnich kilku punktów, ale nigdy nie chcemy wprowadzać żadnych zmian w teście po jego opublikowaniu.

Jasne, coś może się zepsuć, ale to jedyna zmiana, jaką powinniśmy kiedykolwiek wprowadzić. Nie zmieniamy projektu, nie kopiujemy, ani nic.

Jeśli test działa, pozwól mu się uruchomić, a dane zadecydują, co działa.

#32. Zmiana alokacji ruchu % w trakcie testu lub usuwanie słabych wyników

Tak jak nie zmieniamy testowanych stron, nie usuwamy żadnych odmian ani nie zmieniamy rozkładu ruchu w trakcie testu.

Czemu?

Załóżmy, że przeprowadzasz test A/B/n z kontrolą i 3 odmianami. Rozpoczynasz test i po tygodniu niegrzecznie rzucasz okiem i zauważasz, że 2 wersje radzą sobie świetnie, a jedna kiepsko.

Teraz byłoby kuszące, aby wyłączyć „przegrywającą” odmianę i ponownie rozdzielić ruch między inne odmiany, prawda? Heck… możesz nawet wziąć dodatkowe 25% ruchu i po prostu wysłać je do najskuteczniejszego, ale nie rób tego.

Czemu?

Ta redystrybucja wpłynie nie tylko na wydajność testu, ale może bezpośrednio wpłynąć na wyniki i sposób ich wyświetlania w narzędziu do raportowania.

Wszyscy użytkownicy, którzy byli wcześniej przydzieleni do usuniętego wariantu, będą musieli zostać ponownie przydzieleni do wariantu i w krótkim czasie zobaczą zmienioną stronę internetową, co może wpłynąć na ich zachowanie i późniejsze wybory.

Dlatego nigdy nie zmieniasz ruchu ani nie wyłączasz odmian w połowie drogi. (A także dlaczego nie powinieneś podglądać!)

#33. Nie przerywanie testu, gdy masz dokładne wyniki

Czasami po prostu zapomniałeś zatrzymać test!

Nadal działa i dostarcza 50% odbiorców na słabszą stronę i 50% na zwycięzcę. Ups!

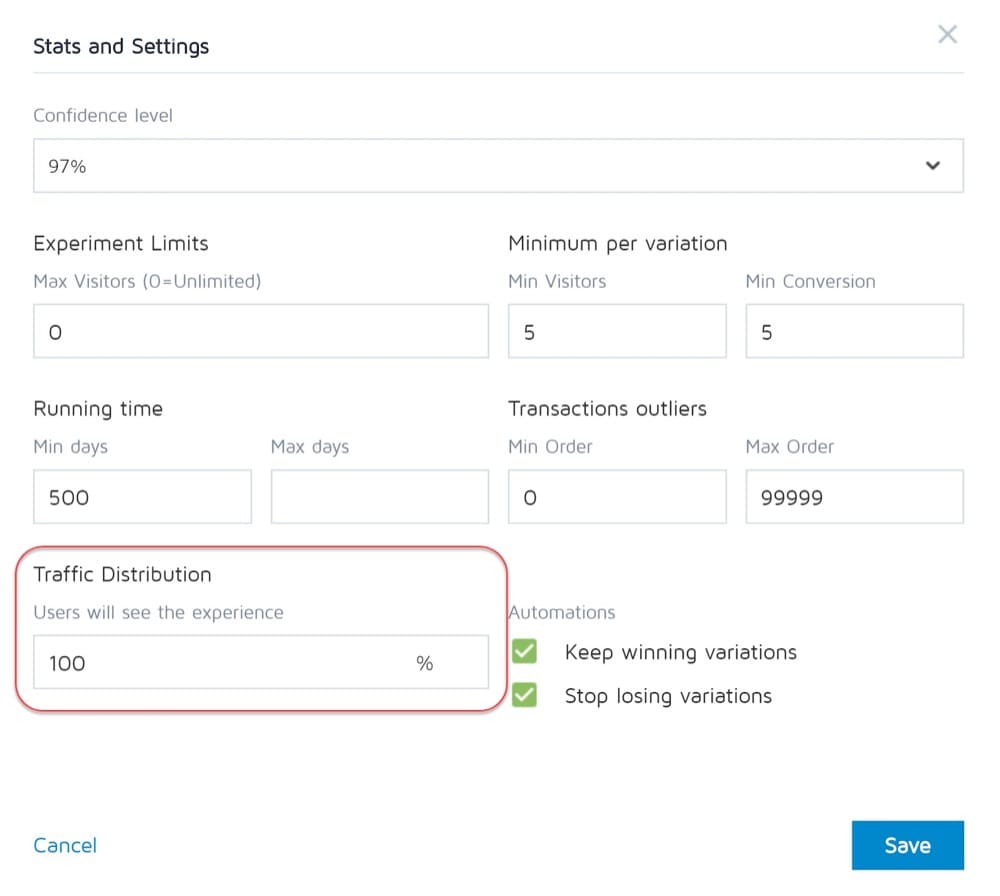

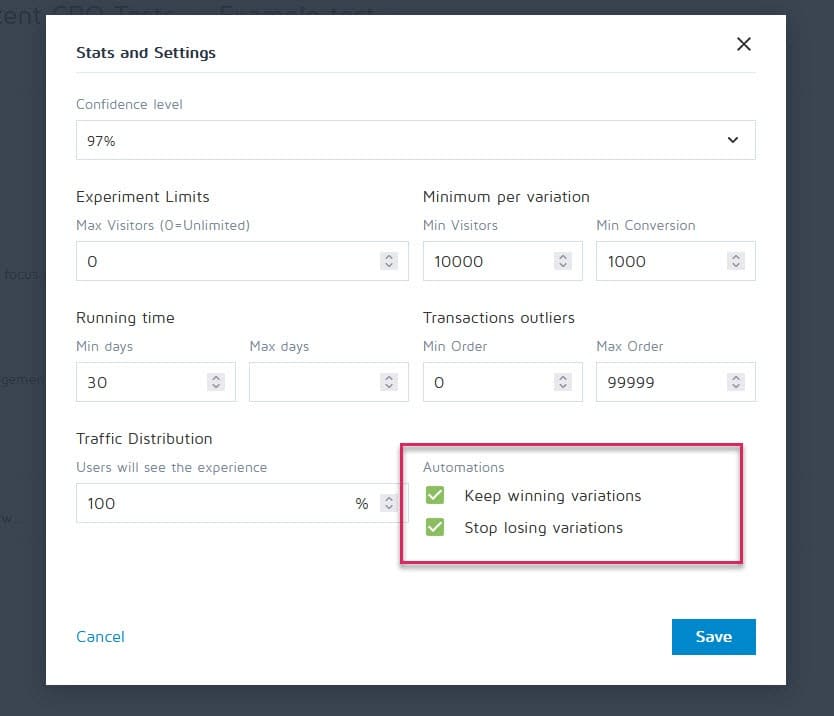

Na szczęście narzędzia takie jak Convert Experiences można skonfigurować tak, aby zatrzymać kampanię i automatycznie pokazać zwycięzcę po spełnieniu określonych kryteriów (takich jak rozmiar próbki, sygnał statystyczny, konwersje i ramy czasowe).

#34. Bycie emocjonalnie zainwestowanym w utratę wariacji

Jako testerzy musimy być bezstronni. Czasami jednak możesz mieć konkretny projekt lub pomysł, który po prostu kochasz i jesteś przekonany, że powinien był wygrać, więc przedłużasz test coraz dłużej, aby zobaczyć, czy się rozwija.

Zdejmij bandaż.

Możesz mieć dobry pomysł, który wymaga tylko poprawy, ale nie możesz tego zrobić, dopóki nie zakończysz bieżącego testu.

#35. Zbyt długie przeprowadzanie testów i brak śledzenia

Oto kolejny potencjalny problem z zanieczyszczeniem próbki.

Jeśli przeprowadzasz test na dłużej niż 4 tygodnie, istnieje prawdopodobieństwo, że pliki cookie użytkowników zostaną usunięte. Może to powodować brak śledzenia zdarzeń, ale mogą one nawet zwracać i ponownie zanieczyszczać przykładowe dane.

#36. Nie używanie narzędzia, które pozwala zatrzymać/wdrożyć test!

Kolejny rzadki problem.

Niektóre programy testujące nalegają na tworzenie testów zakodowanych na stałe. czyli programista i inżynier budują kampanię od podstaw.

Nie jest to jednak wspaniałe, gdy test się kończy i musisz poczekać, aż ten sam programista go wyłączy i zainstaluje zwycięską odmianę. Jest to nie tylko frustrujące, ale może poważnie spowolnić liczbę testów, które możesz przeprowadzić, a nawet ROI strony w oczekiwaniu na jej uruchomienie.

Typowe błędy w testach A/B, które możesz popełnić po zakończeniu testu

#37. Rezygnacja po jednym teście!

9 na 10 testów zwykle kończy się niepowodzeniem.

Oznacza to, że musisz przeprowadzić 10 testów, aby uzyskać tego zwycięzcę. To wymaga wysiłku, ale zawsze warto, więc nie zatrzymuj się po jednej kampanii!

#38. Rezygnacja z dobrej hipotezy przed przetestowaniem wszystkich jej wersji

Porażka może po prostu oznaczać, że twoja hipoteza jest poprawna, ale musi być lepiej wykonana.

Wypróbuj nowe sposoby, nowe projekty, nowy układ, nowe obrazy, nowe awatary, nowy język. Masz pomysł i widzisz, czy możesz go lepiej zrealizować.

Potrzeba było 21 iteracji CXL, aby ulepszyć stronę swojego klienta, ale zajęło im to współczynnik konwersji z 12,1% do 79,3%.

#39. Cały czas spodziewasz się ogromnych wygranych

Faktem jest, że możesz wygrać tylko 1 na 10 lub więcej zwycięskich kampanii.

To jest wporządku. Ciągle testujemy i ciągle się poprawiamy, bo nawet o 1% zwiększamy z czasem związki. Popraw go i osiągnij 2%, a teraz podwoiłeś skuteczność.

Jakie rodzaje testów dają najlepsze wyniki?

Prawda jest taka, że różne eksperymenty mają różne efekty. Według badań Jakuba Linowskiego z ponad 300 testów, eksperymenty z układem prowadzą do lepszych wyników.

Jaki typ ekranu jest najtrudniejszy do optymalizacji? To samo badanie ujawnia ekrany kasowe (z medianą +0,4% z 25 testów).

#40. Nie sprawdzanie ważności po teście

Więc test jest skończony. Biegałeś wystarczająco długo, widziałeś wyniki i otrzymałeś sygnał statystyczny, ale czy możesz zaufać dokładności danych?

Możliwe, że coś się zepsuło w trakcie testowania. Nigdy nie zaszkodzi sprawdzić.

#41. Nieprawidłowe odczytywanie wyników

Co tak naprawdę mówią ci twoje wyniki? Niepoprawne ich odczytanie może łatwo zabrać potencjalnego zwycięzcę i wydawać się kompletną porażką.

- Zanurz się głęboko w swoje analizy.

- Spójrz na wszelkie posiadane dane jakościowe.

Co zadziałało, a co nie? Dlaczego to się stało?

Im lepiej rozumiesz swoje wyniki, tym lepiej.

#42. Nie patrzenie na wyniki według segmentów

Zawsze opłaca się zanurkować trochę głębiej.

Na przykład nowy wariant może wydawać się słabą konwersją, ale na urządzeniach mobilnych ma 40% wzrost konwersji!

Możesz się tego dowiedzieć tylko poprzez segmentację w swoich wynikach. Przyjrzyj się zastosowanym urządzeniom i ich wynikom. Możesz znaleźć cenne spostrzeżenia!

Po prostu bądź świadomy znaczenia rozmiaru swojego segmentu. Być może nie masz wystarczającego ruchu do każdego segmentu, aby w pełni mu zaufać, ale zawsze możesz przeprowadzić test tylko dla urządzeń mobilnych (lub innego kanału) i sprawdzić, jak działa.

#43. Nie uczenie się na podstawie wyników

Utrata testów może dać ci wgląd w to, gdzie musisz jeszcze poprawić lub przeprowadzić więcej badań. Najbardziej irytującą rzeczą jako CRO są klienci, którzy odmawiają uczenia się na podstawie tego, co właśnie zobaczyli. Mają dane, ale ich nie używają…

#44. Zabieranie przegranych

Albo, co gorsza, przyjmują wariant przegrywający.

Może wolą projekt, a współczynnik konwersji różni się tylko o 1%, ale z biegiem czasu te efekty się potęgują. Weź te małe wygrane!

#45. Niepodejmowanie działań w związku z wynikami

Jeszcze gorzej?

Zdobywasz wygraną, ale jej nie wdrażasz! Mają dane i po prostu nic z nimi nie robią. Bez zmian, bez wglądu i bez nowych testów.

#46. Brak iteracji i poprawy na wygranych

Czasem można się podwieźć, ale jest więcej do zdobycia. Tak jak powiedzieliśmy wcześniej, bardzo rzadko każda wygrana daje dwucyfrowy wzrost.

Ale to nie znaczy, że nie możesz się tam dostać, uruchamiając nowe iteracje i ulepszenia i zdobywając 1% na raz.

Wszystko się sumuje, więc ulepszaj się!

#47. Nie udostępnianie zwycięskich wyników w innych obszarach lub działach

Jedną z największych rzeczy, jakie widzimy w przypadku bardzo skutecznych/dojrzałych zespołów CRO, jest to, że dzielą się swoimi wygranymi i odkryciami z innymi działami w firmie.

Daje to innym działom wgląd w to, jak mogą się poprawić.

- Znajdź zwycięską kopię strony sprzedaży? Zaprogramuj go w swoich reklamach, które przyciągną ich do strony!

- Znajdź styl lead magnet, który działa świetnie? Przetestuj go w całej witrynie.

#48. Nie testowanie tych zmian w innych działach

I to jest tutaj klucz. Nawet jeśli dzielisz się spostrzeżeniami z innymi działami, nadal powinieneś testować, aby zobaczyć, jak to działa.

Stylowy projekt, który unosi się w jednym obszarze, może dać upadek w innych, więc zawsze testuj!

#49. Za dużo iteracji na jednej stronie

Nazywamy to osiągnięciem „lokalnego maksimum”.

Strona, na której uruchamiasz testy, ustabilizowała się i po prostu nie możesz uzyskać z niej większego wzrostu.

Możesz spróbować radykalnych przeprojektowań, ale co dalej?

Po prostu przejdź na inną stronę w procesie sprzedaży i popraw to. (Jak na ironię może to w rzeczywistości zapewnić wyższy zwrot z inwestycji).

Zmiana konwersji strony sprzedaży z 10% do 11% może być mniej ważna niż zmiana strony, która kieruje do niej ruch z 2% do 5%, ponieważ zasadniczo zwiększysz ponad dwukrotnie ruch na poprzedniej stronie.

Jeśli masz wątpliwości, znajdź następny najważniejszy test na swojej liście i zacznij od niego poprawiać. Może się nawet okazać, że i tak pomaga w konwersji na tej zablokowanej stronie, po prostu zapewniając jej lepsze perspektywy.

#50. Testowanie za mało!

Testy wymagają czasu, a jest ich tylko tyle, ile możemy przeprowadzić na raz.

Więc co możemy zrobić?

Po prostu skróć przestoje między testami!

Wypełnij test, przeanalizuj wynik i wykonaj iterację lub uruchom inny test. (Najlepiej ustawić je w kolejce i gotowe do pracy).

W ten sposób uzyskasz znacznie wyższy zwrot z inwestycji czasowej.

#51. Nie dokumentowanie testów

Innym nawykiem dojrzałych zespołów CRO jest tworzenie wewnętrznej bazy testów, która zawiera dane dotyczące strony, hipotezy, co zadziałało, a co nie, windy itp.

Możesz nie tylko uczyć się na podstawie starszych testów, ale może również uniemożliwić przypadkowe ponowne przeprowadzenie testu.

#52. Zapominając o fałszywych alarmach i nie sprawdzając dwukrotnie dużych kampanii wzrostowych

Czasami wynik jest zbyt dobry, aby był prawdziwy. Albo coś zostało skonfigurowane, albo źle się rejestrowało, albo tak się składa, że 1 na 20 testów daje fałszywie pozytywny wynik.

Więc co możesz zrobić?

Po prostu ponownie uruchom test, ustaw wysoki poziom ufności i upewnij się, że wykonujesz je wystarczająco długo.

#53. Brak śledzenia wyników downline

Podczas śledzenia wyników testu ważne jest również, aby pamiętać o swoim celu końcowym i śledzić wskaźniki downline przed podjęciem decyzji o zwycięzcy.

Z technicznego punktu widzenia nowy wariant może uzyskiwać mniej kliknięć, ale zwiększa sprzedaż wśród osób, które klikają.

W takim przypadku ta strona byłaby w rzeczywistości bardziej opłacalna, zakładając, że ruch, który kliknięcia nadal powoduje konwersję…

#54. Nie uwzględniać efektów prymatu i nowości, które mogą wpływać na wyniki leczenia

Załóżmy, że ze zmianą kierujesz nie tylko do nowych użytkowników, ale cały ruch.

Wciąż dzielimy je na segmenty, więc 50% widzi oryginalną wersję, a 50% nową wersję, ale dopuszczamy do kampanii byłych użytkowników. Oznacza to, że osoby, które widziały już Twoją witrynę, czytały jej treści, widziały wezwania do działania itp.

Ponadto przez cały czas trwania kampanii widzą tylko swoją konkretną wersję testową.

Kiedy wprowadzasz nową zmianę, może to faktycznie mieć wpływ na twoją dawną publiczność.

Może cały czas widzą to samo wezwanie do działania, a teraz po prostu je ignorują, prawda? W tym przypadku nowy przycisk CTA lub nowy projekt może rzeczywiście zauważyć wzrost poprzednich odwiedzających, nie dlatego, że chcą go teraz bardziej, ale dlatego, że jest nowy i interesujący.

Czasami możesz nawet uzyskać więcej kliknięć, ponieważ układ się zmienił, a oni badają projekt.

Z tego powodu zazwyczaj w odpowiedzi otrzymasz wstępny wzrost, który z czasem słabnie.

Kluczem do przeprowadzenia testu jest segmentacja odbiorców i sprawdzenie, czy nowi użytkownicy odpowiadają tak samo jak starzy.

Jeśli jest znacznie niższy, może to być efekt nowości w przypadku klikania starych użytkowników. Jeśli jest na podobnym poziomie, możesz mieć nowego zwycięzcę na swoich rękach.

Tak czy inaczej, pozwól mu działać przez pełny cykl i zrównoważyć.

#55. Bieżące zmiany okresu rozpatrywania wniosków

Kolejną rzeczą do rozważenia podczas testowania jest każdy wariant, który może zmienić okres rozważania odbiorców.

Co mam na myśli?

Załóżmy, że zwykle nie otrzymujesz natychmiastowej sprzedaży. Leady mogą być w 30-dniowym lub nawet dłuższym cyklu sprzedaży.

Jeśli testujesz wezwanie do działania, które bezpośrednio wpływa na ich czas na rozważenie i zakup, może to zniekształcić Twoje wyniki. Po pierwsze, Twoja kontrola może uzyskać sprzedaż, ale nie będzie trwać w okresie testowym, więc przegapisz je.

Innym scenariuszem jest to, że jeśli masz CTA, które oferuje ofertę, punkt cenowy czegokolwiek innego, co sprawia, że chcą podjąć działanie teraz, to prawie zawsze spowoduje to zniekształcenie wyników, aby ta wersja wyglądała, jakby konwertowała znacznie lepiej.

Pamiętaj o tym i przejrzyj swoje analizy w trakcie i po teście, aby mieć pewność.

#56. Brak ponownego testowania po X czasie

Mniej chodzi o pewną stronę lub błąd testowy, ale bardziej o filozofię testowania.

Tak, możesz mieć niesamowitą stronę i tak, mogłeś zrobić na niej 20 iteracji, aby dostać się tam, gdzie jest dzisiaj.

Rzecz w tym, że za kilka lat może być konieczne ponowne przerobienie całej strony. Zmieniają się środowiska, używany język i terminy, produkt można dostosować.

Zawsze bądź gotowy na powrót do starej kampanii i ponowne przetestowanie. (Kolejny powód, dla którego posiadanie repozytorium testowego działa świetnie.)

#57. Testowanie tylko ścieżki, a nie produktu

Prawie każdy z nas skupia się na ścieżce do sprzedaży i testuje to. Ale rzeczywistość jest taka, że produkt można również przetestować i udoskonalić pod kątem A/B, a nawet zapewnić wyższy udźwig.

Pomyśl o iPhonie.

Firma Apple przetestowała swoją witrynę internetową i poprawiła ją, ale to iteracje i ulepszenia produktów nadal napędzają jeszcze większy wzrost.

Teraz możesz nie mieć fizycznego produktu. Możesz mieć program lub ofertę cyfrową, ale dowiedzenie się więcej o potrzebach odbiorców i przetestowanie ich, a następnie przeniesienie ich z powrotem na stronę sprzedaży może być OGROMNE pod względem wzrostu.

Wniosek

Więc masz to. 57 powszechnych i nietypowych błędów testów A/B, które widzimy i jak można ich uniknąć.

Możesz skorzystać z tego przewodnika, aby ominąć te problemy we wszystkich przyszłych kampaniach.