5 wskazówek dotyczących oszczędzania czasu przy użyciu OnCrawl

Opublikowany: 2017-06-21Jak wykorzystać zaawansowane funkcje OnCrawl, aby poprawić swoją wydajność podczas codziennego monitorowania SEO.

OnCrawl to potężne narzędzie SEO, które pomaga monitorować i optymalizować widoczność witryn e-commerce, wydawców internetowych lub aplikacji w wyszukiwarkach. Narzędzie zostało zbudowane wokół jednej prostej zasady: pomóż managerom ruchu zaoszczędzić czas w procesie analizy i codziennym zarządzaniu projektami SEO.

Oprócz tego, że jest narzędziem do audytu na miejscu, opartym na platformie SaaS wspieranej przez API łączące wszystkie dane stron internetowych, jest również analizatorem logów, który upraszcza ekstrakcję danych i analizę z plików serwera logów.

Możliwości OnCrawl są dość szerokie, ale trzeba je opanować. W tym artykule podzielimy się 5 wskazówkami oszczędzającymi czas, dotyczącymi codziennego korzystania z naszego robota indeksującego SEO i analizatora logów.

1# Jak kategoryzować adresy URL HTTP i HTTPS?

Migracja HTTPS to gorący temat w sferze SEO. Aby doskonale poradzić sobie z tym kluczowym krokiem, ważne jest, aby dokładnie śledzić zachowanie botów w obu protokołach.

Doświadczenie pokazuje, że całkowite przełączenie botów z HTTP na HTTPS zajmuje mniej lub więcej czasu. Przejście to trwa średnio kilka tygodni lub miesięcy, w zależności od zewnętrznych i wewnętrznych czynników związanych z jakością i migracją witryny.

Aby dokładnie zrozumieć tę fazę przejściową, w której mocno wpływa na budżet indeksowania, mądrze jest monitorować trafienia botów. Niezbędna jest zatem analiza logów serwera. Bot, jako zwykły użytkownik, zostawia ślady na każdej stronie, zasobie i żądaniu, które zgłasza. Twoje dzienniki są właścicielami portów, które dostarczyły te połączenia. W ten sposób możesz zweryfikować jakość migracji swojej witryny HTTPS.

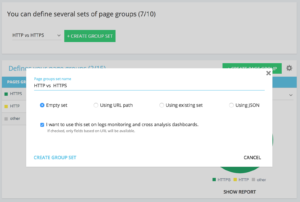

Metody tworzenia dedykowanego zestawu grup stron http i https

W domu projektu Zaawansowane możesz znaleźć w prawym górnym rogu przycisk „ustawienia”. Następnie wybierz menu „Konfiguruj grupę stron”. W tym miejscu utwórz nowy „Utwórz zestaw grupowy” i nazwij go „HTTP vs HTTPS”.

Aby uzyskać dostęp do swoich dzienników, ważne jest, aby wybrać opcję „Chcę używać tego zestawu w pulpitach nawigacyjnych monitorowania dzienników i analiz krzyżowych” .

- HTTPS : „Pełny adres URL” / „Zacznij od” / https

- HTTP : „Pełny adres URL” / „nie zaczyna się od” / https

Po zapisaniu uzyskasz dostęp do widoku migracji HTTPS (jeśli dodałeś port żądania w swoich wierszach dziennika. Możesz zajrzeć do naszego przewodnika).

Nasze QuickFilters można znaleźć w Eksploratorze danych. Zostały zbudowane, aby ułatwić dostęp do niektórych ważnych wskaźników SEO, takich jak linki prowadzące do 404, 500 lub 301/302, zbyt wolne lub zbyt słabe strony itp.

Oto pełna lista:

- Błędy 404

- Błędy 5xx

- Aktywne strony

- Aktywne strony nie zindeksowane przez Google

- Aktywne strony z kodem stanu napotkanym przez Google innym niż 200

- Kanoniczny brak dopasowania

- Nie ustawiono kanonicznego

- Strony indeksowalne

- Brak stron do indeksowania

- Aktywne strony osierocone

- Strony osierocone

- Strony zindeksowane przez Google

- Strony zindeksowane przez Google i OnCrawl

- Strony w strukturze nie zindeksowane przez Google

- Strony wskazujące na błędy 3xx

- Strony wskazujące na błędy 4xx

- Strony wskazujące na błędy 5xx

- Strony ze złym h1

- Strony ze złym h2

- Strony ze złym opisem meta

- Strony ze złym tytułem

- Strony z problemami z powielaniem HTML

- Strony z mniej niż 10 linkami

- Przekieruj 3xx

- Zbyt ciężkie strony

- Zbyt wolne strony

Czasami jednak te szybkie filtry nie rozwiązują wszystkich problemów biznesowych. W takim przypadku możesz zacząć od jednego z nich i utworzyć „Własny filtr”, dodając elementy w filtrze i zapisując je, aby szybko znaleźć filtry za każdym razem, gdy połączysz się z narzędziem.

Na przykład, z linków wskazujących na 4xx, możesz wybrać filtrowanie linków, które mają pustą kotwicę: „Kotwica” / „jest” / „” i zapisać ten filtr. Po zapisaniu można go modyfikować tyle razy, ile potrzeba.

Masz teraz bezpośredni dostęp do tego konkretnego „Szybkiego filtra” na liście „Wybierz szybki filtr” u dołu części „Własne”, jak widać na poniższym zrzucie ekranu.

3# Jak skonfigurować pola niestandardowe związane z DataLayer?

Możesz użyć segmentacji powiązanych typów stron podczas definiowania na przykład tagów narzędzi analitycznych. Ten konkretny kod jest bardzo interesujący, jeśli chodzi o segmentację lub krzyżowanie danych z OnCrawl z danymi zewnętrznymi.

Aby umożliwić Ci utworzenie „kolumny osiowej” do analizy, możemy wyodrębnić te fragmenty kodów podczas indeksowania i przywrócić je jako typ danych Twojego projektu.

Opcja „Pola niestandardowe” umożliwia zeskrobanie dowolnego elementu ze stron kodu źródłowego dzięki wyrażeniu regularnemu lub XPath. Te języki mają swoją własną definicję i zasady. Informacje o XPath znajdziesz tutaj, ao wyrażeniach regularnych tutaj.

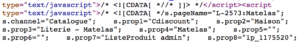

Przypadek użycia 1: wyodrębnianie danych warstwy danych z kodu źródłowego strony

Kod do analizy:

Rozwiązanie : Użyj wyrażenia regularnego: s.prop2=”([^”]+)” / Wyodrębnij : Mono-wartość / Format pola : Wartość

- Znajdź ciąg znaków s.prop2="

- Zdrap wszystkie znaki, które nie są „ (pierwszy znak po danych do wyodrębnienia)

- Ciąg do wyodrębnienia można znaleźć przed zamknięciem „

Po przeszukaniu w eksploratorze danych znajdziesz w kolumnie sProp2, sProp3 lub w polu Nazwa wyodrębnione dane:

Użyj XPATH

Kod do analizy:

Wystarczy skopiować/wkleić element XPath, który chcesz zeskrobać bezpośrednio z analizatora kodu Chrome. Uważaj, jeśli kod jest renderowany w JavaScript, będziesz musiał skonfigurować niestandardowy projekt scrape. Język Xpath jest bardzo potężny i może być trudny do manipulowania, więc jeśli potrzebujesz pomocy, zadzwoń do naszych ekspertów.

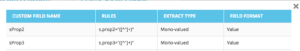

Przypadek użycia 3: testowanie obecności tagów analitycznych w fazie odbioru

Użyj wyrażenia regularnego

Kod do analizy:

Rozwiązanie : Użyj „regex” : '_setAccount', 'UA-364863-11' / Wyodrębnij : Sprawdź, czy istnieje

Otrzymasz w Eksploratorze danych „prawdę”, jeśli ciąg zostanie znaleziony, „fałsz”, wręcz przeciwnie.

4# Jak zwizualizować częstotliwość indeksowania Google w każdej części Twojej witryny?

Budżet indeksowania jest w centrum każdego problemu SEO. Jest to głęboko powiązane z koncepcją „ważności strony” i harmonogramem indeksowania Google. Znamy te zasady, wprowadzone w patencie Google od 2012 roku, które pozwalają społeczeństwu Mountain View optymalizować zasoby poświęcone indeksowaniu sieci.

Google nie zużywa tyle samo energii na każdą część Twojej witryny. Jego częstotliwość indeksowania w każdej części Twojej witryny zapewnia dokładny wgląd w znaczenie Twoich stron dla oczu Google.

Ważne strony są częściej indeksowane przez boty Google, ponieważ budżet indeksowania jest ściśle powiązany z umiejętnościami pozycjonowania stron.

Projekty OnCrawl Advanced pozwalają natywnie zobaczyć budżet indeksowania w części „Monitorowanie dziennika” / „Zachowanie indeksowania” / „Zachowanie indeksowania według grupy”.

Widać, że grupa „Strona główna” ma najwyższą częstotliwość indeksowania. To normalne, ponieważ Google nieustannie poszukuje nowych artykułów i zazwyczaj są one umieszczane na stronie głównej. Idea ważności strony jest ściśle związana z koncepcją świeżości Google. Twoja strona główna jest najważniejszą stroną, na której priorytet ma budżet indeksowania Google. Następnie optymalizacja jest przenoszona na inne strony pod względem głębokości i popularności.

Trudno jednak dostrzec różnice częstotliwości. Musisz zatem kliknąć grupy, które chcesz usunąć (klikając legendę) i zobaczyć, jak pojawiają się dane.

5# Jak przetestować kody statusu z listy adresów URL po migracji?

Jeśli chcesz szybko przetestować kody statusu z zestawu adresów URL, możesz zmodyfikować ustawienia nowego indeksowania:

- Dodaj wszystkie początkowe adresy URL (przycisk „dodaj startowy adres URL”)

- Zdefiniuj maksymalną głębokość na 1

To indeksowanie niestandardowe zwróci dane jakościowe dotyczące tego zestawu adresów URL.

Będziesz mógł sprawdzić, czy przekierowania są dobrze skonfigurowane lub śledzić ewolucję kodów stanu w czasie. Pomyśl o korzyściach płynących z regularnego indeksowania, będziesz mógł automatycznie śledzić stare adresy URL.

Dlaczego nie utworzysz zautomatyzowanego pulpitu nawigacyjnego za pośrednictwem naszego interfejsu API i nie stworzysz zautomatyzowanego monitorowania testów w tych aspektach.

Mamy nadzieję, że te hacki pomogą Ci poprawić wydajność korzystania z OnCrawl. Wciąż mamy wiele zaawansowanych sztuczek do pokazania. Podziel się z nami na Twitterze swoimi #oncrawlhackami, na przykład, cieszymy się, że nasi użytkownicy mogą czerpać tyle radości z naszego narzędzia, co my.