5 kluczy do analizy plików dziennika, których potrzebuje każdy SEO

Opublikowany: 2018-12-13Pliki dziennika są dokładnym odzwierciedleniem życia Twojej witryny. Niezależnie od tego, czy są to użytkownicy, czy boty, na stronach lub w zasobach, cała aktywność w Twojej witrynie jest przechowywana w Twoich dziennikach.

Zawierając informacje, takie jak adresy IP, kody statusu, klienci użytkownika, odsyłacze i inne dane techniczne, każdy wiersz w logach (dane oparte na serwerze) może pomóc w uzupełnieniu analizy witryny internetowej, która zwykle opiera się głównie na danych analitycznych ( dane zorientowane).

Dane, które znajdziesz w swoich dziennikach, same w sobie mogą pomóc Ci ukierunkować strategię SEO.

1. Stan zdrowia Twojej strony internetowej

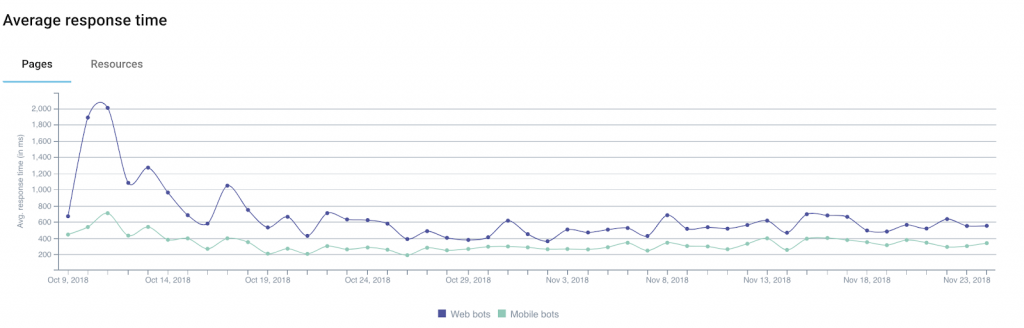

Wśród informacji, które możesz uzyskać w swoich dziennikach, kod statusu , rozmiar odpowiedzi i czas odpowiedzi są doskonałymi wskaźnikami kondycji Twojej witryny.

W rzeczywistości często traci się ruch lub konwersje, nie rozumiejąc, dlaczego. To dlatego, że wyjaśnienie może być czasem techniczne.

Wśród tropów do rozważenia jest kilka, które są bezpośrednio związane z 3 dziedzinami, o których właśnie wspomnieliśmy.

Przykład 1: wzrost liczby błędów serwera („5xx”) może wskazywać na problemy techniczne, które mogą pozostać niewykryte, jeśli po prostu przejdziesz ze strony na stronę.

Przykład 2: kilka badań wykazało wpływ czasu ładowania na współczynnik konwersji dla witryn e-commerce. Spadek przychodów ze sprzedaży może korelować z wydłużeniem czasu ładowania stron.

Dodatkowo Google oferuje kalkulator, który pozwala na symulację zależności między czasem ładowania a przychodami (do przyjęcia z przymrużeniem oka).

Przykład 3: czasami może się zdarzyć, że Twój serwer z powodu różnych problemów technicznych zwraca puste strony. W takim przypadku proste monitorowanie kodów statusu nie wystarczy, aby Cię ostrzec. Dlatego pomocne może być dodanie rozmiaru odpowiedzi do monitorowanych danych: te puste (lub puste) strony są zwykle jaśniejsze niż zwykle.

Segmentując swoją witrynę na podstawie różnych typów adresów URL/stron, będziesz w stanie łatwiej wyodrębnić źródła problemów technicznych, co ułatwi rozwiązanie problemu.

2. Częstotliwość uderzeń bota

Dla członków społeczności SEO logi stanowią bogactwo przydatnych informacji na temat tego, w jaki sposób boty z wyszukiwarek „konsumują” ich witryny.

Na przykład informują nas, kiedy boty odwiedziły stronę po raz pierwszy lub ostatni.

Weźmy za przykład serwis informacyjny, który logicznie potrzebuje wyszukiwarek, aby szybko znaleźć i zindeksować świeżą zawartość. Analiza pól logów wskazujących datę i godzinę pozwala określić średni czas pomiędzy publikacją artykułu a jego wykryciem przez wyszukiwarki.

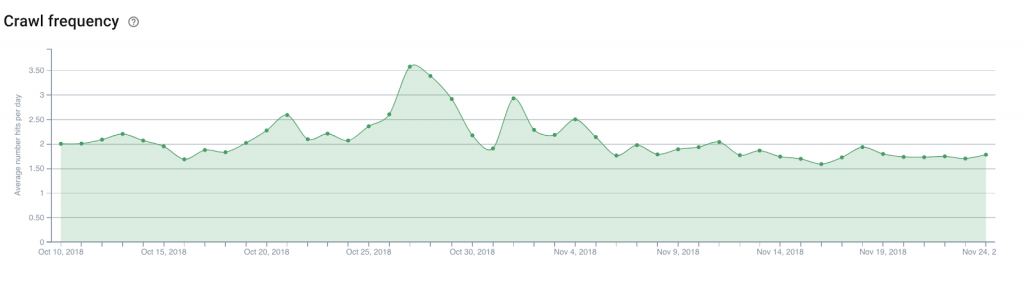

Na tym etapie warto byłoby przeanalizować liczbę codziennych trafień botów (lub częstotliwość indeksowania ) na stronie głównej witryny, stronach kategorii… Ułatwi to określenie, gdzie umieścić linki do nowych artykułów, które należy odkryć.

Ta sama teoria może dotyczyć witryny e-commerce , aby odkryć nowe produkty w katalogu, takie jak te, które chcesz wyróżnić, aby być na bieżąco z pojawiającymi się trendami.

3. Budżet indeksowania

Budżet indeksowania (rodzaj kredytu na przepustowość indeksowania, który Google i jego partnerzy poświęcają witrynie) jest ulubionym tematem ekspertów SEO, a jego optymalizacja stała się obowiązkowym zadaniem.

Poza dziennikami tylko Google Search Console (na razie stara wersja) da Ci podstawowe pojęcie o budżecie, jaki wyszukiwarki przyznają Twojej witrynie. Jednak poziom dokładności w Search Console tak naprawdę nie pomoże Ci określić, na czym skoncentrować swoje wysiłki. Zwłaszcza, że zgłoszone dane są w rzeczywistości zbiorczymi danymi zebranymi ze wszystkich Googlebotów.

Logi jednak, dzięki analizie pola user-agent i adresu URL , mogą zidentyfikować, które strony (lub zasoby) boty odwiedzają iw jakim tempie.

Dzięki tym informacjom dowiesz się, czy Googleboty nadmiernie przeglądają części Twojej witryny, które nie są istotne dla SEO, marnując budżet, który może być przydatny dla innych stron.

Tego typu analizy można wykorzystać do ustrukturyzowania strategii wewnętrznych linków, zarządzania plikami robots.txt, wykorzystania metatagów ukierunkowanych na boty…

4. Mobilność i migracja

Niektórzy nie mogą się na to doczekać, inni się tego boją, ale z pewnością nadejdzie dzień, w którym otrzymasz od Google wiadomość e-mail z informacją, że Twoja witryna została przełączona na słynny indeks mobile-first.

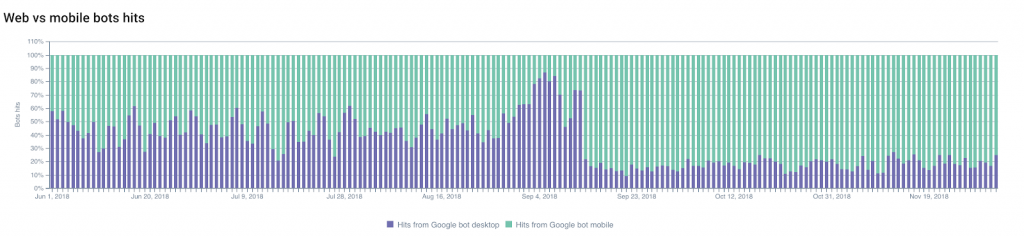

Możesz przewidzieć , kiedy nastąpi zmiana, śledząc zmiany w stosunku trafień Googlebota na komputery do trafień Googlebota na komórki .

Część indeksowania przez mobilne Googleboty generalnie wzrośnie, umożliwiając przewidywanie i planowanie zmiany.

Z drugiej strony niezauważenie zmian tego wskaźnika może być również istotnym wskaźnikiem zgodności Twojej witryny z kryteriami Google dotyczącymi przełączania indeksów.

Możesz także monitorować inne zmiany: migracje (np. z HTTP na HTTPS ) czy modyfikacje struktury Twojej witryny .

Jeśli skoncentrujemy się na pierwszym przykładzie — na modyfikacji używanego protokołu — indeksację bezpiecznych adresów URL i przekierowań, a także postępujące „zanikanie” starych adresów URL można łatwo monitorować dzięki logom.

Monitorowanie zmian w kodach statusu będzie Twoim najlepszym sprzymierzeńcem!

5. Wścibscy sąsiedzi

Jesteś świetnym SEO, a Twoje wysiłki przynoszą efekty!

Wzbudziło to ciekawość Twoich konkurentów (i innych wścibskich ludzi), którzy chcą zrozumieć, jak to zrobiłeś i którzy zdecydowali się zaindeksować całą Twoją witrynę.

To jest złe. Ale nie niezwykłe (wręcz przeciwnie).

Twoim zadaniem jest teraz wykrywanie węszycieli..

Najbardziej subtelni z nich będą próbować udawać swoje roboty jako Googleboty, korzystając z klientów użytkownika Google . I tutaj adres IP przechowywany w logach może być bardzo przydatny.

Ale w rzeczywistości oficjalne Googleboty wykorzystują tylko dobrze udokumentowane zakresy adresów IP. Google doradza webmasterom przeprowadzenie odwrotnego wyszukiwania DNS w celu zweryfikowania pochodzenia botów.

Jeśli ten test się nie powiedzie, wyniki (lub wyniki śledzenia geograficznego IP) mogą pomóc Ci zdecydować, co zrobić.

Dla przypomnienia, ekspert ds. bezpieczeństwa cyfrowego w Imperva Incapsula przeprowadził badanie opublikowane w 2016 roku, z którego wynika, że 28,9% analizowanej przepustowości było zużywane przez „złe boty” (w porównaniu z 22,9% przez „dobre boty” i 48,2% przez użytkowników ). Spojrzenie na swoje dzienniki może pomóc w uniknięciu nadmiernego drenażu zasobów poprzez wykrywanie niechcianych botów.