5 świetnych powodów, aby połączyć dane dotyczące indeksowania i dzienników

Opublikowany: 2018-03-27W społeczności SEO coraz bardziej wzrasta zrozumienie danych z plików dziennika w SEO. Pliki dziennika są w rzeczywistości jedyną jakościową reprezentacją tego, co dzieje się na stronie internetowej. Ale nadal musimy być w stanie zmusić ich do skutecznego przemawiania.

Dokładne wizyty SEO i zachowanie botów są obecne w plikach dziennika. Z drugiej strony dane z raportu indeksowania mogą dostarczyć dobrej wiedzy na temat wydajności w witrynie. Musisz połączyć pliki dziennika i dane indeksowania, aby podczas analizy witryny wyróżnić nowe wymiary.

W tym artykule znajdziesz pięć doskonałych sposobów łączenia danych indeksowania i plików dziennika. Oczywiście jest ich o wiele więcej.

1# Wykrywanie stron osieroconych i optymalizacja budżetu indeksowania

Co to jest strona osierocona? Jeśli adres URL pojawia się w dziennikach, ale nie znajduje się w architekturze witryny, nazywa się go osieroconym.

Google ma kolosalny indeks! Z czasem zachowa wszystkie adresy URL, które już wykrył w Twojej witrynie, nawet jeśli nie ma ich już w architekturze (zmiana ślimaka, usunięte strony, pełna migracja witryny, błędne lub przekształcone linki zewnętrzne). Oczywiście pozwolenie Google na indeksowanie tak zwanych stron osieroconych może mieć wpływ na optymalizację budżetu indeksowania. Jeśli przestarzałe adresy URL zużywają budżet indeksowania, zapobiega to częstszemu indeksowaniu innych adresów URL i z pewnością będzie miało wpływ na SEO.

Podczas indeksowania Twojej witryny OnCrawl przegląda wszystkie linki, aby odkryć, dogłębnie, kompletną architekturę Twojej witryny. Z drugiej strony, podczas monitorowania plików dziennika OnCrawl zbiera dane z trafień botów Google i wizyt SEO.

Różnica między adresami URL znanymi Google a tymi, które są połączone w architekturze, może być bardzo istotna. Niezbędne są optymalizacje SEO, które mają na celu poprawienie zapomnianych lub uszkodzonych linków i zmniejszenie liczby osieroconych stron.

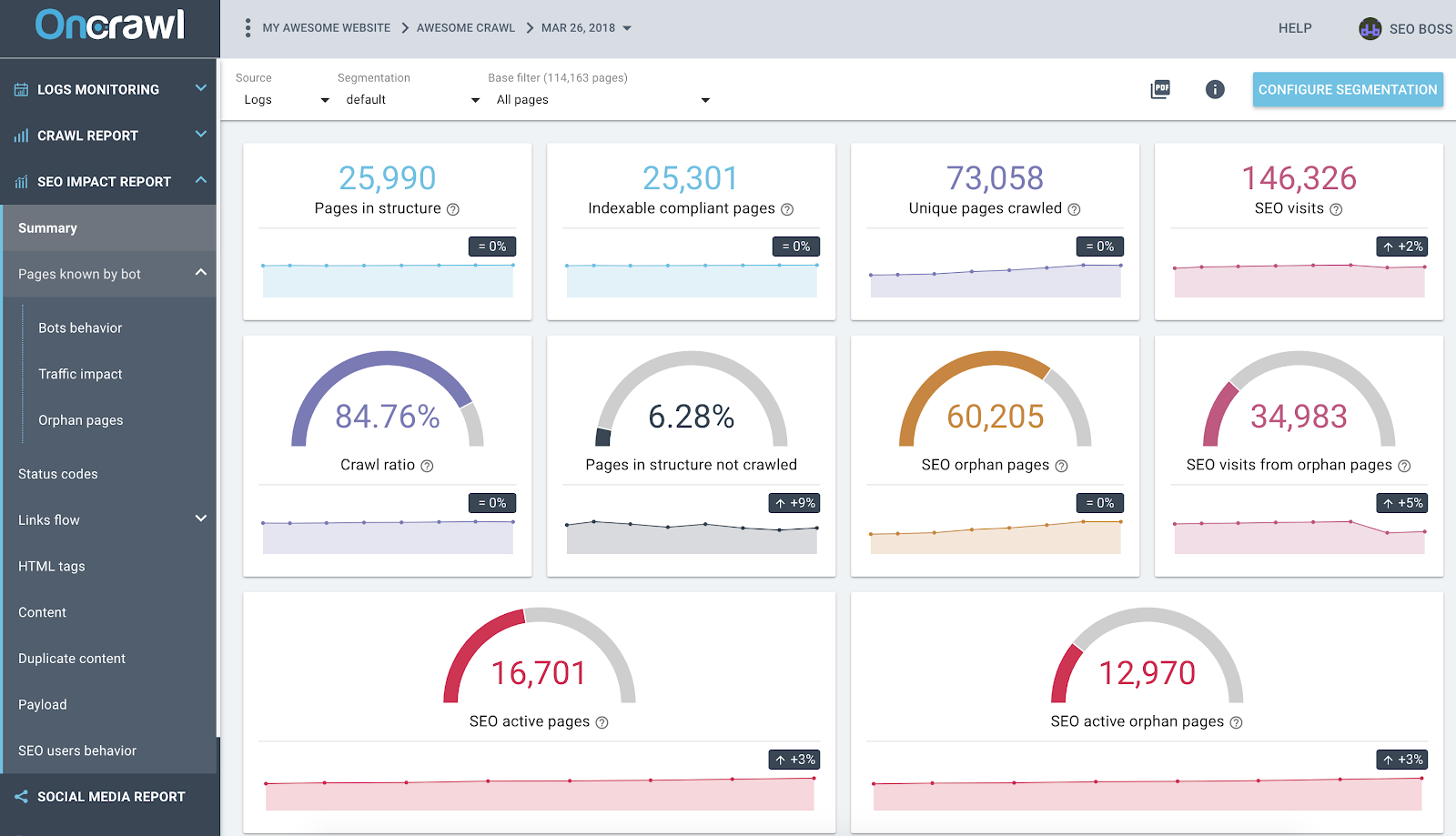

Raport wpływu na SEO OnCrawl na podstawie logów i analizy krzyżowej danych indeksowania

Powyższy zrzut ekranu przedstawia stan Twoich dzienników i danych indeksowania. Szybko zauważysz, że:

- W strukturze znajduje się 25 990 stron – znalezionych przez naszego robota indeksującego i uwzględniających wszystkie linki, którymi podążał na stronie;

- 73 058 stron jest indeksowanych przez Google – to 3x więcej niż w strukturze;

- Współczynnik indeksowania 84% – (zindeksowane strony OnCrawl + aktywne strony z dzienników + zindeksowane strony Google) / strony zindeksowane przez Google;

- Ponad 6% stron wewnętrznych nie jest indeksowanych — wystarczy kliknąć czarne wiadro, aby wyświetlić listę tych stron w Eksploratorze danych;

- 60 tys. stron osieroconych – różnica między stronami w strukturze a stronami indeksowanymi przez Google;

- 34 tys. wizyt SEO na tych stronach – wygląda na to, że jest problem z linkowaniem wewnętrznym!

Najlepsza praktyka: OnCrawl daje możliwość eksploracji danych za każdym wykresem lub metryką, po prostu klikając na nie. W ten sposób uzyskasz do pobrania listę adresów URL, które są bezpośrednio filtrowane w eksplorowanym przez Ciebie zakresie.

2# Dowiedz się, które adresy URL zużywają najwięcej (lub najmniej) budżetu indeksowania

Wszystkie zdarzenia z wizyt botów Google są znane platformie danych OnCrawl. Dzięki temu możesz poznać – dla każdego adresu URL – wszystkie dane skompilowane według czasu.

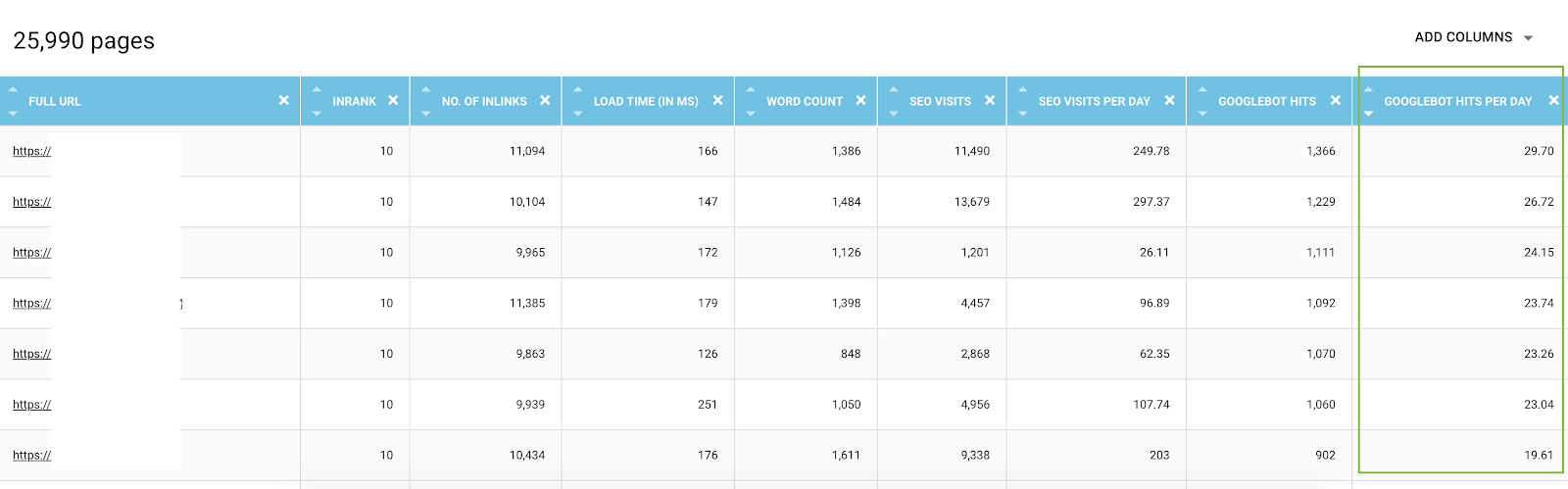

W Eksploratorze danych możesz dodać dla każdego adresu URL kolumny trafień bota (przez okres 45 dni) oraz trafień według dnia i przez boty, co jest średnią wartością dzienną. Te informacje są przydatne do oceny wykorzystania budżetu indeksowania Google. Często okaże się, że ten budżet nie jest jednakowy we wszystkich witrynach.

Lista wszystkich adresów URL z Eksploratora danych ze wskaźnikami indeksowania i filtrowana według trafień botów według dnia

W rzeczywistości niektóre czynniki mogą wywołać lub zmniejszyć budżet indeksowania. W tym artykule utworzyliśmy listę najważniejszych wskaźników dotyczących znaczenia strony Google. Głębokość, liczba linków prowadzących do strony, liczba słów kluczowych, szybkość strony, InRank (wewnętrzna popularność) wpływają na indeksowanie botów. Więcej dowiesz się w następnym akapicie.

3# Poznaj swoje najlepsze strony SEO, najgorsze strony SEO i określ czynniki sukcesu stron

Korzystając z Eksploratora danych, masz dostęp do kluczowych wskaźników dotyczących stron — ale porównywanie setek wierszy i wskaźników może być skomplikowane. Używanie kolumn do segmentowania według trafień botów według dnia i odwiedzin SEO według dnia jest sprzymierzeńcem w eksploracji danych.

- Pobierz pliki JSON CS – Bot Hits by Day i CS – SEO visits by day;

- Dodaj je jako nowe segmenty.

W rzeczywistości możesz tworzyć segmentacje na podstawie tych dwóch wartości wynikających z analizy logów, aby uzyskać pierwszy rozkład stron według grup. Ale możesz także przefiltrować każdą grupę tych segmentacji, aby szybko wykryć – w każdym raporcie OnCrawl – które strony nie osiągają oczekiwanych wartości.

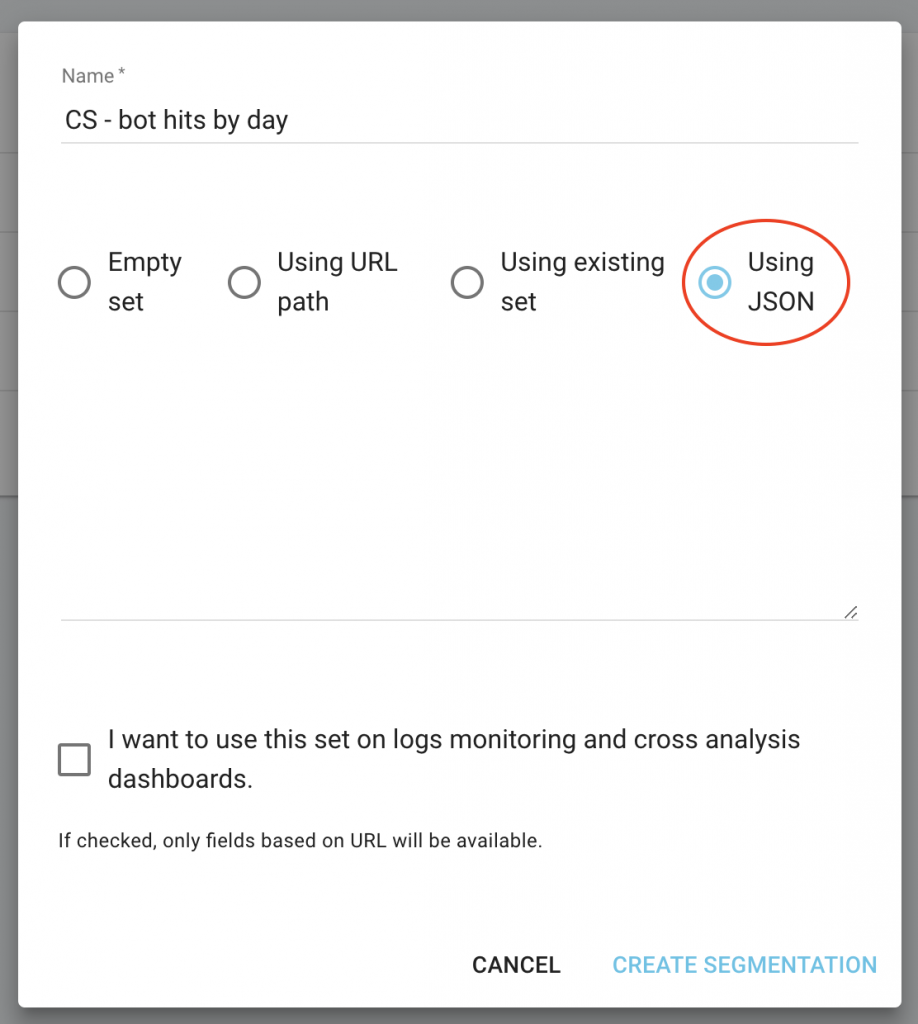

Na stronie głównej projektu kliknij przycisk „Konfiguruj segmentację”.

Następnie utwórz nową segmentację

Użyj importu JSON, wybierając pojemność „Using JSON” i skopiuj/wklej pobrane pliki.

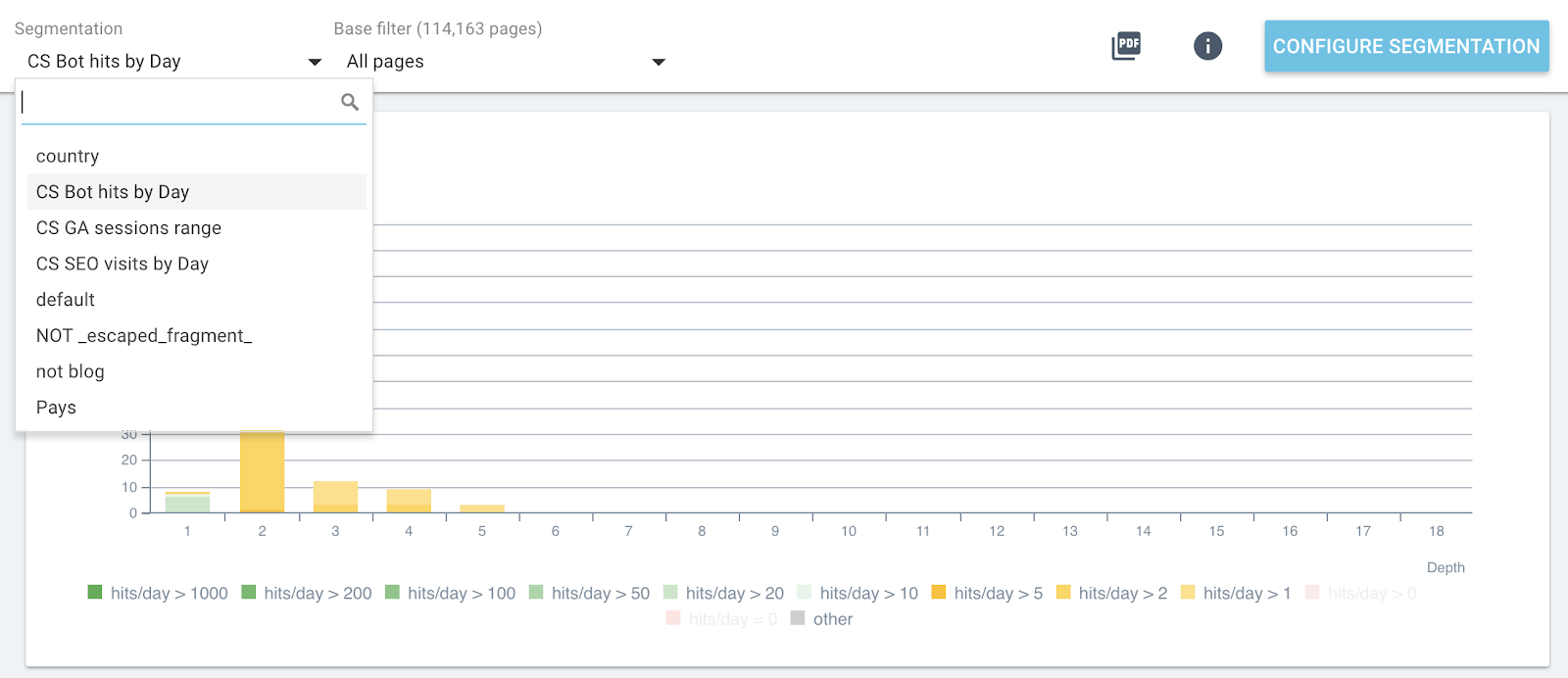

Teraz możesz przełączać segmentacje za pomocą górnego menu w każdym raporcie.

Zmiana segmentacji na żywo we wszystkich raportach OnCrawl

Dzięki temu na każdej grafice uzyskasz wpływ analizowanych danych i powiązanych ze stronami pogrupowanymi według trafień botów lub wizyt SEO.

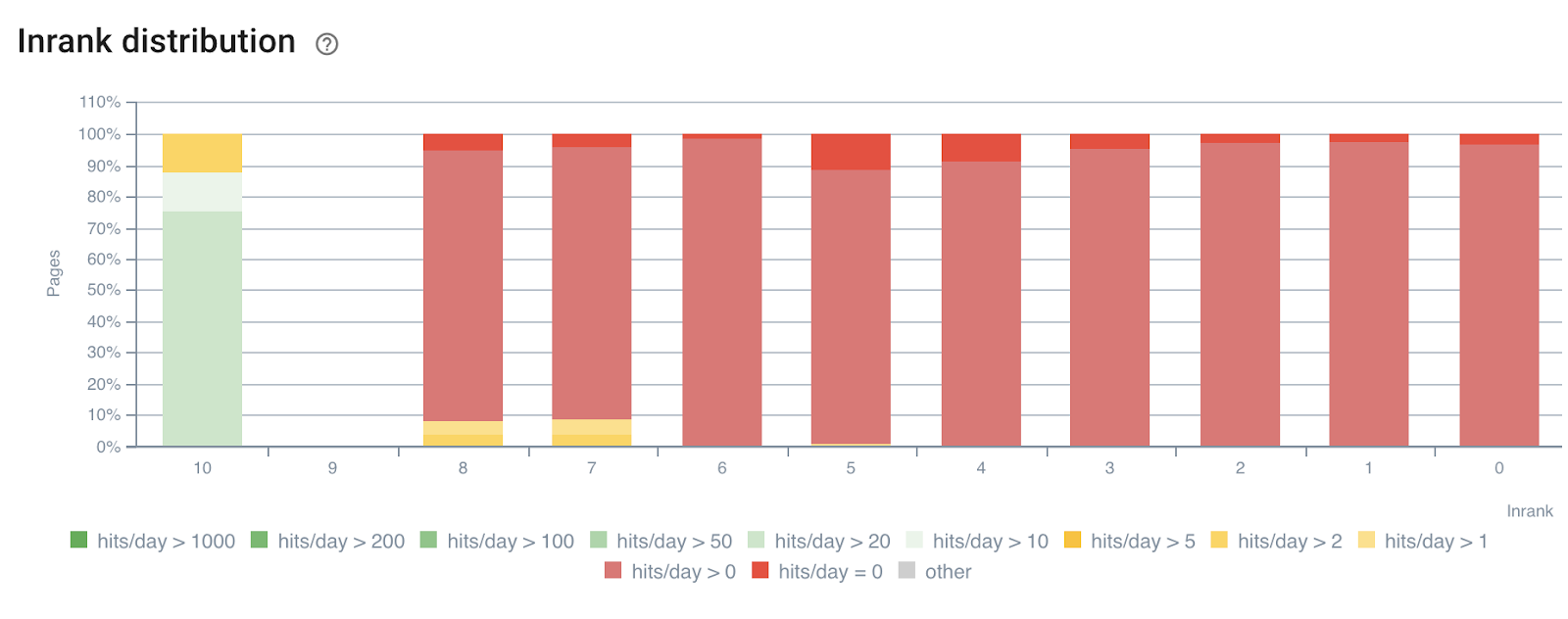

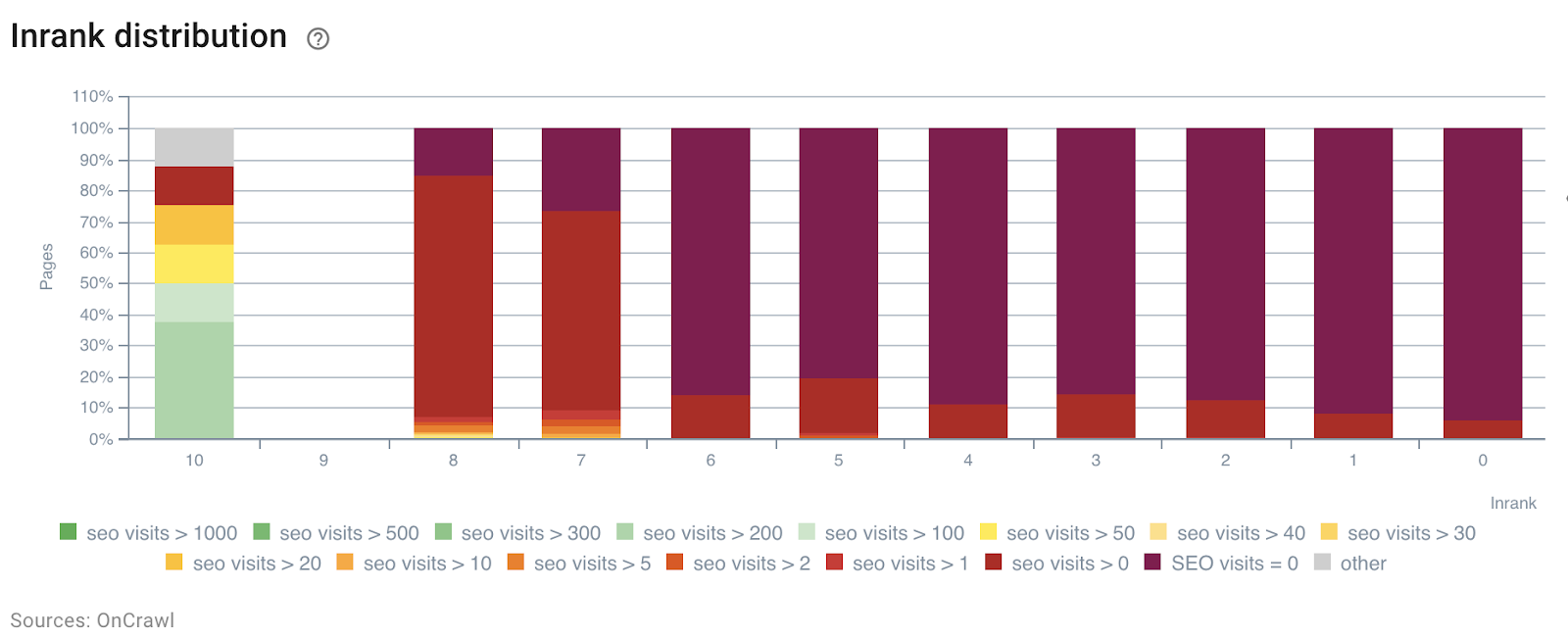

W poniższym przykładzie wykorzystaliśmy te segmenty, aby zrozumieć wpływ wewnętrznej popularności InRank – na podstawie siły linków według głębokości. Co więcej, trafienia botów i wizyty SEO są skorelowane na tej samej osi.

Rozkład InRank według trafień botów w ciągu dnia

Rozkład InRank według wizyt SEO w ciągu dnia

Głębokość (liczba kliknięć ze strony głównej) ma wyraźny wpływ zarówno na trafienia botów, jak i wizyty SEO.

W ten sam sposób każdą grupę stron można wybrać niezależnie, aby wyróżnić dane z najczęściej odwiedzanych lub odwiedzanych stron.

Pozwala to szybko wykryć strony, które mogłyby działać lepiej, gdyby zostały zoptymalizowane, np. liczbę słów na stronie, głębokość czy liczbę linków przychodzących.

Wystarczy wybrać odpowiednią segmentację i grupę stron, które chcesz analizować.

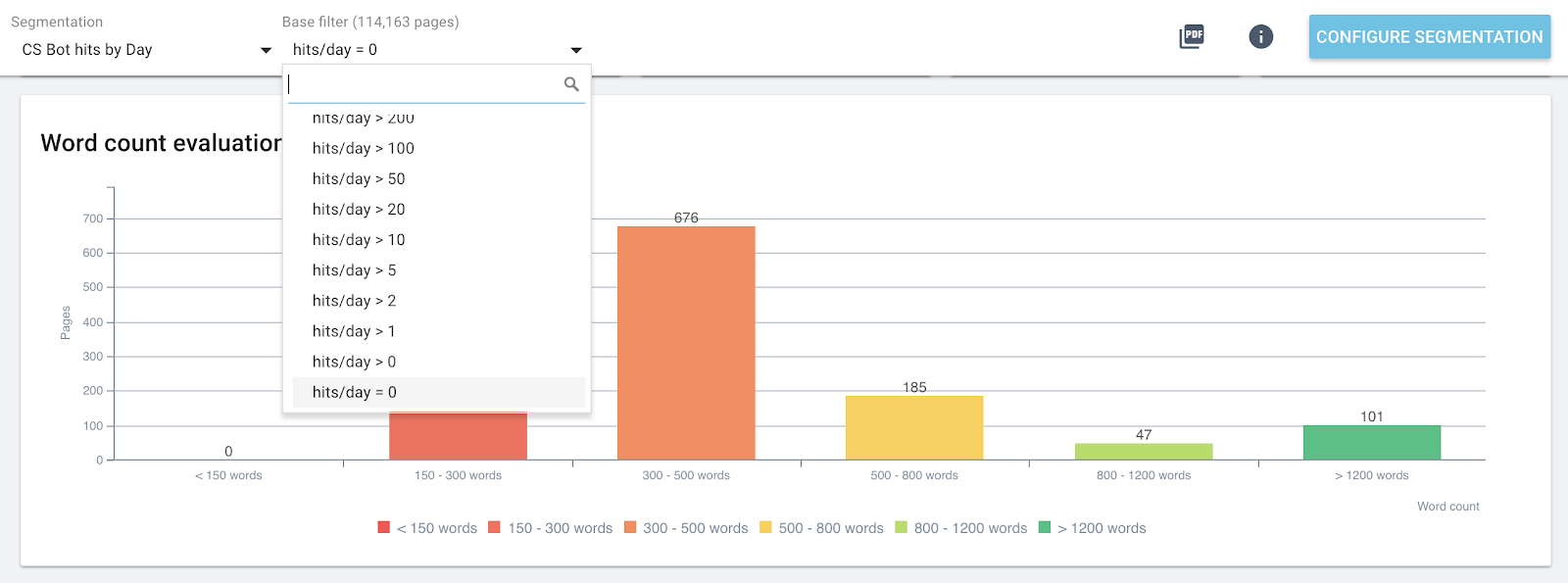

Rozkład słów na stronie dla grupy zawierającej 0 trafień bota dziennie

4# Określ wartości progowe, aby zmaksymalizować budżet indeksowania i wizyty SEO

Idąc dalej, Raport Wpływu SEO – indeksuj i loguj analizę danych krzyżowych – może wykryć wartości progowe, które pomagają zwiększyć liczbę wizyt SEO, częstotliwość indeksowania lub wykrywanie stron.

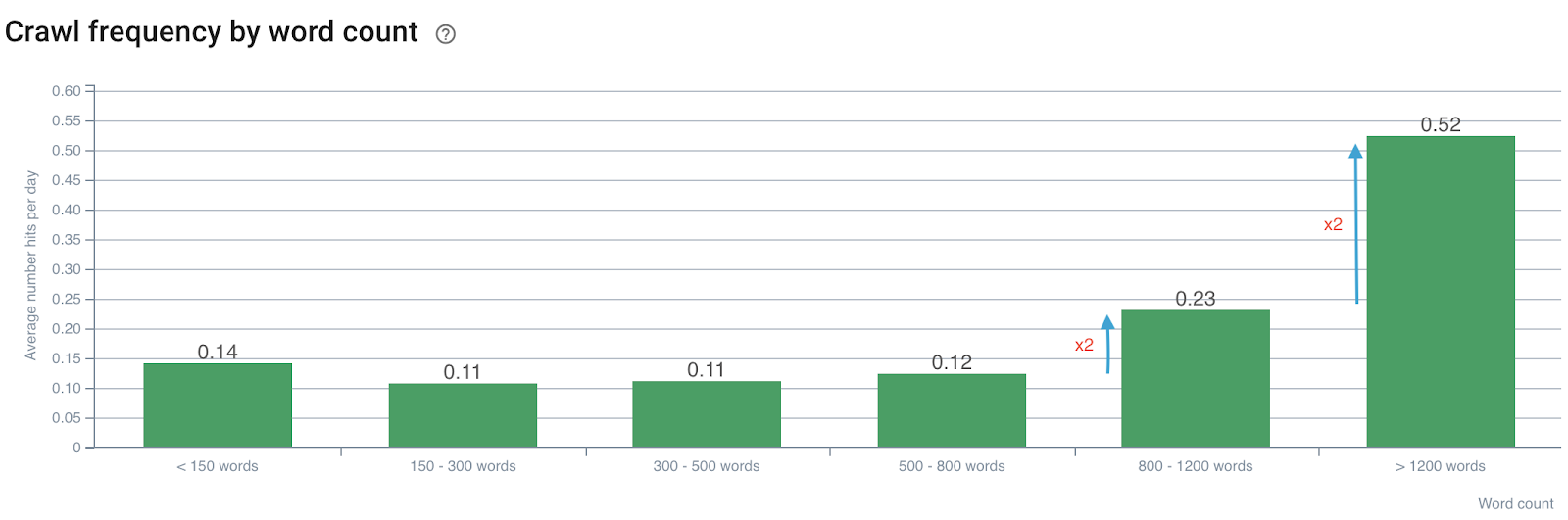

Wpływ liczby słów na częstotliwość indeksowania

Częstotliwość indeksowania według liczby słów

Zauważamy, że częstotliwość indeksowania jest podwajana, gdy liczba słów przekracza 800. Następnie jest również podwajana, gdy liczba słów na stronie przekracza 1200.

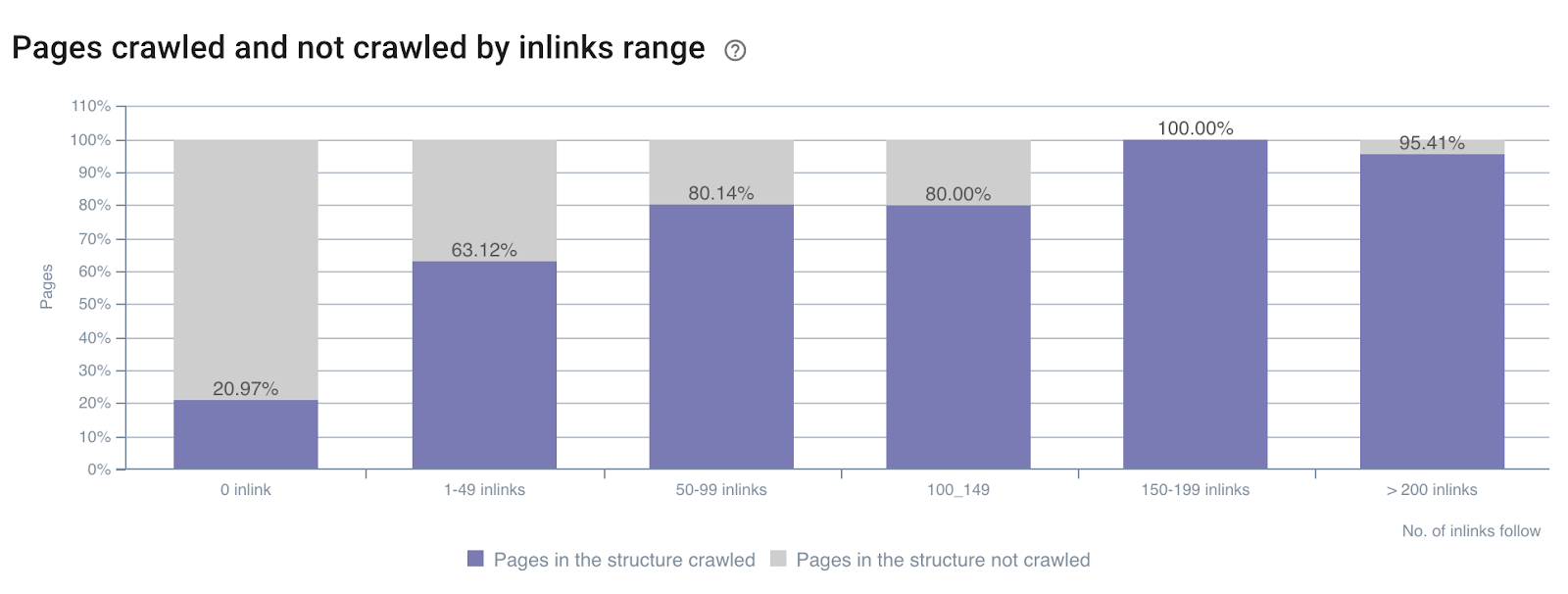

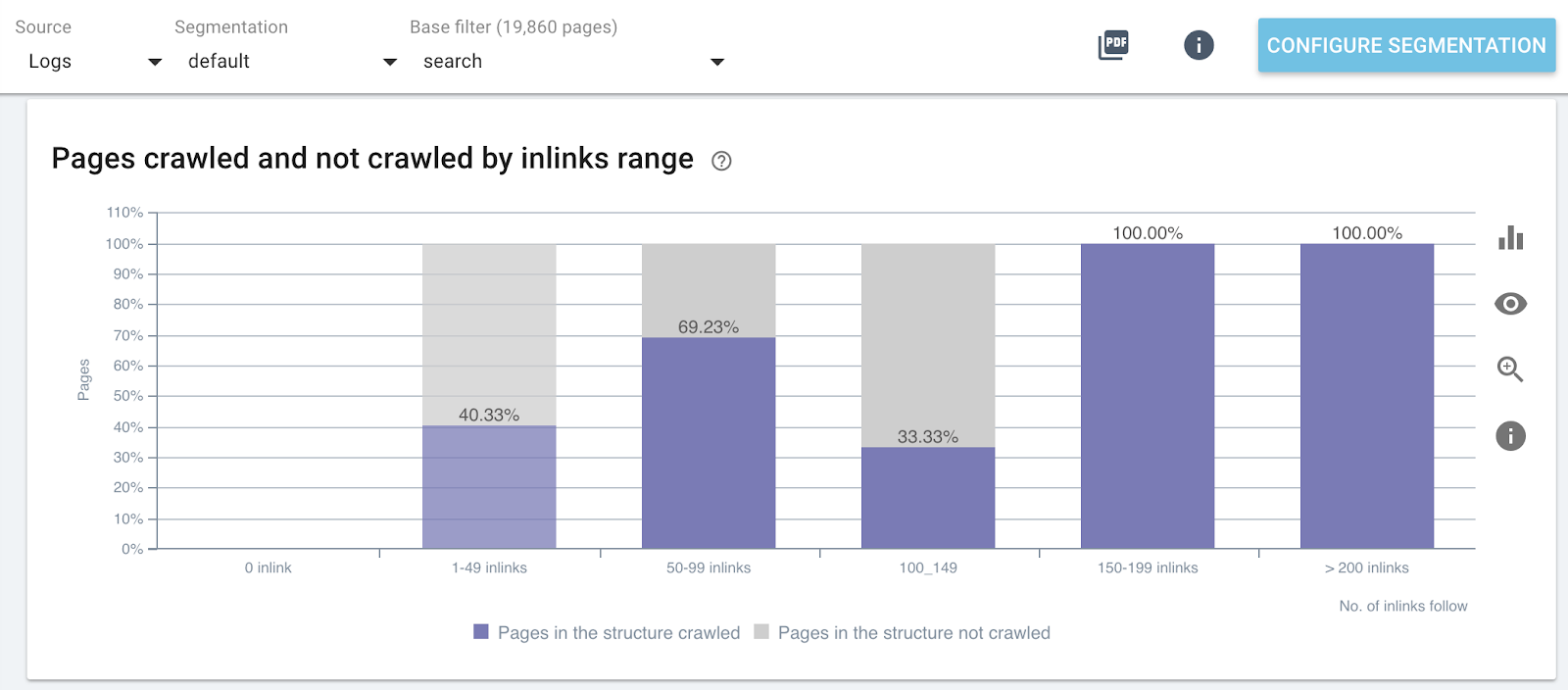

Wpływ liczby linków na wskaźnik indeksowania

Współczynnik indeksowania według liczby linków w całej witrynie

Wskaźnik indeksowania według liczby linków w określonych częściach witryny (stron wyszukiwania)

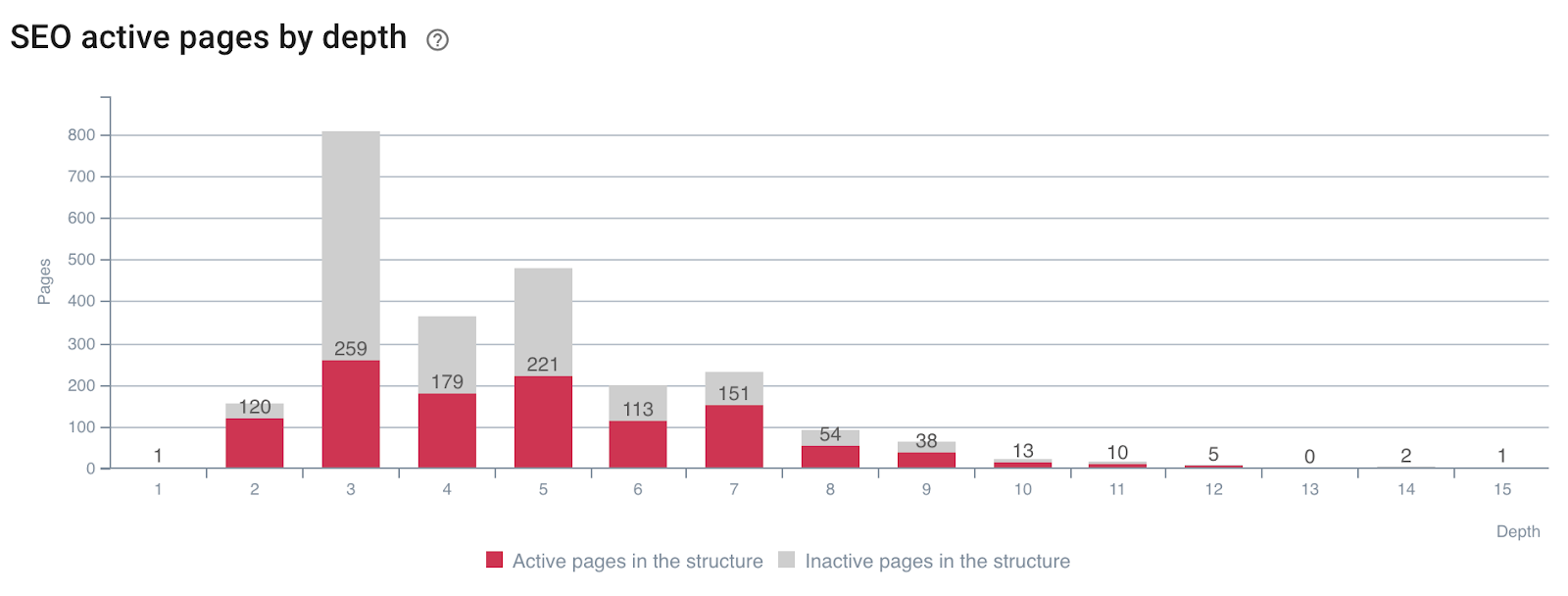

Wpływ głębokości na aktywność stron

Strony generujące wizyty SEO (lub nie) według głębokości

Widać, że posiadanie odpowiednich wskaźników witryny podczas indeksowania i przekraczania danych dzienników pozwala natychmiast wykryć, jakie optymalizacje SEO są potrzebne, aby manipulować indeksowaniem Google i poprawiać wizyty SEO.

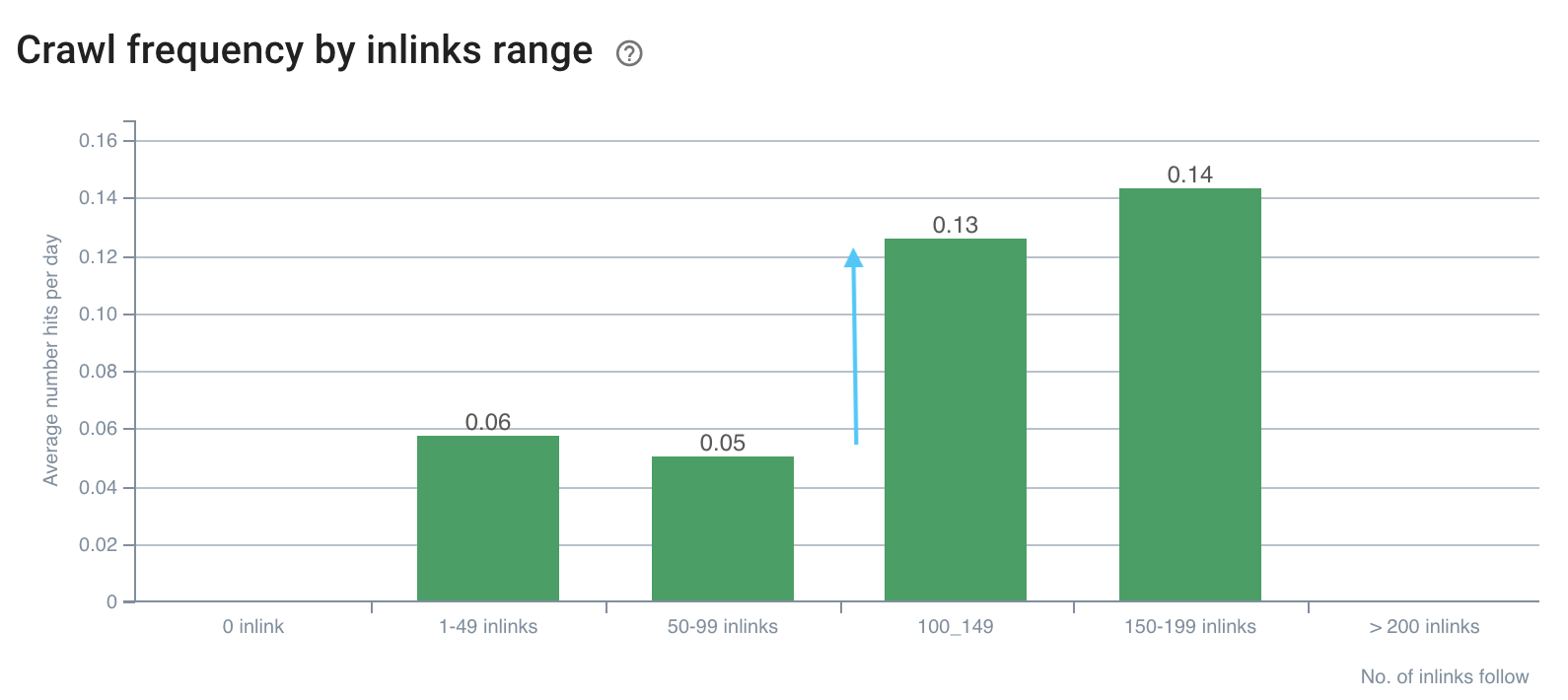

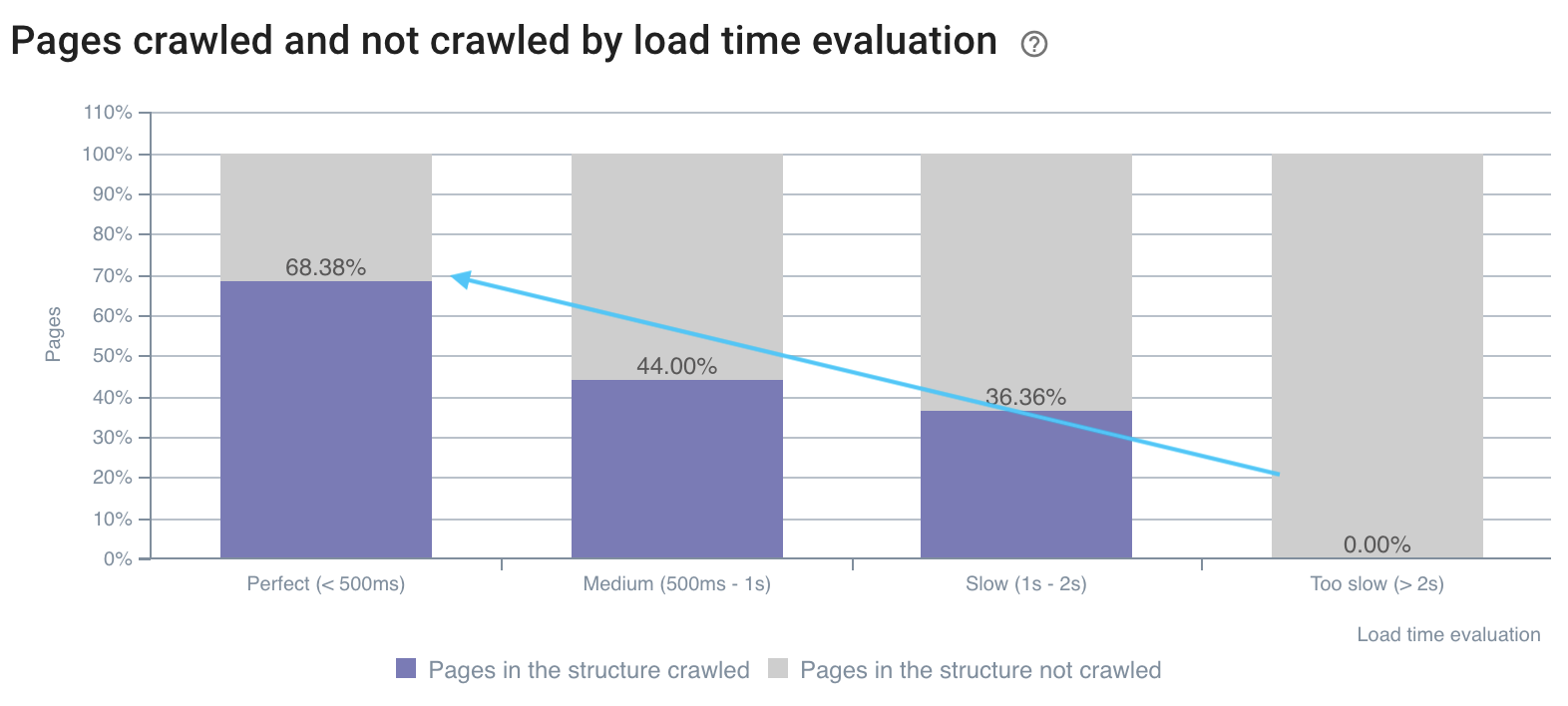

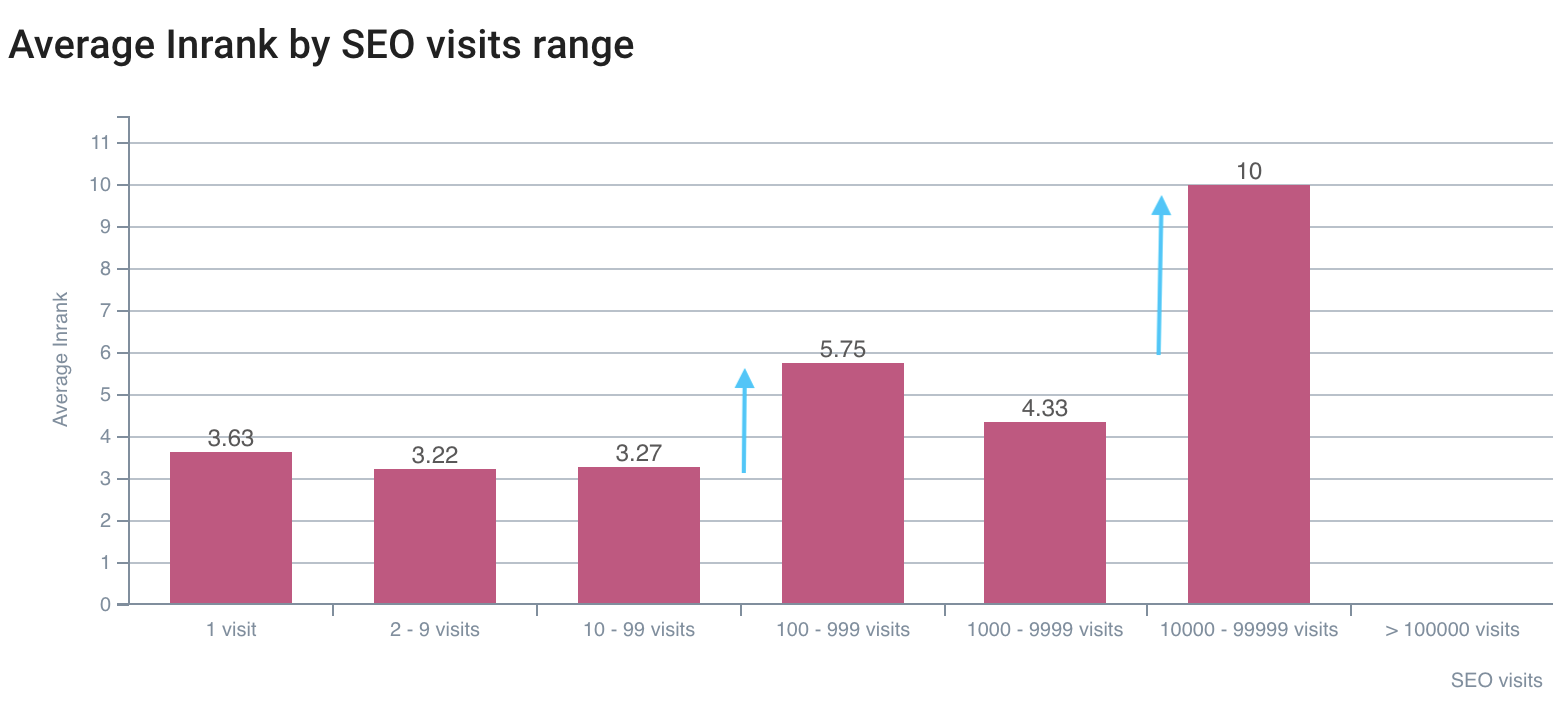

5# Określ, jak czynniki rankingu SEO wpływają na częstotliwość indeksowania

Wyobraź sobie, że możesz wiedzieć, jakie wartości kierować, aby zmaksymalizować SEO? Do tego właśnie służy analiza danych krzyżowych! Pozwala precyzyjnie określić, dla każdej metryki, przy której progowej częstotliwości indeksowania, szybkości indeksowania lub aktywności są maksymalizowane.

Widzieliśmy powyżej – na przykładzie liczby słów na stronie i częstotliwości indeksowania – że istnieją wartości wyzwalające częstotliwość indeksowania. Luki te należy przeanalizować i porównać dla każdego typu strony, ponieważ szukamy skoków w zachowaniu botów lub odwiedzin SEO.

Jak te przedstawione poniżej:

Częstotliwość indeksowania ma przerwę na ponad 100 linków

Szybkość indeksowania jest lepsza na szybkich stronach

Pierwsza luka w wizytach SEO jest na InRank 5,75, najlepsza jest na InRank 10 (strona główna)

Połączenie danych indeksowania i dzienników pozwala otworzyć czarną skrzynkę Google i dokładnie określić wpływ danych na indeksowanie i wizyty botów. Wdrażając swoje optymalizacje w tych analizach, możesz poprawić swoje SEO w momencie każdego wydania. To zaawansowane zastosowanie jest trwałe w czasie, ponieważ możesz wykryć nowe wartości do osiągnięcia przy każdej analizie danych krzyżowych.

Jakieś inne sztuczki z analizą danych, którymi chciałbyś się podzielić?