A/B 테스트 결과를 배우고 개선하는 7가지 주요 단계

게시 됨: 2021-04-13

A/B 테스트가 방금 완료되었지만 예상한 결과가 표시되지 않습니다.

다른 모든 사람들은 버튼 색상 변경이나 약간의 조정만으로 큰 효과를 본 사례 연구를 공유하고 있지만 테스트에서 전환이 개선되지 않았거나 더 심하게는 대신 손실이 발생한 것 같습니다. 이제 다음을 수행해야 합니다. 이것을 상사에게 제시하십시오.

글쎄, 당신의 테스트가 실제로 패자가 아니라면 어떻게 될까요?

만약 그것이 변장한 승자라면?

그리고 그것이 패자 라면, 시험에서 패하는 것이 실제로 좋은 일이라면?

이 가이드에서는 A/B 테스트 결과에 대한 더 깊은 관점을 얻을 수 있도록 도와드릴 것입니다.

A/B 테스트에서 배우는 것이 왜 그렇게 중요한지, 그리고 왜 패자가 매출을 올릴 수 있는지 다룰 것입니다. 우리는 당신이 따를 수 있는 프로세스를 공유하여 당신이 단계별로 당신의 테스트를 완전히 분석하고 당신이 보고 있는 것, 승패에 대해 확신을 가질 수 있도록 합니다.

더 좋은 점은 데이터가 불안하고 분석을 확인하고 싶지 않은 것에서 동료와 결과를 공유하는 데 자신감을 가질 수 있도록 도와드리는 것입니다.

그럼 본격적으로...

A/B 테스트에서 배워야 하는 이유는 무엇입니까?

처음에는 명백한 비용이 수반됩니다. 각 테스트는 설정하는 데 비용이 듭니다. 손실된 변형이 있는 경우 해당 변형의 매출도 감소합니다.

하지만 문제는 다음과 같습니다.

A/B 테스트(일반적으로 CRO)는 더 많은 돈을 버는 것만이 아닙니다. 데이터를 구매하는 것 입니다. 청중에 대한 데이터는 청중을 더 잘 이해하고 더 나은 제품과 서비스를 제공하는 데 도움이 될 수 있습니다. 이는 더 많은 판매와 향상된 고객 경험, 심지어 새로운 제품 제안에 대한 통찰력으로 이어집니다.

당신이 봉사하는 사람들에 대해 더 많이 알수록 더 잘할 수 있습니다. 그렇기 때문에 대부분의 테스트가 실패하더라도 자주 테스트하고 테스트하는 것이 중요합니다.

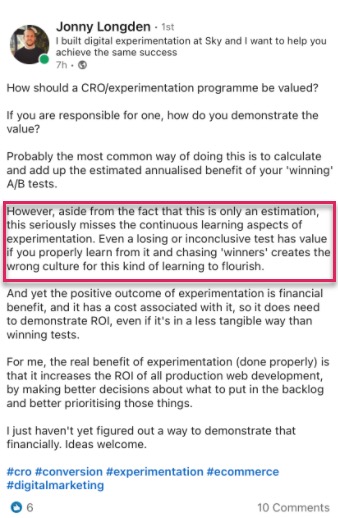

우리도 이런 생각을 하고 있는 것이 아닙니다.

사실, 우리 도구를 사용하여 28,304개의 테스트에 대한 내부 데이터를 전문 테스트 기관과의 대화와 함께 살펴보았을 때 대부분의 회사는 10번의 테스트에서 1명의 승자를 찾는 반면 에이전시는 일반적으로 모든 테스트에서 1명의 승자를 찾습니다. 4.

그리고 나는 당신이 생각하는 것을 알고 있습니다.

확실히 그것은 내가 각 테스트에서 90%의 시간을 잃는다는 것을 의미합니까?

예, 하지만 테스트 청중의 절반에게만 해당됩니다. 나머지 절반은 여전히 귀하의 사이트를 보고 평소와 같이 전환하고 있습니다.

또한 얻은 데이터는 작동하지 않는 것을 찾는 데 도움이 되므로 작동하는 방법을 배울 수 있습니다. 테스트하고, 배우고, 다시 테스트하고 효과가 있는 것을 찾을 때까지 계속합니다.

그리고 이 10% 테스트에서 이겼습니까?

더 큰 영향을 주기 위해 유사한 모든 페이지에서 사이트 전체로 확장되기 전에 계속해서 개선할 수 있는 점진적인 상승도를 지속적으로 제공할 수 있습니다.

이것이 디지털 플랫폼에서 전환이 증가하는 것을 볼 때의 아름다움입니다. 단 1%의 상승도라는 단순한 규모는 현재와 미래의 모든 트래픽 모두에서 비즈니스에 막대한 영향을 미칠 수 있습니다. 실제로 Jeff Bezos는 연례 주주 보고서에서 Amazon과 테스트 및 개선 목표를 "세계에서 실패하기 가장 좋은 곳"이라고 부르며 같은 방식으로 생각합니다.

100배의 결과가 나올 확률이 10%라면 매번 그 베팅을 해야 합니다. 하지만 열에 아홉은 여전히 틀릴 것입니다 .

아마존 제프 베조스

더 많은 판매와 더 나은 통찰력이 A/B 테스트의 유일한 이점은 아닙니다.

테스트를 실행하면 장애물 주제 및 그룹 이론에서 벗어날 수 있습니다. 가능한 웹 디자인 변경 사항에 대해 논의하고 아무 것도 하지 않는 대신 몇 달 동안 작업을 수행하고 테스트하여 팀이 다른 일에 집중할 수 있도록 합니다. (실시간으로 푸시하기 전에 효과를 테스트하십시오!)

그뿐만 아니라 A/B 테스트만 알 수 있는 청중에 대해 새로운 것을 배울 수 있습니다.

이론 작성 및 고객 설문 조사는 훌륭하지만 청중이 말하는 내용뿐만 아니라 청중이 사이트에서 실제로 수행하는 작업이 가장 중요합니다. 테스트를 이해하면 이러한 아이디어와 피드백을 증명하거나 반증하는 데 도움이 됩니다.

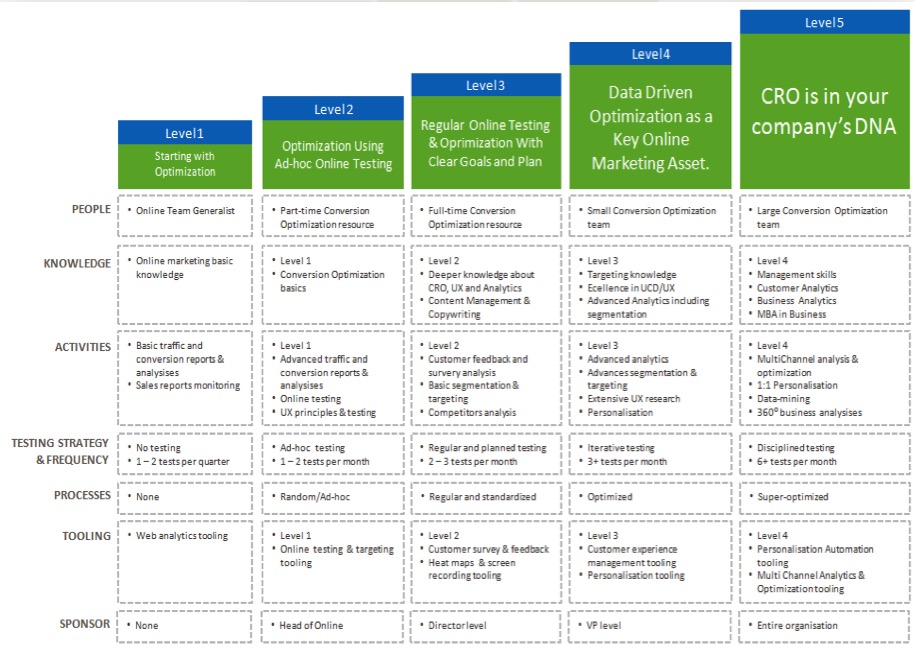

결과를 더 많이 이해할수록 테스트에 대한 자신감이 높아져 CRO 노력을 '성숙'하고 테스트를 더 자주 실행할 수 있으며 내부 테스트 팀 구축을 시작할 수도 있습니다.

이제 각 A/B 테스트에서 학습의 이점을 확인했으므로 실행하는 각각의 새 테스트를 분석하는 간단한 프로세스를 안내해 드리겠습니다.

A/B 테스트에서 배우기 위한 7단계 프로세스(향후 테스트에서 개선하는 데 사용할 수 있는 시스템과 함께)

우리는 이것을 따라야 할 7가지 주요 단계로 분류했습니다.

여기에서 권장하는 모든 방법이나 도구가 없을 수도 있지만, 어떻게 맞는지 보고 그 가치를 측정하고 향후 테스트에 통합할지 여부를 결정할 수 있습니다.

1단계: 데이터가 정확하고 유효하며 유의미한지 확인

이것은 이 전체 프로세스에서 가장 중요한 부분입니다. 테스트에 대한 정보가 정확하고 유효한지 확인하여 결과를 확신할 수 있습니다.

그렇다면 테스트 결과가 신뢰할 수 있는 데이터를 제공하는지 어떻게 확인할 수 있습니까?

글쎄, 당신이 할 수있는 몇 가지 일이 있습니다 ...

도구 정확도 확인

이제 대부분의 사람들은 이것을 놓치고 있습니다. 사이트 방문자가 한 달에 10,000명을 넘지 않으면 건너뛰어도 됩니다. 기술적으로 CRO를 시작할 필요가 없으며 트래픽 양이 많은 사이트에서 가장 잘 작동하지만 큰 사이트에서는 실제로 차이를 볼 수 있으므로 여기에 포함하지 않는 것이 좋습니다.

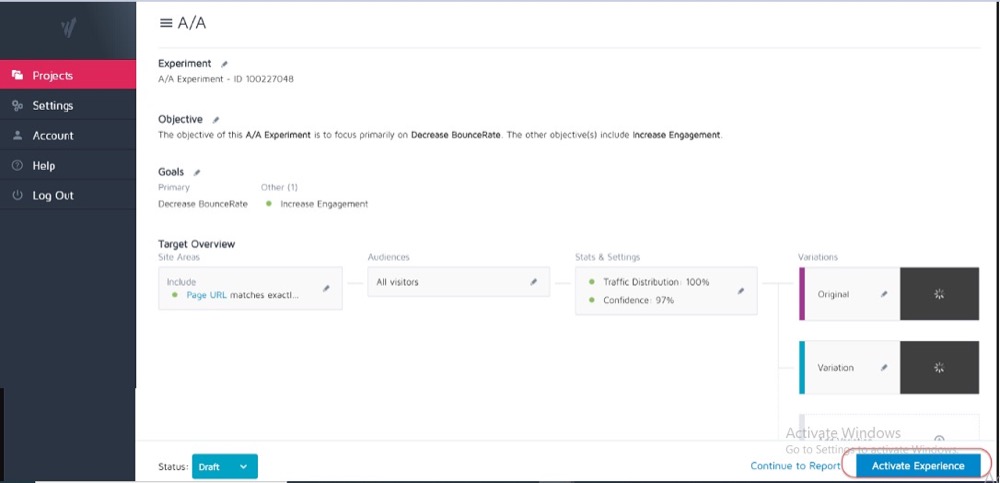

이상적으로는 현재 테스트 도구에서 이미 A/A 테스트를 실행하여 정확도와 문제가 있는지 확인하는 것이 좋습니다.

어떻게?

웹 페이지의 동일한 사본 2개로 간단한 분할 테스트를 실행한 다음 동일한 두 페이지의 결과를 추적합니다.

그들 사이에는 차이가 없기 때문에 결과는 각 페이지에 대해 동일해야 합니다. 그러나 도구와 도구가 데이터를 측정하거나 추적하는 방법으로 인해 일부 불일치가 있을 수 있습니다.

이를 미리 알면 테스트 결과의 정확성에 대한 허용 오차를 확보하고 향후 모든 테스트에 대한 지침으로 사용할 수 있습니다.

예시

A/A 테스트에서 두 개의 동일한 페이지 간의 전환율 차이가 0.5%인 것을 발견했다면 대조군과 대안 간의 차이가 0.5%에 불과할 때 승자를 나타내는 테스트 결과를 경계할 수 있습니다.

결과를 믿기 전에 테스트에서 1% 이상의 상승도를 보여야 한다는 내부 지침을 설정할 수 있습니다. 다시 말하지만, 새 도구를 시도하거나 현재 도구에 보고에 문제가 있거나 잘못 설정되었다고 생각되는 경우 A/A 테스트를 한 번만 실행하면 됩니다.

A/A 테스트는 정확하게 확인하는 데 필요한 샘플 데이터가 상당히 클 수 있기 때문에 대규모 트래픽 사이트에서 가장 잘 작동하지만 1% 오류의 차이는 클 수 있습니다.

고객이 사이트와 상호 작용하는 방식에 대한 유효한 보기를 얻을 수 있을 만큼 충분히 오래 테스트를 실행하십시오.

이제 도구를 신뢰하므로 이전에 통계적으로 차단할 수 있을 만큼 충분한 전환이 발생하더라도 2-4주 동안 테스트를 실행하려고 합니다.

왜요?

청중이 요일이나 특정 월의 특정 단계에 따라 사이트와 상호작용하는 방식이 다르기 때문입니다.

예시

청중의 사람들이 목요일에 급여를 받았다면 테스트가 월요일부터 수요일까지만 실행된다면 놓칠 수 있는 인상을 보게 될 것입니다. 그렇죠?

마찬가지로, 다른 사용자는 격주 또는 월 단위로 급여를 받을 수 있으며, 테스트가 테스트에 포함될 만큼 충분히 오래 실행되지 않으면 결과가 왜곡될 수 있습니다. 놓친 시간 동안 판매량이나 트래픽이 더 낮다고 가정할 수 있습니다.

언제 테스트를 종료해야 하는지 어떻게 알 수 있습니까? A/B 테스트 통계적 중요성: 테스트를 종료하는 방법 및 시기에 대해 자세히 알아보기

결과에 영향을 줄 수 있는 모든 내부 또는 외부 요인을 인식하십시오.

데이터를 왜곡할 수 있는 고유하거나 예약된 이벤트입니다.

예를 들어 CEO나 회사가 뉴스에 나왔거나 현재 마케팅 캠페인이나 프로모션을 진행 중이거나 국경일이나 무작위 트래픽 급증과 같은 외부 요인이 있는 경우입니다.

이 모든 것이 사이트 트래픽에 영향을 미치고 해당 기간 동안 결과의 정확도를 변경할 수 있습니다.

실화:

약 6년 전 저는 서핑 의류 회사를 운영했습니다.

어느 날 갑자기 트래픽이 약 800% 급증했고 이탈률이 급증했습니다. 우리는 새로운 마케팅 캠페인을 실행하지 않았기 때문에 트래픽이 어디서 오는지 알아보기 위해 약간의 조사를 했습니다.

알고 보니 우리 티셔츠 중 하나에 한국 팝 밴드의 신곡과 같은 이름의 제품명이 있었고, 이틀 동안 우리는 그것에 대해 순위를 매기고 방문자를 확보했습니다.

물론 이 새로운 청중은 우리 제품에 전혀 관심이 없었고 곧 떠났습니다.

미쳤지?

또 다른 시간에 내 마케팅 블로그가 TV 회사의 브랜드 이름에 순위를 매기기 시작했는데 같은 일이 일어났습니다. 잘못된 잠재고객으로부터 트래픽이 급증했습니다.

이처럼 무작위적이지만 이러한 종류의 일이 발생할 수 있으므로 이와 같은 외부 또는 내부 이벤트를 알고 있어야 합니다. 항상 분석을 확인하여 트래픽이 어디에서 왔는지 확인한 다음 모든 것이 정상으로 돌아오면 테스트를 다시 시작할 수 있습니다.

충분한 데이터를 확보하십시오

테스트의 성능에 대한 유효한 아이디어를 얻기 위해 테스트에 충분한 전환이 있는지 확인하려고 합니다.

테스트 결과가 통계적으로 유의미한 경우에도 총 전환수가 50개에 불과하고 그 사이의 작은 차이가 있는 대조군과 변형을 갖는 것만으로는 청중에 대한 통찰력을 얻기에 충분하지 않습니다. 대부분의 전문가는 변형당 약 300개 이상의 전환이 일반적으로 좋은 경험 법칙이라는 데 동의합니다(나중에 분류하려는 경우 더 많이 포함).

데이터 세트가 클수록 사후 테스트 분석에서 인사이트를 더 쉽게 찾을 수 있습니다.

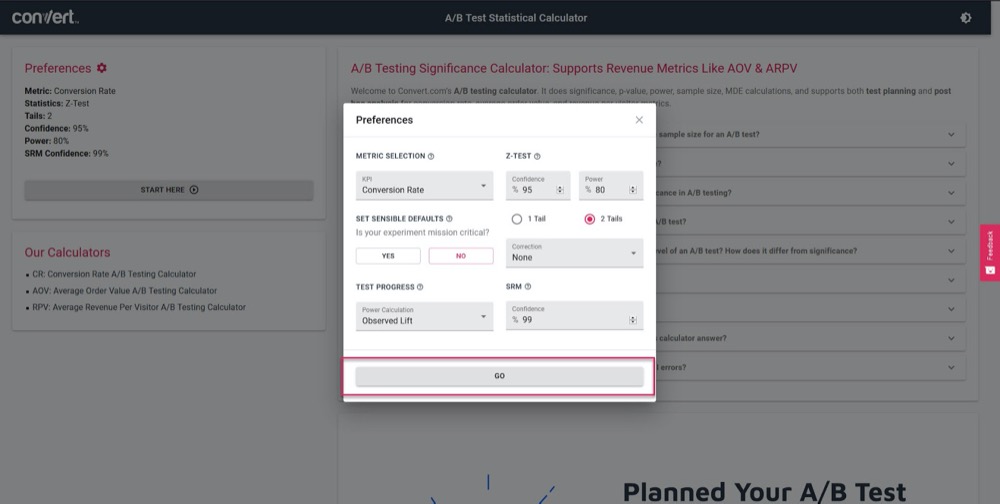

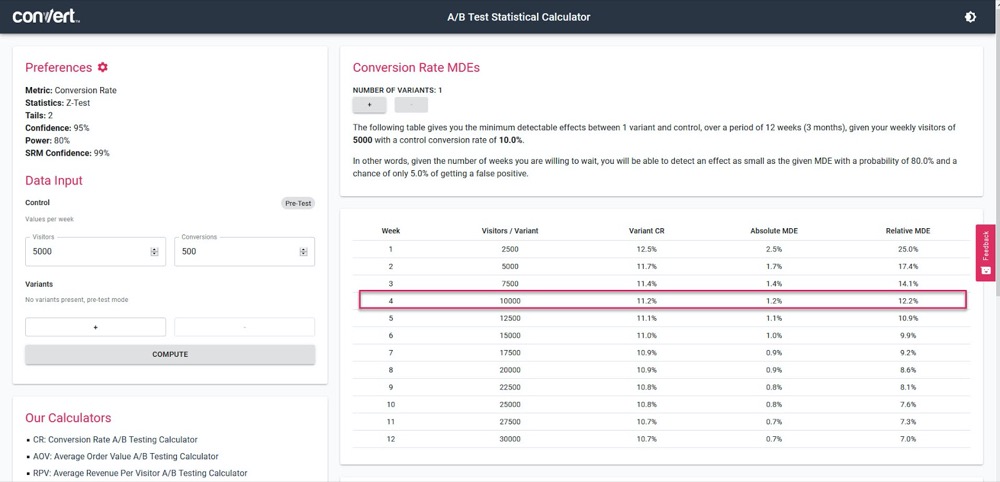

A/B 테스트 유의성 계산기를 사용하여 4주 판매 주기와 현재 '컨트롤' 페이지의 정보를 기반으로 테스트가 얼마나 정확한지 알아보십시오.

테스트 매개변수를 설정하기만 하면 됩니다.

그런 다음 현재 페이지의 전환 수와 함께 일주일에 테스트에 얼마나 많은 트래픽이 발생해야 하는지 입력한 다음 테스트에서 계산할 수 있는 정확도와 상승도 %를 찾으십시오.

위의 예에서 우리는 4주 후에 1.2%의 상승도를 측정할 수 있습니다. (정확도를 높이려면 테스트를 더 길게 실행하거나 테스트에서 트래픽 볼륨을 늘리면 됩니다.)

통계적으로 의미 있는 결과 얻기

통계적 유의성은 중요하지만 테스트할 때 가장 중요한 요소가 아닌 이유가 여기에 있습니다.

예, 결과에서 95-99%의 신뢰 등급을 볼 수 있을 만큼 충분히 오랫동안 테스트를 실행하고 싶지만 위에서 다룬 다른 모든 요소가 적중되었는지도 확인하고 싶습니다.

왜요?

A/A 테스트조차도 충분히 오랫동안 실행되지 않은 경우 동일한 사본보다 한 버전이 더 낫다는 95% 신뢰를 보여줄 수 있습니다.

(하루는 한 버전에서 모든 전환을 무작위로 볼 수 있고 다른 버전에서는 아무 것도 볼 수 없습니다.)

너무 많은 새 테스터가 캠페인이 '통계 서명'에 도달하면 캠페인을 중지하여 잘못된 데이터를 얻습니다. 그렇기 때문에 95% 이상의 통계적 유의성을 얻을 것을 권장하지만 300개 이상의 전환과 충분한 샘플 크기로 2-4개의 판매 주기에 걸쳐 테스트를 실행하십시오.

이 모든 작업을 수행하면 테스트가 유효하고 정확한 결과를 제공할 것이라고 믿을 수 있습니다.

테스트를 실행하여 이러한 기준을 충족하는 것이 얼마나 중요한지 아무리 강조해도 지나치지 않습니다.

너무 일찍 테스트를 호출하면 잘못된 정보가 제공되어 다음 중 하나로 이어질 수 있습니다.

- 정보가 충분하지 않아 잠재적인 승자를 찾지 못하고,

- 실적이 저조한 캠페인을 운영하는 이유는 캠페인이 승자라고 생각하지만 실제로는 전환율이 더 낮기 때문입니다.

- 또는 더 나쁜 것은 이러한 결과에 대한 잘못된 확신을 갖게 된 다음 배운 내용을 사용하여 사이트의 다른 부분으로 확장하여 부정적인 영향을 확대할 수 있다는 것입니다.

A/B 테스트 도구가 승리한 변형에 대한 결론에 도달하는 방법을 알고 있습니까? A/B 테스트 유의성 계산기를 사용하려면 여기를 클릭하십시오.

참고:

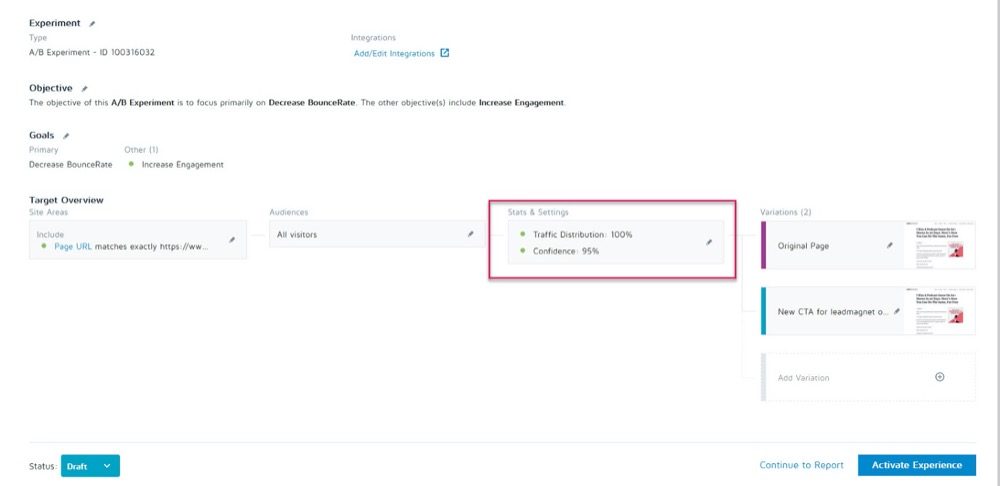

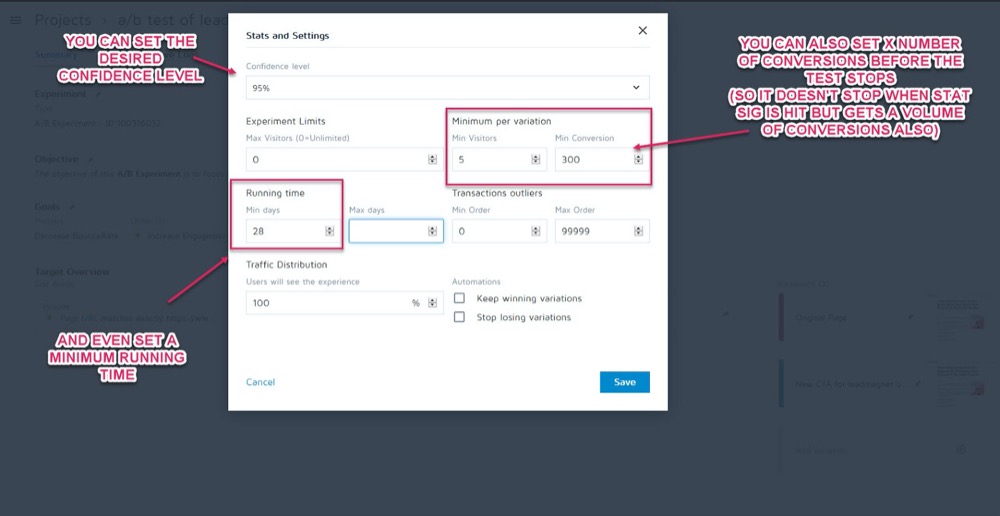

경험 변환 앱에서 실험의 통계 및 설정 섹션에서 테스트를 실행하기 전에 매개변수로 설정할 수 있습니다.

그런 다음 테스트를 호출하기 전에 원하는 신뢰 수준, 최소 실행 시간, 전환 수를 설정할 수 있습니다.

데이터가 정확하다고 확신했다면 이제 데이터를 분석할 차례입니다…

2단계: 마이크로, 매크로 및 가드레일 지표 확인

대부분의 사람들은 테스트를 보고 도구가 알려주는 모든 것에서 승자 또는 패자를 액면 그대로 받아들입니다.

물론 문제는 도구가 설정한 기준에 따라 테스트가 어떻게 수행되는지 알려줄 수 있다는 것입니다. CRO 테스터로서 우리는 항상 이러한 결과가 발생한 "방법"과 "이유"를 이해하여 배울 수 있기를 원합니다.

이제 몇 가지 확인해야 할 사항이 있지만 먼저 가장 중요한 세 가지를 다룰 것입니다. 미시적 및 거시적 결과 추적이 필요한 곳입니다.

설명하겠습니다:

- 마이크로 추적은 테스트를 최적화한 목표를 추적하는 것을 의미하며 더 많은 클릭, 가입 등이 될 수 있습니다.

- 매크로 추적은 일반적으로 판매인 비즈니스의 Northstar 메트릭에 미치는 영향을 확인합니다.

이것이 왜 중요합니까?

때로는 테스트 페이지에서 마이크로 이벤트의 상승도가 매크로에 생각하는 방식에 영향을 미치지 않는 경우가 있습니다.

예시

리드 캡처 페이지에서 CTA를 테스트하고 패자가 컨트롤보다 적은 리드를 얻는다고 가정해 보겠습니다.

어떤 테스트가 이겼는지 분명해 보이죠?

그러나 분석을 자세히 살펴보면 '패배' 테스트에서 나온 리드가 실제로 백엔드에서 훨씬 더 높게 전환되었고 훨씬 더 큰 ROI를 생성했음을 알 수 있습니다.

왜 이런 일이 일어날까요?

현재 페이지가 더 많은 청중에게 어필하고 더 많은 리드를 전환할 수 있지만 새로운 '잃어버린' 변형은 실제로 지금 바로 구매할 준비가 된 사람들에게 어필하고 있습니다.

예에서 패배한 캠페인은 실제로 Northstar 측정항목을 사용하여 훨씬 더 나은 전환율로 실행하고 싶은 페이지가 될 것입니다.

최종 목표를 기억하고 가장 큰 영향을 미치는 모든 것에 노력을 집중하십시오.

미시적 및 거시적 결과만 찾는 것은 아닙니다.

아직 하지 않았다면 캠페인에 'Guardrail 지표'를 추가하는 것을 고려하십시오.

이는 다른 변경 작업을 수행할 때 주시해야 하는 핵심 메트릭이므로 성능이 너무 중요하기 때문에 특정 테스트 방법을 롤백하거나 중지할 수 있습니다.

Uber에서는 주어진 시간에 100번의 실험을 진행합니다. 이러한 실험의 목표는 제품과 사용자 경험을 지속적으로 개선하는 것입니다. 그러나 때로는 실험자가 몇 가지 주요 메트릭을 염두에 두고 팀과 회사 전체에 중요한 몇 가지 다른 메트릭에 대한 영향을 인식하지 못할 수 있으며 실험이 실행됨에 따라 이러한 모니터링되지 않은 메트릭이 퇴보할 수 있습니다.

이러한 시나리오를 감지하고 완화하기 위해 실험 모니터링 플랫폼을 구축했습니다. 목표는 실험 실행 중에 저하되고 싶지 않은 몇 가지 가드레일 메트릭을 식별하고 모니터링하는 것입니다. 우리는 이러한 가드레일 메트릭을 지속적으로 모니터링하고 실험의 처리 그룹과 대조군 사이의 회귀를 감지하기 위해 순차적 A/B 방법론의 변형을 적용합니다. 회귀가 감지되면 실험 소유자에게 알림을 보냅니다 .

Suman Bhattacharya, 수석 데이터 과학자, Uber

예시

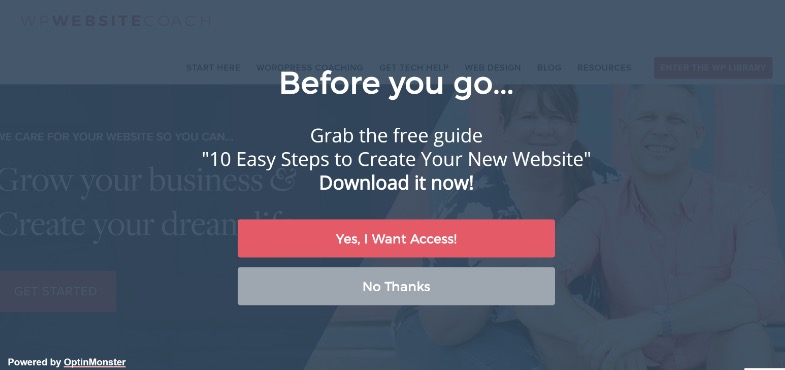

전체 화면 팝업을 사용하여 더 많은 리드를 수집하고 싶다고 가정해 보겠습니다.

일부 사이트에서는 잘 작동하지만 항상 그런 것은 아닙니다. (이것이 우리가 테스트하는 이유입니다!)

전체 화면 팝업을 설치하고 해당 페이지에서 더 많은 리드를 얻기 시작했지만 새로운 구독자에게 보내는 환영 이메일이 수신되지 않고 전달되지 않을 수 있습니다.

사람들이 팝업이 표시되지 않도록 하기 위해 가짜 이메일을 선택한 것으로 나타났습니다.

실제 구독자에 대한 이메일 전달 결과를 낮출 수 있으므로 이메일 목록에 가짜 리드가 포함되는 것을 원하지 않습니다. 또한 청중이 이메일을 속여야 한다고 느낄 정도로 사용자 경험을 낮추고 싶지 않아야 합니다.

이메일 마케팅은 판매 프로세스의 핵심 부분이므로 리드 캡처 페이지에서 A/B 테스트를 실행하는 동안 이메일 반송률이 설정값을 초과하면 이를 알려주는 알림을 설정하기로 결정했습니다.

이것은 가드레일 메트릭이 될 것입니다. 이 예에서는 손상되었음을 확인할 수 있으며 덜 방해가 되는 리드 캡처 방법을 사용하기로 결정했습니다.

말이 돼?

Guardrail 지표는 리드 캡처 및 이탈률만이 아닙니다. 사용자 경험에 영향을 미치는 하락을 보고 싶지 않은 주요 지표입니다.

사용자 경험의 저하를 방지하면서 중요한 메트릭도 개선하고 있는지 확인하려면 몇 가지 가드레일 메트릭을 정의하십시오. 이 메트릭은 특정 임계값에 의해 떨어질 경우 가정된 " 승리” 변형. 이것은 또한 전환 최적화와 UX 또는 브랜드 가이드라인 간의 논쟁을 끝내는 데 도움이 됩니다 .

알렉스 버켓(Alex Birkett), 전지전능한 디지털

이러한 메트릭이 귀하의 비즈니스에 무엇인지 결정하는 것은 귀하에게 달려 있습니다. 이를 사용하여 실제 승자가 있는지 또는 더 중요한 영역에서 손실을 위해 한 결과의 상승도를 단순히 거래하고 있는지 확인하십시오.

영감이 필요하면 Ben Labay의 실험 및 테스트에서 일반적인 가드레일 메트릭 목록을 확인하십시오.

그런 다음 그에 따라 변경합니다.

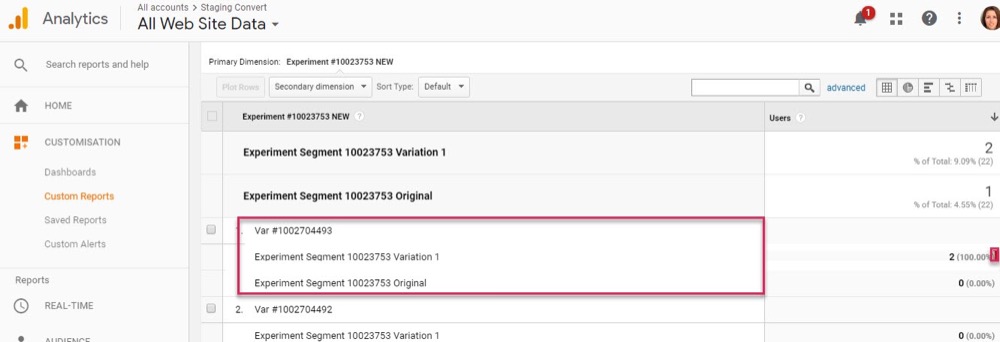

귀하의 분석 및 고급 세그먼트로 변환 경험 앱이 설정되어 있는 한, 빠르게 둘러보면 이 정보를 찾을 수 있을 것입니다. 테스트 도구의 승자를 선택하지 않도록 각 변형이 Northstar 메트릭과 '가드레일'에 미치는 영향을 확인하십시오.

이제 핵심 메트릭을 다루었으므로 결과를 좀 더 자세히 살펴보겠습니다.

3단계: 더 깊이 들어가 결과를 세분화

테스트에 관해서는 평균이 거짓말이라는 것을 기억하십시오 .

평균 결과는 여러 데이터 요소의 조합을 기반으로 하는 광범위한 정보만 제공할 수 있습니다. 그 결과가 발생한 이유를 이해하고 항상 보이는 것이 아니기 때문에 더 자세히 살펴보는 것은 사용자의 몫입니다.

매크로 결과가 마이크로 테스트 변경의 영향을 받는 것을 이미 보았지만 분석 세그먼트는 더 깊은 통찰력을 제공할 수 있습니다.

예시

더 많은 리드에 대한 테스트를 실행 중이라고 가정해 보겠습니다. 언뜻보기에 컨트롤과 변형은 방문자의 구독자 전환율이 같습니다.

그러나 자세히 살펴보면 데스크톱에서 새 변형이 컨트롤의 전환율의 거의 두 배이지만 모바일에서는 0이므로 페이지의 평균이 컨트롤과 동일하게 보입니다.

분명히 뭔가 잘못되었지만 왜 이런 일이 발생합니까?

새로운 변형이 모바일에서 올바르게 로드되지 않거나 양식이 특정 장치에서 작동하지 않아 실제로 구독하려는 모바일 사용자가 없을 수 있습니다. 그리고 이 문제를 수정하면 '동일한 결과' 변형이 실제로 컨트롤을 훨씬 능가할 수 있습니다.

결과 뒤에 숨겨진 더 많은 정보를 얻기 위해 노력할 때만 이러한 것들을 찾을 수 있습니다.

각 테스트를 통해 통찰력에 대한 실험을 하게 되며, 이는 더 스마트한 세분화를 알려주고, 이는 새로운 통찰력으로 이어지며, 결국 더 의미 있는 전략으로 이어질 것 입니다.

샤넬 멀린스, Shopify

세분화는 오류를 찾는 것뿐만 아니라 다른 사용자 통찰력을 찾는 것입니다.

페이지와 컨트롤이 모두 정상적으로 작동하고 있을 수 있지만 자세히 살펴보면 특정 트래픽 채널이 이 새로운 테스트에서 다른 채널보다 훨씬 더 높은 전환율을 보이고 있다는 것을 알 수 있습니까?

종종 일부 세그먼트는 실적이 저조하고 다른 세그먼트는 실적이 초과됩니다. 그러면 새로운 개인화 캠페인이나 유료 또는 유기적 트래픽 전략을 알릴 수 있습니다.

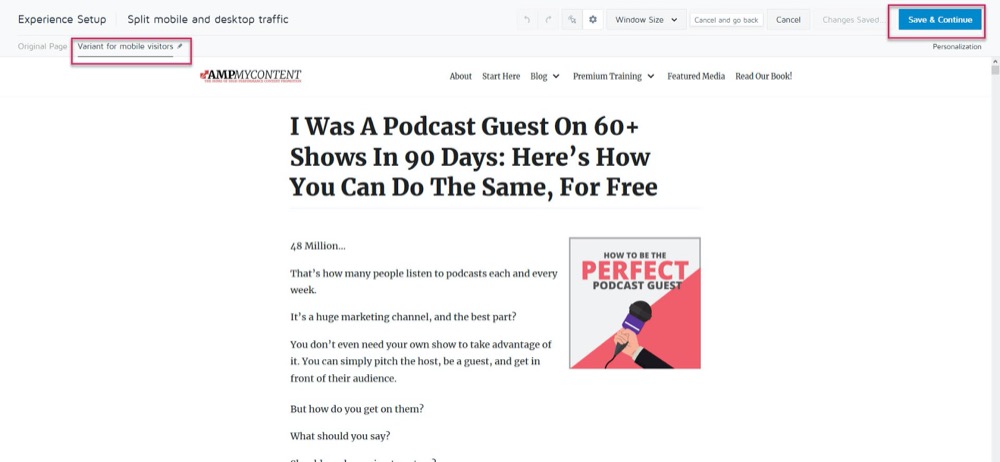

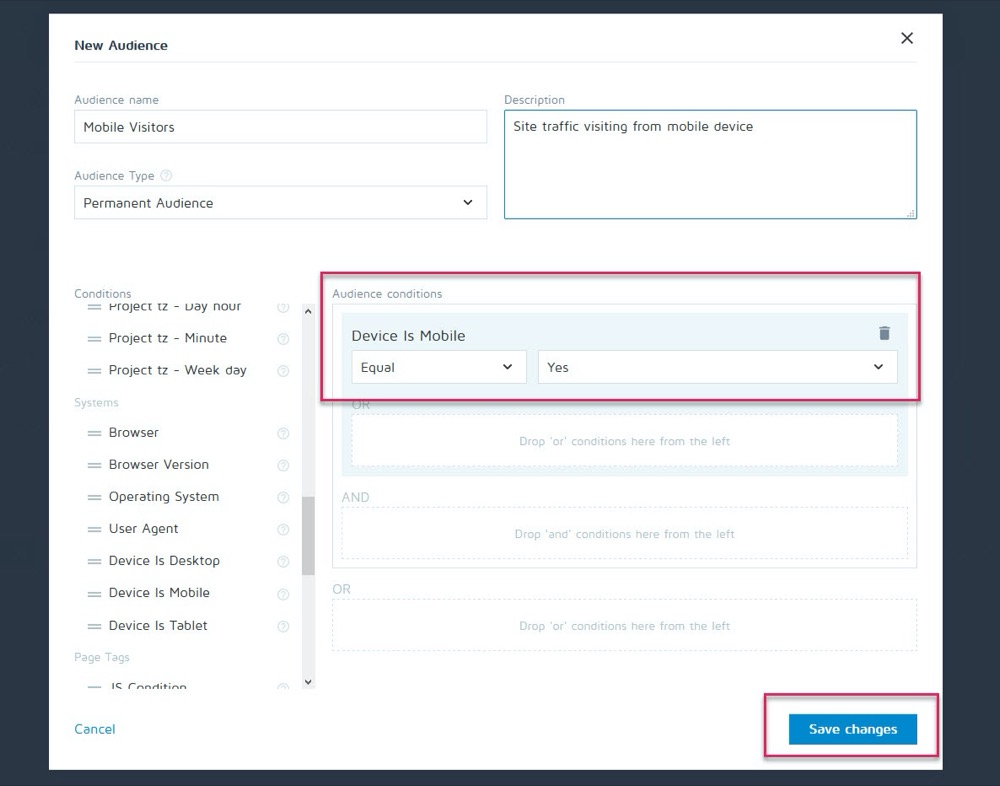

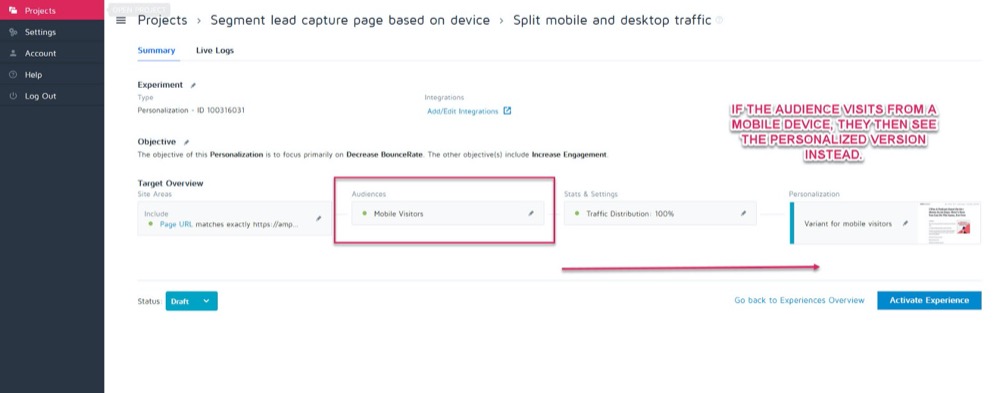

아마도 컨트롤은 데스크톱에서 가장 잘 전환되지만 새로운 변형은 모바일에서 더 높게 전환됩니다. 예를 들어 시청자가 사이트를 보는 방식에 따라 표시할 버전을 선택하려는 경우를 가정해 보겠습니다.

Convert의 개인화 기능을 사용하면 모바일에서 우승한 변형을 해당 청중만을 위한 개인화로 설정할 수 있습니다.

그런 다음 방문자가 모든 모바일 장치에서 올 때 새 버전을 표시할 수 있습니다.

그러나 데스크탑에서 마주치면 데스크탑 버전이 대신 표시됩니다.

사용할 수 있는 다양한 개인화 방법이 있지만 캠페인에서 통찰력을 얻은 후에만 사용할 수 있습니다.

세그먼트 분석의 핵심은 항상 결과를 살펴보고 왜 문제가 발생했는지 알아보는 것입니다.

보다:

- 신규 시청자 vs 재방문 시청자 . 하나의 변형이 사람들을 더 자주 다시 데려오나요? 하나가 더 많은 콜드/신규 청중을 전환하고 있습니까?

- 트래픽 소스. 한 채널이 다른 채널보다 실적이 더 좋습니까? 여기에 더 집중할 수 있습니까?

- 페이지 조회수. 특히 테스트 페이지가 판매 페이지로 트래픽을 유도하려는 경우. 한 버전에 대한 클릭이 부족하면 깨진 버튼이나 CTA 문제가 있음을 의미할 수 있습니다.

- 이탈률. 이는 끊어진 링크/느린 로드/나쁜 UX 경험을 나타내거나 잘못된 대상을 대상으로 할 수도 있습니다.

- 운영 체제,

- 모바일 대 데스크탑.

- 사용된 기기입니다.

약간의 면책 조항:

이와 같이 분할할 때 각 채널의 정확한 반영을 얻으려면 많은 데이터가 필요합니다. 경험상 일반적으로 실행하는 것보다 약 10배 많은 전환수(또는 변형 페이지당 전환수가 아닌 채널당 300회 전환)로 테스트하는 것이 좋습니다.

"이런 테스트를 실행하기에 충분한 트래픽을 얻을 수 있는 방법은 없습니다" 라고 생각할 수 있습니다. 아니면 그렇게 하는 데 몇 달이 걸릴 수도 있습니다.

그런 경우에도 세그먼트 분석을 그냥 건너뛰지 마십시오.

왜요?

데이터 기반 결론을 도출하기 위해 각 세그먼트에서 전환이 충분하지 않을 수 있지만 클릭이 없는 페이지 조회 또는 즉각적인 이탈률과 같은 문제가 나타나기 시작하면 몇 가지 분명한 통찰력을 제공할 수 있습니다 .

이 모든 것은 테스트가 실패했음을 나타내고 놓칠 수 있는 승자를 찾는 데 도움이 될 수 있습니다. 계속 진행하여 주요 하락 및 문제를 찾으십시오. 모든 것이 각 플랫폼과 장치에서 작동했습니까?

이상적으로는 테스트 전에 모두 확인했지만 테스트 중간에 문제가 발생할 수 있으므로 다시 확인하십시오.

개인적으로 WordPress가 캠페인 중간에 자동으로 업데이트되도록 한 다음 테스트 도중 리드 캡처 양식이 갑자기 작동을 멈췄습니다. 항상 확인하고 결과의 정확성을 망치는 것을 발견하면 테스트를 중지하고 문제를 수정한 다음 다시 실행하십시오.

모든 것이 제대로 작동했다면?

사람들이 왜 당신의 행동을 취하지 않았는지 살펴보고 알아봅시다...

4단계: 추가 통찰력을 위해 사용자 행동 확인

이상적으로는 테스트 도구 위에 정성적 추적 기능이 있어야 합니다.

왜요?

이는 종종 정기적인 테스트로 놓칠 수 있는 변형에 대한 통찰력을 제공할 수 있기 때문입니다.

기억하다:

Convert와 같은 정량적 테스트 도구 는 무슨 일이 일어났는지 알려줍니다. 얼마나 많은 사람들이 클릭했는지 또는 클릭하지 않았는지 사이의 원시 숫자 데이터를 제공하고 각 A/B 테스트를 설정하는 데 도움을 줄 수 있습니다.

그러나 정성적 도구 를 추가하면 행동이 발생한 이유를 이해하는 데 도움이 됩니다. 이를 통해 사용자가 무엇을 하고 있었는지 볼 수 있고 그들의 행동에 대해 더 많은 통찰력을 얻을 수 있습니다.

(테스트는 일반적으로 잘못된 실행이나 청중의 이해로 인해 실패하며 문제를 해결할 수 있는 문제를 확인해야만 테스트에 실패합니다.)

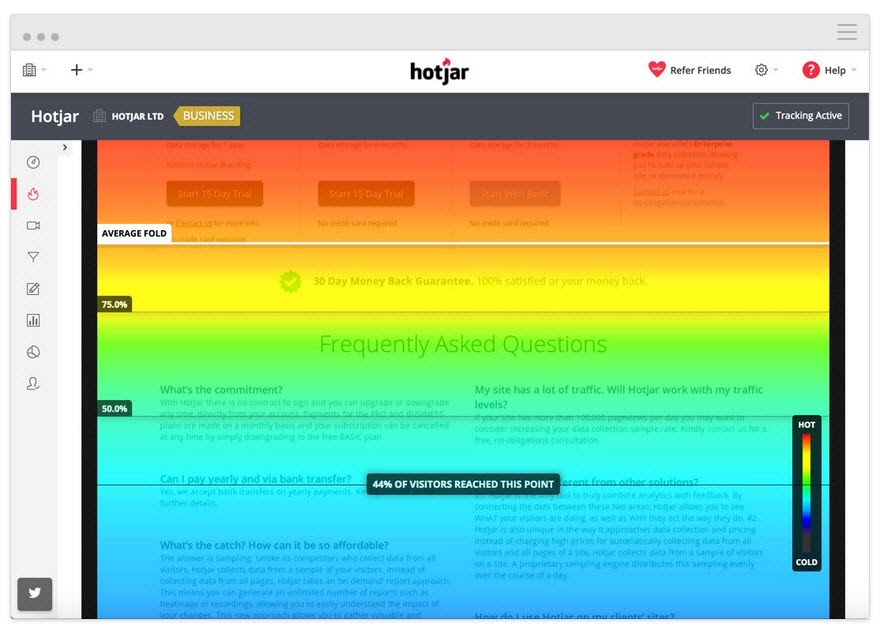

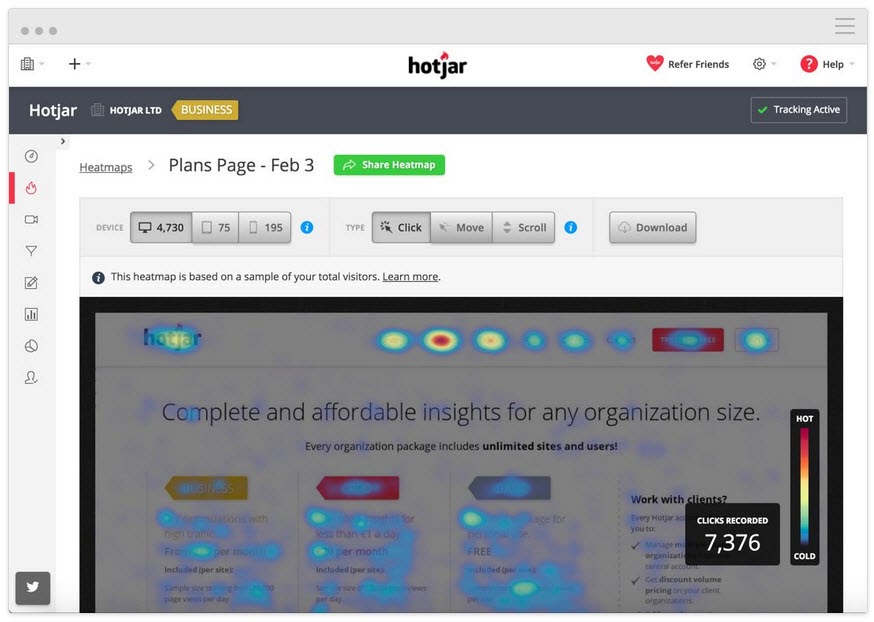

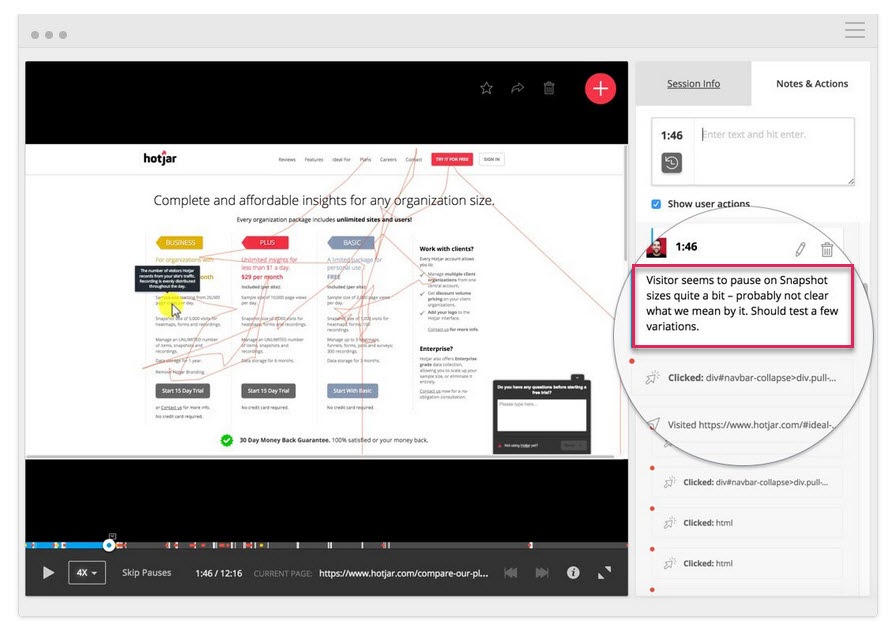

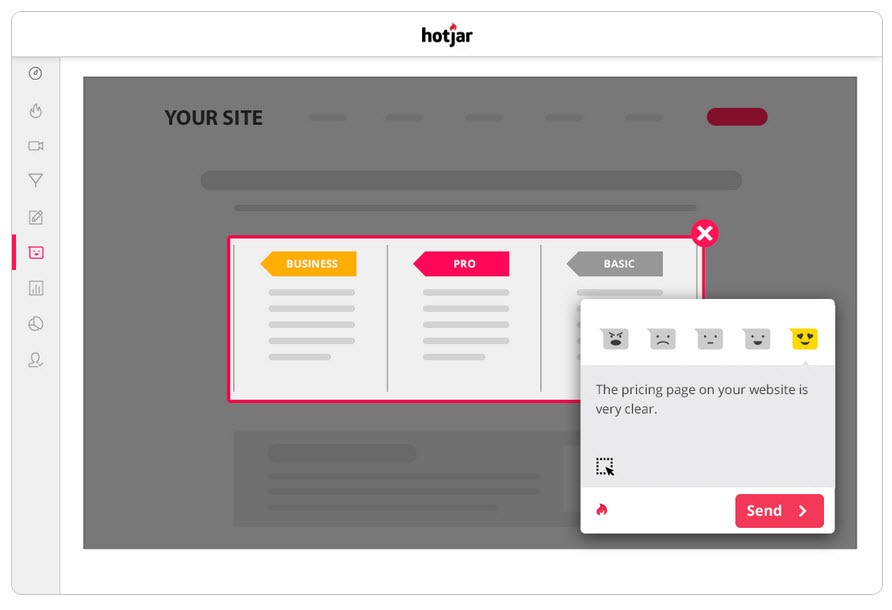

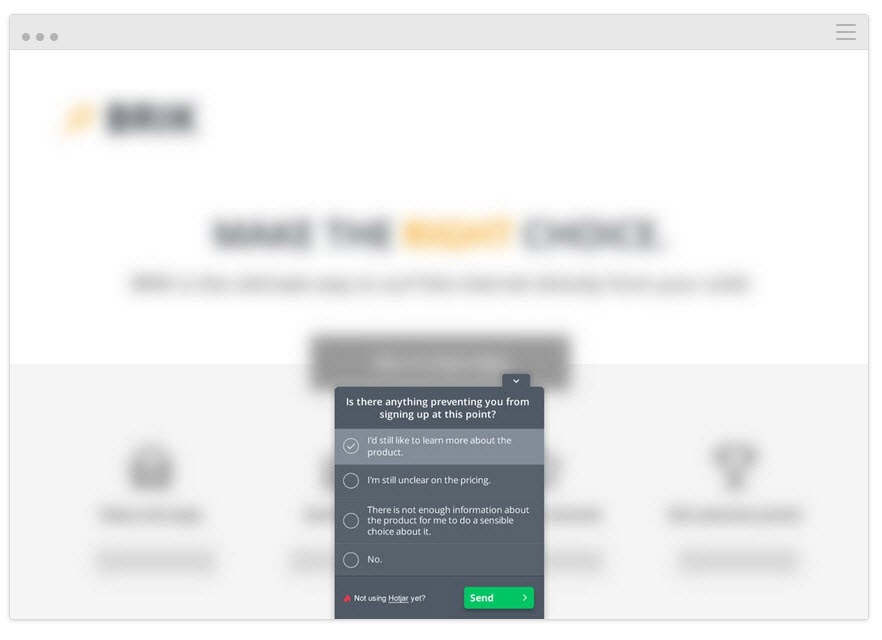

Hotjar와 같은 도구를 사용하여 여러 정성적 테스트를 실행할 수 있으며 내장된 통합을 통해 데이터를 변환 대시보드로 바로 가져올 수도 있습니다.

더 깊은 통찰력을 얻으려면 Hotjar – 변환 통합을 설정하고 아래 전술을 시도하십시오.

사용자가 얼마나 멀리 읽었는지 추적

페이지에 히트맵 도구를 추가하여 잠재고객이 CTA에 도달하는지 확인하세요. 그렇지 않은 경우 테스트를 다시 실행하고 CTA를 페이지 위쪽으로 이동할 수 있습니다.

사용자가 클릭하지만 해서는 안 되는 클릭 추적

전략적 CTA를 클릭합니까, 아니면 링크로 생각되는 임의의 텍스트입니까?

클릭하지 않지만 클릭해야 하는 항목을 보려면 화면 녹화를 시청하세요.

CTA 버튼을 볼 수 있을 만큼 충분히 스크롤했는데도 클릭하지 않습니까? 클릭하지만 열리지 않습니까? 그들은 그것을 보지만 클릭해야 할 버튼이라는 것을 깨닫지 못합니까?

이 모든 것을 볼 수 있으며 이러한 항목이 나오면 메모를 추가할 수도 있습니다.

도움이 될 수 있는 것은 히트 매핑 및 클릭 추적 도구만이 아닙니다.

청중을 대상으로 설문조사 실행

설문조사는 청중이 행동을 취한 원인(또는 중지)에 대한 피드백을 얻을 뿐만 아니라 이를 설명하는 데 사용하는 언어를 제공하는 데 도움이 됩니다.

카피 라이팅에서 우리는 이것을 '거울 언어'라고 부르며 사용자와 연결하는 데 매우 효과적입니다. 그들의 문제를 인식할 뿐만 아니라 그들이 사용하는 동일한 단어로 설명하므로 다른 누구보다 더 잘 이해하는 것처럼 느껴집니다.

A/B 테스트 도구와 함께 설문조사를 사용하는 두 가지 좋은 방법은 다음과 같습니다.

- 종료 의도 투표 . 새 버전을 사용하지 않는 사람들을 식별하여 무엇이 중단되었는지 알 수 있습니다.

오늘 옵트인/구매하지 않은 이유가 있습니까?

- 구매/전환 후 설문조사. 변종을 선택하는 사람들을 찾아 문제가 되는 부분과 동기를 부여하는 요소가 있는지 확인하십시오.

오늘 조치를 취하기로 결정한 이유는 무엇입니까?” 거의 결정하지 못하게 막았던 것이 있습니까?

더 많은 정보가 필요한 경우 컨트롤에 대해 유사한 설문 조사를 실행할 수도 있습니다. 이 모든 것이 테스트가 어떻게 수행되었는지 이해하는 데 도움이 되어 반복하고 개선할 수 있습니다.

말하자면…

5단계: 시험에서 지는 것에서 배우기

시험에서 질 때 가장 중요한 것은 결과에서 무언가를 배우는 것입니다. 청중을 개선하거나 더 잘 이해하기 위해 통찰력을 얻을 수 있는 한 나쁜 테스트와 같은 것은 없습니다.

A/B 테스트는 대화형 프로세스입니다. 우리는 이해를 얻으면서 앞으로 실패합니다. 단순히 승자를 얻는 것보다 승자에게 지는 테스트를 통해 훨씬 더 많은 것을 배울 수 있습니다.

지금까지 3가지 작업을 수행했습니다.

- 테스트 데이터가 정확한지 확인하고,

- 모든 문제에 대한 원시 결과를 살펴보고

- 사용자와 그들의 행동을 이해하려고 노력합니다.

이 단계는 실패를 유발할 수 있는 일반적인 문제(테스트 데이터가 정확하고 CTA 버튼이 모두 작동한다고 가정)를 이해하고 접근 방식과 가설을 분석하는 데 도움이 되는 경험적 접근 방식에 가깝습니다.

가설이 틀렸거나 테스트가 잘못 정렬되었습니까?

이것은 특히 새로운 테스터 사이에서 일반적인 문제입니다.

실제 KPI와 일치하지 않는 몇 가지 '우우우우우웅' 지표나 아이디어를 테스트해 보셨습니까?

예시

페이지에서 더 많은 판매를 원하지만 어떤 이유로 소셜 공유 버튼에 대한 조정을 대신 테스트하기로 결정했다고 가정해 보겠습니다. (더 많은 소셜 공유가 판매에 영향을 미친다는 것을 보여주는 데이터가 0이더라도).

미친 소리 같지만 이런 일이 얼마나 자주 발생하는지 놀라게 될 것입니다.

자신에게 물어:

내 테스트 목표가 핵심 KPI와 이에 영향을 미칠 수 있는 방식으로 일치했습니까?

그렇지 않은 경우 괜찮지만 다음 테스트가 더 잘 정렬되는지 확인하십시오.

우리는 실패하고, 배우고, 다시 시도합니다.

다음 테스트에서는 핵심 KPI 측정항목과 이에 영향을 줄 수 있는 방법에 집중하고 테스트에 명확한 승/실패 시나리오를 제공해야 합니다.

우리는 이 페이지에서 더 많은 리드를 얻기를 원하기 때문에 더 나은 CTA를 만들고 싶다는 뜻입니다.

또는

우리는 이 페이지가 더 많은 리드를 얻기를 원하며 사용자가 우리의 CTA까지 스크롤하지 않는다는 것을 발견하여 페이지 위로 올리는 것을 테스트하고 있습니다.

테스트를 목표에 맞추면 올바른 경로로 이동할 수 있지만 그렇게 해도 더 많은 전환이 표시되지 않을 수 있습니다.

가설이 맞고 검정이 정렬되었지만 결과에는 여전히 변화가 없었습니다.

이것은 90%의 시간 동안 발생할 수 있으며 이것이 대부분의 테스트가 실패하는 이유입니다.

예 #1

사용자 데이터는 사용자가 귀하의 사이트를 충분히 신뢰하지 않는다는 것을 보여줍니다. 사회적 증거, 사용자 평가, SSL 인증서와 같은 신뢰 요소를 추가했지만 전환율은 여전히 증가하지 않았습니다.

그것은 당신이 멈추고 새로운 테스트나 각도를 시도해야 한다는 것을 의미합니까?

전혀…

초기 가설이 옳았을 수 있지만 효과를 보기 전에 테스트를 개선하거나 더 잘 실행해야 합니다.

더 많은 신뢰 요소를 추가하거나 더 눈에 띄도록 기존 요소를 이동할 수도 있습니다. 아마도 청중과 더 잘 연결되도록 돕기 위해 사용된 언어를 다시 말하십시오.

이 모든 것은 여전히 초기 가설과 일치하므로 더 많은 버전을 테스트하여 승자를 찾으면 됩니다.

예 #2

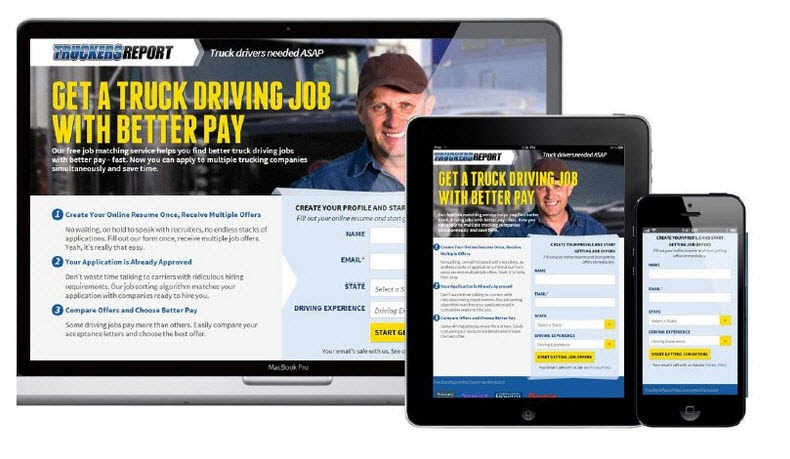

CXL은 이 랜딩 페이지에서 6개의 다른 테스트 캠페인을 실행하여 트럭 운전사 인증에 대한 더 많은 리드를 얻었습니다.

그들은 페이지를 계속 개선하기 위해 옵트인 비율을 12.1%에서 79.3%로 높였습니다.

(거의 모든 테스트 캠페인은 상승도를 보기 전에 동일한 가설을 사용하여 여러 번 시도했습니다. 그런 다음 페이지의 다른 요소를 개선하기 위해 계속 진행하고 테스트했습니다.)

A/B 테스트는 반복적인 프로세스입니다. 개선 사항을 찾기 위해 계속 테스트하고 조정해야 하며, 업계 최고라도 승자를 찾을 확률은 10%에 불과합니다.

가상으로 당신이 조직이고 당신이 실행한 모든 테스트가 성공했다면, 제 생각에는 실제로 적신호일 것입니다.

반직관적으로 들리지만 분명한 것만 테스트하고 있으며 실제로 바늘을 움직이기에 충분한 위험을 감수하고 있지 않다는 것을 알 수 있습니다 .

데보라 오말리, 테스트를 맞춰봐

최고로부터 배우는 것은 항상 좋은 일이며 Deborah와 했던 인터뷰를 공유하게 되어 기쁩니다. 우리는 테스트가 결코 실패하지 않는 이유와 테스트에서 올바른 사고방식을 갖는 것의 중요성에 대해 이야기했습니다. 시작하는 데 도움이 되도록 여기에서 인터뷰를 들어보십시오.

즉, 긍정적인 상승을 보기 전에 9번의 테스트가 필요할 수 있으므로 계속 진행해야 합니다.

테스트는 가장 영향력이 큰 우선 순위 시스템을 따라야 합니다. 현재 캠페인을 개선하기 위해 더 많은 테스트와 변경을 실행하면 현재 캠페인에서 즉각적인 결과를 볼 수 없기 때문에 중요도가 낮은 테스트로 점프하는 것보다 훨씬 더 많은 영향을 볼 수 있습니다.

그리고 여전히 작은 변화로 상승이 나타나지 않으면 다른 디자인을 실행하는 혁신적인 테스트를 실행하는 것이 좋습니다.

그것은 울타리를 위한 그네일 수 있지만 때로는 당신이 해야 할 변화가 될 수 있습니다.

이 모든 테스트와 조정 후에도 변형이 여전히 패자라면?

따라서 데이터가 정확하고 모든 조정을 시도하고 전체 페이지에 대규모 혁신적 변경을 수행했지만 여전히 컨트롤보다 성능이 좋지 않습니다.

별 것 아닌 것 같지만 사실 이것은 좋은 것입니다.

왜요?

당신은 청중과 함께 작동하지 않는 것을 발견했기 때문에!

많은 웹사이트가 아무 것도 테스트하지 않고 대대적인 변경을 수행하고 상관없이 롤아웃합니다.

스스로에게 다음과 같이 물어보십시오.

해당 페이지 변형이 현재 컨트롤보다 1%만 더 나쁘게 전환된다면 먼저 테스트하고 배포하지 않음으로써 얼마나 많은 돈을 절약할 수 있었습니까?

2014년에 Marks and Spencer는 샘플 청중을 대상으로 먼저 테스트하지 않고 전체 웹사이트를 업데이트하기로 결정했습니다.

결과?

Their online sales dropped by 8.1% in 3 months, causing a loss of $55 million.

This is why testing and finding losers is a really good thing because even losing tests can save you money.

What if the Test and the Variant Have Identical Results?

You checked everything, it all works, you've segmented down and gone into the nitty-gritty, but there's just no discernible difference between your current page and your new variant.

You've even tried complete page overhauls but through some fluke of math, your new page still converts at the same rate as the old one.

In this case, it's simply the dealer's choice.

Does the new variation more actively represent your brand and style?

If so, choose whichever you wish to use. The results are still the same but you are happier with the design.

Note: This should be the only time that you do this. Branding should not sacrifice results; it should aid them, as seen in the previous example.

Step #6: Double Down on Winners and Continue to Improve Them

So far we've been covering losing campaigns, but what if you got a winner right out of the gate?

First off, congratulations!

Second, let's make sure you actually have a winner. Oftentimes, things can happen to affect your results and give you a false positive (ie we think it's a winner but we implement it and nothing happens.)

Go ahead and run the test again with just your control and the winning variant and prove the lift in results first before you make any changes to your site.

Then if it really is a winner? Don't stop there, continue to improve it!

Iterative improvements of a new winning campaign are the easiest new test to run. With each new improvement, you'll see more ongoing ROI. You can even take what you learned with your winning test and then roll it out across similar pages on your site for further tests and see if it also adds lift there too.

Step #7: Create a Learning Repository for Future Tests

This step is relevant to both winning and losing tests.

Not only will it help you with future tests, but it will also help your QA team diagnose any broken campaigns faster, as they can see where issues have appeared in the past.

그래도 낫다?

It will help you document your results for clients or your boss, while also standardizing your reporting processes and ramping up your test velocity.

작동 방식은 다음과 같습니다.

You're going to create a master archive or learning repository of all past tests. A place to document your previous wins and losses that you can use to both reference for new campaigns and share with stakeholders or customers.

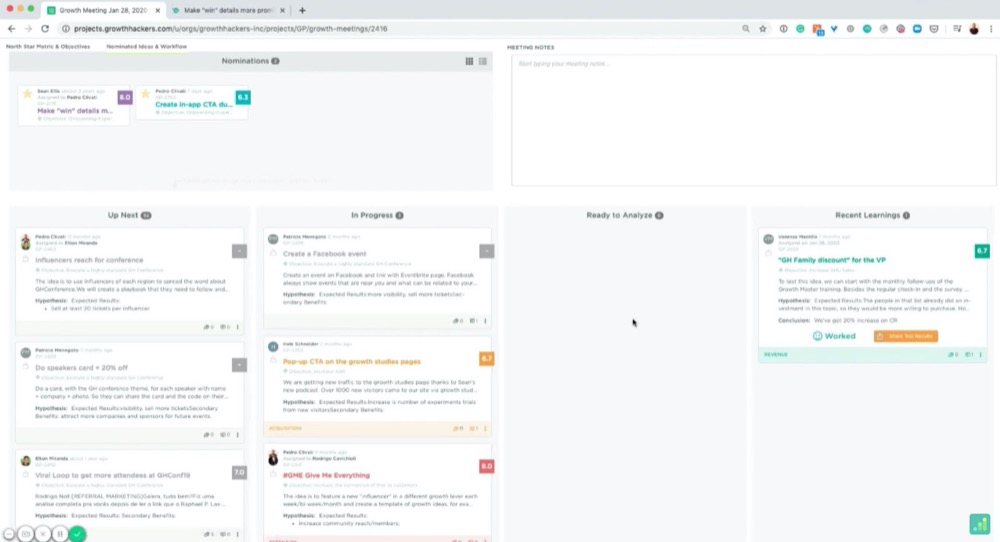

You can use a folder on your computer for this, but, if you really want to get organized, there's a great tool called GrowthHackers experiments.

Its main goal is to help marketing growth teams communicate and organize campaigns, but you can easily use it to manage your CRO testing and learnings. It will even pull in results from your test tool and allows you to archive each test. (You can simply tag and then add them to the repository.)

Whatever you decide to use, here are some best practices:

Organizing Your Tests

You probably have your own naming conventions but if you're just starting, I recommend naming each test like so:

“Goal – Campaign – Test Date”

예를 들어:

“CTR lift test – XYZ client – March 1st-14th 2021”

This way, you can organize tests by goals to get inspiration for future tests, search through and find them for client campaigns, or look back on your experiments month by month.

Then, if you wanted to run a CTR test later on, you can swipe through them and see what ideas worked or failed in the past.

How Do We Create Documents for the Learning Repository?

Feel free to add screenshots of your testing tools graphs, confidence, and power level or any data that you think is relevant.

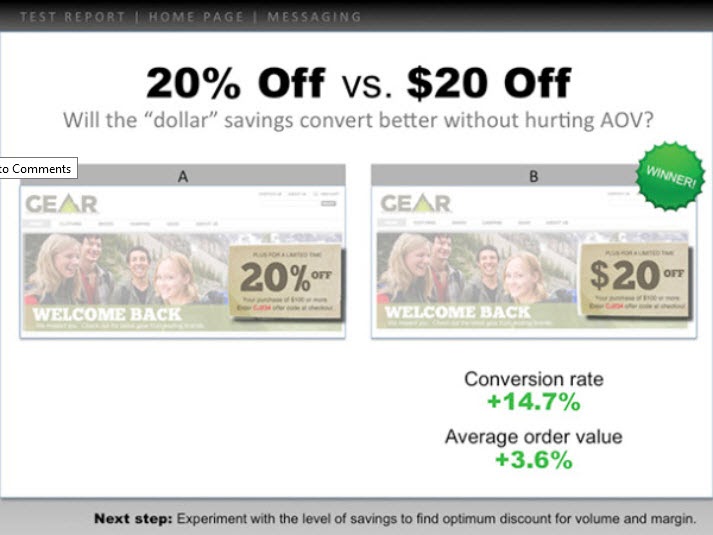

However, I highly recommend creating a slide with the following information:

- The hypothesis and how you came up with the idea (any survey data or information).

- A headline with the test goal.

- A screenshot of the control, the winning variant, and any other failed versions/tests that got some lift but not as much. (Highlight the key elements so you can spot what changed without having to look too hard.)

- Add the micro goal and its percentage lift. (Perhaps 3.2% CTR)

- Then add the macro goal and its percentage lift. (AVG order value up 2.2%, etc.)

다음은 예입니다.

You can use these slides to present the test information to anyone else who needs them, while also having a simple file to understand the test at a moment's notice.

Pretty handy, right?

Now that you've analyzed your test and recorded the results, let's walk you through how to present this to your boss in a way that even if the test failed, they're still happy to see your findings…

How To Present This Information To Your Boss (Even When Your Campaigns Failed)

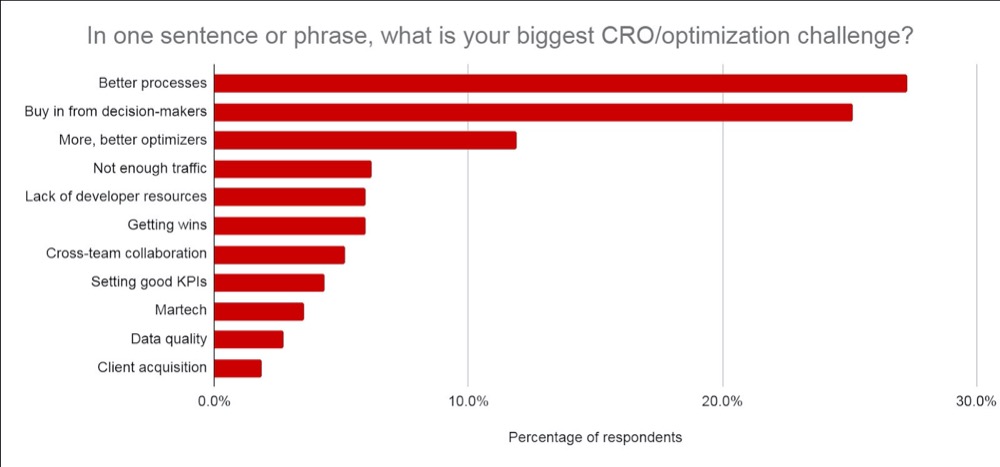

Don't worry if you feel anxious about this, you're not alone. In fact, according to CXL's state of the industry report, presenting test information or getting buy-in from your stakeholders is consistently one of the biggest struggles CROs face.

We've covered the best ways to communicate this information before, but I want to give you a few extra tips on how to get your test results across (even if your test failed).

Tip #1: Get Everyone On Board With CRO and Its Realities as Soon as Possible

Ideally, you covered this when you first broached the topic of running A/B tests but it never hurts to recap.

Make sure they understand that A/B testing is a continual learning process that's more about understanding your audience and improving their experience. The lift in ROI is simply a byproduct of taking action on each test and implementing what you learn, regardless of if it wins or fails.

Winners give lift and losers give insight into where to improve.

No test is ever wasted but the majority of them do fail. You're looking at roughly 1/10 winners for most people's tests and agencies are around 1/4.

Be clear on how many tests fail and the need to run more tests to find winners.

Tip #2: Present the Information as Simply as You Can

Not everyone can read graphs easily. Even if they can, it still means that it takes effort to understand the context of what they are seeing.

The more effort it takes to understand something, the more frustrating it can be and can cause you to lose the other person's attention.

(Top tip for landing pages btw ^^)

Break it down nice and simple by using the slides from your learning repository.

It should already include:

- 사전에 배운 내용과 테스트 아이디어에 도달한 방법.

- 당신이 테스트 한 것. 컨트롤, 변형 및 승자를 표시합니다.

- 미시적 및 거시적 수준에서 어떻게 작동했는지. 결과를 포함합니다.

Finally, add any insights you drew from tests to decide on your next important action to take. (Improve execution, test new variations, new hypothesis, etc.)

Providing insight into what happened is HUGE.

당신의 상사는 행동할 수 있는 결과보다 당신이 배운 것에 더 관심이 있습니다. 그것을 공유하고 다음에 할 일에 대한 아이디어를 제공하면 그들이 상황을 통제하고 있음을 확인하고 추가 테스트에 대해 자신감을 느끼는 데 도움이 될 것입니다.

팁 #3: 보기 좋게 만들기

한 단계 더 나아가 관심 있는 데이터를 추가하세요.

- 테스트가 실패했다면 실패했다고 생각하는 이유에 대한 통찰력을 제공하십시오 . 실패한 테스트를 롤아웃하지 않음으로써 절약한 ROI와 이것이 MRR 및 ARR에 미치는 영향을 추가합니다.

- 이겼으면 ROI에 대한 통찰력과 이것이 연간 수익/MRR 및 ARR에 미치는 영향 과 함께 더 확장하고 ROI를 더 높일 수 있는 기회를 제공하십시오. (즉, 리드 캡처 페이지를 테스트하고 레이아웃을 조정할 때 상승을 보았을 수 있습니다. 잠재적 상승을 볼 수 있는 이 테스트를 적용할 수 있는 30개의 다른 유사한 페이지가 있을 수 있습니다.)

- 테스트가 단순했다면 발생한 일과 다음에 해야 할 일에 대한 통찰력을 공유하십시오. (더 나은 실행, 새로운 변형, 전체 변경 또는 더 잘 정렬된 테스트 등)

물론 ARR + MRR 또는 YOY 영향은 대략적인 추정치이지만 테스트의 잠재적 영향과 가치를 보여줍니다. 그것이 당신의 상사가 관심을 갖는 것이고 그들이 당신의 결과를 볼 때 생각할 가능성이 있는 것입니다.

저를 믿으십시오. 이와 같은 정보를 제공하면 훨씬 더 쉽게 전달된다는 것을 알게 될 것입니다. 당신은 테스트를 '돈 손실'이나 시간 낭비로 틀을 잡는 것에서 대신 잠재적인 저축, 실제 수입 및 잠재적인 추가 성장에 초점을 맞추게 됩니다.

뿐만 아니라 더 많은 테스트를 실행하고, CRO 노력을 성숙시키고, 테스트 속도를 높이는 것의 가치를 증명할 수 있습니다.

결론

당신은 그것을 가지고 있습니다.

지금쯤이면 A/B 테스트 결과를 분석하고 학습하는 방법에 대해 훨씬 더 확신을 갖게 되며 테스트 수행 방식에 관계없이 이 정보를 상사나 다른 사람에게 제공할 수 있습니다.

이 가이드를 따라 실행하는 각각의 새로운 A/B 테스트에 대한 사후 테스트 분석을 간소화하십시오!