웹사이트에서 효율적인 데이터 추출을 위한 25가지 최고의 웹 크롤링 도구

게시 됨: 2023-06-15웹 크롤링 도구 소개

스파이더 또는 웹 스크레이퍼라고도 하는 웹 크롤링 도구는 분석 및 데이터 마이닝 목적으로 웹 사이트에서 중요한 데이터를 추출하려는 기업에 필수적입니다. 이러한 도구에는 시장 조사에서 검색 엔진 최적화(SEO)에 이르기까지 광범위한 응용 프로그램이 있습니다. 다양한 공개 소스에서 데이터를 수집하여 구조화되고 사용 가능한 형식으로 제공합니다. 웹 크롤링 도구를 사용하여 회사는 뉴스, 소셜 미디어, 이미지, 기사, 경쟁사 등을 추적할 수 있습니다.

웹 사이트에서 빠르게 데이터를 추출하는 25가지 최고의 웹 크롤링 도구

스크래피

Scrapy는 개발자가 확장 가능한 웹 크롤러를 만들 수 있는 인기 있는 오픈 소스 Python 기반 웹 크롤링 프레임워크입니다. 웹 크롤러를 쉽게 구현하고 웹 사이트에서 데이터를 추출할 수 있는 포괄적인 기능 세트를 제공합니다. Scrapy는 비동기식입니다. 즉, 한 번에 하나씩 요청하지 않고 병렬로 요청하므로 효율적인 크롤링이 가능합니다. 잘 정립된 웹 크롤링 도구인 Scrapy는 대규모 웹 스크래핑 프로젝트에 적합합니다.

주요 특징들

- JSON, CSV 및 XML과 같은 형식으로 피드 내보내기를 생성합니다.

- XPath 또는 CSS 표현식을 통해 소스에서 데이터를 선택하고 추출하기 위한 지원 기능이 내장되어 있습니다.

- 스파이더를 사용하여 웹 페이지에서 자동으로 데이터를 추출 할 수 있습니다.

- 확장 가능하고 내결함성이 있는 아키텍처로 빠르고 강력 합니다.

- 플러그인 시스템과 풍부한 API로 쉽게 확장할 수 있습니다.

- Linux, Windows, Mac 및 BSD에서 실행되는 휴대용 입니다.

가격

- 무료 도구입니다.

ParseHub

ParseHub는 AJAX 기술, JavaScript, 쿠키 등을 사용하는 웹 사이트에서 데이터를 수집할 수 있는 웹 크롤러 도구입니다. 기계 학습 기술은 웹 문서를 읽고 분석한 다음 관련 데이터로 변환할 수 있습니다. ParseHub의 데스크톱 애플리케이션은 Windows, Mac OS X 및 Linux 운영 체제를 지원합니다. 사용자 친화적인 인터페이스를 제공함으로써 ParseHub는 웹사이트에서 데이터를 추출하려는 비프로그래머를 위해 설계되었습니다.

주요 특징들

- AJAX, JavaScript, 무한 스크롤, 페이지 매김, 드롭다운, 로그인 및 기타 요소를 사용하는 동적 웹 사이트를 스크랩할 수 있습니다.

- 사용하기 쉽고 코딩 기술이 필요하지 않습니다.

- 클라우드 기반 이며 서버에 데이터를 저장할 수 있습니다.

- IP 순환 , 예약된 수집 , 정규식 , API 및 웹후크를 지원합니다.

- JSON 및 Excel 형식으로 데이터를 내보낼 수 있습니다.

가격

- ParseHub에는 무료 및 유료 요금제가 있습니다. 유료 플랜의 가격은 월 $149부터 시작하며 업그레이드된 프로젝트 속도, 실행당 스크랩되는 페이지 수에 대한 더 높은 제한 및 더 많은 프로젝트를 생성할 수 있는 기능을 제공합니다.

옥토파스

Octoparse는 사용자가 코딩할 필요 없이 웹 데이터를 스프레드시트로 추출할 수 있는 클라이언트 기반 웹 크롤링 도구입니다. 포인트 앤 클릭 인터페이스를 갖춘 Octoparse는 비코더를 위해 특별히 제작되었습니다. 사용자는 자신의 웹 크롤러를 생성하여 모든 웹사이트에서 데이터를 수집할 수 있으며 Octoparse는 Amazon, eBay 및 Twitter와 같은 인기 웹사이트를 위해 사전 구축된 스크레이퍼를 제공합니다. 이 도구는 예약된 클라우드 추출, 데이터 정리, IP 프록시 서버를 통한 차단 우회와 같은 고급 기능도 제공합니다.

주요 특징들

- 포인트 앤 클릭 인터페이스 : 스크랩하려는 웹 요소를 클릭하여 쉽게 선택할 수 있으며, Octoparse는 자동으로 데이터 패턴을 식별하고 데이터를 추출합니다.

- 고급 모드 : 텍스트 입력, 버튼 클릭, 페이지 스크롤, 목록 반복 등과 같은 다양한 작업으로 스크래핑 작업을 사용자 지정할 수 있습니다. XPath 또는 RegEx를 사용하여 데이터를 정확하게 찾을 수도 있습니다.

- 클라우드 서비스 : Octoparse의 클라우드 서버에서 연중무휴 24시간 스크래핑 작업을 실행하고 데이터를 클라우드 플랫폼에 저장할 수 있습니다. 또한 작업을 예약하고 자동 IP 순환을 사용하여 웹사이트에 의해 차단되는 것을 방지할 수 있습니다.

- API : API를 통해 데이터에 액세스하고 다른 애플리케이션 또는 플랫폼과 통합할 수 있습니다. 또한 Octoparse를 사용하여 모든 데이터를 사용자 지정 API로 전환할 수 있습니다.

가격

- 무료 및 유료 플랜이 있습니다. 유료 요금제는 월 $89부터 시작합니다.

웹하비

WebHarvy는 프로그래머가 아닌 사용자를 위해 설계된 포인트 앤 클릭 웹 스크래핑 소프트웨어입니다. 웹 사이트에서 텍스트, 이미지, URL 및 이메일을 자동으로 스크랩하여 XML, CSV, JSON 또는 TSV와 같은 다양한 형식으로 저장할 수 있습니다. WebHarvy는 또한 대상 웹사이트에 액세스하기 위해 프록시 서버 또는 VPN 서비스를 활용하여 익명 크롤링 및 동적 웹사이트 처리를 지원합니다.

주요 특징들

- 코딩이나 스크립팅 없이 데이터를 선택하기 위한 포인트 앤 클릭 인터페이스

- 자동 크롤링 및 스크래핑을 통한 다중 페이지 마이닝

- 유사한 페이지 또는 목록에서 데이터를 스크랩하기 위한 카테고리 스크래핑

- 전자 상거래 웹사이트의 상품 상세 페이지에서 이미지 다운로드

- 추가 구성 없이 스크래핑 목록 또는 테이블에 대한 자동 패턴 감지

- 입력 키워드를 검색 양식에 제출하여 키워드 기반 추출

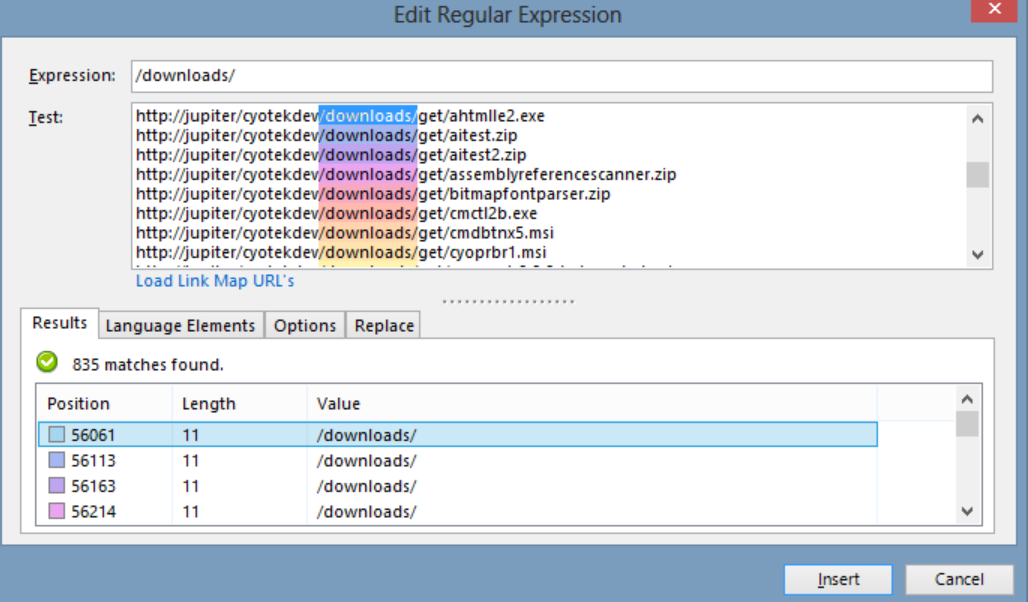

- 더 많은 유연성과 스크래핑 제어를 위한 정규 표현식

- 링크 클릭, 옵션 선택, 스크롤 등과 같은 작업을 수행하기 위한 자동화된 브라우저 상호 작용

가격

- WebHarvy는 일회성 라이센스 비용이 있는 웹 스크래핑 소프트웨어입니다.

- 라이센스 가격은 1년에 $139부터 시작합니다.

아름다운 수프

Beautiful Soup은 HTML 및 XML 문서를 구문 분석하는 데 사용되는 오픈 소스 Python 라이브러리입니다. 웹에서 데이터를 쉽게 추출할 수 있는 구문 분석 트리를 만듭니다. Scrapy만큼 빠르지는 않지만 Beautiful Soup은 주로 사용 편의성과 문제 발생 시 커뮤니티 지원으로 칭찬을 받고 있습니다.

주요 특징들

- 파싱 : 뷰티풀수프를 html.parser, lxml, html5lib 등과 같은 다양한 파서와 함께 사용하여 다양한 유형의 웹 문서를 파싱할 수 있습니다.

- 탐색 : find(), find_all(), select(), .children, .parent, .next_sibling 등과 같은 Pythonic 메서드 및 특성을 사용하여 구문 분석 트리를 탐색할 수 있습니다.

- 검색 : 원하는 요소를 찾기 위해 태그 이름, 속성, 텍스트, CSS 선택자, 정규 표현식 등의 필터를 사용하여 구문 분석 트리를 검색할 수 있습니다.

- 수정 : 요소 및 속성을 추가, 삭제, 교체 또는 편집하여 구문 분석 트리를 수정할 수 있습니다.

가격

Beautiful Soup은 pip를 사용하여 설치할 수 있는 무료 오픈 소스 라이브러리입니다.

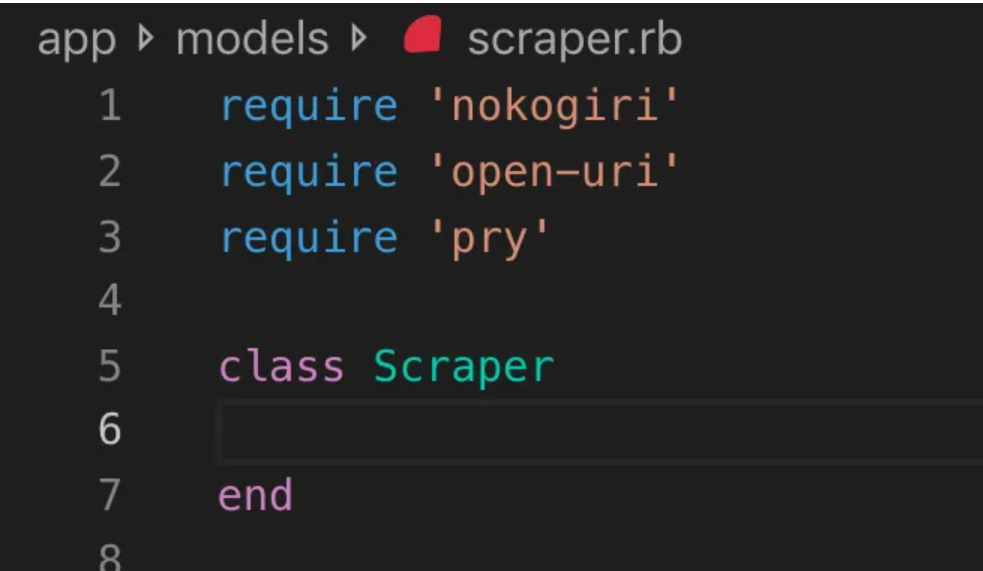

노코기리

Nokogiri는 웹 개발 초보자에게 친숙한 프로그래밍 언어인 Ruby를 사용하여 HTML 및 XML 문서를 쉽게 구문 분석할 수 있는 웹 크롤러 도구입니다. Nokogiri는 C의 libxml2 및 Java의 xerces와 같은 기본 파서에 의존하므로 웹 사이트에서 데이터를 추출하는 강력한 도구입니다. Ruby 기반 웹 크롤링 라이브러리로 작업하려는 웹 개발자에게 적합합니다.

주요 특징들

- XML, HTML4 및 HTML5용 DOM 파서

- XML 및 HTML4용 SAX 파서

- XML 및 HTML4용 푸시 파서

- XPath 1.0을 통한 문서 검색

- 일부 jquery와 유사한 확장자가 있는 CSS3 선택기를 통한 문서 검색

- XSD 스키마 검증

- XSLT 변환

- XML 및 HTML 문서용 "빌더" DSL

가격

- Nokogiri는 무료로 사용할 수 있는 오픈 소스 프로젝트입니다.

Zyte(구 스크래핑허브)

Zyte(이전의 Scrapinghub)는 수천 명의 개발자가 웹사이트에서 귀중한 데이터를 가져오는 데 도움이 되는 클라우드 기반 데이터 추출 도구입니다. 오픈 소스 시각적 스크래핑 도구를 사용하면 프로그래밍 지식 없이도 웹 사이트를 스크래핑할 수 있습니다. Zyte는 스마트 프록시 로테이터인 Crawlera를 사용하여 대규모 또는 봇 보호 사이트를 쉽게 크롤링하기 위해 봇 대책 우회를 지원하며 사용자가 간단한 HTTP API를 통해 프록시 관리의 어려움 없이 여러 IP 및 위치에서 크롤링할 수 있도록 합니다.

주요 특징들

- 주문형 데이터: Zyte에 웹 사이트 및 데이터 요구 사항을 제공하면 일정에 따라 요청된 데이터를 제공합니다.

- Zyte AP I: 가장 효율적인 프록시 및 추출 구성을 사용하여 웹사이트에서 HTML을 자동으로 가져오므로 기술적인 문제 없이 데이터에 집중할 수 있습니다.

- Scrapy Cloud : Scrapy 스파이더를 위한 확장 가능한 호스팅으로 크롤러를 관리, 모니터링 및 제어하기 위한 사용자 친화적인 웹 인터페이스를 제공하며 모니터링, 로깅 및 데이터 QA 도구를 갖추고 있습니다.

- 자동 데이터 추출 API : Zyte의 AI 기반 추출 API를 통해 웹 데이터에 즉시 액세스하여 고품질의 구조화된 데이터를 신속하게 제공합니다. 이 특허 기술을 사용하면 새로운 소스 온보딩이 더 간단해집니다.

가격

Zyte는 필요한 데이터의 복잡성과 볼륨에 따라 유연한 가격 책정 모델을 제공합니다. 세 가지 요금제 중에서 선택할 수 있습니다.

- 개발자: 250,000개의 요청에 대해 $49/월

- 비즈니스: 2백만 요청에 대해 $299/월

- 엔터프라이즈: 1천만 개 이상의 요청에 대한 사용자 지정 가격 책정

- 매월 10K 요청으로 Zyte를 무료로 사용해 볼 수도 있습니다.

HT트랙

HTTrack은 사용자가 오프라인 브라우징을 위해 전체 웹사이트 또는 특정 웹페이지를 로컬 장치에 다운로드할 수 있는 무료 오픈 소스 웹 크롤링 도구입니다. 명령줄 인터페이스를 제공하며 Windows, Linux 및 Unix 시스템에서 사용할 수 있습니다.

주요 특징들

- 원래 사이트의 상대 링크 구조를 유지합니다.

- 기존 미러 사이트를 업데이트하고 중단된 다운로드를 재개할 수 있습니다.

- 완전히 구성 가능하며 통합 도움말 시스템이 있습니다.

- Windows, Linux, OSX, Android 등 다양한 플랫폼을 지원합니다.

- 명령줄 버전과 그래픽 사용자 인터페이스 버전이 있습니다.

가격

- HTTrack은 GNU GPL에 따라 라이선스가 부여된 무료 소프트웨어입니다.

아파치 너치

Apache Nutch는 데이터 분석과 같은 분야에서 자주 사용되는 확장 가능한 오픈 소스 웹 크롤러입니다. HTTPS, HTTP 또는 FTP와 같은 프로토콜을 통해 콘텐츠를 가져오고 HTML, PDF, RSS 및 ATOM과 같은 문서 형식에서 텍스트 정보를 추출할 수 있습니다.

주요 특징들

- 대용량 데이터 볼륨을 일괄 처리하는 데 적합한 Apache Hadoop 데이터 구조를 기반으로 합니다.

- 고도로 모듈화된 아키텍처를 갖추고 있어 개발자가 미디어 유형 구문 분석, 데이터 검색, 쿼리 및 클러스터링을 위한 플러그인을 만들 수 있습니다.

- Windows, Linux, OSX, Android 등 다양한 플랫폼을 지원합니다.

- 명령줄 버전과 그래픽 사용자 인터페이스 버전이 있습니다.

- 구문 분석을 위해 Apache Tika, 인덱싱을 위해 Apache Solr 및 Elasticsearch, 스토리지를 위해 Apache HBase와 통합됩니다.

가격

- Apache Nutch는 Apache License 2.0에 따라 라이선스가 부여된 무료 소프트웨어입니다.

헬륨 스크레이퍼

Helium Scraper는 코딩할 필요 없이 사용자가 사용자 지정하고 제어할 수 있는 시각적 웹 데이터 크롤링 도구입니다. 프록시 회전, 빠른 추출, Excel, CSV, MS Access, MySQL, MSSQL, XML 또는 JSON과 같은 여러 데이터 형식 지원과 같은 고급 기능을 제공합니다.

주요 특징들

- 빠른 추출 : 추출 작업을 별도의 브라우저에 자동으로 위임

- 빅 데이터 : SQLite 데이터베이스는 최대 140테라바이트를 저장할 수 있습니다.

- Database Generation : 추출된 데이터를 기반으로 테이블 관계를 생성

- SQL 생성 : 내보내기 또는 입력 데이터를 위해 신속하게 테이블을 조인하고 필터링합니다.

- API 호출 : 웹 스크래핑과 API 호출을 하나의 프로젝트로 통합

- 텍스트 조작 : 추출된 텍스트를 일치, 분할 또는 교체하는 기능 생성

- JavaScript 지원: 모든 웹사이트에서 사용자 지정 JavaScript 코드 삽입 및 실행

- 프록시 회전 : 프록시 목록을 입력하고 지정된 간격으로 회전합니다.

- 유사 원소 검출 : 하나 또는 두 개의 샘플에서 유사 원소 검출

- 목록 감지 : 웹사이트에서 목록 및 테이블 행을 자동으로 감지합니다.

- 데이터 내보내기 : 데이터를 CSV, Excel, XML, JSON 또는 SQLite로 내보내기

- 예약 : 명령줄 또는 Windows 작업 스케줄러에서 실행 가능

가격

- 기본 라이선스는 사용자당 $99입니다.

콘텐츠 그래버(시퀀텀)

Content Grabber는 기업을 대상으로 하는 웹 크롤링 소프트웨어로, 사용자가 독립 실행형 웹 크롤링 에이전트를 만들 수 있도록 합니다. 타사 데이터 분석 또는 보고 응용 프로그램과의 통합, 강력한 스크립팅 편집 및 디버깅 인터페이스, Excel 보고서, XML, CSV 및 대부분의 데이터베이스로 데이터 내보내기 지원과 같은 고급 기능을 제공합니다.

주요 특징들

- 사용하기 쉬운 포인트 앤 클릭 인터페이스 : HTML 요소를 기반으로 동작을 자동으로 감지

- 강력한 API : 기존 데이터 파이프라인과 손쉬운 드래그 앤 드롭 통합 지원

- 사용자 정의 : Python, C#, JavaScript, 정규 표현식과 같은 일반적인 코딩 언어로 스크래핑 에이전트를 사용자 정의하십시오.

- 통합 : 데이터 보강을 위해 타사 AI, ML, NLP 라이브러리 또는 API 통합

- 안정성 및 확장성 : 엔드투엔드 작업을 실시간으로 모니터링하면서 인프라 비용을 낮추십시오.

- 법률 준수 : 책임을 줄이고 비용이 많이 드는 소송 및 규제 벌금과 관련된 위험을 완화합니다.

- 데이터 내보내기 : 데이터를 모든 형식으로 내보내고 모든 엔드포인트에 전달

- 예약 : 명령줄 또는 Windows 작업 스케줄러에서 스크래핑 에이전트 실행

가격

- 기본 라이선스는 연간 $27,500이며 한 대의 컴퓨터에서 소프트웨어를 사용할 수 있습니다.

사이오텍 웹카피

Cyotek WebCopy는 사용자가 오프라인 참조를 위해 일부 또는 전체 웹사이트를 하드 디스크에 로컬로 복사할 수 있는 무료 웹사이트 크롤러입니다. 웹 사이트 내의 링크를 감지하고 따라갈 수 있으며 로컬 경로와 일치하도록 링크를 자동으로 다시 매핑할 수 있습니다. 그러나 WebCopy는 가상 DOM이나 JavaScript 구문 분석의 어떤 형태도 포함하지 않으므로 JavaScript를 많이 사용하기 때문에 동적 웹 사이트 레이아웃을 올바르게 처리하지 못할 수 있습니다.

주요 특징들

- HTML 요소를 기반으로 하는 자동 동작 감지 기능이 있는 사용하기 쉬운 포인트 앤 클릭 인터페이스

- 간단한 끌어서 놓기 기능을 통해 기존 데이터 파이프라인과의 원활한 통합을 위한 강력한 API

- Python, C#, JavaScript 및 정규 표현식과 같은 널리 사용되는 코딩 언어를 사용하여 스크래핑 에이전트를 특정 요구 사항에 맞게 조정하는 사용자 지정 옵션

- 타사 AI, ML, NLP 라이브러리 또는 API와 통합 기능을 통해 스크랩한 데이터 보강

- 비용 효율적인 운영을 위한 실시간 모니터링 기능을 갖춘 안정적이고 확장 가능한 인프라

- 책임을 줄이고 소송 및 규제 벌금의 위험을 완화하는 법률 준수 기능

- 원하는 형식으로 데이터 내보내기 및 다양한 엔드포인트로 전달

- 예약 옵션을 사용하면 명령줄 또는 Windows 작업 스케줄러에서 스크래핑 에이전트를 시작할 수 있습니다.

가격

- 기본 라이선스는 연간 $27,500이며 한 대의 컴퓨터에서 소프트웨어를 사용할 수 있습니다.

80다리

80legs는 맞춤형 요구 사항에 따라 구성할 수 있는 강력한 웹 크롤링 도구입니다. 추출된 데이터를 즉시 다운로드하는 옵션과 함께 대량의 데이터 가져오기를 지원합니다. 이 도구는 사용자가 크롤러를 만들고 데이터를 관리하는 등의 작업을 수행할 수 있는 API를 제공합니다. 주요 기능 중 일부는 스크레이퍼 사용자 지정, 웹 스크래핑 요청을 위한 IP 서버, 사용자 지정 동작으로 웹 크롤링을 구성하기 위한 JS 기반 앱 프레임워크를 포함합니다.

주요 특징들

- 확장 가능하고 빠름 : 50,000개 이상의 동시 요청으로 하루에 최대 20억 페이지를 크롤링할 수 있습니다.

- 유연하고 사용자 지정 가능: 자체 코드를 사용하여 크롤링 논리 및 데이터 추출을 제어하거나 기본 제공 도구 및 템플릿을 사용할 수 있습니다.

가격

- 100,000개의 URL/크롤링에 대해 월 $29에서 시작하여 1,000만 개의 URL/크롤링에 대해 $299/월까지 필요에 따라 다양한 요금제 중에서 선택할 수 있습니다.

Webhose.io

Webhose.io는 사용자가 전 세계의 온라인 소스를 크롤링하고 다양한 깨끗한 형식으로 제공하여 실시간 데이터를 얻을 수 있도록 합니다. 이 웹 크롤러 도구는 다양한 소스를 포괄하는 여러 필터를 사용하여 데이터를 크롤링하고 다양한 언어로 키워드를 추가로 추출할 수 있습니다. 사용자는 스크랩한 데이터를 XML, JSON 및 RSS 형식으로 저장하고 아카이브에서 기록 데이터에 액세스할 수 있습니다. Webhose.io는 크롤링 데이터 결과로 최대 80개 언어를 지원하므로 사용자가 도구로 크롤링된 구조화된 데이터를 쉽게 인덱싱하고 검색할 수 있습니다.

주요 특징들

- 여러 형식 : XML, JSON, RSS 또는 Excel 형식으로 데이터를 가져올 수 있습니다.

- 구조화된 결과 : 필요에 따라 정규화, 보강 및 분류된 데이터를 얻을 수 있습니다.

- 기록 데이터 : 지난 12개월 이상의 보관된 데이터에 액세스할 수 있습니다.

- 광범위한 적용 범위 : 80개 언어와 240개 국가의 백만 개 이상의 출처에서 데이터를 얻을 수 있습니다.

- 다양한 출처 : 뉴스 사이트, 블로그, 포럼, 게시판, 댓글, 리뷰 등에서 데이터를 얻을 수 있습니다.

- 빠른 통합 : 간단한 REST API를 사용하여 몇 분 안에 Webhose.io를 시스템과 통합할 수 있습니다.

가격

- 매월 1000건의 요청을 무료로 할 수 있는 무료 플랜이 있습니다. 견적을 위해 연락할 수 있는 맞춤형 계획도 있습니다.

모젠다

Mozenda는 사용자가 한 줄의 코드를 작성하지 않고도 웹 데이터를 추출할 수 있는 클라우드 기반 웹 스크래핑 소프트웨어입니다. 데이터 추출 프로세스를 자동화하고 예약된 데이터 추출, 데이터 정리 및 IP 프록시 서버를 통한 차단 우회와 같은 기능을 제공합니다. Mozenda는 사용자 친화적인 인터페이스와 강력한 스크래핑 기능을 갖춘 기업용으로 설계되었습니다.

주요 특징들

- 텍스트 분석: 자연어 처리 기술을 사용하여 모든 웹사이트에서 텍스트 데이터를 추출하고 분석할 수 있습니다.

- 이미지 추출: 웹 페이지에서 이미지를 다운로드하여 저장하거나 크기, 형식, 해상도 등과 같은 이미지 메타데이터를 추출할 수 있습니다.

- 서로 다른 데이터 수집: HTML, XML, JSON, RSS 등과 같은 여러 소스 및 형식에서 데이터를 수집할 수 있습니다.

- 문서 추출: 광학 문자 인식(OCR) 또는 텍스트 추출 방법을 사용하여 PDF, Word, Excel 및 기타 문서 유형에서 데이터를 추출할 수 있습니다.

- 이메일 주소 추출 : 정규표현식이나 패턴매칭을 이용하여 웹페이지나 문서에서 이메일 주소를 찾아 추출할 수 있습니다.

가격

- 유료 요금제는 월 $99부터 시작합니다.

UiPath

UiPath는 무료 웹 스크래핑을 위한 RPA(로봇 프로세스 자동화) 소프트웨어입니다. 대부분의 타사 앱에서 크롤링되는 웹 및 데스크톱 데이터를 자동화합니다. Windows와 호환되는 UiPath는 여러 웹 페이지에서 표 형식 및 패턴 기반 데이터를 추출할 수 있습니다. 이 소프트웨어는 또한 복잡한 사용자 인터페이스를 추가로 크롤링하고 처리하기 위한 내장 도구를 제공합니다.

주요 특징들

- 텍스트 분석 : 이메일 주소 추출과 같은 작업을 위해 자연어 처리, 정규 표현식, 패턴 매칭을 사용하여 텍스트 데이터를 추출하고 분석합니다.

- 이미지 추출 : 웹 페이지에서 이미지를 다운로드 및 저장하고 크기, 형식 및 해상도를 포함한 이미지 메타데이터를 추출합니다.

- 이종 데이터 수집 : 다른 온라인 서비스 및 API에 연결하기 위한 통합 기능을 사용하여 HTML, XML, JSON, RSS와 같은 다양한 소스 및 형식에서 데이터를 수집합니다.

- 문서 추출 : OCR 또는 텍스트 추출 방법을 사용하여 PDF, Word, Excel 및 기타 문서 유형에서 데이터를 추출합니다. 문서 이해 기능을 사용하여 다양한 문서 유형 및 구조에서 정보를 처리하고 추출합니다.

- 웹 자동화 : 로그인, 페이지 탐색, 양식 작성, 버튼 클릭과 같은 웹 기반 활동을 자동화합니다. 레코더 기능을 활용하여 작업을 캡처하고 자동화 스크립트를 생성합니다.

가격

- 유료 플랜은 월 $420부터 시작합니다.

아웃윗 허브

OutWit Hub는 사용자의 웹 검색을 단순화하는 수십 가지 데이터 추출 기능이 포함된 Firefox 애드온입니다. 이 웹 크롤러 도구는 페이지를 탐색하고 추출된 정보를 적절한 형식으로 저장할 수 있습니다. OutWit Hub는 필요에 따라 소량 또는 대량의 데이터를 스크랩할 수 있는 단일 인터페이스를 제공하며 몇 분 만에 다양한 웹사이트에서 데이터를 추출하는 자동 에이전트를 생성할 수 있습니다.

주요 특징들

- 웹 콘텐츠 보기 및 내보내기: 웹 페이지에 포함된 링크, 문서, 이미지, 연락처, 데이터 테이블, RSS 피드, 이메일 주소 및 기타 요소를 볼 수 있습니다. HTML, SQL, CSV, XML, JSON 또는 기타 형식으로 내보낼 수도 있습니다.

- 테이블 및 목록의 데이터 구성: 테이블 및 목록에서 수집한 데이터를 정렬, 필터링, 그룹화 및 편집할 수 있습니다. 여러 기준을 사용하여 추출할 데이터를 선택할 수도 있습니다.

- 자동화 기능 설정 : 스크레이퍼 기능을 사용하여 단순 또는 고급 명령을 사용하여 모든 웹사이트에서 데이터를 추출할 수 있는 사용자 지정 스크레이퍼를 만들 수 있습니다. 매크로 기능을 사용하여 웹 탐색 및 스크래핑 작업을 자동화할 수도 있습니다.

- 쿼리 및 URL 생성: 쿼리 기능을 사용하여 키워드 또는 패턴을 기반으로 쿼리를 생성할 수 있습니다. URL 기능을 사용하여 패턴 또는 매개변수를 기반으로 URL을 생성할 수도 있습니다.

가격

- Light 라이센스는 무료이며 완전히 작동하지만 자동화 기능이 포함되어 있지 않으며 추출기에 따라 추출이 1개 또는 수백 개의 행으로 제한됩니다.

- Pro 라이선스는 연간 $110이며 Light 라이선스의 모든 기능과 자동화 기능 및 무제한 추출이 포함됩니다.

비주얼 스크레이퍼

Visual Scraper는 SaaS 플랫폼이 되는 것 외에도 데이터 전달 서비스 및 클라이언트용 소프트웨어 추출기 생성과 같은 웹 스크래핑 서비스도 제공합니다. 이 웹 크롤링 도구는 다운로드, URL 관리에서 콘텐츠 추출에 이르기까지 크롤러의 전체 수명 주기를 다룹니다. 이를 통해 사용자는 특정 시간에 실행되도록 프로젝트를 예약하거나 분, 일, 주, 월 또는 년마다 시퀀스를 반복할 수 있습니다. Visual Scraper는 뉴스, 업데이트 및 포럼을 자주 추출하려는 사용자에게 이상적입니다. 단, 공식 홈페이지는 현재 업데이트가 되지 않은 것으로 보이며, 이 정보는 최신 정보가 아닐 수 있습니다.

주요 특징들

- 사용하기 쉬운 인터페이스

- 여러 데이터 형식(CSV, JSON, XML 등) 지원

- 페이지 매김, AJAX 및 동적 웹 사이트 지원

- 프록시 서버 및 IP 순환 지원

- 스케줄링 및 자동화 지원

가격

- 월 $39.99부터 시작하는 무료 요금제와 유료 요금제가 있습니다.

Import.io

Import.io는 사용자가 특정 웹 페이지에서 데이터를 가져와 코드를 작성하지 않고 CSV로 내보낼 수 있는 웹 스크래핑 도구입니다. 몇 분 만에 수천 개의 웹 페이지를 쉽게 스크랩하고 사용자 요구 사항에 따라 1000개 이상의 API를 구축할 수 있습니다. Import.io는 몇 번의 클릭만으로 웹 데이터를 사용자의 앱이나 웹사이트에 통합하여 웹 스크래핑을 더 쉽게 만듭니다.

주요 특징들

- 포인트 앤 클릭 선택 및 교육

- 인증된 대화형 추출

- 이미지 다운로드 및 스크린샷

- 프리미엄 프록시 및 국가별 추출기

- CSV, Excel, JSON 출력 및 API 액세스

- 데이터 품질 SLA 및 보고

- 이메일, 티켓, 채팅 및 전화 지원

가격

- 스타터: 5,000개의 쿼리에 대해 월 $199

Dexi.io

Dexi.io는 브라우저 기반 웹 크롤러로 사용자가 모든 웹 사이트에서 브라우저를 기반으로 데이터를 스크랩할 수 있도록 하며 추출기, 크롤러 및 파이프의 세 가지 유형의 로봇을 제공하여 스크래핑 작업을 생성합니다. 프리웨어는 익명의 웹 프록시 서버를 제공하며 추출된 데이터는 데이터가 보관되기 전 2주 동안 Dexi.io의 서버에서 호스팅되거나 사용자가 추출된 데이터를 JSON 또는 CSV 파일로 직접 내보낼 수 있습니다. 실시간 데이터 추출이 필요한 사용자를 위해 유료 서비스를 제공합니다.

주요 특징들

- 포인트 앤 클릭 선택 및 교육

- 인증된 대화형 추출

- 이미지 다운로드 및 스크린샷

- 프리미엄 프록시 및 국가별 추출기

- CSV, Excel, JSON 출력 및 API 액세스

- 데이터 품질 SLA 및 보고

- 이메일, 티켓, 채팅 및 전화 지원

가격

- 표준: 근로자 1인당 월 $119 또는 연간 $1,950

인형극

Puppeteer는 Google에서 개발한 Node 라이브러리로 프로그래머가 DevTools 프로토콜을 통해 Chrome 또는 Chromium을 제어할 수 있는 API를 제공합니다. 이를 통해 사용자는 Puppeteer 및 Node.js로 웹 스크래핑 도구를 구축할 수 있습니다. Puppeteer는 웹 페이지의 스크린샷 촬영 또는 PDF 생성, 양식 제출/데이터 입력 자동화, 자동화된 테스트를 위한 도구 생성과 같은 다양한 목적으로 활용될 수 있습니다.

주요 특징들

- 웹 페이지의 스크린샷 및 PDF 생성

- 웹 사이트에서 데이터 크롤링 및 스크랩

- 양식 제출, UI 테스트, 키보드 입력 등을 자동화합니다.

- 성능 메트릭 및 추적 캡처

- Chrome 확장 프로그램 테스트

- 헤드리스 또는 헤드풀 모드에서 실행

가격

- Puppeteer는 무료이며 오픈 소스입니다.

크롤러4j

Crawler4j는 웹을 크롤링하기 위한 간단한 인터페이스가 있는 오픈 소스 Java 웹 크롤러입니다. 이를 통해 사용자는 메모리를 효율적으로 사용하면서 다중 스레드 크롤러를 구축할 수 있습니다. Crawler4j는 간단하고 사용자 정의 가능한 Java 기반 웹 크롤링 솔루션을 원하는 개발자에게 매우 적합합니다.

주요 특징들

- 정규식을 사용하여 크롤링할 URL과 무시할 URL을 지정할 수 있습니다.

- 다운로드한 페이지를 처리하고 여기에서 데이터를 추출할 수 있습니다.

- robots.txt 프로토콜을 준수하고 허용되지 않는 페이지 크롤링을 방지합니다.

- HTML, 이미지 및 기타 파일 형식을 크롤링할 수 있습니다.

- 통계를 수집하고 여러 크롤러를 동시에 실행할 수 있습니다.

가격

- Crawler4j는 자신의 웹 크롤러를 쉽게 설정하고 실행할 수 있는 오픈 소스 Java 프로젝트입니다.

일반 크롤링

Common Crawl은 연구, 분석 및 교육 목적으로 웹 데이터의 개방형 코퍼스를 제공하는 웹 크롤러 도구입니다.

주요 특징들

- 원시 웹 페이지 데이터, 추출된 메타데이터, 텍스트, 일반 크롤링 색인과 같은 웹 크롤링 데이터에 대한 액세스를 사용자에게 제공합니다.

가격

- 공개적으로 액세스할 수 있는 이 무료 웹 크롤링 데이터는 개발자, 연구원 및 기업에서 다양한 데이터 분석 작업에 사용할 수 있습니다.

MechanicalSoup

MechanicalSoup은 Mechanize 라이브러리에서 영감을 받아 Beautiful Soup 라이브러리를 기반으로 웹 사이트를 구문 분석하는 데 사용되는 Python 라이브러리입니다. 쿠키를 저장하고 리디렉션, 하이퍼링크를 따르고 웹 사이트에서 양식을 처리하는 데 적합합니다.

주요 특징들

- MechanicalSoup은 복잡한 프로그래밍 작업을 처리할 필요 없이 웹사이트에서 데이터를 탐색하고 추출하는 간단한 방법을 제공합니다.

가격

- 무료 도구입니다.

노드 크롤러

Node Crawler는 Node.js 플랫폼으로 웹사이트를 크롤링하기 위한 대중적이고 강력한 패키지입니다. Cheerio를 기반으로 실행되며 요청 수와 요청 사이에 걸리는 시간 제한을 포함하여 사용자가 웹을 크롤링하거나 스크랩하는 방식을 사용자 정의할 수 있는 많은 옵션이 제공됩니다. Node Crawler는 웹 크롤링 프로젝트를 위해 Node.js 작업을 선호하는 개발자에게 이상적입니다.

주요 특징들

- 사용하기 쉬운

- 이벤트 기반 API

- 구성 가능한 재시도 및 시간 제한

- 자동 인코딩 감지

- 자동 쿠키 처리

- 자동 리디렉션 처리

- 자동 gzip/수축 처리

가격

- 무료 도구입니다.

웹 크롤링 도구를 선택할 때 고려해야 할 요소

가격

선택한 도구의 가격 구조를 고려하고 숨겨진 비용 없이 투명한지 확인하십시오. 명확한 가격 책정 모델을 제공하고 사용 가능한 기능에 대한 자세한 정보를 제공하는 회사를 선택하십시오.

사용의 용이성

사용자 친화적이고 광범위한 기술 지식이 필요하지 않은 웹 크롤링 도구를 선택하십시오. 많은 도구가 포인트 앤 클릭 인터페이스를 제공하므로 프로그래머가 아닌 사용자가 웹 사이트에서 데이터를 쉽게 추출할 수 있습니다.

확장성

웹 크롤링 도구가 추출해야 하는 데이터의 양을 처리할 수 있는지, 비즈니스와 함께 성장할 수 있는지 여부를 고려하십시오. 일부 도구는 소규모 프로젝트에 더 적합하고 다른 도구는 대규모 데이터 추출용으로 설계되었습니다.

데이터 품질 및 정확성

웹 크롤링 도구가 추출된 데이터를 정리하고 사용 가능한 형식으로 구성할 수 있는지 확인하십시오. 정확한 분석을 위해서는 데이터 품질이 중요하므로 효율적인 데이터 정리 및 구성 기능을 제공하는 도구를 선택하세요.

고객 지원

문제가 발생할 때 도움을 줄 수 있는 신속하고 유용한 고객 지원을 제공하는 웹 크롤링 도구를 선택하십시오. 고객 지원에 연락하고 정보에 입각한 결정을 내리기 전에 응답하는 데 걸리는 시간을 기록하여 고객 지원을 테스트하십시오.

결론

웹 크롤링 도구는 시장 조사, SEO 및 경쟁 분석과 같은 다양한 목적을 위해 웹 사이트에서 귀중한 데이터를 추출하려는 비즈니스에 필수적입니다. 가격, 사용 용이성, 확장성, 데이터 품질 및 정확성, 고객 지원과 같은 요소를 고려하여 필요에 맞는 올바른 웹 크롤링 도구를 선택할 수 있습니다. 위에서 언급한 상위 25개 웹 크롤링 도구는 비프로그래머부터 개발자까지 다양한 사용자를 수용하여 모두에게 적합한 도구가 있는지 확인합니다. Scalenut의 7일 무료 평가판에 등록하여 웹 사이트 콘텐츠를 최적화하고 순위를 높일 수도 있습니다.