가장 과소평가된 5가지 온크롤링 기능

게시 됨: 2021-10-20플랫폼을 손등처럼 안다고 생각하는 노련한 Oncrawler입니까? 또는 최근에 우리와 파트너 관계를 맺었고 시작을 위한 내부 팁을 찾고 있습니까? Oncrawl의 CSM 팀의 일원으로서 저는 플랫폼 도구에 대해 자주 방문하지 않는 것으로 나타났습니다. 따라서 귀하의 상황에 관계없이 다음은 간과했거나 아직 알지 못하는 과소 평가된 Oncrawl 기능 상위 5개에 대한 요약입니다!

사용자 정의 필드(데이터 스크래핑)

Oncrawl의 사용자 정의 필드에 대한 간략한 요약은 XPath와 Regex의 두 가지 스크래핑 방법을 제공합니다. 더 진행하기 전에 웹 스크래핑, 웹 사이트에서 데이터 추출에 대해 더 자세히 살펴보고 싶다면 유용한 기능에 대해 설명하는 이 기사를 확인하십시오.

이제 사용자 정의 필드 기능이 반드시 획기적인 것은 아니지만 믿을 수 없을 정도로 편리한 것은 한 가지 방법으로 제한되지 않고 Regex와 XPath를 혼합하여 사용할 수 있다는 것입니다.

간단히 말해서 Regex와 Xpath는 물건을 찾는 방법입니다. 텍스트를 개별적으로 검색하는 대신 패턴을 기반으로 검색할 수 있습니다. 이 텍스트에서 "September, 21"이라는 월을 식별하려는 경우 "September"를 검색하는 대신 정규식을 사용하여 \w+를 사용하여 문자라는 단어를 선택할 수 있습니다. Xpath를 사용하면 XML 또는 HTML 문서의 텍스트 요소를 표시할 수 있습니다. 이 경우 div 요소 내에 콘텐츠를 표시하고 싶다고 가정해 보겠습니다. //div[@class 등으로 시작합니다. 어떤 경우에는 내용만 표시하고 싶은 경우도 있고 특정 패턴을 식별하고 싶은 경우도 있지만 두 가지를 혼합해야 하는 경우도 있습니다.

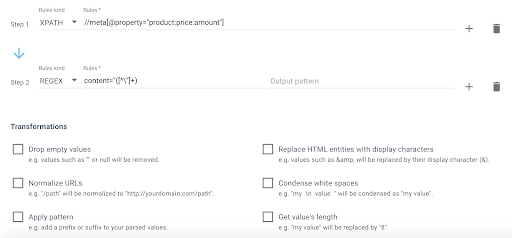

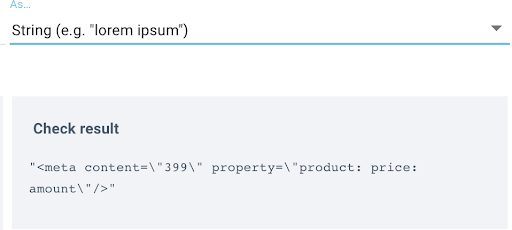

예를 들어 사이트의 모든 제품 항목에 대한 가격을 스크랩하고 싶다고 가정해 보겠습니다. 첫 번째 규칙에서는 XPath를 사용하고 있으며 가격 요소를 선택하고 있는지 확인하기 위해 원시 데이터를 가져오는 것을 볼 수 있습니다.

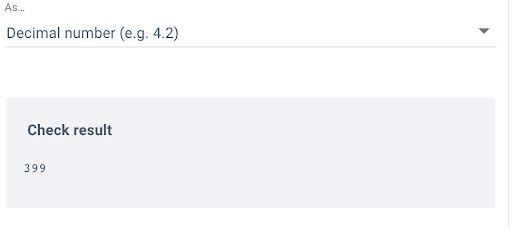

그런 다음 두 번째 규칙에 Regex를 사용하여 따옴표까지 요소만 선택합니다. 이 경우에는 가격이 content=”([^\”]+)입니다.

스크래핑 규칙을 좀 더 빠르고 쉽게 만들 수 있습니다. 두 가지 방법 모두 아직 익숙하지 않다면 여기에 몇 가지 팁이 포함된 멋진 기사가 있습니다.

데이터 탐색기의 사용자 정의 필터

Oncrawl 쿼리 언어와 함께 사용한 필터를 기억하려고 데이터 탐색기에서 자신을 발견한 적이 있습니까? 또는 거기에 있을 때마다 항상 수동으로 OQL을 사용하여 크롤링된 페이지를 필터링하고 관련 열을 하나씩 추가할 수 있습니다. DataSet 옵션의 오른쪽에 편리하게 위치한 사용자 정의 필터 기능을 사용하여 귀중한 시간을 절약할 수 있습니다.

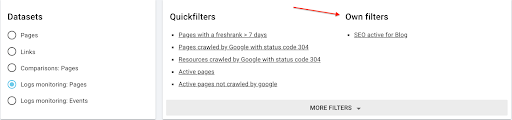

일반 쿼리로 구성된 Quickfilters 옵션이 있으며, 저장한 모든 사용자 정의 필터는 찾고 있는 페이지를 쉽게 검색할 수 있는 '자체 필터' 섹션 아래에 추가됩니다. 이것은 사용 가능한 모든 데이터 세트에 대해 수행할 수 있으며 기본적으로 페이지 및 링크가 있지만 구독에서 로그 모니터링을 활성화한 경우 로그 모니터링: 페이지 및 로그 모니터링: 이벤트에 대한 옵션이 표시됩니다.

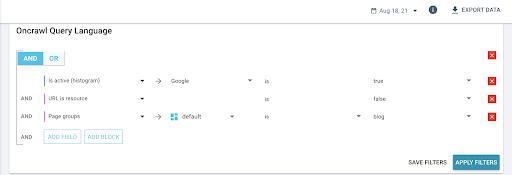

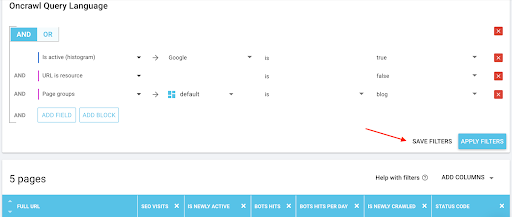

OQL을 사용하여 페이지를 필터링하기만 하면 됩니다. 여기서는 8월 18일, 특히 블로그 페이지 그룹에 대한 SEO 활성 페이지를 보고 있습니다.

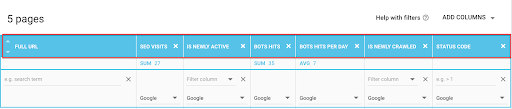

그런 다음 드롭다운 메뉴("ADD COLUMNS")를 사용하여 관련 메트릭을 검색에 추가할 수 있습니다.

그런 다음 "필터 저장"을 클릭하여 사용자 정의 필터를 저장하면 "자체 필터"에서 사용할 수 있습니다.

경고/알림 기록

간과할 수 있는 2021년 기능 업그레이드에 최근 추가된 기능은 로그 경고를 활성화하는 옵션입니다. 이는 로그의 모든 처리 문제를 인식할 수 있는 좋은 방법입니다. 따라서 플랫폼에 로그인할 때 예치금 문제를 발견하기를 기다리지 말고 최근에 로그가 예치되지 않았거나 예치된 항목이 유용하지 않은 것으로 간주될 때 알려주는 로그 경고를 활성화하십시오.

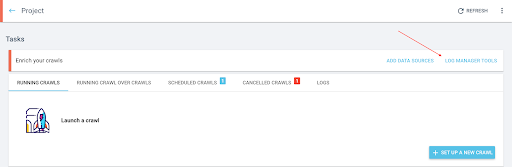

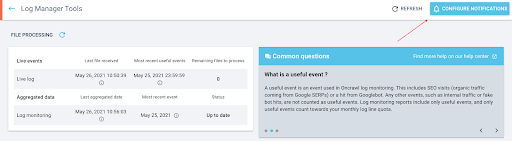

사용 방법은 매우 간단합니다. 로그 모니터링이 활성화된 프로젝트로 이동하여 "로그 관리자 도구" 탭을 클릭합니다.

로그 관리자 도구 보고서에서 "알림 구성"을 클릭합니다.

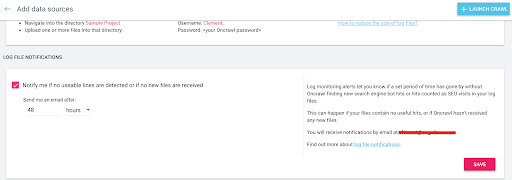

여기에서 알림을 활성화하고 유용한 라인이 없거나 새 파일이 저장되지 않은 경우 연락해야 하는 시점에 대한 임계값을 정의할 수 있습니다.

이렇게 하면 일부 예금에서 정확히 무엇이 잘못되었는지 발견하는 데 시간을 절약할 수 있으므로 최신 보고서를 더 빨리 얻을 수 있습니다.

[전자책] SEO 로그 분석을 활용하는 4가지 활용 사례

로그 관리자 도구

로그에 대한 주제이므로 로그 관리자 도구 보고서는 자주 활용되지 않는 플랫폼의 또 다른 중요한 영역이라는 점을 언급하는 것이 적절해 보입니다. 로그 파일과 관련하여 정확히 무엇이 저장되는지에 대한 세부 정보로 구성된 프로젝트 수준에 자리 잡은 멋진 작은 허브입니다.

뛰어들면 입금된 정확한 파일을 볼 수 있을 뿐만 아니라 각 입금의 정확한 날짜와 시간, 각 유형의 로그 라인 분석(OK, 필터링됨, 오류), 입금 날짜별로 탐지된 가짜 봇 히트 수를 모니터링하는 그래프로, 입금된 로그의 품질 분석과 유용한 라인 분포를 볼 수 있습니다.

예를 들어 파일이 압축되었는지 확인하고 실제로 입금하는 경우 유기적 방문 및 봇 히트에서와 같이 SEO 관련 라인인지 확인하고 입금 빈도 확인과 같이 파일 예치의 품질을 확인하기에 좋은 곳입니다.

로그 보고서에서 이상한 점을 발견하기 시작하면 로그 관리자 도구에서 조사를 시작하는 것이 좋습니다. 로그 라인 형식이 변경되었고 고객 성공 팀이 파서를 업데이트해야 하거나 버킷 이름이 변경되어 새 자격 증명을 보내야 한다는 것을 알게 될 수도 있습니다. 어쨌든, 더 깊이 파고드는 데 도움이 필요하면 언제든지 살펴보고 저희에게 연락할 수 있습니다.

개인화된 세분화

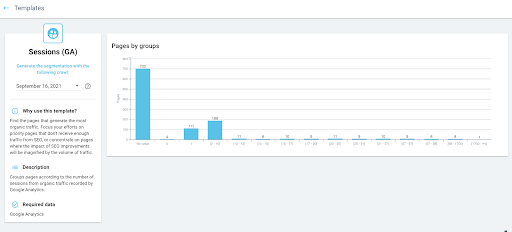

마지막으로 가장 최근에 추가된 개인화된 세분화입니다! 이제 세분화 작업을 한 번도 해본 적이 없는 Oncrawl을 처음 사용하는 사람들에게 영감을 주거나 좀 더 원활하게 개발할 수 있도록 하는 세분화 템플릿 모음이 있습니다.

분할에 대한 빠른 실행은 크롤링 결과를 검사할 때 사이트의 어느 부분을 보고 있는지 알고 싶기 때문에 개발에 필수적입니다. URL의 첫 번째 경로를 기준으로 페이지를 그룹화하는 것처럼 간단할 수도 있고 GA 세션 범위를 기준으로 페이지를 그룹화하는 것처럼 구체적일 수도 있습니다.

이제 템플릿을 사용해야 하는 이유에 대한 약간의 지침을 제공하는 템플릿 외에도 프로젝트에 대해 설정한 외부 데이터 커넥터에 따라 여러 템플릿을 사용할 수 있습니다.

따라서 로그 데이터가 있는 경우 SEO 방문 또는 봇 조회수에 대한 템플릿 제안이 표시되고 Google Search Console이 연결된 경우 위치 또는 순위 페이지를 기반으로 세분화를 생성하는 옵션이 표시됩니다.

사이트를 어떻게 볼 것인지는 귀하에게 달려 있습니다. 저희는 이를 조금 더 쉽게 하기 위해 여기 있습니다. 그러니 한 번 시도해 보고 어떻게 생각하는지 알려주십시오.