크롤링 데이터와 로그 데이터를 결합해야 하는 5가지 이유

게시 됨: 2018-03-27SEO 커뮤니티에서 SEO의 로그 파일 데이터에 대한 이해가 점점 증가하고 있습니다. 로그 파일은 실제로 웹사이트에서 일어나는 일에 대한 유일한 정성적 표현입니다. 그러나 우리는 여전히 그들이 효과적으로 말하게 할 수 있어야 합니다.

정확한 SEO 방문 및 봇 동작은 로그 파일에 있습니다. 반면에 크롤링 보고서의 데이터는 현장 성과에 대한 좋은 정보를 제공할 수 있습니다. 웹사이트를 분석할 때 새로운 차원을 강조하려면 로그 파일과 크롤링 데이터를 결합해야 합니다.

이 기사에서는 크롤링 및 로그 파일 데이터를 결합하는 5가지 훌륭한 방법을 보여줍니다. 분명히 더 많은 것을 사용할 수 있습니다.

1# 고아 페이지 감지 및 크롤링 예산 최적화

고아 페이지란 무엇입니까? URL이 사이트 아키텍처에 있지 않고 로그에 나타나는 경우 이 URL을 고아라고 합니다.

Google에는 엄청난 색인이 있습니다! 시간이 지나면 아키텍처에 더 이상 존재하지 않는 경우에도 웹사이트에서 이미 발견한 모든 URL을 유지합니다(슬러그 변경, 삭제된 페이지, 완전한 사이트 마이그레이션, 오류 또는 변환된 외부 링크). 분명히 Google에서 이러한 소위 분리된 페이지를 크롤링하면 크롤링 예산 최적화에 영향을 미칠 수 있습니다. 사용되지 않는 URL이 크롤링 예산을 소모하는 경우 다른 URL이 더 정기적으로 크롤링되는 것을 방지하고 반드시 SEO에 영향을 미칩니다.

웹사이트를 크롤링할 때 OnCrawl은 모든 링크를 통해 사이트의 전체 아키텍처를 깊이별로 탐색합니다. 반면에 로그 파일 모니터링 중에 OnCrawl은 Google 봇 조회수 및 SEO 방문의 데이터를 컴파일합니다.

Google이 알고 있는 URL과 아키텍처에 연결된 URL 간의 차이는 매우 중요할 수 있습니다. 잊혀지거나 깨진 링크를 수정하고 고아 페이지를 줄이는 것을 목표로 하는 SEO 최적화는 필수적입니다.

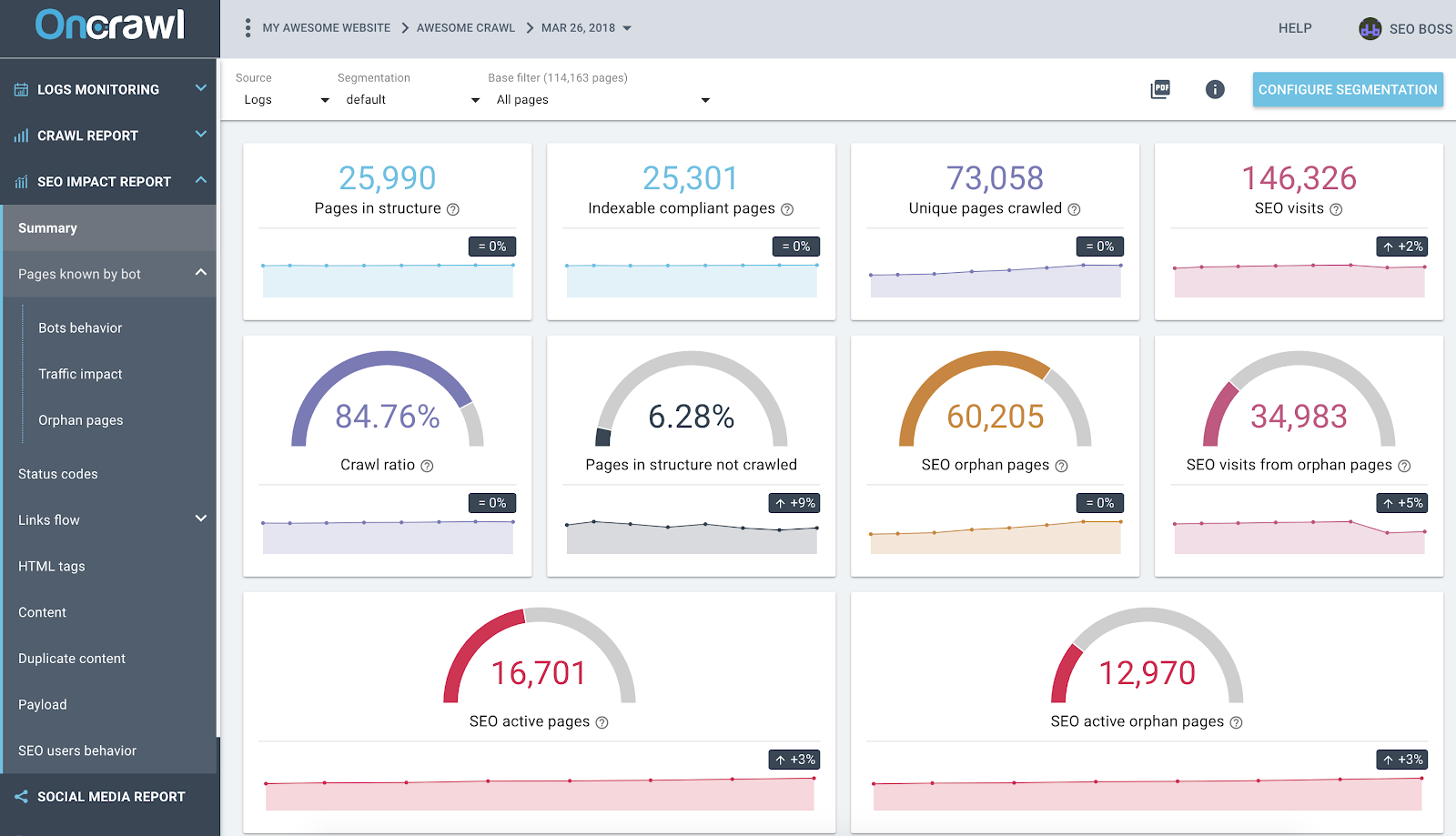

로그 및 크롤링 교차 데이터 분석을 기반으로 하는 OnCrawl SEO 영향 보고서

위의 스크린샷은 최신 로그 및 크롤링 데이터를 보여줍니다. 다음을 빠르게 확인할 수 있습니다.

- 구조에는 25,990페이지가 있습니다. 크롤러가 웹사이트에서 찾은 모든 링크를 고려하여 찾았습니다.

- Google은 73,058페이지를 크롤링합니다. 이는 구조보다 3배 많은 양입니다.

- 84%의 크롤링 비율 – (OnCrawl 크롤링 페이지 + 로그의 활성 페이지 + Google 크롤링 페이지 ) / Google 크롤링 페이지;

- 내부 페이지의 6% 이상이 크롤링되지 않습니다. 검은색 버킷을 클릭하기만 하면 데이터 탐색기에 이러한 페이지 목록이 표시됩니다.

- 60K 고아 페이지 – 구조의 페이지와 Google에서 크롤링한 페이지 간의 델타.

- 이 페이지의 34K SEO 방문 - 내부 연결에 문제가 있는 것 같습니다!

모범 사례: OnCrawl은 각 그래프 또는 메트릭을 클릭하기만 하면 이면에 있는 데이터를 탐색할 수 있는 이점을 제공합니다. 이렇게 하면 탐색한 범위에서 직접 필터링된 다운로드 가능한 URL 목록을 얻을 수 있습니다.

2# 크롤링 예산을 가장 많이(또는 가장 적게) 소비하는 URL을 찾습니다.

Google 봇 방문의 모든 이벤트는 OnCrawl 데이터 플랫폼에 의해 알려져 있습니다. 이를 통해 각 URL에 대해 시간에 따라 컴파일된 모든 데이터를 알 수 있습니다.

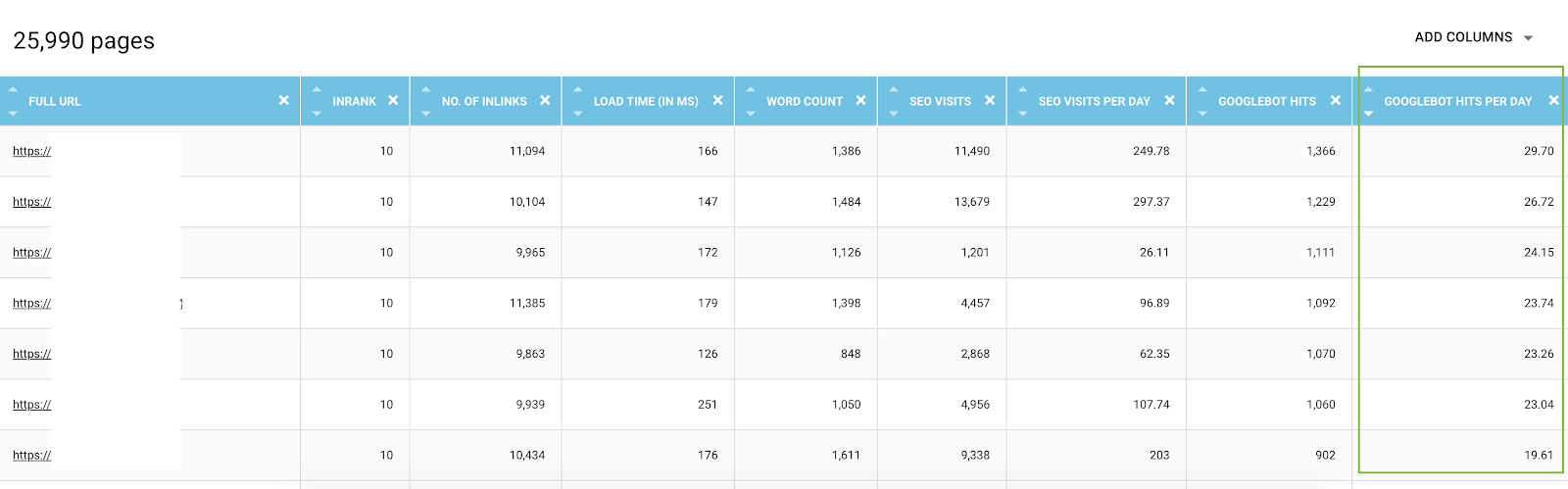

데이터 탐색기에서 각 URL 봇 적중 열(45일 동안)과 일별 및 봇별 적중(일별 평균 값)에 대해 추가할 수 있습니다. 이러한 정보는 Google 크롤링 예산 소비를 평가하는 데 유용합니다. 이 예산이 모든 사이트에서 균일하지 않다는 것을 알게 될 것입니다.

크롤링 지표가 있는 데이터 탐색기의 모든 URL 목록과 일별 봇 조회수로 필터링됨

실제로 일부 요인은 크롤링 예산을 실행하거나 줄일 수 있습니다. 그런 다음 이 기사에서 Google 페이지 중요도에 대한 가장 중요한 측정항목 목록을 만들었습니다. 깊이, 페이지를 가리키는 링크 수, 키워드 수, 페이지 속도, InRank(내부 인기도)는 봇 크롤링에 영향을 줍니다. 다음 단락에서 더 배우게 될 것입니다.

3# 최고의 SEO 페이지, 최악의 SEO 페이지를 파악하고 페이지의 성공 요인을 결정하십시오.

데이터 탐색기를 사용하면 페이지에 대한 주요 메트릭에 액세스할 수 있지만 수백 개의 라인과 메트릭을 함께 비교하는 것은 복잡할 수 있습니다. 열을 사용하여 일별 봇 조회수와 일별 SEO 방문을 분류하는 것은 데이터 마이닝의 동맹입니다.

- CS – 일별 봇 조회수 및 CS – 일별 SEO 방문 JSON 파일을 다운로드하십시오.

- 새 세분화로 추가하십시오.

사실, 로그 분석의 결과인 이 두 값을 기반으로 세분화를 생성하여 그룹별로 페이지를 먼저 배포할 수 있습니다. 그러나 이러한 세분화의 각 그룹을 필터링하여 각 OnCrawl 보고서에서 예상 값에 도달하지 못한 페이지를 빠르게 감지할 수도 있습니다.

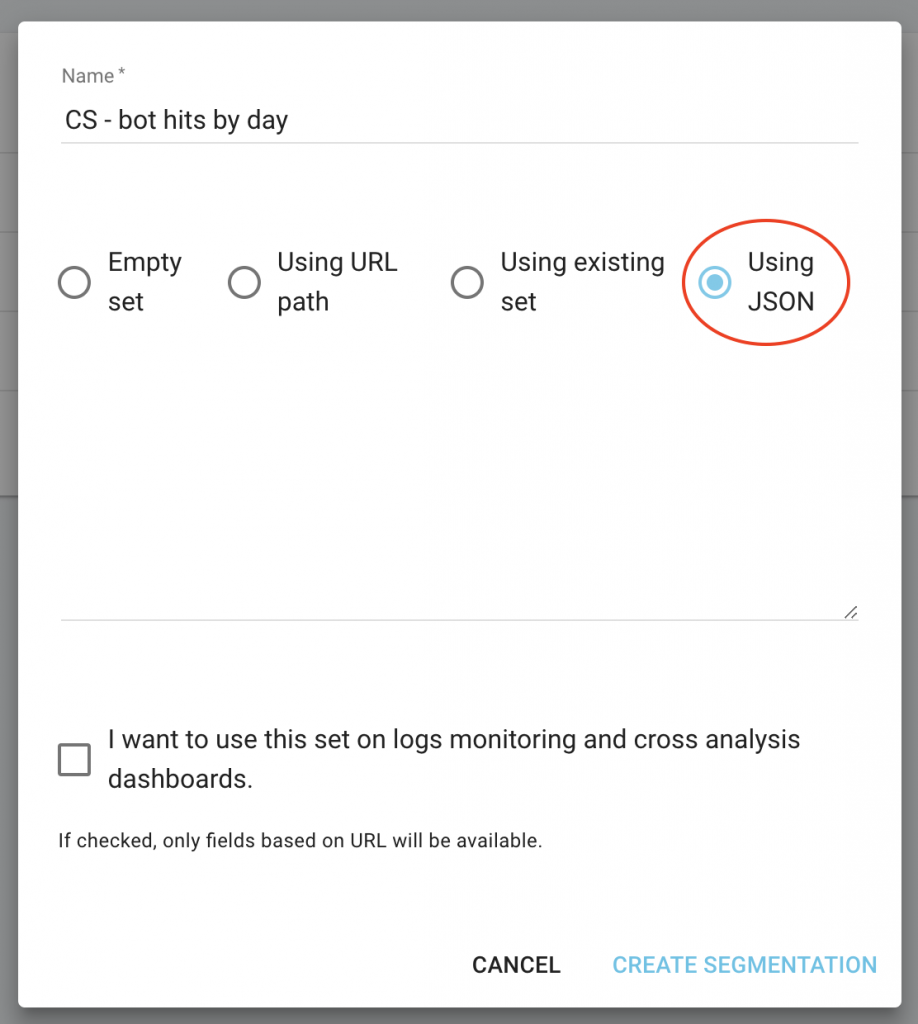

프로젝트 홈페이지에서 "세그먼트 구성" 버튼을 클릭합니다.

그런 다음 새 세분화 만들기

"JSON 사용" 용량을 선택하여 JSON 가져오기를 사용하고 다운로드한 파일을 복사/붙여넣기합니다.

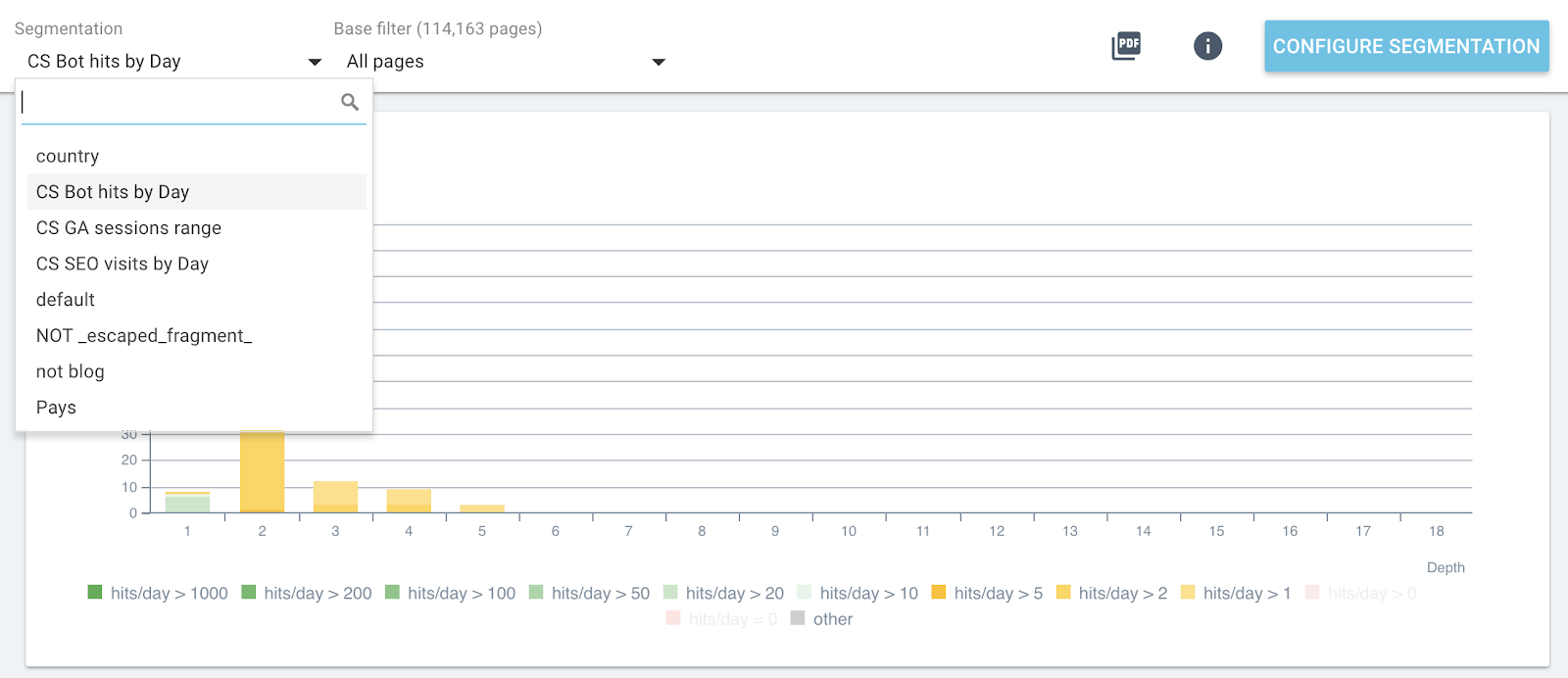

이제 각 보고서의 상단 메뉴를 사용하여 세분화를 전환할 수 있습니다.

모든 OnCrawl 보고서의 실시간 세분화 변경

이렇게 하면 분석 중인 메트릭의 영향과 봇 조회수 또는 SEO 방문별로 그룹화된 페이지와 관련된 각 그래픽을 확인할 수 있습니다.

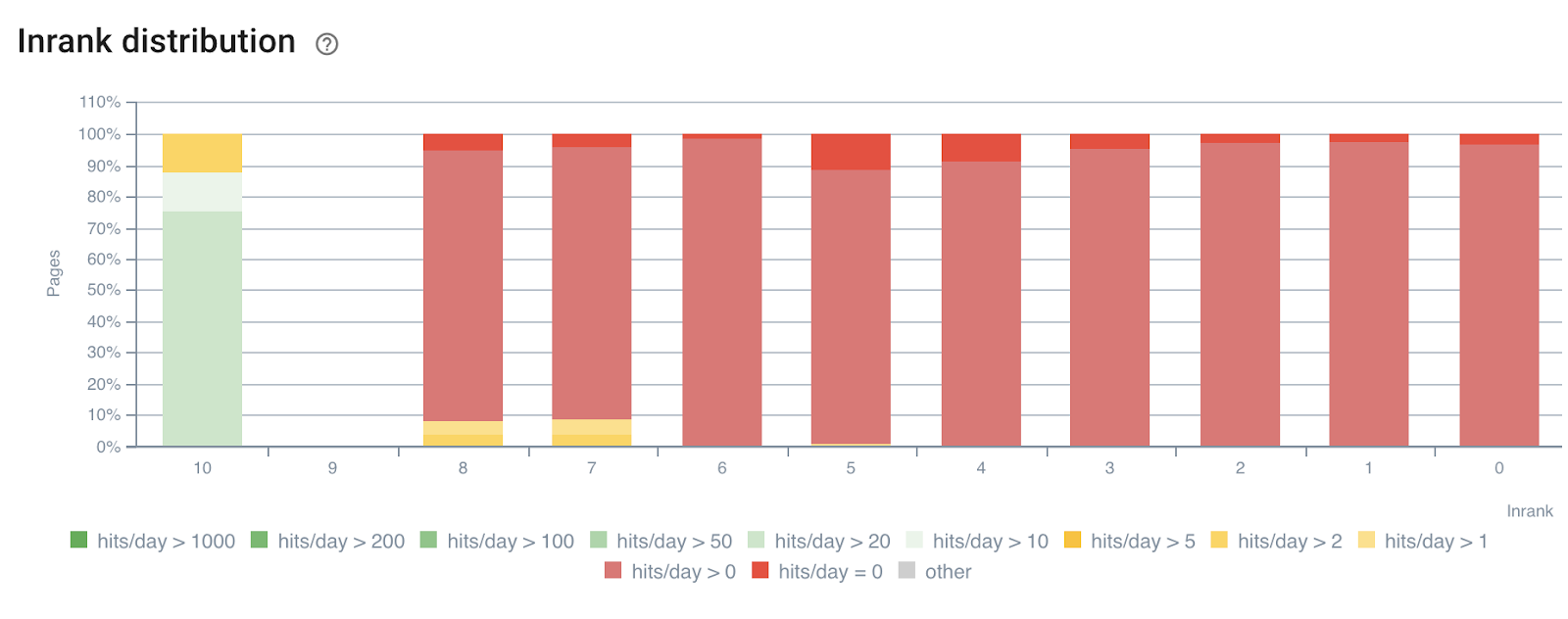

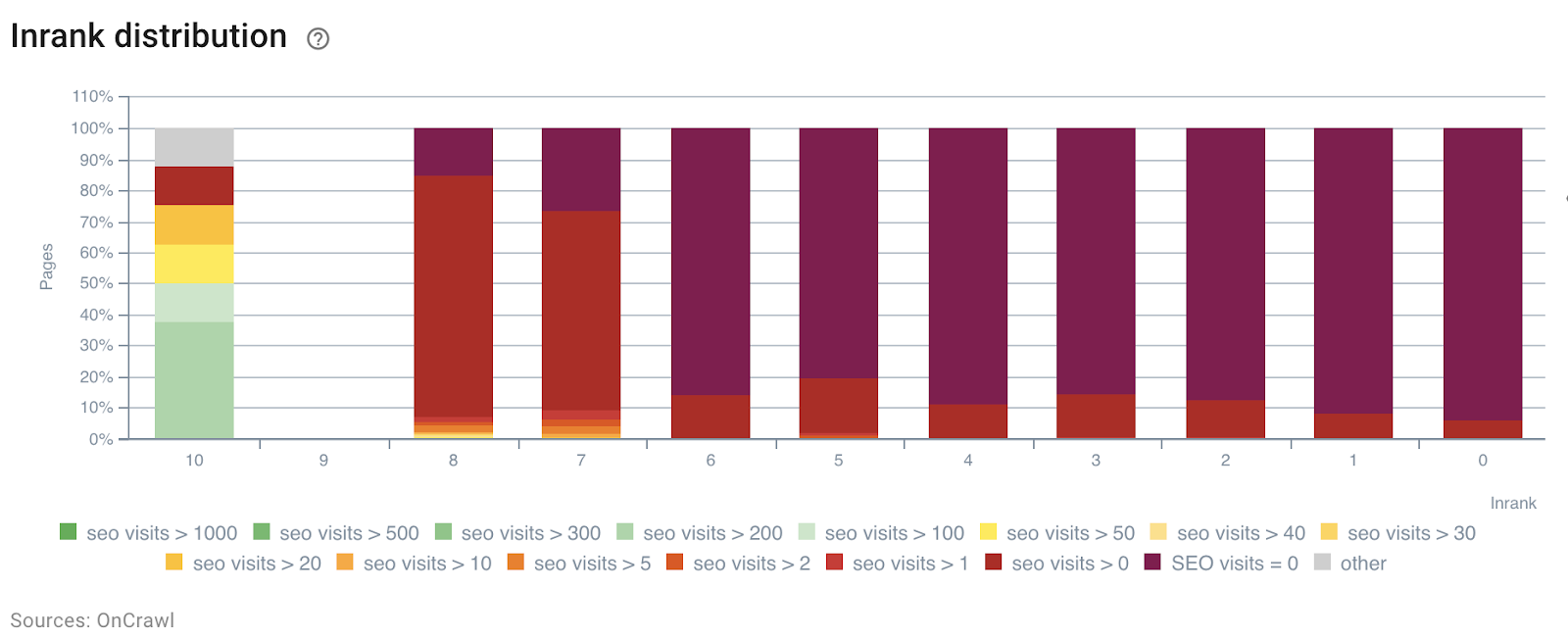

다음 예에서는 깊이별 링크의 힘을 기반으로 InRank 내부 인기도의 영향을 이해하기 위해 이러한 세그먼트를 사용했습니다. 또한 봇 조회수와 SEO 방문은 동일한 축에서 상관 관계가 있습니다.

일별 봇 조회수별 InRank 분포

일별 SEO 방문별 InRank 분포

깊이(홈페이지의 클릭 수)는 봇 조회수와 SEO 방문수 모두에 분명히 영향을 미칩니다.

같은 방식으로 각 페이지 그룹을 독립적으로 선택하여 가장 많이 방문했거나 방문한 페이지의 데이터를 강조 표시할 수 있습니다.

이를 통해 최적화된 경우 더 나은 성능을 낼 수 있는 페이지, 페이지의 단어 수, 수신 링크의 깊이 또는 수를 빠르게 감지할 수 있습니다.

분석하려는 페이지 그룹과 올바른 세분화를 선택하기만 하면 됩니다.

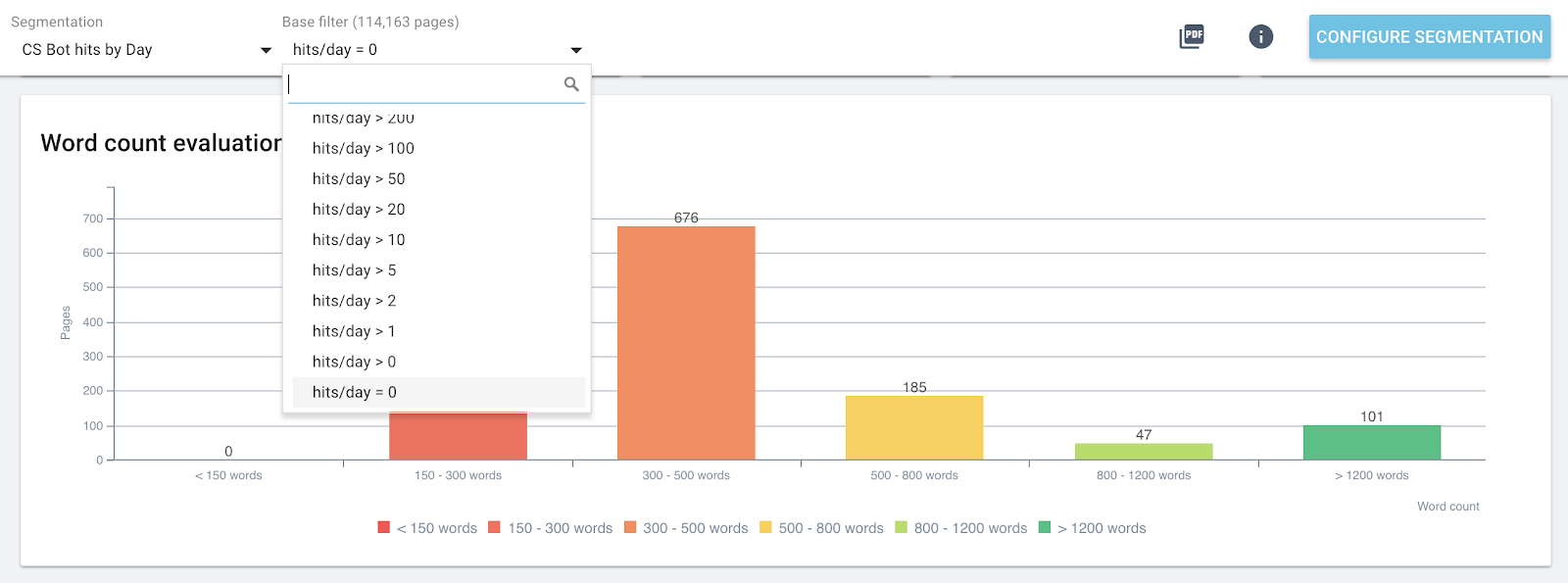

일별 0 봇 적중을 포함하는 그룹에 대한 페이지의 단어 분포

4# 크롤링 예산 및 SEO 방문을 최대화하기 위한 임계값 결정

더 나아가서 SEO 영향 보고서(크롤링 및 로그 교차 데이터 분석)는 SEO 방문, 크롤링 빈도 또는 페이지 검색을 늘리는 데 도움이 되는 임계값을 감지할 수 있습니다.

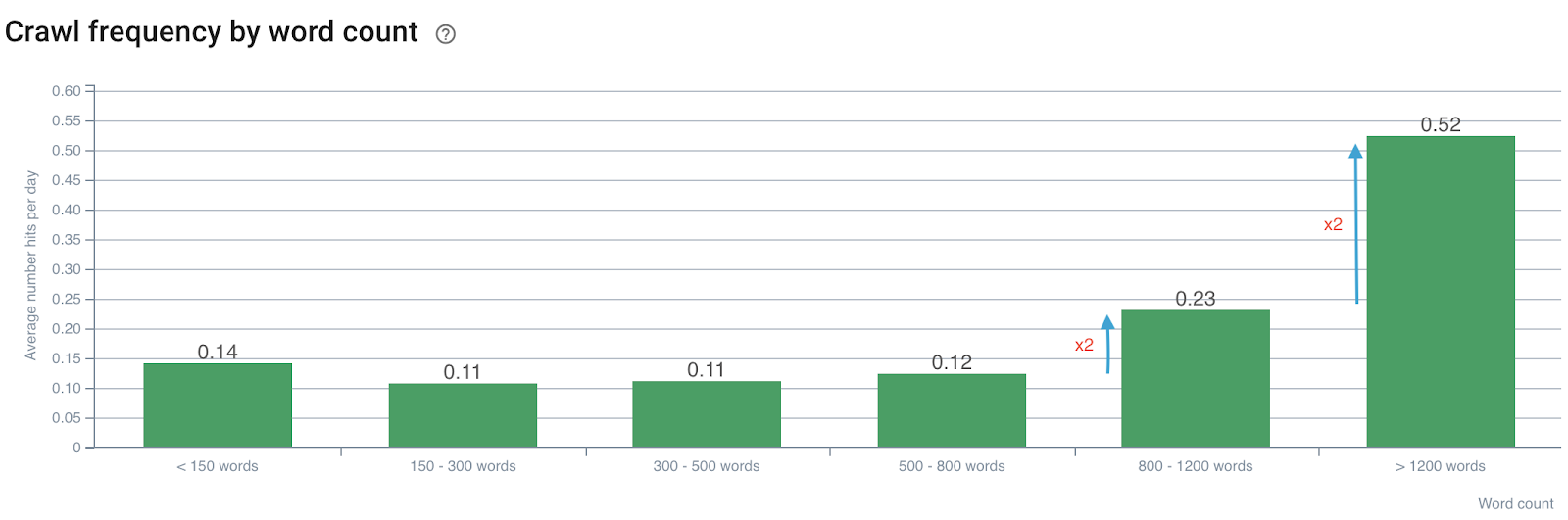

크롤링 빈도에 대한 단어 수가 미치는 영향

단어 수에 따른 크롤링 빈도

단어 수가 800개를 초과하면 크롤링 빈도가 두 배가 됩니다. 그런 다음 페이지의 단어 수가 1200단어를 초과하면 크롤링 빈도도 두 배가 됩니다.

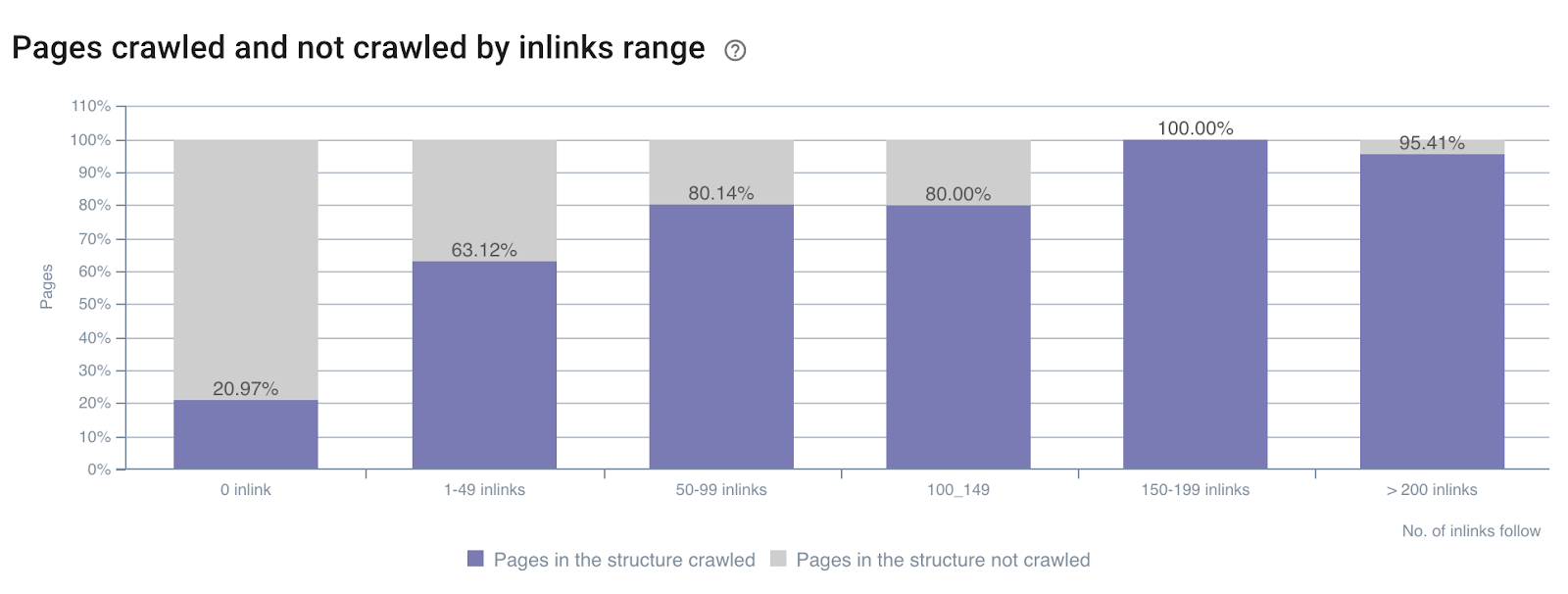

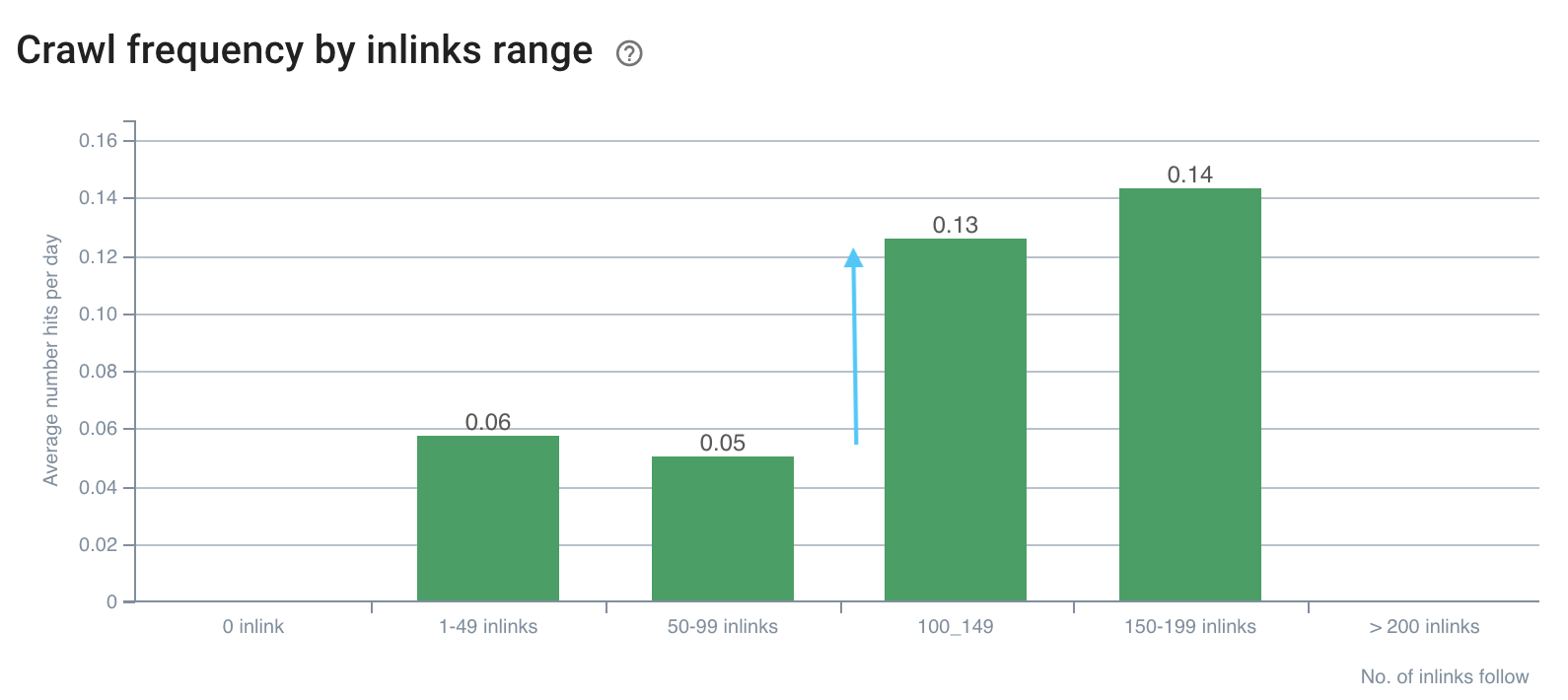

크롤링 비율에 대한 인링크 수의 영향

사이트 전체의 인링크 수에 따른 크롤링 비율

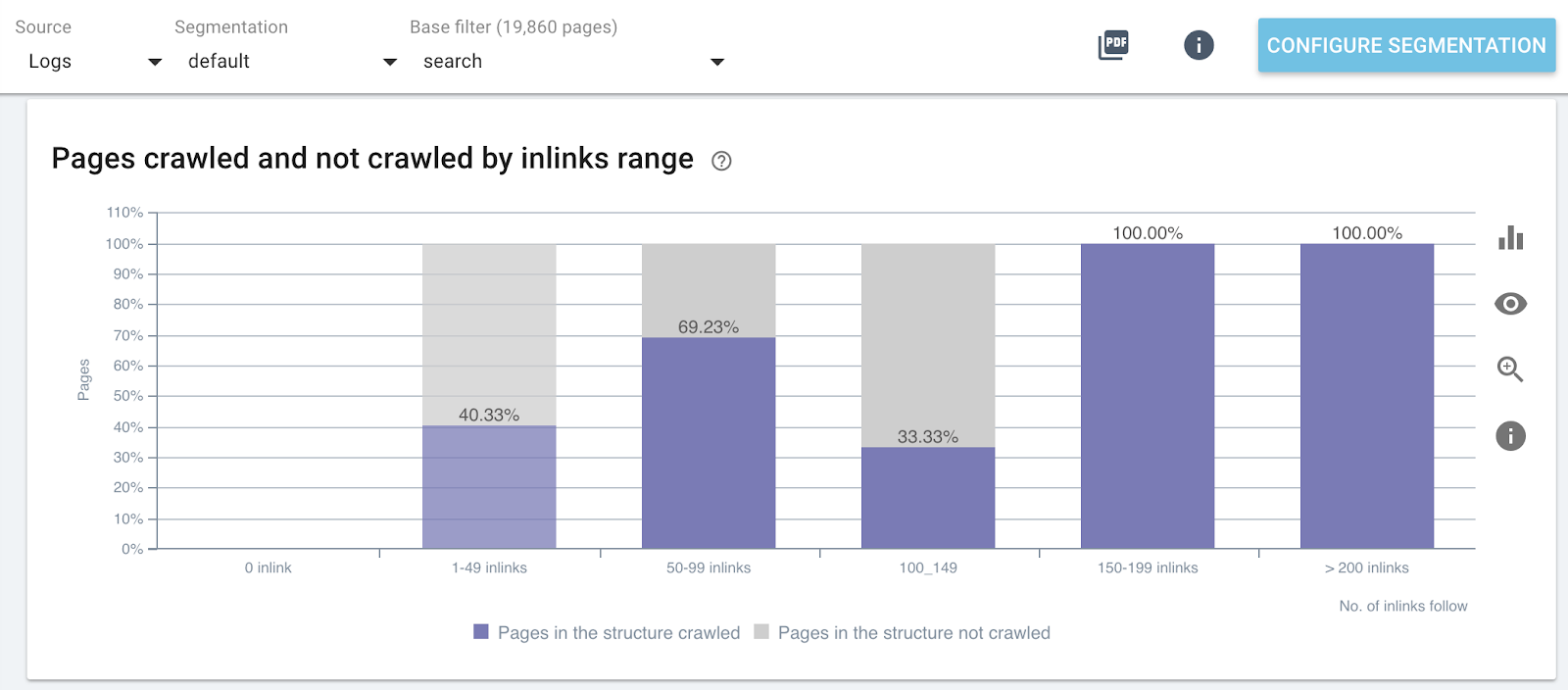

웹사이트의 특정 부분에 대한 인링크 수에 따른 크롤링 비율(검색 페이지)

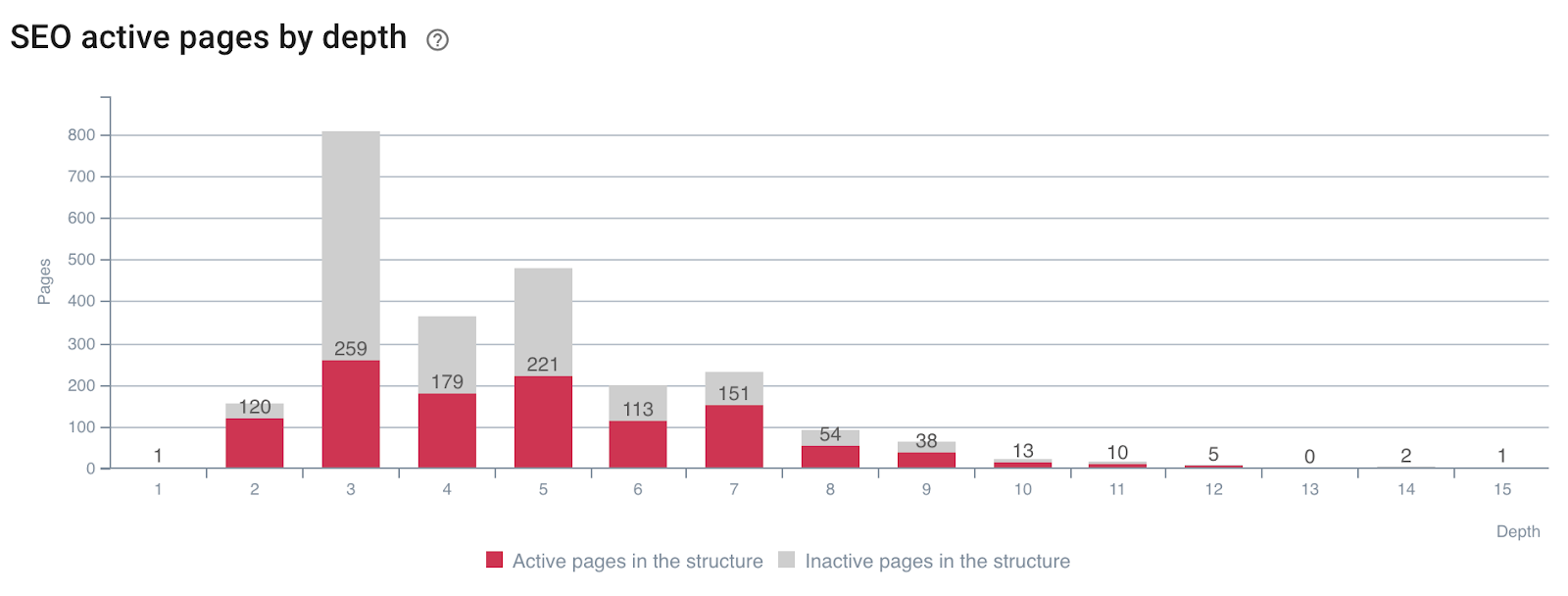

페이지의 활성도에 대한 깊이의 영향

깊이에 따라 SEO 방문을 생성하는 페이지(또는 생성하지 않는 페이지)

크롤링 및 교차 로그 데이터 중에 올바른 사이트 메트릭을 사용하면 Google의 크롤링을 조작하고 SEO 방문을 개선하는 데 필요한 SEO 최적화를 즉시 감지할 수 있음을 알 수 있습니다.

5# SEO 순위 요소가 크롤링 빈도에 미치는 영향 결정

SEO를 극대화하기 위해 어떤 값을 타겟팅해야 하는지 알 수 있다고 상상해 보십시오. 이것이 바로 교차 데이터 분석이 만들어진 이유입니다! 이를 통해 임계 크롤링 빈도, 크롤링 속도 또는 활성이 최대화되는 각 메트릭에 대해 정확하게 결정할 수 있습니다.

페이지당 단어 수와 크롤링 빈도에 대한 예에서 위에서 크롤링 빈도 트리거 값이 있음을 보았습니다. 이러한 격차는 봇 행동 또는 SEO 방문의 급증을 찾고 있기 때문에 각 페이지 유형에 대해 분석하고 비교해야 합니다.

아래에 제시된 것과 같이:

크롤링 빈도에 100개 이상의 인링크에 간격이 있습니다.

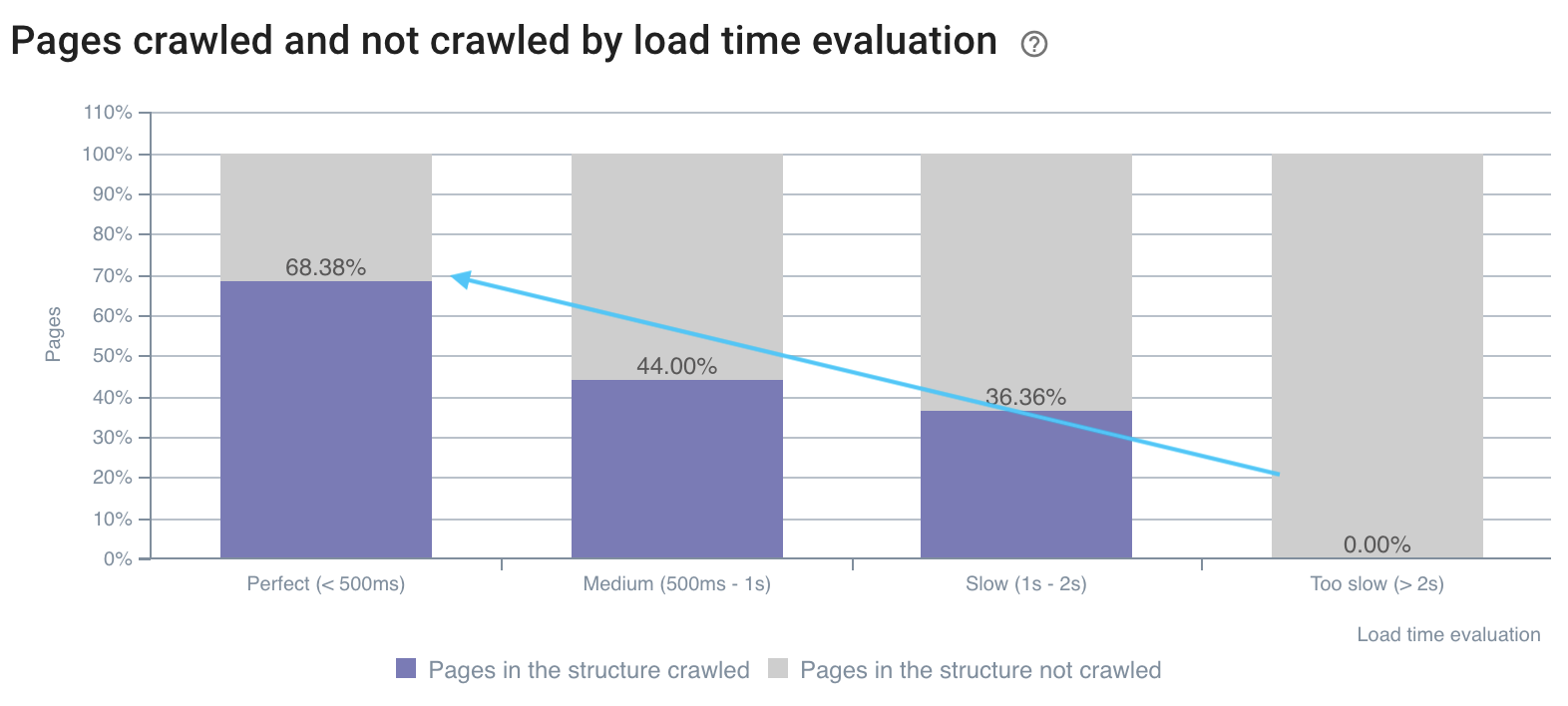

크롤링 속도는 빠른 페이지에서 더 좋습니다.

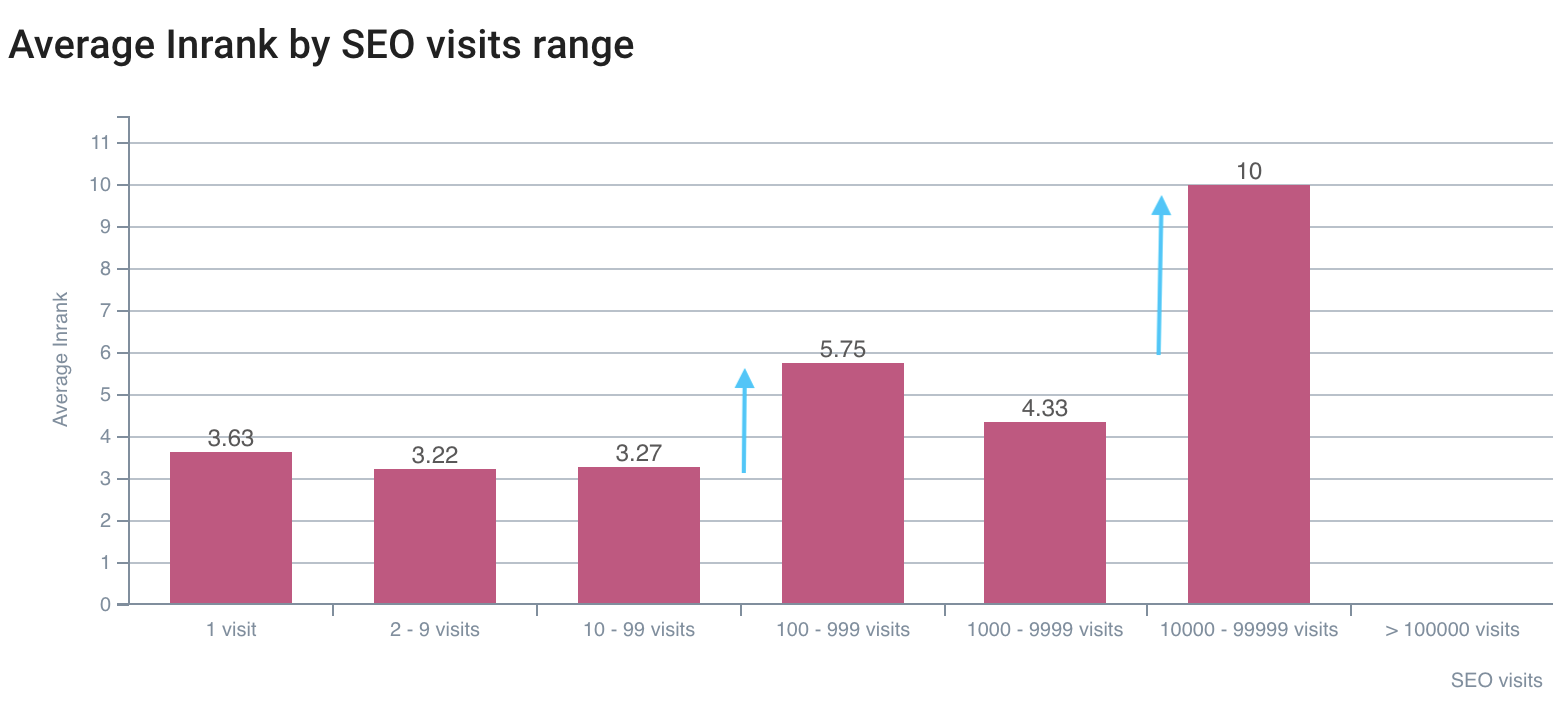

SEO 방문의 첫 번째 격차는 InRank 5,75에 있고 최고는 InRank 10(홈페이지)에 있습니다.

크롤링 및 로그 데이터를 결합하면 Google 블랙박스를 열고 측정항목이 봇 크롤링 및 방문에 미치는 영향을 정확하게 결정할 수 있습니다. 이러한 분석에 대한 최적화를 구현할 때 각 릴리스 시점에 SEO를 개선할 수 있습니다. 이 고급 사용은 각 교차 데이터 분석에서 도달할 새로운 값을 감지할 수 있기 때문에 시간이 지남에 따라 지속됩니다.

공유하고 싶은 교차 데이터 분석에 대한 다른 트릭이 있습니까?