検索コンソールカバレッジレポートを理解する

公開: 2019-08-15カバレッジレポートの概要とデータの解釈方法

Search Console Coverage Reportは、サイトのどのページがインデックスに登録されているかに関する情報を提供し、Googlebotがクロールしてインデックスに登録しようとしているときに問題が発生したURLを一覧表示します。

カバレッジレポートのメインページには、ステータス別にグループ化されたサイトのURLが表示されます。

- エラー:ページはインデックスに登録されていません。 これにはいくつかの理由があります。特に、404ページで応答するページ、ソフト404ページなどです。

- 警告付きで有効:ページはインデックスに登録されていますが、問題があります。

- 有効:ページにインデックスが付けられます。

- 除外:ページはインデックスに登録されていません。Googleは、robots.txtのnoindexタグやメタタグ、正規タグなど、ページがインデックスに登録されないようにするサイトのルールに従っています。

このカバレッジレポートは、古いグーグル検索コンソールよりもはるかに多くの情報を提供します。 Googleは共有するデータを本当に改善しましたが、まだ改善が必要なことがいくつかあります。

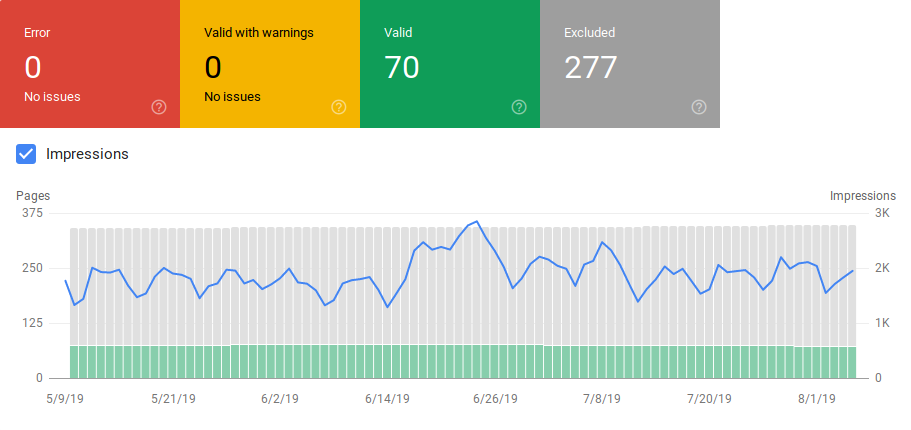

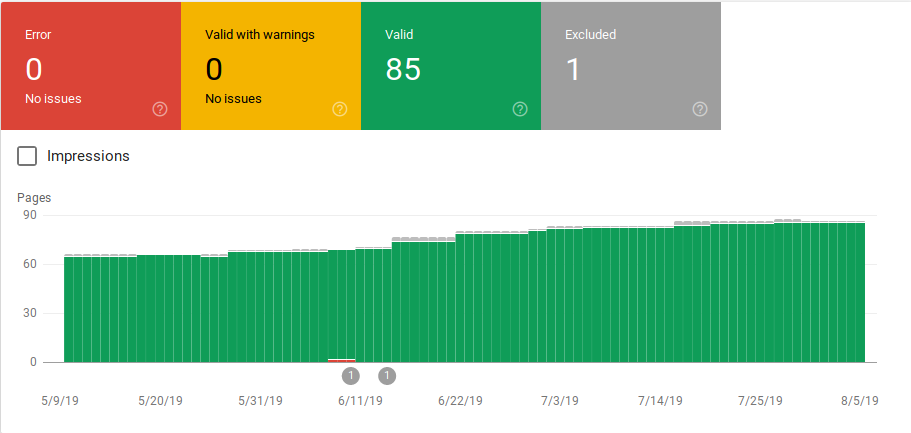

以下に示すように、Googleは各カテゴリのURLの数を示すグラフを表示します。 エラーが突然増加した場合は、バーを確認し、それをインプレッションと関連付けて、エラーまたは警告のあるURLの増加がインプレッションを減らすことができるかどうかを判断することもできます。

サイトを立ち上げた後、または新しいセクションを作成した後、有効なインデックス付きページの数を増やしたいと考えています。 Googleが新しいページをインデックスに登録するのに数日かかりますが、URL検査ツールを使用してインデックス作成をリクエストし、Googleが新しいページを見つける時間を短縮できます。

ただし、有効なURLの数が減少している場合や突然の急増が見られる場合は、[エラー]セクションでURLを特定し、レポートに記載されている問題を修正することが重要です。 Googleは、エラーや警告が増加した場合に実行するアクションアイテムの概要を提供します。

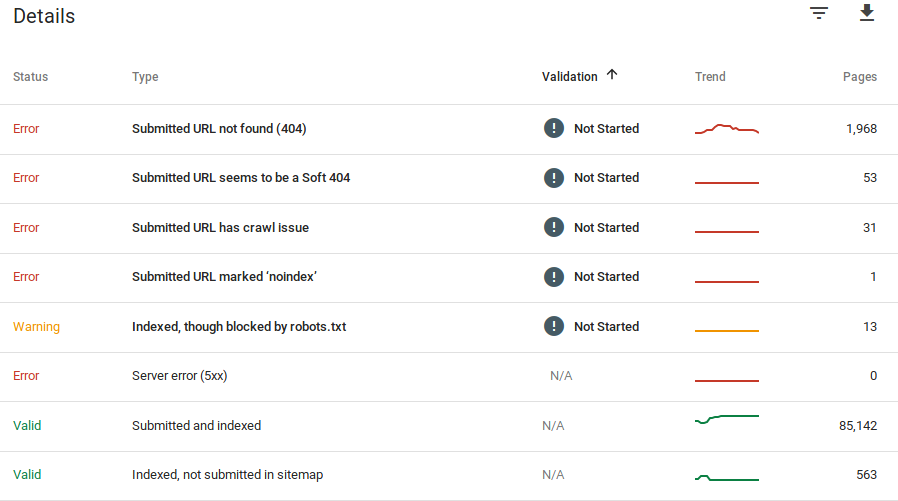

Googleは、エラーとは何か、およびその問題を抱えているURLの数に関する情報を提供します。

Google検索コンソールには100%正確な情報が表示されないことに注意してください。 実際、バグやデータの異常についてはいくつかの報告があります。 さらに、Google検索コンソールの更新には時間がかかります。データが16日から20日遅れていることが知られています。 また、上の画像にあるように、レポートには1000ページを超えるエラーまたは警告カテゴリが表示されることがありますが、監査と確認のために1000のURLのサンプルを表示およびダウンロードすることしかできません。

それでも、これはサイトのインデックス作成の問題を見つけるための優れたツールです。

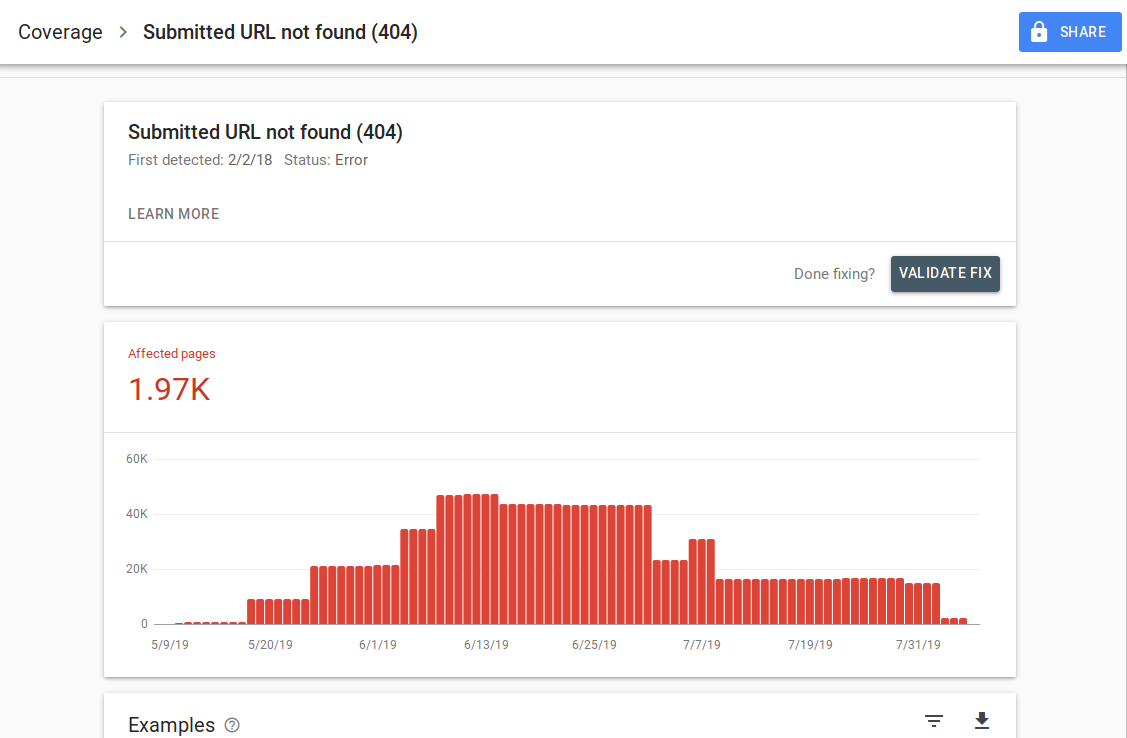

特定のエラーをクリックすると、URLの例を一覧表示する詳細ページが表示されます。

上の画像でわかるように、これは404で応答するすべてのURLの詳細ページです。各レポートには、その特定のエラーの詳細を提供するGoogleドキュメントページに移動する「詳細」リンクがあります。 グーグルはまた、時間の経過とともに影響を受けたページの数を示すグラフを提供します。

各URLをクリックして、古いGoogle検索コンソールの古い「Googlebotとしてフェッチ」機能に似たURLを調べることができます。 ページがrobots.txtによってブロックされているかどうかをテストすることもできます

URLを修正したら、レポートからエラーが消えるように、URLの検証をGoogleにリクエストできます。 検証状態が「失敗」または「開始されていない」問題の修正を優先する必要があります。

サイト上のすべてのURLがインデックスに登録されることを期待するべきではないことに注意することが重要です。 Googleは、ウェブマスターの目標は、すべての正規URLをインデックスに登録することであると述べています。 重複ページまたは代替ページは、正規ページと同様のコンテンツを持っているため、除外として分類されます。

サイトでは、除外されたカテゴリに複数のページが含まれているのが普通です。 ほとんどのウェブサイトには、インデックスメタタグがないか、robots.txtによってブロックされているページがいくつかあります。 Googleが重複ページまたは代替ページを識別した場合、それらのページに正しいURLを指す正規タグが付いていることを確認し、有効なカテゴリで正規の同等物を見つけてください。

Googleには、レポートの左上にドロップダウンフィルタが含まれているため、特定のサイトマップ内のすべての既知のページ、送信されたすべてのページ、またはURLに対してレポートをフィルタリングできます。 デフォルトのレポートには、Googleによって検出されたすべてのURLを含むすべての既知のページが含まれます。 送信されたすべてのページには、サイトマップを通じて報告したすべてのURLが含まれます。 複数のサイトマップを送信した場合は、各サイトマップのURLでフィルタリングできます。

[ケーススタディ]戦略ページのクロール予算を増やす

エラー、警告、有効なURLと除外されたURL

エラー

- サーバーエラー(5xx): Googlebotがページをクロールしようとしたときに、サーバーが500エラーを返しました。

- リダイレクトエラー: GooglebotがURLをクロールしたときに、チェーンが長すぎるか、リダイレクトループがあったか、URLが最大URL長を超えたか、リダイレクトチェーンに不正なURLまたは空のURLがあったためにリダイレクトエラーが発生しました。

- 送信されたURLがrobots.txtによってブロックされています:このリストのURLは、robts.txtファイルによってブロックされています。

- 「noindex」とマークされた送信済みURL:このリストのURLには、メタロボットの「noindex」タグまたはhttpヘッダーがあります。

- 送信されたURLはソフト404のようです:存在しない(削除またはリダイレクトされた)ページがユーザーに「ページが見つかりません」というメッセージを表示したが、HTTP404ステータスコードを返さなかった場合にソフト404エラーが発生します。 ソフト404は、ページが関連性のないページにリダイレクトされた場合にも発生します。たとえば、404ステータスコードを返したり、関連性のあるページにリダイレクトしたりする代わりに、ホームページにリダイレクトしたりします。

- 送信されたURLが不正なリクエストを返します(401):インデックス作成のために送信されたページが401の不正なHTTP応答を返しています。

- 送信されたURLが見つかりません(404): Googlebotがページをクロールしようとしたときに、ページが404NotFoundエラーで応答しました。

- 送信されたURLにクロールの問題があります:他のどのカテゴリにも該当しないこれらのページをクロールしているときに、Googlebotでクロールエラーが発生しました。 各URLを確認し、問題が何であったかを判断する必要があります。

警告

- インデックスに登録されていますが、robots.txtによってブロックされています: Googlebotがページを指す外部リンクを介してアクセスしたため、ページはインデックスに登録されましたが、ページはrobots.txtによってブロックされています。 Googleは、これらのURLを警告としてマークします。これは、ページが検索結果に表示されないように実際にブロックする必要があるかどうかがわからないためです。 ページをブロックする場合は、「noindex」メタタグを使用するか、noindexHTTP応答ヘッダーを使用する必要があります。

Googleが正しく、URLが誤ってブロックされた場合は、robots.txtファイルを更新して、Googleがページをクロールできるようにする必要があります。

有効

- 送信およびインデックス作成:インデックス作成のためにsitemap.xmlを介してGoogleに送信し、インデックスに登録されたURL。

- インデックスに登録され、サイトマップに送信されていません: URLはGoogleによって検出され、インデックスに登録されましたが、サイトマップに含まれていませんでした。 サイトマップを更新し、Googleがクロールしてインデックスに登録するすべてのページを含めることをお勧めします。

除外

- 'noindex'タグで除外: Googleがページのインデックスを作成しようとすると、'noindex'メタロボットタグまたはHTTPヘッダーが見つかりました。

- ページ削除ツールによってブロックされました:誰かがGoogle検索コンソールのURL削除リクエストを使用して、このページをインデックスに登録しないようにGoogleにリクエストを送信しました。 このページのインデックスを作成する場合は、Googleの検索コンソールにログインして、削除されたページのリストからページを削除します。

- robots.txtによってブロックされました: robots.txtファイルには、クロールからURLを除外する行があります。 robots.txtテスターを使用して、これを実行している行を確認できます。

- 不正なリクエストによりブロックされました(401):エラーカテゴリと同じように、ここのページは401HTTPヘッダーで返されます。

- クロールの異常:これは一種のキャッチオールカテゴリです。ここでのURLは、4xxレベルまたは5xxレベルの応答コードで応答します。 これらの応答コードは、ページの索引付けを防ぎます。

- クロール–現在インデックスに登録されていません: Googleは、URLがインデックスに登録されなかった理由を提供していません。 彼らは、索引付けのためにURLを再送信することを提案しています。 ただし、ページにコンテンツが薄いか重複しているかどうか、別のページに正規化されているか、noindexディレクティブがあるか、指標がユーザーエクスペリエンスの低下、ページの読み込み時間が長いかなどを確認することが重要です。Googleにはいくつかの理由が考えられます。ページにインデックスを付けたくない。

- 検出済み–現在インデックスに登録されていません:ページは見つかりましたが、Googleはそのページをインデックスに含めていません。 上記のようにプロセスをスピードアップするために、インデックス作成用のURLを送信できます。 グーグルは、これが起こる典型的な理由は、サイトが過負荷になり、グーグルがクロールを再スケジュールしたことであると述べています。

- 適切な正規タグを持つ代替ページ:別のURLを指す正規タグがあるため、Googleはこのページのインデックスを作成しませんでした。 Googleは正規のルールに従い、正規のURLを正しくインデックスに登録しました。 このページがインデックスに登録されないようにする場合は、ここで修正する必要はありません。

- ユーザーが選択した正規のタグなしで重複: Googleは、このカテゴリにリストされているページの重複を検出しましたが、正規のタグを使用しているものはありません。 Googleは、正規タグとして別のバージョンを選択しました。 これらのページを確認し、正しいURLを指す正規タグを追加する必要があります。

- 重複して、Googleはユーザーとは異なる正規を選択しました。これらのカテゴリのURLは、明示的なクロールリクエストなしでGoogleによって検出されました。 グーグルは外部リンクを通してこれらを見つけ、より良い標準を作る別のページがあると判断しました。 このため、Googleはこれらのページのインデックスを作成していません。 これらのURLを正規の複製としてマークすることをお勧めします。

- 見つかりません(404): Googlebotがこれらのページにアクセスしようとすると、404エラーで応答します。 Googleは、これらのURLは送信されておらず、これらのURLはこれらのURLを指す外部リンクから検出されたと述べています。 これらのURLを同様のページにリダイレクトして、リンクエクイティを活用し、ユーザーが関連するページにアクセスできるようにすることをお勧めします。

- 法的な申し立てによりページが削除されました:著作権侵害などの法的な問題により、誰かがこれらのページについて苦情を申し立てています。 提出された法的苦情はここで上訴できます。

- リダイレクトのあるページ:これらのURLはリダイレクトされているため、除外されます。

- ソフト404:上記で説明したように、これらのURLは404で応答する必要があるため、除外されます。ページをチェックして、404HTTPヘッダーで応答するための「notfound」メッセージがあることを確認してください。

- 重複して送信されたURLが正規として選択されていない: 「Googleがユーザーとは異なる正規を選択した」と同様ですが、このカテゴリのURLはあなたによって送信されました。 サイトマップをチェックして、重複するページが含まれていないことを確認することをお勧めします。

サイトを改善するためのデータとアクションアイテムの使用方法

代理店で働いている私は、さまざまなサイトとそのカバレッジレポートにアクセスできます。 私は、Googleがさまざまなカテゴリで報告するエラーの分析に時間を費やしました。

正規化と重複コンテンツの問題を見つけることは役に立ちましたが、@jroakesによって報告されたような矛盾に遭遇することがあります。

Google検索コンソール>URL検査>ライブテストは、クロールが許可されているため、すべてのJSファイルとCSSファイルを誤って報告しているようです:いいえ:robots.txtによってブロックされています。 3つのドメインで約20個のファイルをテストします。 pic.twitter.com/fM3WAcvK8q

— JR%20Oakes ???? (@jroakes)2019年7月16日

AJ Kohは、新しいGoogle検索コンソールが利用可能になった直後にすばらしい記事を書きました。データの真の価値はそれを使用してサイトの各タイプのコンテンツの健康状態を描くことであると説明しています。

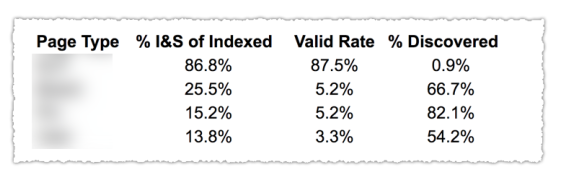

上の画像でわかるように、カバレッジレポートのさまざまなカテゴリのURLは、ブログ、サービスページなどのページテンプレートによって分類されています。さまざまなタイプのURLに複数のサイトマップを使用すると、Googleで許可されているため、このタスクに役立ちます。サイトマップでカバレッジ情報をフィルタリングします。 次に、次の情報を含む3つの列を含めました。インデックス付きページと送信済みページの割合、有効率、および検出された割合。

この表は、サイトの状態の概要を示しています。 さて、さまざまなセクションを掘り下げたい場合は、レポートを確認し、Googleが提示するエラーを再確認することをお勧めします。

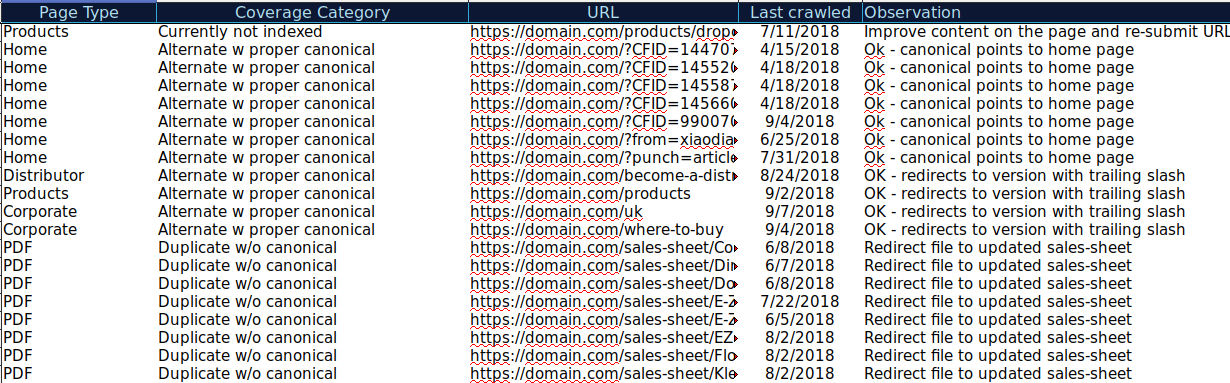

さまざまなカテゴリで表示されるすべてのURLをダウンロードし、OnCrawlを使用してHTTPステータス、正規タグなどを確認し、次のようなスプレッドシートを作成できます。

このようにデータを整理すると、問題を追跡したり、改善または修正が必要なURLのアクションアイテムを追加したりするのに役立ちます。 また、正しい正規タグが実装されたパラメータを持つURLの場合は、正しいURLをチェックでき、アクションアイテムは必要ありません。

14日間の無料トライアルを開始する

onCrawlと統合されたahrefs、Majestic、Google Analyticsなどの他のソースから、このスプレッドシートにさらに情報を追加することもできます。 これにより、Google検索コンソールの各URLのリンクデータとトラフィックおよびコンバージョンデータを抽出できます。 このデータはすべて、各ページの処理方法をより適切に決定するのに役立ちます。たとえば、404のページのリストがある場合は、これをバックリンクと結び付けて、にリンクしているドメインからリンクの公平性を失っているかどうかを判断できます。あなたのサイトの壊れたページ。 または、インデックスに登録されたページと、それらが取得しているオーガニックトラフィックの量を確認できます。 オーガニックトラフィックを取得していないインデックス付きページを特定し、それらの最適化(コンテンツと使いやすさの向上)に取り組んで、そのページへのトラフィックを増やすことができます。

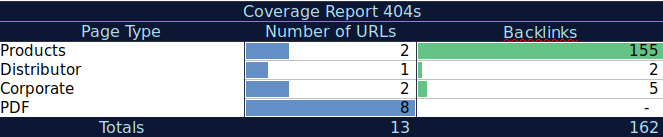

この追加データを使用して、別のスプレッドシートに要約テーブルを作成できます。 式=COUNTIF(range、criteria)を使用して、各ページタイプのURLをカウントできます(このテーブルは、AJ Kohnが上記で提案したテーブルを補完することができます)。 別の数式を使用して、URLごとに抽出したバックリンク、訪問、またはコンバージョンを追加し、次の数式= SUMIF(range、criteria、[sum_range])を使用してサマリーテーブルに表示することもできます。 あなたはこのようなものを得るでしょう:

データの要約ビューを提供し、最初に修正に集中する必要のあるセクションを特定するのに役立つ要約テーブルを操作するのが本当に好きです。

最終的な考え

問題の修正に取り組み、このレポートのデータを確認する際に考慮する必要があるのは、次のとおりです。私のサイトはクロール用に最適化されていますか? インデックスに登録された有効なページは増加していますか、それとも減少していますか? エラーのあるページは増加していますか、それとも減少していますか? Googleがユーザーにより多くの価値をもたらすURLに時間を費やすことを許可していますか、それとも価値のないページをたくさん見つけていますか? これらの質問への回答があれば、サイトの改善を開始して、Googlebotが価値のないページではなく、ユーザーに価値を提供できるページにクロール予算を費やすことができるようになります。 robots.txtを使用してクロールの効率を向上させたり、可能であれば価値のないURLを削除したり、canonicalタグやnoindexタグを使用してコンテンツの重複を防ぐことができます。

Googleは、Google検索コンソールのさまざまなレポートに機能を追加し、データの精度を更新し続けているため、Google検索コンソールの他のレポートだけでなく、カバレッジレポートの各カテゴリのデータも引き続き表示されることを願っています。