A/Bテストの結果から学習および改善するための7つの重要なステップ

公開: 2021-04-13

A / Bテストが終了したばかりですが、期待した結果が得られていません。

他のすべての人がケーススタディを共有しています。ボタンの色を変更したり、微調整したりするだけで大きな伸びが見られましたが、テストでコンバージョンが改善されなかった、またはさらに悪いことに、代わりにお金がなくなったようです。これを上司に提示します。

さて、あなたのテストが実際に敗者ではない場合はどうなりますか?

それが変装した勝者である場合はどうなりますか?

そして、それが敗者である場合、敗北テストが実際に良いことである場合はどうなりますか?

このガイドでは、A / Bテストの結果をより深く理解し、分析して分析し、ゴールドを見つけることができるように支援します。

A / Bテストから学ぶことが非常に重要である理由と、敗者が売り上げを得ることができる理由について説明します。 私たちはあなたが従うことができるプロセスを共有しているので、あなたはあなたのテストを段階的に完全に分析し、あなたが見ているもの、勝つか失敗するかについて自信を持って感じることができます。

さらに良いことに、私たちはあなたが不安であなたの分析をチェックしたくないデータから、あなたの結果をあなたの仲間と共有することに自信を持つことへとあなたを助けるでしょう。

では、飛び込みましょう…

なぜA/Bテストから学ぶ必要があるのですか?

まず、明らかなコストがかかります。 各テストの設定には費用がかかります。 バリアントを失った場合は、そのバリアントの売上も減少します。

ただし、これが問題です。

A / Bテスト(および一般的なCRO)は、より多くのお金を稼ぐことだけではありません。 データの購入についてです。 オーディエンスに関するデータは、オーディエンスをよりよく理解し、より良い製品とサービスを提供するのに役立ちます。 これにより、売り上げの増加と顧客体験の向上、さらには新製品の提供に関する洞察さえも得られます。

奉仕する人々について学べば学ぶほど、上手になります。 そのため、テストの大部分が失敗した場合でも、頻繁にテストしてテストすることが非常に重要です。

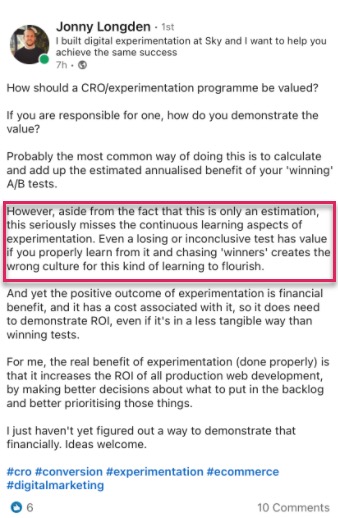

この考え方も私たちだけではありません。

実際、ツールを使用して28,304のテストの内部データを確認し、専門のテストエージェンシーとの会話を行ったところ、ほとんどの企業は10のテストごとに1つの勝者しか見つけられませんでしたが、エージェンシーは通常、すべてのテストのうち1つの勝者を見つけます。 4.4。

そして、私はあなたが何を考えているか知っています、

確かにそれは私が各テストで90%の時間お金を失っていることを意味しますか?

はい。ただし、テスト対象者の半分にすぎません。 残りの半分はまだあなたのサイトを見て、いつものように変換しています。

また、取得したデータは、機能しないものを見つけるのに役立つため、機能するものを学ぶことができます。 あなたはテストし、学び、もう一度テストし、そして何がうまくいくかが見つかるまで続けます。

そして、それらの10%のテストは勝ちますか?

それらは、より大きな影響を与えるためにすべての同様のページでサイト全体にスケールアウトされる前に、何度も改善できる継続的な増分リフトを提供できます。

これが、デジタルプラットフォームでのコンバージョン数の増加を目の当たりにすることの美しさです。 わずか1%のリフトという規模は、現在および将来のすべてのトラフィックの両方で、ビジネスに大きな影響を与える可能性があります。 実際、Jeff Bezosは同じ考えに沿って考えており、Amazonとテストと改善の目標を、年次株主報告の中で「世界で失敗するのに最適な場所」と呼んでいます。

100倍のペイオフの10%の確率を考えると、毎回その賭けをする必要があります。 しかし、あなたはまだ10回のうち9回間違っているでしょう。

ジェフ・ベゾス、アマゾン

ただし、A / Bテストのメリットは、売り上げの増加と洞察の向上だけではありません。

テストを実行すると、障害となるトピックや群論から離れることができます。 Webデザインの変更の可能性について何ヶ月も話し合って何もしない代わりに、それに対して行動を起こしてテストし、チームが他のことに集中できるようにします。 (ライブでプッシュする前に、必ずその効果をテストしてください!)

それだけでなく、A/Bテストだけが教えてくれるオーディエンスについての新しいことを学ぶことができます。

理論の作成と顧客調査は素晴らしいですが、彼らが言うことだけでなく、それはあなたの聴衆があなたのサイトで実際に行うことです。 テストを理解することは、それらのアイデアやフィードバックを証明または反証するのに役立ちます。

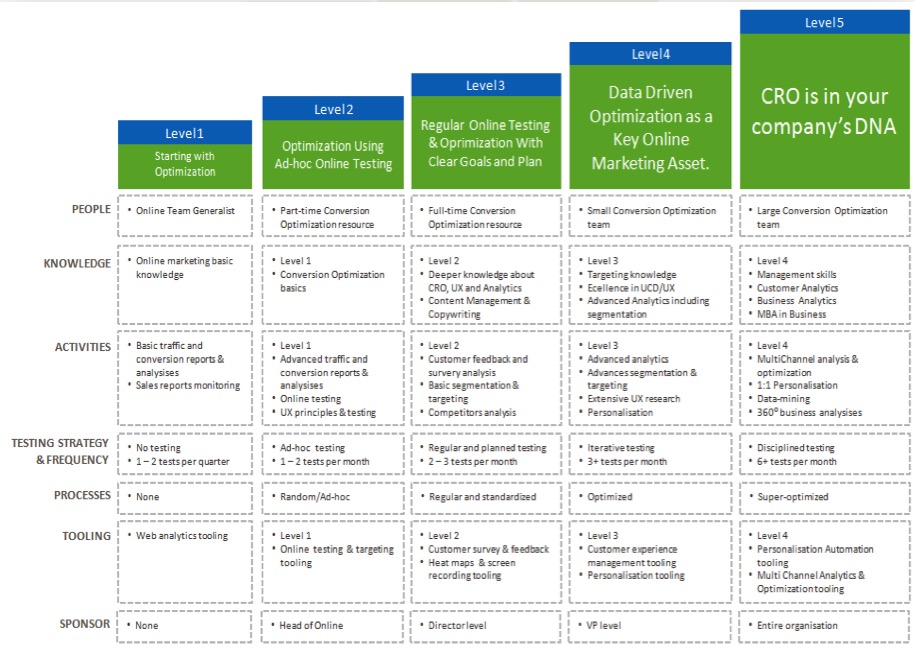

結果を理解すればするほど、テストに自信が持てるようになり、CROの取り組みを「成熟」させてテストをより頻繁に実行できるようになり、社内でテストチームを構築し始めることもできます。

各A/Bテストから学習することの利点がわかったので、実行する新しい各テストを分析するための簡単なプロセスを見ていきましょう…

A / Bテストから学ぶための7ステップのプロセス(将来のテストを改善するために使用できるシステムとともに)

これを7つの重要なステップに分けました。

ここで推奨するすべての方法やツールがあるとは限りませんが、それらがどのように適合するかを確認することで、それらの値を測定し、将来のテストに統合するかどうかを決定できます。

ステップ1:データが正確で有効かつ重要であることを確認する

これは、このプロセス全体の中で最も重要な部分です。 結果に自信を持てるように、テストに関する情報が正確かつ有効であることを確認してください。

では、テスト結果が信頼できるデータを提供していることをどのように確認しますか?

さて、あなたができることがいくつかあります…

ツールの精度を確認する

今、ほとんどの人はこれを見逃しています。 サイトの訪問者が月に10,000人を超えない場合は、スキップしてかまいません。 技術的には、CROを使い始める必要はなく、トラフィック量の多いサイトで最適に機能しますが、大規模なサイトでは実際に違いがわかるため、ここに含めないでください。

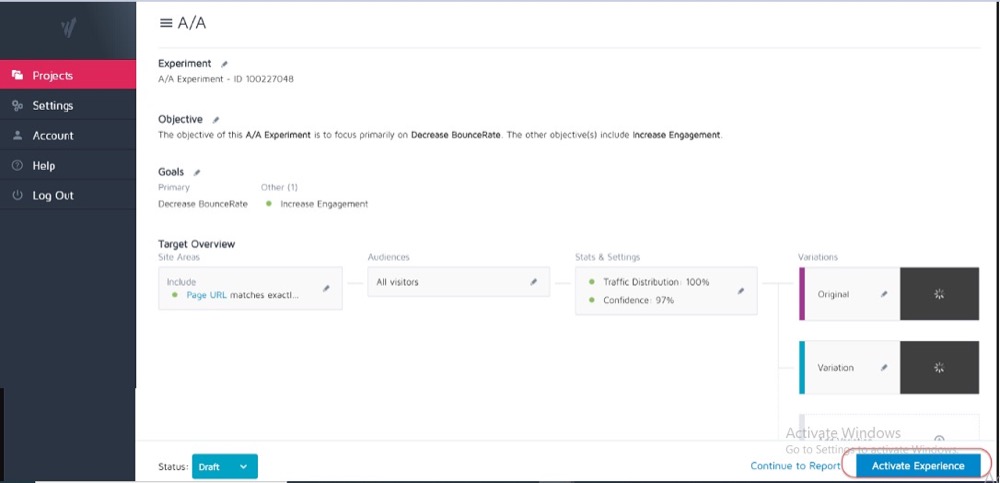

理想的には、現在のテストツールでA / Aテストをすでに実行して、それがどれほど正確で、問題があるかどうかを確認していることをお勧めします。

どのように?

Webページの2つの同一のコピーを使用して単純な分割テストを実行し、それらの2つの同一のページにわたって結果を追跡します。

それらの間に違いはないので、結果は各ページで同じである必要があります。 ただし、ツールと、ツールがデータを測定または追跡する方法によって、いくつかの不一致が生じる場合があります。

これを事前に知っておくと、テスト結果の精度の許容範囲を取得し、将来のすべてのテストのガイドラインとして使用するのに役立ちます。

例

A / Aテストで2つの同じページ間でコンバージョン率に0.5%の違いがあることに気付いた場合は、コントロールとバリアントの間に0.5%の違いがあるだけで、勝者を示すテスト結果に注意する必要があります。

結果を信じる前に、テストで1%以上の上昇を示さなければならないという内部ガイドラインを設定できます。 繰り返しになりますが、新しいツールを試しているとき、または現在のツールにレポートの問題があるか、正しく設定されていない可能性があると思われる場合は、A/Aテストを1回だけ実行する必要があります。

A / Aテストは、正確にチェックするために必要なサンプルデータが非常に大きくなる可能性があるため、大規模なトラフィックサイトで最適に機能しますが、1%のエラーの差は非常に大きくなる可能性があります。

顧客がサイトとどのように相互作用するかについての有効なビューを取得するのに十分な時間、テストを実行します

ツールを信頼できるようになったので、以前に統計的にツールを停止できる十分な変換が得られたとしても、2〜4週間テストを実行する必要があります。

なんで?

なぜなら、オーディエンスは、曜日や月の特定の段階に応じて、サイトとのやり取りが異なることがよくあるからです。

例

あなたの聴衆の人々が木曜日に給料をもらった場合、あなたのテストが月曜日から水曜日までしか実行されなかった場合、あなたは見逃すかもしれない上昇を見るでしょう?

同様に、他のユーザーは隔週または毎月の支払いを受ける可能性があり、テストがテストに含まれるのに十分な時間実行されなかった場合は、結果が歪んでしまいます。 あなたは単にあなたが逃した時間のために低い売上高またはトラフィックを仮定するでしょう。

テストをいつ終了するかをどうやって知るのですか? A / Bテストの統計的有意性についてもっと読む:テストを終了する方法と時期

結果に影響を与える可能性のある内部または外部の要因に注意してください

これらは、データを歪める可能性のある一意のイベントまたはスケジュールされたイベントです。

たとえば、CEOや会社がニュースになっている場合や、現在のマーケティングキャンペーンやプロモーションを実行している場合、および祝日やランダムなトラフィックの急増などの外部要因がある場合です。

これらすべてがサイトのトラフィックに影響を及ぼし、その期間中の結果の正確さを変える可能性があります。

実話:

6年ほど前、私はサーフウェア会社を経営していました。

ある日、トラフィックはどこからともなく約800%急増し、バウンス率は急上昇しました。 新しいマーケティングキャンペーンを実行していなかったので、トラフィックがどこから来たのかを調べるために少し調査しました。

私たちのTシャツの1つは、韓国のポップバンドの新曲と同じ名前の製品名であることがわかり、2日間、ランク付けして訪問者を獲得しました。

もちろん、この新しいオーディエンスは私たちの製品にまったく興味がなく、すぐに去りました。

クレイジーだよね?

別の時、私のマーケティングブログはテレビ会社のブランド名のランキングを始めました、そして同じことが起こりました。 間違ったオーディエンスからのトラフィックが急増しました。

これはランダムですが、このようなことが起こる可能性があるため、このような外部または内部のイベントに注意してください。 いつでも分析をチェックしてトラフィックがどこから来たのかを確認し、すべてが正常に戻ったらテストを再開できます。

十分なデータを確実に取得する

テストのパフォーマンスを有効に把握するために、テストに十分な変換があることを確認する必要があります。

合計コンバージョン数がわずか50のコントロールとバリアントがあり、それらの間のわずかな違いだけでは、テスト結果が統計的に有意であったとしても、オーディエンスを洞察するのに十分ではありません。 ほとんどの専門家は、バリアントごとに約300以上の変換が通常は経験則として適切であることに同意しています(後でセグメント化する場合はさらに多くの変換が必要です)。

データセットが大きいほど、テスト後の分析で洞察を見つけやすくなります。

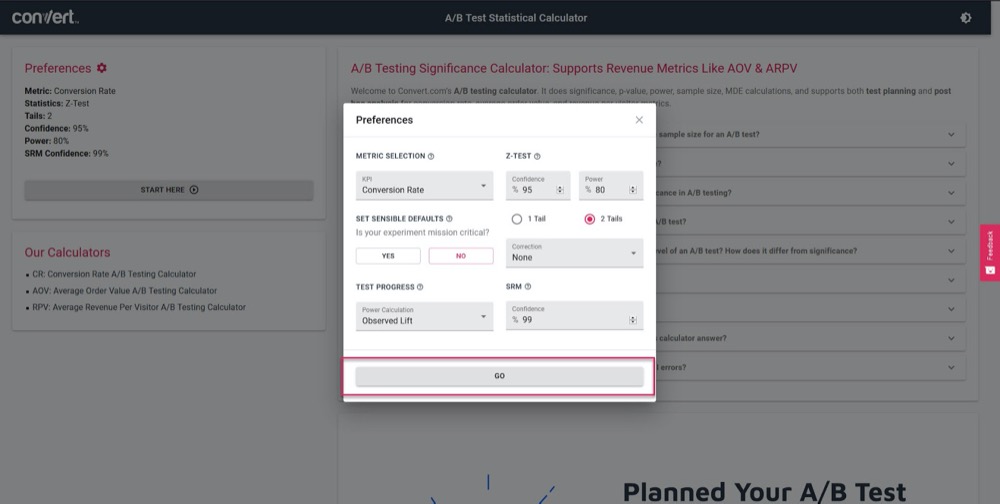

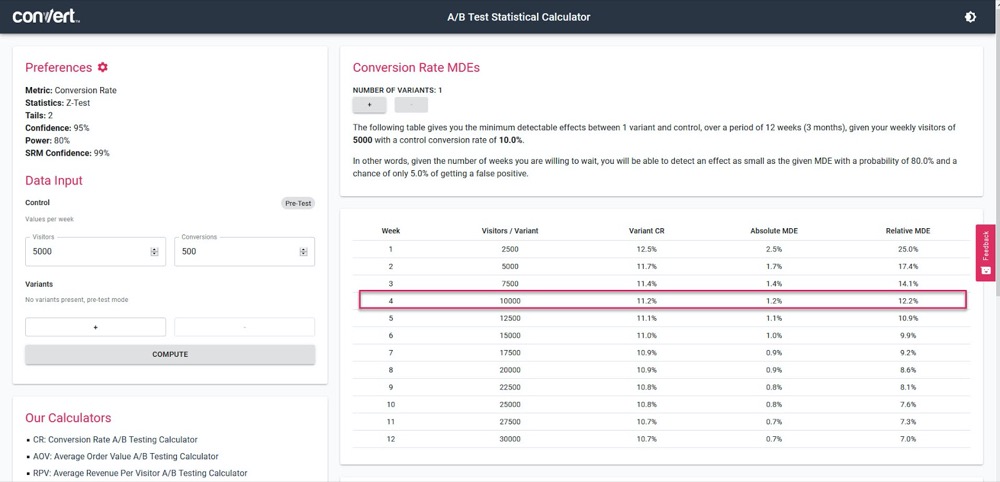

A / Bテストの有意性計算ツールを使用して、4週間の販売サイクルと現在の「コントロール」ページの情報に基づいて、テストがどの程度正確になるかを把握します。

テストパラメータを設定するだけです。

次に、現在のページのコンバージョン数とともに、テストで1週間に取得するトラフィックの量を入力し、テストで計算できる精度とリフト率を確認します。

上記の例では、4週間後にわずか1.2%のリフトを測定できます。 (より高い精度が必要な場合は、テストを長時間実行するか、テストのトラフィック量を増やしてください。)

統計的に有意な結果を得る

これが、統計的有意性が重要であるが、テスト時に最も重要な要素ではない理由です。

はい、結果に95〜99%の信頼度が表示されるようにテストを十分に長く実行する必要がありますが、上記で説明した他のすべての要素がヒットすることも確認する必要があります。

なんで?

A / Aテストでさえ、十分に長く実行されていない場合、1つのバージョンが同一のコピーよりも優れているという95%の信頼性を示すことができます。

(あるバージョンではすべてのコンバージョンがランダムに表示され、他のバージョンでは表示されない可能性があります。)

キャンペーンが「statsig」に達すると、新しいテスターが多すぎるとキャンペーンが停止し、誤ったデータが取得されます。 そのため、95%以上の統計的有意性を取得することをお勧めしますが、300以上のコンバージョンと十分なサンプルサイズを使用して、2〜4回の販売サイクルでテストを実行することもお勧めします。

これらすべてを行うと、テストによって有効で正確な結果が得られると確信できます。

これらの基準を満たすためにテストを実行することがどれほど重要であるかについては、十分に強調することはできません。

テストの呼び出しが早すぎると、次のいずれかにつながる可能性のある誤った情報が得られる可能性があります。

- あなたが十分な情報を持っていないので、潜在的な勝者を見つけられません、

- パフォーマンスの低いキャンペーンを実行するのは、それらが勝者であると思うが、実際にはコンバージョン率が低いためです。

- さらに悪いことに、これらの結果に誤った信頼を置き、学んだことを使用してサイトの他の部分にスケールアウトし、これらの悪影響を増大させる可能性があります。

A / Bテストツールがバリアントの獲得について結論を出す方法を知っていますか? A / Bテストの有意性計算ツールを使用するには、ここをクリックしてください。

サイドノート:

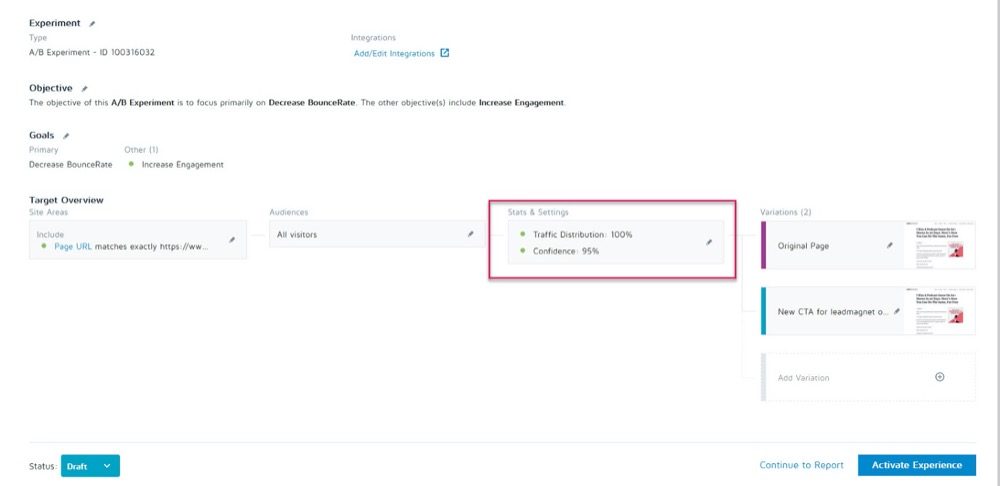

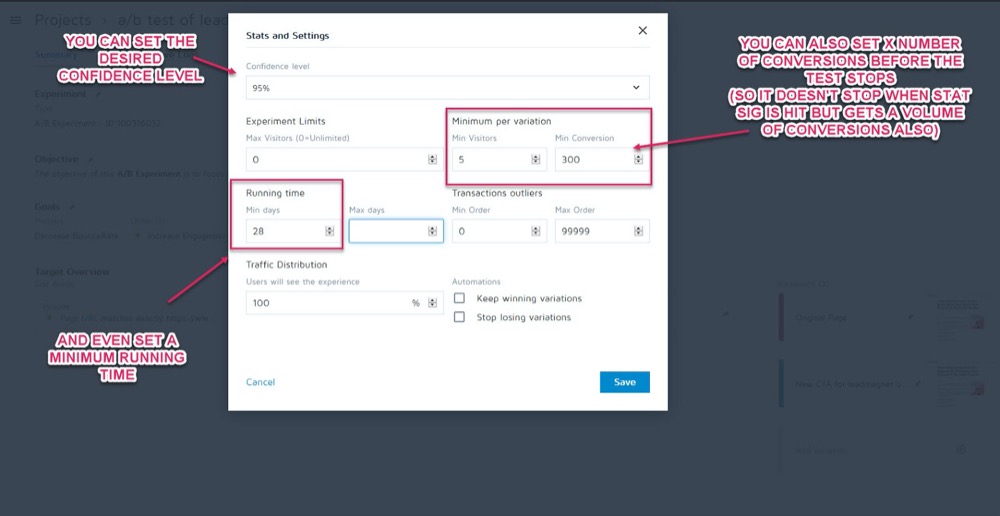

Convert Experiencesアプリのテストの[統計と設定]セクションで、テストを実行する前にこれらをパラメーターとして設定できます。

次に、テストを呼び出す前に、必要な信頼水準、最小実行時間、および達成する変換数を設定できます。

データが正確であることが確認できたら、それを分析します…

ステップ2:マイクロ、マクロ、ガードレールの指標を確認する

ほとんどの人はテストを見て、ツールが教えてくれるものから、勝者または敗者を額面通りに受け取ります。

もちろん問題は、ツールが設定した基準に基づいてテストがどのように実行されるかを通知することしかできないことです。 CROテスターとして、私たちは常にこれらの結果が発生した「方法」と「理由」を理解し、それらから学ぶことができるようにしたいと考えています。

これから行うチェックがいくつかありますが、最初に最も重要な3つのチェックについて説明します。 そこで、ミクロとマクロの結果追跡が登場します。

説明させてください:

- マイクロトラッキングとは、テストを最適化した目標を追跡することを指します。これには、クリック数や登録数の増加などがあります。

- マクロトラッキングは、通常は売上であるビジネスのNorthstarメトリックへの影響を調べています。

なぜこれが重要なのですか?

場合によっては、テストページのマイクロイベントの上昇がマクロに影響を与えないことがあります。

例

リードキャプチャページでCTAをテストし、敗者がコントロールよりも少ないリードを取得するとします。

どのテストが勝ったかは明らかだと思いますよね?

しかし、分析をさらに詳しく調べると、その「負けた」テストで得られたリードが、実際にはバックエンドではるかに高く変換され、はるかに大きなROIを生み出していることがわかります。

なぜこれが起こるのでしょうか?

あなたの現在のページはより多くのオーディエンスにアピールしていて、より多くのリードを変換しているかもしれませんが、あなたの新しい「負け」バリアントは実際に今すぐ購入する準備ができている人々にアピールしています。

この例では、負けキャンペーンは、Northstarメトリックではるかに優れた変換を行うため、実際に実行したいページになります。

あなたの最終目標を覚えて、それに最も影響を与えるものにあなたの努力を集中してください。

ただし、ミクロとマクロの結果だけを探す必要はありません。

まだ行っていない場合は、キャンペーンに「ガードレールメトリック」を追加することを検討してください。

これらは、他の変更を行うときに注意したいコアメトリックです。これにより、パフォーマンスが非常に重要であるため、変更が低下し始めた場合に、特定のテストメソッドをロールバックまたは停止できます。

Uberでは、いつでも何百もの実験を行っています。 これらの実験の目標は、当社の製品とユーザーエクスペリエンスを継続的に改善することです。 ただし、実験者がいくつかの重要な指標を念頭に置いており、チームや会社全体にとって重要な他のいくつかの指標への影響を認識していない場合があります。また、実験を実行すると、これらの監視されていない指標が低下する場合があります。

このようなシナリオを検出して軽減するために、実験監視プラットフォームを構築しました。 目標は、実験の実行中に劣化させたくないいくつかのガードレールメトリックを特定して監視することです。 シーケンシャルA/B手法のバリエーションを適用して、これらのガードレールメトリックを継続的に監視し、実験の治療群と対照群の間の回帰を検出します。 リグレッションが検出された場合、実験の所有者にアラートを送信します。

Uber、シニアデータサイエンティスト、Suman Bhattacharya

例

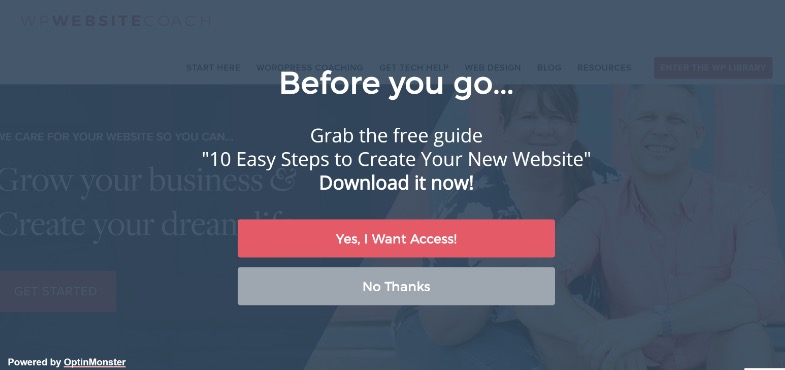

フルスクリーンのポップアップを使用して、より多くのリードを収集したいとします。

一部のサイトでは、これらはうまく機能しますが、常に機能するとは限りません。 (これが私たちがテストする理由です!)

おそらく、フルスクリーンポップアップをインストールして、そのページでより多くのリードを獲得し始めましたが、それらの新しいサブスクライバーへのウェルカムメールが返送されて配信されていません。

ポップアップの表示を停止するためだけに、人々が偽の電子メールをオプトインしていたことが判明しました。

実際の購読者への電子メール配信結果を低下させる可能性があるため、電子メールリストに偽のリードを含めたくありません。 また、オーディエンスが電子メールを偽造する必要があると感じるほどユーザーエクスペリエンスを低下させたくない場合もあります。

メールマーケティングは販売プロセスの中心的な部分であるため、リードキャプチャページでA / Bテストを実行しているときに、メールのバウンス率が設定値を超えた場合に通知するアラートを設定することにしました。

これがガードレールの指標になります。 この例では、それが壊れていることがわかり、邪魔にならないリードキャプチャ方法を使用することにしました。

それは理にかなっていますか?

ただし、ガードレールの指標は、リードキャプチャとバウンス率だけではありません。 これらは、ユーザーエクスペリエンスに影響を与えるような落ち込みを見たくない重要な指標です。

重要な指標も改善していることを確認しながら、ユーザーエクスペリエンスの低下を防ぐために、いくつかのガードレール指標を定義します。これらの指標が特定のしきい値を下回った場合、想定される「勝利」バリアント。 これは、コンバージョンの最適化とUXまたはブランドガイドラインの間の議論を終わらせるのにも役立ちます。

Alex Birkett、全知デジタル

これらの指標があなたのビジネスにとって何であるかを決めるのはあなた次第です。 それらを使用して、実際の勝者がいるかどうか、または1つの結果のリフトをより重要な領域での損失と交換しているだけかどうかを確認します。

インスピレーションが必要な場合は、実験とテストでの一般的なガードレールメトリックのBenLabayのリストを確認してください。

次に、それに応じてこれらの変更を行います。

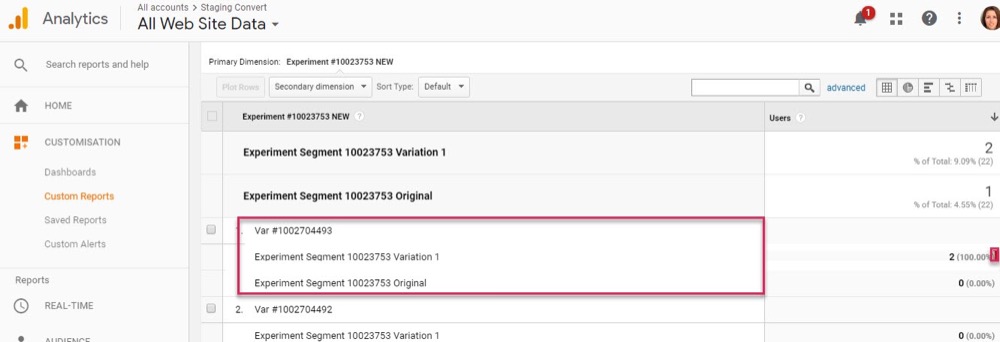

アナリティクスと高度なセグメントを使用してConvertExperiencesアプリを設定している限り、この情報を簡単に確認して見つけることができます。 テストツールの勝者を選ぶだけでなく、ノーススターメトリックと「ガードレール」に対する各バリエーションの影響を確認してください。

コアメトリクスについて説明したので、結果をもう少し詳しく見ていきましょう…

ステップ3:より深く進み、結果をセグメント化する

テストに関しては、平均は嘘であることを忘れないでください。

平均的な結果では、複数のデータポイントの組み合わせに基づいた幅広い情報しか得られません。 その結果が発生した理由を理解し、それが常に見た目とは限らないため、より深く見るのはあなた次第です。

マクロの結果がマイクロテストの変更の影響を受けることはすでに見てきましたが、分析セグメントからさらに深い洞察を得ることができます。

例

より多くのリードのテストを実行しているとしましょう。 一見すると、コントロールとバリアントの訪問者からサブスクライバーへのコンバージョン率は同じです。

ただし、詳しく調べてみると、デスクトップでは新しいバリエーションがコントロールのコンバージョン率のほぼ2倍になっていますが、モバイルではゼロであるため、ページの平均はコントロールと同じように見えます。

明らかに、何かが間違っていますが、なぜこれが起こるのでしょうか?

新しいバリアントがモバイルで正しく読み込まれないか、フォームが特定のデバイスで機能しないため、サブスクライブしたいモバイルユーザーが実際にロードできない可能性があります。 そして、この問題を修正した場合、「等しい結果」のバリアントが実際にコントロールをはるかに上回っている可能性があります。

あなたがあなたの結果の背後にあるより多くの情報を得るために働くときだけ、あなたはこれらのものを見つけることができます。

各テストで、洞察への道を実験します。これにより、よりスマートなセグメンテーションが通知され、新しい洞察が得られ、最終的にはより意味のある戦略につながります。

Shanelle Mullins、Shopify

セグメンテーションは、エラーを見つけるだけでなく、他のユーザーの洞察を見つけることでもあります。

ページとコントロールはすべて正常に機能している可能性がありますが、詳しく見ると、この新しいテストでは、特定のトラフィックチャネルが他のチャネルよりもはるかに高く変換されていることがわかりますか?

多くの場合、一部のセグメントのパフォーマンスが低下し、他のセグメントのパフォーマンスが向上します。 これにより、新しいパーソナライズキャンペーンや有料またはオーガニックのトラフィック戦略を知ることができます。

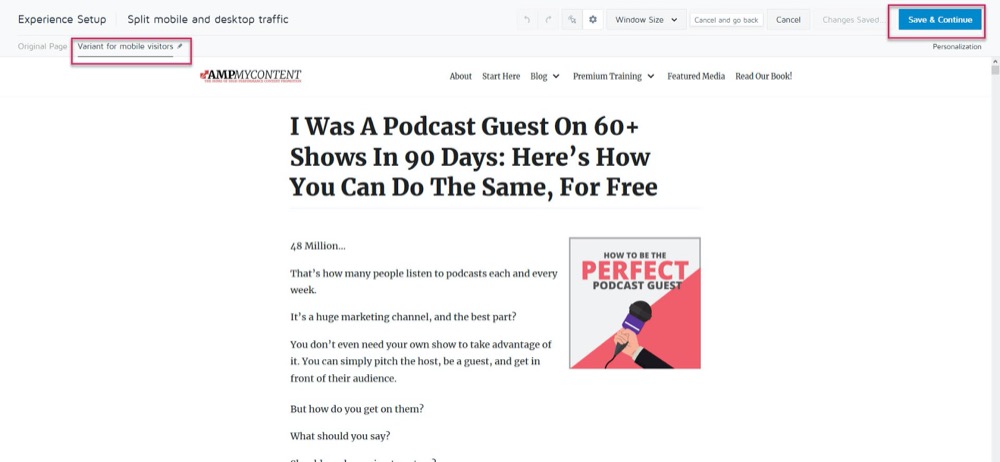

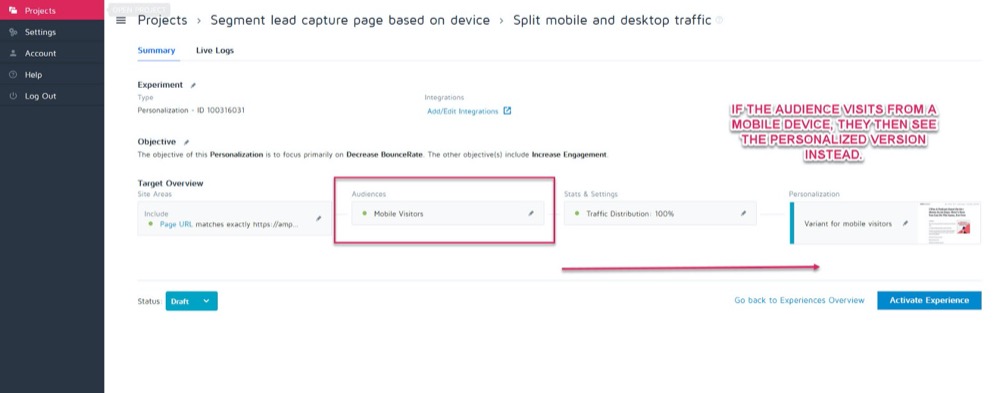

おそらく、コントロールはデスクトップで最もよく変換されますが、新しいバリアントはモバイルでより高く変換されます。 たとえば、閲覧者がサイトをどのように見ているかに基づいて、どのバージョンが表示されるかを選択するとします。

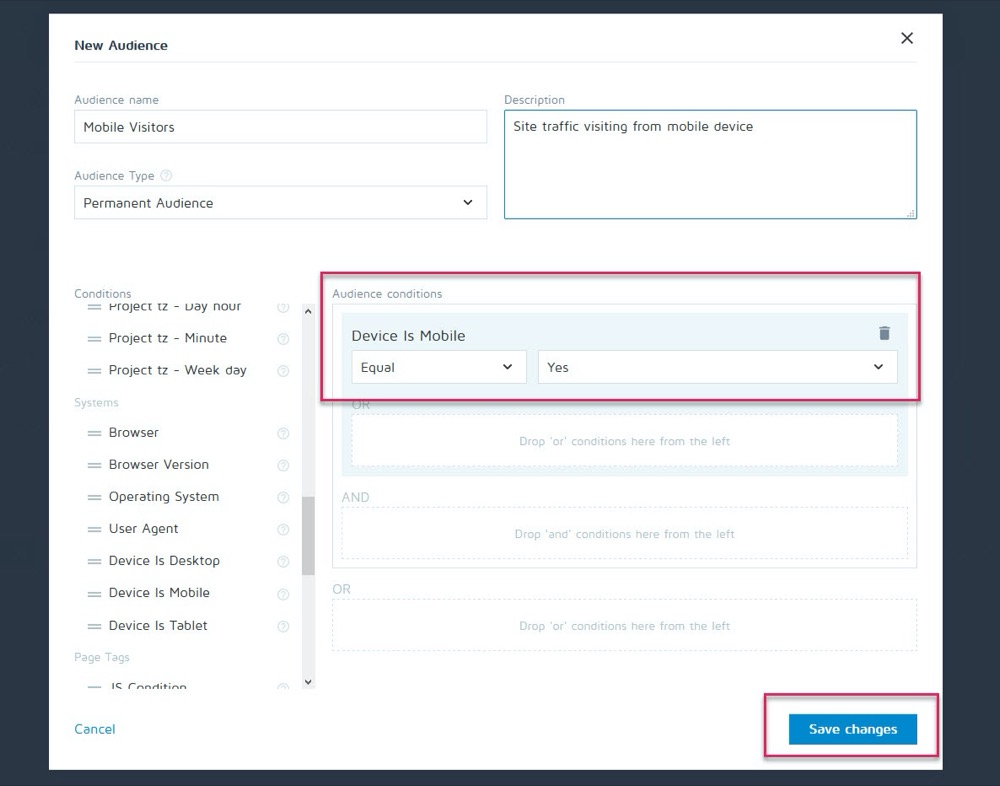

Convertのパーソナライズ機能を使用すると、モバイルでの勝利のバリエーションを、そのオーディエンスだけのパーソナライズとして設定できます。

次に、訪問者が任意のモバイルデバイスから来ているときに、新しいバージョンを表示できます。

ただし、デスクトップから出くわした場合は、代わりにデスクトップバージョンが表示されます。

使用できるさまざまなパーソナライズ方法は山ほどありますが、キャンペーンからいくつかの洞察を得た場合に限ります。

セグメントを分析するための鍵は、常に結果を調べて、なぜ何かが起こったのかを知ることです。

見る:

- 新しい対リピーター。 1つのバリエーションは、人々をより頻繁に呼び戻すのでしょうか? より多くのコールド/新しいオーディエンスメンバーを変換していますか?

- トラフィックソース。 1つのチャネルが他のチャネルよりも優れていますか? ここでもっと集中できますか?

- ページビュー。 特に、テストページが販売ページへのトラフィックを促進しようとしている場合。 1つのバージョンでクリックがない場合は、ボタンが壊れているか、CTAに問題がある可能性があります。

- バウンス率。 これは、リンク切れ/読み込みが遅い/ UXエクスペリエンスが悪いこと、または間違ったオーディエンスをターゲットにしていることを示している可能性があります。

- オペレーティング·システム、

- モバイルとデスクトップ。

- 使用したデバイス。

わずかな免責事項:

このようにセグメント化するときに各チャネルを正確に反映するには、大量のデータが必要です。 経験則として、通常実行する場合の約10倍のコンバージョン数(またはバリアントページごとだけでなく、チャネルごとに300回のコンバージョン)でテストを行うことをお勧めします。

「このようなテストを実行するのに十分なトラフィックを取得する方法はありません」とお考えかもしれません。 または、そうすると、それが発生するまでに数か月かかる可能性があります。

その場合でも、セグメント分析の確認をスキップしないでください。

なんで?

データに裏付けられた結論を引き出すのに十分なコンバージョンが各セグメントにない場合でも、クリック数がゼロのページビューや即時のバウンス率などの問題が発生し始めた場合は、いくつかの明白な洞察が得られます。

これらはすべて、失敗したテストを示し、逃した可能性のある勝者を見つけるのに役立つ可能性があるものです。 先に進んで、主要なドロップオフと問題を探します。 すべてが各プラットフォームとデバイスで機能していましたか?

理想的には、テストの前にすべてをチェックしましたが、テストの途中で問題が発生する可能性があるため、もう一度チェックしてください。

私は個人的にWordPress自体をキャンペーンの途中で自動的に更新しました。これにより、テストの途中でリードキャプチャフォームが突然機能しなくなりました。 常にチェックインしてください。結果の精度を損なうものが見つかった場合は、テストを停止し、問題を修復してから、もう一度実行してください。

そして、すべてがうまく機能していた場合はどうなりますか?

見て、なぜ人々があなたの行動を起こさなかったのかを調べましょう…

ステップ4:ユーザーの行動をチェックしてさらなる洞察を得る

理想的には、テストツールの上に定性的な追跡を配置する必要があります。

なんで?

これにより、バリアントについての洞察が得られることが多いため、定期的なテストだけでは見逃してしまいます。

覚えて:

Convertなどの定量的テストツールは、何が起こったかを教えてくれます。 クリックした人とクリックしなかった人の生の数値データを提供し、各A/Bテストの設定を支援します。

ただし、定性的なツールを追加すると、アクションが発生した理由を理解するのに役立ちます。 これにより、ユーザーが何をしていたかを確認し、ユーザーの行動についてさらに洞察を得ることができます。

(テストは通常、実行が不十分であるか、聴衆の理解が不十分であるために失敗します。問題を解決できるのは、何がうまくいかなかったかを確認することによってのみです。)

Hotjarなどのツールを使用すると、多数の定性テストを実行でき、組み込みの統合機能を使用してデータをConvertダッシュボードに直接取り込むこともできます。

より深い洞察を得るには、Hotjar – Convert統合を設定し、以下の戦術を試してください。

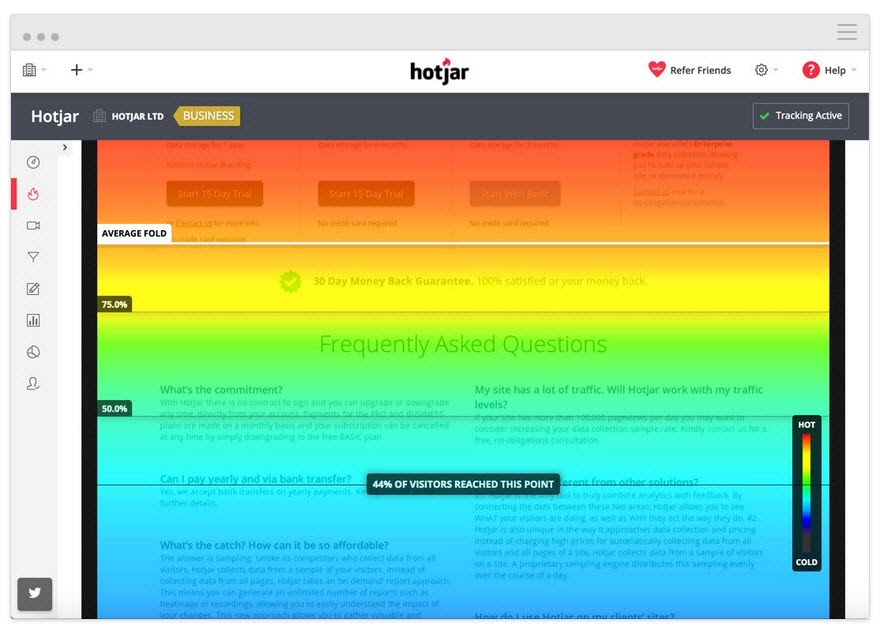

ユーザーが読んだ距離を追跡する

ヒートマップツールをページに追加して、オーディエンスがCTAまで到達しているかどうかを確認します。 そうでない場合は、テストを再度実行して、CTAをページの上位に移動できます。

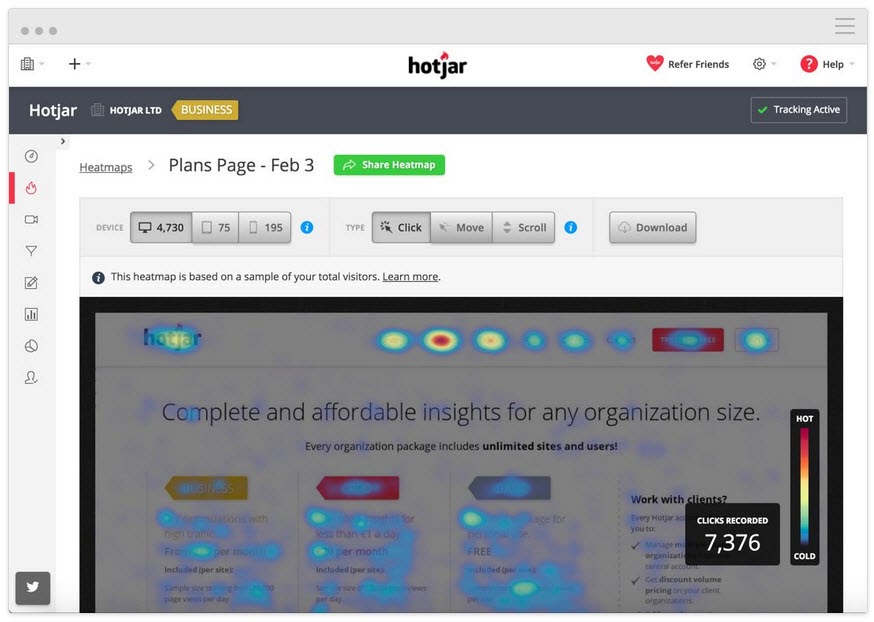

ユーザーがクリックしたものを追跡するが、すべきではない

彼らは戦略的なCTAをクリックしますか、それとも代わりにリンクであると彼らが考えるランダムなテキストですか?

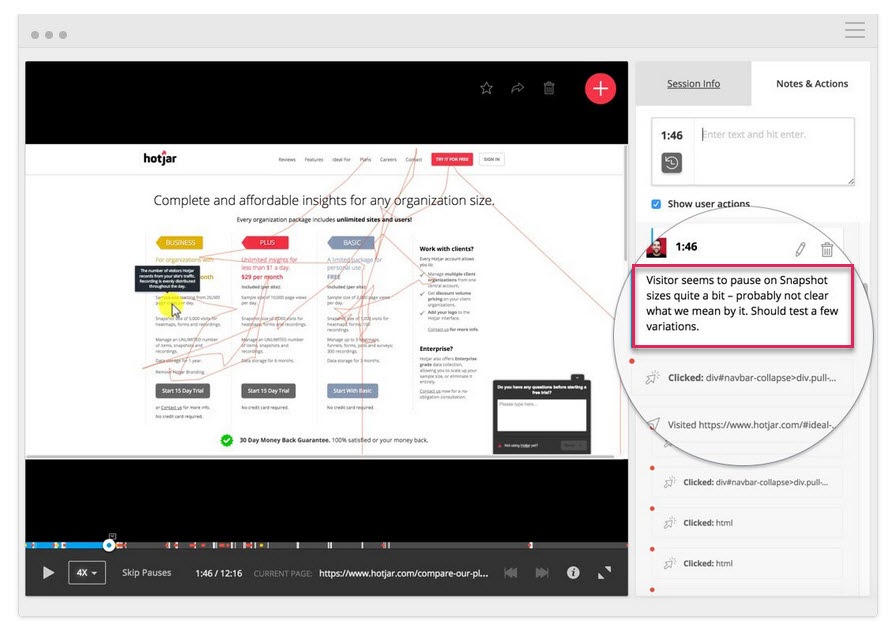

画面の記録を見て、クリックしないがクリックする必要があるものを確認します

彼らはそれを見るのに十分遠くまでスクロールしても、あなたのCTAボタンをクリックしていませんか? 彼らはクリックしていますが、開いていませんか? 彼らはそれを見ますが、それがクリックされるボタンであることに気づいていませんか?

これらすべてを見ることができ、これらのものが飛び出したときにメモを追加することもできます。

役立つのは、ヒートマッピングおよびクリック追跡ツールだけではありません。

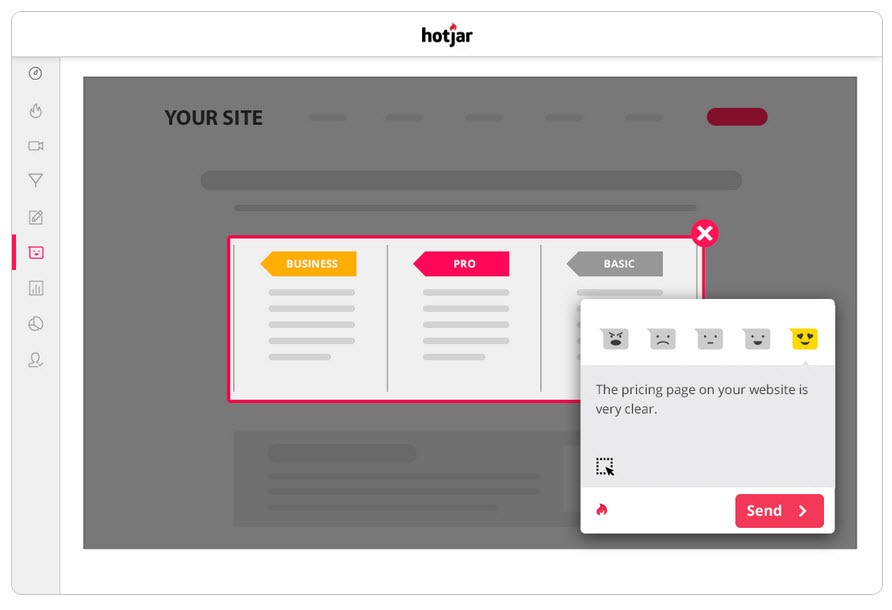

あなたの聴衆に調査を実行します

調査は、視聴者が行動を起こした(または止めた)原因についてのフィードバックを得るだけでなく、これを説明するために使用する言語も提供するのに役立ちます。

コピーライティングでは、これを「ミラー言語」と呼び、ユーザーとのつながりに非常に効果的です。 彼らが使っているのと同じ言葉でそれを説明するので、あなたは彼らの問題を認識するだけでなく、他の誰よりもそれをよく理解しているように感じます。

A/Bテストツールと一緒に調査を使用する2つの優れた方法は次のとおりです。

- インテントポーリングを終了します。 新しいバージョンを使用していない人を特定し、何が彼らを止めたのかを知ることができます。

今日オプチン/購入しなかった理由はありますか?

- 購入後/コンバージョン後の投票。 バリアントを使用している人を見つけて、問題点や動機付けの要因がないかどうかを確認します。

今日行動を起こすことになったきっかけは何ですか?」 あなたが決断するのをほとんど妨げたものはありましたか?

さらに情報が必要な場合は、コントロールで同様の調査を実行することもできます。 これらすべては、テストがどのように実行されたかを理解するのに役立ち、反復して改善することができます。

そういえば…

ステップ5:負けたテストから学ぶ

負けテストを受ける際に最も重要なことは、結果から何かを学ぶことです。 視聴者をよりよく理解するために洞察を得ることができる限り、悪いテストのようなものはありません。

A/Bテストはインタラクティブなプロセスです。 理解を深めながら失敗します。 多くの場合、勝者を完全に獲得するだけでなく、負けたテストを勝者に与えることからはるかに多くのことを学ぶことができます。

これまで、3つのことを行ってきました。

- テストデータが正確であることを確認し、

- 問題の生の結果を見て、

- ユーザーとその行動を理解しようとしています。

このステップは、失敗の原因となる可能性のある一般的な問題を理解し(テストデータが正確で、CTAボタンがすべて機能していると仮定して)、アプローチと仮説を分析するのに役立つヒューリスティックなアプローチです。

あなたの仮説は間違っていましたか、それともあなたのテストはずれていましたか?

これは、特に新しいテスターの間で一般的な問題です。

実際のKPIと一致していないいくつかの「woowoo」メトリックまたはアイデアからテストを実行しましたか?

例

ページからの売り上げを増やしたいが、何らかの理由で、代わりにソーシャル共有ボタンの微調整をテストすることにしたとします。 (より多くのソーシャルシェアが売上に影響を与えることを示すデータはありませんが。)

クレイジーに聞こえますが、このようなことが頻繁に発生することに驚かれることでしょう。

自問してみてください:

私のテスト目標はコアKPIと一致し、それに影響を与える可能性がありますか?

そうでない場合は問題ありませんが、次のテストが適切に調整されていることを確認してください。

私たちは失敗し、学び、再試行します。

次のテストでは、コアKPIメトリックとそれらにどのように影響を与えることができるかに焦点を当て、テストに明確な勝ち/失敗のシナリオを与えるようにしてください。

このページでより多くのリードを獲得したいので、オプトインするためのテストを行っています。つまり、より良いCTAを作成したいと考えています。

また

このページでより多くのリードを獲得したいのですが、ユーザーがCTAまでスクロールしないことがわかったため、ページを上に上げてテストしています。

テストを目標に合わせると正しい方向に進むことができますが、それでもコンバージョンが増えない可能性があります…

仮説は正しく、テストは調整されましたが、結果に変化はありませんでした

これは90%の確率で発生する可能性があり、ほとんどのテストが失敗するのはそのためです。

例1

あなたのユーザーデータは、ユーザーがあなたのサイトを十分に信頼していないことを示しています。 社会的証明、ユーザーの声、SSL証明書などの信頼要素を追加しましたが、コンバージョンはまだ増加していません。

それはあなたが立ち止まって新しいテストやアングルを試すべきだという意味ですか?

全くない…

最初の仮説は正しかったかもしれませんが、効果を確認するには、テストを改善するか、より適切に実行する必要があります。

信頼要素を追加してみたり、持っているものを移動して目立つようにすることもできます。 おそらく、彼らがあなたの聴衆とより良くつながるのを助けるために彼らで使われている言語を言い換えます。

これらはすべて最初の仮説と一致しています。勝者を見つけるには、さらに多くのバージョンをテストする必要があります。

例2

CXLは、このランディングページで6つの異なるテストキャンペーンを実行して、トラック運転手の認定のリードを増やしました。

彼らは、ページの改善を続けることで、オプトイン率を12.1%から79.3%に引き上げました。

(これらのテストキャンペーンのほとんどすべては、上昇が見られる前に同じ仮説を使用して複数回試行しました。その後、ページ上の他の要素を改善するために移動してテストしました。)

A/Bテストは反復プロセスです。 改善点を見つけるには、テストと調整を続ける必要があります。ビジネスで最高の人でさえ、10%の確率で勝者を見つけることができます。

仮にあなたが組織であり、実行したすべてのテストが成功した場合、それは実際には私の意見では危険信号になります。

直感に反するように聞こえますが、あなたは明白なことをテストしているだけであり、実際に針を動かすのに十分なリスクがとられていないことを私に示しています。

デボラ・オマリー、テストを推測する

最高のものから学ぶことは常に素晴らしいことであり、私たちがデボラと行ったインタビューを共有できることを嬉しく思います。 テストが失敗しない理由と、テストで正しい精神を持っていることの重要性について話しました。 あなたが正しい足で始めるのを助けるために、ここで私たちのインタビューを聞いてください。

つまり、ポジティブリフトが表示されるまでに、9回のテストが必要になる可能性があるので、それに固執します。

テストは、影響が最も大きいものから最も低いものまでの優先順位システムに従う必要があります。 現在のキャンペーンを改善するためにさらに多くのテストと変更を実行することで、現在のキャンペーンですぐに結果が表示されないため、重要度の低いテストにジャンプするよりもはるかに大きな影響が見られます。

それでも小さな変更で上昇が見られない場合は、別の設計を実行する革新的なテストを実行することを検討してください。

それはフェンスの揺れかもしれませんが、時にはそれはあなたがする必要がある変更かもしれません。

これらのテストと調整をすべて行った後でも、バリアントがまだ敗者である場合はどうなりますか?

したがって、データは正しく、すべての調整を試し、ページ全体に大幅な革新的な変更を加えても、コントロールよりもパフォーマンスが向上することはありません。

見えないかもしれませんが、これは実際には良いことです。

なんで?

あなたはあなたの聴衆とうまくいかないものを見つけたからです!

非常に多くのWebサイトが、何もテストせずに大幅な変更を加え、それをロールアウトするだけです。

これを自問してください:

そのページバリアントが現在のコントロールよりもわずか1%悪い変換である場合、これを最初にテストし、展開しないことでどれだけのお金を節約できましたか?

2014年に、Marks and Spencerは、最初にサンプルオーディエンスでテストせずに、Webサイト全体を更新することを決定しました。

結果?

Their online sales dropped by 8.1% in 3 months, causing a loss of $55 million.

This is why testing and finding losers is a really good thing because even losing tests can save you money.

What if the Test and the Variant Have Identical Results?

You checked everything, it all works, you've segmented down and gone into the nitty-gritty, but there's just no discernible difference between your current page and your new variant.

You've even tried complete page overhauls but through some fluke of math, your new page still converts at the same rate as the old one.

In this case, it's simply the dealer's choice.

Does the new variation more actively represent your brand and style?

If so, choose whichever you wish to use. The results are still the same but you are happier with the design.

Note: This should be the only time that you do this. Branding should not sacrifice results; it should aid them, as seen in the previous example.

Step #6: Double Down on Winners and Continue to Improve Them

So far we've been covering losing campaigns, but what if you got a winner right out of the gate?

まず、おめでとうございます!

Second, let's make sure you actually have a winner. Oftentimes, things can happen to affect your results and give you a false positive (ie we think it's a winner but we implement it and nothing happens.)

Go ahead and run the test again with just your control and the winning variant and prove the lift in results first before you make any changes to your site.

Then if it really is a winner? Don't stop there, continue to improve it!

Iterative improvements of a new winning campaign are the easiest new test to run. With each new improvement, you'll see more ongoing ROI. You can even take what you learned with your winning test and then roll it out across similar pages on your site for further tests and see if it also adds lift there too.

Step #7: Create a Learning Repository for Future Tests

This step is relevant to both winning and losing tests.

Not only will it help you with future tests, but it will also help your QA team diagnose any broken campaigns faster, as they can see where issues have appeared in the past.

Better still?

It will help you document your results for clients or your boss, while also standardizing your reporting processes and ramping up your test velocity.

仕組みは次のとおりです。

You're going to create a master archive or learning repository of all past tests. A place to document your previous wins and losses that you can use to both reference for new campaigns and share with stakeholders or customers.

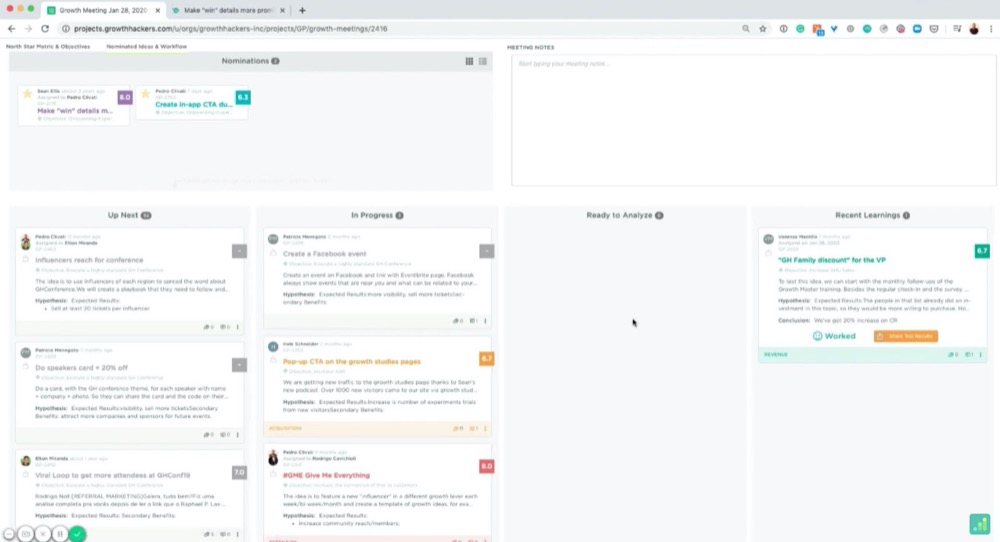

You can use a folder on your computer for this, but, if you really want to get organized, there's a great tool called GrowthHackers experiments.

Its main goal is to help marketing growth teams communicate and organize campaigns, but you can easily use it to manage your CRO testing and learnings. It will even pull in results from your test tool and allows you to archive each test. (You can simply tag and then add them to the repository.)

Whatever you decide to use, here are some best practices:

Organizing Your Tests

You probably have your own naming conventions but if you're just starting, I recommend naming each test like so:

“Goal – Campaign – Test Date”

例えば:

“CTR lift test – XYZ client – March 1st-14th 2021”

This way, you can organize tests by goals to get inspiration for future tests, search through and find them for client campaigns, or look back on your experiments month by month.

Then, if you wanted to run a CTR test later on, you can swipe through them and see what ideas worked or failed in the past.

How Do We Create Documents for the Learning Repository?

Feel free to add screenshots of your testing tools graphs, confidence, and power level or any data that you think is relevant.

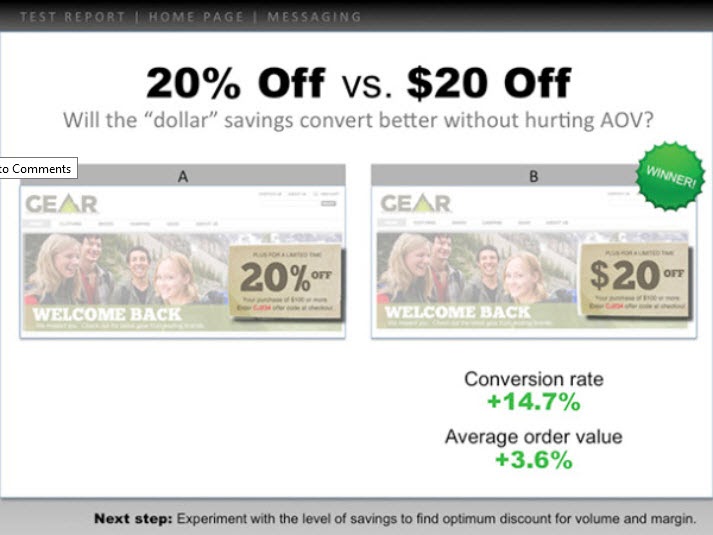

However, I highly recommend creating a slide with the following information:

- The hypothesis and how you came up with the idea (any survey data or information).

- A headline with the test goal.

- A screenshot of the control, the winning variant, and any other failed versions/tests that got some lift but not as much. (Highlight the key elements so you can spot what changed without having to look too hard.)

- Add the micro goal and its percentage lift. (Perhaps 3.2% CTR)

- Then add the macro goal and its percentage lift. (AVG order value up 2.2%, etc.)

次に例を示します。

You can use these slides to present the test information to anyone else who needs them, while also having a simple file to understand the test at a moment's notice.

Pretty handy, right?

Now that you've analyzed your test and recorded the results, let's walk you through how to present this to your boss in a way that even if the test failed, they're still happy to see your findings…

How To Present This Information To Your Boss (Even When Your Campaigns Failed)

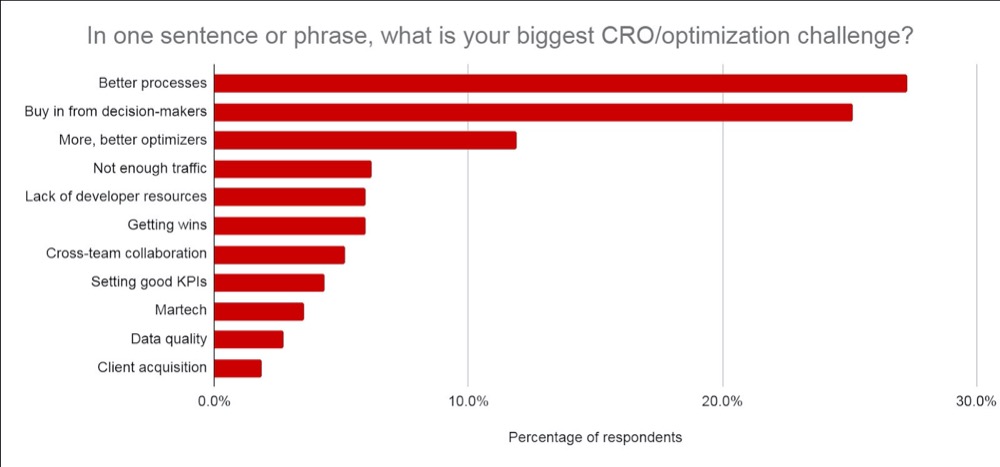

Don't worry if you feel anxious about this, you're not alone. In fact, according to CXL's state of the industry report, presenting test information or getting buy-in from your stakeholders is consistently one of the biggest struggles CROs face.

We've covered the best ways to communicate this information before, but I want to give you a few extra tips on how to get your test results across (even if your test failed).

Tip #1: Get Everyone On Board With CRO and Its Realities as Soon as Possible

Ideally, you covered this when you first broached the topic of running A/B tests but it never hurts to recap.

Make sure they understand that A/B testing is a continual learning process that's more about understanding your audience and improving their experience. The lift in ROI is simply a byproduct of taking action on each test and implementing what you learn, regardless of if it wins or fails.

Winners give lift and losers give insight into where to improve.

No test is ever wasted but the majority of them do fail. You're looking at roughly 1/10 winners for most people's tests and agencies are around 1/4.

Be clear on how many tests fail and the need to run more tests to find winners.

Tip #2: Present the Information as Simply as You Can

Not everyone can read graphs easily. Even if they can, it still means that it takes effort to understand the context of what they are seeing.

The more effort it takes to understand something, the more frustrating it can be and can cause you to lose the other person's attention.

(Top tip for landing pages btw ^^)

Break it down nice and simple by using the slides from your learning repository.

It should already include:

- 事前に学んだことと、どのようにしてテストのアイデアにたどり着いたか。

- あなたがテストしたもの。 コントロール、バリエーション、勝者を表示します。

- ミクロおよびマクロレベルでどのように機能したか。 結果を含めます。

Finally, add any insights you drew from tests to decide on your next important action to take. (Improve execution, test new variations, new hypothesis, etc.)

Providing insight into what happened is HUGE.

上司は、結果よりもあなたが学んだことを気にかけます。 それを共有し、次に何をすべきかについてのアイデアを与えることは、あなたが状況をコントロールしていることを彼らが理解するのを助け、彼らがさらなるテストについて自信を持っていると感じるのを助けます。

ヒント3:見栄えを良くする

さらに一歩進んで、関心のあるデータを追加します。

- テストが失敗した場合は、失敗したと思う理由を洞察してください。 失敗したテストをロールアウトしないことで節約されたROIと、それがMRRとARRにどのように影響するかを追加します。

- 勝った場合は、作成されたROIと、これが前年比の収益/ MRRおよびARRにどのように影響するかについての洞察を提供し、さらに規模を拡大してROIをさらに向上させる機会を提供します。 (つまり、リードキャプチャページをテストし、レイアウトを微調整するときにリフトが見られた可能性があります。このテストを適用できる他の同様のページが30あり、潜在的なリフトが見られる可能性があります。)

- テストがフラットだった場合は、何が起こったと思うか、次に何をすべきかについての洞察を共有します。 (より良い実行、新しいバリアント、完全な変更、またはより適切に調整されたテストなど)

確かに、ARR + MRR、またはYOYの影響は概算ですが、テストの潜在的な影響と価値を示しています。 それがあなたの上司が気にかけていることであり、彼らがあなたの結果を見たときに彼らが考えていることです。

私を信じてください、あなたがこのようにあなたの情報を提示するとき、あなたはそれがはるかに簡単に伝わることに気付くでしょう。 テストを「お金が失われた」または時間の無駄として組み立てることから、代わりに潜在的な節約、実際の収益、および潜在的なさらなる成長に焦点を当てることになります。

それだけでなく、さらに多くのテストを実行し、CROの取り組みを成熟させ、テスト速度を上げることの価値を証明することもできます。

結論

そこにあります。

これで、A / Bテストの結果を分析して学習する方法に自信が持てるようになり、テストの実行方法に関係なく、この情報を上司や他の人に提示できるようになります。

このガイドに従って、実行する新しいA/Bテストごとのテスト後の分析を合理化してください。