A / Aテストのすべて:なぜ、いつA / Aテストを実行する必要がありますか?

公開: 2022-07-07

A / Aテストを使用すると、2つの同一のページを相互にテストでき、新しいA/Bテストツールを設定するときに非常に役立ちます。

A/Aテストは

- A /Bテストプラットフォームの精度を評価し、

- A /Bテストプラットフォームが内部分析と完全に統合されているかどうかを判断し、

- A /Bテストツールで発生する可能性のある技術的な問題を特定し、

- ページまたは目標到達プロセスのベースラインコンバージョン率を提供し、

- A /Bテストに使用する適切なサンプルサイズを決定し、

- ページと目標到達プロセスのパフォーマンスをベンチマークします。

Convertは、A/Aテスト機能とA/Bテスト機能の両方を提供し、高変換Webサイトの設計と開発を成功させるために必要なすべてのものを備えていることを確認します。

A / Aテストの重要性と、最初のエクスペリエンスを設定する方法について詳しくは、以下をお読みください。

- A / Aテストとは何ですか?

- なぜA/Aテストを実行するのですか?

- A/Bテストプラットフォームの精度を確認する

- 内部分析との統合の程度を決定する

- 考えられる技術的な問題を特定する

- 任意のページまたは目標到達プロセスのベースラインコンバージョン率を提供する

- 必要なサンプルサイズを見つける

- ページと目標到達プロセスのパフォーマンスのベンチマーク

- A/Aエクスペリエンスの設定

- A / Aテスト結果をどのように解釈しますか?

- A/Aエクスペリエンスで決定的な結果は期待できません

- 同一でないバリエーションを取得した場合、それはどういう意味ですか?

- A / Aテストの課題は何ですか?

- ランダム性

- 大きなサンプルサイズ

- エクスペリエンスとA/Aテストの変換

- ConvertExperiences内でA/Aテストを設定するにはどうすればよいですか?

- 純粋なA/A体験

- キャリブレーションされたA/A/BまたはA/A / B/Bエクスペリエンス

- 多くのA/Aエクスペリエンスを実行する

- A/Bエクスペリエンスと同時にA/Aエクスペリエンスを実行できますか?

- テスト前のQAプロセス:A/Aテストの興味深い代替案

- SRMはA/Aテストに存在できますか?

- ConvertExperiences内でA/Aテストを設定するにはどうすればよいですか?

- A / Aテストの長所は短所を上回りますか?

おそらく、このようなことが以前にあなたに起こったことがあるでしょう…

- A / Bテストを実行して、新しいCTAボタンと見出しがコンバージョンを増やすかどうかを確認します。

- 翌月には、コントロールとバリエーションの両方のランディングページに同じ量のトラフィックを送信します。

- あなたのソフトウェアはあなたのバリエーションが勝者であると宣言しているので(99%の自信を持って)、あなたはやめます。

- 次に、「勝利」のデザインを開始しますが、いくつかのビジネスサイクルの後、コンバージョン率の50%の増加が純利益にほとんど影響を与えていないことがわかります。

最も可能性の高い説明は、偽陽性のテスト結果です。 幸いなことに、誤ったテストを処理するためのさまざまな方法があります。

聞いたことがあるかもしれませんが、A/Aテストです。

A / Aテストとは何ですか?

A / Aテストに飛び込む前に、A / Bテストについて話しましょう。そうすれば、違いを指摘できます。

通常のA/Bエクスペリエンスでは、トラフィックは2つ以上の代替バリエーションに分割されます。

1つのバリエーションは通常、「コントロール」または「オリジナル」として指定されます。 エクスペリエンスの他のすべてのバリエーションをコントロールと比較して、特定のメトリックで最大のリフトを生成するものを決定します。

一方、A / Aテストでは、通常50/50分割を使用して、トラフィックを2つの同一のバリエーションに割り当てる必要があります。

通常のA/Bテストでは、より高いコンバージョン率を見つけることが目標ですが、A / Aテストでは、通常、バリエーションのリフトが同じかどうかを調べることが目的です。

A / Aテストでは、トラフィックはランダムに分割され、両方のグループに同じページが表示されます。

次に、何かを学ぶことを期待して、報告されたコンバージョン率、クリック率、および各グループの関連する統計がログに記録されます。

A/Aテスト=互いにテストされた2つの同一ページ

それでは、A / Aエクスペリエンスを使用できる場所の例をいくつか見て、それらが役立つかどうかを判断しましょう。

なぜA/Aテストを実行するのですか?

A / Aテストの実行は、次のようなWebデザインおよび開発プロセスのさまざまな段階で特に効果的です。

- 新しいA/Bテストツールのインストールが完了したら、

- 現在のA/Bテストツールの設定がアップグレードまたは変更された場合、

- 新しいウェブサイトやアプリを作成するときは、

- A/Bテストのデータレポートと使用している他の分析ツールの間に不一致があることに気付いたとき。

これらの各ユースケースについて詳しく見ていきましょう。

A/Bテストプラットフォームの精度を確認する

A / Aエクスペリエンスは、A / Bテストプラットフォームの取得を検討している企業、または新しいテストソフトウェアの試用を検討している企業(適切にセットアップされていることを確認するため)のいずれかによって開始できます。

A / Aエクスペリエンスでは、同じページの2つの完全に同一のバージョンを比較し、同様のコンバージョン値を実現します。

コントロールとバリエーションの間に違いがない場合、期待される結果は決定的ではありません。

それでも、「勝者」は2つの同一のコピーで宣言されることがあります。

これが発生した場合、ツールが正しく構成されていないか、効果がない可能性があるため、A/Bテストプラットフォームを評価することが重要です。

次のステップとして、次のことを行う必要があります。

- A/Bトラッキングコードが正しくインストールされていることを確認してください

- サイトエリアを確認してください

- あなたの聴衆をチェックしてください

- あなたの目標を確認してください

- A / Bテストのサポートチームに連絡して、プラットフォームを放棄する前に解決できるものかどうかを確認してください。

うまくいけば、問題は上記の1つです。 問題を理解できない場合、これはA / Aテストが決定的であり、A/Bテストプラットフォームが不正確であることを意味している可能性があります。

内部分析との統合の程度を決定する

A / Bテストプラットフォームの精度をチェックする場合、A / Aテストを使用して、プラットフォームが分析ツールと完全に統合されているかどうかを評価できます。

Google Analytics、Heap Analytics、Adobe Analytics、Plausible、Matomo、またはその他を使用しているかどうかにかかわらず、A / Aテスト結果を内部分析ツールと比較して、統合が期待どおりに機能したかどうかを判断できます。

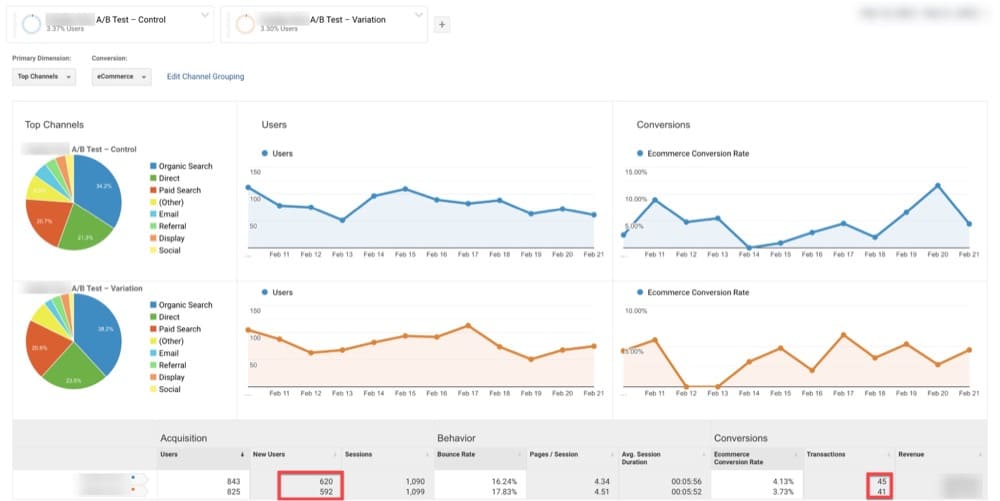

たとえば、以下の例では、GAはオリジナルで620人の訪問者、バリエーションで592人の訪問者を識別しました(オリジナルと同じページ)。

同じ日付範囲で、Convertはオリジナルで972人の訪問者、バリエーションで980人の訪問者を明らかにしました(オリジナルと同じページ)。

これは、2つのプラットフォーム間の統合が期待どおりに機能していないことを示している可能性があります。

考えられる技術的な問題を特定する

A / Aテストを使用して、考えられる技術的な問題を特定することもできます。

ほとんどのA/Bテストソフトウェアは、プログラムがどこまでプッシュされるかによって、多少異なる方法を使用し、大幅な変動をもたらす可能性があります。

これは異常のように見えるかもしれませんが、次のいずれかでより深刻な根本的な問題を示唆している可能性もあります。

- 数学と統計式

- ランダム化アルゴリズム

- ブラウザのCookie

A / Aエクスペリエンスを使用して、上記の問題を明らかにすることができます。

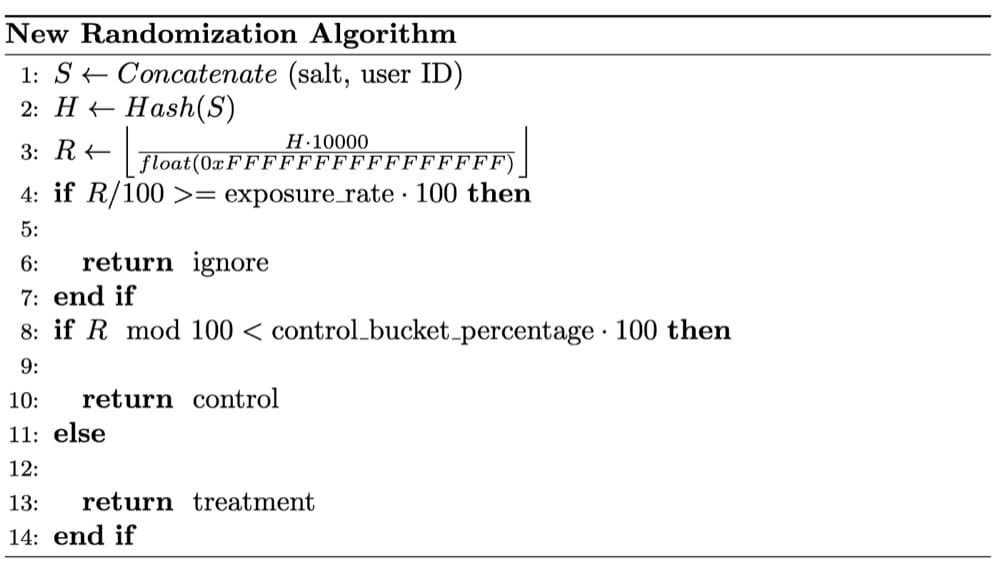

以下のケースでは、ウィッシュのデータサイエンティストは、A/Aテストに関するSRMの懸念に気づきました。 徹底的な調査の結果、SRMは完全にランダムではないランダム化が原因であると判断されました。

ランダム化手法は、信頼できる実験結果を得るために重要です。

ランダム化されたサンプルの使用は、A/Bテストで使用される統計的テストの重要な前提です。

ランダム化は、実験バケット間で観察されたユーザー要因と観察されなかったユーザー要因の両方のバランスを取ります。 これは、テスト対象の製品機能と試行結果の変更との因果関係を確立します。

任意のページまたは目標到達プロセスのベースラインコンバージョン率を提供する

任意の数を改善したい場合は、最初にそのベースラインがどのように見えるかを把握する必要があります。 これはあなたの速度、体重、または実行時間である可能性があります。

同様に、A / Bテストを実行する前に、結果を比較するコンバージョン率を最初に決定する必要があります。 これがベースラインコンバージョン率です。

1回の体験で収益が増えると聞いたことがあるかもしれませんが、これは誤解を招く可能性があります。 あなたのウェブサイトのコンバージョンが改善されたかどうかは、1回の経験ではわかりません。

ベースラインのコンバージョン率を知ることは重要です。すべてのエクスペリエンスの上昇を定量化できない場合は、予想される全体的なコンバージョンと達成されたコンバージョンを頻繁に比較する必要があるためです。

運が良ければ、「勝利」と見なされるすべての経験は、コンバージョンが期待を超えるのに役立ちます。

そして、これを十分に頻繁に行うと、コンバージョンは改善し続けるだけです。

A / Aテストは、それを達成するのに役立ちます。

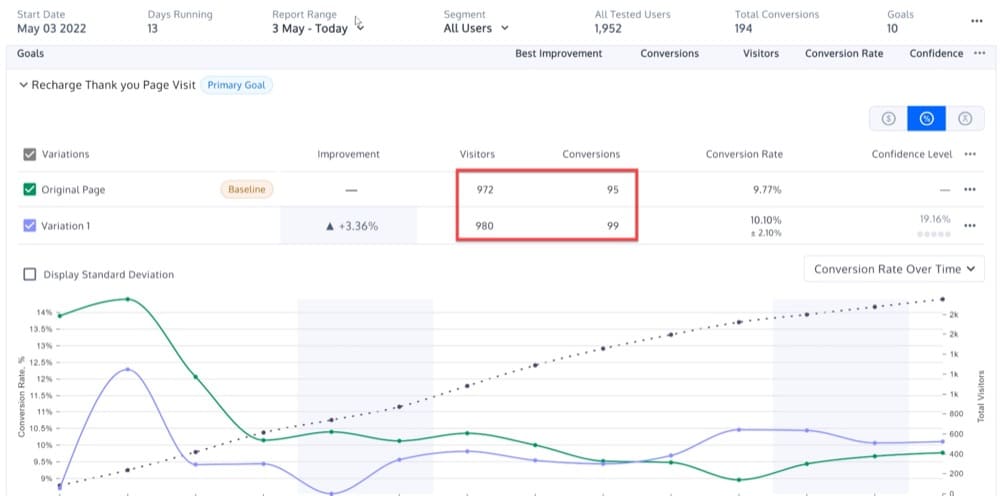

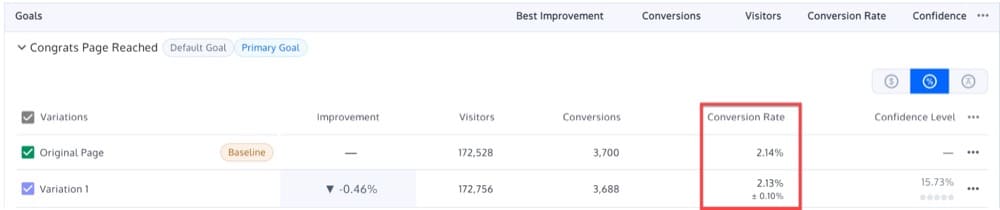

ランディングページの1つでA/Aテストを実行していて、オリジナルAとバリエーションBでほぼ同じ結果(2.14%と2.13%)が得られたとします。

その結果、ベースラインコンバージョン率を2.13-2.14%に設定できます。

これを念頭に置いて、このベンチマークを超えることを目標に、将来のA/Bテストを実施できます。

新しいバージョンのランディングページでA/Bテストを実行し、2.15%のコンバージョン率を受け取った場合、結果は統計的に有意ではありません。

必要なサンプルサイズを見つける

A / Bエクスペリエンスを実行する前に、ロードトリップに行く前と同じように、サンプルサイズを再確認してください。

十分なサンプル(ユーザー)がない場合、経験効果は観察されません。 一方、サンプルが多すぎると、人々を悪い経験にさらし続けることで、チームの進行を遅らせるリスクがあります。

理想的には、収集するサンプルの数を最初に決定せずに、エクスペリエンスを開始しないでください。

理由を理解するには、次のことを考慮してください。

あなたがコインを持っていて、それが50/50の確率で表または裏に着地するという仮説があるとしましょう。 これを証明するために、あなたはそれを百回投げます。

しかし、最初の10回のトスで10個の尾を取得し、そこで実験を停止することにしたとしましょう。

帰無仮説(コインが公正である)を棄却することは統計的に有意に見えるかもしれませんが、実験を途中で終了しました。 実験を開始するのにどれくらいの時間がかかるかわかりません。

サンプルサイズを推定しないと、どのくらいの期間体験を行うかを決定できない場合もあります。

では、これにどのようにアプローチしますか?

A / Aテストは、Webサイトの訪問者から必要なサンプルサイズの大きさを把握するのに役立ちます。

おそらく、月曜日の朝の訪問者は、土曜日の夜の訪問者とは統計的に完全に異なります。 そして、おそらく、ホリデーシーズンの買い物客は、ホリデーシーズン以外の買い物をする人とは統計的に異なります。

デスクトップの顧客は、モバイルの顧客と統計的に異なる場合があります。 そして、スポンサー付きの広告を介して来るあなたの顧客は、口コミの紹介から来る顧客と同じではありません。

デバイスやブラウザなどのカテゴリ内で結果を表示すると、正しいサンプルサイズで明らかになる傾向に驚かれることでしょう。

もちろん、サンプルサイズが小さすぎる場合、結果は信頼できない可能性があります。 いくつかの部分を見逃す可能性があり、それがエクスペリエンスの結果に影響を与える可能性があります。

サンプルサイズが大きいほど、テストに影響を与えるすべてのセグメントが含まれる可能性が高くなります。

A / Aテストを実行することにより、同じバリエーション間で理想的な同等性を実現できるサンプルサイズを決定できます。

つまり、A / Aテストは、将来のA/Bテストに使用できる適切なサンプルサイズを決定するのに役立ちます。

ページと目標到達プロセスのパフォーマンスのベンチマーク

ホームページ、カートページ、商品ページ、その他のページに何人の訪問者が訪れますか?

これを行うときに勝者が見つかるかどうかは関係ありません。 むしろ、特定のページのより大きなパターンを検索しています。

これらの経験は、次のような質問に答えるのに役立ちます。

- ホームページのマクロコンバージョン率はどれくらいですか?

- 訪問者セグメントごとのそのコンバージョン率の内訳は何ですか?

- デバイスセグメントごとのコンバージョン率の内訳は何ですか?

A / Aエクスペリエンスは、Webサイトの任意の部分の新鮮なA/Bエクスペリエンスを比較できるベースラインを提供します。

Webサイトの分析を通じて同じ情報を受け取ることができると主張する人もいるかもしれません。

しかし、これは真実でも真実でもありません。

A / Bテストツールは、主に勝者を宣言するために使用されます(Google Analyticsにテストデータを送信するとき、または他の計算を実行するとき)。そのため、実行中にWebサイトのメトリックを監視する必要があります。

A/Aエクスペリエンスの設定

A / Aエクスペリエンスは、コンバージョン率を最適化するための非常に重要なツールです。

ただし、A / Aエクスペリエンスの課題は、エクスペリエンスを実行するときに使用するページを決定することです。

A / Aエクスペリエンスページに選択するページに、次の2つの品質があることを確認してください。

- 大量のトラフィック。 ページにアクセスする人が多いほど、バリエーション間の整合性にすぐに気付くでしょう。

- 訪問者は購入またはサインアップすることができます。 A/Bテストソリューションをフィニッシュラインまで微調整する必要があります。

これらの要件が、WebサイトのホームページでA/Aテストを頻繁に実施する理由です。

次のセクションでは、A / Aテストキャンペーンを作成する方法について詳しく説明しますが、簡単に言うと、WebサイトのホームページでA/Aテストを設定する方法は次のとおりです。

- 同じページの2つの同一バージョン(コントロールとバリエーション)を作成します。 バリエーションの作成が完了したら、同じサンプルサイズのオーディエンスを選択します。

- KPIを決定します。 KPIは、時間の経過に伴うパフォーマンスを測定するメトリックです。 たとえば、KPIは、召喚状をクリックした訪問者の数である可能性があります。

- テストツールを使用してオーディエンスを均等かつランダムに分割し、一方のグループをコントロールに送信し、もう一方のグループをバリエーションに送信します。 コントロールとバリエーションの両方が特定の訪問数に達するまで、エクスペリエンスを実行します。

- 両方のグループのKPIを追跡します。 両方のグループが同じコンテンツに公開されているため、同じように動作する必要があります。

- A/Bテストツールを分析ソフトウェアに接続します。 これにより、分析プログラムでデータが正確に収集されていることを再確認できます。

A / Aテスト結果をどのように解釈しますか?

A/Aエクスペリエンスで決定的な結果は期待できません

季節性によってA/Aテストの結果が変わる可能性は低いですが、目的の1つは、予期しない結果を検出することです。 このため、結果を確認する前に、少なくとも1週間はテストを実行することをお勧めします。

1週間の終わりに、A / Aテストの結果を調べると、次の動作に気付くはずです。

- 時間の経過とともに、統計的有意性は特定の値の周りに落ち着きます。 10%の確率で、統計的有意性は90%を超えて落ち着きます。

- より多くのデータが収集されると、実験の信頼区間は縮小し、ゼロ以外の値は除外されます。

- オリジナルとバリエーションは、テスト結果のさまざまな時点で異なるパフォーマンスを示す可能性がありますが、どちらも統計的に有意な勝者と公式にラベル付けされるべきではありません。

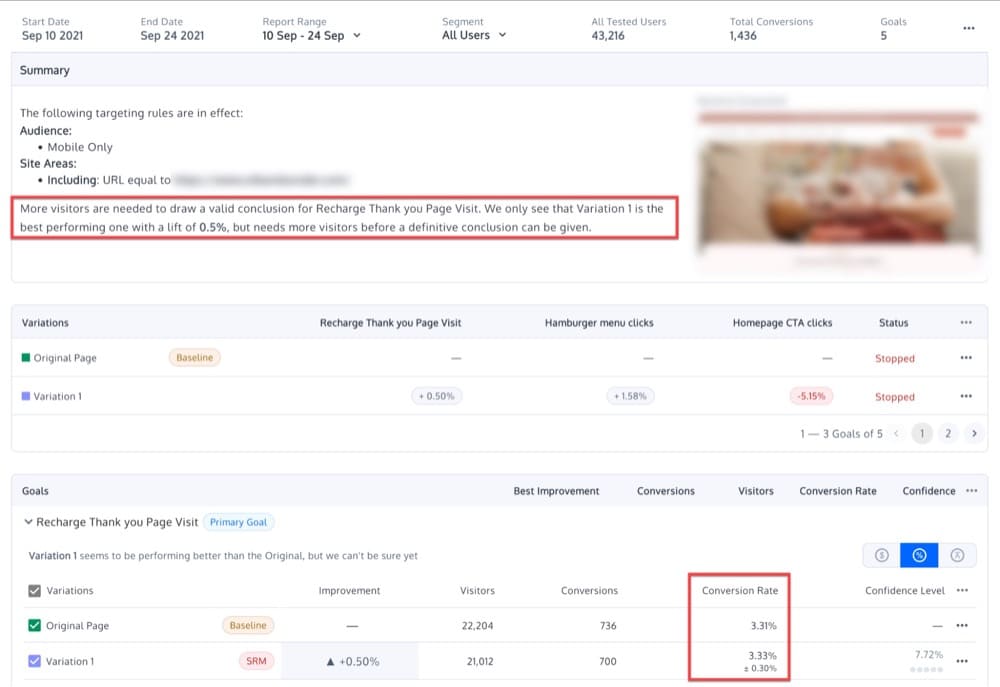

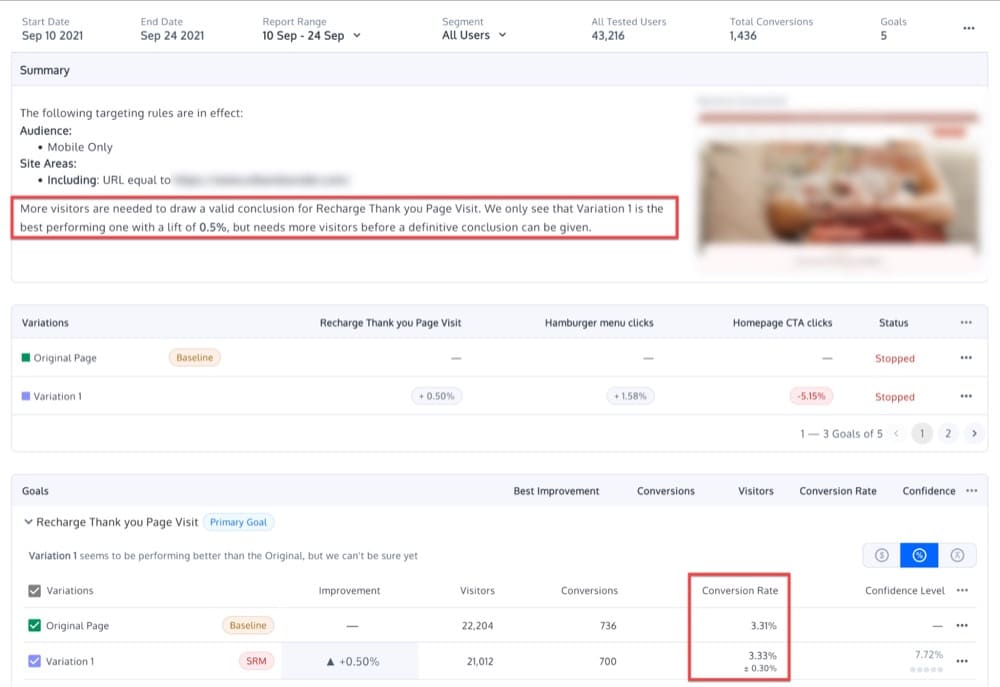

バリエーション間に差はないはずなので、わずかな差しか見られず、統計的に有意な結果は見られないはずです。 おそらく、これらの線に沿って何かが表示されます。

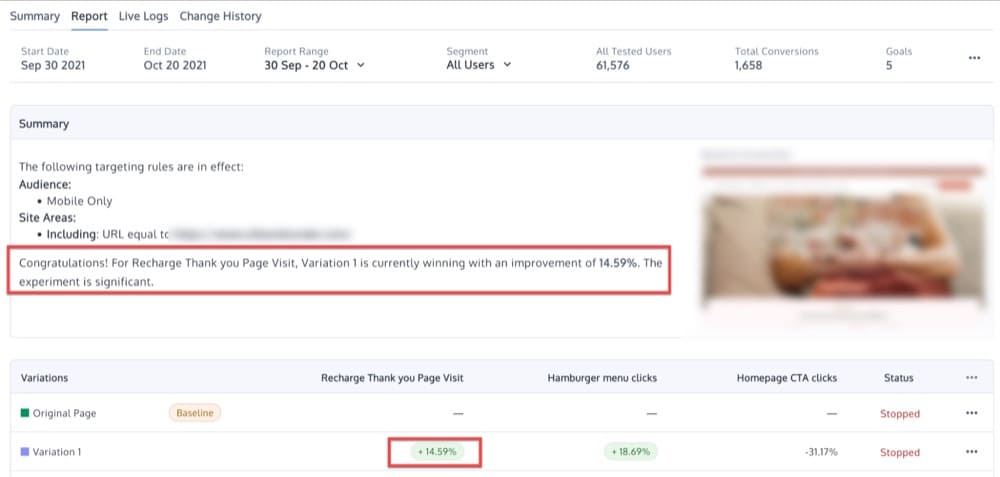

同一でないバリエーションを取得した場合、それはどういう意味ですか?

A / Aエクスペリエンスの2つの同一のバリエーションの間にかなりの違いがある場合は、 A / Bテストソフトウェアが正しく実装されていないか、テストツールが非効率的である可能性があります。

ただし、エクスペリエンスが適切に実行されなかったか、結果がランダムな分散によるものである可能性もあります。 この種のサンプリングエラーは、すべての訪問者を測定するのではなく、サンプルを測定するときに自然に発生します。

たとえば、95%の信頼水準は、2つのバリエーション間のパフォーマンスの有意差ではなく、サンプリングエラーが原因で、20回に1回の確率で勝ちの結果が発生することを示しています。

適切に実行されたA/Aエクスペリエンスがバリエーションのアイデンティティを検証しない可能性があるもう1つの理由は、ターゲットオーディエンスの異質性によるものです。

たとえば、さまざまな年齢の女性のコンバージョン率を変えて、女性のグループでA/Aエクスペリエンスを実行するとします。

正確なA/Bテストツールを使用してテストを適切に実行した場合でも、2つの同一のバリエーションの間に有意差が見られる場合があります。 なんで? この例では、訪問者の50%が20〜90歳で、残りの50%が20〜50歳である可能性があります。プラットフォームのエラーではなく、不一致の結果は、2人のオーディエンスがとても違う。

最後に、A / Aテストを含むあらゆる種類のテストを実行する場合の別のよくある間違いは、結果をチェックし続け、統計的有意性が検出されたらテストを途中で終了することです。

勝ちのバリエーションを宣言するのが早すぎるというこの慣行は「データの覗き見」と呼ばれ、無効な結果につながる可能性があります。

A / Aテストでデータを覗き見すると、アナリストは、2つが実際には同一である場合に、1つのバリエーションの上昇を確認できます。

これを回避するには、使用するサンプルサイズを事前に決定する必要があります。 以下に基づいてこの決定を行います。

- 最小効果量:それを下回ると、効果が組織にとって意味をなさなくなる最小リフト

- 力

- 許容できると考える有意水準

A / Aテストの目的は、サンプルサイズが達成された後、統計的に有意な結果が表示されないようにすることです。

A / Aテストの課題は何ですか?

A / Aテストが実験戦略にもたらす多くの利点とは別に、これらはA/Aテストの2つの大きな欠点です。

- A / A実験セットアップには、予測不可能な要素が含まれています。

- 高いサンプルサイズが必要です。

これらの課題のそれぞれを個別に見てみましょう。

ランダム性

前述のように、A / Aテストを実行する主な理由の1つは、テストツールの精度を評価することです。

しかし、コントロールとバリエーションの変換の違いを発見したとしましょう。

A / Aテストの問題は、常にランダム性の要素が関係していることです。

他の状況では、統計的有意性は偶然によってのみ達成されます。 これは、2つのバリエーション間の変換率の差が、絶対的なものではなく確率的なものであることを意味します。

大きなサンプルサイズ

同様のバリエーションを比較する場合、同一のバリエーションよりも1つが優先されるかどうかを判断するには、大きなサンプルサイズが必要です。

これにはかなりの時間がかかります。

A / Aテストを実行すると、「実際の」テスト時間が無駄になる可能性があります。

大規模な最適化プログラムの秘訣は、プロセスから無駄、愚かさ、非効率性を完全に取り除くことによって、リソースコストと機会の比率を減らし、テストスループットと学習内容の速度を確保することです。

サイトで実験を実行することは、主要な国際空港で忙しい航空会社を実行することに少し似ています。離陸スロットが限られているため、それらを効果的に使用する必要があります。

CXLのCraigSullivan

エクスペリエンスとA/Aテストの変換

A / Aテストは、より「高度な」サポートリクエストで頻繁に発生します。

Convertサポートエージェントからの次の提案は、解決された数十のケースに基づいています。

- A / Bテストプラットフォームをテストするには、最初にA/Aエクスペリエンスを実施します。 選択したレベルで2つの差が統計的に有意である場合、プラットフォームが壊れている可能性があります。

- A / A/BまたはA/A / B / Bテスト(これについては以下で詳しく説明します)を実行し、2つのAバリエーションまたは2つのBバリエーションが選択したレベルで統計的に有意な差を生成する場合は結果を破棄します。

- 多くのA/Aテストを設定します。 予想よりも多くのテストで統計的に有意な差が示された場合、プラットフォームは壊れています。

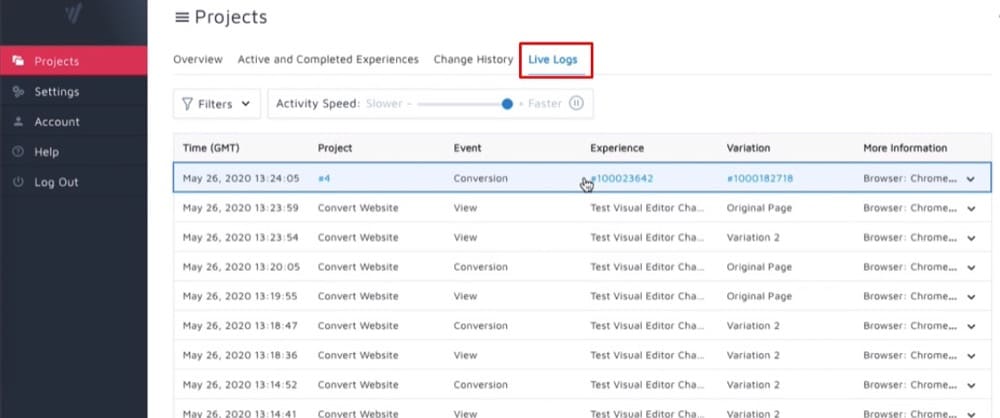

ConvertExperiences内でA/Aテストを設定するにはどうすればよいですか?

次に、ConvertExperiencesを使用していくつかの異なるタイプのA/ Aテスト(はい、複数形)を設定する方法を見てみましょう。

純粋なA/A体験

最も一般的なA/Aセットアップは、同一の2つのページ間で50/50に分割されます。

目標は、各バリエーションのパフォーマンスがほぼ同じであることを確認することにより、エクスペリエンス構成を検証することです。

同じことを自分自身に対してチェックして、データに有用な情報ではなくノイズが含まれているかどうかを調べています。

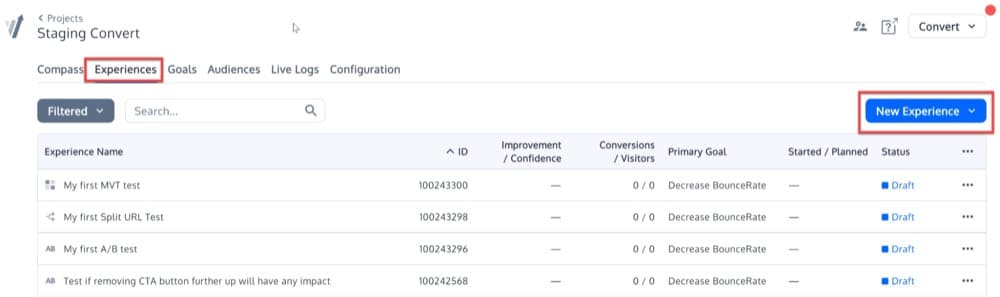

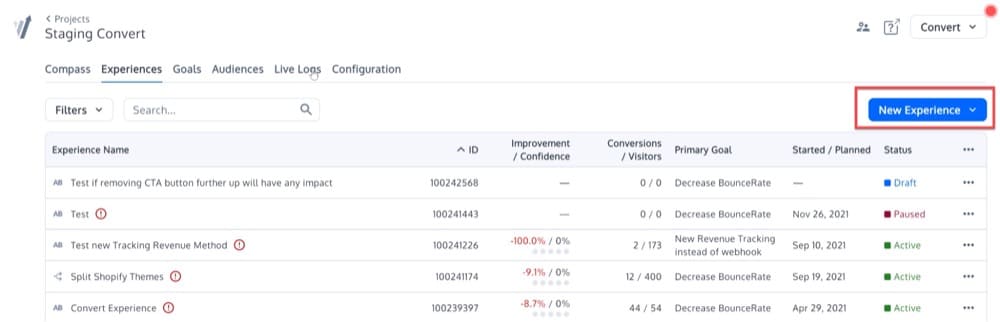

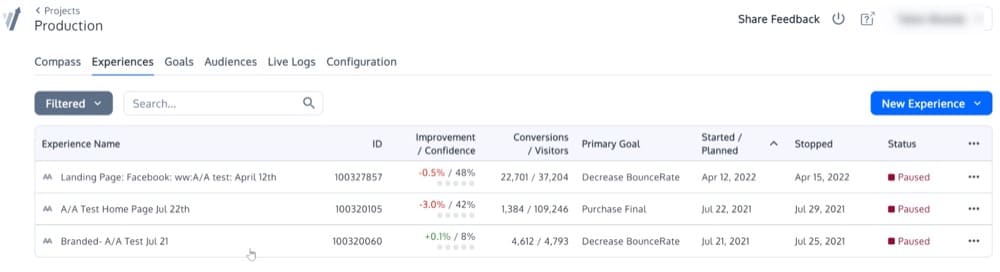

このシンプルなA/Aエクスペリエンスを設定するには、[エクスペリエンス]メニューをクリックします。 次に、右上の「新しいエクスペリエンス」ボタンをクリックします。

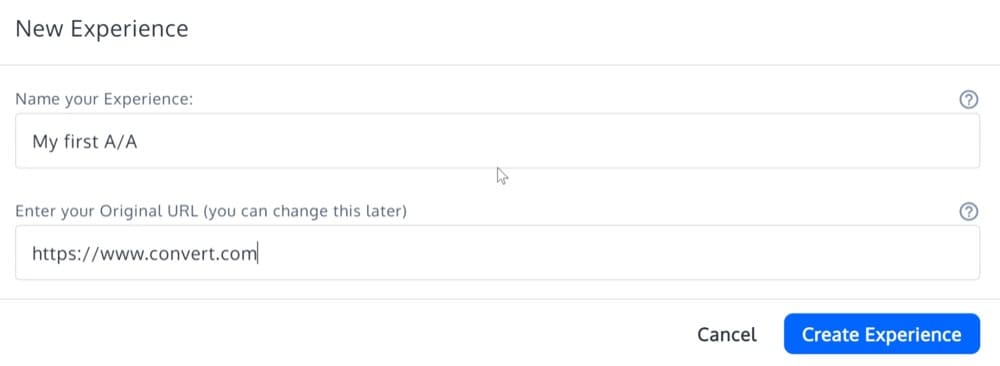

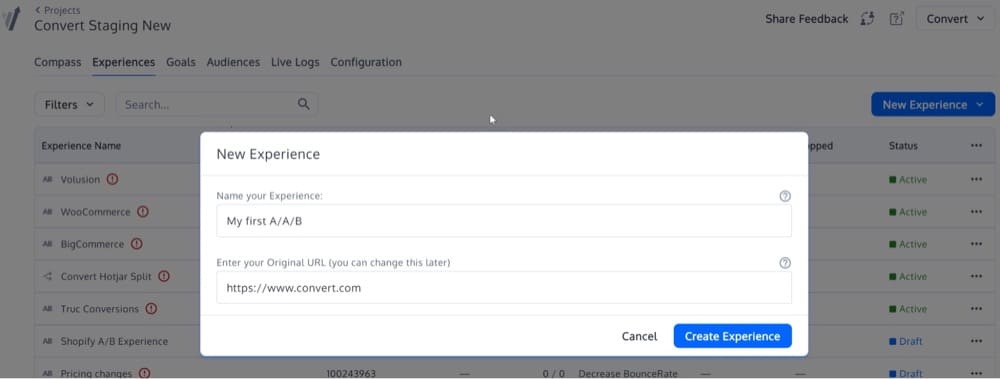

「エクスペリエンス作成ウィザード」の詳細を入力し、「A/Aエクスペリエンス」エクスペリエンスタイプを選択します。

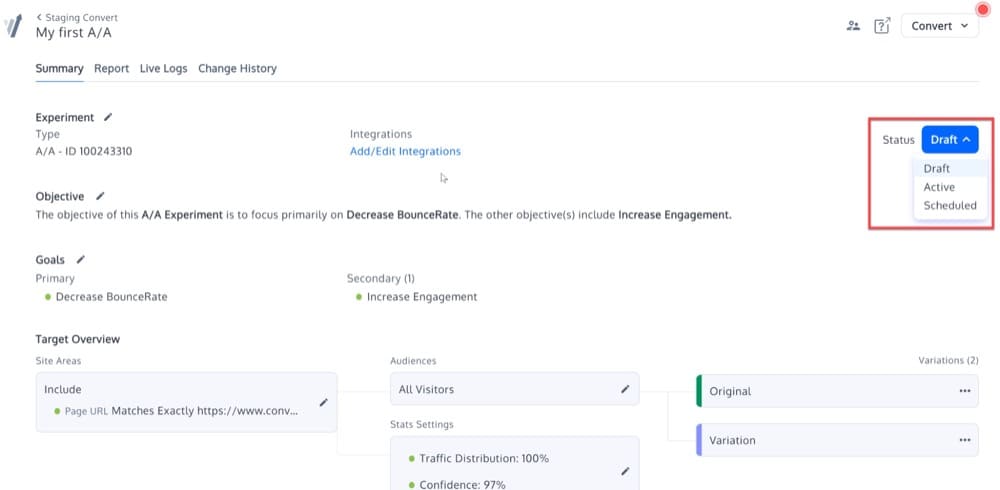

これで、A/Aエクスペリエンスが作成されます。 「バリエーションを編集」するオプションがないことを除けば、プラットフォーム内の他のタイプの実験と同じになります。

ステータスを変更して、エクスペリエンスをアクティブ化します。

キャリブレーションされたA/A/BまたはA/A / B/Bエクスペリエンス

このキャリブレーションされたA/A/BまたはA/A / B / Bテストの背後にある考え方は、複製されたAまたはBのバリエーションがA/Bテストの精度の尺度を提供するということです。

AとAまたはBとBの差が統計的に有意である場合、テストは無効と見なされ、結果は破棄されます。

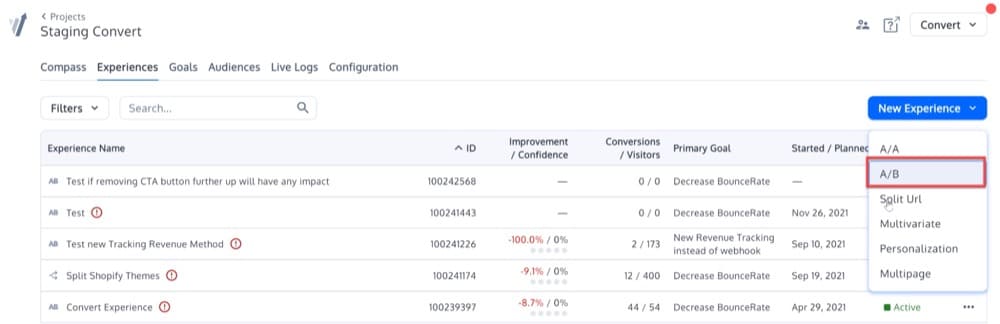

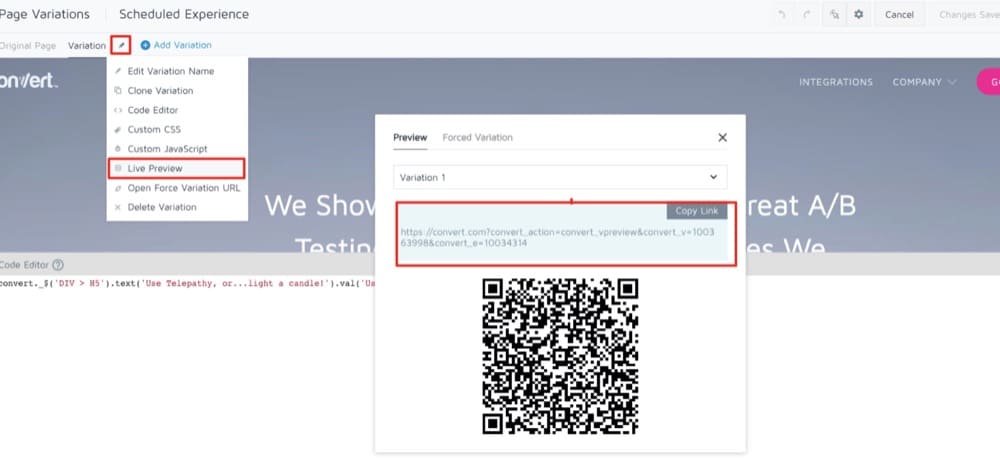

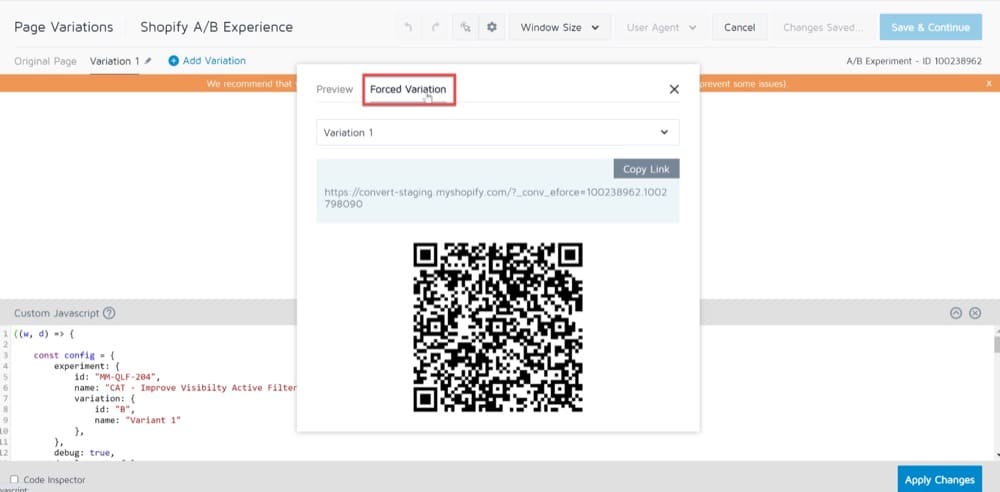

このようなテストを設定するには、A/AではなくA/Bエクスペリエンスを開始する必要があります。

画面右側の「新しいエクスペリエンス」ボタンをクリックして、新しいエクスペリエンスの作成を開始します。

そのボタンをクリックすると、このポップアップメニューが表示されます。 オプションA/Bを選択します。

次に、2番目のボックスにURLを入力します。

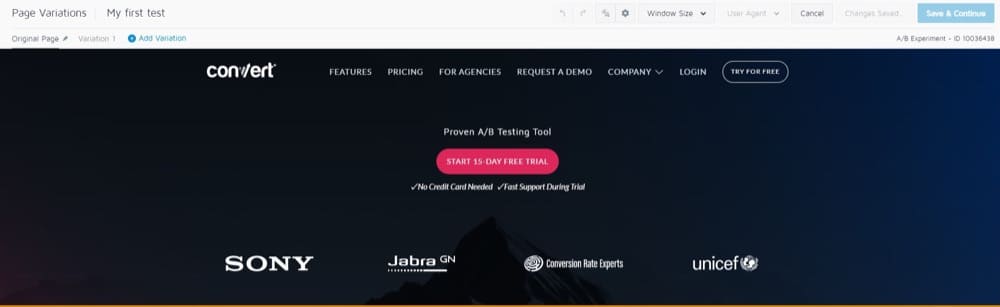

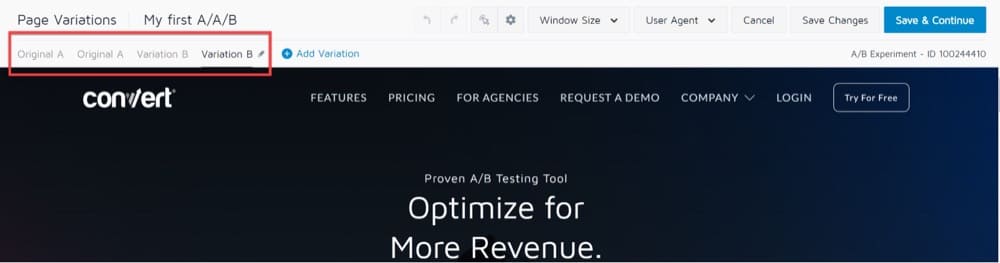

選択したURLと上部のツールバーを表示するビジュアルエディターが表示されます。

左上の[ページバリエーション]セクションで、デフォルトで[バリエーション1]が選択されていることがわかります。

つまり、このバージョンのURLに加えた変更は、元のURLには影響しません。

これにより、「A」バージョンが元のページで、「B」バージョンがバリエーション1である従来のA/Bテストが実行されます。

A / A/BまたはA/A / B / Bの場合、それぞれバリエーションAおよびバリエーションBと同一の別のバリエーションAおよび別のバリエーションBを追加する必要があります。

次のようになります。

「保存して続行」ボタンをクリックすると、すべて完了です。

多くのA/Aエクスペリエンスを実行する

これについてはすでに説明しましたが、大勢のユーザーを対象に1000回の連続したA / Aテストを実施し、すべての要件に従い、予測よりもはるかに頻繁に統計的に有意な結果を達成した場合、A/Bテストのフレームワークが壊れている可能性があります。

サンプルが適切にランダム化されていない可能性があります。 あるいは、2つのバリエーションは相互に排他的ではありません。

これは次のようになります。

A/Bエクスペリエンスと同時にA/Aエクスペリエンスを実行できますか?

同じWebサイトで、A/Bテストと同時にA/Aテストを実行する必要がある可能性があります。

その場合、いくつかの可能性があります。

- テストを同時に実行すれば、テストが互いに競合することを心配する必要はありません。

- 実験は同時に行うこともできますが、対象者は異なります。

- 正しい順序でテストを実行できます(テスト2(A / Bテスト)に進む前に、テスト1(A / Aテスト)を完了します)。

オプション3が最も安全ですが、エクスペリエンスの機能が大幅に制限されます。

同じページまたはページのセットで同時に複数のエクスペリエンスを実行することは完全に可能です。

ただし、ある実験でのバケット化は、同時に発生する別の実験のデータに影響を与える可能性があることに注意してください。

並列テストを実行するときに使用する2つの最も重要な変換手法は次のとおりです。

- トラフィックの50%をA / Aテストに割り当て、残りの50%のトラフィックが他の実行中のA/Bエクスペリエンスに入るのを許可します。

- 他のA/BテストからA/A訪問者を除外します。

テスト前のQAプロセス:A/Aテストの興味深い代替案

A / Aテストを実行するかどうかを決定するとき、答えはあなたが誰に尋ねるかによって異なります。 A/Aテストが論争の的となる問題であることは間違いありません。

A / Aテストに対する最も一般的な議論の1つは、時間がかかりすぎるということです。

A / Aテストはかなりの時間を消費し、多くの場合、A/Bテストよりもかなり大きなサンプルサイズを必要とします。

Webサイトの2つの同一バージョンを比較する場合、大きなバイアスを示すために高いサンプルサイズが必要です。

その結果、テストの完了に時間がかかり、他の重要なテストに費やす時間が短縮される可能性があります。

時間やトラフィックが少ない場合は、テスト前のQAプロセスの実施を検討することをお勧めします。

このブログ記事では、完全なQAプロセスを実行するために従う必要のあるすべての手順について説明します。 あなたが使用する方法はあなた次第であり、あなたがあなたの手にどれだけの時間を持っているかに依存します。

SRMはA/Aテストに存在できますか?

これを自問してみてください。A/Aテスト中に観察された実際のユーザー数は、半分に分割した場合、50/50の比率(または90/10の比率、またはその他の比率)に近いですか?

そうでない場合は、次の2つの問題のいずれかに直面します。コード内からテストインフラストラクチャを呼び出す方法に問題があるか(一方の側で「リーク」している)、テストインフラストラクチャに問題があります。割り当てメカニズム。

サンプル比率の不一致エラー(SRMエラー)は、A/Aテストで検出できる欠陥です。

比率が65/35のようなものになった場合は、同じターゲティング戦略を使用して別のA / Bテストを実行する前に、問題を調査する必要があります。

A / Aテストの長所は短所を上回りますか?

A / Aテストは月単位で実行するべきではありませんが、新しいA/Bツールをセットアップするときにデータをテストすることは価値があります。

誤ったデータを今すぐ見つければ、後でA/Bテストの結果に自信が持てるようになります。

最終的にはあなた次第ですが、新しいツールを使い始める場合は、A/Aテストを実施することを強くお勧めします。 そうでない場合は、厳密な事前テストQA手順を設定することをお勧めします。これは、A / Bテストによって時間、費用、およびトラフィックを節約できるためです。

上記のスクリーンショットがあなたの質問に答えてくれることを願っていますが、そうでない場合は、デモにサインアップして、ConvertExperiencesでA/Aテストを設定するのがいかに簡単かを自分で確認してください。