SEOウェブサイトの移行を処理する方法

公開: 2017-10-13ウェブサイトのライフサイクルにおいて、SEOウェブサイトの移行フェーズは、SEOに悪影響を与えないようにするために、多くの詳細に注意を払う必要がある重要な瞬間です。

サイトの移行はそれぞれ異なります。 移行は即座の結果を意味するものではありませんが、SEOを改善する絶好のタイミングです。 サイトが進化するとき、検索エンジンは常に同じタイミングであるとは限らず、多かれ少なかれ重要な適応の時期があることを理解する必要があります。 ただし、これはWebサイトが技術的な品質を向上させ、HTML5とjson-ldを使用してコードを強化し、内部リンクのアーキテクチャ、編集の豊富さのおかげでサイロ化し、強力なSEO信号を検索エンジンに返すための最も適切な時期です。

発生する変更に応じて、いくつかのタイプのサイト移行があり、通常、次の要素の1つ以上が関係します。

- ホスティング/IPアドレス

- ドメイン名

- URL構造

- サイトのアーキテクチャ

- コンテンツ

- デザインのコンセプト

最も困難なサイトの移行には、上記のほとんど(またはすべて)の変更が含まれます。

SEOの再設計が適切に管理されている場合、移行前と移行後に1つずつあります。 時間をかけてサイトの問題点を理解し、修正に取り組んでください。 パフォーマンスを向上させ、クロール性を容易にします。 あなたは長期的には勝者になるでしょう。

この記事では、安全なSEOWebサイト移行のベストプラクティスを提供します。

SEO Webサイト移行の主要な手順、アクション、およびドキュメント

制御された移行は、十分に準備された移行です。 したがって、一連の構造化手順に従うと効果的です。 これらの手順により、移行サイクル全体で信頼できる一連のドキュメントとデータを蓄積し、移行の良い(または悪い)影響を評価することもできます。

目的に応じたアクションと移行ドキュメントの一覧表を次に示します。

| 目標 | 行動 | ドキュメント |

| ウェブサイトの写真 | –予備のCrawlAggregateサーバーログデータ | クロールレポート テクニカルファイル(robots.txt、サイトマップ、古いリダイレクトファイル) クロールされた/クロールされていないURL、孤立したページ、およびそれぞれのクロール/日の頻度の表 |

| 外部ツールからのデータをコンパイル、集約、保存します | –データを読むGoogle Analytics、Omniture、AT Internet、検索コンソール(Bing / Google)、SemRush、MyPoseo、Majestic、SEObserver、… | 表現/ニッチによるポジション、クリック率、インプレッションのエクスポート 分析データのエクスポート バックリンクのエクスポート、TF / CF、ニッチ、 ニッチからのキーワードのエクスポート キーワード検索 データクロスオーバー |

| 改善すべき領域の特定 | –監査とデータ分析 | タスクリスト |

| 主題の優先順位付け | –利益/努力の評価 | ROIマトリックス |

| 仕様 | –利益/努力の評価 | SEOに適したコードの付録付きの要件式 |

| 製造 | - 発達 –知識の実装 | 重要なポイントに関するチームディスカッション 品質コード |

| 変更チェック | –技術レシピ –コード検証コード保証 | 比較クロールレポート 毎日の修正 報告する D日に行われるテストの検証 |

| 住む | –新しいコードとファイル(サイトマップ、robots.txt、リダイレクト)のデプロイ –新しいサイトの整合性テスト –新しいサイトマップの宣言 –検索コンソールでエンジンを強制的にクロールします | 新しいコードを本番環境に渡す 最新のXMLサイトマップファイルを確認する ロボットを検証します。 txtの最適化 該当する場合はリダイレクトファイル コードが期待され、本番環境で安定している |

| ライブモニタリング | –クロールオーバークロール –リダイレクトされたURLのクロール | データ比較に戻る KPIの開発に関するレポート |

移行前のデータのコンパイルと分析

予備クロール

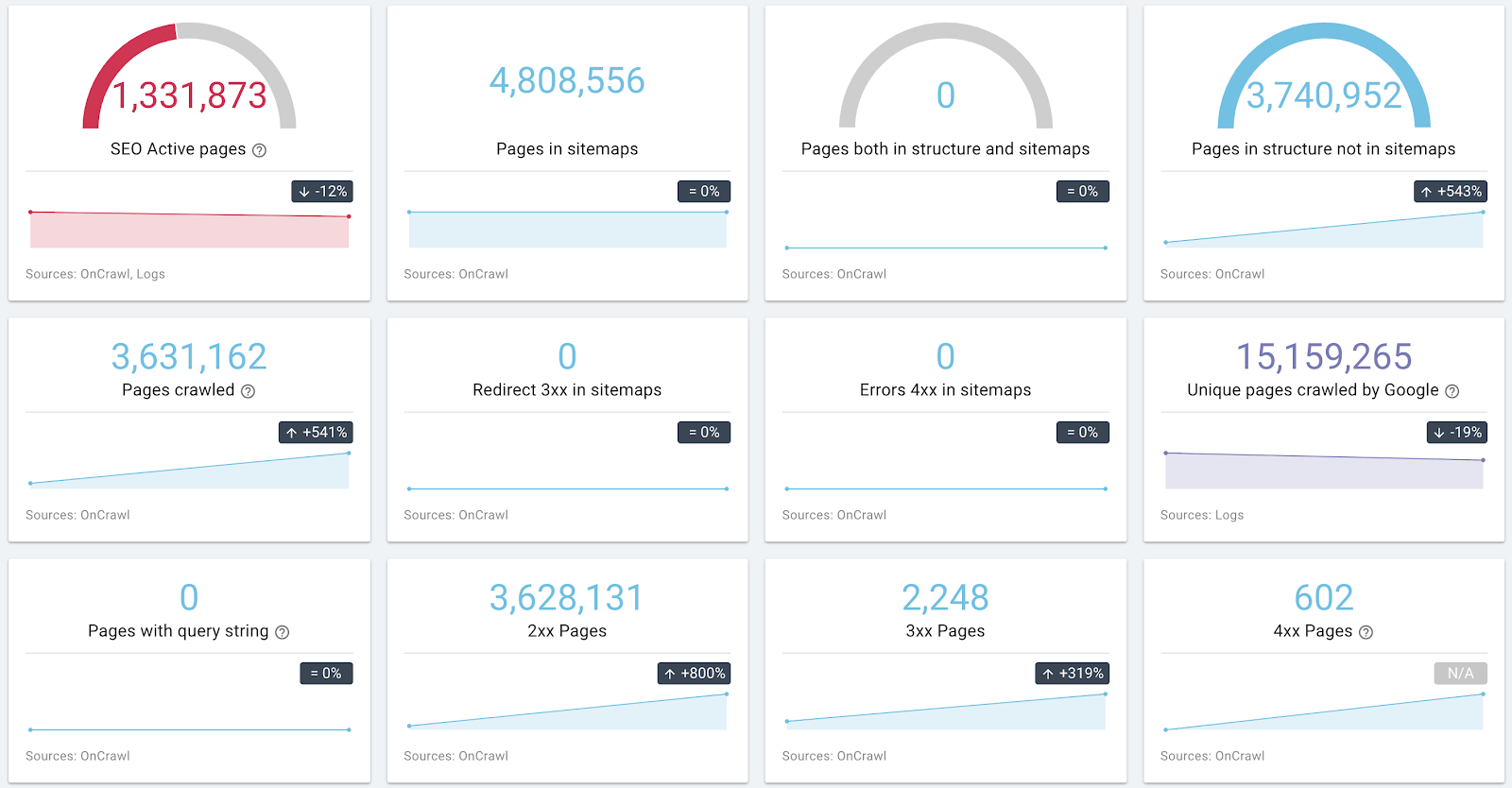

サイトの問題を理解することは、仕様の準備と移行監視KPIに不可欠です。 サイトをよりよく理解し、改善すべき領域を検出するために、移行前にサイトの完全な写真を作成することをお勧めします。

これを行うには、Googleが尊重する原則と同じ原則、つまりロボットを考慮した原則を尊重してクロールを開始します。 txtの後に、クエリ文字列を含むリンクが続きます。 移行に複数のサブドメインが含まれている場合、OnCrawlを使用すると、サブドメインを検出してクロールできます。

サイトのアーキテクチャとヘルスステータスに関する情報の例

ログデータを収集する可能性がある場合は、URLごとに収集することを躊躇しないでください。 クロール/ログの相互参照データを使用して、一連のページの成功要因を特定できます。

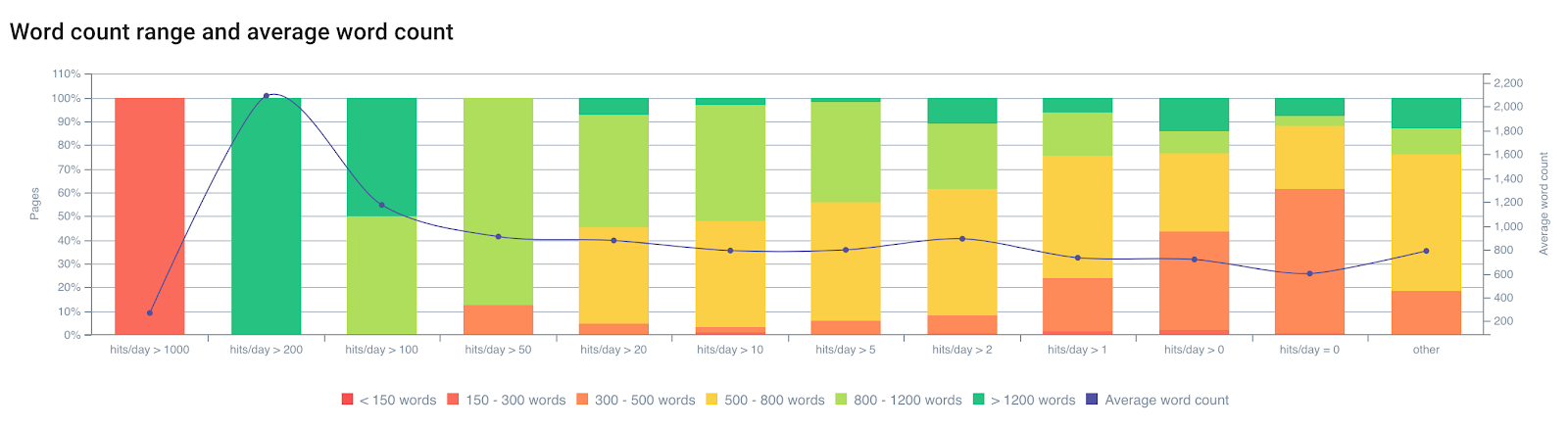

単語数に応じて1日あたりのボットヒット数を表示する

Googleのクロールは、ページ上のいくつかの要因の影響を受けることが経験からわかっています。 Googleはすべてのページを同じ頻度で閲覧するわけではありません。 これらのページのインデックスは更新されないため、ダウングレードする傾向があります。 インデックス内の廃止されたページは、必ずしもユーザーの要求に対する「ベストアンサー」ではなくなりました。 クロールの頻度、インデックスの更新、ランキングの間には強い関係があります。

次の場合、ページのクロールは少なくなります。

- アーキテクチャが深すぎます。

- 十分な単一のテキストが含まれていません。

- 十分な内部リンクがありません(外部リンクもあります)。

- ロードするのに十分な速さではないか、重すぎます。

- …など

ページ上の要素がGoogleのクロールに与える影響について詳しくは、「Google Importance Page」の記事をご覧ください。この記事では、「CrawlScheduling」に関連するGoogleの特許について詳しく知ることができます。

予備クロールにより、サイトを知ることができます。 また、最適化の検証のページとなるページを分類することもできます。 クロールにペナルティを課す要因を修正するために、予備分析ではこれらのデータを考慮に入れる必要があります。

外部ツールからのデータの読み取り

Google検索コンソール/Bing検索コンソール/Bing検索コンソール

GoogleとBingの検索コンソールには、定性的データと定量的データの両方があります。 改善を監視するためにこのデータを収集することは非常に良い習慣です。

このデータをもう一度クロスチェックして、自分自身を配置するページの一般的な機能、キーワードの欠落、モバイル/AMPまたはSEOエラーに関連する問題を理解することをお勧めします。

保存する重要なデータ:エラーの数と種類、クロールの予算(1日あたりのヒット数)と読み込み時間、HTMLの改善、インデックスに登録されたページの数、式とURLによる位置/CTR/インプレッション。

日ごとに調査されたページ–移行前/移行後の比較のために取られるクロール予算曲線

検索エンジンからのこれらのビューにより、サイトがどのように解釈されるかを理解できます。 また、KPIの移行後の監視の基礎にもなります。 エンジンによって報告されたSEOエラーを考慮に入れて、最初に修正することが重要です。

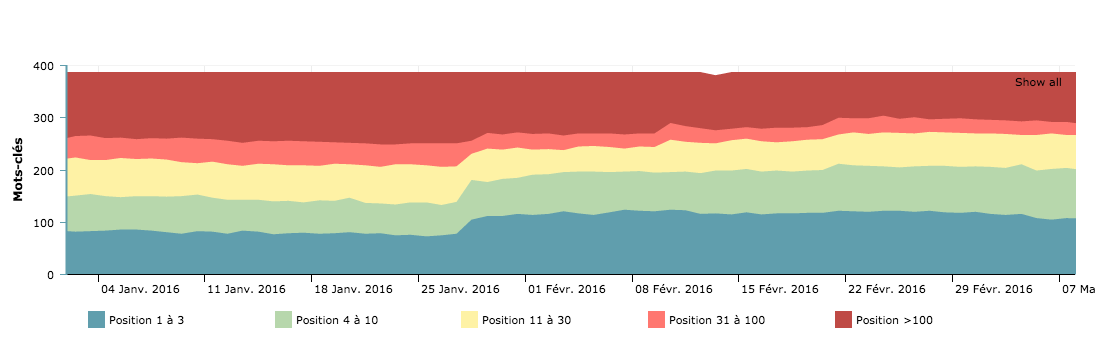

ランキングと可視性

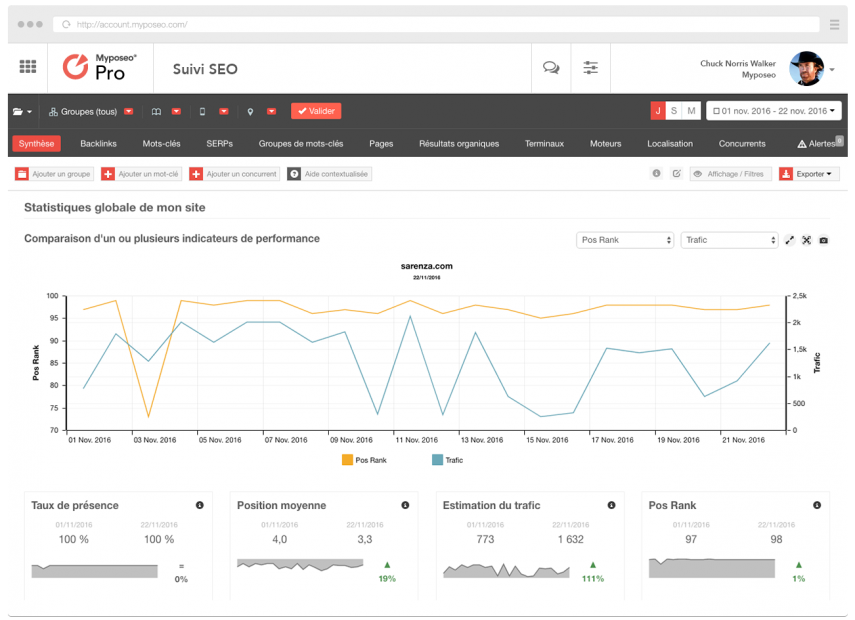

MyPoseoなどのポジショニング追跡ツールは、サイトの可視性とキーワードの調査を簡素化します。

Google検索コンソールのデータに加えて、ニッチでの可視率を知る必要があります。 このデータは、移行後の分析に不可欠です。

分析

追跡および分析ソリューションを使用して、ユーザーの使用状況データを収集できます。 また、オーガニック訪問、バウンス率、コンバージョントンネル、ルート、サイトの魅力など、ページのパフォーマンスに関する情報源でもあります。 改善すべき領域を検出し、ライブ分析のために保存できるデータをエクスポートする必要があります。

過去12か月間に少なくとも1回アクセスしたすべてのURLをGoogleAnalyticsを介してエクスポートすることは、多数の貴重なインデックス付きページを取得する1つの方法です。

アクションの優先順位付けのためにランディングページを分類し、レビューされていないページを見逃さないようにし、もう一度パフォーマンス要因を検出して、推奨事項に刺激を与えてください。

セグメンテーション

予備的なクロールと外部データの記録に続いて、移行境界の完全なビューが表示されます。 分析から、さまざまなメトリックに従ってグループ化できるページのセットを作成して、移行を限定することができます。

OnCrawlを使用すると、10セットまたは15グループのページのセットを作成できます。 この機能を使用して移行セットを作成してみませんか?

改善のために各領域に分類を作成します。 OnCrawlを使用すると、350を超えるメトリックに基づいてグループを作成できます。たとえば、受信リンクが少なすぎる、深すぎるなど、貧弱、重い、重複、ロボットによるアクセスがない、ユーザーによるアクセスが少ないなどです。 それらは、再設計を事後的に検証することを可能にします。

上級者向けのヒント:1秒以上応答するすべてのページ、クロールレートが低く、ランキングデータと人間の行動のクロスオーバー(GSCのCTRまたは分析のバウンスレート)のあるページをグループ化できます。 あなたは正しい決定を下すことができるでしょう。

クロール、ログ、分析データのクロスチェックは、移行の完全で現実的な分析を実行するための最良の方法です。

編集、作成、削除するページ

収集されたデータのおかげで、訪問数が最も多いページ、重複コンテンツ率が最も重要なページ、アーキテクチャで欠落しているページなどを特定できます。

再構築により、最もペナルティの高いSEOの問題とSEOコンプライアンスを修正するだけでなく、エンジンユーザーの重要な文章を中心にサイトを充実させて再調整できるようになることを覚えておく必要があります。 彼らはあなたのページに存在するデータを自分の言葉で検索します。 探索とセマンティック調整の作業は、しばしば見過ごされがちな作業ですが、ランキングの点で最高のパフォーマンスを実現します。

ユーザーのニーズに最も合うように、新しいハブページとランディングページを追加する必要があります。 それらは、サイトが最も適切に配置されていないクエリと一致している必要があります。

[ケーススタディ]あなたの再設計があなたのSEOにペナルティを課さないようにしてください

内部リンク管理

内部リンクは、SEOの再構築を成功させるための重要な要素の1つです。 アンカーのバリエーション、内部人気の拡散の最適化、およびアンカーのセマンティックアラインメントは強力な味方です。

OnCrawlによる最適化された内部リンクの表現

あなたのページの人気がさまざまなリンクブロックを通してどのように広がっているかを理解するために時間をかけてください。 ページ上の無関係なリンクをできるだけ減らすようにしてください。 最良の例はメガメニューです。

すべてのページからすべてのページへのリンクを作成することは避けてください。 これは逆効果です。 カテゴリヘッダーへのリンクを保持しながら、同じサイロにないリンクをHTMLコードから削除します。

ナビゲーションもロボットの罠です。 最も近い単位、数十、数百にジャンプできるアルゴリズムを使用して、ページ間にショートカットを作成してみてください。

ページを指すアンカーをできるだけ変更するようにしてください。 これにより、広いセマンティックフィールドを使用していることをエンジンに示し、ページの重要度スコア、つまりページのクロールを優先することができます。

また、魅力的で非常に人気のあるページが作成されないように、フッターリンクを縮小またはセグメント化することも検討してください。 CGUまたはニュースレターのサブスクリプションリンク、およびドメインからの送信リンクは、多くの内部ページランクリークです。 また、ソーシャルネットワークへのリンクにも注意してください。これらのサイトは多くの場合、あなたのサイトよりも大きく、サイトのページランクを上げます。

リダイレクション

物事がうまくいかない可能性があるため、このアクティビティには多くの注意が必要です。 現在のリダイレクトルールを取得して、新しいツリー構造がある場合はそれらを一致させることが重要です。 リダイレクト文字列を回避するには、古いリダイレクトルールを更新する必要があります。

また、301ですべての古いURLが新しいURLにリダイレクトされることを確認する必要があります。

テストクロールは、すべての古いURLのリストをエクスポートし、それらを最大深度1の開始URLに追加することで作成できます。

HTTPS移行の特定のケース(URL構造の変更の有無にかかわらず)では、すべての内部リンクが更新されていることを確認してください(HTTPSページからHTTPページへの内部リンクはありません)。 この操作を実行するための税関フィールドOnCrawlがあります。

上級者向けのヒント:ランク付けするページへのショートカットのページを作成し(ハブページのおかげで製品ページ)、読み込み時間を改善し、ページのコンテンツの量を増やし、サイトマップを作成して孤立したページ、正規のページを修正し、重複するコンテンツを減らします…

トラフィックの多いページには特別な注意が必要であることを強調することが重要ですが、SEOではすべてのURLが重要です。

トラフィックの多いページには特別な注意が必要であることを強調することが重要ですが、SEOではすべてのURLが重要です。

レシピフェーズ

移行のこの重要なフェーズは、ソースコードの間違いに注意する必要がある期間、または必要性の表現を理解する必要がある期間です。

検索エンジン開発プラットフォームの保護

htpasswdは、検索エンジンによってクロールされたステージングURLが表示されないようにするための推奨ソリューションです。 この方法では、ブロッキングrobots.txtファイルを実行したり、メタロボットを「禁止」したりしないようにすることもできます。 見た目よりも頻繁に発生します。

プロのヒント:開発中のサイトは、将来のサイトのコードを保証するためにISOである必要があります。

各コード配信の品質を確認してください

このフェーズでは、レシピプラットフォームで定期的にクロールを起動して、サイトが正しい方向に移動していることを確認する必要があります。 2つのバージョンを比較するには、CrawlOverCrawlを作成することをお勧めします。

それをチェックすることを躊躇しないでください:

- リンクジュースの転送と内部リンク。

- ページ深度の進化。

- エラー40xおよびこれらのページへのリンク。

- エラー50xおよびこれらのページへのリンク。

- タイトル、メタディスクリプション、ロボットタグの品質。

- ソースコードと重複コンテンツ要素の品質。

コードがW3Cに準拠していることを確認してください。 忘れがちですが、セマンティックデータにエラーが含まれていないこと、ソースコードが野心のレベルにあること、最適化ルールが境界全体に適用されていることは、Googleの最初の推奨事項の1つです。

プロのヒント:リダイレクトが新しいリダイレクトを指さないようにするには、古いリダイレクトルールを更新する必要があります。

すべての古いURLが301で新しいURLにリダイレクトされることを確認する必要があります。 テストクロールは、すべての古いURLのリストをエクスポートし、それらを最大深度1の開始URLに追加することで作成できます。

サイトマップ。 xmlファイル

コードが安定していて、すべてのURLがテストクローラーによって検出されたら、サイトのすべてのURLをエクスポートできます。 これにより、sitemap.xmlファイル(またはsitemap_index.xml)を作成できます。

robots.txtにアドレスを追加し、サイトのルートに配置します(ここで利用可能なサイトマップ仕様で推奨されています)

プロのヒント:サイトの大部分でサイトマップを作成すると、Google検索コンソールでサイトの各部分のインデックスを個別に追跡できます。

古いリダイレクトされたすべてのURLを使用してサイトマップファイルを作成し、エンジンがそれぞれを強制的に渡すようにします。

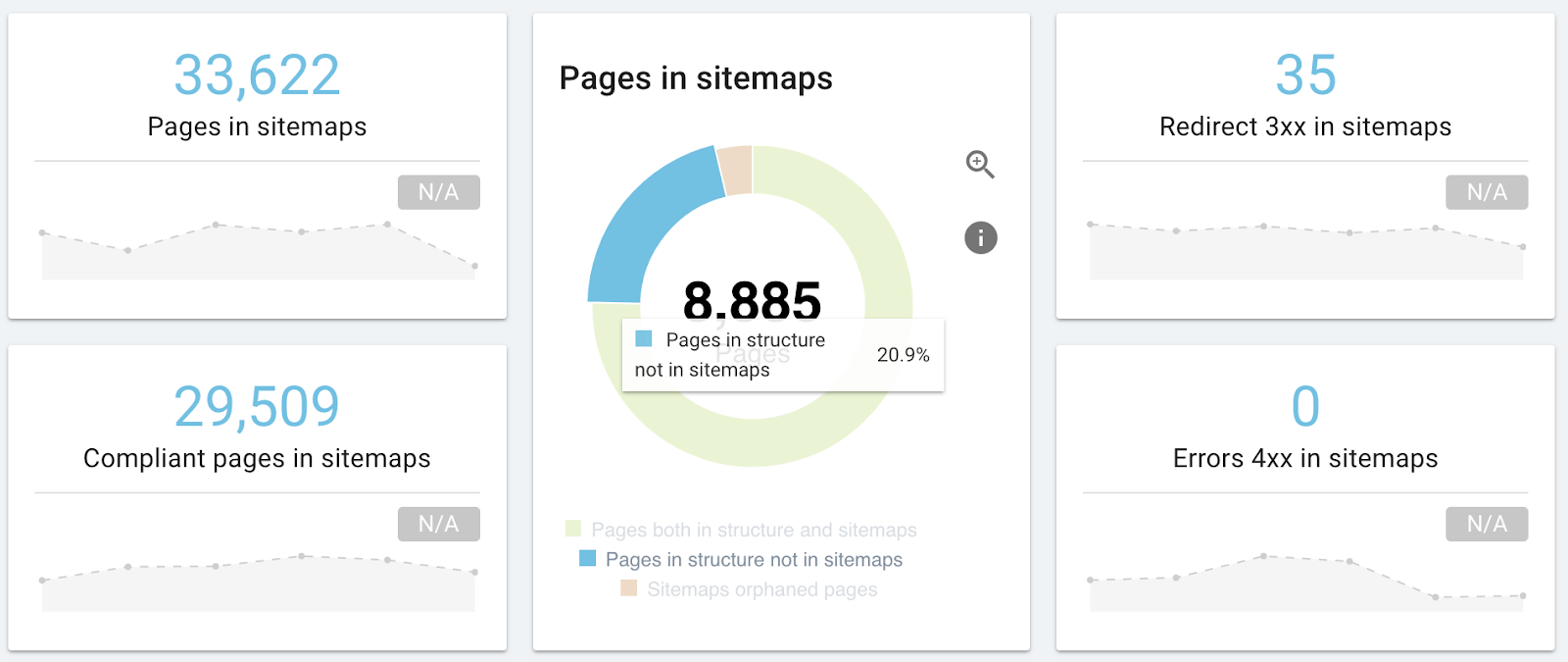

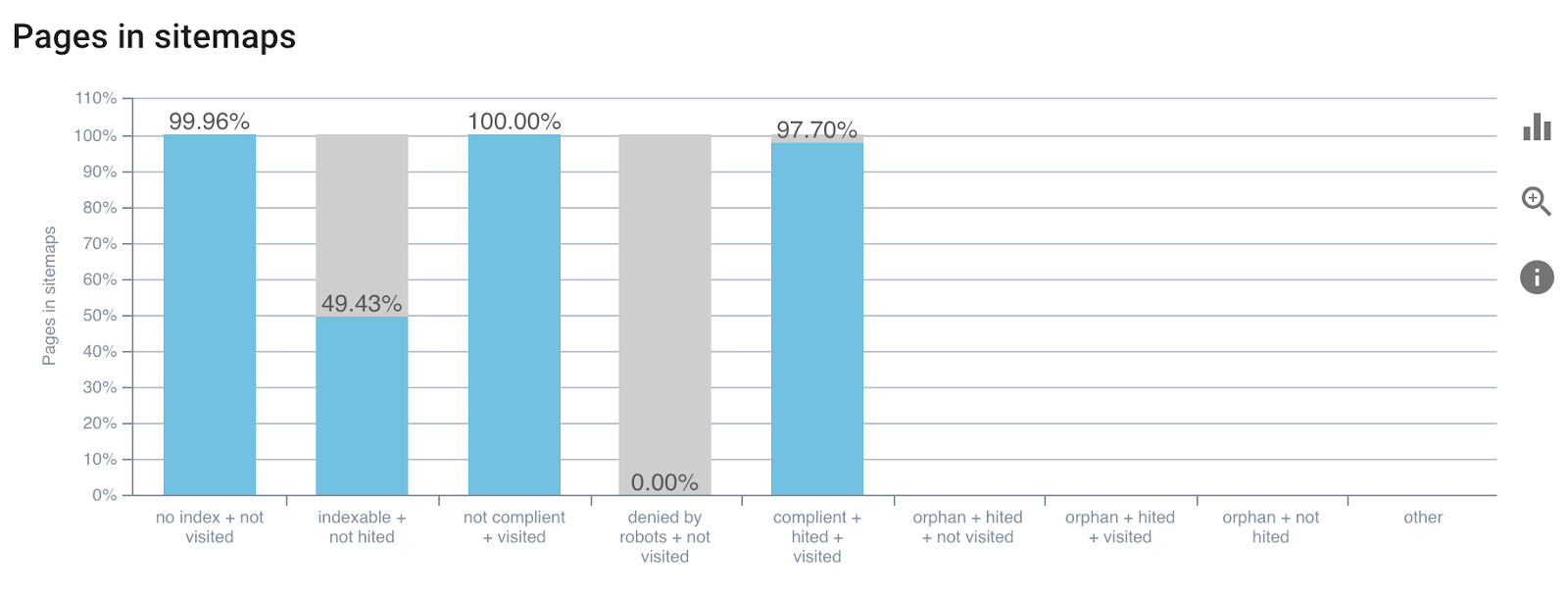

OnCrawlの最新バージョンには、sitemap.xmlの調査に関連するレポートが含まれます。 これにより、URLを見逃していないこと、サイトマップがURLとは異なる正規のページを指していること、または404を指していることを検証できます。

サイトマップ分析レポートの例

サイトマップの詳細については、こちらをご覧ください。 xml。

ライブバージョンへの移行日

レシピが終了し、コードがすべてのプレーヤーによって検証されます。 したがって、新しいコードをライブで渡すためのすべての信号が緑色になっています。 重要なページは特別な注意を払う価値があるため、SEOは影響を受けません。 ただし、あなたはGoogle側で実行されるすべてのアクションの保証人でもあります。

SEOとしてのタスクのリストは次のとおりです。

- robots.txtファイルを確認してください。

- オンラインでコードを確認してください。

- オンラインサイトマップを確認してください。

- リダイレクトを確認します。

すべてが大丈夫なら:

- モータークロールを強制する

- ログとステータスコードをライブで確認する

ステップごとに専用のクロールを開始できます。目的はページを限定することであるため、より狭い境界でクロールを使用して反応性を高めます。

プロのヒント:サイト全体をテストせずに、変更の参照ページをテストするために、最大深度1でクロールを定義します。

ライブフォローアップ

オンラインでの立ち上げに続いて、SEOの前後を比較し、移行がプラスの影響または最小限のマイナスの影響を及ぼしていることを確認できる必要があります。

新しいサイトが稼働したら、変更の影響を監視する必要があります。 最初のステップとして、ランキングとインデックス作成を毎週監視します。 結論を出すには短い月を待たなければならないと推定されているので、辛抱強くなければなりません。

移行後の異常な異常がないか、ウェブマスターツールでサイトのパフォーマンスを確認してください。

ランキングをチェックする前に、検索エンジンによるページのインデックス作成率とキャッシュを追跡してください。

冒頭で述べたように、エンジンは新しいバージョンに適応するのに時間がかかり、この期間中は位置がかなり変動する可能性があります。

移行の前後にCrawlOverCrawl(Crawl Over Crawl Comparison)を起動してデータを比較することは、効率を高めるための最良の方法です。

結論

移行はSEOにとって重要で、多くの場合有益な時期です。 OnCrawlは、これらのフェーズを通じてあなたに同行します。 最初のクロールから検証メトリックのフォローアップ、およびログによる検索エンジンの反応の分析まで、運用作業が簡素化されます。