ランキングのためにボットの放牧とスパイダーのラングリングを処理する方法は?

公開: 2020-01-23

Googleクローラーは、Webサイトで公開するすべてのコンテンツのインデックスを作成します。 これらのクローラーは、リンクとコードをたどり、それをアルゴリズムに配信するプログラムされたソフトウェアです。 次に、アルゴリズムがインデックスを作成し、コンテンツを膨大なデータベースに追加します。 このように、ユーザーがキーワードを検索するたびに、検索エンジンは、すでに索引付けされているページのデータベースから関連する結果を抽出してランク付けします。

Googleはすべてのウェブサイトにクロール予算を割り当て、クローラーはそれに応じてサイトのクロールを実行します。 Webサイト全体のインテリジェントなクロールとインデックス作成を確実にするには、クロールバジェットを管理および利用する必要があります。

この投稿では、検索エンジンのボット/スパイダーまたはクローラーがWebサイトをクロールしてインデックスを作成する方法を処理するためのトリックとツールについて学習できます。

1. Robot.txtの禁止ディレクティブの最適化:

Robots.txtは厳密な構文のテキストファイルであり、スパイダーがサイトをクロールする方法を決定するためのガイドのように機能します。 robots.txtファイルは、クローラーがURLを検索するWebサイトのホストリポジトリに保存されます。 これらのRobots.txtまたは「RobotsExclusionProtocol」を最適化するために、サイトのURLがGoogleクローラーによってクロールされて上位にランク付けされるのに役立ついくつかのトリックを使用できます。

それらのトリックの1つは、 「Disallow Directive」を使用することです。これは、Webサイトの特定のセクションに「RestrictedArea」の看板を置くようなものです。 Disallow Directiveを最適化するには、最初の防衛線である「ユーザーエージェント」を理解する必要があります。

ユーザーエージェントディレクティブとは何ですか?

各Robots.txtファイルは1つ以上のルールで構成されており、その中でユーザーエージェントルールが最も重要です。 このルールは、クローラーにWebサイト上の特定のリストへのアクセスと非アクセスを提供します。

したがって、user-agentディレクティブは、特定のクローラーにアドレス指定し、クロールの実行方法を指示するために使用されます。

一般的に使用されるGoogleクローラーの種類:

ディレクティブを許可しない:

これで、Webサイトをクロールするように割り当てられたボットについて学習した後、ユーザーエージェントのタイプに基づいてボットのさまざまなセクションを最適化できます。 Webサイトのdisallowディレクティブを最適化するために従うことができるいくつかの重要なトリックと例は次のとおりです。

- ブラウザに表示できる完全なページ名を使用して、disallowディレクティブに使用します。

- クローラーをディレクトリパスからリダイレクトする場合は、「/」マークを使用します。

- パスのプレフィックス、サフィックス、または文字列全体に*を使用します。

disallowディレクティブの使用例は次のとおりです。

#例1:Googlebotのみをブロックする

ユーザーエージェント:Googlebot

禁止:/

#例2:GooglebotとAdsbotをブロックする

ユーザーエージェント:Googlebot

ユーザーエージェント:AdsBot-Google

禁止:/

#例3:AdsBotクローラー以外のすべてをブロックする

ユーザーエージェント: *

禁止:/

2. Robots.txtの非インデックスディレクティブ:

他のWebサイトがサイトにリンクしている場合、クローラーにインデックスを付けたくないURLが公開される可能性があります。 この問題を解決するには、インデックス以外のディレクティブを使用できます。 見てみましょう、Robots.txtに非インデックスディレクティブを適用するにはどうすればよいですか?

Webサイトに非インデックスディレクティブを適用するには、次の2つの方法があります。

<メタ>タグ:

メタタグは、ページのコンテンツを短いシースルー方式で説明するテキストスニペットであり、訪問者は何が来るのかを知ることができますか? 同じことを使用して、クローラーがページのインデックスを作成しないようにすることができます。

まず、クローラーにインデックスを付けたくないページの「<head>」セクションにメタタグ「<metaname =“ robots” content =” noindex”>」を配置します。

Googleクローラーの場合、「<head>」セクションで「<metaname =” googlebot” content =” noindex”/>」を使用できます。

さまざまな検索エンジンクローラーがページを探しているため、インデックス以外のディレクティブの解釈が異なる場合があります。 このため、ページが検索結果に表示される場合があります。

したがって、クローラーまたはユーザーエージェントに従ってページのディレクティブを定義すると役立ちます。

次のメタタグを使用して、さまざまなクローラーにディレクティブを適用できます。

<meta name =” googlebot” content =” noindex”>

<meta name =” googlebot-news” content =” nosnippet”>

X-Robotsタグ:

クライアントまたは検索エンジンからの、場所やサーバーが提供するWebページに関連する追加情報の要求への応答として使用されるHTTPヘッダーについては誰もが知っています。 ここで、非インデックスディレクティブのこれらのHTTPヘッダー応答を最適化するために、Webサイトの任意のURLのHTTPヘッダー応答の要素としてX-Robotsタグを追加できます。

さまざまなX-RobotsタグをHTTPヘッダー応答と組み合わせることができます。 さまざまなディレクティブをコンマで区切ってリストに指定できます。 以下は、X-Robotsタグと組み合わせたさまざまなディレクティブを使用したHTTPヘッダー応答の例です。

HTTP / 1.1 200 OK

日付:2020年1月25日火曜日21:42:43 GMT

(…)

X-Robots-タグ:noarchive

X-Robots-タグ:unavailable_after:2020年7月25日15:00:00 PST

(…)

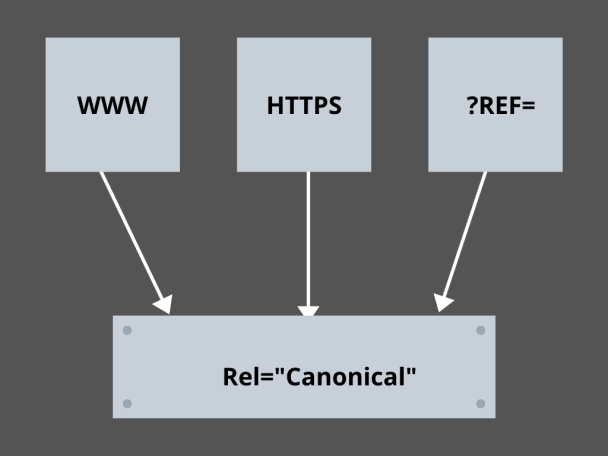

3.カノニカルリンクをマスターする:

今日のSEOで最も恐れられている要因は何ですか? ランキング? トラフィック? いいえ! それは重複したコンテンツのためにあなたのウェブサイトにペナルティを課す検索エンジンの恐れです。 したがって、クロール予算を戦略化するときは、重複するコンテンツを公開しないように注意する必要があります。

ここで、正規リンクをマスターすると、重複コンテンツの問題を処理するのに役立ちます。 重複コンテンツという言葉は、それが意味するものではありません。 eコマースWebサイトの2ページの例を見てみましょう。

たとえば、スマートウォッチ用の同一のページのペアを備えたeコマースWebサイトがあり、どちらも同様のコンテンツを持っています。 検索エンジンボットがURLをクロールすると、重複するコンテンツがないかチェックされ、任意のURLを選択できます。 それらをあなたにとって不可欠なURLにリダイレクトするために、正規リンクをページに設定することができます。 どうすればそれができるか見てみましょう:

- 正規バージョンの2ページから任意の1ページを選択してください。

- より多くの訪問者を受け入れるものを選択してください。

- 次に、rel =” canonical”を非正規ページに追加します。

- 非正規ページのリンクを正規ページにリダイレクトします。

- 両方のページリンクを1つの正規リンクとしてマージします。

4.ウェブサイトの構造化:

クローラーには、サイトの重要なURLを検出するためのマーカーと看板が必要です。また、Webサイトを構造化しないと、クローラーはURLに対してクロールを実行するのが困難になります。 このために、サイトマップを使用します。サイトマップは、クローラーにWebサイトのすべての重要なページへのリンクを提供するためです。

ウェブサイトやモバイルアプリ開発プロセスを通じて開発されたアプリの標準的なサイトマップ形式は、XMLサイトマップ、Atom、RSSです。 クロールを最適化するには、XMLサイトマップとRSS/Atomフィードを組み合わせる必要があります。

- XMLサイトマップは、クローラーにWebサイトまたはアプリのすべてのページへの道順を提供します。

- また、RSS / Atomフィードは、Webサイトのページの更新をクローラーに提供します。

- XMLサイトマップは、クローラーにWebサイトまたはアプリのすべてのページへの道順を提供します。

5.ページナビゲーション:

ページナビゲーションは、スパイダーにとって、さらにはWebサイトへの訪問者にとっても不可欠です。 これらのブーツはWebサイト上のページを検索し、事前定義された階層構造は、クローラーがWebサイトにとって重要なページを見つけるのに役立ちます。 より良いページナビゲーションのために従うべき他のステップは次のとおりです:

- HTMLまたはCSSでコーディングを維持します。

- ページを階層的に配置します。

- より良いページナビゲーションのために浅いウェブサイト構造を使用してください。

- ヘッダーのメニューとタブは最小限かつ具体的にしてください。

- ページのナビゲーションが簡単になります。

6.スパイダートラップの回避:

スパイダートラップは、クローラーがWebサイトをクロールするときに、同じページの同じコンテンツを指す無限のURLです。 これは、空包を撃つようなものです。 最終的に、それはあなたのクロール予算を使い果たします。 この問題はクロールごとにエスカレートし、トラップでクロールされるすべてのURLが一意ではないため、Webサイトには重複したコンテンツがあると見なされます。

Robots.txtでセクションをブロックするか、 followまたはno followディレクティブのいずれかを使用して特定のページをブロックすることで、トラップを解除できます。 最後に、無限のURLの発生を停止することにより、技術的に問題を修正することを検討できます。

7.リンク構造:

相互リンクは、クロール最適化の重要な部分の1つです。 クローラーは、Webサイト全体で適切に構造化されたリンクを使用して、ページをより適切に見つけることができます。 優れたリンク構造の秘訣は次のとおりです。

- 検索エンジンがテキストリンクを簡単にクロールするためのテキストリンクの使用: <ahref =” new-page.html”>テキストリンク</a>

- リンクでの説明的なアンカーテキストの使用

- ジムのウェブサイトを運営していて、すべてのジムの動画をリンクしたい場合は、次のようなリンクを使用できます-すべての<ahref =” videos.html”>ジムの動画</a>を自由に閲覧してください。

8. HTMLの至福:

HTMLドキュメントをクリーンアップし、HTMLドキュメントのペイロードサイズを最小限に抑えることは、クローラーがURLをすばやくクロールできるようにするために重要です。 HTML最適化のもう1つの利点は、検索エンジンによる複数のクロールが原因でサーバーの負荷が高くなることです。これにより、ページの読み込みが遅くなる可能性があります。これは、SEOや検索エンジンのクロールの兆候ではありません。 HTMLの最適化により、サーバーでのクロールの負荷を軽減し、ページの読み込みを高速に保つことができます。 また、サーバーのタイムアウトやその他の重大な問題によるクロールエラーの解決にも役立ちます。

9.シンプルに埋め込む:

今日のWebサイトでは、コンテンツをバックアップする優れた画像やビデオがなければコンテンツを提供できません。これにより、コンテンツが視覚的に魅力的で、検索エンジンのクローラーにとって入手しやすくなります。 ただし、この埋め込みコンテンツが最適化されていない場合、読み込み速度が低下し、ランク付けできるコンテンツからクローラーが遠ざかる可能性があります。

ここで、埋め込みコンテンツのHTMLに固執することで、検索エンジンからのクロールを改善できます。 AJAX、Javascriptなどのテクノロジーは、新機能を提供するのに非常に優れていますが、検索エンジンのクロールを非常に難しくします。

結論:

SEOとトラフィックの増加に重点を置くことで、すべてのWebサイトの所有者は、ボットの放牧とスパイダーのラングリングを処理するためのより良い方法を探しています。 しかし、解決策は、ウェブサイトで行う必要のあるきめ細かい最適化と、検索エンジンのクロールをより具体的にし、検索エンジンの結果ページで上位にランク付けできる最高のウェブサイトを表すように最適化できるクロールURLにあります。