Meta-analisi negli esperimenti controllati online: uno sguardo imparziale al potere e ai limiti di questo metodo scientifico

Pubblicato: 2022-09-28

Quanto è utile la meta-analisi nei test A/B e in altri esperimenti online?

È utile sfruttare l'apprendimento passato per migliorare la generazione di ipotesi? O la meta-analisi è solo una scusa pigra per fare affidamento semplicemente su "modelli collaudati" invece di basarsi su dati specifici della situazione per innovare all'interno della tua azienda attraverso l'esperienza?

Questo è un argomento di dibattito caldo. Alcuni sono favorevoli e altri fortemente contrari. Ma come puoi beneficiare di entrambi i punti di vista e apportare un valore tangibile al tuo programma di sperimentazione?

Ecco di cosa tratta questo post. In esso, lo farai

- Comprendi cos'è effettivamente la meta-analisi

- Guarda esempi di meta-analisi in azione

- Scopri perché la meta-analisi come concetto deve essere trattata con cautela (e rispetto) e

- Scopri come i team di sperimentazione possono eseguire la meta-analisi nel modo giusto

E con un bonus: vedrai anche due noti esperti di ottimizzazione del tasso di conversione discuterne da estremi opposti.

Entriamo in esso.

- Cos'è la meta-analisi?

- Esempi di meta-analisi in esperimenti controllati online

- Interessato a condurre la tua meta-analisi di test A/B?

- Meta-analisi: sì o no

- Meta-analisi: procedere con cautela?

- Non compromettere il rigore dei test e la ricerca dell'innovazione

- Meta-analisi: ingrassare il volano della sperimentazione?

- Meta-analisi: procedere con cautela?

- Se scegli di condurre (e utilizzare) la meta-analisi, tieni a mente quanto segue

- Scarsa qualità degli esperimenti inclusi nell'analisi

- Eterogeneità

- Bias di pubblicazione

Cos'è la meta-analisi?

La meta-analisi utilizza le statistiche per prendere una decisione dall'analisi dei risultati di più esperimenti. Viene dal mondo scientifico, dove i ricercatori mettono insieme i risultati di studi medici che affrontano lo stesso problema e usano l'analisi statistica per giudicare se un effetto è realmente presente e quanto sia significativo.

Negli esperimenti controllati online, in cui abbiamo test A/B, test multivariati e test divisi per prendere decisioni e trovare modi con le migliori prestazioni per raggiungere gli obiettivi aziendali, abbiamo preso in prestito la meta-analisi per sfruttare ciò che abbiamo già appreso da precedenti test per informare i test futuri.

Vediamo diversi esempi in natura.

Esempi di meta-analisi in esperimenti controllati online

Ecco 3 esempi di meta-analisi nel test A/B, come è stato utilizzato e cosa è stato trovato in ogni sforzo:

- Una meta-analisi empirica delle strategie di test A/B dell'e-commerce di Alex P. Miller e Kartik Hosanagar

Questa meta-analisi dei test A/B è stata pubblicata a marzo 2020. Gli analisti hanno studiato i test in modo specifico dal settore dell'e-commerce, con i dati raccolti da una piattaforma di test A/B SaaS. Consisteva in 2.732 test A/B condotti da 252 società di e-commerce con sede negli Stati Uniti in 7 settori in un arco di 3 anni.

Hanno analizzato questi test per fornire un'analisi solida di come i test sono posizionati nelle varie fasi del funnel di conversione dell'e-commerce.

Quello che hanno trovato è stato:

- Rispetto ad altri tipi di esperimento, i test sulle promozioni di prezzo e quelli posizionati sulle pagine delle categorie sono associati alle dimensioni degli effetti maggiori.

- La prova che la risposta dei consumatori alle diverse promozioni dipende da dove tali promozioni sono posizionate all'interno del sito di e-commerce.

- Mentre le promozioni relative ai prezzi dei prodotti sono più efficaci all'inizio della canalizzazione di conversione, le promozioni relative alla spedizione sono più efficaci alla fine della canalizzazione di conversione (sulle pagine dei prodotti e sui checkout).

Diamo un'occhiata a un altro esempio e cosa hanno trovato i ricercatori...

- Cosa funziona nell'e-commerce — Una meta-analisi di 6.700 esperimenti di Will Browne e Mike Swarbrick Jones

Con i dati di 6.700 grandi esperimenti di e-commerce principalmente nei settori del commercio al dettaglio e dei viaggi, Browne e Jones hanno studiato l'effetto di 29 diversi tipi di modifiche e hanno stimato il loro impatto cumulativo sulle entrate. È stato pubblicato a giugno 2017.

Come suggerisce il titolo dell'articolo, l'obiettivo era esplorare ciò che funziona nell'e-commerce eseguendo un'ampia meta-analisi. Ecco come potrebbero arrivare a questo potente riassunto: le modifiche all'aspetto del sito hanno avuto un impatto molto più trascurabile sulle entrate rispetto ai cambiamenti fondati sulla psicologia comportamentale.

La metrica delle entrate per visitatore (RPV) viene utilizzata per misurare questo impatto. Quindi, nei loro risultati, un aumento del +10% da un esperimento significa che l'RPV è aumentato del 10% in quell'esperimento.

Ecco alcuni altri risultati dell'analisi:

- I migliori interpreti (per categoria) sono stati:

- Scarsità (indicatori di borsa, ad esempio "Solo 3 rimasti"): +2,9%

- Social proof (informare gli utenti del comportamento degli altri): +2,3%

- Urgenza (timer per il conto alla rovescia): +1,5%

- Recupero abbandono (inviare messaggi agli utenti per mantenerli sul sito): +1,1%

- Consigli sui prodotti (upsell, cross-sell, ecc.): +0,4%

- Ma le modifiche estetiche all'interfaccia utente come quelle seguenti non erano efficaci:

- Colore (cambiare il colore degli elementi della pagina web): +0,0%

- Pulsanti (modifica pulsanti del sito Web): -0,2%

- Inviti all'azione (modifica del testo): -0,3%

- Il 90% degli esperimenti ha avuto un effetto sulle entrate inferiore all'1,2%, positivo o negativo

- Poche prove che i test A/B portino ad aumenti a due cifre delle entrate comunemente presenti nei casi di studio.

Ora aspetta. Prima di prendere questi risultati della meta-analisi come un vangelo, devi sapere che la meta-analisi degli esperimenti online ha dei limiti. Ne parleremo più tardi.

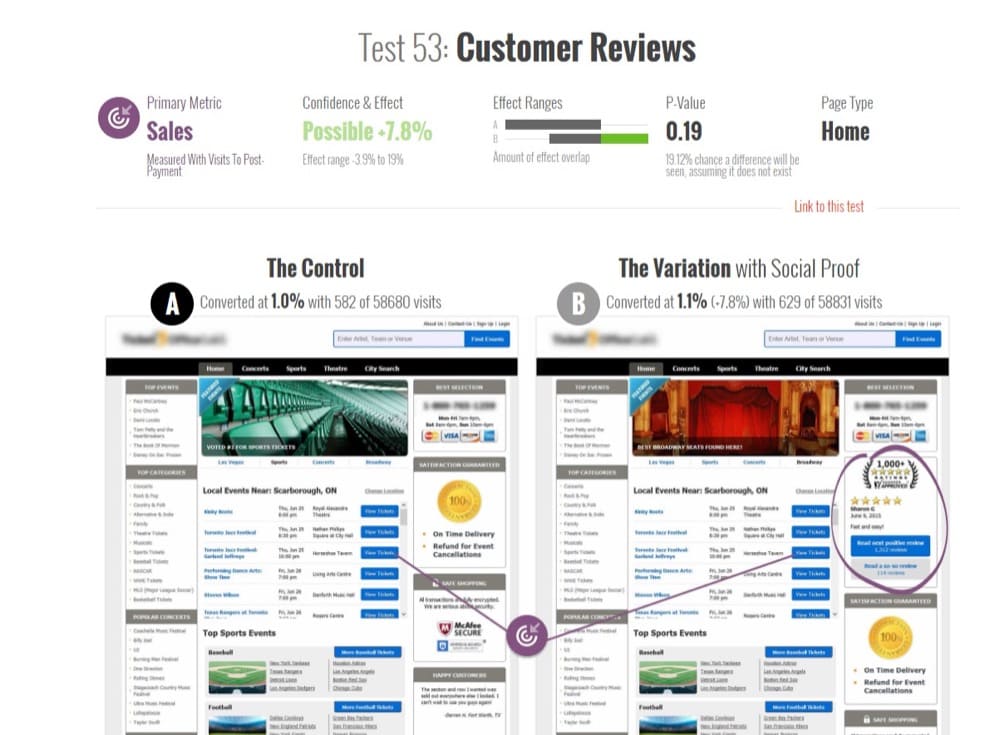

- Meta-analisi di 115 test A/B su GoodUI.org di Georgi Georgiev

Nel giugno 2018, Georgi Georgiev, esperto di sperimentazione online e autore di "Metodi statistici nei test A/B online", ha analizzato 115 test A/B disponibili pubblicamente su GoodUI.org.

GoodUI.org pubblica una raccolta di risultati della sperimentazione, inclusi i modelli dell'interfaccia utente scoperti di recente e ciò che aziende guidate dalla sperimentazione come Amazon, Netflix e Google stanno imparando dai loro test.

L'obiettivo di Georgi era quello di raccogliere e analizzare questi dati per rivelare i risultati medi dei test e contribuire con idee su migliori pratiche statistiche durante la progettazione e la conduzione di una meta-analisi dei test A/B.

Ha iniziato eliminando il set di dati iniziale e apportando alcuni aggiustamenti statistici. Questi includevano la rimozione:

- Test con squilibri tra il numero di utenti inviati a sperimentare il controllo rispetto a quelli inviati a sperimentare lo sfidante e

- Test compromessi (rilevati dal loro potere statistico irrealisticamente basso).

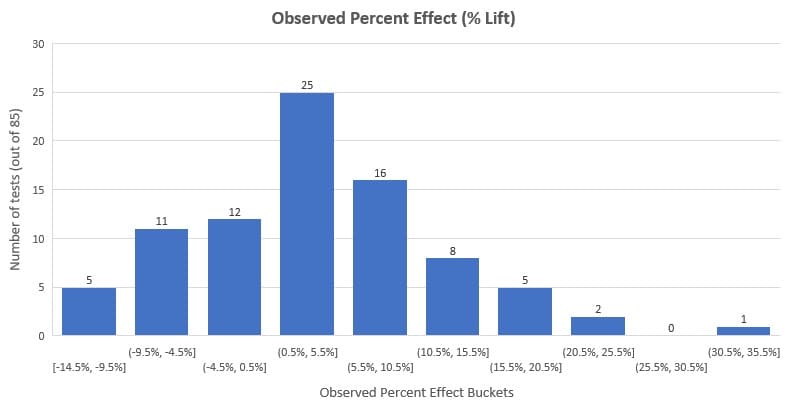

Ha analizzato i restanti 85 test e ha scoperto che l'incremento percentuale medio era del 3,77% e l'incremento mediano del 3,92%. Osservando la distribuzione di seguito, vedrai che il 58% dei test (che è la maggioranza) ha avuto un effetto osservato (incremento %) compreso tra -3% e +10%.

È importante notare che questo rappresenta questo set di dati e non tutti i test A/B mai eseguiti. Inoltre, dobbiamo tenere conto del bias di pubblicazione (uno degli svantaggi della meta-analisi di cui parleremo più avanti).

Tuttavia, questa meta-analisi è utile agli ottimizzatori del tasso di conversione e ad altre parti interessate dell'ottimizzazione per avere un'idea di quali siano i benchmark esterni nei test A/B.

Interessato a condurre la tua meta-analisi di test A/B?

Puoi accedere allo stesso set di dati utilizzato da Georgi. È disponibile pubblicamente su GoodUI.org, un repository di risultati distillati da test A/B condotti su piattaforme, settori e per diversi problemi principali.

Esistono altre raccolte di risultati di test A/B come questa (puoi anche creare i tuoi estraendo dati da numerosi esempi di test A/B e casi di studio) ma GoodUI è unico. Ottieni ulteriori informazioni statistiche sul test che altrimenti sarebbero impossibili da ottenere se stai navigando e raccogliendo casi di studio.

Alcune altre cose rendono GoodUI unico:

- Non discrimina sulla base dei risultati dell'esperimento. Include test vincenti, inconcludenti, piatti e negativi per combattere i bias di pubblicazione nella meta-analisi, che è un vero problema, come affermato in "Meta-analisi, trame a imbuto e analisi di sensibilità" di John Copas e Jian Qing Shi.

Il bias di pubblicazione è una preferenza per la pubblicazione di piccoli studi se i loro risultati sono "significativi" rispetto agli studi con risultati negativi o inconcludenti. Non puoi correggere questo senza fare ipotesi non verificabili.

- GoodUI fa un ulteriore passo avanti. Spesso i risultati delle meta-analisi giacciono sepolti nei documenti di ricerca. Non arrivano quasi mai all'applicazione pratica, soprattutto per i team di sperimentazione che non sono estremamente maturi.

Con i modelli GoodUI, gli ottimizzatori curiosi possono approfondire la variazione percentuale osservata, i calcoli della significatività statistica e gli intervalli di confidenza. Possono anche utilizzare la valutazione di GoodUI di quanto sia forte il risultato, con possibili valori di "Insignificante", "Possibile", "Significativo" e "Forte", andando in entrambe le direzioni per ciascun modello di conversione. Si potrebbe dire che "democratizza" le intuizioni dalle meta-analisi dei test A/B.

- Tuttavia, c'è un problema qui. Gli sperimentatori che potrebbero non essere consapevoli dei problemi che affliggono la meta-analisi - eterogeneità e bias di pubblicazione - oltre al fatto che i risultati della meta-analisi dipendono dalla qualità della meta-analisi stessa, possono virare nel territorio della copia cieca dei modelli.

Piuttosto, dovrebbero condurre le proprie ricerche ed eseguire i test A/B. In caso contrario, negli ultimi tempi (giustamente) è stato motivo di preoccupazione nello spazio CRO.

Un'altra risorsa di case study di test A/B che puoi approfondire per una profondità simile di dettagli su alcuni test come GoodUI è GuessTheTest.

DISCLAIMER : non stiamo scrivendo questo blog con l'intento di fare una panoramica o lodare i modelli di meta-analisi e conversione. Presenteremo semplicemente i pro ei contro, come discusso da esperti nel campo CRO. L'idea è di presentare la meta-analisi come uno strumento in modo da poterla utilizzare a propria discrezione.

Meta-analisi: sì o no

Una mente intelligente cerca modelli. È così che accorci il percorso dal problema alla soluzione la prossima volta che ti viene presentato un problema simile.

Questi schemi ti portano a una risposta in tempi record. Ecco perché siamo inclini a credere che possiamo prendere ciò che abbiamo imparato dagli esperimenti, aggregarli e dedurre uno schema.

Ma è consigliabile che i team di sperimentazione lo facciano?

Quali sono gli argomenti a favore e contro la meta-analisi negli esperimenti controllati online? Riesci a trovare una via di mezzo che ottenga il meglio da entrambi i mondi?

Abbiamo chiesto a due delle voci più vocali nel regno della sperimentazione con punti di vista (rispettosamente) diversi sulla loro interpretazione della meta-analisi.

Jonny Longden e Jakub Linowski sono voci di cui ti puoi fidare.

Meta-analisi: procedere con cautela?

Nella discussione di cui sopra, Jonny ha indicato due potenziali problemi con l'utilizzo dei dati di meta-analisi nei test online che richiedono ai professionisti del CRO di procedere con cautela.

- Problema n. 1: utilizzo di un risultato senza testarlo

“Se ha funzionato per quell'azienda, dovrebbe funzionare anche per noi”. Questo potrebbe rivelarsi un pensiero errato perché ci sono sfumature intorno ai test che non arrivano allo snippet dei risultati che stai esaminando.

Diversi test potrebbero dimostrare una soluzione semplice, ma questa è solo una probabilità che possa funzionare leggermente meglio di altre soluzioni e non una risposta definitiva che funzionerà sul tuo sito web.

- Problema n. 2: non è possibile classificare i test così facilmente

Come menzionato nel punto 1, quei risultati non mostrano la storia completa e ricca di sfumature dietro i test. Non vedi perché i test sono stati eseguiti, da dove provenivano, quali problemi precedenti esistevano sul sito Web, ecc.

Vedi solo che è stato un test sull'invito all'azione nella pagina del prodotto, ad esempio. Ma i database di meta-analisi li ordineranno in schemi specifici, anche se non rientrano esattamente in quei modelli.

Cosa significa questo per te, un utente del database di meta-analisi di test A/B o un ricercatore CRO che mette insieme il tuo database di meta-analisi per estrarre gli apprendimenti?

Non significa che la meta-analisi sia off limits, ma dovresti stare attento quando la usi. Che tipo di cautela dovresti prendere?

Non compromettere il rigore dei test e la ricerca dell'innovazione

Ricordiamo che la meta-analisi è un'idea statistica della comunità medica in cui gli esperimenti sono fortemente controllati per garantire la ripetibilità del risultato.

L'ambiente e altri fattori che circondano l'osservazione si ripetono in diversi esperimenti, ma non è lo stesso con gli esperimenti online. La meta-analisi degli esperimenti online raccoglie i loro dati indipendentemente da queste differenze.

Un sito Web è radicalmente e completamente diverso da un altro sito Web perché ha un pubblico molto diverso e cose molto diverse succedono. Anche se sembra relativamente simile, anche se è lo stesso prodotto, allora è ancora completamente e completamente diverso in milioni e milioni di modi, quindi non puoi controllarlo.

Jonny Longden

Tra le altre limitazioni, ciò influisce sulla qualità di ciò che possiamo chiamare vera meta-analisi.

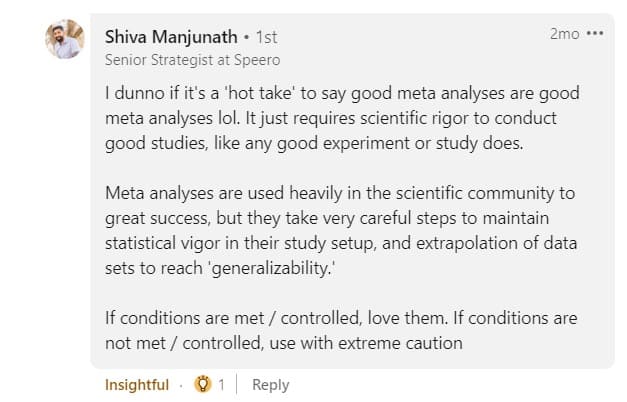

Quindi, dove non sei sicuro del livello di vigore statistico che è andato nei test e nella meta-analisi dei test, puoi usarlo solo con estrema cautela, come consiglia Shiva Manjunath.

L'obiettivo della meta-analisi non dovrebbe essere quello di copiare i concorrenti. Il passaggio dallo sfruttamento della meta-analisi alla copia diretta spinge i confini della credibilità. Ci sono sfumature nell'intento di "copiare", quindi non è certo una situazione in bianco e nero.

I commenti sul post di Deborah sopra erano vari. Va bene copiare in una certa misura, ma esagerare è pericoloso:

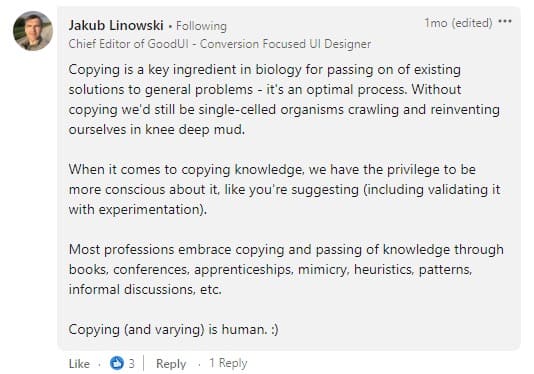

Come Jakub concorda, dobbiamo essere cauti nel copiare, specialmente quando si tratta di convalidare i modelli che abbiamo osservato con gli esperimenti.

Tuttavia, ciò da cui dovremmo stare in guardia è la sperimentazione mercifica . Cioè, utilizzare i modelli e le intuizioni della meta-analisi come migliori pratiche per sostituire la ricerca nella sperimentazione, invece di complimentarsi con ciò che i dati specifici della situazione hanno da dire.

Quindi, inizia con la comprensione del problema che vuoi risolvere e individua il tipo di intervento che ha maggiori probabilità di successo. È qui che la meta-analisi dei dati di sperimentazione legacy supporta al meglio una strategia di ottimizzazione unica.

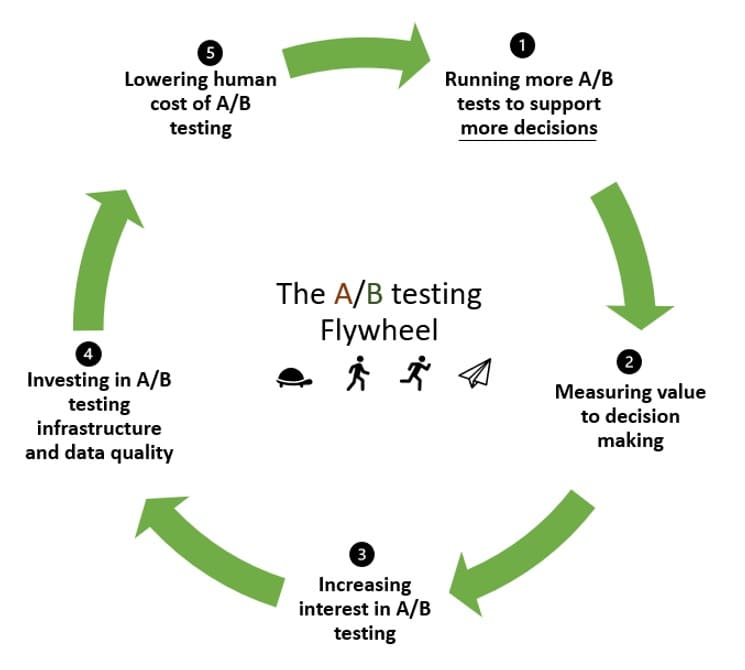

Meta-analisi: ingrassare il volano della sperimentazione?

Il volano della sperimentazione ha un modo per riciclare lo slancio. Quando stai sperimentando per la prima volta, hai bisogno di molta inerzia per mettere in moto le cose.

L'idea con il volano di sperimentazione è di capitalizzare questo slancio per eseguire più test e girare di nuovo, migliorando sempre di più, eseguendo sempre più test.

Ed è qui che la meta-analisi può aiutare. Nel volano:

- Esegui test per convalidare, si spera, le tue ipotesi (e forse rifiutarne alcune nel processo).

- Misura il valore che hanno aggiunto al processo decisionale.

- Incoraggiare più interesse e buy-in per i test A/B.

- Investi nell'infrastruttura di test A/B e nel miglioramento della qualità dei tuoi dati.

- Riduci il costo umano dei test A/B in modo che il passaggio successivo decolli con uno sforzo minore rispetto al round precedente.

Ma come organizzazione basata sui dati, non ti fermi qui poiché riconosci la potenza dei test A/B. Invece, vuoi sfruttare il tuo investimento iniziale nella sperimentazione per convalidare o rifiutare più ipotesi.

Se quell'intuizione o conoscenza iniziale non è lì per iniziare, l'inerzia per mettere in moto il tuo volano sarà troppo grande. La condivisione di questa conoscenza (democratizzando i dati dei test A/B) ispira e consente ad altri di adottare un approccio di sperimentazione abbassando la barriera della conoscenza.

Questo ci porta al punto n. 1 di come la meta-analisi ingrassa il volano della sperimentazione:

- La meta-analisi potrebbe ridurre il tempo necessario per ipotizzare idee.

Puoi prendere ciò che hai imparato, approfondimenti e tutto, dai test precedenti per generare facilmente nuove ipotesi. Ciò aumenta il numero di test eseguiti ed è un ottimo modo per accelerare il volano dei test A/B.

Dedichiamo meno tempo a rifare ciò che ha già stabilito schemi e più tempo a ritagliare nuovi percorsi sulla base di ciò che abbiamo appreso in esperimenti precedenti.

- La meta-analisi può portare a tassi di previsione migliori con i dati passati.

Un altro modo in cui l'apprendimento guidato dalla sperimentazione del passato può far girare più velocemente il volano della sperimentazione è quando viene combinato con i dati attuali per informare nuove ipotesi.

Ciò migliora potenzialmente il modo in cui l'impatto osservato in un test A/B si riversa nel futuro.

L'implementazione di un test A/B non garantisce di vedere il risultato desiderato poiché il tasso di false discovery (FDR) per i test con una significatività del 95% è compreso tra il 18% e il 25%. E solo il 70% dei test esaminati che hanno portato a questa conclusione aveva una potenza adeguata.

Il tasso di false discovery è la frazione dei risultati significativi dei test A/B che sono in realtà effetti nulli. Da non confondere con falso positivo o errore di tipo I.

- Infine, la meta-analisi potrebbe essere un modo per creare fiducia nei risultati dei test che sono essenzialmente inconcludenti.

I livelli di fiducia ti aiutano a credere che i risultati del tuo test non siano dovuti al puro caso. Se non ne hai abbastanza, potresti essere propenso a etichettare quel test come "inconcludente", ma non avere tanta fretta.

Come mai? Statisticamente, puoi accumulare valori p insignificanti per ottenere un risultato significativo. Vedi il post qui sotto:

La meta-analisi ha due vantaggi principali: 1) migliora l'accuratezza delle stime degli effetti e 2) aumenta la generalizzabilità dei risultati.

Fonte: Il buono, il brutto e il cattivo: meta-analisi di Madelon van Wely

Dato che una meta analisi regola e corregge sia la dimensione dell'effetto che i livelli di significatività, è possibile utilizzare risultati standard così elevati allo stesso modo in cui si utilizzano altri esperimenti, tra cui:

1) per effettuare calcoli di potenza/stime delle dimensioni del campione per i propri esperimenti (utilizzando dati reali anziché ipotesi soggettive)

2) prendere la decisione sull'exploit-esperimento. Nei casi in cui qualcuno ritiene che sia necessaria ulteriore fiducia, può decidere di eseguire ulteriori esperimenti per conto proprio. Nei casi in cui qualcuno trova le prove della meta-analisi sufficientemente solide, potrebbe semplicemente agire prima senza eseguire ulteriori esperimenti.

Jakub Linowski

Con tutti i modi in cui la meta-analisi può aiutare il tuo programma di sperimentazione a guadagnare più slancio, è importante tenere a mente che soffre di alcune limitazioni ben note.

Se scegli di condurre (e utilizzare) la meta-analisi, tieni a mente quanto segue

Sì, la combinazione dei risultati degli esperimenti tramite metodi meta-analitici può migliorare la precisione statistica, ma ciò non elimina i problemi fondamentali con il set di dati iniziale, come...

Scarsa qualità degli esperimenti inclusi nell'analisi

Se gli esperimenti inclusi nella meta-analisi sono stati impostati male e contengono errori statistici, non importa quanto sia accurato il meta-analista, otterranno risultati non validi.

Forse c'era un'allocazione ineguale della dimensione del campione nei test A/B, la potenza o la dimensione del campione erano insufficienti, o c'erano prove di sbirciare - qualunque sia il caso, quei risultati sono imperfetti.

Quello che puoi fare per aggirare questa limitazione è scegliere con attenzione i risultati del test. Elimina i risultati discutibili dal tuo set di dati. Puoi anche ricalcolare la significatività statistica e gli intervalli di confidenza per i test che hai scelto di includere e utilizzare i nuovi valori nella tua meta-analisi.

Eterogeneità

Questo sta combinando i risultati dei test che non dovrebbero essere messi nello stesso secchio in primo luogo. Ad esempio, quando la metodologia utilizzata per condurre i test è diversa (analisi statistica bayesiana vs frequentista, differenze specifiche della piattaforma di test A/B, ecc.).

Questa è una limitazione comune della meta-analisi in cui l'analista, consapevolmente o inconsapevolmente, ignora le differenze chiave tra gli studi.

Puoi guardare i dati quantitativi grezzi per combattere l'eterogeneità. È meglio che combinare solo il riepilogo dei risultati del test. Ciò significa ricalcolare i risultati di ogni test A/B, supponendo che tu abbia accesso ai dati.

Bias di pubblicazione

Conosciuto anche come "problema del cassetto dei file", questo è il problema più famigerato della meta-analisi. Quando conduci una meta-analisi sui dati disponibili pubblicamente, sei limitato a mettere in comune quei risultati che sono arrivati alla pubblicazione.

E quelli che non ce l'hanno fatta? Le pubblicazioni di solito favoriscono risultati statisticamente significativi e dove c'è un effetto del trattamento significativo. Quando questi dati non sono rappresentati nella meta-analisi, i risultati descrivono solo ciò che è stato pubblicato.

Puoi individuare la distorsione di pubblicazione con i grafici a imbuto e le statistiche corrispondenti.

Quindi, dove vai a trovare test A/B che non sono arrivati a casi di studio o database di meta-analisi di test A/B? Le piattaforme di test A/B sono nella posizione migliore per fornire dati sui test indipendentemente dai risultati. Ecco dove gli esempi 1 e 2 in questo articolo sono fortunati.