Che cos'è lo scraping dei dati e come puoi utilizzarlo?

Pubblicato: 2017-09-13Che cos'è lo scraping dei dati?

Lo scraping dei dati, noto anche come scraping web, è il processo di importazione di informazioni da un sito Web in un foglio di calcolo o in un file locale salvato sul computer. È uno dei modi più efficienti per ottenere dati dal Web e, in alcuni casi, per incanalare tali dati su un altro sito Web. Gli usi popolari dello scraping dei dati includono:

- Ricerca di contenuti web/business intelligence

- Prezzi per siti di prenotazione di viaggi/siti di confronto prezzi

- Trovare contatti di vendita/condurre ricerche di mercato eseguendo la scansione di fonti di dati pubbliche (ad es. Yell e Twitter)

- Invio dei dati di prodotto da un sito di e-commerce a un altro fornitore online (es. Google Shopping)

E quella lista sta solo grattando la superficie. Lo scraping dei dati ha un vasto numero di applicazioni: è utile praticamente in tutti i casi in cui i dati devono essere spostati da un luogo all'altro.

Le basi dello scraping dei dati sono relativamente facili da padroneggiare. Esaminiamo come impostare una semplice azione di scraping dei dati utilizzando Excel.

Data Scraping con query web dinamiche in Microsoft Excel

La configurazione di una query Web dinamica in Microsoft Excel è un metodo di scraping dei dati semplice e versatile che consente di impostare un feed di dati da un sito Web esterno (o più siti Web) in un foglio di calcolo.

Guarda questo eccellente video tutorial per imparare come importare dati dal Web in Excel o, se preferisci, utilizza le istruzioni scritte di seguito:

- Apri una nuova cartella di lavoro in Excel

- Fare clic sulla cella in cui si desidera importare i dati

- Fare clic sulla scheda "Dati".

- Fai clic su "Ottieni dati esterni"

- Fare clic sul simbolo "Dal web".

- Nota le piccole frecce gialle che appaiono in alto a sinistra della pagina web e accanto a determinati contenuti

- Incolla l'URL della pagina web da cui vuoi importare i dati nella barra degli indirizzi (ti consigliamo di scegliere un sito in cui i dati siano mostrati nelle tabelle)

- Fai clic su "Vai"

- Fare clic sulla freccia gialla accanto ai dati che si desidera importare

- Fai clic su "Importa"

- Viene visualizzata una finestra di dialogo "Importa dati".

- Fai clic su "OK" (o modifica la selezione della cella, se lo desideri)

Se hai seguito questi passaggi, ora dovresti essere in grado di vedere i dati dal sito web indicato nel tuo foglio di lavoro.

Il bello delle query web dinamiche è che non si limitano a importare i dati nel foglio di calcolo come un'operazione una tantum, ma li alimentano, il che significa che il foglio di calcolo viene aggiornato regolarmente con l'ultima versione dei dati, come appare sul sito web di origine. Ecco perché li chiamiamo dinamici.

Per configurare la frequenza con cui la tua query web dinamica aggiorna i dati che importa, vai su "Dati", quindi "Proprietà", quindi seleziona una frequenza ("Aggiorna ogni X minuti").

Raschiamento automatizzato dei dati con strumenti

Fare i conti con l'utilizzo di query Web dinamiche in Excel è un modo utile per acquisire una comprensione dello scraping dei dati. Tuttavia, se intendi utilizzare regolarmente lo scraping dei dati nel tuo lavoro, potresti trovare più efficace uno strumento di scraping dei dati dedicato.

Ecco i nostri pensieri su alcuni degli strumenti di scraping dei dati più popolari sul mercato:

Data Scraper (plug-in Chrome)

Data Scraper si inserisce direttamente nelle estensioni del browser Chrome, consentendoti di scegliere tra una gamma di "ricette" di scraping di dati già pronte per estrarre i dati da qualsiasi pagina Web caricata nel browser.

Questo strumento funziona particolarmente bene con fonti di scraping di dati popolari come Twitter e Wikipedia, poiché il plug-in include una maggiore varietà di opzioni di ricette per tali siti.

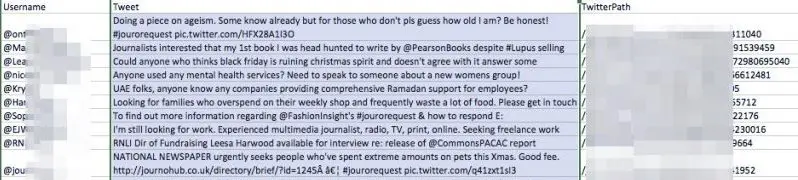

Abbiamo provato Data Scraper estraendo un hashtag Twitter, "#jourorequest", per opportunità di pubbliche relazioni, utilizzando una delle ricette pubbliche dello strumento. Ecco un assaggio dei dati che abbiamo ottenuto:

Come puoi vedere, lo strumento ha fornito una tabella con il nome utente di ogni account che ha pubblicato di recente sull'hashtag, più il loro tweet e il suo URL

Avere questi dati in questo formato sarebbe più utile per un rappresentante PR piuttosto che vedere semplicemente i dati nella visualizzazione del browser di Twitter per una serie di motivi:

- Potrebbe essere utilizzato per creare un database di contatti con la stampa

- Potresti continuare a fare riferimento a questo elenco e trovare facilmente quello che stai cercando, mentre Twitter si aggiorna continuamente

- L'elenco è ordinabile e modificabile

- Ti dà la proprietà dei dati, che potrebbero essere portati offline o modificati in qualsiasi momento

Siamo rimasti colpiti da Data Scraper, anche se le sue ricette pubbliche a volte sono leggermente approssimative. Prova a installare la versione gratuita su Chrome e divertiti con l'estrazione dei dati. Assicurati di guardare il filmato introduttivo che forniscono per avere un'idea di come funziona lo strumento e di alcuni semplici modi per estrarre i dati desiderati.

WebHarvy

WebHarvy è uno scraper di dati point-and-click con una versione di prova gratuita. Il suo più grande punto di forza è la sua flessibilità: puoi utilizzare il browser Web integrato dello strumento per navigare verso i dati che desideri importare e quindi creare le tue specifiche di mining per estrarre esattamente ciò di cui hai bisogno dal sito Web di origine.

import.io

Import.io è una suite di strumenti di data mining ricca di funzionalità che fa gran parte del duro lavoro per te. Ha alcune caratteristiche interessanti, tra cui "Cosa è cambiato?" rapporti che possono notificarti gli aggiornamenti a siti Web specifici, ideali per un'analisi approfondita della concorrenza.

In che modo i professionisti del marketing utilizzano lo scraping dei dati?

Come avrai capito a questo punto, lo scraping dei dati può tornare utile praticamente ovunque vengono utilizzate le informazioni. Ecco alcuni esempi chiave di come la tecnologia viene utilizzata dai marketer:

Raccolta di dati disparati

Uno dei grandi vantaggi dello scraping dei dati, afferma Marcin Rosinski, CEO di FeedOptimise, è che può aiutarti a raccogliere dati diversi in un unico posto. "La scansione ci consente di prendere dati non strutturati e sparsi da più fonti, raccoglierli in un unico posto e strutturarli", afferma Marcin. “Se hai più siti web controllati da entità diverse, puoi combinarli tutti in un unico feed.

"Lo spettro di casi d'uso per questo è infinito."

FeedOptimise offre un'ampia varietà di servizi di scraping e feed di dati, di cui puoi trovare informazioni sul loro sito Web.

Accelerare la ricerca

L'uso più semplice per lo scraping dei dati è il recupero dei dati da un'unica fonte. Se c'è una pagina web che contiene molti dati che potrebbero esserti utili, il modo più semplice per ottenere tali informazioni sul tuo computer in un formato ordinato sarà probabilmente lo scraping dei dati.

Prova a trovare un elenco di contatti utili su Twitter e importa i dati utilizzando lo scraping dei dati. Questo ti darà un assaggio di come il processo può adattarsi al tuo lavoro quotidiano.

Output di un feed XML su siti di terze parti

L'alimentazione dei dati di prodotto dal tuo sito a Google Shopping e ad altri venditori di terze parti è un'applicazione chiave dello scraping dei dati per l'e-commerce. Ti consente di automatizzare il processo potenzialmente laborioso di aggiornamento dei dettagli del tuo prodotto, che è fondamentale se il tuo stock cambia spesso.

"Lo scraping dei dati può generare il tuo feed XML per Google Shopping", afferma Ciaran Rogers, direttore marketing di Target Internet. “ Ho lavorato con un certo numero di rivenditori al dettaglio online che aggiungevano continuamente nuovi SKU al loro sito man mano che i prodotti entravano in magazzino. Se la tua soluzione di e-commerce non genera un feed XML adatto, puoi collegarlo al tuo Google Merchant Center in modo da poter pubblicizzare i tuoi prodotti migliori, questo può essere un problema. Spesso i tuoi ultimi prodotti sono potenzialmente i più venduti, quindi desideri che vengano pubblicizzati non appena vengono pubblicati. Ho utilizzato lo scraping dei dati per produrre inserzioni aggiornate da inserire in Google Merchant Center. È un'ottima soluzione e, in realtà, c'è così tanto che puoi fare con i dati una volta che li hai. Utilizzando il feed, puoi taggare i prodotti con la migliore conversione su base giornaliera in modo da poter condividere tali informazioni con Google Adwords e assicurarti di fare offerte più competitive su quei prodotti. Una volta impostato, è tutto abbastanza automatizzato. La flessibilità di un buon feed di cui hai il controllo in questo modo è eccezionale e può portare ad alcuni miglioramenti molto definiti in quelle campagne che i clienti amano".

È possibile configurare autonomamente un semplice feed di dati in Google Merchant Center. Ecco come si fa:

Come impostare un feed di dati su Google Merchant Center

Utilizzando una delle tecniche o degli strumenti descritti in precedenza, crea un file che utilizza una query dinamica del sito Web per importare i dettagli dei prodotti elencati nel tuo sito. Questo file dovrebbe aggiornarsi automaticamente a intervalli regolari.

I dettagli devono essere stabiliti come specificato qui.

- Carica questo file su un URL protetto da password

- Vai su Google Merchant Center e accedi (assicurati prima che il tuo account Merchant Center sia configurato correttamente)

- Vai a Prodotti

- Fare clic sul pulsante più

- Inserisci il tuo paese di destinazione e crea un nome feed

- Seleziona l'opzione "recupero pianificato".

- Aggiungi l'URL del file di dati del tuo prodotto, insieme al nome utente e alla password richiesti per accedervi

- Seleziona la frequenza di recupero che meglio corrisponde alla pianificazione di caricamento del prodotto

- Fare clic su Salva

- I tuoi dati di prodotto dovrebbero ora essere disponibili in Google Merchant Center. Assicurati solo di fare clic sulla scheda "Diagnostica" per verificarne lo stato e assicurarti che tutto funzioni senza intoppi.

Il lato oscuro dello scraping dei dati

Ci sono molti usi positivi per lo scraping dei dati, ma viene abusato anche da una piccola minoranza.

L'uso improprio più diffuso dello scraping dei dati è la raccolta delle e-mail: lo scraping dei dati da siti Web, social media e directory per scoprire gli indirizzi e-mail delle persone, che vengono poi venduti a spammer o truffatori. In alcune giurisdizioni, l'uso di mezzi automatizzati come lo scraping dei dati per raccogliere indirizzi e-mail con intenti commerciali è illegale ed è quasi universalmente considerato una cattiva pratica di marketing.

Molti utenti Web hanno adottato tecniche per ridurre il rischio che i raccoglitori di posta elettronica ottengano il loro indirizzo e-mail, tra cui:

- Address munging: modificare il formato del tuo indirizzo email quando lo pubblichi pubblicamente, ad esempio digitando 'patrick[at]gmail.com' invece di '[email protected]'. Questo è un approccio semplice ma leggermente inaffidabile per proteggere il tuo indirizzo e-mail sui social media: alcuni raccoglitori cercheranno varie combinazioni munged così come e-mail in un formato normale, quindi non è del tutto ermetico.

- Moduli di contatto: utilizzando un modulo di contatto invece di pubblicare i tuoi indirizzi email sul tuo sito web.

- Immagini: se il tuo indirizzo email è presentato sotto forma di immagine sul tuo sito web, sarà al di là della portata tecnologica della maggior parte delle persone coinvolte nella raccolta di email.

Il futuro dello scraping dei dati

Indipendentemente dal fatto che tu intenda utilizzare lo scraping dei dati nel tuo lavoro, è consigliabile informarti sull'argomento, poiché è probabile che diventi ancora più importante nei prossimi anni.

Ora sul mercato sono disponibili IA per lo scraping dei dati che possono utilizzare l'apprendimento automatico per continuare a riconoscere meglio gli input che solo gli esseri umani sono stati tradizionalmente in grado di interpretare, come le immagini.

Grandi miglioramenti nello scraping dei dati da immagini e video avranno conseguenze di vasta portata per i marketer digitali. Man mano che lo scraping delle immagini diventa più approfondito, saremo in grado di saperne di più sulle immagini online prima di averle viste noi stessi e questo, come lo scraping dei dati basato su testo, ci aiuterà a fare molte cose meglio.

Poi c'è il più grande data scraper di tutti: Google. L'intera esperienza della ricerca sul Web verrà trasformata quando Google può dedurre con precisione tanto da un'immagine quanto da una pagina di copia, e questo vale il doppio dal punto di vista del marketing digitale.

Se hai dei dubbi sul fatto che ciò possa accadere nel prossimo futuro, prova l'API di interpretazione delle immagini di Google, Cloud Vision, e facci sapere cosa ne pensi. ottieni ora la tua iscrizione gratuita - assolutamente non è richiesta la carta di credito

ISCRIZIONE GRATUITA