Trovare opportunità CRO utilizzando SEO crawler

Pubblicato: 2022-08-12

Gli esseri umani sono ancora necessari, ma, ragazzo, i crawler possono aiutare

Più a lungo faccio CRO, più mi rendo conto dell'importanza di diversi tipi di ricerca. Per molti anni mi sono occupato (e lo sono ancora in una certa misura) di dati quantitativi. Raggiungere una raccolta di dati pulita e affidabile in configurazioni di Google Analytics quasi perfette. Questo porterà ai migliori programmi CRO, giusto? Sicuramente ti fa iniziare in un posto fantastico, ma è solo un inizio.

In questo post, condividerò un flusso di lavoro interno dei risultati di ricerca che ho sviluppato negli anni dai miei giorni di analisi e SEO che ti aiuterà ad accelerare la tua ricerca nelle aree su cui il tuo programma CRO dovrebbe concentrarsi.

Incontra la rana urlante.

Risultati della ricerca (ricerca interna nel sito) Approfondimento

Sarebbe facile per me mostrarti le mappature degli intenti (sia per l'intento del ricercatore che per l'intento SERP) da mostrare quando manca la pertinenza (sia per le parole chiave che per i tipi di pagina). Forse verrà dopo, ma penso che sia stato fatto un bel po'.

Invece, voglio parlare di qualcosa di ancora più vicino alla conversione, i risultati di ricerca interni del tuo sito.

La ricerca sul sito è uno dei segnali più grandi che i tuoi utenti vogliono davvero qualcosa.

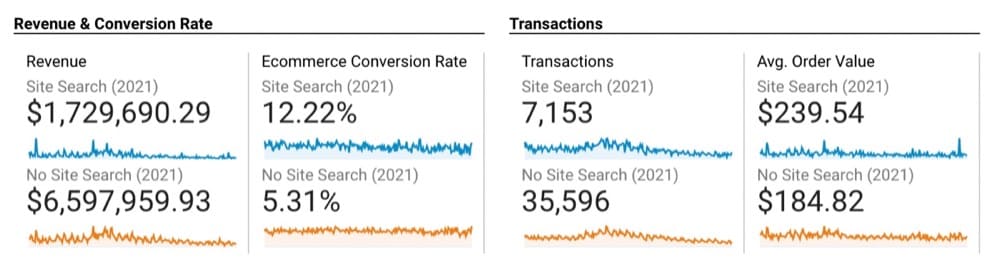

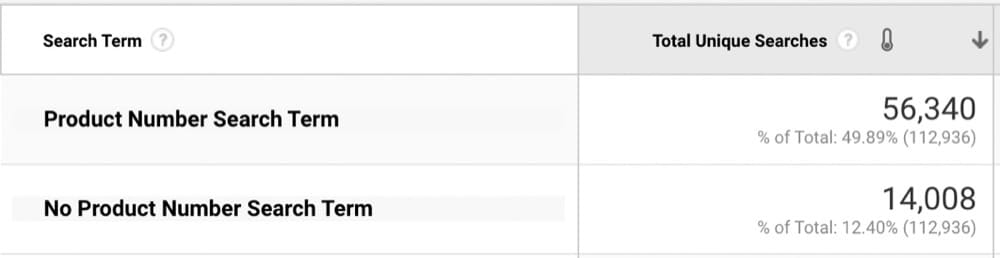

Possiamo vedere la differenza qui da questo sito di forniture per piscine dagli utenti che cercano rispetto a quelli che non lo fanno:

Il 130% in più di conversioni quando gli utenti effettuano ricerche non è eccessivamente sorprendente, ma mostra il potere di fornire la migliore esperienza di ricerca possibile.

Ora analizziamo i termini di ricerca per assicurarci che l'esperienza sia ottimizzata.

La mia prima raccomandazione è di scaricare tutti i termini di ricerca (gli ultimi 12 mesi di solito hanno più senso a meno che tu non sia altamente stagionale).

Quindi, eseguili attraverso uno strumento cluster per capire come le persone effettuano ricerche a un livello superiore (questo ti darà una direzione migliore rispetto alla setacciatura di migliaia di KW).

(Prima del raggruppamento, assicurati di standardizzare e pulire i tuoi KW per errori di ortografia e/o gestione dei casi diversa.)

Usa =trim(clean(lower(cell-number))) per la tua formula per ripulirli in Fogli Google.

Ora, copiali e incollali in Keyword Grouper Pro da MarketBold (questo è gratuito).

Per formare un gruppo, stimerai quanti in base al fatto che sto usando 1.000 parole chiave per iniziare, quindi supponendo che 10 per gruppo mi daranno la giusta quantità di gruppi qui. Non sai mai quanti gruppi vuoi, ma dovresti averne abbastanza per essere rappresentativo dei tuoi utenti che effettuano ricerche in base a quanti ne stai caricando (con l'uso migliorerai in questo).

tramite GIPHY

Vedendo le parole chiave raggruppate, le raggrupperei in alcune categorie diverse in base a come le persone cercano:

- Numeri di parte (non ottiene molto più fondo della canalizzazione di così)

- Marchi

- Tipi di categoria ampia

Ora posso essere più mirato con i termini di ricerca GA per sapere cosa cercare.

In questo scenario, poiché gli utenti che cercano numeri di prodotto hanno un'elevata intenzione di acquisto, vorrei iniziare da lì (e non solo guardare i primi risultati di ricerca "x"). Con alcune semplici espressioni regolari per isolare solo i numeri di prodotto (più di un numero nei termini di ricerca), scopriamo che l'80% delle ricerche contiene un numero di prodotto

Ora vorremo esportare i nostri risultati di ricerca da Google Analytics. Se hai molti termini di ricerca, potresti dover utilizzare l'API o uno strumento come il componente aggiuntivo Fogli Google di Google Analytics (è gratuito).

Ispezione dei risultati della ricerca (cosa stiamo cercando?)

Certo, è qui che ho iniziato per assicurarmi che non stessi andando nella tana del coniglio. Ma avendolo fatto troppe volte per poter contare adesso, sapevo cosa stavo cercando

Le "aree problematiche" qui variano in base alla piattaforma e al provider di ricerca che stai utilizzando. Per questo scenario, mi interessa principalmente:

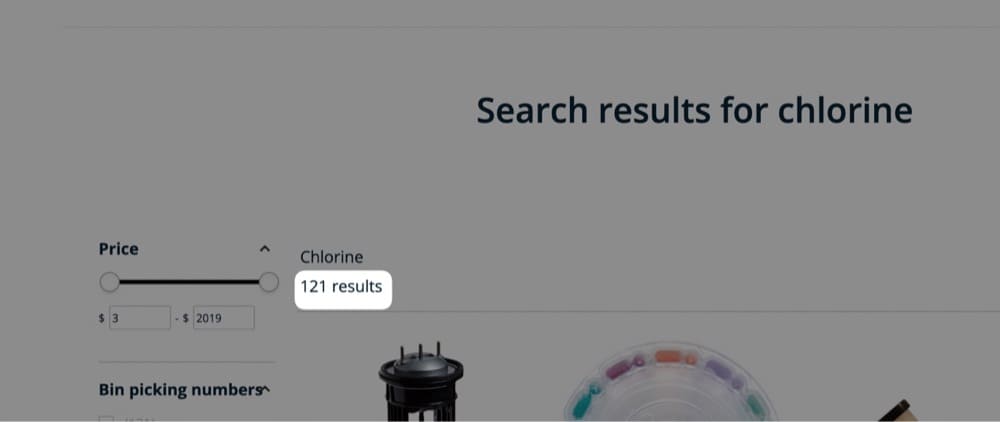

- il numero di risultati visualizzati

Mostrato qui:

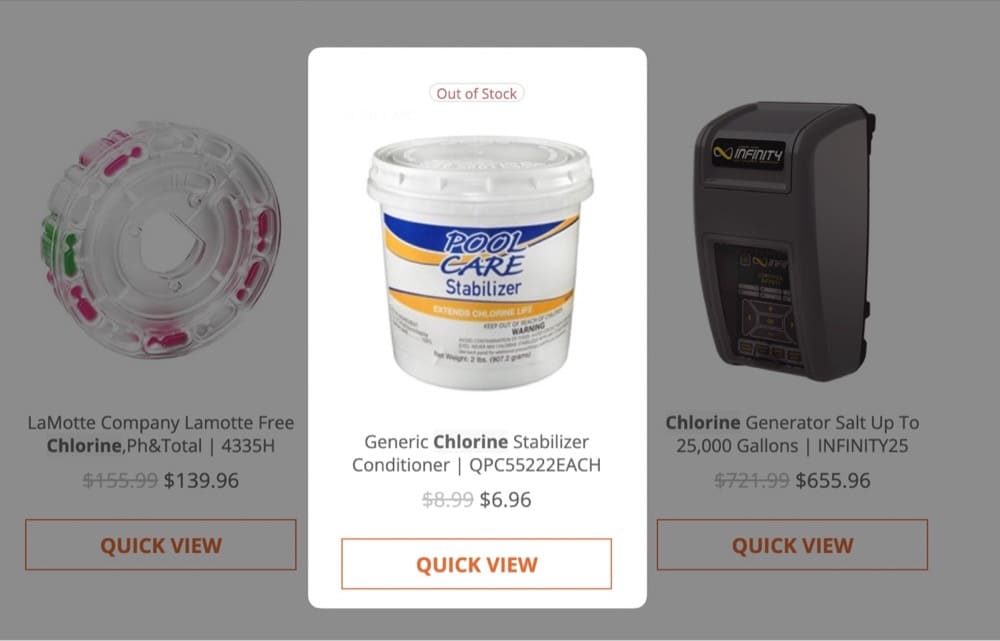

- Articoli mostrati esauriti

Mostrato qui:

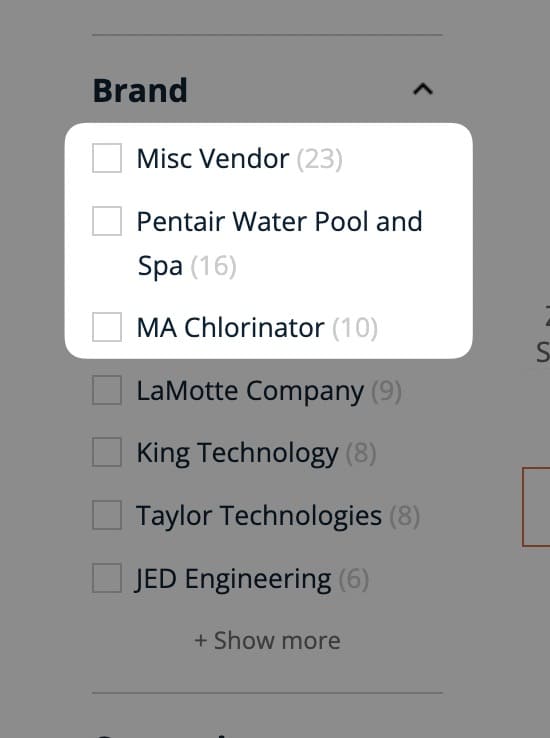

- Le prime 3 categorie in cui rientrano i risultati della ricerca (questo potrebbe essere ottenuto con un VLOOKUP in seguito, ma preferirei farlo qui/tutto in una volta)

Mostrato qui:

Le seguenti domande mi aiutano a capire i dati:

- Stiamo mostrando la giusta quantità di risultati di ricerca per queste ricerche di codici prodotto?

Con quasi tutti gli altri tipi di ricerca, avere un solo risultato non sarebbe ottimale, ma sulla base di queste ricerche ha senso mostrare solo 1 risultato. Ma è abbastanza importante che stiamo vedendo quell'unico risultato, comunque!

- Quali risultati di ricerca hanno restituito il maggior numero di prodotti bloccati?

Anche un po' più pertinente per le ricerche che restituiscono molti risultati.

- Quali categorie ottengono di più...

- Ricerche di prodotti?

- Hai il maggior numero di risultati esauriti?

- È stata restituita la quantità più bassa di risultati (che molto probabilmente si tradurrà in uscite più elevate)?

Utilizzo di Screaming Frog per imitare i risultati della ricerca

Ora arriva la parte divertente: usare Screaming Frog!

Non tratterò alcun aspetto su come usare Screaming Frog. È uno strumento molto complesso e anche se lo uso da quasi un decennio, c'è ancora molto che potrei probabilmente fare con esso.

Hanno ottime guide sul loro sito (che è anche il punto in cui lo scarichi all'indirizzo).: https://www.screamingfrog.co.uk/seo-spider/user-guide/ (il costo è di $ 151,77 all'anno ed è incredibilmente basso per cosa può fare.)

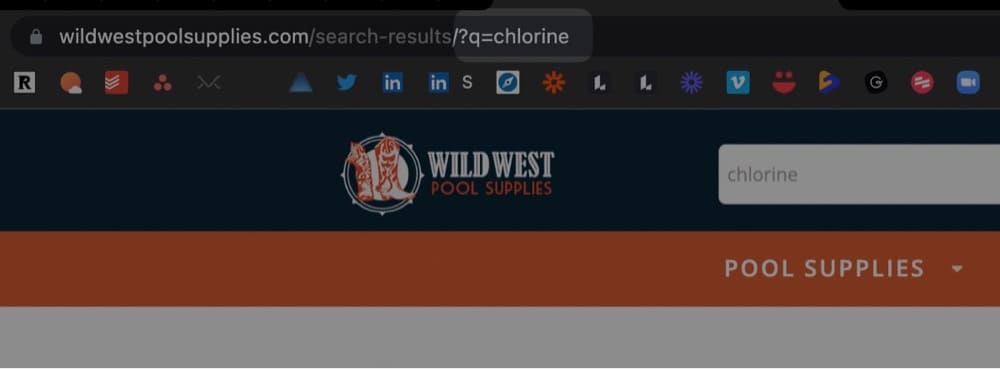

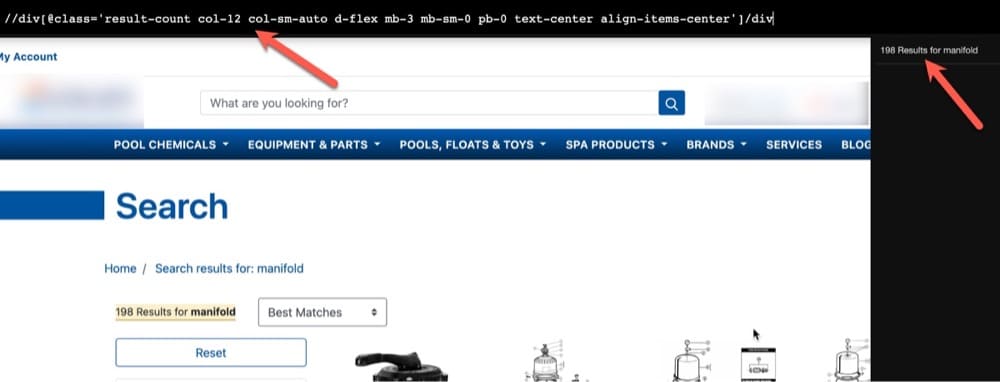

L'ultimo pezzo di "attenzione ai dettagli" è guardare l'URL del tuo sito dopo aver cercato per vedere il modello:

Questo è importante da sapere, poiché aggiungeremo il termine di ricerca di Google Analytics agli URL del sito in modo che corrisponda a questo modello. Imiteremo un utente che cerca questo con il crawler ed estrarremo le aree di interesse che abbiamo già trattato (risultati di ricerca, esaurito e categorie).

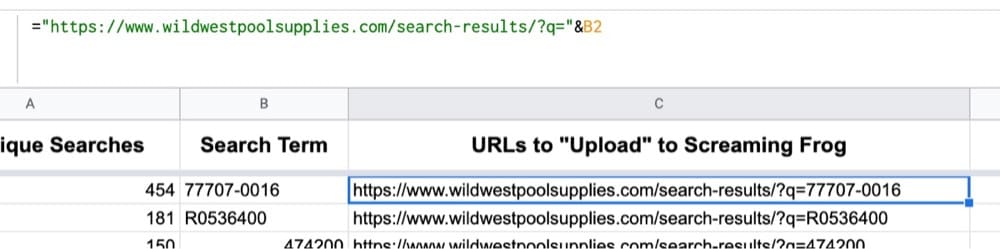

- Prendi tutto prima del termine di ricerca nell'URL:

- Combina quella stringa URL con il termine di ricerca:

Nota: se hai spazi nei termini di ricerca, dovrai utilizzare espressioni regolari o JS avanzate per aggiungere un %20 nell'URL. Personalmente uso TextSoap per queste manipolazioni.

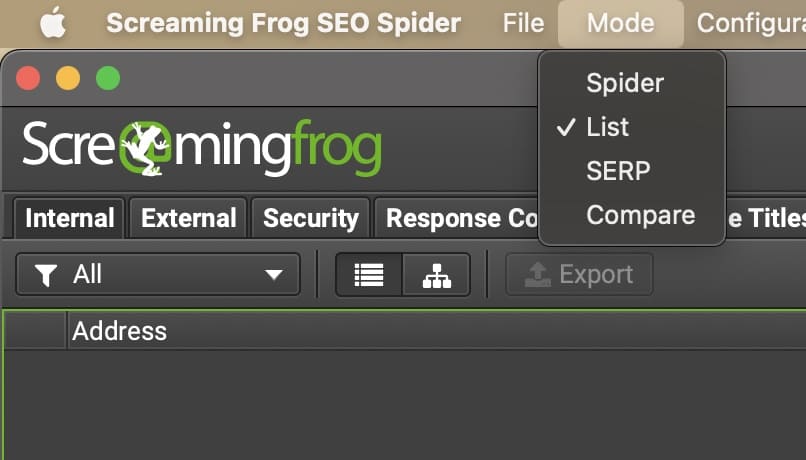

- Apri Screaming Frog e passa alla modalità Elenco:

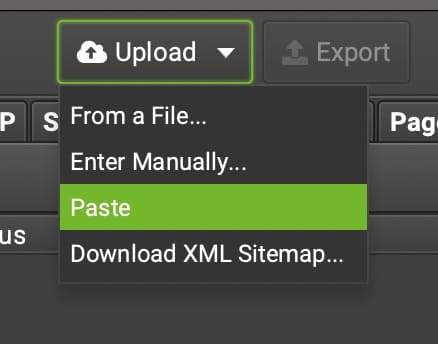

- Scegli come vuoi caricare il tuo elenco di URL (non incollarli se hai più di 10.000, il caricamento impiegherà un'eternità):

- Prima di eseguire il tuo crawler, ti consigliamo di trovare un modo per estrarre gli elementi necessari dal sito.

Mostrerò i risultati della ricerca qui in SF e il resto puoi scegliere come vuoi estrarre.

1. Ti consigliamo di estrarre il numero di risultati di ricerca per sapere quanti risultati stanno tornando quando viene ricercata questa parola chiave. Per farlo, useremo XPATH (la mia lingua preferita di solito in fantascienza).

2. Di solito mi piace provare prima il modo più semplice possibile, quindi ispezionare l'elemento solo quando necessario. #WorkSmarter con l'estensione XPather chrome.

GIPHY

3. Questo mi dà l'XPATH di cui ho bisogno, insieme a un'anteprima dell'"output" di ciò che molto probabilmente vedrò in Screaming Frog.

4. Nota: non mi preoccuperò di estrarre solo il numero dei risultati. Questa è una pulizia di 5 secondi in Fogli Google.

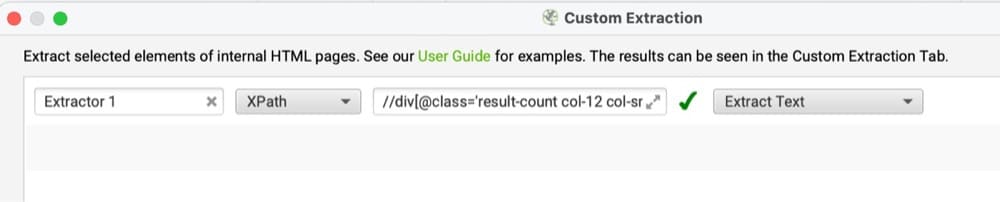

5. Ora posso inserirlo in SF nella sezione Configurazione → Personalizzato → Estrazione, visto qui:

6. Cambierò l'output in Estrai testo per ripulirlo di più e tralasciare HTML non necessario.

7. Dopo aver fatto clic su OK, sarai in grado di eseguire la scansione degli URL specificati che hai caricato in precedenza (o forse non ancora). (Ancora una volta, il motivo per cui abbiamo caricato gli URL era evitare di eseguire la scansione dell'intero sito e di eseguire la scansione solo dei termini di ricerca a cui teniamo.)

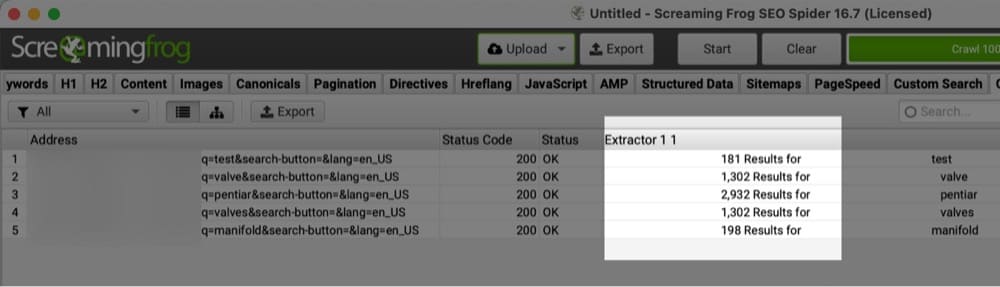

8. Ecco un esempio dell'output per una manciata di URL e il numero di risultati di ricerca restituiti da quei termini di ricerca:

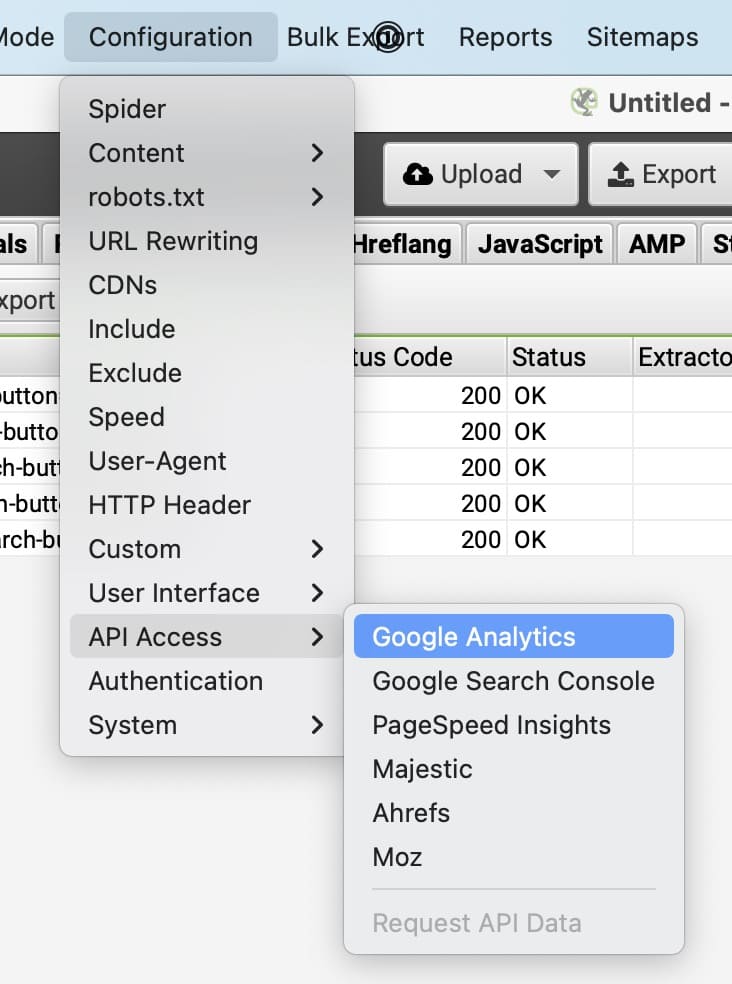

9. Successivamente, probabilmente vorresti sapere con quale frequenza si verificano tali ricerche. Qui è dove puoi connettere Google Analytics per vedere i conteggi delle visualizzazioni di pagina per gli URL corrispondenti.

10. Personalmente trovo utile qui creare un "rapporto" tra pagine di ricerca elevate e un numero basso di risultati restituiti.

Inoltre, esiste una correlazione tra un numero basso di risultati e uscite elevate su quelle pagine? (Vedo che ciò si verifica quando ci sono meno di 10 risultati, il che significherebbe che i risultati della ricerca non sembrano "completi" poiché la maggior parte dei siti non ha più di 5 larghezze per riga.)

11. Altri punti dati utili che potresti utilizzare qui (in base a come vengono visualizzati i risultati della ricerca e la navigazione a faccette):

Quali risultati di ricerca restituiscono il maggior numero di risultati esauriti? (Se non puoi intraprendere alcuna azione, come ricevere una notifica quando quel prodotto è disponibile, potresti pensare di rimuoverlo dai risultati di ricerca.)

Mappatura dei termini di ricerca alle categorie (e sottocategorie se pertinenti). Aiuta a comprendere la domanda nel tempo da parte degli utenti e alimenta molte informazioni diverse, dai nuovi test alla personalizzazione di parole chiave ambigue su come funziona l'ordinamento dei risultati.

Ricerche di prodotto #, come mostrato in precedenza. La maggior parte delle persone non eseguirà più ricerche se il loro prodotto # non restituisce nulla. Potrebbe non essere una soluzione immediata, ma potresti mostrare un pop-up con l'intenzione di uscita per ricevere una notifica quando quel prodotto sarà di nuovo disponibile.

Usa l'URL come variabile da trasmettere in qualsiasi forma tu stia utilizzando per il tuo provider pop-up in modo da sapere quale prodotto # stanno cercando.

Potrei continuare qui, ma si spera che questi esempi abbiano aiutato a dipingere un quadro migliore di come puoi raschiare i tuoi risultati di ricerca per ottenere informazioni migliori sul tipo di esperienza che stanno fornendo agli utenti.

Nota: potresti aver notato che ho cambiato sito che sto estraendo da qui. Quando ho iniziato questo post sul blog, il primo sito utilizzava un provider di ricerca diverso, poi è cambiato e volevo mostrare un esempio migliore basato su XPATH rispetto all'immersione in altri metodi (questo è solitamente il metodo più affidabile, insieme a CSS selettori).

Seconda nota: filtra l'indirizzo IP del tuo crawler in Google Analytics in modo da non contare te stesso nelle tue visualizzazioni di pagina #s. Se attivi il tag di visualizzazione di pagina 2-3 secondi dopo il caricamento della finestra, non devi preoccuparti del traffico di crawler o bot in questo modo (e complimenti a te, questa è una verità molto più utile dei dati).

Ridimensionamento + Aree di automazione di questo processo

Alcuni di voi potrebbero dire: "Beh, questo non è automatizzato, non voglio farlo manualmente".

Questo è un punto assolutamente valido. Personalmente non mi dispiace perché la maggior parte dei miei clienti non ha milioni di risultati di ricerca restituiti per giustificare di farlo settimanalmente (o più). Di solito si tratta di un'attività mensile o trimestrale che svolgo insieme a Google Analytics per vedere se le tendenze e i modelli stanno cambiando.

Se sei più tecnico, puoi restare con Screaming Frog e configurare una soluzione VPS per eseguire scansioni automatizzate nel cloud, inviando i risultati a Google BigQuery al termine. SF ha una bella guida su questo.

Ci sono altre soluzioni là fuori che sono più "chiavi in mano" e sicuramente meno pratiche, come ContentKing (le ho usate in passato), che consente anche "avvisi" se vengono raggiunte determinate soglie. (Pensa alle ricerche del numero di prodotto senza risultati restituiti = e-mail o notifica Slack).

Altre aree da cercare con un crawler SEO

Speriamo che questo ti abbia aperto un po' di più gli occhi sulle possibilità di utilizzare i crawler SEO per ottenere informazioni sull'ottimizzazione. (Screaming Frog è solo uno dei tanti, ma quello che consiglio).

I risultati di ricerca interni sono solo una piccola parte di ciò per cui utilizzo i crawler. C'è molto di più che i crawler possono trovare per te. Li uso in molti modi diversi quando lavoro con i miei clienti.

Se hai domande o commenti specifici su questo o qualsiasi altra cosa relativa al CRO, non esitare a contattarmi tramite LinkedIn, Twitter o via e-mail: [email protected].