Come iniziare a posizionarsi più in alto con un crawl budget meglio ottimizzato

Pubblicato: 2018-09-06Ci sono molteplici fattori che influenzano le classifiche: link esterni, utilizzo delle parole chiave, velocità del sito e molti, molti altri. Ma quando inizi a ottimizzare il tuo sito, ciò che devi ricordare è che affinché tutti i tuoi sforzi di ottimizzazione vengano ripagati, il tuo sito deve essere scansionato e indicizzato.

Il modo in cui viene eseguita la scansione del tuo sito Web è determinato dal budget di scansione, ovvero il numero di volte in cui Googlebot visita il tuo sito durante un determinato periodo di tempo. E la visibilità del tuo sito dipende da quanto bene è equilibrato il budget di scansione.

Perché il crawl budget influisce sulla visibilità del tuo sito su Google?

Il budget di scansione è limitato. Ciò crea diverse sfide:

- Quando il crawl budget non è ottimizzato, non tutte le pagine del sito vengono visitate da Googlebot. Di conseguenza, non sono indicizzati e non si classificano nei risultati di ricerca.

- Le pagine aggiornate possono non ricevere a lungo l'attenzione di Googlebot a causa della frequenza di scansione delle pagine dell'altro sito web. Ciò influisce negativamente sulla tua sequenza temporale SEO: finché Google non conosce i tuoi sforzi di ottimizzazione, la visibilità della tua SERP non migliorerà.

Quindi, per assicurarsi che tutte le pagine importanti vengano visitate regolarmente, è necessario ottimizzare il crawl budget. Ecco come puoi farlo.

Come determinare il tuo budget di scansione corrente

Per capire se il tuo crawl budget deve essere ottimizzato, controlla innanzitutto se sei a corto di risorse. Secondo Gary Illyes di Google, solo i grandi siti devono davvero dare la priorità a cosa scansionare, specialmente quelli che generano automaticamente molti URL in base ai parametri. Se ritieni che il tuo sito richieda un ulteriore bilanciamento del crawl budget, ecco come iniziare.

In Google Search Console, puoi trovare le statistiche di scansione del tuo sito corrente e scoprire i dettagli del tuo budget di scansione.

Il budget di scansione approssimativo può essere calcolato in questo modo:

Numero medio di pagine scansionate al giorno x numero di giorni in un mese =

Budget di scansione approssimativo

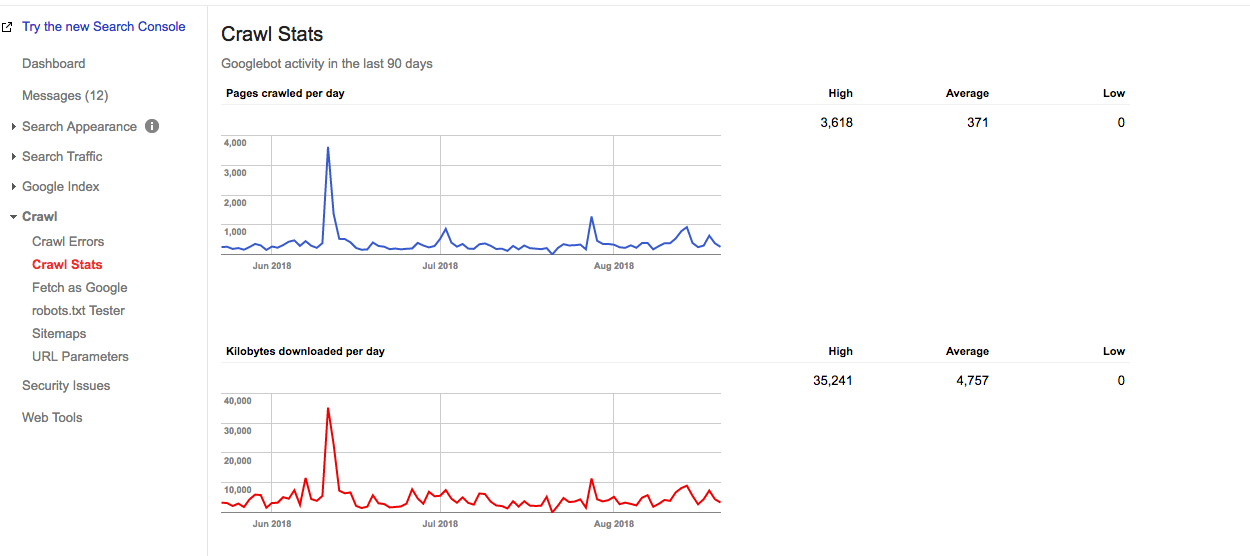

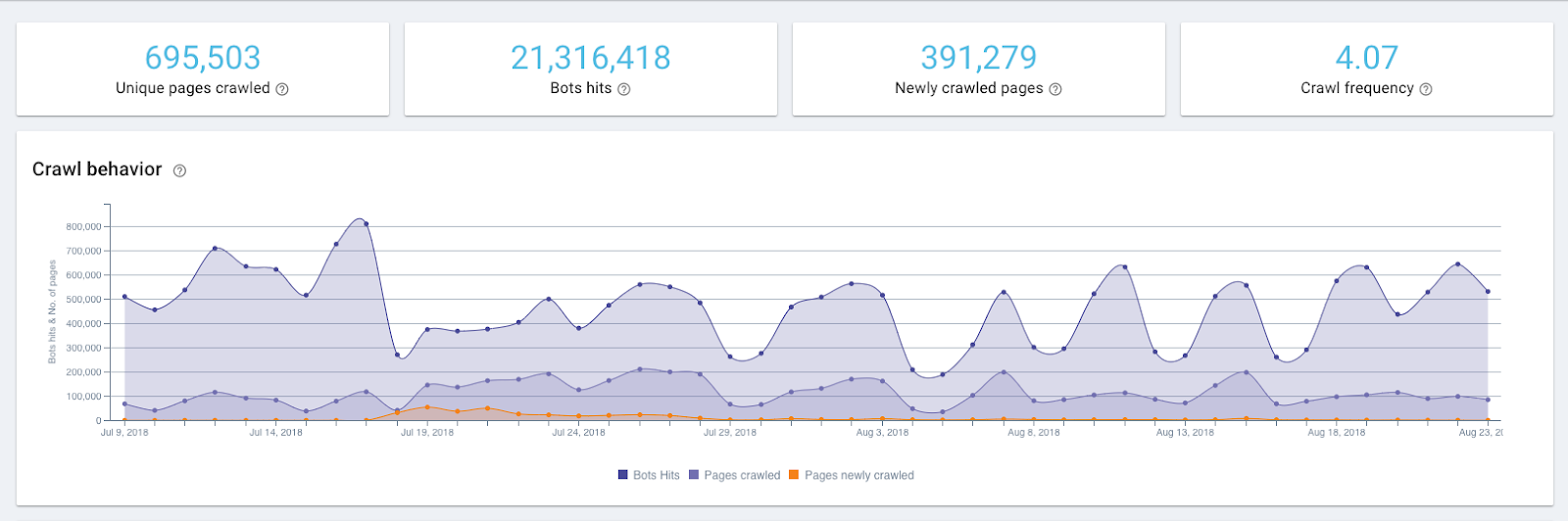

Ad esempio, da un rapporto di seguito, puoi vedere che su questo sito Web Google esegue la scansione di 371 pagine al giorno.

Grafico delle statistiche di scansione in Google Search Console

Pertanto, un budget di scansione approssimativo di questo sito Web è:

371 x 30 = 11130

Ma per sapere esattamente con quale frequenza i crawler di Google colpiscono il tuo sito web, devi controllare i log del server. Google Search Console mostra il budget di scansione aggregato per 12 bot e per vedere l'esatta distribuzione del budget di scansione è necessario uno strumento di analisi dei log.

Gli alti e bassi nel grafico di scansione possono essere un segno di un problema, ma non è sempre così. Ad esempio, un picco nel grafico sopra rappresenta una mappa del sito reinviata, che è un fattore scatenante per un Googlebot per visitare nuovamente il sito web.

Come ottimizzare il tuo crawl budget

Per ottimizzare il tuo crawl budget, devi attenerti a una semplice regola:

Assicurati che ciò che deve essere scansionato sia scansionato e ciò che non deve essere scansionato non sia scansionato.

Ciò significa che le pagine importanti stanno ricevendo sufficiente attenzione e quelle che non apportano alcun valore al tuo sito vengono escluse. Ecco i passaggi esatti che ti porteranno lì.

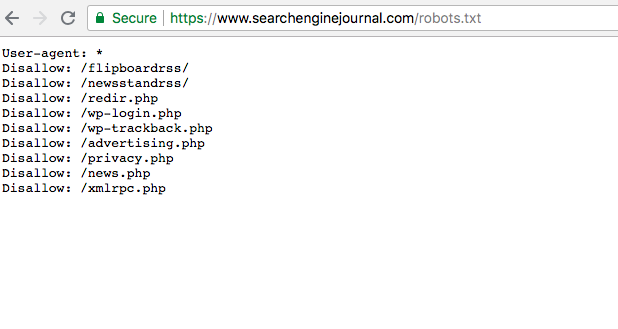

1.Assicurati che tutte le tue pagine importanti siano accessibili da Googlebot (ad es. non siano bloccate in robots.txt)

Sorprendentemente, è molto comune quando le pagine importanti hanno uno stato di disconoscimento nel file robots.txt. In questo modo vengono ignorati da Googlebot e, quindi, nascosti dall'indicizzazione. Il tuo compito è assicurarti che le pagine di cui desideri eseguire la scansione non abbiano quello stato e siano accessibili ai crawler.

Puoi trovare il file robots.txt in Google Search Console. Per assicurarti che le tue pagine importanti non vengano sconfessate, sfoglia il file.

2. Controlla lo stato generale del tuo sito poiché influisce sulla frequenza delle visite di Googlebot (noto anche come limite della velocità di scansione)

Come dice Google stesso, il limite della velocità di scansione è la velocità massima di recupero per un determinato sito. In poche parole, specifica quante connessioni parallele può creare un Googlebot per eseguire la scansione del sito e quanto tempo deve attendere tra i recuperi. Quando la velocità del sito è alta e, il limite aumenta e Googlebot crea più connessioni simultanee. Quando il tasso di risposta del sito è basso o restituisce errori del server, il limite diminuisce e Googlebot esegue la scansione di meno.

Pertanto, anche il modo in cui viene eseguita la scansione del tuo sito è influenzato dalla salute del sito. Ciò include la velocità del sito, la compatibilità con i dispositivi mobili, la quantità di 404 errori, ecc.

Lo stato di salute del sito può essere verificato con questi strumenti.

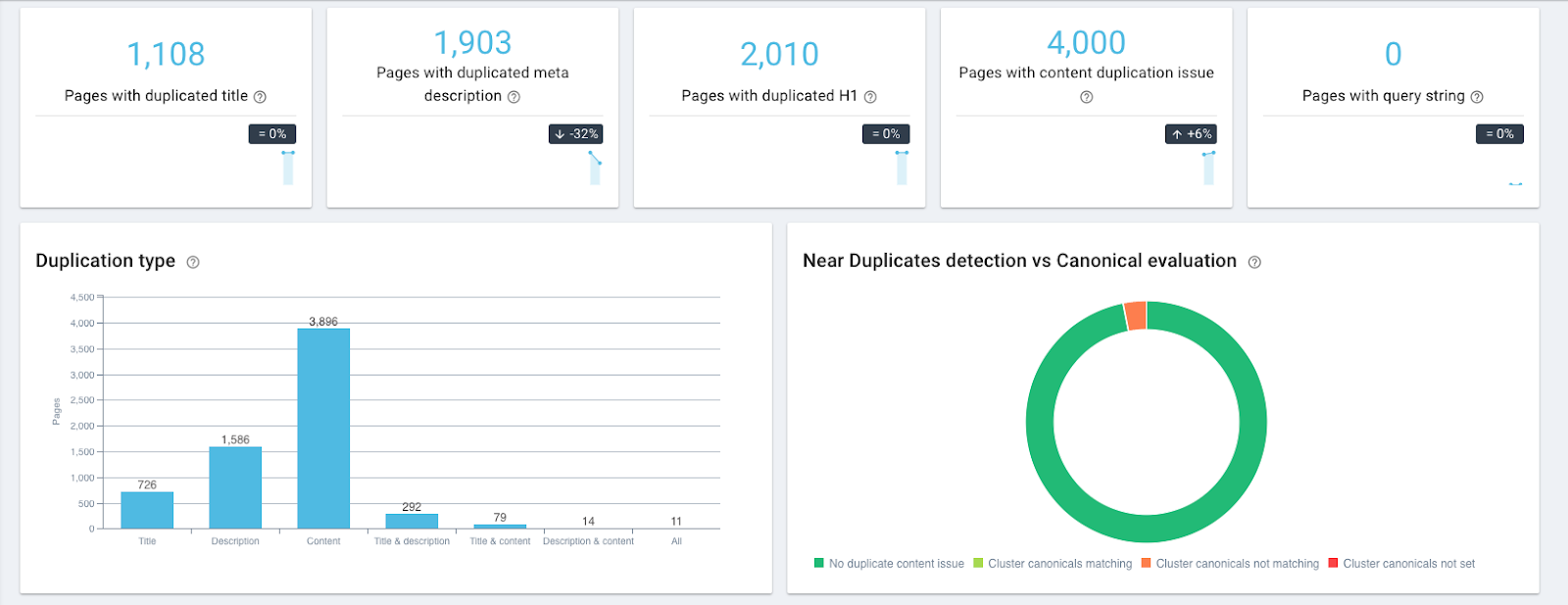

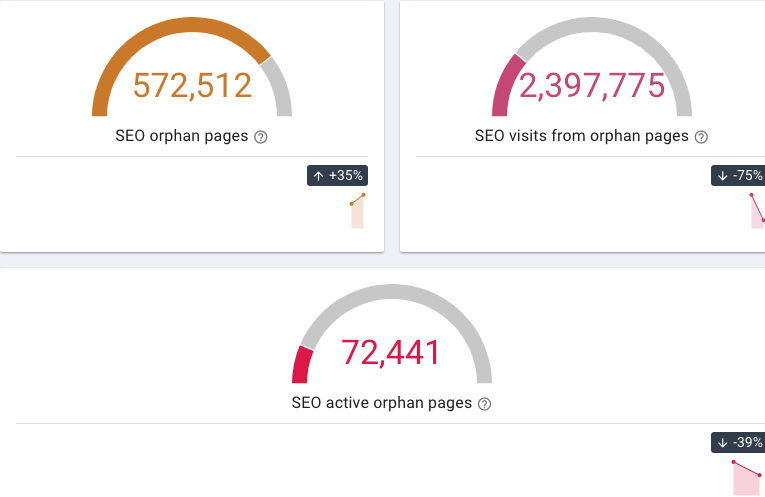

- OnCrawl ti consente di trovare pagine con contenuto duplicato e quasi duplicato, pagine 404 e orfane (che non hanno collegamenti interni che puntano ad esso) ecc.

Widget di contenuti duplicati in OnCrawl

Widget di pagine orfane in OnCrawl

- Il Mobile-Friendly Test di Google verifica la compatibilità mobile di un sito web

- La velocità del sito può essere verificata con l'aiuto degli strumenti gratuiti di PageSpeed Insights o GTmetrix.

Puoi quindi monitorare la frequenza di scansione utilizzando un analizzatore di file di registro come OnCrawl e vedere se Googlebot ha colpito le tue pagine più spesso.

3. Escludi le pagine che non portano alcun valore agli utenti

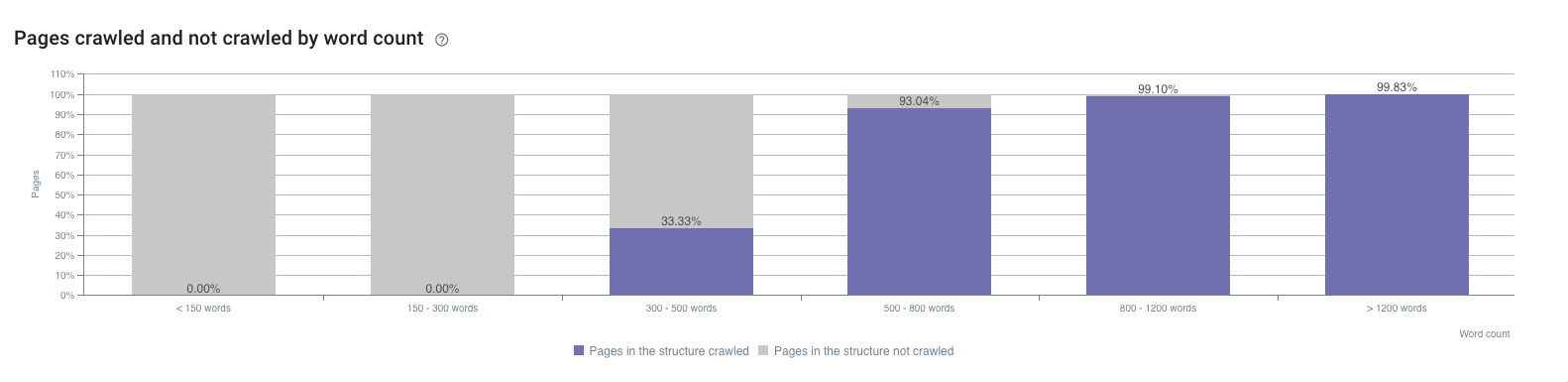

Queste sono le pagine che hanno contenuto debole o assente, pagine tecniche ecc. Poiché sono indicizzate e hanno poche impressioni, possono essere trovate nella Google Search Console. Un altro posto per individuarli è il rapporto sull'impatto della SEO di OnCrawl. Ad esempio, mostra l'impatto del conteggio delle parole sulla frequenza di scansione.

Ad esempio, un problema comune per i grandi siti di e-commerce è la navigazione a faccette. Ryan Stewart ne parla nel suo video sull'ottimizzazione del crawl budget (puoi saltare a 7:20 per verificarlo, ma anche l'intero video è estremamente utile). Quando l'utente seleziona una categoria in un sito Web, il suo parametro viene aggiunto all'URL della pagina. Secondo Googlebot, da quel momento, è un URL diverso e richiede una visita separata. Poiché il numero di possibili combinazioni di categorie è vasto e può sovraccaricare notevolmente il budget di scansione, tali pagine devono essere filtrate.

Un problema simile si verifica quando un identificatore di sessione viene inserito all'interno degli URL. Anche tali pagine dovrebbero essere filtrate.

4. Dai la priorità alle tue pagine in modo che le più importanti vengano scansionate più spesso

La pagina è importante se ha un grande potenziale di traffico.

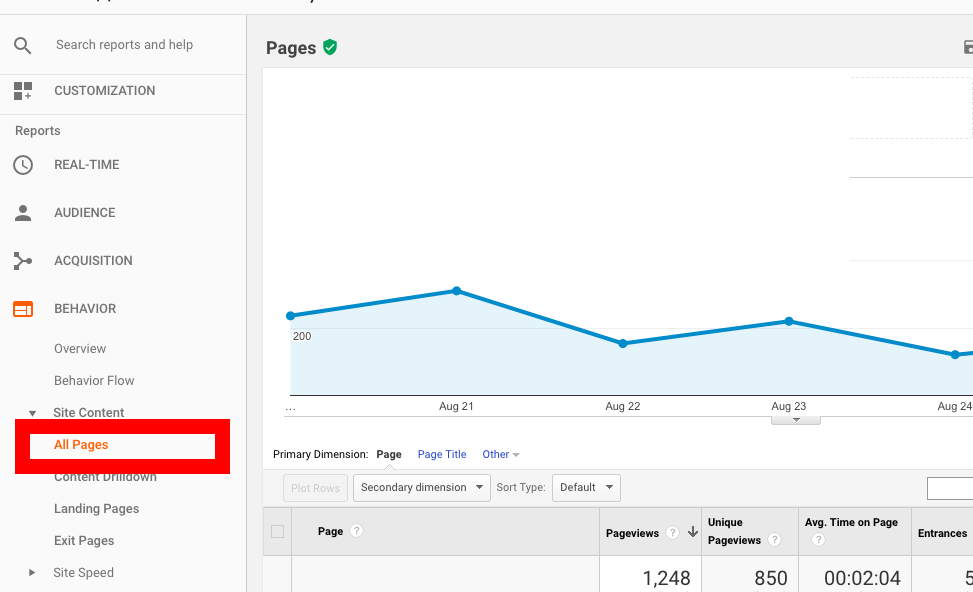

Innanzitutto queste sono le pagine che hanno già molto traffico; puoi individuarli in Google Analytics. In Rapporto sul comportamento , vai su Contenuto del sito → Tutte le pagine e ordina le pagine in base al numero di visualizzazioni di pagina.

In secondo luogo, sono le pagine le cui posizioni stanno migliorando, il che significa che stanno crescendo in popolarità. Tali pagine possono essere trovate in Google Search Console, ma con le sue opzioni di filtro limitate potrebbe volerci del tempo prima di individuarle.

Un'alternativa sarebbe utilizzare AccuRanker in quanto ti consente di vedere che tipo di pagine hanno un trend di visibilità crescente. Per iniziare a usarlo, puoi importare l'elenco delle parole chiave da Google Search Console in un clic e quindi individuare quali pagine sono le più promettenti.

Inoltre, c'è un modo per individuare le pagine che possono avere traffico SEO aggiuntivo nelle settimane e nei mesi successivi. Implica un po' di gioco con l'API di Google Search Console e Google Data Studio, ma il risultato è in qualche modo sorprendente. Utilizzando le pagine di destinazione come dimensioni e impressioni, clic sugli URL e CTR degli URL come metriche, puoi trovare le pagine che stanno crescendo in popolarità più velocemente delle altre.

Quando scopri quali pagine richiedono l'assegnazione di priorità, ecco cosa puoi fare per assicurarti che vengano scansionate più spesso:

- Sposta le pagine più importanti più vicino alla pagina principale o inserisci il link ad esse. Ad esempio, puoi aggiungere un link di pagina alle sezioni Navigazione o “Offerte speciali”.

- Inserisci reindirizzamenti 301 in tutte le categorie di pagine che non hanno prodotti (prodotti esauriti/ stagionali). Non dimenticare di disattivare quel reindirizzamento una volta che il prodotto in questione è di nuovo disponibile.

5. Fornire sufficienti collegamenti interni alla pagina

I collegamenti interni sono fondamentali per la scansione come percorso principale per Googlebot. Senza un collegamento interno su una pagina, semplicemente non può andare avanti. Quindi, aggiungendo collegamenti che conducono a una pagina, aumenti le sue possibilità di essere indicizzata prima.

Ad esempio, se desideri che una vecchia pagina venga scansionata più spesso, aggiungi un link che conduca ad essa, alle tue nuove pagine. Quando il Googlebot visita la nuova pagina, reindicizzerà anche quella precedente.

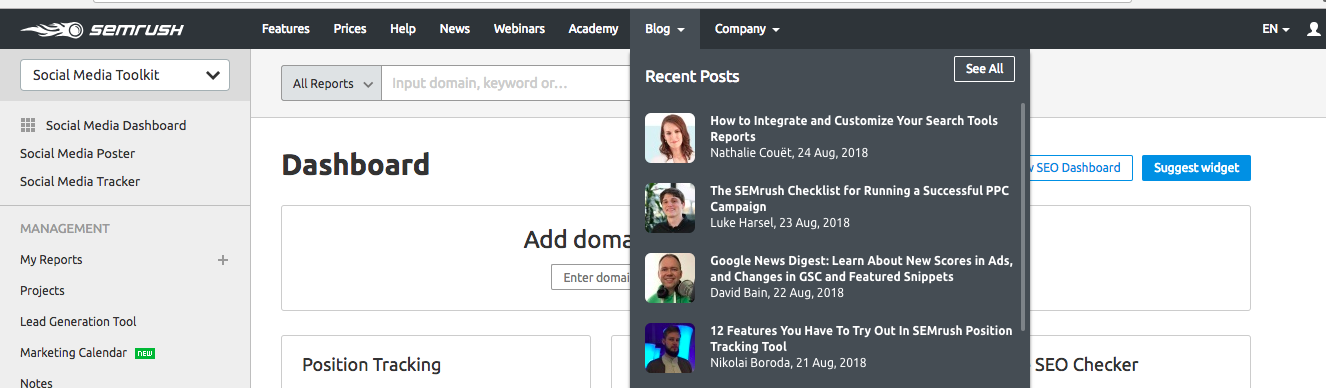

Aggiungendo il link della pagina al menu di navigazione del sito web lo rendi facilmente accessibile anche dagli utenti e da Googlebot. SEMrush utilizza questa tecnica per velocizzare la scansione dei nuovi post del blog. Tutti i nuovi articoli vengono visualizzati nella sezione Post recenti sulla loro pagina principale e, quindi, hanno la priorità da parte di Googlebot.

Questa tecnica può essere utilizzata anche per velocizzare l'indicizzazione delle nuove pagine prodotto sui siti di e-commerce.

Avvolgendo

Come detto sopra, l'ottimizzazione del crawl budget è più importante per i siti più grandi con una struttura ramificata come i siti di e-commerce. Ma poiché una corretta scansione della pagina è alla base della SEO e influisce direttamente sulla visibilità della SERP, potresti voler rivedere le tue statistiche di scansione e bilanciare il budget di scansione per accelerare i risultati dei tuoi sforzi SEO.

Il toolkit di base per l'ottimizzazione del crawl budget include:

- Google Search Console per visualizzare la stima del budget di scansione corrente

- Revisori sanitari del sito come OnCrawl per trovare contenuti duplicati, 404 pagine, pagine orfane ecc.

- Strumenti per verificare la compatibilità mobile del tuo sito come Mobile-Friendly Test di Google

- Controllo della velocità del sito come PageSpeed Insights o GTmetrix

- Strumenti per trovare le pagine con un alto potenziale di popolarità: quelle che hanno già molto traffico (puoi vedere quelle in Google Analytics) o quelle con un trend di visibilità in crescita (puoi trovare con l'aiuto di AccuRanker).