SEO in un mondo a due algoritmi: Pubcon Keynote di Rand Fishkin

Pubblicato: 2022-06-12 Rand dedica questa presentazione a Dana Lookadoo, che sarà sempre con noi.

Rand dedica questa presentazione a Dana Lookadoo, che sarà sempre con noi.

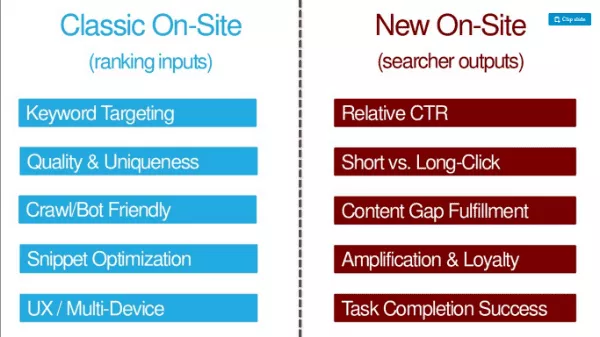

TL:DR di questo autore: oltre ai tradizionali fattori di ottimizzazione SEO (input di classificazione come targeting per parole chiave, qualità e unicità, facilità di scansione/bot, ottimizzazione snippet, UX/ottimizzazione multi-dispositivo), i SEO devono ottimizzare gli output dei ricercatori ( come CTR, clic lunghi, soddisfacimento del gap di contenuto, amplificazione e fedeltà, successo nel completamento delle attività).

Ecco dove puoi ottenere la presentazione: http://bit.ly/twoalgo

Ricordi quando avevamo un solo lavoro? Abbiamo dovuto creare pagine perfettamente ottimizzate. Il team per la qualità della ricerca l'avrebbe classificato e hanno utilizzato i collegamenti come segnale principale. Nel 2007, lo spam dei link era onnipresente. Ogni SEO è ossessionato dai giochi di difesa della torre perché amiamo ottimizzare. Anche nel 2012, sembrava che Google stesse facendo bugiardi dal mondo SEO di White Hat (-Wil Reynolds).

Rand dice oggi che quell'affermazione non è più vera. I contenuti autentici e di qualità vengono premiati da Google meglio di quanto non lo siano mai stati. Google ha cancellato le pratiche della vecchia scuola combattendo cose come lo spam di link. E hanno sfruttato la paura e l'incertezza della penalizzazione per mantenere i siti in linea. Spesso è così pericoloso usare disconoscimenti che molti di noi stanno eliminando i collegamenti che forniscono valore ai nostri siti perché abbiamo tanta paura delle sanzioni.

Google è diventato più intelligente

Google è anche diventato bravo a capire l'intento. Guardano la lingua e non solo le parole chiave.

Predicono risultati diversi.

Hanno capito quando vogliamo freschezza.

Possono separare la navigazione dalle query informative. Collegano le entità ad argomenti e parole chiave. Anche i marchi sono diventati una forma di entità. Bill Slawski ha notato che Google menziona i marchi in numerosi brevetti depositati.

Google è molto più in linea con le loro dichiarazioni pubbliche. Per lo più hanno una politica che corrisponde al modo migliore per fare marketing di ricerca oggi.

La posizione di Google sull'apprendimento automatico è cambiata

Durante questi progressi, il team per la qualità della ricerca di Google ha subito una rivoluzione. All'inizio, Google ha rifiutato l'apprendimento automatico nel suo algoritmo di ranking organico. Google ha affermato che l'apprendimento automatico non consente loro di possedere, controllare e comprendere i fattori nell'algoritmo. Ma più recentemente, i commenti di Amit Singhal suggeriscono che in parte ciò è cambiato.

Nel 2012, Google ha pubblicato un documento su come utilizzano l'apprendimento automatico per prevedere la percentuale di clic degli annunci. Gli ingegneri di Google hanno chiamato il loro sistema SmartASS (apparentemente questo è IN REALTÀ il nome del sistema!). Entro il 2013, Matt Cutts ha parlato a Pubcon di come Google potrebbe utilizzare pubblicamente l'apprendimento automatico (ML) nella ricerca organica.

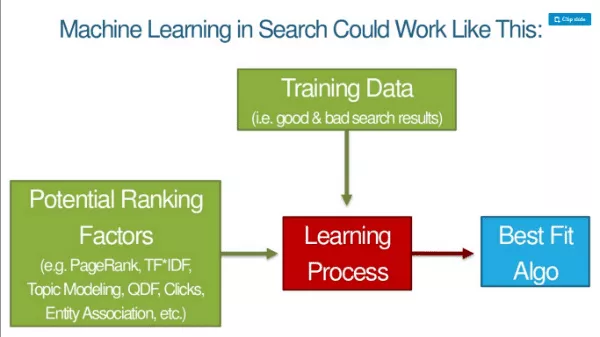

Man mano che il ML assume più algoritmo di Google, le basi delle classifiche cambiano. Google rende pubblico il modo in cui utilizzano il ML nel riconoscimento e nella classificazione delle immagini. Prendono fattori che potrebbero utilizzare per classificare le immagini e quindi aggiungere dati di addestramento (le cose che dicono alla macchina che qualcosa è un gatto, un cane, una scimmia, ecc.) E c'è un processo di apprendimento che li porta a un algoritmo di corrispondenza migliore. Quindi possono applicare quel modello ai dati in tempo reale dappertutto.

La presentazione di diapositive del rappresentante di Google Jeff Dean su Deep Learning è una lettura obbligata per i SEO. Rand dice che questa è una lettura essenziale e non troppo impegnativa da consumare. Jeff Dean è un collega di Google e qualcuno che gli piace prendere in giro molto su Google: "La velocità della luce nel vuoto era di circa 35 miglia orarie. Fino a quando Jeff Dean non ha trascorso un fine settimana a ottimizzare la fisica".

Rimbalzo, clic, tempo di sosta: tutte queste cose sono qualità nel processo di apprendimento automatico e l'algoritmo cerca di emulare le buone esperienze SERP. Stiamo parlando di un algoritmo per costruire algoritmi. I googler non alimentano i fattori di ranking. La macchina li determina essa stessa. I dati di allenamento sono buoni risultati di ricerca.

Cosa significa Deep Learning per la SEO?

I googler non sapranno perché qualcosa si classifica o se una variabile è nell'algoritmo. Tra il lettore e Rand, non suona molto come le cose che dicono i Googler ora? ;)

Le metriche di successo della query saranno tutto ciò che conta per le macchine:

- Rapporto clic lungo o corto

- CTR relativo rispetto ad altri risultati

- Tasso di utenti che effettuano ricerche correlate aggiuntive

- Tasso di condivisione/amplificazione rispetto ad altri risultati

- Metriche di coinvolgimento degli utenti nel dominio

- Metriche di coinvolgimento degli utenti nella pagina (Come? Utilizzando Chrome e Android)

Se molti risultati su una SERP fanno tutto quanto sopra, continueranno a includerlo. Ottimizzeremo di più per gli output dei ricercatori. È probabile che questi siano i criteri dei SEO in loco in futuro.

OK, ma queste metriche ci interessano oggi? Nel 2014, Moz ha eseguito un test di query e clic. Da allora, è stato molto più difficile spostare l'ago con query e clic grezzi. Google sta rilevando clic grezzi e manipolazioni di query.

A SMX Advanced, Gary Illyes ha affermato che l'uso dei clic direttamente nelle classifiche non avrebbe molto senso con quel rumore. Ha detto che c'erano persone che producevano rumore in clic, chiamando Rand Fishkin. - Caso chiuso! O è … ?

Ma cosa succede se provassimo clic lunghi contro clic brevi? Alle 11:39 del 21 giugno, Rand ha chiesto alle persone di fare un test in cui hanno fatto clic nuovamente sul risultato n. 1 e quindi hanno fatto clic e si sono soffermati sul risultato n. 4. Il risultato n. 4 è rimasto nella posizione n. 1 della SERP per circa 12 ore. Questo ci dice che gli output dei ricercatori influiscono sulle classifiche. (PS Questo è difficile da replicare. Non farlo, perché è magia oscura.)

Quello che dovresti fare sono cose che indurranno naturalmente le persone a voler fare clic sul tuo risultato nella SERP.

Una scelta di due algoritmi

Questo è il motivo per cui Rand dice che stiamo ottimizzando per due algoritmi. Dobbiamo scegliere come bilanciare il nostro lavoro. Martellare sui vecchi segnali? Funzionano ancora. I collegamenti funzionano ancora. Il testo di ancoraggio muove ancora l'ago. Ma possiamo vedere all'orizzonte più chiaramente che mai dove sta andando Google.

SEO in loco classico (ingressi di ranking) e nuovo SEO in loco (output del ricercatore):

Usare entrambi gli argomenti perché ci sono due algoritmi.

Nuovi elementi di SEO

Parliamo dei cinque nuovi elementi della moderna SEO.

1. Punzonare al di sopra del CTR medio

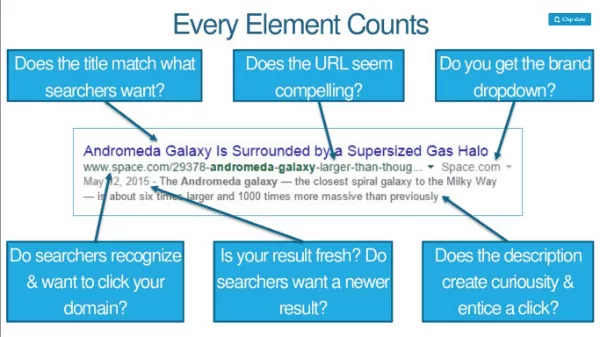

Ottimizzazione del titolo, della meta descrizione e dell'URL un po' per le parole chiave ma molto per i clic. Se sei al 3° posto ma puoi aumentare il tuo CTR, puoi guadagnare un aumento in classifica. Ogni elemento conta. Gli utenti riconoscono e desiderano fare clic sul tuo dominio? L'URL sembra interessante? Viene visualizzato un elenco a discesa del marchio?

Aumenta il CTR attraverso il branding o le ricerche di branding e potrebbe darti una spinta in più. Gli sforzi di branding (come la pubblicità su TV, radio, PPC) hanno un impatto sul CTR. Il budget del brand aiuta la percentuale di clic relativa e tutti i tipi di altri segnali di ranking, e questo aumento sta causando in parte questo.

Con gli intervalli più accurati e personalizzabili di Google Trends, puoi effettivamente guardare gli effetti di eventi e annunci sul volume delle query di ricerca. Ad esempio, c'è un picco nelle query "fitbit" dopo che Fitbit ha pubblicato annunci la domenica della NFL.

2. Battere gli altri elenchi SERP sul coinvolgimento

Insieme, il pogo-sticking e i clic lunghi potrebbero in gran parte determinare dove ti posizioni (e per quanto tempo). Cosa li influenza? Ecco una checklist SEO per un migliore coinvolgimento:

- Contenuti che soddisfano i bisogni consci e inconsci del ricercatore

- Velocità, velocità e ancora velocità

- Offrendo la migliore UX su ogni browser

- Invogliare i visitatori ad approfondire il tuo sito

- Evitare le funzioni che infastidiscono o dissuadono i visitatori

Esempio: il New York Times ha grafici ad alto coinvolgimento che chiedono ai visitatori di disegnare la loro migliore conclusione di un grafico.

3. Colmare le lacune nella conoscenza dei visitatori

Google sta cercando segnali che mostrino che una pagina soddisfa tutte le esigenze di un ricercatore. I modelli ML possono notare che la presenza di determinate parole, frasi e argomenti predice ricerche più riuscite. Le classifiche vanno a pagine/siti che colmano le lacune nella conoscenza dei ricercatori. SUGGERIMENTO: controlla Alchemy API o MonkeyLearn. Esegui i tuoi contenuti attraverso di essi per vedere come si comporta da una prospettiva ML.

4. Guadagnare più condivisioni, collegamenti e fedeltà per visita

I dati di Buzzsumo e Moz mostrano che pochissimi articoli guadagnano condivisioni/link e che questi due non hanno alcuna correlazione. Le persone condividono molte cose che non hanno mai letto. Google classifica quasi definitivamente diversi tipi di SERP in modo diverso. Molte condivisioni su informazioni mediche, ad esempio, non faranno salire il risultato in classifica; la precisione sarà più importante.

Un nuovo KPI: condivisioni e link ogni 1.000 visite. Visite uniche su condivisioni + link.

Anche sapere cosa fa tornare le persone o impedisce loro di farlo è fondamentale.

Non abbiamo bisogno di contenuti migliori, abbiamo bisogno di contenuti 10X (ovvero, contenuti 10 volte migliori dei migliori attualmente disponibili).

5. Soddisfare il compito del ricercatore (non solo la sua query)

Compito = cosa vogliono ottenere quando fanno quella query. Google non vuole un percorso multiricerca di query continuamente focalizzate. Vogliono una ricerca ampia per la quale compilano tutti i passaggi e tu completi il tuo compito.

Il motore di ricerca potrebbe utilizzare i dati del flusso di clic per classificare un sito più in alto anche se non ha i tradizionali segnali di ranking. Una pagina che risponda alla domanda iniziale potrebbe non essere sufficiente, soprattutto se i concorrenti consentono il completamento delle attività.

Algo 1: Google

Algo 2: sottoinsieme dell'umanità che interagisce con i tuoi contenuti (dentro e fuori dai risultati di ricerca)

"Crea pagine per le persone, non per motori" è un consiglio terribile.

I motori hanno bisogno di molte delle cose che abbiamo sempre fatto ed è meglio che continuiamo a farlo. Le persone hanno bisogno di cose aggiuntive e faremo meglio anche a farlo.

Link bonus:

- http://bit.ly/10Xcontent

- http://bit.ly/sharesvslinks