Cos'è Robots.txt: definizione, importanza ed esempi

Pubblicato: 2022-07-14Potresti aver sentito parlare di Google che esegue la scansione del nostro sito Web e delle pagine su Internet e poi le visualizza nella pagina dei risultati di ricerca.

Bene, il robots.txt dice a Google quali siti stanno seguendo i loro algoritmi e quali no. In questa guida, abbiamo condiviso tutto ciò che devi sapere su robots.txt, esempi e come funzionano.

Cos'è Robots.txt?

Robots.txt è un file di testo di un webmaster che guida i robot web (di solito i robot dei motori di ricerca) nella scansione delle pagine del loro dominio. Un file robots.txt, in altre parole, è un insieme di istruzioni per i bot.

Robots.txt sono inclusi nel codice sorgente per la maggior parte dei siti web.

Il file robots.txt fa parte del Robots Exclusion Protocol (REP). Definisce il modo in cui i robot eseguono la scansione delle pagine Web, trovano e indicizzano il contenuto e forniscono tali informazioni alle persone che lo desiderano.

Robots.txt aiuta i bot dei motori di ricerca a capire quali URL dovrebbero scansionare sul tuo sito.

Perché Robots.txt è importante?

Ci sono principalmente tre ragioni per cui how.txt può aiutarti:

- Massimizza il budget di scansione: il budget di scansione è il numero di pagine che i robot di Google indicizzano in un intervallo di tempo. Robots.txt può aiutare a bloccare le pagine di contenuto non importanti o duplicare e concentrarsi solo sulle pagine che sono importanti per te, massimizzando il tuo budget di scansione e aumentando la visibilità.

- Evita l'indicizzazione delle risorse: Robots.txt può indicizzare o de-indicizzare risorse come PDF o immagini. Pertanto, le pagine noindex o protette da password possono essere utilizzate per bloccare le pagine o le risorse. Puoi controllare le pagine indicizzate utilizzando la console di ricerca di Google e vedere se i bot eseguono la scansione delle pagine che desideri indicizzare.

- Blocca pagine non importanti: ci sono alcune pagine del tuo sito web che non vuoi mostrare nei risultati di ricerca di Google. Potrebbe trattarsi della pagina di accesso o della versione di prova/stadio del tuo sito web. Usando robots.txt, puoi bloccare queste pagine e concentrarti solo sulle pagine che contano.

Esempi di Robots.txt

Alcuni esempi di robots.txt sono:

User-agent: Googlebot

Non consentire: /nogooglebot/

User-agent: *

Permettere: /

Mappa del sito: http://www.example.com/sitemap.xml

Allo stesso modo, per il motore di ricerca Bing, va:

User-agent: Bingbot

Non consentire: /example-subfolder/blocked-page.html

La sintassi aiuta il crawler a evitare la scansione di una determinata pagina.

Vale la pena notare che ogni sottodominio necessita del proprio file robots.txt.

Ad esempio, mentre www.cloudflare.com ha un proprio file, anche tutti i sottodomini Cloudflare (blog.cloudflare.com, community.cloudflare.com e così via) richiedono il proprio.

Come funziona un file Robots.txt?

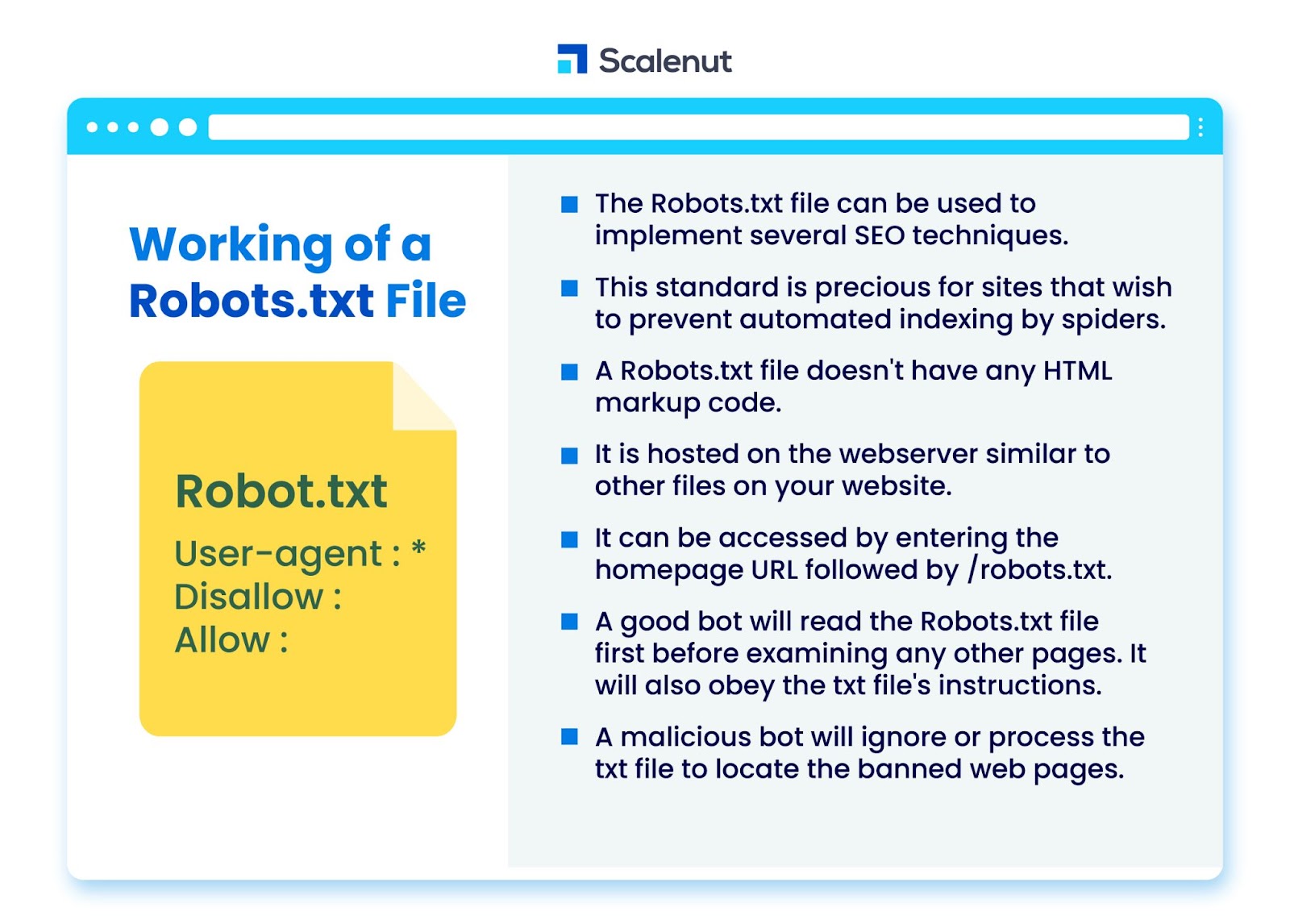

Il file robots.txt può essere utilizzato per implementare diverse tecniche di ottimizzazione dei motori di ricerca (SEO), come le pagine non indicizzate o il file robots txt che impedisce a tutti o parti specifiche del sito da parte di programmi bot.

Lo standard è particolarmente utile per i siti che desiderano impedire agli spider di indicizzare i propri contenuti tramite processi automatizzati come software di ricerca e posizionamento delle pagine utilizzando crawler web automatici.

Un robots.txt è un file senza codice di markup HTML. È ospitato sul server web, proprio come altri file sul tuo sito web.

È possibile accedervi inserendo l'URL della home page seguito da /robots.txt. Un esempio generale è https://www.xyz.com/robots.txt.

Poiché il file non è collegato in nessun altro punto del sito, è improbabile che i visitatori lo trovino, ma la maggior parte dei bot web crawler lo cercherà prima di indicizzare il resto del sito.

Un buon bot, come un crawler di Google o un bot di feed di notizie, leggerà il file robots.txt prima di esaminare qualsiasi altra pagina su un sito e obbedirà alle istruzioni.

Un bot dannoso ignorerà o elaborerà il file robots.txt per trovare le pagine Web vietate.

Blocco di Robots.txt

Robots.txt consiste in istruzioni per informare i robot di eventuali regole di blocco su un sito Web altrimenti ricercabile indicizzato da Googlebot, che hanno lo scopo di impedire al crawler di accedere a pagine con determinati contenuti.

Non influisce sugli utenti regolari o sui bot che si limitano a navigare nei siti senza eseguirne la scansione.

Nel tempo, i siti Web hanno bloccato app mobili, JavaScript e altre parti del loro sito utilizzando questo metodo pur consentendo alcuni elementi come le immagini.

Quali protocolli vengono utilizzati in un file Robots.txt?

Un protocollo è un formato per la trasmissione di istruzioni o ordini in rete. I file Robots.txt utilizzano una varietà di protocolli. Il protocollo principale è noto come Robots Exclusion Protocol.

Indica ai robot su quali siti Web e risorse evitare.

Il protocollo Sitemaps è un altro protocollo utilizzato per i file robots.txt. Questo può essere considerato un protocollo per l'inclusione dei robot.

Le Sitemap informano i web crawler sulle pagine a cui possono accedere. Questo aiuta a garantire che un bot crawler non trascuri pagine cruciali.

Cos'è la mappa del sito?

La mappa del sito è un file XML che descrive le informazioni utilizzate dai web crawler per visualizzare le pagine del tuo sito. La mappa del sito elenca tutti gli URL del tuo sito web, inclusi i titoli e le descrizioni e altre informazioni correlate.

Questo documento aiuta i motori di ricerca a indicizzare correttamente questi elementi in modo che i visitatori possano trovarli rapidamente utilizzando i motori di ricerca o altri sistemi di navigazione.

Che cos'è un agente utente?

User-agent user-agent: *disallow: /nogooglebot/ user-agent user-agent: Googlebot

Non consentire tutte le regole robots.txt, indipendentemente dallo user-agent. Ciò impedirà a qualsiasi web crawler di accedere al tuo sito. Questo è più spesso utilizzato da siti Web sensibili ai problemi di privacy (e quindi non vogliono che i dati dei loro utenti vengano esposti).

I nomi comuni degli user agent dei bot dei motori di ricerca includono:

Google :

- Googlebot

- Immagine di Googlebot (per immagini)

- Googlebot-News (per le notizie)

- Googlebot-Video (per video)

Bing:

- Binbot

- MSNBot-Media (per immagini e video)

Baidu:

- Baiduspider

Che cos'è un file .txt?

TXT è un'estensione di file di testo supportata da molti editor di testo.

Non esiste una definizione statica di un file di testo, mentre esistono diversi formati popolari, inclusi ASCII (un formato multipiattaforma) e ANSI (utilizzato su piattaforme DOS e Windows). TXT è l'abbreviazione di TeXT. Testo/normale è il tipo MIME.

Nel file di testo robots.txt, ogni regola specifica uno schema di URL a cui possono accedere tutti i crawler o solo i crawler specificati.

Ogni riga dovrebbe iniziare con due punti singoli (:) e contenere da 1 a 3 righe, ignorando le righe vuote. Ogni riga viene interpretata come un nome di file, che può essere assoluto o relativo alla directory in cui si trova.

I Web Robot sono gli stessi di Robots.txt?

Alcuni motori di ricerca potrebbero non supportare le direttive txt.

Le istruzioni nei file robots.txt non possono obbligare i crawler a visitare il tuo sito; spetta al crawler seguirli. Al contrario, Googlebot e altri famosi web crawler seguono le regole in un file robots.txt.

Come implementare Robots.txt?

Un file robots.txt può essere implementato in quasi tutti gli editor di testo. Notepad, TextEdit, vi ed emacs, ad esempio, possono generare tutti file robots.txt legittimi.

Di seguito sono riportate le regole da seguire robots.txt:

- Il nome del file dovrebbe essere robots.txt.

- Un file robots.txt può essere utilizzato per limitare l'accesso ai sottodomini (ad esempio, https://website.example.com/robots.txt) o alle porte non standard.

- Un file robots.txt deve essere in formato UTF-8 (che include ASCII). Google potrebbe rifiutare caratteri non compresi nell'intervallo UTF-8, invalidando potenzialmente le normative robots.txt.

- Il file robots.txt si trova solitamente nella directory principale dell'host del sito Web a cui è applicato. Per abilitare la scansione su tutti gli URL come questo- https://www.example.com/, il file robots.txt deve essere trovato all'indirizzo https://www.example.com/robots.txt. Non può essere inserito in una sottodirectory (ad es. https://example.com/pages/robots.txt).

Limitazioni di un file Robots.txt

Ecco le limitazioni del file robots.txt:

- Tutti i motori di ricerca non supportano Robots.txt: i file Robots.txt non possono obbligare i crawler a visitare il tuo sito; spetta al crawler seguirli. Mentre Googlebot e altri web crawler affidabili seguiranno le istruzioni in un file robots.txt, altri crawler potrebbero non farlo.

- Diversi crawler interpretano la sintassi in modo diverso: sebbene i web spider rispettabili aderiscano alle direttive in un file robots.txt, ogni crawler può interpretare le direttive in modo diverso.

- Una pagina non consentita può essere indicizzata se è collegata ad altre pagine: sebbene Google non eseguirà la scansione o l'indicizzazione dei contenuti che un file robots.txt ha limitato, potrebbe trovare e indicizzare un URL non consentito se è collegato da altre posizioni su Internet.

Di conseguenza, l'indirizzo URL e forse altre informazioni pubblicamente disponibili come il testo di ancoraggio nei collegamenti alla pagina potrebbero ancora essere visualizzati nei risultati di ricerca di Google.

FAQ

Q1. Dove va robots.txt su un sito?

Ris: Un file robots.txt viene in genere posizionato nella directory principale del tuo sito Web, ma può trovarsi in qualsiasi punto del tuo sito in cui desideri limitare l'accesso.

Q2. È necessario un file robots.txt?

Ans: La risposta breve è no. Un file robots.txt non è necessario per un sito web. Se un bot visita il tuo sito web e non ha un file robots.txt, eseguirà la scansione e indicizzerà le pagine come farebbe normalmente. Il file .txt è richiesto solo se desideri un maggiore controllo su ciò che viene scansionato.

Q3. robots.txt è sicuro?

Ris: Il file robots.txt non rappresenta di per sé un rischio per la sicurezza e il suo corretto utilizzo può rappresentare una buona pratica per motivi non di sicurezza. Non dovresti aspettarti che tutti i robot web seguano le istruzioni nel file.

Q4. È illegale accedere a robots.txt?

Risposta: un file robots.txt è una licenza implicita dal proprietario del sito web. Se sei a conoscenza del file robots.txt, continuare a raschiare il loro sito senza autorizzazione potrebbe essere visto come accesso non autorizzato o hacking.

Q5. Che cos'è il ritardo di scansione in robots txt?

Risposta: La direttiva crawl-delay è un modo per dire ai crawler di rallentare in modo che il server web non sia sovraccarico.

Conclusione

Robots.txt è un semplice file che ha molta potenza. Se sai come usarlo bene, può aiutare la SEO. Creare il giusto tipo di robots.txt significa migliorare anche la SEO e l'esperienza utente.

I bot saranno in grado di presentare i tuoi contenuti nelle SERP nel modo in cui desideri che vengano visualizzati se consenti loro di eseguire la scansione delle cose corrette.

Se sei disposto a saperne di più sulla SEO e sui fattori importanti, dai un'occhiata a molti altri blog di Scalenut.