L'ascesa della ricerca multimodale e multilingue

Pubblicato: 2022-01-06Estendere la ricerca oltre le query testuali e rimuovere le barriere linguistiche sono tendenze recenti che plasmano il futuro dei motori di ricerca. Con le nuove funzionalità basate sull'intelligenza artificiale, i motori di ricerca stanno cercando di promuovere una migliore esperienza di ricerca e, allo stesso tempo, di introdurre nuovi strumenti per aiutare gli utenti a recuperare informazioni specifiche. In questo articolo affronteremo il tema emergente dei sistemi di ricerca multimodali e multilingue . Mostreremo anche i risultati di uno strumento di ricerca demo che abbiamo creato in Wordlift.

La prossima generazione di motori di ricerca

Una buona esperienza utente abbraccia molteplici aspetti di interazione tra utenti e motori di ricerca. Dalla progettazione dell'interfaccia utente e dalla sua usabilità alla comprensione dell'intento di ricerca e alla risoluzione delle sue query ambigue, i grandi motori di ricerca stanno preparando la prossima generazione di strumenti di ricerca .

Ricerca multimodale

Un modo per descrivere un motore di ricerca multimodale è pensare a un sistema in grado di gestire testo e immagini in un'unica query . Tali motori di ricerca permetterebbero agli utenti di esprimere le loro query di input attraverso un'interfaccia di ricerca multimodale e, di conseguenza, consentirebbe un'esperienza di ricerca più naturale e intuitiva.

Su un sito di e-commerce, un motore di ricerca multimodale consentirebbe il recupero di documenti rilevanti da un database indicizzato. La pertinenza viene valutata misurando la somiglianza dei prodotti disponibili con una determinata query in più di un formato come testo, immagine, audio o video. Di conseguenza, questo motore di ricerca è un sistema multimodale poiché i suoi meccanismi sottostanti sono in grado di gestire diverse modalità di input, cioè formati, contemporaneamente.

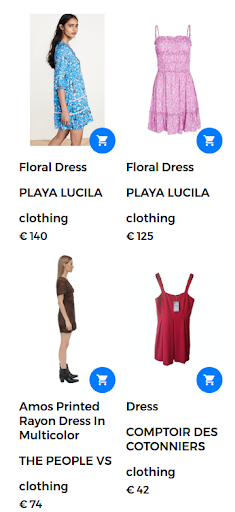

Ad esempio, una query di ricerca potrebbe assumere la forma di "abito floreale". In questo caso, sul web store è disponibile un gran numero di abiti floreali. Tuttavia, il motore di ricerca restituisce abiti che non sono realmente soddisfacenti per l'utente, come mostrato nella figura seguente.

Risultati restituiti per la query "abito floreale".

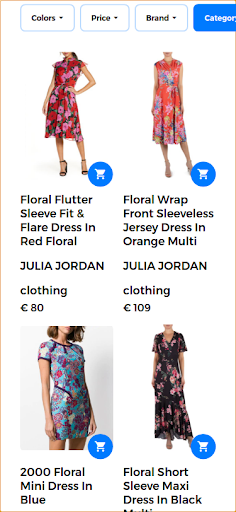

Per fornire una buona esperienza di ricerca e restituire risultati altamente pertinenti, un motore di ricerca multimodale è in grado di combinare un testo e un'immagine in un'unica query . In questo caso, l'utente fornisce l'immagine di esempio del prodotto desiderato. Quando si esegue questa ricerca come ricerca multimodale, l'immagine di input è un abito floreale mostrato nell'immagine seguente.

Immagine fornita dall'utente per la query multimodale.

In questo scenario, la prima parte della query rimane la stessa (abito floreale) e la seconda parte aggiunge l'aspetto visivo alla query multimodale. I risultati restituiti producono abiti simili all'abito floreale fornito dall'utente. In questo caso d'uso, è disponibile lo stesso identico vestito e, quindi, è il primo risultato restituito insieme ad altri abiti simili.

Risultati di ricerca pertinenti restituiti in risposta alla query multimodale.

MAMMA

Google ha introdotto una nuova tecnologia per aiutare gli utenti con complesse attività di ricerca. Questa nuova tecnologia, denominata MUM, sta per Multitask Unified Model ed è in grado di abbattere le barriere linguistiche e interpretare le informazioni in diversi formati di contenuto come pagine Web e immagini.

Google Lens è uno dei primi prodotti a sfruttare il vantaggio di combinare immagini e testo in un'unica query. In un contesto di ricerca, MUM renderebbe più facile per gli utenti trovare motivi come uno specifico motivo floreale in un'immagine fornita dall'utente.

MUM è una nuova pietra miliare dell'IA per comprendere le informazioni presentate qui:

"Sebbene siamo agli inizi dell'esplorazione di MUM, è un'importante pietra miliare verso un futuro in cui Google può comprendere tutti i diversi modi in cui le persone comunicano e interpretano le informazioni in modo naturale".

Per saperne di più sulla ricerca multimodale MUM di Google, controlla questa storia web:

Estendere la ricerca tra le lingue

Sebbene l'immagine sia indipendente dalla lingua, i termini di ricerca sono specifici della lingua. Il compito di progettare un sistema multilingue si riduce alla creazione di modelli linguistici in un'ampia gamma di lingue.

Ricerca multilingue

Un limite chiave degli attuali sistemi di ricerca è che recuperano documenti scritti o annotati nella lingua in cui l'utente ha scritto la query di ricerca. In generale, questi motori sono solo in inglese. Tali motori di ricerca monolingui limitano l'utilità di questi sistemi nel trovare informazioni utili scritte in una lingua diversa.

D'altra parte, i sistemi multilingue accettano una query in una lingua e recuperano documenti che sono indicizzati in altre lingue. In realtà, un sistema di ricerca è multilingue se è in grado di recuperare documenti rilevanti dal database abbinando il contenuto del documento, o didascalie, scritte in una lingua con la query testuale in un'altra lingua. Le tecniche di corrispondenza spaziano dai meccanismi sintattici agli approcci di ricerca semantica.

L'abbinamento di frasi in lingue diverse con concetti visivi è un primo passo per promuovere l'uso di modelli linguistici visivi interlingui . La buona notizia è che i concetti visivi sono interpretati quasi allo stesso modo da tutti gli esseri umani. Questi sistemi, in grado di incorporare informazioni provenienti da più di una fonte e in più di una lingua, sono chiamati sistemi multilingue multimodali . Tuttavia, l'abbinamento immagine-testo non è sempre fattibile per tutte le lingue su larga scala, come discusso nella sezione seguente.

[Case Study] Guidare la crescita in nuovi mercati con la SEO on-page

Da MUM a MURAL

Ci sono sforzi crescenti verso l'applicazione di tecniche avanzate di deep learning e di elaborazione del linguaggio naturale ai motori di ricerca. Google ha presentato un nuovo lavoro di ricerca che consente agli utenti di esprimere parole utilizzando immagini. Ad esempio, la parola "valiha" si riferisce a uno strumento fatto di cetra a tubo ed è suonato dal popolo malgascio. Questa parola manca di una traduzione diretta nella maggior parte delle lingue, ma potrebbe essere facilmente descritta usando le immagini.

Il nuovo sistema, chiamato MURA, sta per Multimodal, Multi-task Retrieval Across Languages. Consente di affrontare il problema delle parole in una lingua che potrebbero non avere una traduzione diretta in una lingua di destinazione. Con tali problemi molti modelli multilingue pre-addestrati non riuscirebbero a trovare parole semanticamente correlate oa tradurre accuratamente parole da o verso una lingua con risorse insufficienti. In effetti, MURAL può affrontare molti problemi del mondo reale:

- Parole che trasmettono significati mentali diversi in lingue diverse: un esempio è la parola "matrimonio" in inglese e hindi che trasmette immagini mentali diverse, come mostrato nell'immagine seguente dal blog di Google.

- Scarsità di dati per le lingue con risorse insufficienti sul Web: il 90% delle coppie testo-immagine sul Web appartiene alle prime 10 lingue con risorse elevate.

Le immagini sono tratte da Wikipedia, accreditate a Psoni2402 (a sinistra) e David McCandless (a destra) con licenza CC BY-SA 4.0.

Ridurre l'ambiguità delle query e fornire una soluzione al problema della scarsità di coppie immagine-testo per le lingue con risorse insufficienti è un altro miglioramento verso la prossima generazione di motori di ricerca basati sull'intelligenza artificiale.

Ricerca multilingue e multimodale in azione

In questo lavoro, utilizziamo gli strumenti esistenti e i modelli linguistici e visivi disponibili per progettare un sistema multilingue multimodale che va oltre una singola lingua e può gestire più di una modalità alla volta .

Innanzitutto, per progettare un sistema multilingue è importante collegare semanticamente parole che provengono da lingue diverse. In secondo luogo, per rendere il sistema multimodale, è necessario mettere in relazione la rappresentazione dei linguaggi con le immagini. Di conseguenza, questo è un grande passo avanti verso l'obiettivo di lunga data di una ricerca multimodale multilingue.

Il contesto

Il caso d'uso principale di questo sistema multilingue multimodale è restituire immagini rilevanti dal set di dati data una query che combina un'immagine e un testo allo stesso tempo. In questo senso, mostreremo alcuni esempi che illustrano vari scenari multimodali e multilingue.

La spina dorsale di questa app demo è alimentata da Jina AI, un ecosistema di ricerca neurale open source. La ricerca neurale, alimentata dal recupero delle informazioni della rete neurale profonda (o IR neurale), è una soluzione interessante per la costruzione di un sistema multimodale. In questa demo, utilizziamo l'architettura MPNet Transformer di Hugging Face, multilingua-mpnet-base-v2, per elaborare descrizioni testuali e didascalie. Per quanto riguarda la parte visiva utilizziamo MobileNetV2.

Di seguito presentiamo una serie di test per mostrare la potenza dei motori di ricerca multilingue e multimodali . Prima di presentare i risultati del nostro strumento demo, ecco un elenco di elementi chiave che descrivono questi test:

- Il database è composto da 1k immagini che ritraggono persone che suonano musica. Queste immagini sono tratte dal set di dati pubblico Flickr30K.

- Ogni immagine ha una didascalia scritta in inglese.

Passaggio 1: iniziare con una query testuale in inglese

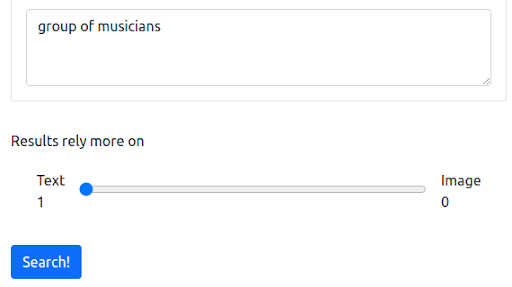

Innanzitutto, iniziamo con una query testuale che riflette il modo attuale in cui opera la maggior parte dei motori di ricerca. La query è "gruppo di musicisti".

La domanda

I risultati

Il nostro motore di ricerca demo basato su Jina restituisce immagini di musicisti che sono semanticamente correlate alla query di input. Tuttavia, questo potrebbe non essere il tipo di musicisti che vogliamo.

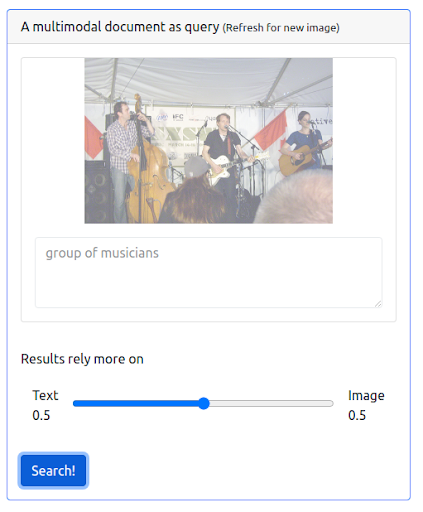

Passaggio 2: aggiunta della multimodalità

Aggiungiamo ora un po' di multimodalità emettendo una query che combina sia la query testuale precedente che un'immagine. L'immagine rappresenta una rappresentazione più accurata dei musicisti che stiamo cercando.

Prima di tutto, l'interfaccia utente deve supportare l'emissione di questo tipo di query. Quindi, dobbiamo assegnare un peso per bilanciare l'importanza di ciascuna modalità durante il recupero dei risultati. In questo caso, sia il testo che l'immagine hanno lo stesso peso (0,5). Come possiamo vedere di seguito, i nuovi risultati di ricerca includono una serie di immagini visivamente simili alla query dell'immagine di input.

La domanda

I risultati

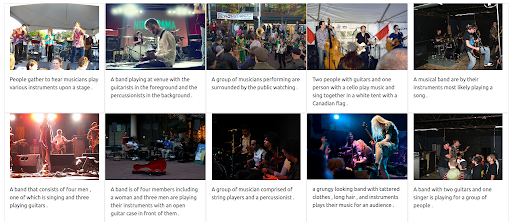

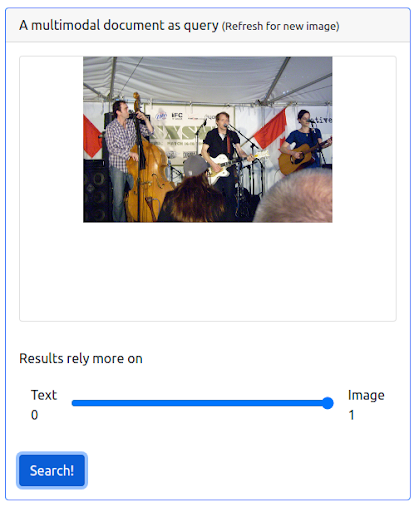

Passaggio 3: Assegnare un peso massimo all'immagine

È anche possibile dare un peso massimo all'immagine. Ciò escluderebbe il testo di input dalla query. In questo caso, vengono restituite più immagini visivamente simili all'immagine di input e classificate nelle prime posizioni. Una cosa da tenere a mente è che i risultati sono limitati alle immagini disponibili nel set di dati.

La domanda

I risultati

Passaggio 4: verifica della ricerca multilingue

Ora proviamo a emettere la stessa query ma utilizzando linguaggi diversi. Il peso del testo è massimizzato per illustrare tutta la potenza di questo sistema multilingue. Si ricorda che le didascalie delle immagini sono solo in inglese. La ricerca viene ripetuta per coprire le seguenti lingue:

- Francese: Groupe de musiciens

- Italiano: Gruppo di musicisti

- Tedesco: Gruppe von Musikern

Indipendentemente dalla lingua della query di input, i risultati restituiti sono pertinenti e coerenti tra le tre lingue. I risultati sono mostrati sotto.

I risultati della query in francese

I risultati della query in italiano

I risultati della query in tedesco

Il futuro multilingue multimodale della ricerca

Nei prossimi anni, l'intelligenza artificiale trasformerà sempre di più la ricerca e sbloccherà modi completamente nuovi per consentire alle persone di esprimere le proprie domande ed esplorare le informazioni. Come Google ha già annunciato, la comprensione delle informazioni con MUM rappresenta una pietra miliare dell'IA. Più sistemi basati sull'intelligenza artificiale in futuro includerebbero funzionalità e miglioramenti che vanno dal fornire una migliore esperienza di ricerca alla risposta a domande sofisticate e dall'abbattere le barriere linguistiche alla combinazione di diverse modalità di ricerca in un'unica query.