Analisi dei file di registro: l'alternativa intelligente a Google Analytics

Pubblicato: 2022-03-08Sai cosa succede ogni giorno sul tuo sito web? La prima cosa che viene in mente quando si risponde a questa domanda sarebbe molto probabilmente utilizzare strumenti di monitoraggio del pubblico e del comportamento. Ci sono molti di questi strumenti disponibili sul mercato, tra cui: Google Analytics, At Internet, Matomo, Fathom Analytics e Simple Analytics per citarne solo alcuni. Sebbene questi strumenti ci consentano di avere una panoramica abbastanza buona di ciò che sta accadendo in un dato momento sui nostri siti Web, le pratiche etiche impiegate da questi strumenti, in particolare Google Analytics, vengono nuovamente messe in discussione.

Ciò suggerisce che esistono altre fonti di dati che attualmente non vengono sufficientemente sfruttate da tutti i proprietari di siti Web: i log.

Strumenti di analisi e GDPR (focus su Google Analytics)

I dati personali sono diventati un argomento sensibile in Francia dall'attuazione del Regolamento generale sulla protezione dei dati (GDPR) e dalla creazione della Commissione nazionale per l'informatica e la libertà (CNIL). La protezione dei dati è diventata una priorità.

Quindi, il tuo sito web è ancora "compatibile con il GDPR"?

Se diamo un'occhiata a tutti i siti web, scopriamo che molti hanno trovato il modo di aggirare le regole utilizzando i loro cookie (banner di raccolta dati) per raccogliere le informazioni di cui hanno bisogno, mentre altri si attengono ancora rigorosamente alle normative ufficiali.

Raccogliendo queste informazioni, gli strumenti di analisi dei dati ci consentono di analizzare da dove proviene il pubblico e il comportamento dei visitatori. Questo tipo di analisi richiede un piano di tagging impeccabile per raccogliere i dati più affidabili e accurati possibili e, in definitiva, i dati raccolti sono il risultato di ogni azione ed evento su un sito.

A seguito di una serie di denunce, la CNIL ha deciso di avvisare Google Analytics rendendolo illegale in Francia, per il momento. Questa sanzione deriva dall'apparente mancanza di controllo sul trasferimento di dati personali ai servizi di intelligence negli Stati Uniti, sebbene le informazioni sui visitatori fossero state precedentemente raccolte con il consenso. Gli sviluppi dovrebbero essere monitorati da vicino.

In questo contesto attuale, con accesso limitato o nullo a Google Analytics, potrebbe essere interessante esaminare altre opzioni di raccolta dati. Una raccolta di eventi storici di un sito e relativamente semplici da recuperare, i file di registro sono un'ottima fonte di informazioni.

Nonostante i file di registro forniscano l'accesso a un interessante archivio di informazioni da analizzare, non ci consentono di visualizzare i valori aziendali o il comportamento reale di un visitatore del sito, come la navigazione del sito dall'inizio fino al momento in cui convalida un carrello o lascia il luogo. L'aspetto comportamentale rimane comunque specifico degli strumenti sopra citati; l'analisi del registro può aiutarci ad arrivare abbastanza lontano.

Comprensione dei file di registro

Cosa sono i file di registro? I registri sono un tipo di file la cui missione principale è archiviare una cronologia degli eventi.

Di che tipo di eventi stiamo parlando? In sostanza, gli "eventi" sono i visitatori e i robot che accedono al tuo sito ogni giorno.

Anche Google Search Console può raccogliere queste informazioni, ma per diversi motivi – in particolare per motivi di privacy – applica un filtro molto specifico.

(Fonte: https://support.google.com/webmasters/answer/7576553. "Differenze tra Search Console e altri strumenti".)

Di conseguenza, avrai solo un campione di ciò che un'analisi del registro può fornire. Con i file di registro, hai accesso al 100% dei dati!

L'analisi delle righe dei file di registro può aiutarti a stabilire la priorità delle tue azioni future.

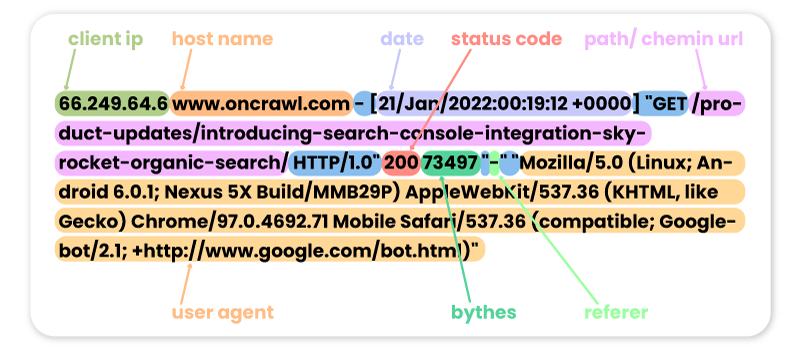

Di seguito sono riportati alcuni esempi di visite precedenti al sito Oncrawl da parte di diversi robot:

FACEBOOK:

66.220.149.10 www.oncrawl.com - [07/Feb/2022:00:18:35 +0000] "GET /feed/ HTTP/1.0" 200 298008 "-" "facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php)"

SEMRUSH:

185.191.171.20 fr.oncrawl.com - [13/Feb/2022:00:18:27 +0000] "GET /infographie/mises-jour-2017-algorithme-google/ HTTP/1.0" 200 50441 "-" "Mozilla/5.0 (compatible; SemrushBot/7~bl; +http://www.semrush.com/bot.html)"

BING:

207.46.13.188 www.oncrawl.com - [22/Jan/2022:00:18:40 +0000] "GET /wp-content/uploads/2018/04/url-detail-word-count.png HTTP/1.0" 200 156829 "-" "Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)"

BOT GOOGLE:

66.249.64.6 www.oncrawl.com - [21/Jan/2022:00:19:12 +0000] "GET /product-updates/introducing-search-console-integration-skyrocket-organic-search/ HTTP/1.0" 200 73497 "-" "Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

Tieni presente che alcune visite bot potrebbero essere false. È importante ricordarsi di verificare gli indirizzi IP per sapere se si tratta di visite reali di Googlebot, Bingbot ecc. Dietro questi falsi user agent, potrebbero esserci dei professionisti che a volte lanciano dei robot per accedere al tuo sito e controllare i tuoi prezzi, i tuoi contenuti o altro informazioni che trovano utili. Per riconoscerli, solo l'IP sarà utile!

Di seguito sono riportati alcuni esempi di visite al sito Oncrawl da parte di utenti Internet:

Da Google.com:

41.73.11x.xxx fr.oncrawl.com - [13/Feb/2022:00:25:29 +0000] "GET /seo-technique/predire-trafic-seo-prophet-python/ HTTP/1.0" 200 57768 "https://www.google.com/" "Mozilla/5.0 (Linux; Android 10; Orange Sanza touch) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.98 Mobile Safari/537.36"

Dagli UTM di Google Ads:

199.223.xxx.x www.oncrawl.com - [11/Feb/2022:15:18:30 +0000] "GET /?utm_source=sea&utm_medium=google-ads&utm_campaign=brand&gclid=EAIaIQobChMIhJ3Aofn39QIVgoyGCh332QYYEAAYASAAEgLrCvD_BwE HTTP/1.0" 200 50423 "https://www.google.com/" "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/96.0.4664.110 Safari/537.36"

Da LinkedIn grazie al referrer:

181.23.1xx.xxx www.oncrawl.com - [14/Feb/2022:03:54:14 +0000] "GET /wp-content/uploads/2021/07/The-SUPER-SEO-Game-Building-an-NLP-pipeline-with-BigQuery-and-Data-Studio.pdf HTTP/1.0" 200 3319668 "https://www.linkedin.com/"

[Ebook] Quattro casi d'uso per sfruttare l'analisi dei log SEO

Perché analizzare il contenuto del registro?

Ora che sappiamo cosa contengono effettivamente i log, cosa possiamo farci? La risposta: analizzali, come qualsiasi altro strumento di analisi.

Bot o robot

A questo punto possiamo porci la seguente domanda:

Quali robot trascorrono più tempo sul mio sito web?

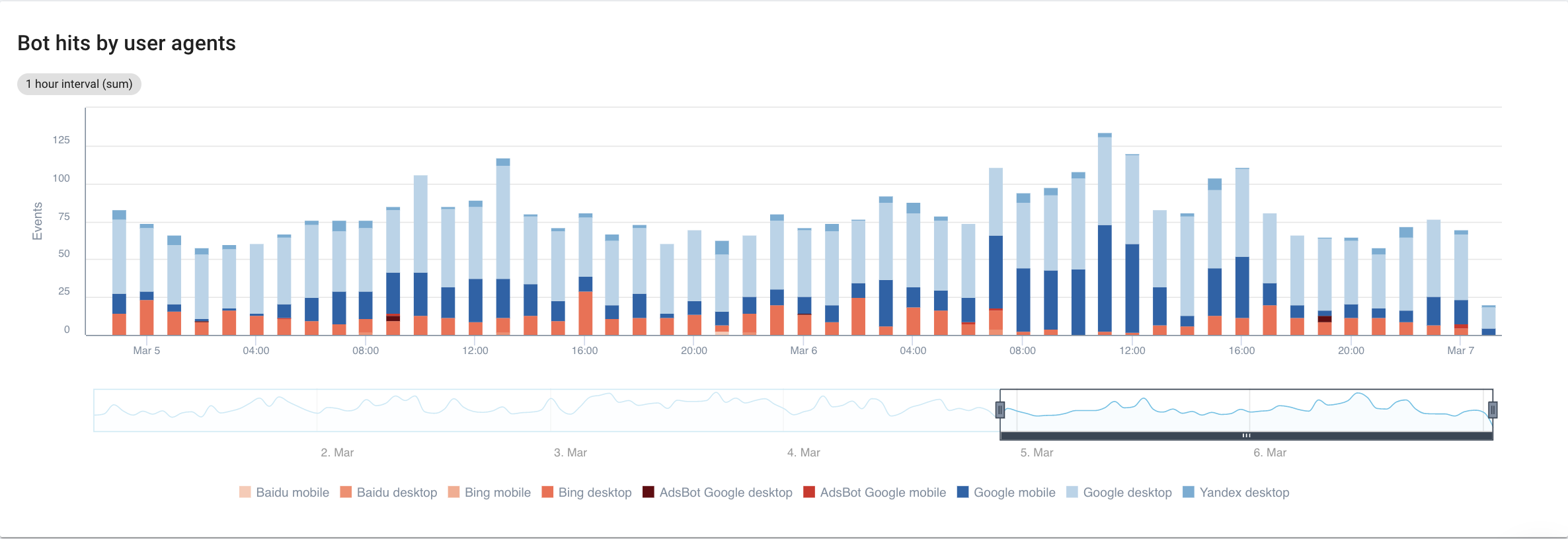

Se ci concentriamo sui motori di ricerca, con una visione dettagliata di ogni bot, ecco cosa possiamo vedere:

Fonte: applicazione Oncrawl

Chiaramente, Google Mobile e Desktop trascorrono molto più tempo a scansionare rispetto ai bot Bing o Yandex. Googlebot ha una quota di mercato globale di oltre il 90%.

Se Google esegue la scansione delle mie pagine, vengono indicizzate automaticamente? No, non necessariamente.

Se andiamo indietro di qualche anno, Google ha utilizzato un riflesso automatico per indicizzare le pagine subito dopo averle visitate. Oggi non è più così visto il volume di pagine che deve elaborare. Di conseguenza, ne consegue una battaglia SEO per quanto riguarda il crawl budget.

Detto questo, potresti chiederti: che senso ha sapere quale bot trascorre più tempo di un altro sul mio sito?

La risposta a questa domanda dipende da ciascuno degli algoritmi dei bot. Sono tutti un po' diversi e non necessariamente ritornano per gli stessi motivi.

Ogni motore di ricerca ha il proprio crawl budget che divide tra questi bot . In altre parole, ciò significa che Google divide il suo budget di scansione tra tutti questi bot. Pertanto, diventa piuttosto interessante guardare un po' più da vicino ciò che fa GooglebotAds, soprattutto se abbiamo 404 in giro. Ripulirli è un modo per ottimizzare il crawl budget e, in definitiva, il tuo SEO.

Analizzatore di log in scansione

Incrociare i dati di Googlebot con i dati di Oncrawl Crawler

Per approfondire l'analisi del comportamento di Googlebot, Oncrawl incrocia i dati di registro con i dati di scansione per ottenere le informazioni più dettagliate e accurate.

L'obiettivo è anche quello di affermare o confutare le ipotesi legate a diversi KPI come profondità, contenuto, performance, ecc.

Di conseguenza, devi farti le domande giuste:

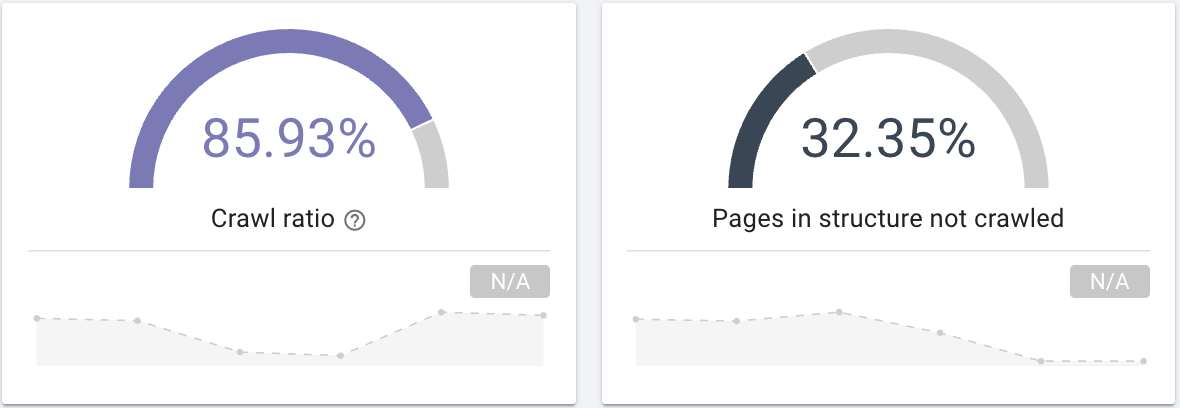

- Googlebot esegue la scansione di tutte le pagine del tuo sito? Interessati al rapporto di scansione che fornisce chiaramente queste informazioni che puoi anche filtrare con una segmentazione delle tue pagine.

Fonte: applicazione Oncrawl

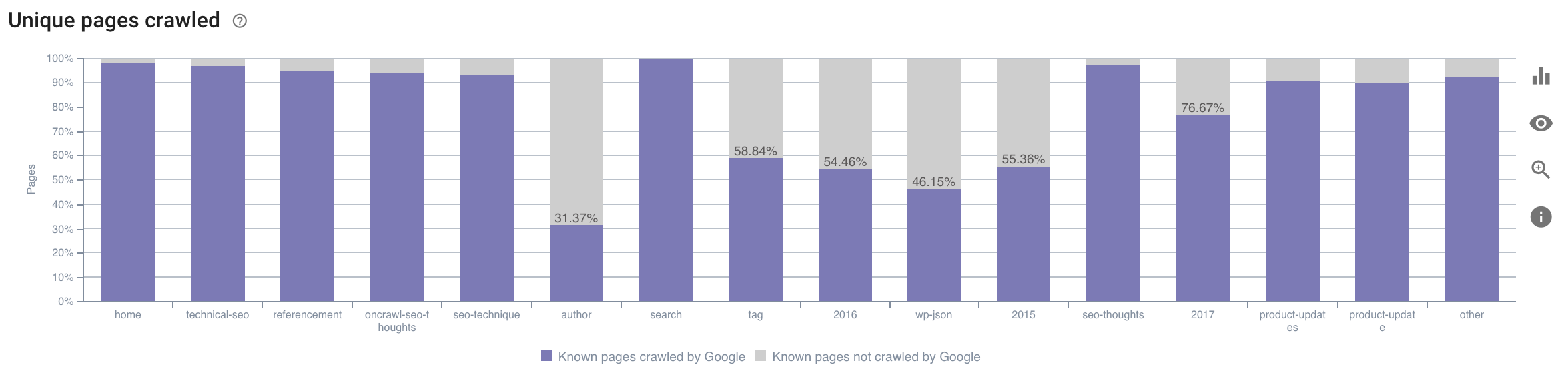

- In quale categoria passa il tempo Googlebot? Si tratta di un uso ottimale del crawl budget? Questo grafico nel SEO Impact Report di Oncrawl incrocia i dati e fornisce queste informazioni.

Fonte: applicazione Oncrawl

Fonte: applicazione Oncrawl

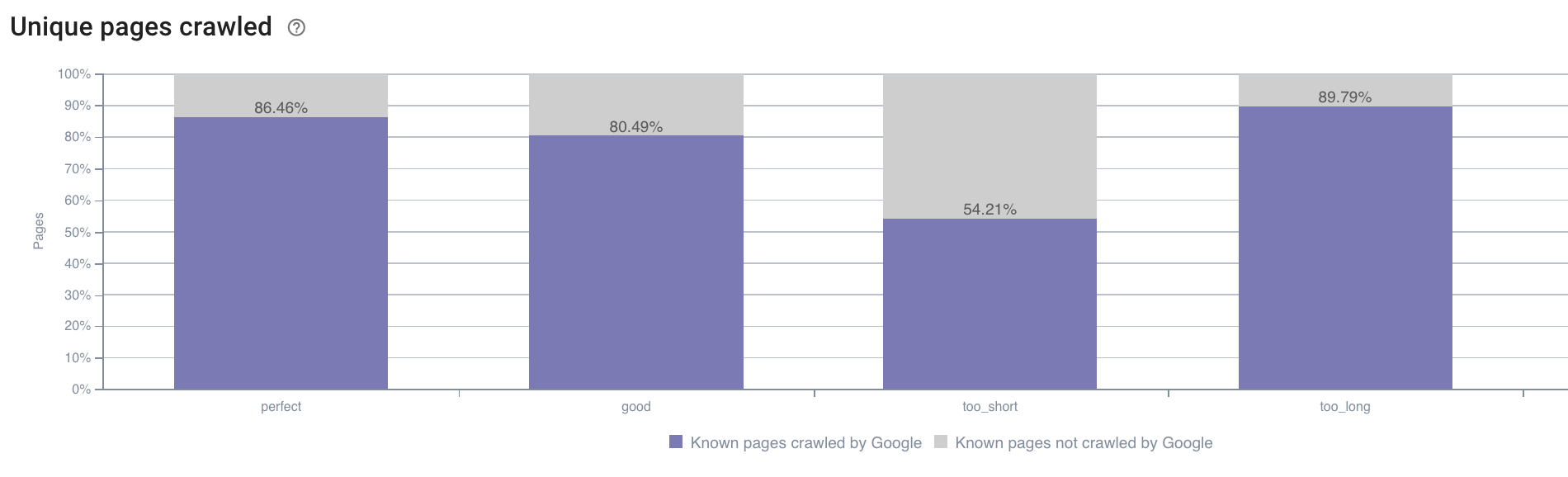

- Potremmo anche avere domande al di fuori dell'ambito di ciò che il rapporto sulla scansione durante la scansione offre per impostazione predefinita. Ad esempio, la lunghezza della descrizione ha un impatto sul comportamento di Googlebot? Abbiamo i dati su questo grazie al crawl, quindi possiamo usarlo per creare una segmentazione proprio come di seguito:

Fonte: applicazione Oncrawl

Le descrizioni troppo brevi vengono scansionate molto meno di quelle la cui dimensione ideale è indicata come "perfetta" o "buona" qui dall'applicazione Oncrawl (tra 110 e 169 caratteri).

Se la descrizione soddisfa i criteri di pertinenza e dimensione, tra gli altri, Googlebot aumenterà felicemente il suo budget di scansione sulle pagine pertinenti.

Nota: le pagine ritenute troppo lunghe a volte vengono riscritte da Google.

Analizza le visite al sito web utilizzando i log

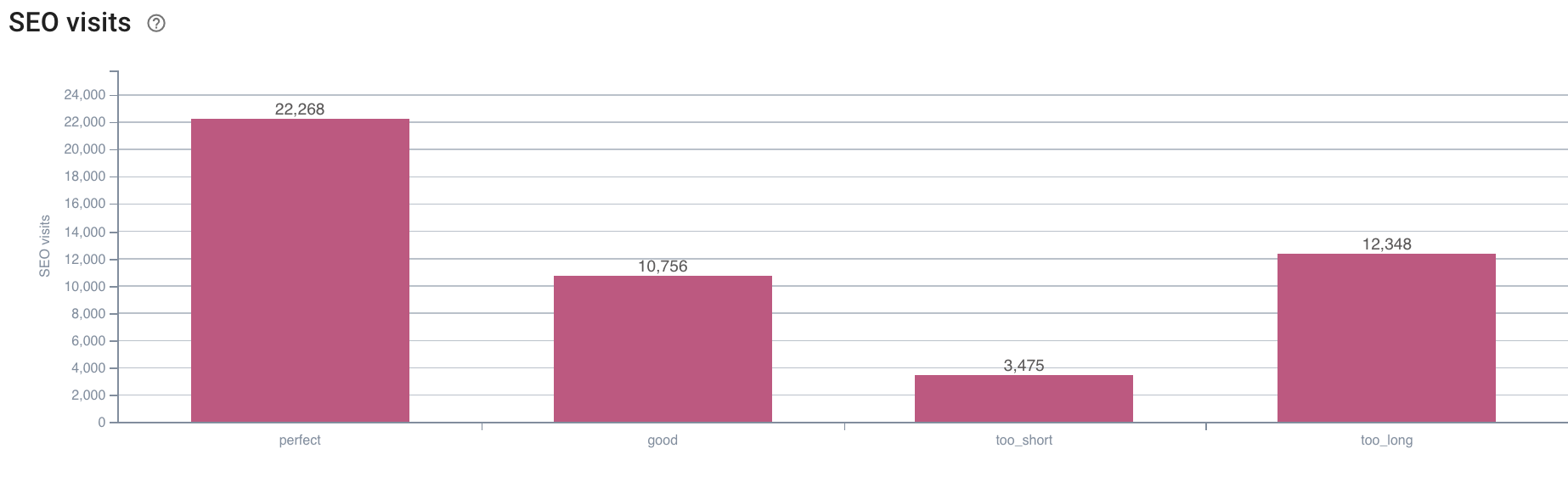

Successivamente, se guardiamo all'esempio della SEO, poiché questo è ciò che stiamo cercando di analizzare con Oncrawl, ti suggerisco di farti un'altra domanda:

- Qual è la correlazione tra il comportamento di Googlebot e le visite SEO?

Oncrawl ha gli stessi grafici per incrociare i dati tra quello della scansione e le visite SEO recuperate nei log.

Fonte: applicazione Oncrawl

Fonte: applicazione Oncrawl

La risposta è molto chiara: le pagine che hanno una lunghezza descrittiva “perfetta” sono quelle che sembrano generare più visite SEO. Dobbiamo quindi concentrare i nostri sforzi su questo asse. Oltre a "nutrire" Googlebot, gli utenti sembrano apprezzare la pertinenza della descrizione.

L'app Oncrawl fornisce dati simili per molti altri KPI. Sentiti libero di verificare le tue ipotesi!

Insomma

Ora che conosci e comprendi la possibilità di esplorare ciò che accade ogni giorno sul tuo sito grazie ai log, ti incoraggio ad analizzare gli utenti Internet e le visite dei robot per trovare vari modi per ottimizzare il tuo sito. Le risposte possono essere tecniche o relative al contenuto, ma ricorda che una buona segmentazione è la chiave per una buona analisi.

Questo tipo di analisi non è tuttavia possibile con gli strumenti di Google Analytics; i loro dati a volte possono essere confusi con quelli del nostro crawler. Anche avere a disposizione quanti più dati possibile è una buona soluzione.

Per ottenere ancora di più dai tuoi dati di registro e dalle analisi di scansione, dai un'occhiata a uno studio condotto dal team di Oncrawl che compila 5 KPI SEO relativi ai log sui siti di e-commerce.