7 passaggi chiave per imparare e migliorare dai risultati del test A/B

Pubblicato: 2021-04-13

Il tuo test A/B è appena terminato ma non vedi i risultati che ti aspettavi.

Tutti gli altri stanno condividendo casi di studio in cui hanno visto un enorme miglioramento con un semplice cambio di colore dei pulsanti o una piccola modifica, ma il tuo test non ha ottenuto alcun miglioramento nella conversione o, peggio, sembra invece aver perso denaro e ora devi farlo presentalo al tuo capo.

E se il tuo test non fosse effettivamente un perdente?

E se fosse un vincitore travestito?

E se è un perdente, cosa succede se un test perdente è effettivamente una buona cosa?

In questa guida, ti aiuteremo ad avere una prospettiva più profonda sui risultati del tuo test A/B in modo da poterli analizzare e scomporre per trovare l'oro.

Spiegheremo perché imparare dai tuoi test A/B è così importante e perché i perdenti possono farti vendere. Condividiamo un processo che puoi seguire in modo che tu possa analizzare completamente i tuoi test passo dopo passo e sentirti sicuro di ciò che stai vedendo, vincere o fallire.

Meglio ancora, ti aiuteremo a passare dall'ansia di dati e dal non voler controllare le tue analisi, all'essere sicuro di condividere i tuoi risultati con i tuoi colleghi.

Allora tuffiamoci...

Perché hai bisogno di imparare dai test A/B?

Per cominciare, c'è l'ovvio costo coinvolto. Ogni test costa denaro per l'impostazione. Se hai varianti perdenti, vedrai anche un calo delle vendite per quella variante.

Ecco la cosa però:

Il test A/B (e il CRO in generale) non riguarda solo fare più soldi. Si tratta di acquistare dati . I dati sul tuo pubblico possono aiutarti a capirlo meglio e a fornire un prodotto e un servizio migliori. Ciò porta quindi a più vendite e a una migliore esperienza del cliente e persino a informazioni dettagliate sulle nuove offerte di prodotti.

Più impari sulle persone che servi, meglio fai. Ecco perché è così importante testare e testare spesso, anche quando la maggior parte dei test fallisce.

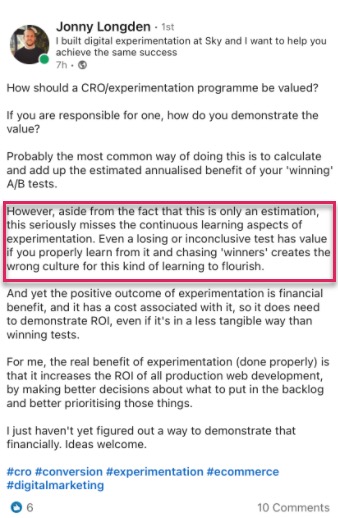

Non siamo nemmeno soli in questo pensiero.

Infatti, quando abbiamo esaminato i nostri dati interni di 28.304 test con il nostro strumento, insieme alle conversazioni con agenzie di test esperte, abbiamo scoperto che la maggior parte delle aziende trova solo 1 vincitore su 10 test, mentre le agenzie di solito vedranno 1 vincitore su ogni 4.

E so cosa stai pensando,

Sicuramente questo significa che sto perdendo soldi il 90% delle volte con ogni test?

Sì, ma solo a metà del tuo pubblico di prova. L'altra metà sta ancora vedendo il tuo sito e si converte come al solito.

Inoltre, i dati che stai ricevendo ti stanno aiutando a scoprire cosa non funziona, così puoi imparare cosa funziona. Metti alla prova, impari, riprovi e vai avanti finché non trovi ciò che funziona.

E quei test del 10% che vincono?

Possono fornire un aumento incrementale continuo che può essere migliorato ancora e ancora, prima di essere ridimensionato in tutto il tuo sito su ogni pagina simile per un maggiore impatto.

Questo è il bello di vedere un aumento delle conversioni su una piattaforma digitale. La semplice scala di un aumento dell'1% può avere un enorme impatto sulla tua attività, sia ora che con tutto il traffico futuro. In effetti, Jeff Bezos pensa in questo modo, definendo Amazon e il loro obiettivo di test e miglioramento "il posto migliore al mondo in cui fallire" durante il loro rapporto annuale per gli azionisti:

Data una probabilità del 10 percento di vincita 100 volte, dovresti accettare quella scommessa ogni volta. Ma sbaglierai comunque nove volte su dieci .

Jeff Bezos, Amazon

Tuttavia, più vendite e migliori approfondimenti non sono gli unici vantaggi dei test A/B.

L'esecuzione dei test ti consente di allontanarti dagli argomenti di blocco e dalla teoria dei gruppi. Invece di passare mesi a discutere di possibili modifiche al web design senza fare nulla, agisci al riguardo e testalo, liberando il tuo team per concentrarsi su altre cose. (Assicurati di testarne l'effetto prima di spingerlo dal vivo!)

Non solo, ma puoi imparare qualcosa di nuovo sul tuo pubblico che SOLO i test A/B possono dirti.

La creazione di teorie e i sondaggi sui clienti sono fantastici, ma è ciò che il tuo pubblico fa effettivamente sul tuo sito che conta di più, non solo quello che dice. Comprendere i tuoi test ti aiuta a dimostrare o smentire quelle idee e feedback.

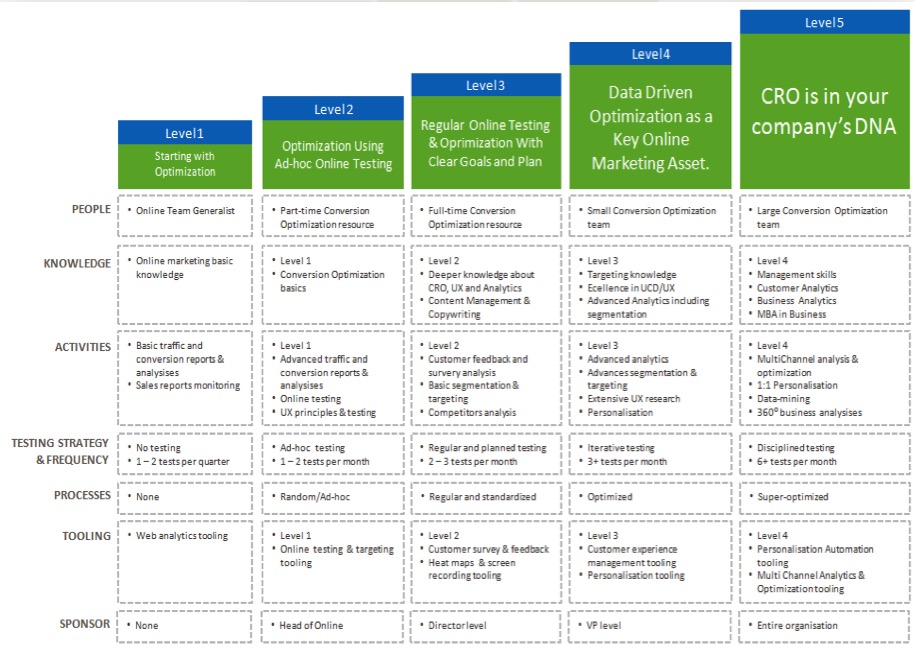

Più comprendi i tuoi risultati, più diventi sicuro dei tuoi test, permettendoti di "maturare" i tuoi sforzi CRO ed eseguire test più spesso, e forse anche iniziare a costruire un team di test internamente.

Ora che vedi il vantaggio di imparare da ogni test A/B, ti guidiamo attraverso un semplice processo per analizzare ogni nuovo test che esegui...

Il processo in 7 fasi per imparare dai test A/B (insieme ai sistemi che puoi utilizzare per migliorare i test futuri)

Lo abbiamo suddiviso in 7 passaggi chiave da seguire.

Potresti non avere tutti i metodi o gli strumenti che consigliamo qui, ma, vedendo come si adattano, puoi quindi misurarne il valore e decidere se vuoi integrarli nei tuoi test futuri.

Passaggio 1: verifica che i tuoi dati siano accurati, validi e significativi

Questa è la parte più importante di questo intero processo. Assicurati che le informazioni che hai sul tuo test siano accurate e valide in modo da poter essere sicuro dei risultati.

Quindi, come ti assicuri che i risultati dei test ti forniscano dati di cui ti puoi fidare?

Bene, ci sono alcune cose che puoi fare...

Verifica la precisione del tuo strumento

Ora, alla maggior parte delle persone manca questo. Sentiti libero di saltarlo se il tuo sito non riceve più di 10.000 visitatori al mese. Tecnicamente, non è necessario per iniziare con CRO e funziona meglio con i siti con un grande volume di traffico, ma sarei negligente se non includerlo qui poiché i siti di grandi dimensioni possono davvero vedere la differenza.

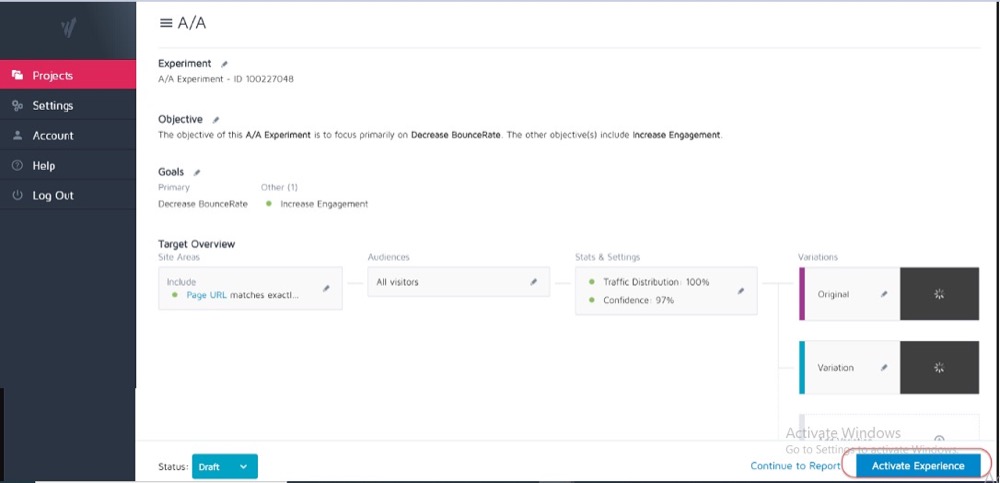

Idealmente, hai già eseguito un test A/A sul tuo attuale strumento di test per vedere quanto è accurato e se ha problemi.

Come?

Esegui un semplice test diviso con 2 copie identiche di una pagina Web e quindi tieni traccia dei risultati su quelle 2 pagine identiche.

Poiché non ci sono differenze tra loro, i risultati dovrebbero essere gli stessi per ogni pagina. Tuttavia, potrebbero esserci delle discrepanze causate dallo strumento e dal modo in cui misura o tiene traccia dei tuoi dati.

Sapere questo in anticipo può aiutarti a ottenere una tolleranza per l'accuratezza dei risultati dei test e utilizzarlo come linea guida per tutti i test futuri.

Esempio

Se hai notato che il tuo test A/A ha mostrato una differenza dello 0,5% nel tasso di conversione tra due pagine identiche, allora potresti diffidare dei risultati dei test che mostrano un vincitore quando è solo una differenza dello 0,5% tra il controllo e la variante.

Potresti impostare linee guida interne che dicono che un test deve mostrare un aumento dell'1% o superiore prima di credere al risultato. Ancora una volta, devi eseguire un test A/A solo una volta quando stai provando un nuovo strumento o se ritieni che il tuo strumento attuale possa avere alcuni problemi con i rapporti o sia impostato in modo errato.

I test A/A funzionano meglio con siti di traffico di grandi dimensioni poiché i dati di esempio necessari per un controllo accurato possono essere piuttosto grandi, ma la differenza in un errore dell'1% potrebbe essere enorme.

Esegui il test abbastanza a lungo per ottenere una visione valida di come i tuoi clienti interagiscono con il tuo sito

Quindi ora che ti fidi del tuo strumento, vuoi eseguire il test per 2-4 settimane, anche se ottieni abbastanza conversioni per essere statisticamente in grado di spegnerlo prima.

Come mai?

Perché il tuo pubblico interagirà spesso con il tuo sito in modo diverso a seconda del giorno della settimana o di alcune fasi del mese.

Esempio

Se le persone nel tuo pubblico venissero pagate il giovedì, vedresti un aumento che potresti perdere se il tuo test si svolgesse solo dal lunedì al mercoledì, giusto?

Allo stesso modo, altri utenti potrebbero essere pagati quindicinalmente o mensilmente, distorcendo ancora una volta i risultati se i test non sono stati eseguiti abbastanza a lungo da includerli. Assumeresti semplicemente vendite o traffico inferiori per le volte che hai perso.

Come fai a sapere quando terminare un test? Ulteriori informazioni su A/B Testing Significato statistico: come e quando terminare un test

Sii consapevole di eventuali fattori interni o esterni che possono influire sui risultati

Questi sono eventi unici o programmati che potrebbero distorcere i tuoi dati.

Ad esempio, se il tuo CEO o la tua azienda era nelle notizie o se stai conducendo campagne o promozioni di marketing in corso, nonché fattori esterni come festività nazionali o persino picchi di traffico casuali.

Tutto ciò può influenzare il traffico del tuo sito e quindi alterare la precisione dei tuoi risultati durante quel periodo.

Storia vera:

Circa 6 anni fa, possedevo un'azienda di abbigliamento da surf.

Un giorno, il nostro traffico è aumentato di circa l'800% dal nulla e la nostra frequenza di rimbalzo è aumentata vertiginosamente. Non avevamo condotto nessuna nuova campagna di marketing e quindi ho fatto un po' di indagini per scoprire da dove proveniva il traffico.

Si scopre che una delle nostre t-shirt aveva un nome di prodotto che era lo stesso nome della nuova canzone di una band pop coreana, e per 2 giorni ci siamo classificati per questo e abbiamo ricevuto i loro visitatori.

Naturalmente, questo nuovo pubblico non era affatto interessato al nostro prodotto e presto se ne andò.

Pazzo, vero?

Un'altra volta, il mio blog di marketing ha iniziato a classificarsi per il marchio di un'azienda televisiva ed è successa la stessa cosa. Abbiamo avuto picchi di traffico dal pubblico sbagliato.

Per quanto sia casuale, questo tipo di cose può accadere, quindi sii consapevole di eventi esterni o interni come questo. Puoi sempre controllare le tue analisi per vedere da dove proviene il traffico e quindi riavviare il test quando tutto torna alla normalità.

Assicurati di ottenere abbastanza dati

Vuoi assicurarti che il tuo test abbia abbastanza conversioni per avere un'idea valida del suo rendimento.

Avere un controllo e una variante con solo 50 conversioni totali e solo una piccola differenza tra di loro non è sufficiente per ottenere informazioni sul tuo pubblico, anche se i risultati del test erano in qualche modo statisticamente significativi. La maggior parte degli esperti concorda sul fatto che circa 300+ conversioni per variante sono generalmente una buona regola pratica (con ancora di più se si desidera segmentare in seguito).

Più grande è il set di dati, più facile è trovare informazioni dettagliate nell'analisi post-test.

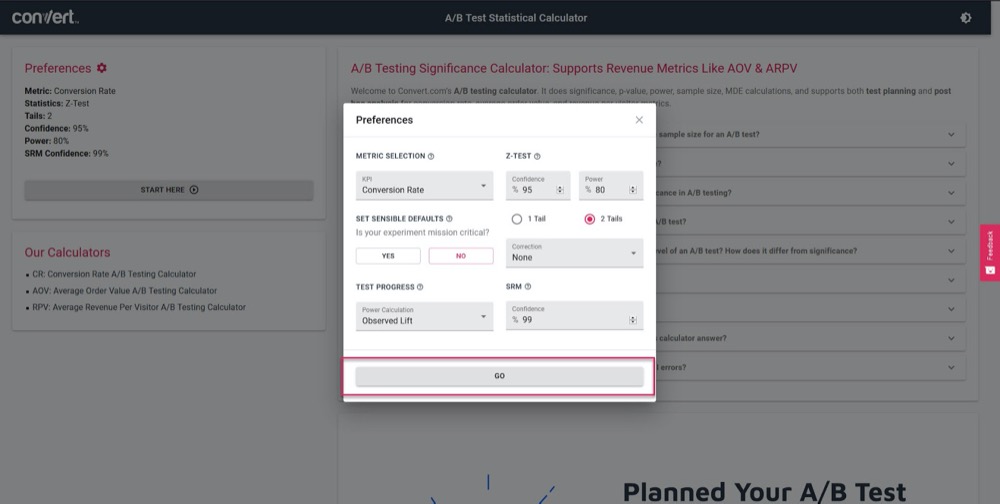

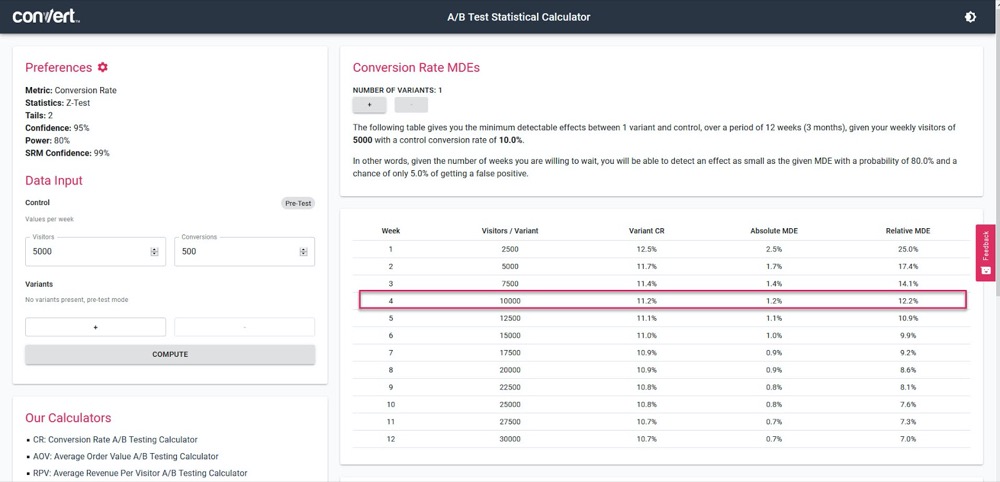

Usa il nostro calcolatore di significatività del test A/B per avere un'idea di quanto sarà accurato il tuo test, basato su un ciclo di vendita di 4 settimane e sulle informazioni della tua pagina di "controllo" corrente.

Basta impostare i parametri del test:

Quindi, inserisci la quantità di traffico che il tuo test dovrebbe ottenere a settimana, insieme al numero di conversioni della tua pagina corrente, quindi scopri l'accuratezza e la percentuale di aumento che il tuo test sarà in grado di calcolare.

Nell'esempio sopra, possiamo misurare un aumento dell'1,2% dopo 4 settimane. (Se vogliamo ottenere una maggiore precisione, esegui semplicemente il test più a lungo o aumenta il volume di traffico nel test.)

Ottieni risultati statisticamente significativi

Ecco perché la significatività statistica è importante ma non il fattore più importante durante il test.

Sì, vuoi assicurarti che il tuo test duri abbastanza a lungo da vedere un punteggio di fiducia del 95-99% nei risultati, ma vuoi anche assicurarti che ogni altro fattore che abbiamo trattato sopra sia colpito.

Come mai?

Anche un test A/A può mostrare il 95% di confidenza nel fatto che una versione sia migliore della sua copia identica se non viene eseguita abbastanza a lungo.

(Potrebbe vedere casualmente tutte le conversioni in una versione un giorno e nessuna nell'altro.)

Troppi nuovi tester interromperanno una campagna una volta che raggiunge 'stat sig' causando loro di ottenere dati falsi. Ecco perché ti consigliamo di ottenere una significatività statistica del 95% o superiore, ma ANCHE di eseguire il test su 2-4 cicli di vendita, con oltre 300 conversioni e con una dimensione del campione sufficientemente ampia.

Se fai tutto questo, puoi essere abbastanza sicuro che puoi fidarti che il tuo test ti darà risultati validi e accurati.

Non posso sottolineare abbastanza quanto sia importante far eseguire il test in modo da soddisfare questi criteri.

Chiamare un test troppo presto può darti informazioni false che possono portare a:

- Non trovare un potenziale vincitore perché non hai abbastanza informazioni,

- Pubblicare campagne con un rendimento inferiore perché ritieni che siano vincenti ma in realtà hanno un tasso di conversione inferiore,

- O peggio, puoi ottenere falsa fiducia in quei risultati e quindi utilizzare ciò che hai imparato per ridimensionarlo ad altre parti del tuo sito, aumentando così quegli effetti negativi.

Sai come il tuo strumento di test A/B giunge a conclusioni sulle varianti vincenti? Fare clic qui per utilizzare il nostro Calcolatore di significatività del test A/B.

Nota a margine:

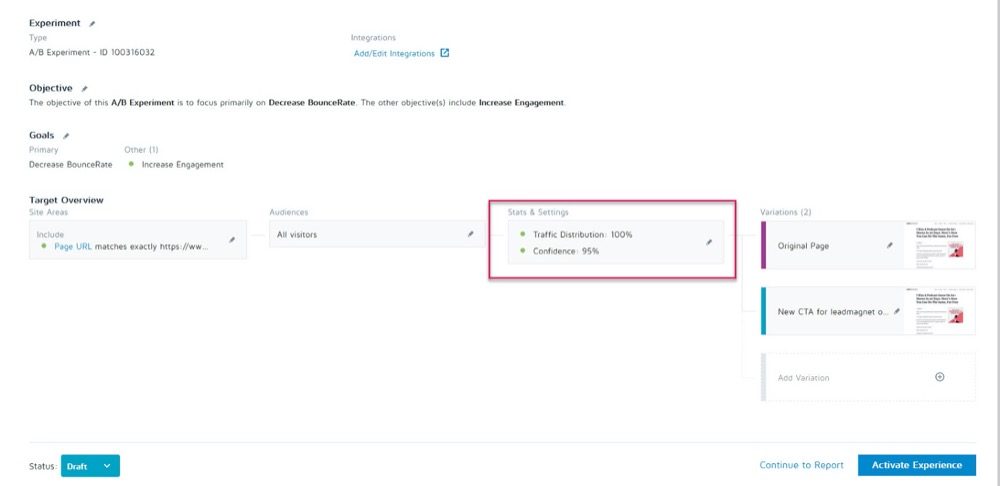

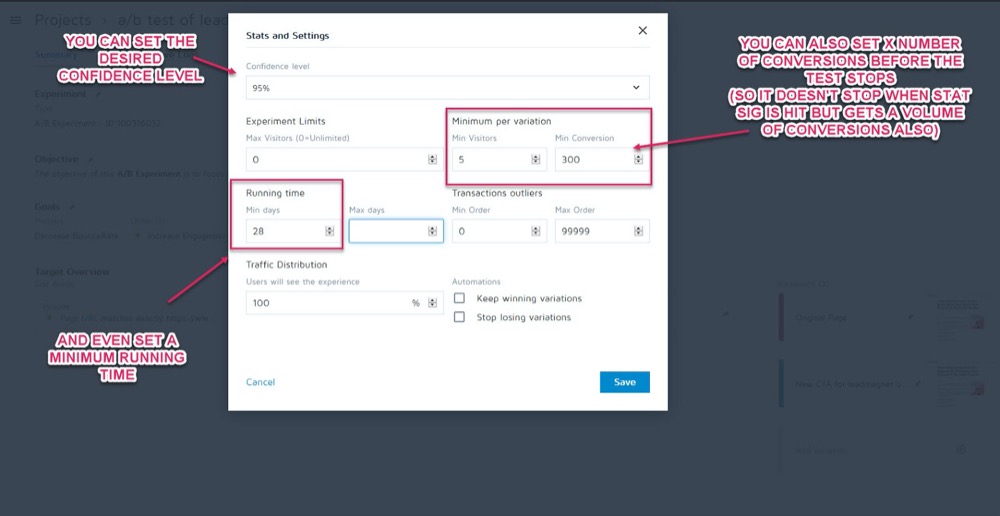

Puoi impostarli come parametri prima dell'esecuzione del test nella sezione Statistiche e impostazioni dell'esperimento nell'app Converti esperienze.

È quindi possibile impostare il livello di confidenza desiderato, il tempo di esecuzione minimo e il numero di conversioni da ottenere prima che il test possa essere chiamato.

Una volta che sei sicuro che i tuoi dati siano accurati, è il momento di analizzarli...

Passaggio 2: controlla le metriche di micro, macro e guardrail

La maggior parte delle persone esaminerà un test e prenderà il vincitore o il perdente al valore nominale da qualunque cosa lo strumento dica loro.

Il problema ovviamente è che lo strumento può dirti solo come si comporta il tuo test in base ai criteri che hai impostato per esso. Come tester CRO, vogliamo sempre capire il "come" e il "perché" che ha causato questi risultati in modo da poter imparare da loro.

Ora ci sono alcuni controlli che faremo, ma prima tratterò tre dei più importanti. È qui che entra in gioco il monitoraggio dei risultati micro e macro.

Lasciatemi spiegare:

- Il micro monitoraggio si riferisce al monitoraggio dell'obiettivo per cui hai ottimizzato il test, che potrebbe essere più clic, registrazioni, ecc.

- Il monitoraggio delle macro sta esaminando l'effetto sulla metrica Northstar per la tua attività, che di solito è costituita dalle vendite.

Perché è importante?

A volte, un aumento del microevento nella pagina di test non influisce sulla macro nel modo in cui potresti pensare.

Esempio

Diciamo che testi la CTA su una pagina di acquisizione dei lead e il perdente ottiene meno lead rispetto al controllo.

Sembra ovvio quale test ha vinto, giusto?

Ma a un'ulteriore ispezione nelle tue analisi, noti che i lead che sono arrivati in quel test di "perdita", in realtà hanno convertito molto più in alto sul back-end e hanno creato un ROI molto più grande.

Perché questo dovrebbe accadere?

Potrebbe essere che la tua pagina attuale attiri un pubblico più ampio e converta più lead, ma la tua nuova variante "perdente" è in realtà attraente per le persone che sono pronte ad acquistare in questo momento.

Nell'esempio, la campagna perdente sarebbe effettivamente la pagina con cui vorresti eseguire poiché sta convertendo molto meglio con la tua metrica Northstar.

Ricorda il tuo obiettivo finale e concentra i tuoi sforzi su ciò che lo influenza di più.

Tuttavia, i risultati micro e macro non sono tutto ciò che devi cercare.

Se non l'hai già fatto, considera l'aggiunta di "metriche Guardrail" alle tue campagne.

Queste sono le metriche di base da tenere d'occhio quando apporti altre modifiche in modo che se iniziano a diminuire, puoi annullare o interrompere determinati metodi di test perché le loro prestazioni sono troppo importanti.

In Uber, eseguiamo centinaia di esperimenti in qualsiasi momento. L'obiettivo di questi esperimenti è di migliorare continuamente i nostri prodotti e l'esperienza dell'utente. Tuttavia, a volte uno sperimentatore potrebbe avere in mente alcune metriche chiave e potrebbe non essere a conoscenza dell'impatto su poche altre metriche importanti per il team e l'azienda in generale e, durante l'esecuzione dell'esperimento, queste metriche non monitorate potrebbero regredire.

Per rilevare e mitigare tali scenari, abbiamo creato la nostra piattaforma di monitoraggio della sperimentazione. L'obiettivo è identificare e monitorare alcune metriche del guardrail che non vogliamo degradare durante le esecuzioni dell'esperimento. Applichiamo una variazione della metodologia A/B sequenziale per monitorare continuamente queste metriche di guardrail e rilevare qualsiasi regressione tra il trattamento e il gruppo di controllo di un esperimento. Se viene rilevata una regressione, inviamo avvisi al proprietario dell'esperimento .

Suman Bhattacharya, Senior Data Scientist, Uber

Esempio

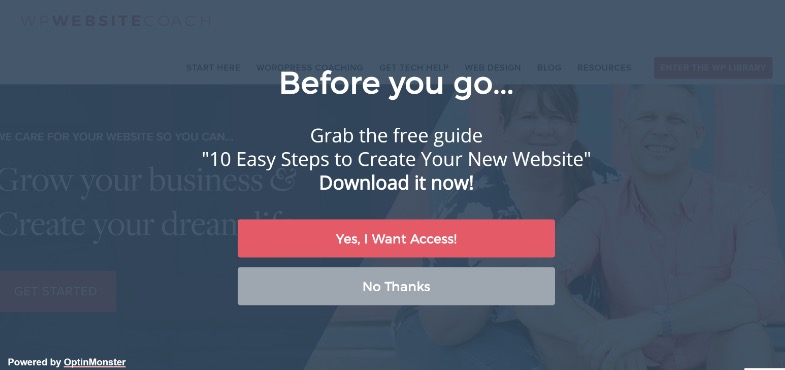

Supponiamo che tu voglia raccogliere più contatti utilizzando i popup a schermo intero.

Per alcuni siti funzionano alla grande, ma non sempre. (Ecco perché testiamo!)

Forse hai installato un pop-up a schermo intero e hai iniziato a ricevere più contatti su quella pagina, ma le tue email di benvenuto a quei nuovi abbonati rimbalzano e non vengono consegnate.

Si scopre che le persone stavano optando per e-mail false solo per far sì che i pop-up smettessero di essere mostrati.

Non vuoi falsi contatti nella tua lista e-mail in quanto possono ridurre i risultati di consegna delle e-mail agli abbonati effettivi. Né dovresti voler ridurre l'esperienza dell'utente così tanto che il tuo pubblico sente di aver bisogno di falsificare la propria e-mail.

Poiché l'email marketing è una parte fondamentale del tuo processo di vendita, decidi di impostare un avviso per informarti se la frequenza di rimbalzo dell'email supera un punto prestabilito durante l'esecuzione di test A/B sulla pagina di acquisizione dei lead.

Questa sarebbe la tua metrica del guardrail. In questo esempio, puoi vedere che non funziona e decidi di utilizzare metodi di acquisizione dei lead meno intrusivi.

Ha senso?

Tuttavia, le metriche del guardrail non sono solo l'acquisizione di lead e la frequenza di rimbalzo. Sono metriche chiave in cui non si desidera vedere un calo che influisca sull'esperienza dell'utente.

Per evitare un degrado dell'esperienza dell'utente assicurandoti al contempo di migliorare le metriche che contano, definisci alcune metriche di guardrail che, se dovessero scendere di una certa soglia, ti impedirebbero di andare avanti con l'implementazione del presunto " variante vincente”. Questo aiuta anche a porre fine al dibattito tra ottimizzazione della conversione e UX o linee guida del marchio .

Alex Birkett, Onnisciente Digitale

Sta a te decidere quali sono queste metriche per la tua attività. Usali per vedere se hai un vero vincitore o se stai semplicemente scambiando un aumento di un risultato con una perdita in un'area più importante.

Se hai bisogno di ispirazione, dai un'occhiata all'elenco di Ben Labay delle metriche comuni del guardrail durante la sperimentazione e i test:

Quindi, apporta le modifiche di conseguenza.

Finché hai configurato l'app Converti esperienze con le tue analisi e i segmenti avanzati, dovresti essere in grado di trovare queste informazioni con una rapida occhiata in giro. Controlla l'effetto di ogni variazione sulla tua metrica Northstar, così come sui tuoi "guardrail" in modo da non scegliere semplicemente il vincitore dello strumento di test.

Ora che hai coperto le tue metriche principali, esaminiamo un po' più a fondo i tuoi risultati...

Passaggio 3: approfondisci e segmenta i risultati

Ricorda che quando si tratta di test, la media è una bugia .

Il risultato medio può fornirti solo informazioni generali basate su una combinazione di più punti dati. Sta a te capire perché si è verificato quel risultato e poi guardare più a fondo perché non è sempre quello che sembra.

Lo abbiamo già visto con i risultati macro interessati dalle modifiche dei microtest, ma i segmenti di analisi possono fornire informazioni ancora più approfondite.

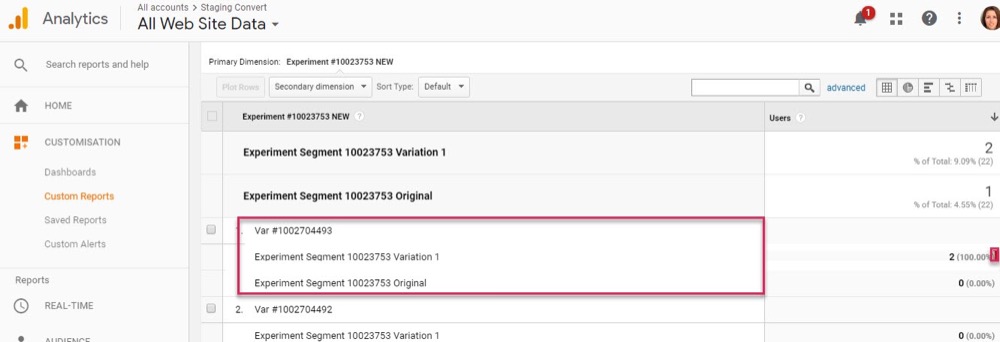

Esempio

Diciamo che stai eseguendo un test per più lead. A prima vista, il controllo e la variante hanno lo stesso tasso di conversione dei visitatori in abbonati.

Tuttavia, a un esame più approfondito, si nota che su desktop, la nuova variazione è quasi il doppio del tasso di conversione del controllo, ma su dispositivo mobile è zero, facendo sì che la media della pagina sembri identica al controllo.

Chiaramente qualcosa non va, ma perché dovrebbe succedere?

Potrebbe essere che la nuova variante non si carichi correttamente sui dispositivi mobili, o forse il modulo non funziona su dispositivi specifici, quindi nessun utente mobile che voleva abbonarsi potrebbe effettivamente farlo. E se hai risolto questo problema, è possibile che la tua variante "risultato uguale" sia effettivamente in grado di superare di gran lunga il controllo.

Puoi trovare queste cose solo quando lavori per ottenere più informazioni dietro i tuoi risultati.

Con ogni test, sperimenterai le informazioni dettagliate, che informeranno una segmentazione più intelligente, che porterà a nuove informazioni, che alla fine ti porteranno a una strategia più significativa .

Shanelle Mullins, Shopify

La segmentazione non riguarda solo la ricerca di errori, ma anche la ricerca di altre informazioni sugli utenti.

Forse la pagina e il controllo funzionano tutti bene, ma quando guardi più in profondità, noti che alcuni canali di traffico stanno convertendo molto più in alto in questo nuovo test rispetto ad altri?

Spesso avrai alcuni segmenti con prestazioni inferiori e altri con prestazioni superiori. Questo può quindi informare nuove campagne di personalizzazione o strategie di traffico a pagamento o organico.

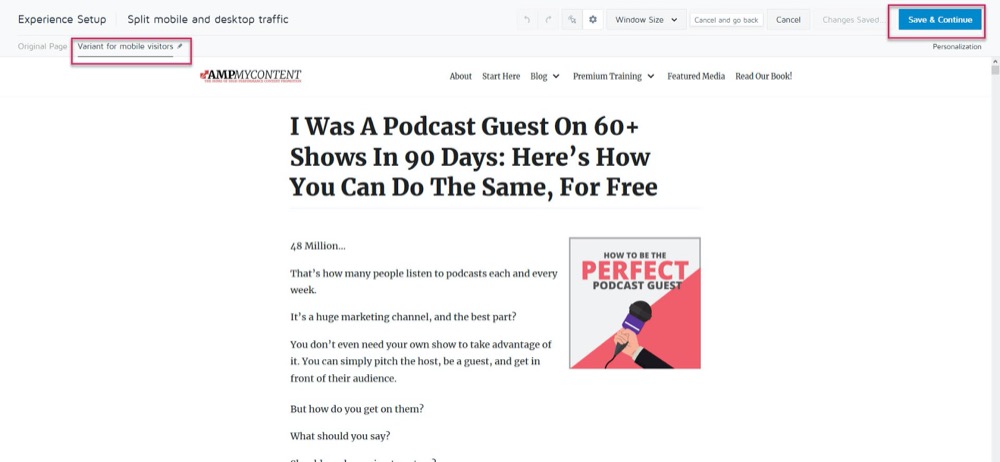

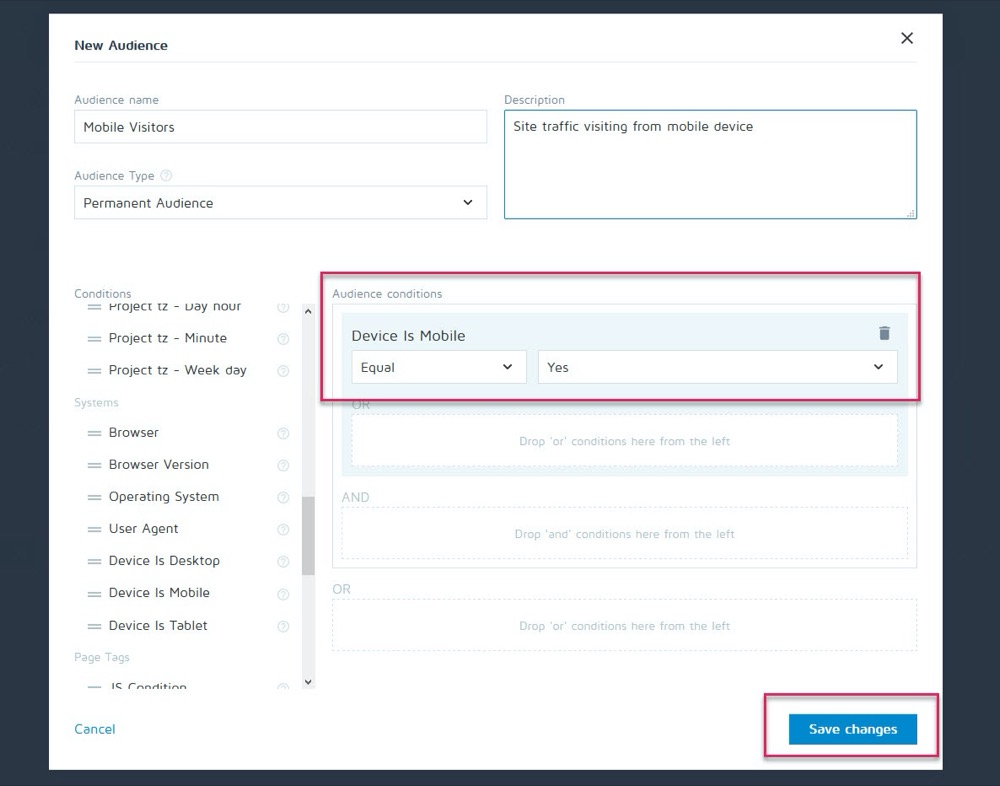

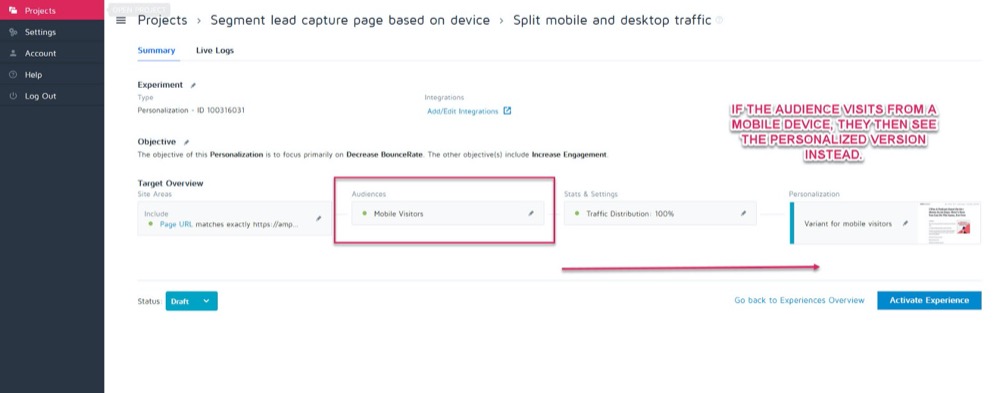

Forse il controllo converte meglio su desktop, ma la nuova variante converte meglio su dispositivi mobili. Supponiamo, ad esempio, di voler scegliere quale versione mostra in base a come lo spettatore vede il tuo sito.

Utilizzando la funzione di personalizzazione di Convert, puoi impostare quella variante vincente per dispositivi mobili come personalizzazione solo per quel pubblico.

Quindi, puoi mostrare la nuova versione quando il visitatore proviene da qualsiasi dispositivo mobile.

Ma se si imbattono in un desktop, vedrebbero invece la versione desktop.

C'è un sacco di diversi metodi di personalizzazione che puoi utilizzare, ma solo dopo aver ottenuto alcune informazioni dalle tue campagne.

La chiave per analizzare i segmenti è esaminare sempre i risultati per sapere PERCHÉ è successo qualcosa.

Guarda a:

- Nuovo Vs pubblico di ritorno . Una variazione riporta le persone indietro più spesso? Si sta convertendo più membri del pubblico freddo/nuovo?

- Sorgente di traffico. Un canale sta andando meglio di altri? Potresti concentrarti di più qui?

- Visualizzazioni di pagina. Soprattutto se la tua pagina di test sta cercando di indirizzare il traffico verso la tua pagina di vendita. La mancanza di clic su una versione potrebbe significare che hai un pulsante rotto o un problema CTA.

- Frequenza di rimbalzo. Ciò può indicare un collegamento interrotto/carico lento/esperienza UX scadente o persino rivolgersi al pubblico sbagliato.

- Sistema operativo,

- Mobile vs desktop.

- Dispositivo utilizzato.

Un leggero disclaimer:

Per ottenere un riflesso accurato di ciascun canale durante la segmentazione in questo modo, sono necessari MOLTI dati. Una buona regola pratica è eseguire un test con circa 10 volte il volume di conversioni che potresti eseguire normalmente (o 300 conversioni per canale, non solo per pagina variante).

Potresti pensare: "Non c'è modo di ottenere abbastanza traffico per eseguire un test come questo ". O se lo fai, potrebbero volerci mesi prima che accada.

Anche se è così, non saltare semplicemente l'analisi dell'analisi del segmento.

Come mai?

Anche se potresti non avere abbastanza conversioni in ogni segmento per trarre conclusioni supportate dai dati, può darti alcune informazioni lampanti se inizi a vedere problemi come visualizzazioni di pagina con zero clic o una frequenza di rimbalzo immediata .

Queste sono tutte cose che potrebbero indicare un test non superato e aiutarti a trovare un vincitore potenzialmente mancato. Vai avanti e cerca eventuali interruzioni e problemi importanti. Tutto funzionava su ogni piattaforma e dispositivo?

Idealmente, li hai controllati tutti prima del test, ma le cose possono rompersi a metà del test, quindi controlla di nuovo.

Personalmente ho fatto in modo che WordPress si aggiornasse automaticamente a metà campagna, il che ha fatto sì che i moduli di acquisizione dei lead smettessero improvvisamente di funzionare durante la metà di un test. Effettua sempre il check-in e, se vedi qualcosa che sta rovinando l'accuratezza dei tuoi risultati, interrompi il test, ripara il problema ed esegui di nuovo.

E se tutto funzionasse bene?

Diamo un'occhiata e scopriamo PERCHE' le persone non hanno intrapreso la tua azione...

Passaggio 4: controlla il comportamento dell'utente per ulteriori approfondimenti

Idealmente, dovresti avere un monitoraggio qualitativo in atto sopra il tuo strumento di test.

Come mai?

Perché questo può spesso darti informazioni sulla tua variante che ti mancherebbero con i soli test regolari.

Ricorda:

Strumenti di test quantitativi come Convert ti dicono cosa è successo. Possiamo fornirti i dati numerici grezzi tra quante persone hanno cliccato o non hanno cliccato e aiutarti a impostare ogni test A/B.

Ma l'aggiunta di strumenti qualitativi ti aiuta a capire PERCHÉ è avvenuta un'azione. Ti consentono di vedere cosa stava facendo l'utente e ottenere maggiori informazioni sulle sue azioni.

(I test di solito falliscono a causa della scarsa esecuzione o della comprensione del pubblico ed è solo vedendo cosa è andato storto che possiamo risolverlo.)

Utilizzando uno strumento come Hotjar, puoi eseguire una serie di test qualitativi e persino estrarre i dati direttamente nella dashboard di Converti con la nostra integrazione integrata.

Per ottenere informazioni più approfondite, imposta l'integrazione Hotjar – Converti e prova le tattiche seguenti.

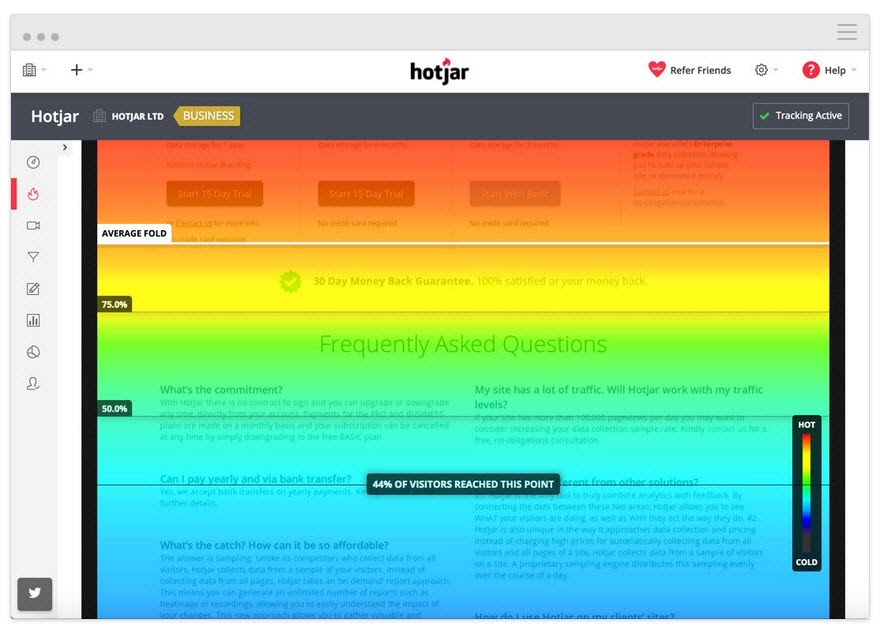

Tieni traccia di quanto in basso l'utente legge

Aggiungi uno strumento heatmap alla tua pagina per vedere se il tuo pubblico arriva fino al tuo CTA. In caso contrario, puoi eseguire nuovamente il test e spostare l'invito all'azione più in alto nella pagina.

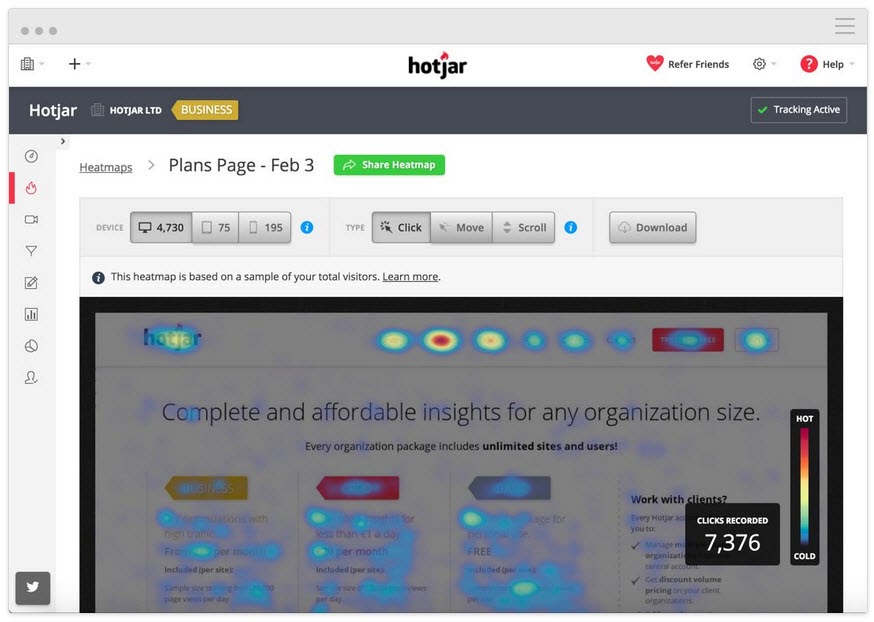

Tieni traccia di ciò su cui gli utenti fanno clic, ma non dovrebbero

Fanno clic su CTA strategici o è un testo casuale che pensano possa essere invece un collegamento?

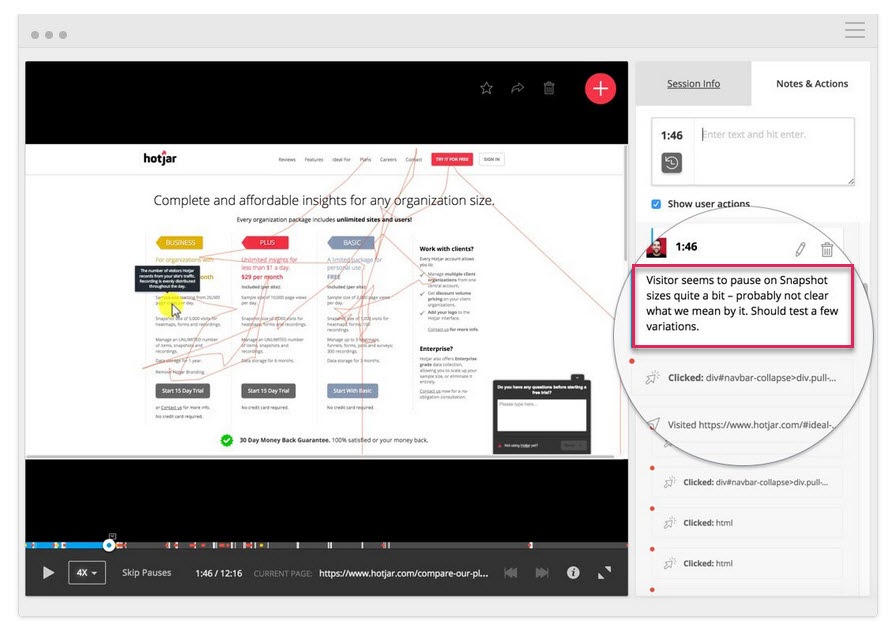

Guarda le registrazioni dello schermo per vedere su cosa non fanno clic, ma dovrebbero

Non stanno facendo clic sul tuo pulsante CTA anche se scorrono abbastanza per vederlo? Stanno facendo clic ma non si apre? Lo vedono ma non si rendono conto che è un pulsante su cui fare clic?

Puoi guardare tutto questo e persino aggiungere note quando queste cose saltano fuori.

Non sono solo gli strumenti di mappatura termica e tracciamento dei clic che possono aiutare.

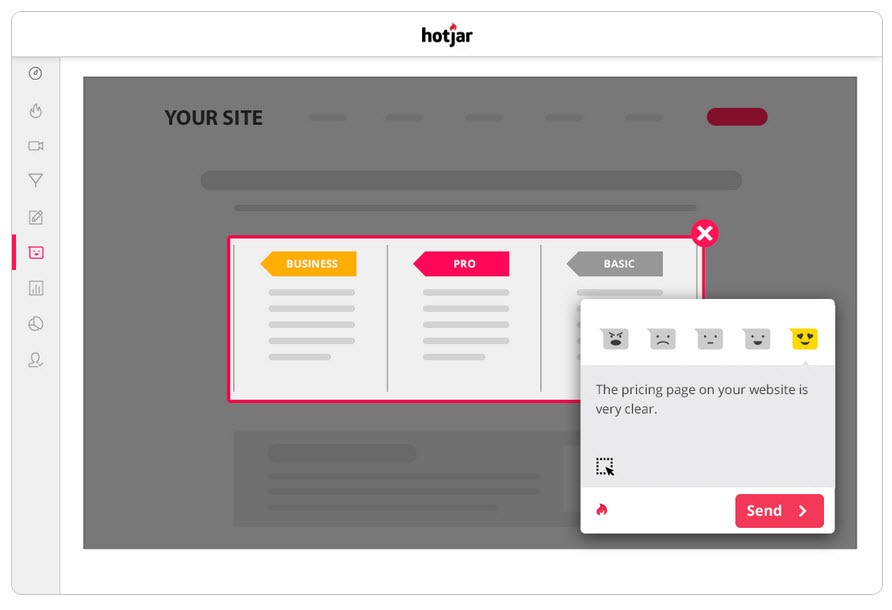

Esegui sondaggi per il tuo pubblico

I sondaggi ti aiutano non solo a ottenere feedback su ciò che ha indotto il tuo pubblico ad agire (o a fermarlo), ma anche a fornirti il linguaggio che usa per descriverlo.

Nel copywriting, chiamiamo questo "linguaggio specchio" ed è incredibilmente efficace nel connettersi con l'utente. Sembra che tu non solo riconosca il loro problema, ma lo capisca meglio di chiunque altro, poiché lo descrivi con le stesse parole che usano.

Due ottimi modi per utilizzare i sondaggi insieme al tuo strumento di test A/B sono:

- Uscire dai sondaggi di intenti . Identifica coloro che non prendono la nuova versione, così puoi scoprire cosa li ha fermati.

C'è un motivo per cui non hai optato/acquistato oggi?

- Sondaggi post-acquisto/conversione. Trova quelli che prendono la variante e vedi se ci sono stati punti critici e fattori motivanti.

Cosa ti ha fatto decidere di agire oggi?" C'è stato qualcosa che ti ha quasi impedito di decidere?

Puoi anche eseguire sondaggi simili sul controllo se desideri maggiori informazioni. Tutto ciò ti aiuterà a capire come si è svolto il test in modo da poter iterare e migliorare.

A proposito…

Passaggio 5: impara dai test perdenti

La cosa più importante quando si tratta di ottenere un test perdente è imparare qualcosa dal risultato. Non esiste un brutto test purché tu possa trarre spunti da esso per migliorare o comprendere meglio il tuo pubblico.

Il test A/B è un processo interattivo. Falliamo in avanti mentre acquisiamo comprensione. Spesso puoi imparare molto di più dal superare un test perdente contro un vincitore piuttosto che ottenere un vincitore a titolo definitivo.

Finora abbiamo fatto 3 cose:

- Assicurarsi che i dati del test siano accurati,

- Guardando i risultati grezzi per eventuali problemi, e

- Cercando di capire i nostri utenti e le loro azioni.

Questo passaggio è più un approccio euristico per aiutarti a comprendere i problemi comuni che possono causare un errore (supponendo che i dati del test siano accurati e che i pulsanti CTA funzionino tutti) e analizzare il tuo approccio e ipotesi.

La tua ipotesi era sbagliata o il tuo test era disallineato?

Questo è un problema comune, soprattutto tra i nuovi tester.

Hai eseguito il test su alcune metriche o idee "woo woo" che non erano allineate con un KPI reale?

Esempio

Diciamo che vuoi più vendite da una pagina, ma per qualche motivo hai deciso di testare le modifiche ai tuoi pulsanti di condivisione social. (Anche se non hai dati per dimostrare che più condivisioni social influiscono sulle tue vendite.)

Sembra pazzesco, ma rimarrai sorpreso di quanto spesso accada qualcosa del genere.

Chiedilo a te stesso:

Il mio obiettivo di test è allineato con un KPI di base e in un modo che può influenzarlo?

In caso contrario, va bene, ma assicurati che il test successivo si allinei meglio.

Falliamo, impariamo, ci riproviamo.

Con il tuo prossimo test, assicurati di concentrarti sulle metriche KPI di base e su come puoi influenzarle e fornisci al test un chiaro scenario vincente/fallito.

Vogliamo che questa pagina ottenga più lead, quindi stiamo testando la cosa che li porta a partecipare, il che significa che vogliamo creare un CTA migliore.

o

Vogliamo che questa pagina ottenga più lead e abbiamo scoperto che gli utenti non scorrono fino al nostro CTA, quindi stiamo testando l'aumento della pagina.

Avere il tuo test allineato con il tuo obiettivo ti porterà sulla strada giusta, ma anche in questo caso, potrebbe comunque non vedere più conversioni...

L'ipotesi era corretta e il test era allineato, ma non c'era ancora alcun cambiamento nei risultati

Questo può accadere il 90% delle volte ed è per questo che la maggior parte dei test fallisce.

Esempio 1

I tuoi dati utente mostrano che gli utenti non si fidano abbastanza del tuo sito. Hai aggiunto fattori di fiducia come prove sociali, testimonianze degli utenti, certificati SSL, ma le conversioni non sono ancora aumentate.

Significa che dovresti fermarti e provare un nuovo test o angolo?

Affatto…

La tua ipotesi iniziale potrebbe essere stata giusta, ma il tuo test deve solo essere migliorato o eseguito meglio prima di poter vedere qualsiasi effetto.

Potresti provare ad aggiungere più fattori di fiducia o anche spostare quelli che hai in modo che si distinguano di più. Forse riformula la lingua usata in loro per aiutarli a connettersi meglio con il tuo pubblico.

Tutte queste cose sono ancora in linea con l'ipotesi iniziale, devi solo testare più versioni per trovare il vincitore.

Esempio #2

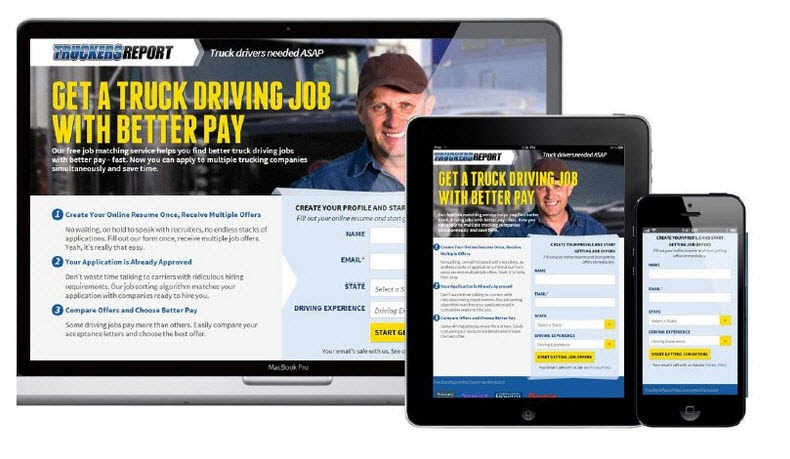

CXL ha condotto 6 diverse campagne di prova su questa pagina di destinazione per ottenere più contatti per le certificazioni di camionisti.

Hanno aumentato il tasso di adesione dal 12,1% al 79,3%, il tutto per continuare a migliorare la pagina.

(Quasi tutte quelle campagne di prova hanno effettuato più tentativi utilizzando la stessa ipotesi prima di vedere un aumento. Solo allora sono andati avanti e hanno testato per migliorare gli altri elementi della pagina.)

Il test A/B è un processo iterativo. Devi continuare a testare e modificare per trovare miglioramenti, e anche i migliori del settore possono trovare un vincitore solo il 10% delle volte.

Se ipoteticamente tu fossi un'organizzazione e ogni test che hai eseguito fosse un successo, secondo me sarebbe effettivamente una bandiera rossa.

Sembra controintuitivo, ma mi mostra che stai solo testando cose ovvie e che non si corrono rischi sufficienti per muovere davvero l'ago .

Deborah O'Malley, Indovina il test

È sempre bello imparare dai migliori e siamo entusiasti di condividere l'intervista che abbiamo fatto con Deborah. Abbiamo parlato del perché i test non sono mai un fallimento e dell'importanza di avere la giusta mentalità nei test. Per aiutarti a iniziare con il piede giusto, ascolta la nostra intervista qui.

Ciò significa che potresti aver bisogno di 9 test prima di vedere un aumento positivo, quindi attieniti.

I tuoi test dovrebbero seguire un sistema di priorità dal maggior impatto al più basso. Eseguendo più test e modifiche per migliorare la tua campagna attuale, vedrai un impatto molto maggiore rispetto al passaggio a un test di importanza inferiore perché non vedi risultati immediati con quello attuale.

E se ancora non vede un miglioramento con modifiche minori, prendi in considerazione l'esecuzione di un test innovativo in cui esegui un design diverso.

Può essere un'altalena per la recinzione, ma a volte può essere il cambiamento che devi apportare.

E se dopo tutti questi test e modifiche, la variante fosse ancora un perdente?

Quindi i dati sono corretti e hai provato ogni modifica e persino apportato grandi modifiche innovative all'intera pagina e non funzionerà ancora meglio del controllo.

Potrebbe non sembrare, ma in realtà è una BUONA COSA.

Come mai?

Perché hai scoperto cosa non funziona con il tuo pubblico!

Così tanti siti Web apportano enormi modifiche radicali senza testare nulla e semplicemente lo implementano a prescindere.

Chiediti questo:

Se quella variante di pagina converte solo dell'1% in meno rispetto al tuo attuale controllo, quanti soldi hai risparmiato testandolo prima e non implementandolo?

Back in 2014, Marks and Spencer decided to update their entire website without testing it with a sample audience first.

Il risultato?

Their online sales dropped by 8.1% in 3 months, causing a loss of $55 million.

This is why testing and finding losers is a really good thing because even losing tests can save you money.

What if the Test and the Variant Have Identical Results?

You checked everything, it all works, you've segmented down and gone into the nitty-gritty, but there's just no discernible difference between your current page and your new variant.

You've even tried complete page overhauls but through some fluke of math, your new page still converts at the same rate as the old one.

In this case, it's simply the dealer's choice.

Does the new variation more actively represent your brand and style?

If so, choose whichever you wish to use. The results are still the same but you are happier with the design.

Note: This should be the only time that you do this. Branding should not sacrifice results; it should aid them, as seen in the previous example.

Step #6: Double Down on Winners and Continue to Improve Them

So far we've been covering losing campaigns, but what if you got a winner right out of the gate?

First off, congratulations!

Second, let's make sure you actually have a winner. Oftentimes, things can happen to affect your results and give you a false positive (ie we think it's a winner but we implement it and nothing happens.)

Go ahead and run the test again with just your control and the winning variant and prove the lift in results first before you make any changes to your site.

Then if it really is a winner? Don't stop there, continue to improve it!

Iterative improvements of a new winning campaign are the easiest new test to run. With each new improvement, you'll see more ongoing ROI. You can even take what you learned with your winning test and then roll it out across similar pages on your site for further tests and see if it also adds lift there too.

Step #7: Create a Learning Repository for Future Tests

This step is relevant to both winning and losing tests.

Not only will it help you with future tests, but it will also help your QA team diagnose any broken campaigns faster, as they can see where issues have appeared in the past.

Better still?

It will help you document your results for clients or your boss, while also standardizing your reporting processes and ramping up your test velocity.

Ecco come funziona:

You're going to create a master archive or learning repository of all past tests. A place to document your previous wins and losses that you can use to both reference for new campaigns and share with stakeholders or customers.

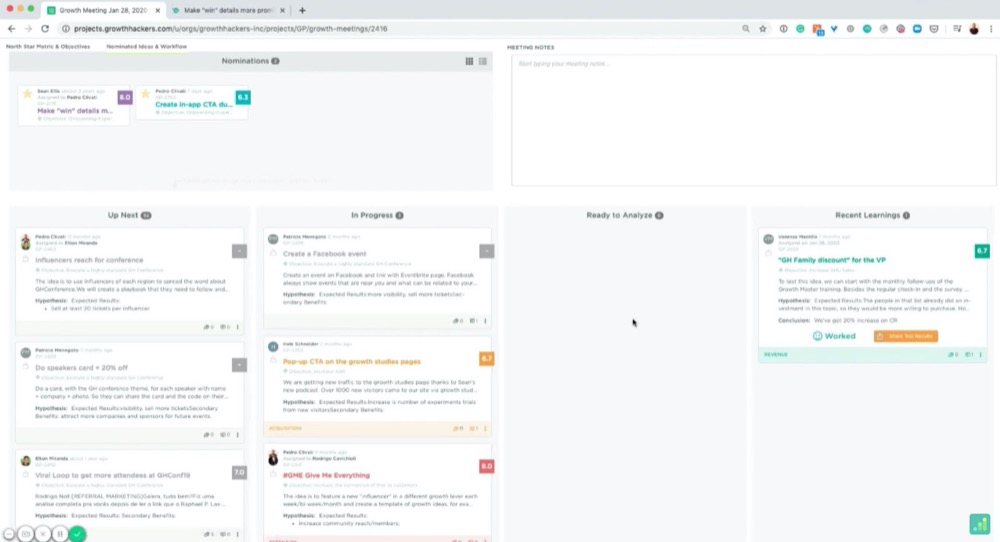

You can use a folder on your computer for this, but, if you really want to get organized, there's a great tool called GrowthHackers experiments.

Its main goal is to help marketing growth teams communicate and organize campaigns, but you can easily use it to manage your CRO testing and learnings. It will even pull in results from your test tool and allows you to archive each test. (You can simply tag and then add them to the repository.)

Whatever you decide to use, here are some best practices:

Organizing Your Tests

You probably have your own naming conventions but if you're just starting, I recommend naming each test like so:

“Goal – Campaign – Test Date”

Per esempio:

“CTR lift test – XYZ client – March 1st-14th 2021”

This way, you can organize tests by goals to get inspiration for future tests, search through and find them for client campaigns, or look back on your experiments month by month.

Then, if you wanted to run a CTR test later on, you can swipe through them and see what ideas worked or failed in the past.

How Do We Create Documents for the Learning Repository?

Feel free to add screenshots of your testing tools graphs, confidence, and power level or any data that you think is relevant.

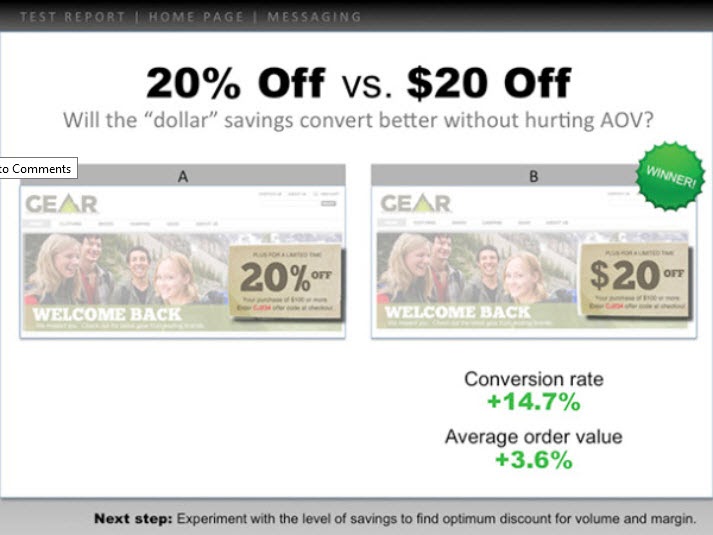

However, I highly recommend creating a slide with the following information:

- The hypothesis and how you came up with the idea (any survey data or information).

- A headline with the test goal.

- A screenshot of the control, the winning variant, and any other failed versions/tests that got some lift but not as much. (Highlight the key elements so you can spot what changed without having to look too hard.)

- Add the micro goal and its percentage lift. (Perhaps 3.2% CTR)

- Then add the macro goal and its percentage lift. (AVG order value up 2.2%, etc.)

Here's an example:

You can use these slides to present the test information to anyone else who needs them, while also having a simple file to understand the test at a moment's notice.

Pretty handy, right?

Now that you've analyzed your test and recorded the results, let's walk you through how to present this to your boss in a way that even if the test failed, they're still happy to see your findings…

How To Present This Information To Your Boss (Even When Your Campaigns Failed)

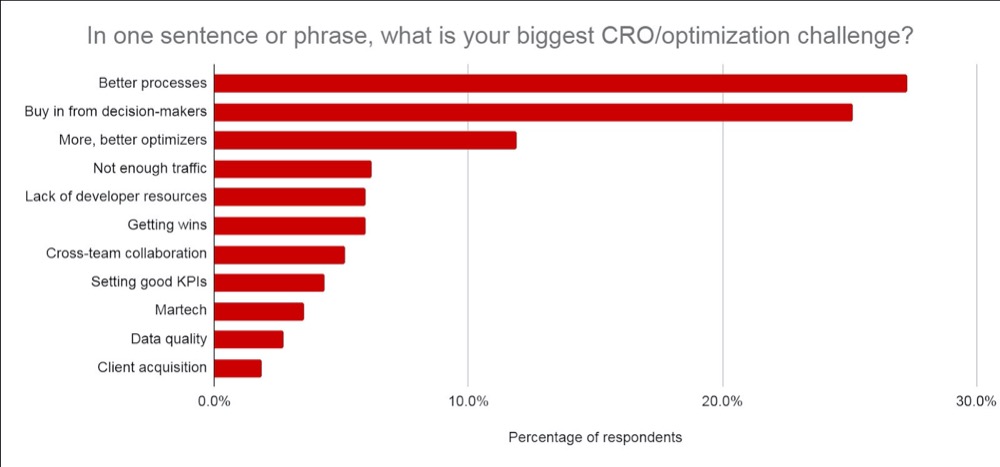

Don't worry if you feel anxious about this, you're not alone. In fact, according to CXL's state of the industry report, presenting test information or getting buy-in from your stakeholders is consistently one of the biggest struggles CROs face.

We've covered the best ways to communicate this information before, but I want to give you a few extra tips on how to get your test results across (even if your test failed).

Tip #1: Get Everyone On Board With CRO and Its Realities as Soon as Possible

Ideally, you covered this when you first broached the topic of running A/B tests but it never hurts to recap.

Make sure they understand that A/B testing is a continual learning process that's more about understanding your audience and improving their experience. The lift in ROI is simply a byproduct of taking action on each test and implementing what you learn, regardless of if it wins or fails.

Winners give lift and losers give insight into where to improve.

No test is ever wasted but the majority of them do fail. You're looking at roughly 1/10 winners for most people's tests and agencies are around 1/4.

Be clear on how many tests fail and the need to run more tests to find winners.

Tip #2: Present the Information as Simply as You Can

Not everyone can read graphs easily. Even if they can, it still means that it takes effort to understand the context of what they are seeing.

The more effort it takes to understand something, the more frustrating it can be and can cause you to lose the other person's attention.

(Top tip for landing pages btw ^^)

Break it down nice and simple by using the slides from your learning repository.

It should already include:

- Cosa hai imparato in anticipo e come sei arrivato all'idea del test.

- Quello che hai testato. Mostra il controllo, le variazioni e il vincitore.

- Come ha funzionato a livello micro e macro. Includi i risultati.

Finally, add any insights you drew from tests to decide on your next important action to take. (Improve execution, test new variations, new hypothesis, etc.)

Providing insight into what happened is HUGE.

Il tuo capo si preoccupa più di ciò che hai imparato che dei risultati, poiché è possibile agire su questo. Condividerlo e dare idee su cosa fare dopo li aiuterà a capire che hai il controllo della situazione e li aiuterà a sentirsi sicuri di ulteriori test.

Suggerimento n. 3: falli sembrare belli

Fai un ulteriore passo avanti e aggiungi i dati a cui tengono:

- Se il test ha fallito, fornisci informazioni sul motivo per cui pensi che abbia fallito . Aggiungi il ROI risparmiato non implementando il test fallito e come influirebbe su MRR e ARR.

- Se ha vinto, fornisci informazioni dettagliate sul ROI realizzato e su come questo influisca sui ricavi / MRR e ARR anno dopo anno , insieme a qualsiasi opportunità per ridimensionarlo ulteriormente e ottenere un aumento del ROI. (ad esempio, potresti aver testato una pagina di acquisizione dei lead e notato un aumento durante la modifica del layout. Potresti avere altre 30 pagine simili a cui potresti applicare questo test che potrebbero vedere un potenziale aumento.)

- Se il test è stato piatto, condividi informazioni su ciò che pensi sia successo e su cosa fare dopo. (Migliore esecuzione, una nuova variante, una modifica totale o un test meglio allineato, ecc.)

Certo, l'impatto ARR + MRR o YOY è una stima approssimativa, ma mostra l'impatto potenziale e il valore dei tuoi test. Questo è ciò che interessa al tuo capo e ciò a cui probabilmente starà pensando quando vedrà i tuoi risultati.

Credimi, quando presenti le tue informazioni in questo modo, noterai che è molto più facile. Si passa dall'inquadrare il test come "soldi persi" o una perdita di tempo a concentrarsi invece su potenziali risparmi, guadagni effettivi e potenziale ulteriore crescita.

Non solo, ma sarai anche in grado di dimostrare il valore nell'esecuzione di ancora più test, maturando i tuoi sforzi CRO e aumentando la velocità del test.

Conclusione

Ecco qua.

A questo punto, dovresti sentirti molto più sicuro su come analizzare e imparare dai risultati dei tuoi test A/B ed essere in grado di presentare queste informazioni al tuo capo o a chiunque altro, indipendentemente da come sono stati eseguiti i tuoi test.

Segui semplicemente questa guida per semplificare l'analisi post-test di ogni nuovo test A/B che esegui!