Tutto sui test A/A: perché e quando dovresti eseguire i test A/A?

Pubblicato: 2022-07-07

Il test A/A consente di testare due pagine identiche l'una contro l'altra e può essere estremamente utile quando si imposta un nuovo strumento di test A/B.

È possibile utilizzare il test A/A

- valutare l'accuratezza di una piattaforma di test A/B,

- determinare se la tua piattaforma di test A/B è completamente integrata con le tue analisi interne,

- identificare possibili problemi tecnici con il tuo strumento di test A/B,

- fornire un tasso di conversione di base per una pagina o una canalizzazione,

- determinare la dimensione del campione appropriata da utilizzare per i test A/B e

- confronta le prestazioni delle tue pagine e delle tue canalizzazioni.

Convert fornisce funzionalità di test A/A e A/B, per assicurarti di avere tutto ciò di cui hai bisogno per progettare e sviluppare con successo un sito Web ad alta conversione.

Continua a leggere per saperne di più sul significato dei test A/A e su come impostare la tua prima esperienza!

- Che cos'è il test A/A?

- Perché eseguire A/A Test?

- Verificare l'accuratezza della piattaforma di test A/B

- Determina l'entità dell'integrazione con le tue analisi interne

- Identifica possibili problemi tecnici

- Fornisci il tasso di conversione di base per qualsiasi pagina o canalizzazione

- Trova la dimensione del campione necessaria

- Confronta le prestazioni delle tue pagine e delle tue canalizzazioni

- Impostazione di un'esperienza A/A

- Come interpretare i risultati del test A/A?

- Ci aspettiamo risultati inconcludenti su un'esperienza A/A

- Cosa significa se ottieni variazioni non identiche?

- Quali sono le sfide dei test A/A?

- Casualità

- Grande dimensione del campione

- Converti esperienze e test A/A

- Come impostare i test A/A all'interno delle esperienze di conversione?

- La pura esperienza A/A

- L'esperienza calibrata A/A/B o A/A/B/B

- Esegui molte esperienze A/A

- Posso eseguire un'esperienza A/A contemporaneamente a un'esperienza A/B?

- Processo di controllo qualità pre-test: un'interessante alternativa ai test A/A

- Può esistere SRM nei test A/A?

- Come impostare i test A/A all'interno delle esperienze di conversione?

- I vantaggi dei test A/A superano gli svantaggi?

Forse qualcosa del genere ti è già successo prima...

- Esegui un test A/B per vedere se il tuo nuovo pulsante CTA e titolo aumenteranno le conversioni.

- Nel mese successivo, invii la stessa quantità di traffico sia alle pagine di destinazione di controllo che a quelle delle varianti.

- Il tuo software dichiara che la tua variante è la vincitrice (con una sicurezza del 99%), quindi ti fermi.

- Quindi lanci il tuo design "vincente", ma dopo diversi cicli economici, vedi che l'aumento del 50% del tuo tasso di conversione ha avuto scarso effetto sul tuo reddito netto.

La spiegazione più probabile è un risultato del test falso positivo. Fortunatamente, ci sono vari metodi per gestire i test errati.

Uno di cui potresti aver sentito parlare è il test A/A.

Che cos'è il test A/A?

Prima di immergerci nei test A/A, parliamo di test A/B, in modo da poter evidenziare le differenze.

In una tipica esperienza A/B, il traffico è suddiviso tra due o più varianti alternative.

Una variazione è solitamente designata come "controllo" o "originale". Tutte le altre variazioni dell'esperienza vengono confrontate con il controllo, per determinare quale produce la spinta maggiore in una determinata metrica.

Il test A/A, d'altra parte, richiede che il traffico sia allocato a due variazioni identiche, solitamente utilizzando una divisione 50/50.

In un normale test A/B, l'obiettivo è trovare un tasso di conversione più elevato, mentre, in un test A/A, lo scopo è di solito esaminare se le variazioni hanno lo stesso incremento.

In un test A/A, il traffico viene suddiviso in modo casuale, con entrambi i gruppi visualizzati sulla stessa pagina.

Quindi, vengono registrati i tassi di conversione riportati, i tassi di clic e le statistiche associate per ciascun gruppo, nella speranza di imparare qualcosa.

Test A/A = 2 pagine identiche testate l'una contro l'altra

Ora, diamo un'occhiata ad alcuni esempi di dove possono essere utilizzate le esperienze A/A, per determinare se ti saranno utili.

Perché eseguire A/A Test?

L'esecuzione di un test A/A può essere particolarmente efficace durante le varie fasi del processo di progettazione e sviluppo web, come ad esempio:

- Al termine dell'installazione di un nuovo strumento di test A/B,

- Quando la configurazione del tuo attuale strumento di test A/B è stata aggiornata o modificata,

- Quando crei un nuovo sito web o un'app,

- Quando noti discrepanze tra i rapporti sui dati del tuo test A/B e altri strumenti di analisi che utilizzi.

Diamo un'occhiata più approfondita a ciascuno di questi casi d'uso.

Verificare l'accuratezza della piattaforma di test A/B

Un'esperienza A/A può essere lanciata da un'azienda che desidera acquisire una piattaforma di test A/B o da un'azienda che desidera provare un nuovo software di test (per confermare che sia impostato correttamente).

In un'esperienza A/A, confrontiamo due versioni completamente identiche della stessa pagina, con l'obiettivo di avere valori di conversione simili.

Il risultato atteso è inconcludente se non vi è alcuna differenza tra il controllo e la variazione.

Anche così, a volte viene dichiarato un "vincitore" su due copie identiche.

Quando ciò si verifica, è fondamentale valutare la piattaforma di test A/B, poiché lo strumento potrebbe essere stato configurato in modo errato o potrebbe essere inefficace.

Come passaggio successivo, dovresti:

- Verifica di aver installato correttamente il codice di monitoraggio A/B

- Controlla la tua Area del Sito

- Controlla il tuo pubblico

- Controlla i tuoi obiettivi

- Contatta il team di supporto per i test A/B per capire se è qualcosa che può essere risolto prima di abbandonare la tua piattaforma.

Si spera che il problema sia uno dei precedenti. Se non riesci a capire il problema, questo probabilmente significa che il test A/A è conclusivo e la tua piattaforma di test A/B è imprecisa.

Determina l'entità dell'integrazione con le tue analisi interne

Quando controlli l'accuratezza di una piattaforma di test A/B, puoi utilizzare un test A/A per valutare se la piattaforma è completamente integrata con il tuo strumento di analisi.

Che tu stia utilizzando Google Analytics, Heap Analytics, Adobe Analytics, Plausible, Matomo o qualsiasi altro, puoi confrontare i risultati del test A/A con il tuo strumento di analisi interno per determinare se l'integrazione ha funzionato come previsto.

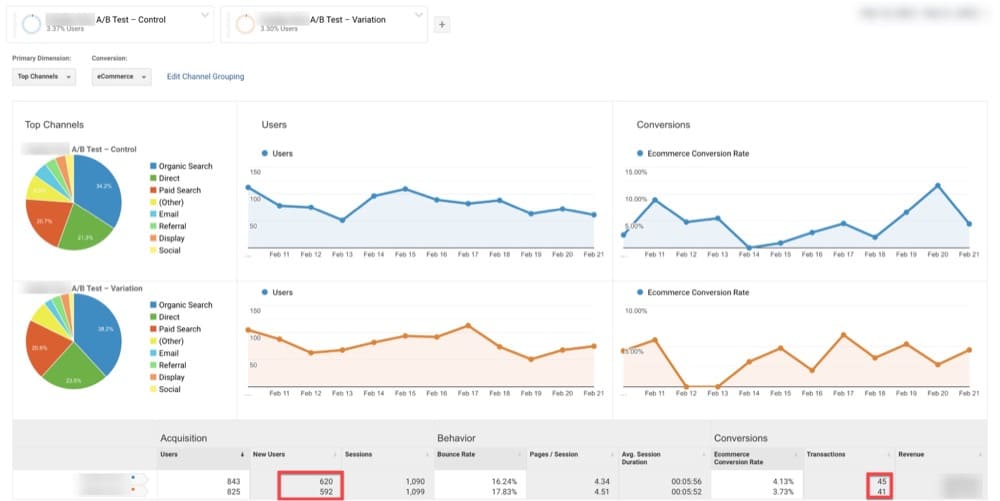

Ad esempio di seguito, GA ha identificato 620 visitatori sull'Originale e 592 sulla Variazione (pagina identica all'Originale).

Per lo stesso intervallo di date, Convert ha rivelato 972 visitatori su Original e 980 su Variation (pagina identica a Original).

Questo potrebbe essere un segno che l'integrazione tra le due piattaforme non sta funzionando come previsto.

Identifica possibili problemi tecnici

Puoi anche utilizzare un test A/A per identificare possibili problemi tecnici.

La maggior parte dei software di test A/B utilizza metodi leggermente diversi e potrebbero comportare variazioni significative, a seconda di quanto viene spinto il programma.

Potrebbe sembrare un'anomalia, ma potrebbe anche suggerire un problema di fondo più serio con uno dei seguenti:

- Formule matematiche e statistiche

- Algoritmi di randomizzazione

- Cookie del browser

Puoi utilizzare le esperienze A/A per rivelare i problemi di cui sopra.

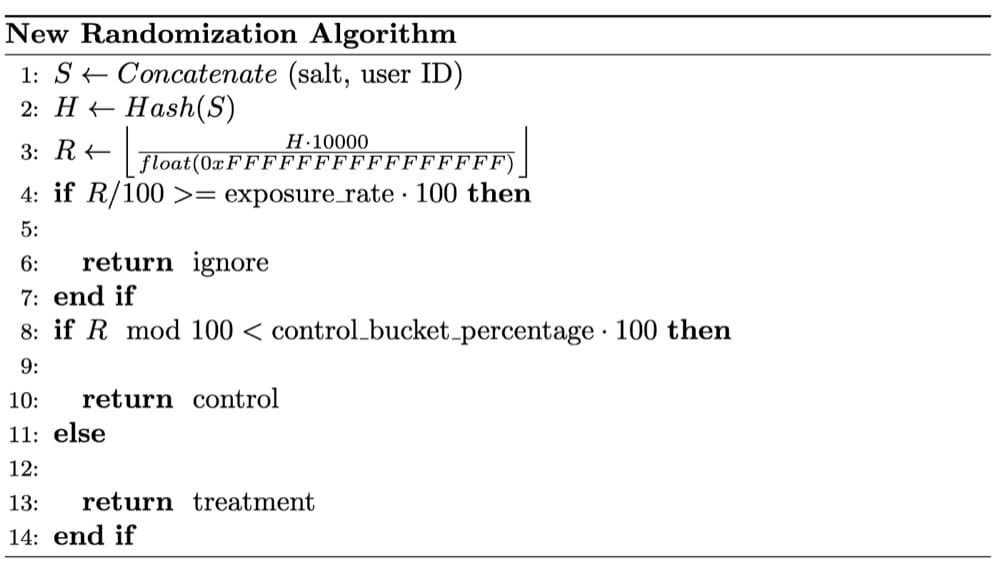

Nel caso seguente, i data scientist di Wish hanno notato problemi di SRM su un test A/A. Dopo un esame approfondito, è stato stabilito che l'SRM era causato dal fatto che la loro randomizzazione non era completamente casuale.

La tecnica di randomizzazione è fondamentale per risultati sperimentali affidabili.

L'uso di campioni randomizzati è un presupposto essenziale dei test statistici impiegati nei test A/B.

La randomizzazione bilancia i fattori utente osservati e non osservati tra i bucket dell'esperimento. Stabilisce una relazione causale tra la caratteristica del prodotto da testare e qualsiasi modifica nei risultati della sperimentazione.

Fornisci il tasso di conversione di base per qualsiasi pagina o canalizzazione

Se vuoi migliorare qualsiasi numero, devi prima capire come appare la sua linea di base. Potrebbe essere la velocità, il peso o il tempo di corsa.

Allo stesso modo, prima di eseguire qualsiasi test A/B, devi prima determinare il tasso di conversione rispetto al quale confronterai i risultati. Questo è il tuo tasso di conversione di base .

Probabilmente hai sentito parlare di maggiori entrate derivanti da una singola esperienza, ma questo può essere fuorviante. Una singola esperienza non ti dirà se la conversione del tuo sito web è migliorata.

È importante conoscere il tuo tasso di conversione di base perché se non riesci a quantificare il miglioramento di ogni esperienza, dovrai confrontare le conversioni complessive previste e realizzate su base frequente.

Con un po' di fortuna, ogni esperienza considerata una "vittoria" aiuterà le tue conversioni a superare le aspettative.

E se lo fai abbastanza spesso, le tue conversioni continueranno a migliorare!

Il test A/A è ciò che ti aiuterà a raggiungere questo obiettivo.

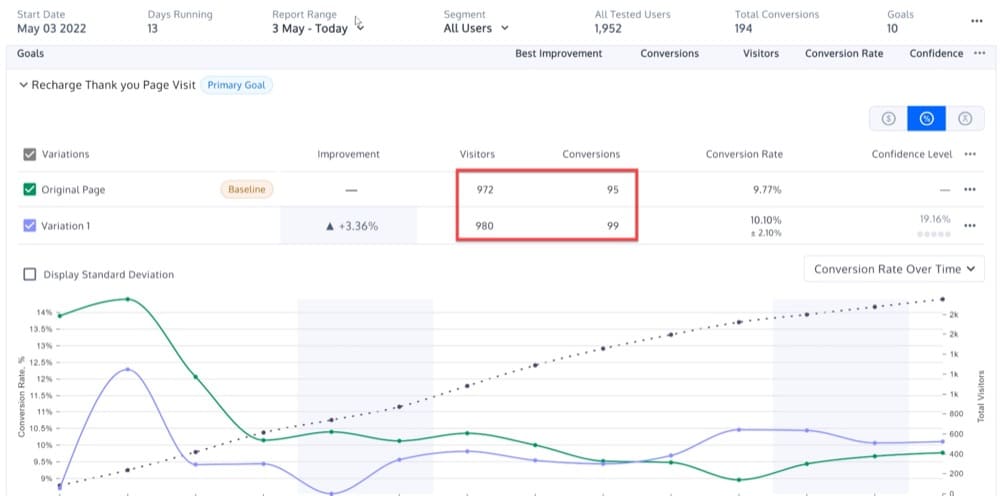

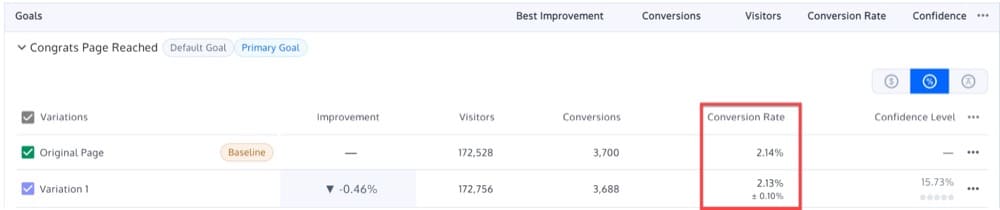

Supponiamo che tu stia eseguendo un test A/A su una delle tue pagine di destinazione, con l'originale A e la variante B che forniscono risultati quasi identici: 2,14% e 2,13%.

Di conseguenza, il tasso di conversione di base può essere impostato su 2,13-2,14%.

Con questo in mente, puoi condurre futuri test A/B, con l'obiettivo di superare questo benchmark.

Il risultato non è statisticamente significativo se esegui un test A/B su una nuova versione della pagina di destinazione e ricevi un tasso di conversione del 2,15%.

Trova la dimensione del campione necessaria

Prima di eseguire un'esperienza A/B, ricontrolla le dimensioni del campione, proprio come faresti prima di partire per un viaggio.

Non osserverai l'effetto dell'esperienza se non ci sono abbastanza campioni (utenti). D'altra parte, se hai troppi campioni, rischi di rallentare i progressi della tua squadra, esponendo continuamente le persone a una brutta esperienza.

Idealmente, non dovresti mai iniziare un'esperienza senza prima determinare quanti campioni raccoglierai.

Per capire perché, considera quanto segue:

Diciamo che hai una moneta e la tua ipotesi è che abbia una probabilità del 50/50 di ottenere testa o croce. Per dimostrarlo, lo lanci cento volte.

Ma diciamo che hai ottenuto dieci croce sui primi dieci lanci e hai deciso di fermare l'esperimento lì.

Rifiutare l'ipotesi nulla (che la moneta sia giusta) potrebbe sembrare statisticamente significativo, ma hai interrotto l'esperimento prematuramente. Non hai idea di quanto tempo avrebbe dovuto richiedere l'esperimento per cominciare.

Se non stimi la dimensione del campione, potresti anche non essere in grado di determinare per quanto tempo condurrai l'esperienza.

Quindi come ci avviciniamo a questo?

Il test A/A può aiutarti a capire quanto grande sarà la dimensione del campione di cui avrai bisogno dai visitatori del tuo sito web.

Forse, i tuoi visitatori del lunedì mattina sono statisticamente completamente diversi dai tuoi visitatori del sabato sera. E forse, i tuoi acquirenti durante le festività sono statisticamente diversi da quelli che fanno acquisti durante la stagione non festiva.

I tuoi clienti desktop potrebbero differire statisticamente dai tuoi clienti mobili. Inoltre, i tuoi clienti che arrivano tramite annunci sponsorizzati non sono gli stessi di quelli che provengono dal passaparola.

Quando visualizzi i tuoi risultati, all'interno di categorie come dispositivi e browser, rimarrai stupito dalle tendenze che scoprirai con la dimensione del campione corretta.

Naturalmente, se la dimensione del campione è troppo piccola, i risultati potrebbero non essere affidabili. Potresti perdere alcune porzioni, il che potrebbe avere un impatto sui risultati della tua esperienza.

Una dimensione del campione più elevata aumenta la probabilità di includere tutti i segmenti che influenzano il test.

Eseguendo un test A/A, sarai in grado di determinare quale dimensione del campione consente l'uguaglianza ideale tra le tue variazioni identiche.

In breve, un test A/A ti aiuta a determinare la dimensione del campione appropriata che può quindi essere utilizzata per futuri test A/B.

Confronta le prestazioni delle tue pagine e delle tue canalizzazioni

Quanti visitatori arrivano alla tua home page, alla pagina del carrello, alle pagine dei prodotti e ad altre pagine?

Non ti interessa se troverai o meno un vincitore quando lo fai. Piuttosto, stai cercando modelli più grandi per una determinata pagina.

Queste esperienze possono aiutarti a rispondere a domande come:

- Qual è il tasso di conversione macro della home page?

- Qual è la ripartizione di quel tasso di conversione per segmento di visitatori?

- Qual è la ripartizione di tale tasso di conversione per segmento di dispositivo?

Le esperienze A/A ti forniscono una linea di base rispetto alla quale puoi confrontare le nuove esperienze A/B per qualsiasi parte del tuo sito web.

Si potrebbe obiettare che puoi ricevere le stesse informazioni attraverso l'analisi del sito web.

Ma questo è sia vero che falso.

Lo strumento di test A/B viene utilizzato principalmente per dichiarare un vincitore (durante l'invio dei dati del test a Google Analytics o l'esecuzione di altri calcoli), quindi dovrai comunque osservare le metriche del sito Web quando è in esecuzione.

Impostazione di un'esperienza A/A

Le esperienze A/A sono uno strumento molto importante per l'ottimizzazione del tasso di conversione.

Tuttavia, la sfida con un'esperienza A/A è decidere quale pagina utilizzare durante l'esperienza.

Assicurati che la pagina che scegli per la tua esperienza A/A abbia queste due qualità:

- Un elevato volume di traffico. Più persone visitano una pagina, prima noterai l'allineamento tra le variazioni.

- I visitatori hanno la possibilità di acquistare o registrarsi . Avrai voglia di mettere a punto la tua soluzione di test A/B fino al traguardo.

Questi requisiti sono il motivo per cui spesso conduciamo test A/A sulla home page di un sito web.

Nella prossima sezione spiegherò più in dettaglio come creare una campagna di test A/A, ma, in poche parole, ecco come impostare un test A/A sulla home page di un sito web:

- Crea due versioni identiche della stessa pagina: un controllo e una variazione. Dopo aver finito di creare le varianti, scegli i tuoi segmenti di pubblico con dimensioni del campione identiche.

- Determina il tuo KPI. Un KPI è una metrica che misura le prestazioni nel tempo. Ad esempio, il tuo KPI potrebbe essere il numero di visitatori che fanno clic su un invito all'azione.

- Dividi il tuo pubblico in modo uniforme e casuale utilizzando il tuo strumento di test, inviando un gruppo al controllo e l'altro alla variazione. Esegui l'esperienza finché sia il controllo che la variazione non raggiungono un certo numero di visite.

- Tieni traccia dei KPI di entrambi i gruppi. Poiché entrambi i gruppi sono esposti allo stesso contenuto, dovrebbero agire in modo simile.

- Collega il tuo strumento di test A/B al tuo software di analisi. Ciò ti consentirà di ricontrollare che i tuoi dati vengano raccolti accuratamente nel tuo programma di analisi.

Come interpretare i risultati del test A/A?

Ci aspettiamo risultati inconcludenti su un'esperienza A/A

Sebbene sia improbabile che la stagionalità alteri i risultati di un test A/A, uno degli obiettivi è rilevare esiti imprevisti. Per questo motivo, consigliamo di eseguire il test per almeno una settimana prima di esaminarne l'esito.

Alla fine di una settimana, dovresti notare il seguente comportamento quando esamini i risultati del tuo test A/A:

- Nel tempo, la tua significatività statistica si stabilizzerà attorno a un determinato valore. Il 10% delle volte, la significatività statistica si attesterà al di sopra del 90%.

- Man mano che vengono raccolti più dati, gli intervalli di confidenza per l'esperimento si ridurranno, escludendo valori diversi da zero.

- L'originale e la variazione possono funzionare in modo diverso in vari punti durante i risultati del test, ma nessuno dei due dovrebbe essere ufficialmente etichettato come vincitore statisticamente significativo.

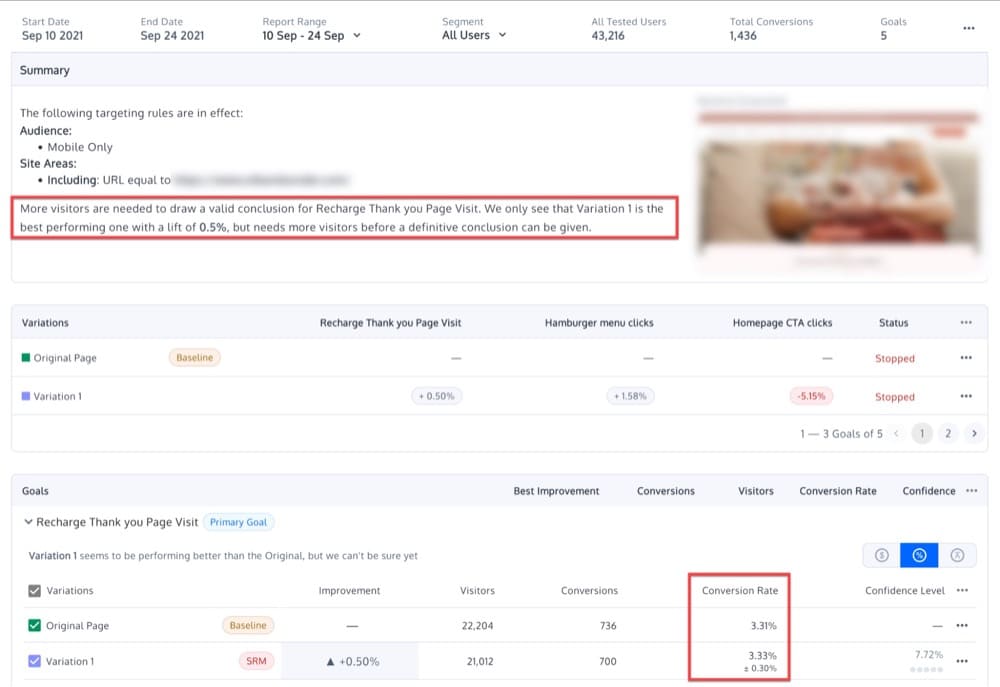

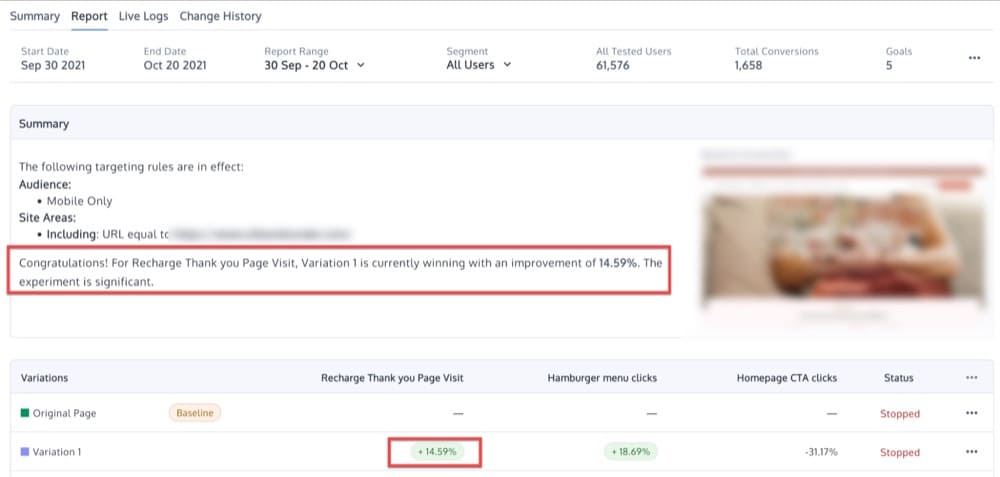

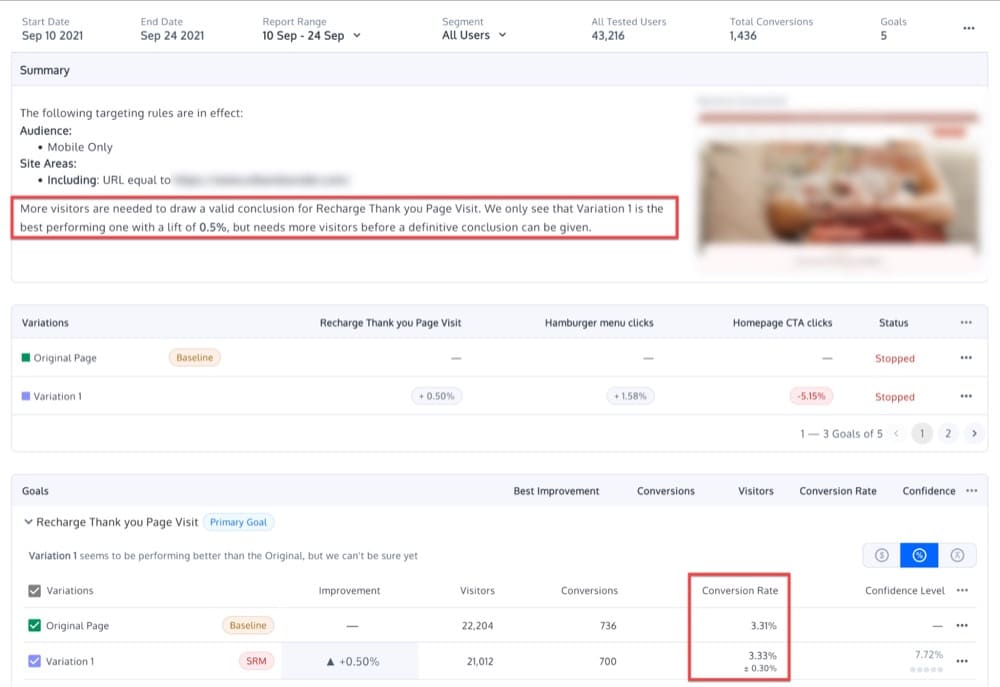

Poiché non dovrebbero esserci differenze tra le variazioni, dovresti aspettarti di vedere solo differenze modeste e nessun risultato statisticamente significativo. Forse vedrai qualcosa del genere:

Cosa significa se ottieni variazioni non identiche?

Se c'è una notevole differenza tra le due variazioni identiche in un'esperienza A/A, potrebbe significare che il tuo software di test A/B non è stato implementato correttamente o che lo strumento di test è inefficiente .

Tuttavia, è anche possibile che l' esperienza non sia stata condotta correttamente o che i risultati siano dovuti a una varianza casuale . Questo tipo di errore di campionamento si verifica naturalmente quando si misura un campione, invece di misurare tutti i visitatori.

Ad esempio, un livello di confidenza del 95% suggerisce che un risultato vincente si verificherà in un caso su 20, a causa di un errore di campionamento piuttosto che di una differenza significativa nelle prestazioni tra due variazioni.

Un altro motivo per cui un'esperienza A/A eseguita correttamente potrebbe non convalidare l'identità delle variazioni è a causa dell'eterogeneità del pubblico di destinazione .

Ad esempio, supponiamo di condurre un'esperienza A/A su un gruppo di donne, con tassi di conversione diversi per donne di età diverse.

Anche se eseguiamo un test correttamente, utilizzando uno strumento di test A/B accurato, potrebbe comunque rivelare una differenza significativa tra due variazioni identiche. Come mai? In questo esempio, il 50% dei visitatori può avere un'età compresa tra 20 e 90 anni, mentre l'altro 50% può variare da 20 a 50. Piuttosto che un errore della piattaforma, il risultato incongruente è semplicemente un segno che i due segmenti di pubblico sono molto diverso.

Infine, un altro errore comune, quando si esegue qualsiasi tipo di test, incluso un test A/A, è quello di continuare a controllare i risultati e terminare prematuramente il test una volta rilevata la significatività statistica.

Questa pratica di dichiarare una variante vincente troppo presto è chiamata "data peeking" e può portare a risultati non validi.

La sbirciatina dei dati in un test A/A può portare gli analisti a vedere un aumento in una variazione, quando le due sono, in effetti, identiche.

Per evitare ciò, dovresti decidere in anticipo la dimensione del campione che desideri utilizzare. Prendi questa decisione in base a:

- Dimensione minima dell'effetto: l'incremento minimo al di sotto del quale un effetto non è significativo per la tua organizzazione

- Potenza

- Livelli di significatività che ritieni accettabili

Lo scopo di un test A/A sarebbe quindi quello di evitare di vedere un risultato statisticamente significativo una volta raggiunta la dimensione del campione.

Quali sono le sfide dei test A/A?

A parte i numerosi vantaggi che un test A/A può apportare alla tua strategia di sperimentazione, questi sono i due principali inconvenienti dei test A/A:

- Una configurazione sperimentale A/A contiene un elemento di imprevedibilità.

- È necessaria un'elevata dimensione del campione.

Diamo un'occhiata a ciascuna di queste sfide separatamente.

Casualità

Come affermato in precedenza, uno dei motivi principali per eseguire un test A/A è valutare l'accuratezza di uno strumento di test.

Ma supponiamo che tu scopra una differenza tra il controllo e le conversioni di variazione.

Il problema con i test A/A è che c'è sempre un elemento di casualità coinvolto.

In altre circostanze, la significatività statistica è ottenuta solo per caso. Ciò significa che la differenza nei tassi di conversione tra due variazioni è probabilistica piuttosto che assoluta.

Grande dimensione del campione

Quando si confrontano variazioni simili, è necessaria un'ampia dimensione del campione per determinare se una è favorita rispetto alla sua controparte identica.

Ciò richiede una notevole quantità di tempo.

L'esecuzione di test A/A può consumare il tempo di test "reale".

Il trucco di un programma di ottimizzazione su larga scala consiste nel ridurre il rapporto tra costo delle risorse e opportunità, per garantire la velocità di test e ciò che impari, rimuovendo completamente sprechi, stupidità e inefficienza dal processo.

Eseguire esperimenti sul tuo sito è un po' come gestire una compagnia aerea indaffarata in un importante aeroporto internazionale: hai slot di decollo limitati e devi assicurarti di usarli in modo efficace.

Craig Sullivan per CXL

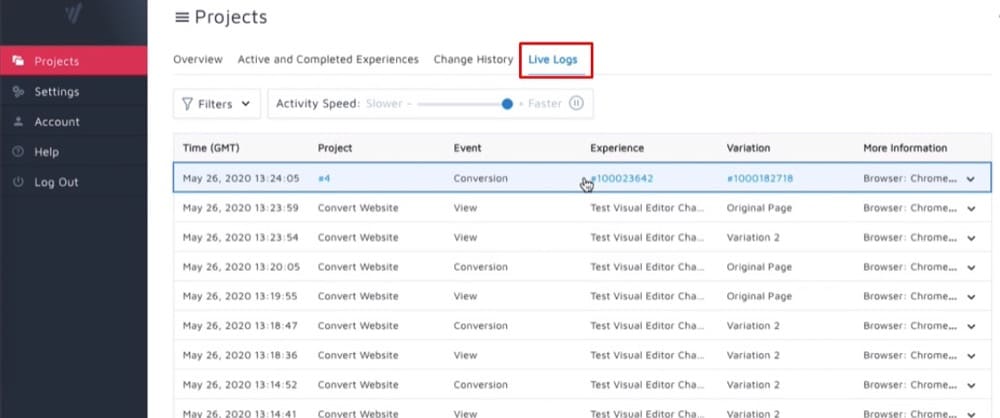

Converti esperienze e test A/A

I test A/A spesso emergono in richieste di supporto più "avanzate".

I seguenti suggerimenti degli agenti di supporto di Convert si basano su dozzine di casi risolti:

- Per testare la tua piattaforma di test A/B, conduci prima un'esperienza A/A. Se la differenza tra i due è statisticamente significativa al livello scelto, la tua piattaforma potrebbe essere rotta.

- Eseguire un test A/A/B o A/A/B/B (più su questo sotto) e scartare i risultati se le due variazioni A o due variazioni B producono differenze statisticamente significative al livello scelto.

- Imposta molti test A/A. Se più test del previsto mostrano differenze statisticamente significative, la tua piattaforma è rotta.

Come impostare i test A/A all'interno delle esperienze di conversione?

Ora diamo un'occhiata a come impostare alcuni tipi diversi di test A/A (sì, plurale) usando Converti esperienze.

La pura esperienza A/A

La configurazione A/A più tipica è una divisione 50/50 tra due pagine identiche.

L'obiettivo è convalidare la configurazione dell'esperienza assicurando che ogni variazione abbia all'incirca le stesse prestazioni.

Stai controllando la stessa cosa contro se stessa per scoprire se i dati contengono rumore piuttosto che informazioni utili.

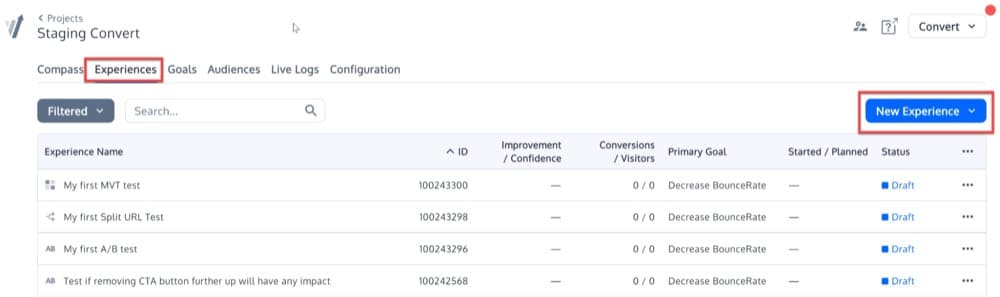

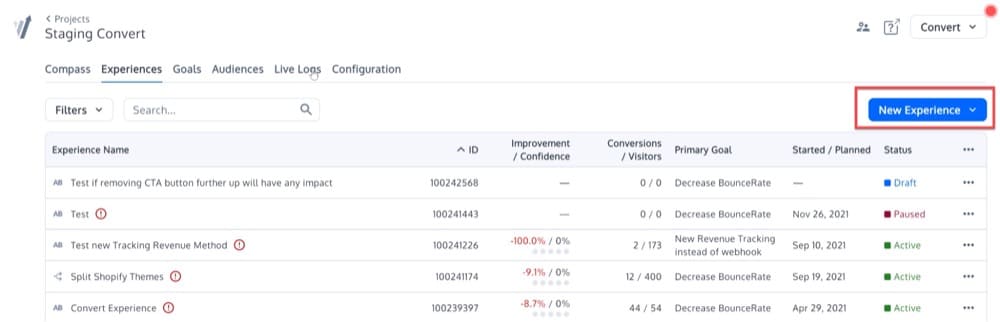

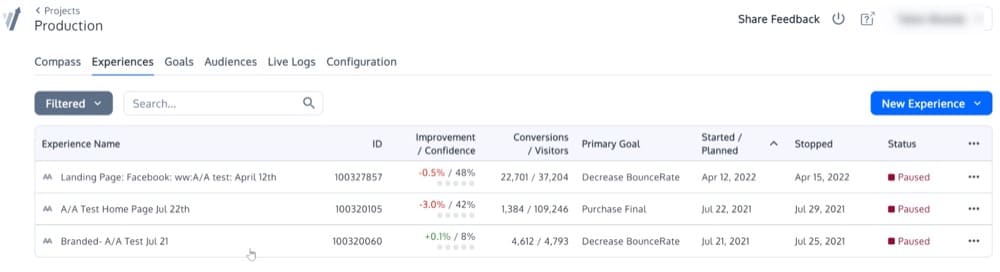

Per impostare questa semplice esperienza A/A, fai clic sul menu Esperienze. Quindi, fai clic sul pulsante "Nuova esperienza" in alto a destra.

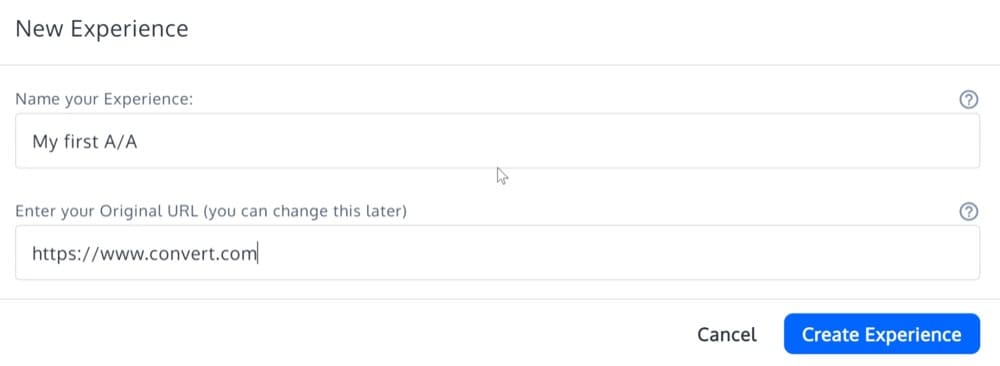

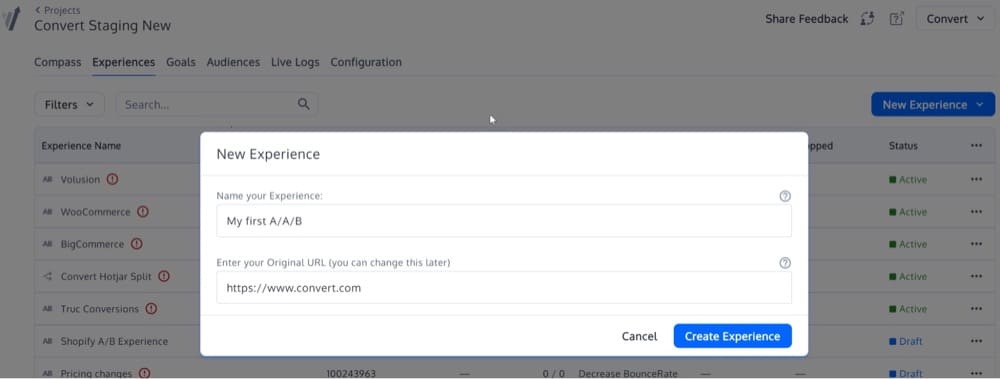

Compila i dettagli della "Procedura guidata per la creazione dell'esperienza" e seleziona il tipo di esperienza "Esperienza A/A".

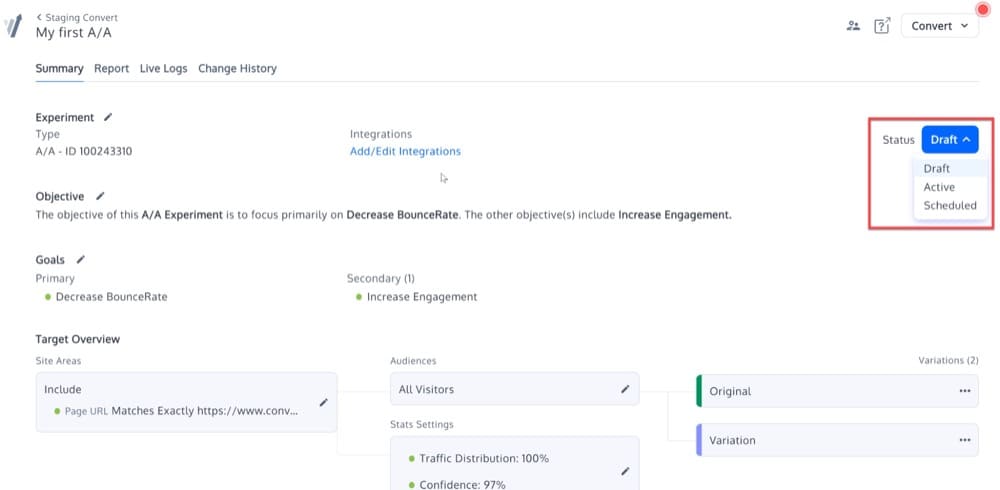

Ora, la tua esperienza A/A dovrebbe essere creata. Sarà identico ad altri tipi di esperimenti nella piattaforma, oltre a non avere opzioni per "Modificare variazioni".

Attiva l'esperienza modificandone lo stato:

L'esperienza calibrata A/A/B o A/A/B/B

L'idea alla base di questo test calibrato A/A/B o A/A/B/B è che le variazioni A o B replicate forniscono una misura dell'accuratezza del test A/B.

Se la differenza tra A e A o B e B è statisticamente significativa, il test è considerato non valido ei risultati vengono scartati.

Per impostare un tale test, dovrai iniziare un'esperienza A/B, piuttosto che un A/A.

Fai clic sul pulsante "Nuova esperienza" sulla destra dello schermo per iniziare a creare una nuova esperienza.

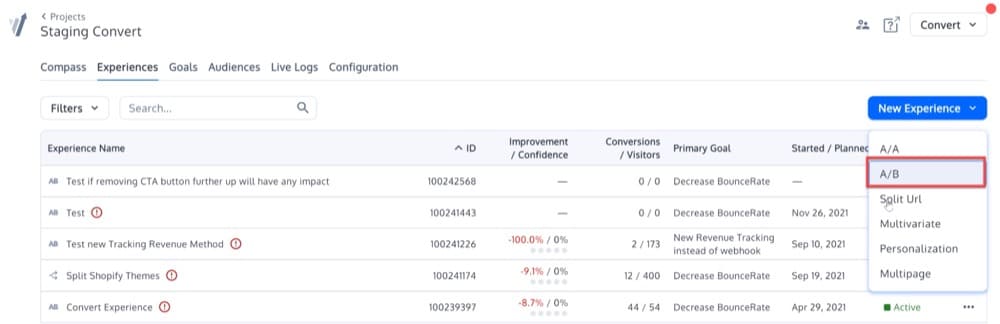

Dopo aver fatto clic su quel pulsante, vedrai questo menu a comparsa. Seleziona l'opzione A/B:

Quindi, inserisci il tuo URL nella seconda casella.

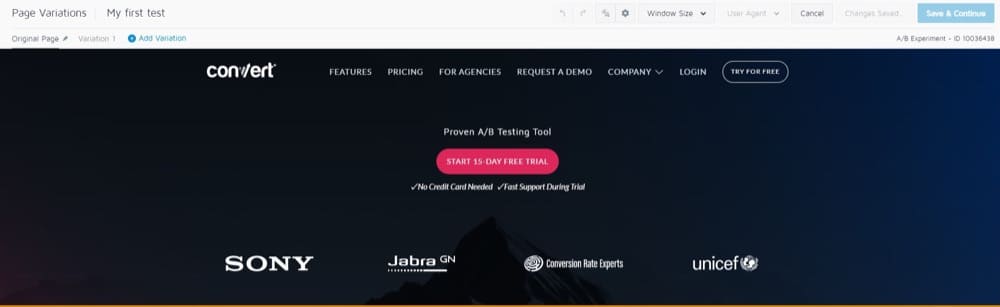

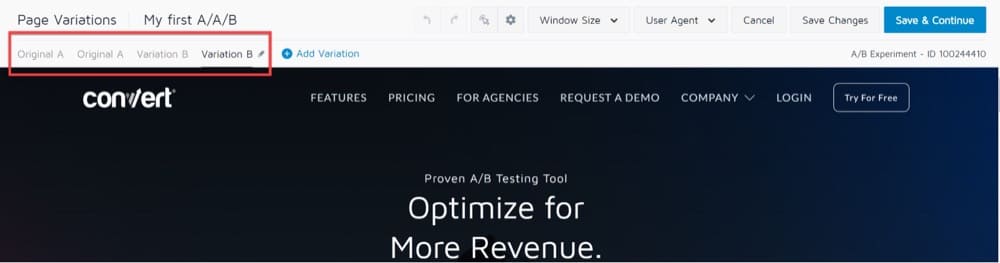

Verrai indirizzato al Visual Editor che mostra l'URL che hai scelto e una barra degli strumenti in alto:

Nella sezione Variazioni di pagina in alto a sinistra, noterai che "Variazione 1" è selezionata per impostazione predefinita.

Ciò significa che qualsiasi modifica apportata a questa versione dell'URL non influirà sull'URL originale.

Ciò risulterà in un classico test A/B, in cui la versione "A" è la pagina originale e la versione "B" è la Variazione 1.

Per A/A/B o A/A/B/B, dovrai aggiungere un'altra variazione A e un'altra variazione B identiche rispettivamente alla variazione A e alla variazione B.

Dovrebbe sembrare come questo:

Fai clic sul pulsante "Salva e continua" e il gioco è fatto!

Esegui molte esperienze A/A

Ne abbiamo già parlato, ma se conduci 1000 test A/A successivi con un pubblico ampio, segui tutti i requisiti e ottieni risultati statisticamente significativi molto più frequentemente del previsto, è possibile che il tuo framework di test A/B sia rotto.

Potrebbe essere che i campioni non siano correttamente randomizzati. O forse, le due varianti non si escludono a vicenda.

Ecco come potrebbe essere:

Posso eseguire un'esperienza A/A contemporaneamente a un'esperienza A/B?

C'è la possibilità che tu debba eseguire un test A/A contemporaneamente a un test A/B, sullo stesso sito web.

In tal caso, ecco alcune possibilità:

- Non dovrai preoccuparti che i test siano in conflitto tra loro se li esegui contemporaneamente.

- Potresti condurre gli esperimenti contemporaneamente, ma con un pubblico distinto.

- È possibile eseguire i test nell'ordine corretto (completare il test 1 (test A/A) prima di passare al test 2 (test A/B)).

L'opzione 3 è la più sicura, ma limita drasticamente le capacità della tua esperienza.

È del tutto possibile eseguire più esperienze sulla stessa pagina o insieme di pagine contemporaneamente.

Tuttavia, tieni presente che il bucket in un esperimento può avere un impatto sui dati di un altro esperimento che si verifica contemporaneamente.

Ecco le due tecniche di conversione più importanti da utilizzare durante l'esecuzione di test paralleli:

- Assegna il 50% del traffico al test A/A, consentendo al restante 50% del traffico di accedere alle altre esperienze A/B in esecuzione.

- Escludere i visitatori A/A dagli altri test A/B.

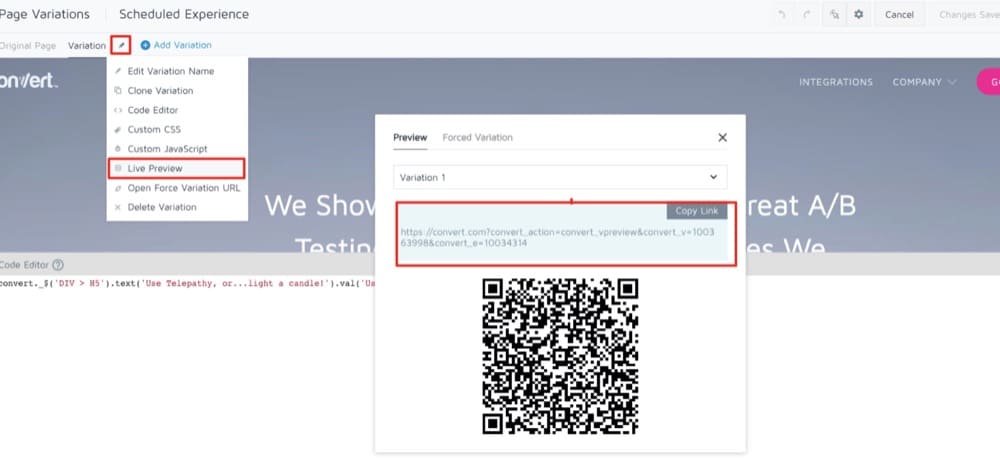

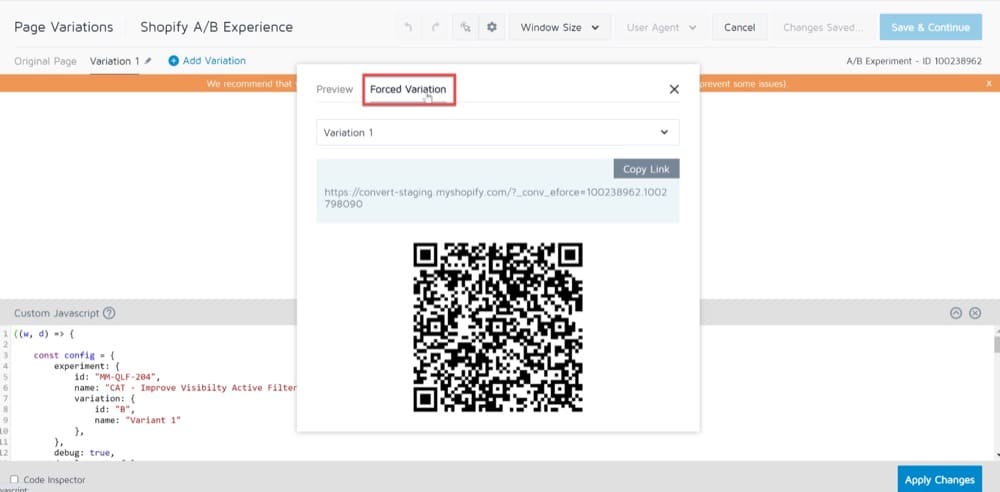

Processo di controllo qualità pre-test: un'interessante alternativa ai test A/A

Al momento di decidere se eseguire o meno un test A/A, le risposte varieranno a seconda di chi chiedi. Non c'è dubbio che il test A/A sia una questione controversa.

Uno degli argomenti più comuni contro il test A/A è che ci vuole troppo tempo.

Il test A/A richiede una notevole quantità di tempo e spesso richiede una dimensione del campione considerevolmente maggiore rispetto al test A/B.

Quando si confrontano due versioni identiche di un sito Web, è necessaria una dimensione del campione elevata per dimostrare una distorsione significativa.

Di conseguenza, il completamento del test richiederà più tempo, riducendo potenzialmente il tempo dedicato ad altri test importanti.

In questi casi in cui non hai molto tempo o traffico elevato, è meglio considerare di condurre un processo di QA pre-test.

In questo articolo del blog, ti guideremo attraverso tutti i passaggi che dovrai seguire per eseguire un processo di QA completo. I metodi che usi dipendono da te e dipendono da quanto tempo hai a disposizione.

Può esistere SRM nei test A/A?

Chiediti questo: il numero effettivo di utenti osservati durante il test A/A è vicino al rapporto 50/50 (o rapporto 90/10 o qualsiasi altro rapporto) se li dividi a metà?

In caso contrario, ti trovi di fronte a uno di questi due problemi: o c'è un problema con il modo in cui stai invocando l'infrastruttura di test dall'interno del tuo codice (rendendolo "perdente" da un lato) o c'è un problema con l'infrastruttura di test meccanismo di assegnazione.

Un errore di mancata corrispondenza del rapporto di campionamento (errore SRM) è un difetto che un test A/A può rilevare.

Se il tuo rapporto risulta essere qualcosa come 65/35, dovresti esaminare il problema prima di eseguire un altro test A/B utilizzando la stessa strategia di targeting.

I vantaggi dei test A/A superano gli svantaggi?

Sebbene il test A/A non debba essere eseguito su base mensile, vale la pena testare i dati quando si imposta un nuovo strumento A/B.

Se ora catturi i dati errati, avrai più fiducia nei risultati del tuo test A/B più avanti lungo la strada.

Sebbene la decisione sia in definitiva tua, è altamente consigliabile condurre test A/A se stai iniziando con un nuovo strumento. In caso contrario, ti consigliamo di impostare una rigorosa procedura di QA pre-test, poiché i test A/B ti faranno risparmiare tempo, denaro e traffico.

Ci auguriamo che gli screenshot qui sopra abbiano risposto alle tue domande, ma in caso contrario, iscriviti a una demo per vedere di persona quanto sia facile impostare un test A/A con Convert Experiences.