Tutti i diversi tipi di test che puoi eseguire sul tuo sito (+ quando eseguirli)

Pubblicato: 2022-09-20

Il mondo della sperimentazione è andato per lo più oltre i semplici test A/B del colore dei pulsanti.

Potrebbero avere il loro posto nel portafoglio di esperimenti che stai eseguendo, ma si spera che, a questo punto, non siano sinonimo di sperimentazione o CRO.

La sperimentazione può essere molto più grande.

Utilizzando diversi tipi di esperimenti, possiamo conoscere la varianza sui nostri siti Web, testare nuove esperienze, scoprire nuovi percorsi di pagina, fare grandi salti o piccoli passi e identificare la combinazione ottimale di elementi in una pagina.

Quello che speri di imparare da un esperimento dovrebbe riflettersi nella sua progettazione, e la progettazione degli esperimenti va ben oltre il semplice testare A contro B usando un'ipotesi concreta.

In effetti, c'è un intero sottocampo di studio noto come Design of Experiments (DoE) che copre questo.

- Progettazione di esperimenti: un'introduzione alla progettazione sperimentale

- 16 Tipi comuni di esperimenti

- 1. Prova A/A

- 2. Test A/B semplice

- 3. Prova A/B/n

- 4. Test multivariato

- 5. Test di targeting

- 6. Prova del bandito

- 7. Algoritmi evolutivi

- 8. Test del percorso della pagina divisa

- 9. Prova di esistenza

- 10. Prova della porta dipinta

- 11. Test di scoperta

- 12. Test iterativo

- 13. Test innovativo

- 14. Test di non inferiorità

- 15. Bandiera caratteristica

- 16. Quasi esperimenti

- Conclusione

Progettazione di esperimenti: un'introduzione alla progettazione sperimentale

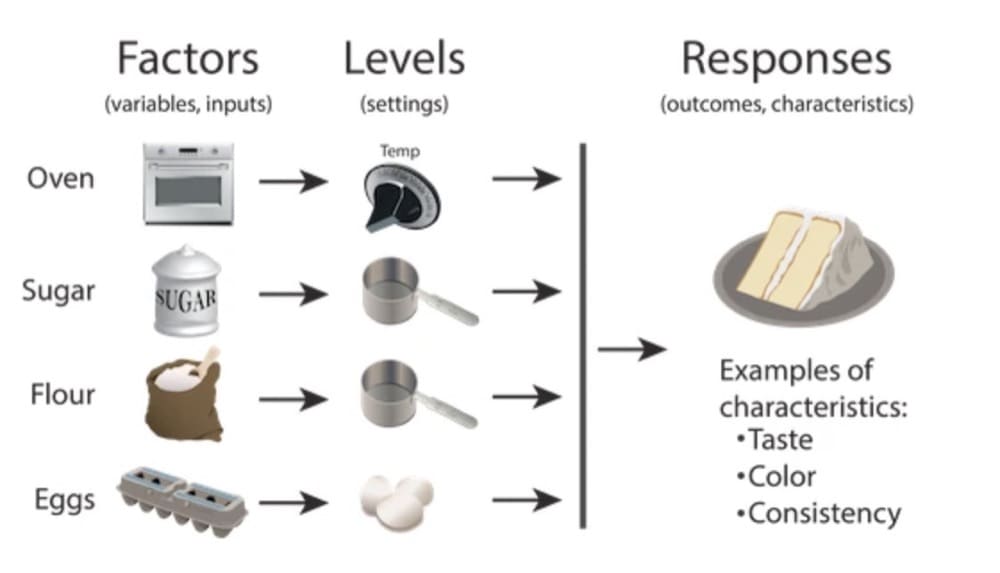

Design of Experiments (DoE) è un metodo scientifico utilizzato per determinare la relazione tra i fattori che influenzano un processo e l'output di quel processo.

Design of Experiments è un concetto reso popolare dallo statistico Ron Fisher negli anni '20 e '30.

DoE ci consente di capire in che modo le diverse variabili di input influiscono sull'output di un processo modificando sistematicamente gli input e osservando i cambiamenti risultanti nell'output. Questo approccio può essere utilizzato per ottimizzare un processo, sviluppare nuovi prodotti o funzionalità o apprendere quali elementi funzionano meglio insieme tra loro.

Nel marketing, utilizziamo DoE per migliorare la nostra comprensione di come i diversi elementi di una pagina (i fattori) influiscono sui tassi di conversione (l'output). Progettando esperimenti in modo efficace, possiamo identificare quali elementi hanno il maggiore impatto sui tassi di conversione.

Esistono molti tipi diversi di esperimenti e ogni tipo può essere utilizzato per apprendere cose diverse sul tuo sito Web o sulla tua app.

In questo articolo tratterò 16 tipi di esperimenti.

Nitpicker potrebbe notare che questi non sono tutti progetti sperimentali fondamentalmente diversi; piuttosto, alcuni sono "tipi" diversi a causa di come generi la tua ipotesi o quali strutture sono alla base delle tue ragioni per eseguire l'esperimento.

Alcuni, inoltre, non sono proprio "esperimenti", ma sono piuttosto regole di ottimizzazione basate su modelli di machine learning.

Tuttavia, ciascuno dei seguenti ha uno scopo distinto e può essere considerato uno strumento unico nel kit di strumenti di uno sperimentatore.

16 Tipi comuni di esperimenti

Esistono molti tipi diversi di esperimenti controllati che puoi eseguire sul tuo sito Web, ma qui ci sono 16 dei più comuni:

1. Prova A/A

2. Semplice test A/B

3. Prova A/B/n

4. Test multivariato

5. Test di targeting

6. Prova del bandito

7. Algoritmi evolutivi

8. Prova del percorso della pagina divisa

9. Prova di esistenza

10. Prova della porta verniciata

11. Test di scoperta

12. Test incrementale

13. Test innovativo

14. Prova di non inferiorità

15. Bandiera caratteristica

16. Quasi esperimenti

1. Prova A/A

Un test A/A è un concetto semplice: stai testando due versioni di una pagina identiche.

Perché dovresti farlo?

Ci sono una serie di ragioni, principalmente nel perseguimento della calibrazione e nella comprensione dei dati sottostanti, del comportamento dell'utente e dei meccanismi di randomizzazione del tuo strumento di test. Il test A/A può aiutarti a:

- Determina il livello di varianza nei tuoi dati

- Identifica gli errori di campionamento all'interno del tuo strumento di test

- Stabilire tassi di conversione di base e modelli di dati.

L'esecuzione di test A/A è stranamente controversa. Alcuni lo giurano. Alcuni dicono che è una perdita di tempo.

La mia opinione? Probabilmente vale la pena eseguirne uno almeno una volta, per tutti i motivi sopra menzionati. Un altro motivo per cui AMO eseguire test A/A è spiegare le statistiche ai principianti.

Quando mostri a qualcuno un esperimento "significativo" con due giorni di dati raccolti, solo per poi rivelare che si trattava di un test A/A, le parti interessate di solito capiscono perché dovresti eseguire un esperimento fino al completamento.

Se vuoi saperne di più sui test A/A (è un argomento enorme, in realtà), Convert ha una guida approfondita su di essi.

Casi d'uso: calibrazione e determinazione della varianza dei dati, verifica dei bug della piattaforma di sperimentazione, determinazione del tasso di conversione di base e dei requisiti del campione.

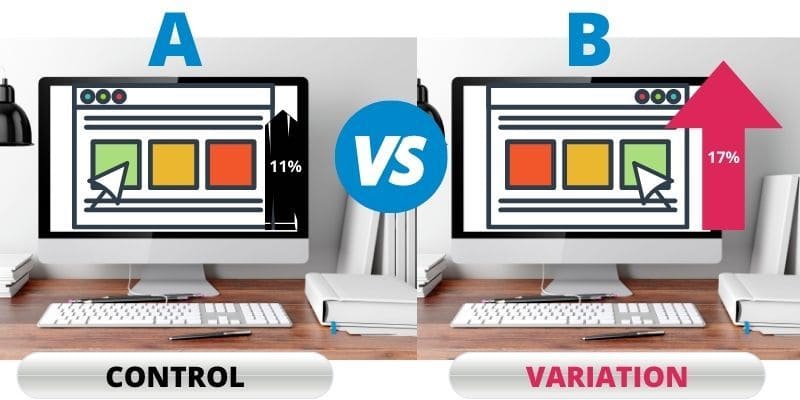

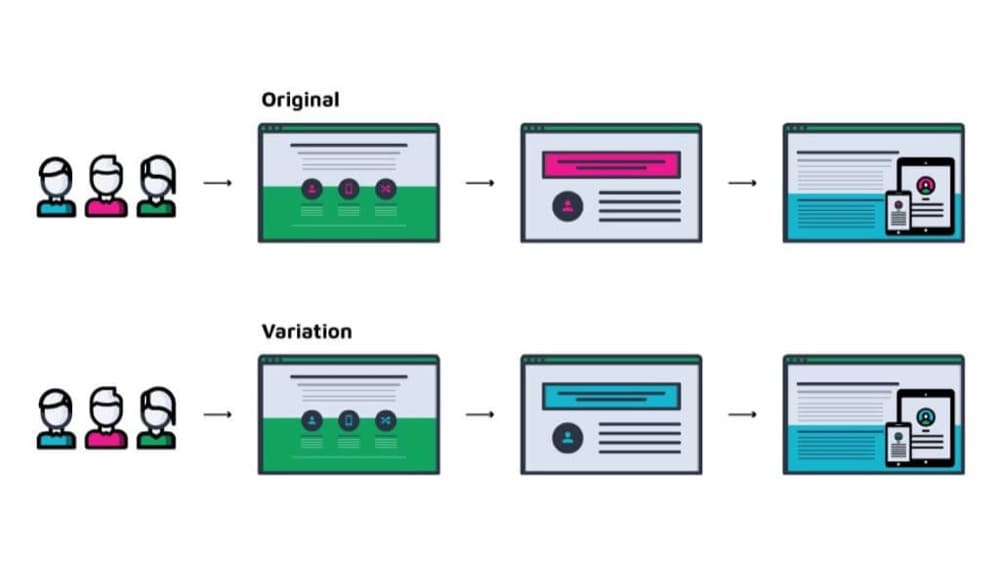

2. Test A/B semplice

Tutti sanno cos'è un semplice test A/B: stai testando due versioni di una pagina, una con una modifica e una senza.

I test A/B sono il pane quotidiano della sperimentazione. Sono semplici da configurare e da capire, ma possono anche essere usati per testare grandi cambiamenti.

I test A/B sono più comunemente usati per testare le modifiche su un'interfaccia utente e l'obiettivo di un semplice test A/B è quasi sempre quello di migliorare il tasso di conversione su una determinata pagina.

Il tasso di conversione, a proposito, è una metrica generica che copre tutti i tipi di proporzioni, come il tasso di attivazione degli utenti di nuovi prodotti, i tassi di monetizzazione degli utenti freemium, i tassi di conversione dei lead sul sito Web e le percentuali di clic.

Con un semplice test A/B, hai un'ipotesi singolare e modifichi un elemento alla volta per imparare il più possibile sugli elementi causali del tuo cambiamento. Potrebbe trattarsi di una modifica del titolo, del colore o della dimensione del pulsante, aggiunta o rimozione di un video o qualsiasi altra cosa.

Quando diciamo "test A/B", utilizziamo principalmente un termine generico per comprendere la maggior parte del resto dei tipi di esperimento che elencherò in questo post. Di solito è usato come termine generico per significare "abbiamo cambiato *qualcosa* - grande, piccolo o molti elementi - per migliorare una metrica".

Casi d'uso: molti! Solitamente per testare un cambiamento singolare in un'esperienza digitale informata da un'ipotesi concreta. I test A/B vengono in genere eseguiti con l'intento di migliorare una metrica, ma anche per conoscere qualsiasi cambiamento che si verifica nel comportamento dell'utente con l'intervento.

3. Prova A/B/n

I test A/B/n sono molto simili ai test A/B, ma invece di testare due versioni di una pagina, stai testando più versioni.

I test A/B/n sono simili, in qualche modo, ai test multivariati (che esplorerò in seguito). Piuttosto che un test "multivariato", tuttavia, li considererei un test multivariante.

I test multivariati sono utili per comprendere le relazioni tra i diversi elementi di una pagina. Ad esempio, se desideri testare diversi titoli, immagini e descrizioni sulla pagina di un prodotto e desideri anche vedere quali combinazioni sembrano interagire meglio, dovresti utilizzare un test multivariato.

I test A/B/n sono utili per testare più versioni di un singolo elemento e non si preoccupano tanto degli effetti di interazione tra gli elementi.

Ad esempio, se desideri testare tre diversi titoli su una pagina di destinazione, utilizzerai un test A/B/n. Oppure, potresti semplicemente testare sette versioni completamente diverse della pagina. È solo un test A/B con più di due esperienze testate.

I test A/B/n sono scelte solide quando hai molto traffico e vuoi testare diverse varianti in modo efficiente. Naturalmente, le statistiche devono essere corrette per più varianti. C'è anche molto dibattito su quante varianti si dovrebbero includere in un test A/B/n.

Spesso, puoi spingere alcune varianti più originali e creative durante il test di più esperienze contemporaneamente anziché in modo iterativo su più semplici test A/B.

Caso d'uso: quando hai il traffico disponibile, più varianti sono ottime per testare un vasto assortimento di esperienze o più iterazioni di un elemento.

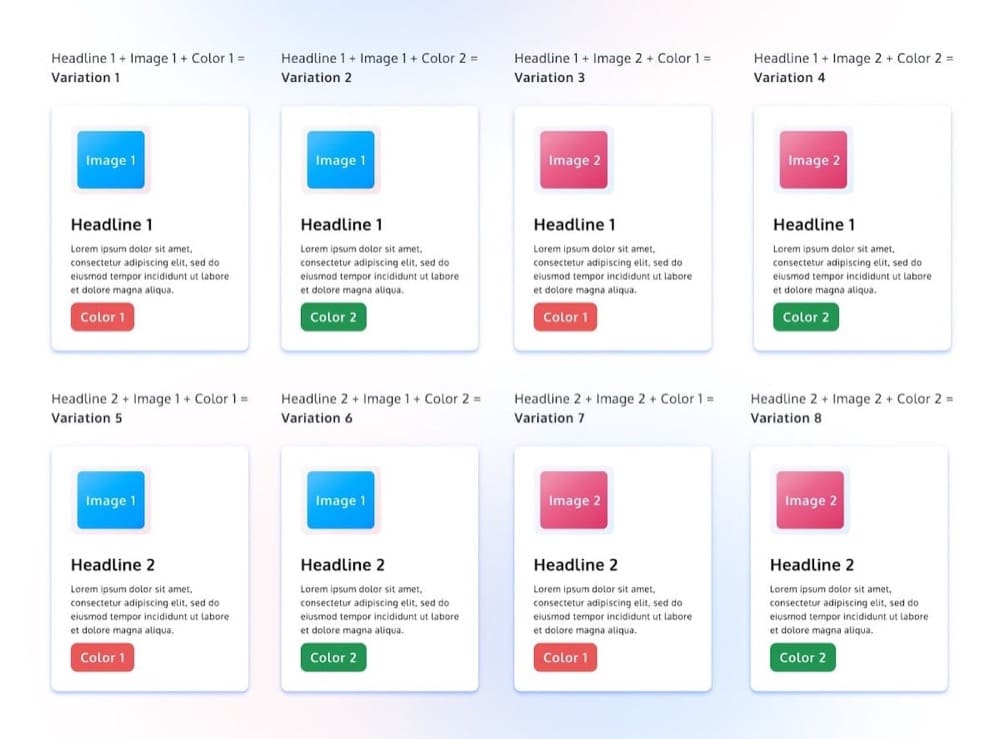

4. Test multivariato

Un test multivariato è un esperimento con più modifiche. Laddove un test A/B/n sta testando le versioni composite di ciascuna variante rispetto a un'altra variante, un test multivariato mira anche a determinare gli effetti di interazione tra gli elementi testati.

Immagina, ad esempio, di riprogettare una home page. Hai fatto ricerche di conversione e hai scoperto problemi di chiarezza con il tuo titolo, ma hai anche alcune ipotesi sul livello di contrasto e chiarezza nel tuo CTA.

Non solo sei interessato a migliorare ciascuno di questi due elementi in isolamento, ma è probabile che anche le prestazioni di questi elementi siano dipendenti. Pertanto, vuoi vedere quale combinazione di nuovi titoli e CTA funziona meglio.

La progettazione dell'esperimento diventa molto più complicata quando si entra in un territorio multivariato. Esistono diversi tipi di configurazioni di esperimenti multivariati, tra cui la progettazione fattoriale completa, la progettazione fattoriale parziale o frazionaria e il test di Taguchi.

E proprio per una questione di buon senso statistico, i test multivariati richiedono quasi sicuramente più traffico rispetto ai semplici test A/B. Ogni elemento aggiuntivo o esperienza che modifichi aumenta la quantità di traffico necessaria per un risultato valido.

Casi d'uso: gli esperimenti multivariati sembrano particolarmente utili per ottimizzare un'esperienza modificando diverse piccole variabili. Ogni volta che si desidera determinare la combinazione ottimale di elementi, è necessario considerare i test multivariati.

5. Test di targeting

I test di targeting, meglio conosciuti come personalizzazione, mirano a mostrare il messaggio giusto alla persona giusta al momento giusto.

Con un test di targeting, puoi creare versioni diverse di una pagina e mostrare ciascuna versione a un diverso gruppo di persone. L'obiettivo è di solito aumentare i tassi di conversione mostrando contenuti pertinenti a ciascun utente.

Tieni presente che personalizzazione e sperimentazione non sono sinonimi. Puoi personalizzare un'esperienza senza trattarla come un esperimento. Ad esempio, puoi decidere con zero dati o intenzione di raccogliere dati, che utilizzerai un token di nome nelle tue e-mail per personalizzare i messaggi con il nome del destinatario.

Personalizzazione? Sì. Sperimentazione? No.

Ma puoi anche eseguire esperimenti mirati a segmenti di utenti specifici. Ciò è particolarmente comune nella sperimentazione del prodotto, in cui è possibile isolare le coorti in base al livello dei prezzi, al tempo di registrazione, all'origine della registrazione e così via.

Le stesse statistiche si applicano agli esperimenti di personalizzazione, quindi è importante scegliere segmenti significativi da scegliere come target. Se diventi troppo dettagliato, ad esempio prendendo di mira gli utenti Chrome mobili del Kansas che hanno tra le 5 e le 6 sessioni, non solo sarà impossibile quantificare statisticamente l'impatto, ma è improbabile che abbia anche un impatto significativo sul business.

La personalizzazione è generalmente considerata come un'estensione naturale del semplice test A/B, ma in molti modi introduce una tonnellata di nuova complessità. Per ogni nuova regola di personalizzazione che utilizzi, è un nuovo "universo" che hai creato per consentire ai tuoi utenti di gestire, aggiornare e ottimizzare.

Gli strumenti di personalizzazione predittiva ti aiutano a identificare i segmenti target e le esperienze che sembrano funzionare meglio con loro. In caso contrario, le regole di personalizzazione vengono spesso identificate eseguendo la segmentazione post-test.

Casi d'uso: isola i trattamenti in segmenti specifici della tua base di utenti.

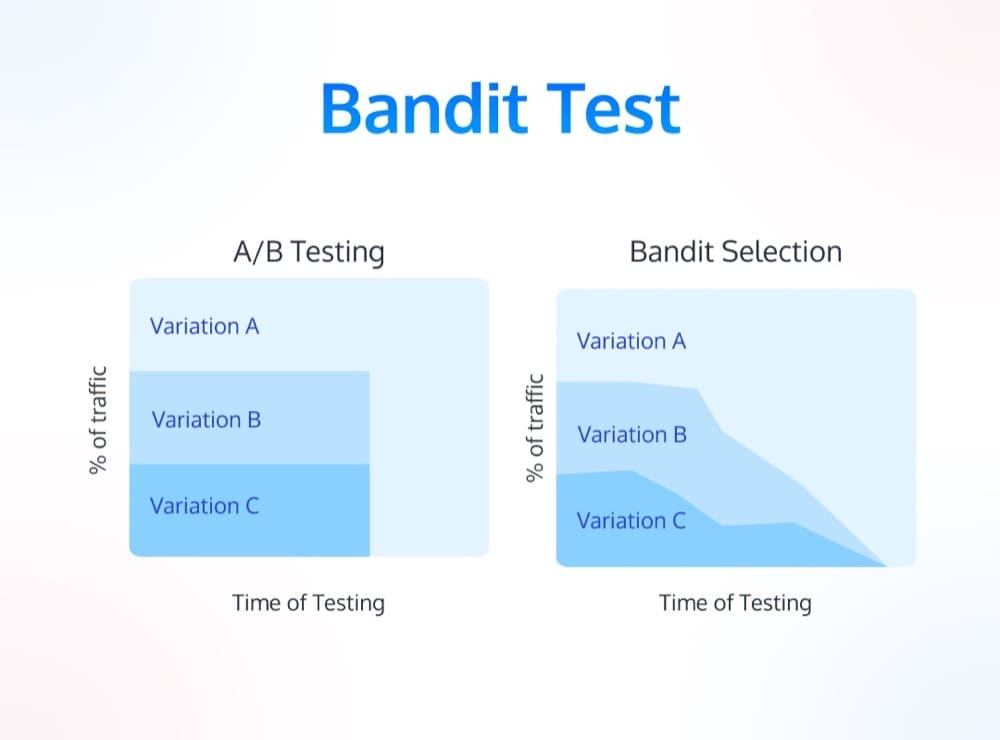

6. Prova del bandito

Un test del bandito, o l'utilizzo di algoritmi del bandito, è un po' tecnico. Ma sostanzialmente differiscono dai test A/B perché imparano e cambiano costantemente quale variante viene mostrata agli utenti.

I test A/B sono in genere esperimenti con "orizzonte fisso" (con l'avvertenza tecnica di utilizzare test sequenziali), il che significa che predetermini un periodo di prova durante l'esecuzione del test. Al termine, decidi di implementare la nuova variante o di ripristinare l'originale.

I test dei banditi sono dinamici. Aggiornano costantemente l'allocazione del traffico a ciascuna variante in base alle sue prestazioni.

La teoria è così: entri in un casinò e ti imbatti in diverse slot machine (banditi multi-armati). Supponendo che ogni macchina abbia ricompense diverse, il problema del bandito aiuta a "decidere quali macchine giocare, quante volte giocare ciascuna macchina e in quale ordine giocarle, e se continuare con la macchina attuale o provare una macchina diversa".

Il processo decisionale qui è suddiviso in "esplorazione", in cui si tenta di raccogliere dati e informazioni, e "sfruttamento", che sfrutta tale conoscenza per produrre ricompense superiori alla media.

Quindi un test bandito su un sito web cercherebbe di trovare, in tempo reale, la variante ottimale e inviare più traffico a quella variante.

Casi d'uso: esperimenti brevi con elevata "deperibilità" (il che significa che l'apprendimento dai risultati non si estenderà molto lontano nel futuro) e ottimizzazione dinamica a lungo termine "impostalo e dimenticalo".

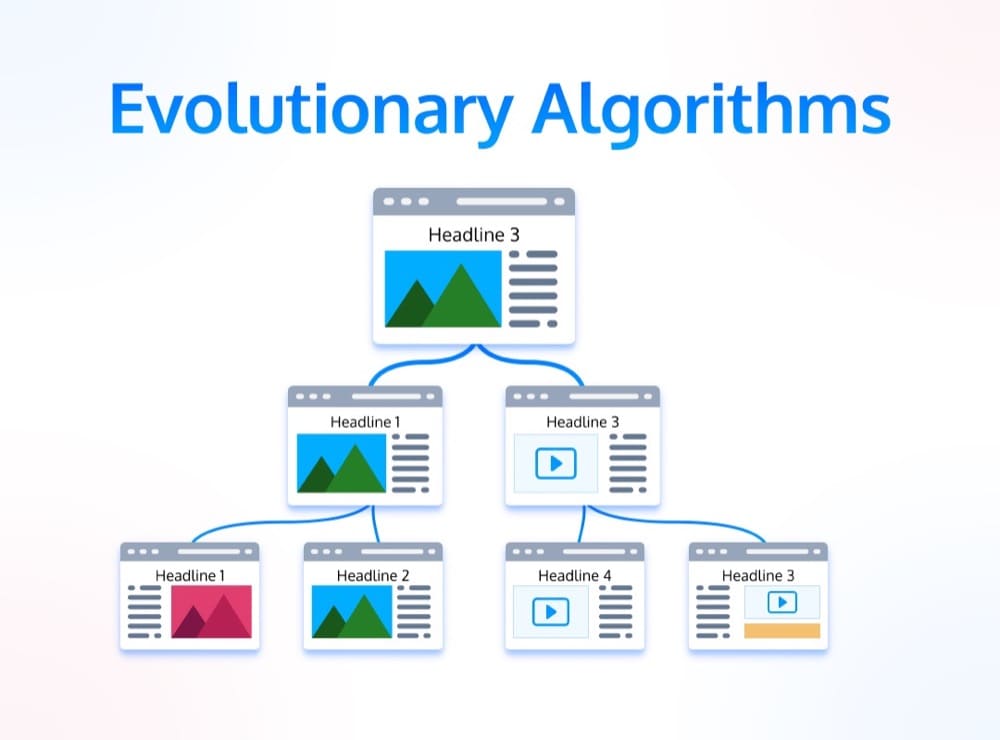

7. Algoritmi evolutivi

Gli algoritmi evolutivi sono una sorta di combinazione tra test multivariati e test bandit. Nel contesto degli esperimenti di marketing, gli algoritmi evolutivi consentono di testare un gran numero di varianti contemporaneamente.

L'obiettivo di un algoritmo evolutivo è trovare la combinazione ottimale di elementi in una pagina. Funzionano creando una "popolazione" di varianti e quindi testandole tutte l'una contro l'altra. La variante con le migliori prestazioni viene quindi utilizzata come punto di partenza per la generazione successiva.

Come suggerisce il nome, utilizza le iterazioni evolutive come modello per l'ottimizzazione. Hai un sacco di versioni diverse di titoli, pulsanti, body copy e video e le unisci insieme per creare nuove mutazioni e provare dinamicamente a eliminare le varianti deboli e inviare più traffico a varianti forti.

È come un test multivariato sugli steroidi, anche se con una minore trasparenza negli effetti di interazione (quindi, un potenziale di apprendimento inferiore).

Questi esperimenti richiedono anche un bel po' di traffico sul sito web per funzionare bene.

Casi d'uso: massicci test multivariati, unire diverse versioni di creatività e trovare il vincitore emergente tra tutte le combinazioni.

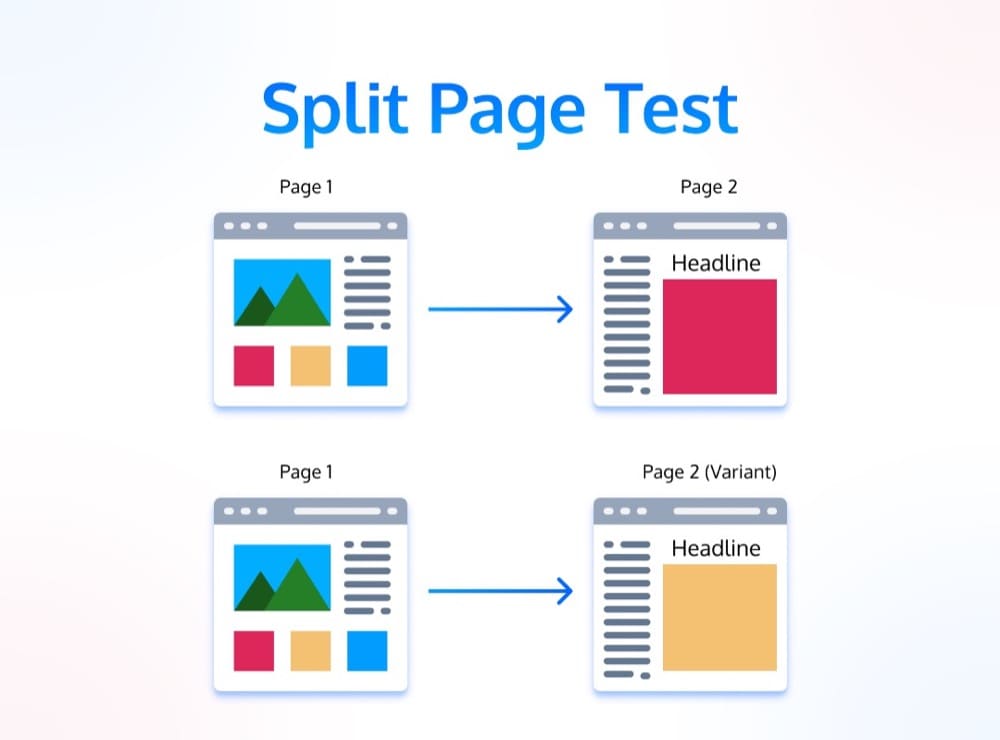

8. Test del percorso della pagina divisa

Un test del percorso di pagina divisa è anche un tipo molto comune di test A/B.

Invece di modificare un elemento in una singola pagina, stai cambiando l'intero percorso che un utente compie attraverso il tuo sito web.

Con un test del percorso di pagina divisa, stai essenzialmente testando due diverse versioni del tuo sito Web, prodotto o canalizzazione. L'obiettivo è di solito trovare la versione che si traduce in più conversioni o vendite. Può anche aiutare a identificare i punti di abbandono nella canalizzazione, che possono diagnosticare le aree di interesse per un'ulteriore ottimizzazione.

Fondamentalmente, invece di modificare la copia su un pulsante, cambi la pagina successiva a cui ti invia il pulsante se fai clic su di esso. È un modo efficace per sperimentare il percorso del cliente.

Casi d'uso: identificare e migliorare i percorsi delle pagine e le canalizzazioni degli utenti in un prodotto o su un sito web.

9. Prova di esistenza

Il test di esistenza è un concetto interessante. Quello che stai cercando di fare è quantificare l'impatto (o la sua mancanza) di un determinato elemento nel tuo prodotto o sito web.

Secondo un articolo di CXL, "In poche parole, rimuoviamo elementi del tuo sito e vediamo cosa succede al tuo tasso di conversione".

In altre parole, stai testando per vedere se una modifica ha alcun effetto.

Strategicamente, questa è una strategia così sottovalutata. Spesso assumiamo, sia attraverso la nostra stessa euristica sia attraverso la ricerca qualitativa, quali elementi siano i più importanti in una pagina.

Sicuramente il video dimostrativo del prodotto è importante. Il test di esistenza è un modo per mettere in discussione questa convinzione e ottenere rapidamente una risposta.

Basta rimuovere il video e vedere cosa succede.

Aumento o diminuzione del tasso di conversione? Interessante: ciò significa che l'elemento o l'immobile che occupava ha un impatto in qualche modo.

Nessun impatto? Anche questo è interessante. In tal caso, punterei l'attenzione del mio team su altre parti dell'esperienza digitale, sapendo che anche rimuovere completamente l'elemento non ha alcun effetto sui nostri KPI.

Casi d'uso: "Mappatura del segnale di conversione". In sostanza, questo può dirti l'elasticità degli elementi sul tuo sito Web, AKA sono anche abbastanza importanti per concentrare i tuoi sforzi di ottimizzazione?

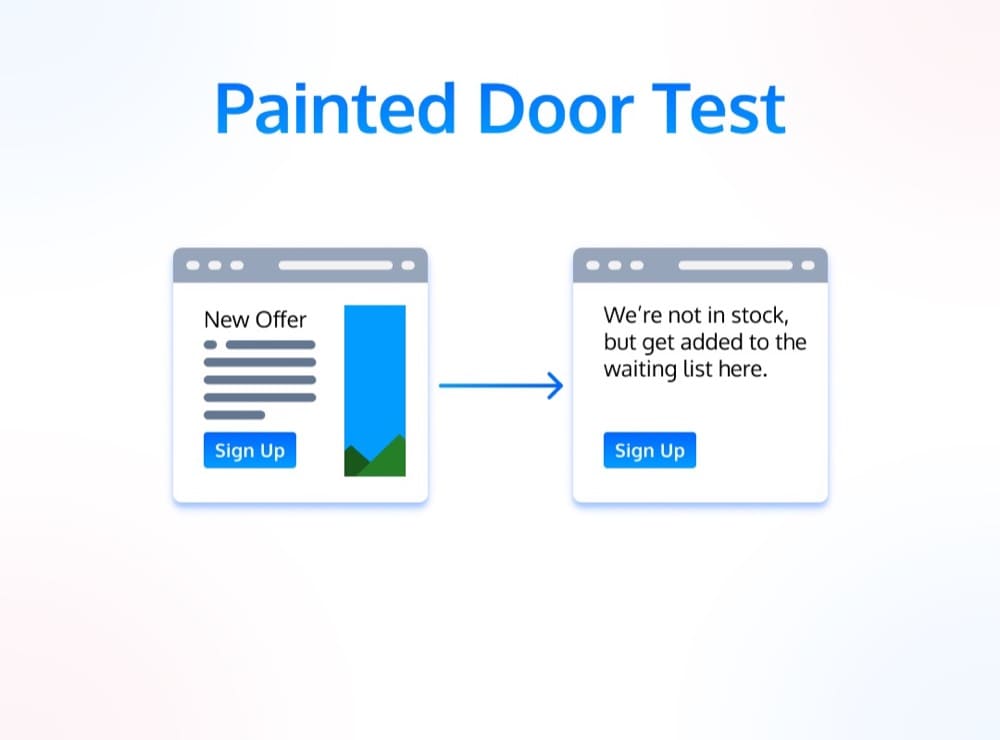

10. Prova della porta dipinta

Un test di una porta dipinta è simile a un test di esistenza in un certo senso. Sono molto comuni per testare nuove offerte e per testare la domanda di nuove funzionalità del prodotto.

Fondamentalmente, un test della porta dipinta è un esperimento per vedere se le persone utilizzeranno effettivamente una nuova funzionalità o meno. In realtà non spendi tempo e risorse per *creare* la nuova offerta o funzionalità. Piuttosto, crei una "porta dipinta" per vedere se le persone che passano cercheranno di aprirla (cioè crei un pulsante o una pagina di destinazione e vedi se le persone fanno clic su di esso, deducendo interesse).

L'obiettivo di un test di una porta verniciata è scoprire se c'è qualche domanda per la cosa che stai testando. Se le persone stanno effettivamente utilizzando la nuova funzionalità, allora sai che vale la pena perseguire. In caso contrario, allora sai che non vale la pena e puoi scartare l'idea.

Sono anche conosciuti come test del fumo .

I test delle porte verniciate sono un ottimo modo per testare nuove idee senza investire molto tempo o denaro.

Poiché in realtà non hai un'offerta o un'esperienza di creazione, di solito non puoi utilizzare KPI come il tasso di conversione. Piuttosto, devi modellare la tua soglia minima di valore atteso. Ad esempio, la creazione della funzione X costerà Y, quindi, dati i nostri dati di base esistenti, dovremo vedere la percentuale di clic Y per garantire la creazione dell'esperienza "reale".

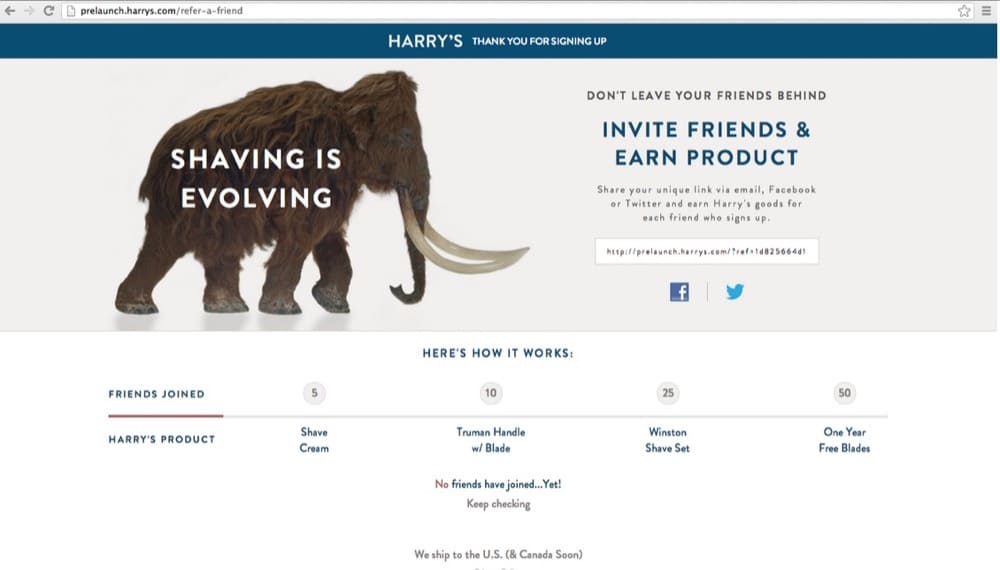

Una lista d'attesa prima del lancio è, in un certo senso, un test della porta dipinta (con il famoso esempio dei rasoi di Harry).

Casi d'uso: dimostra il business case per investire tempo e risorse nella creazione di una nuova funzionalità, offerta o esperienza.

11. Test di scoperta

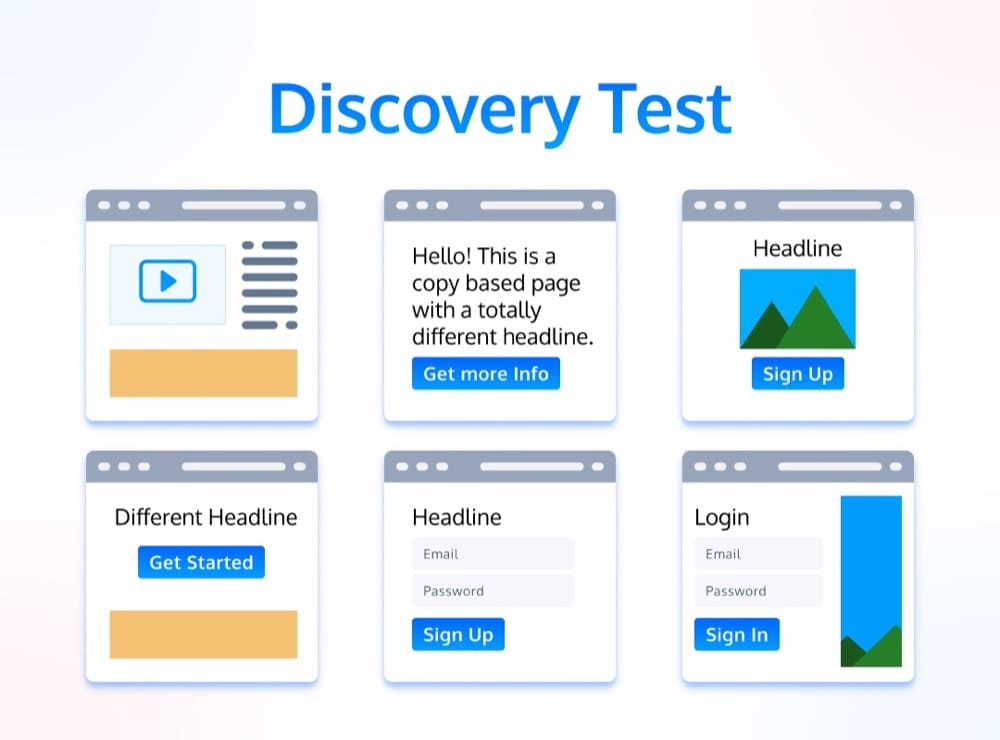

I test di scoperta, che ho estratto dalla Metodologia di test basata sulla disciplina di Andrew Anderson, mirano ad aumentare la gamma di opzioni possibili.

Sono quasi sempre una versione di test A/B/n con più varianti, ma non devono necessariamente essere progettati in questo modo. Lo scopo più grande di questi è testare opzioni al di fuori della gamma di ciò che normalmente avresti considerato ragionevole. Questo mitiga i tuoi pregiudizi, che possono limitare la portata delle opzioni che consideri mai.

Invece di definire in modo restrittivo un'ipotesi, speri di uscire dai tuoi pregiudizi e potenzialmente imparare qualcosa di completamente nuovo su ciò che funziona con il tuo pubblico.

Per fare un test di scoperta, prendi un pezzo di proprietà sul tuo prodotto o sito web e generi un sacco di varianti diverse. L'obiettivo è che ogni variante sia abbastanza diversa dall'ultima, offrendoti un'ampia gamma di opzioni dissimili. L'obiettivo è trovare qualcosa che funzioni, anche se non sai cosa sia in anticipo.

Nei test di scoperta, è importante mappare l'esperimento sul tuo KPI macro e non ottimizzarlo per le microconversioni. È anche importante testare esperienze significative e con traffico elevato, poiché ti consigliamo di disporre di un'adeguata potenza statistica per scoprire gli aumenti tra le numerose varianti.

Per vedere un esempio di un esperimento come questo, dai un'occhiata all'esempio di Andrew Anderson di Malwarebytes in cui hanno testato 11 varianti molto diverse.

Casi d'uso: svincola i tuoi sforzi di sperimentazione da ipotesi distorte e trova soluzioni fuori dagli schemi che, sebbene possano andare contro la tua intuizione, alla fine guidano i risultati aziendali.

12. Test iterativo

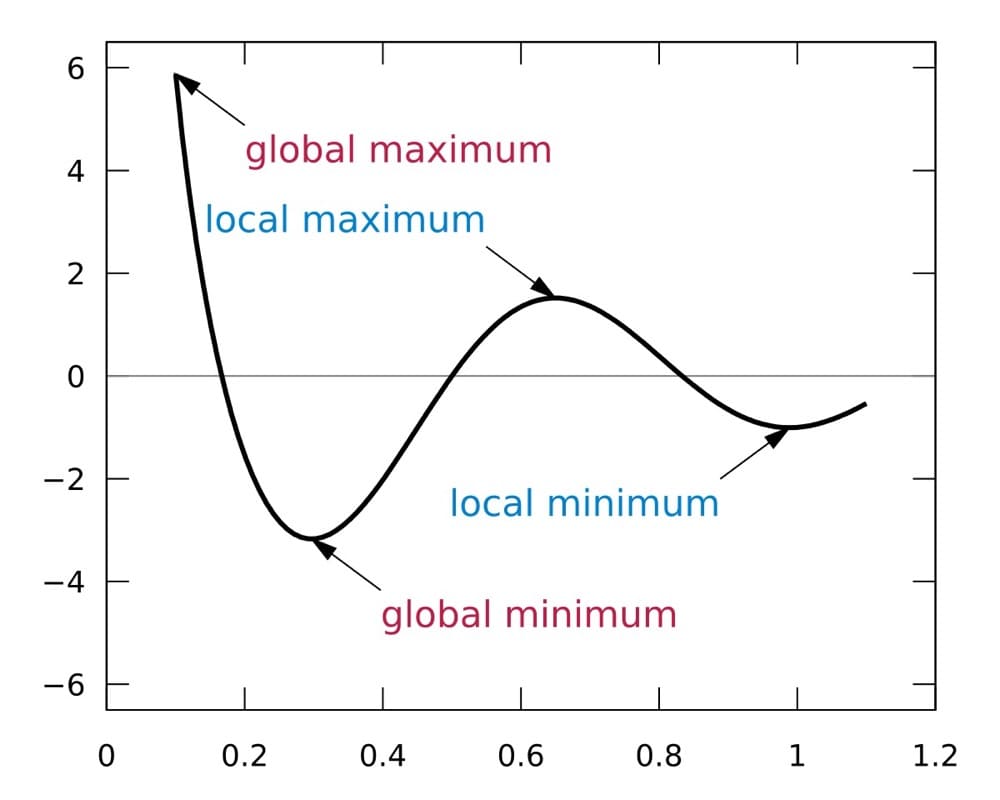

C'è un concetto noto in informatica come il "problema dell'arrampicata in collina". Fondamentalmente, gli algoritmi di arrampicata in collina cercano di trovare il punto più alto in un paesaggio partendo dal basso e salendo costantemente.

Lo stesso concetto può essere applicato agli esperimenti di marketing.

Con un test iterativo, inizi con una piccola modifica e poi continui a ingrandirla fino a raggiungere il punto di rendimenti decrescenti. Questo punto di rendimenti decrescenti è chiamato "massimo locale". Un massimo locale è il punto più alto del paesaggio raggiungibile dal punto di partenza.

L'obiettivo di un test iterativo è trovare il massimo locale per una determinata modifica. Questo può essere un modo molto efficace per testare cose come le modifiche alle offerte o ai prezzi, così come qualsiasi elemento che hai riscontrato avere un impatto attraverso la ricerca o attraverso test di esistenza.

Fondamentalmente, sai che l'elemento X è importante e sai che c'è ulteriore spazio di manovra per migliorare KPI Y migliorando l'elemento X. Quindi fai diverse piccole e iterative pugnalate per cambiare l'elemento X finché non sembra che non puoi più migliorare la metrica (o è estremamente difficile farlo).

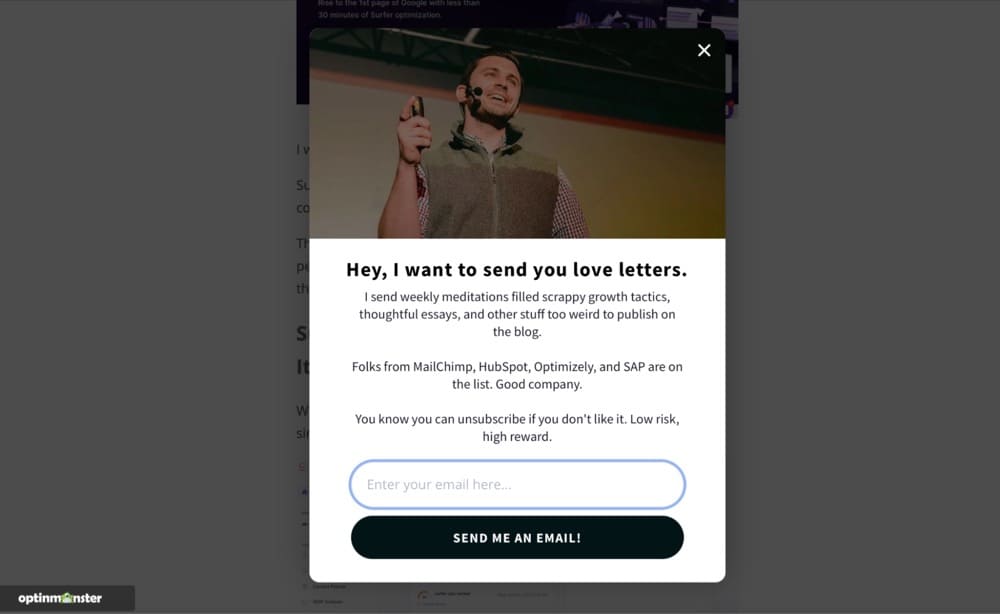

Un semplice esempio di test iterativo viene dal mio sito web. Eseguo popup di lead magnet. So che guidano le e-mail e probabilmente c'è un punto in cui i rendimenti decrescenti, ma non credo di averlo ancora raggiunto. Quindi, ogni pochi mesi, cambio una variabile: il titolo, l'offerta stessa o l'immagine, nella speranza di ottenere un piccolo aumento.

Casi d'uso: ottimizza elementi o esperienze mirati testando consecutivamente diverse piccole iterazioni dell'esperienza per raggiungere un massimo locale.

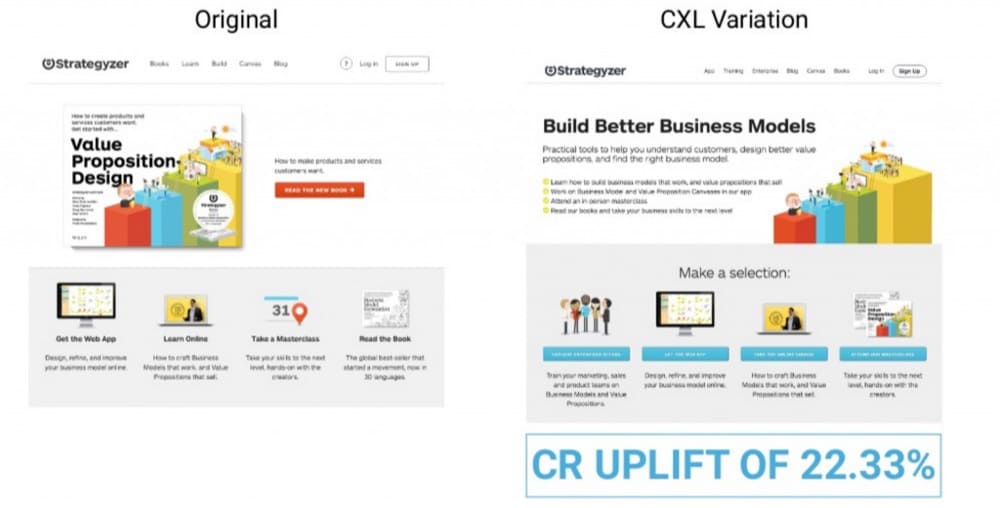

13. Test innovativo

Contrariamente ai test iterativi, i test innovativi cercano di trovare colline completamente nuove da scalare.

Secondo un articolo di CXL, i test innovativi sono "progettati per esplorare territori inesplorati e trovare nuove opportunità".

I test innovativi consistono nel provare qualcosa di completamente nuovo. Di solito sono un po' più rischiosi di altri tipi di esperimenti, ma possono anche essere molto gratificanti. Se stai cercando grandi vittorie, allora i test innovativi sono la strada da percorrere.

Le riprogettazioni complete della home page o della pagina di destinazione rientrano in questa categoria. Il test di scoperta è una forma di test innovativo. I test sul colore dei pulsanti sarebbero l'esatto opposto di un test innovativo.

Un test innovativo dovrebbe mettere leggermente a disagio te o i tuoi stakeholder (ma ricorda, il bello degli esperimenti è che hanno una durata limitata e limitano il tuo lato negativo).

CXL ha fornito un esempio di un test innovativo eseguito per un cliente qui:

Casi d'uso: fai un grande swing e trova una nuova "collina" da scalare. Avvolgi diverse ipotesi e cambia drasticamente un'esperienza.

14. Test di non inferiorità

Un test di non inferiorità viene utilizzato per determinare se un nuovo trattamento non è peggiore del trattamento standard.

L'obiettivo di un test di non inferiorità è dimostrare che il nuovo trattamento è efficace almeno quanto il trattamento standard.

Perché dovresti eseguire un test come questo?

Molte ragioni. La cosa migliore che mi viene in mente è se hai una variante che è "migliore" in qualche altra dimensione (è più economica da mantenere, aderisce meglio agli standard del marchio, ecc.), ma vuoi assicurarti che non danneggi il tuo KPI del core business.

Oppure, nell'ottica degli studi clinici medici, immagina che sia stato sviluppato un farmaco che costa 1/10 in più rispetto al farmaco comunemente prescritto. Finché non ha prestazioni *peggiori* rispetto al farmaco esistente, la sua convenienza significa che è un'opzione molto migliore da implementare.

Un altro motivo per cui li eseguo è se il trattamento è fortemente favorito da un dirigente o da una parte interessata. Odio dirtelo, ma solo perché abbiamo accesso ai dati come professionisti della sperimentazione non significa che evitiamo il disordine del pensiero parziale e della politica umana.

Sono felice di fare il test occasionale inviato da HiPPO ed eseguirlo attraverso una soglia di certezza inferiore come un test di non inferiorità. Finché non incasina i *miei* KPI, non c'è nulla di male nel lanciarlo e ottiene il favore politico.

Casi d'uso: limite negativo degli esperimenti in cui un'altra dimensione è superiore (costo, preferenza degli stakeholder, esperienza utente, marchio, ecc.).

15. Bandiera caratteristica

I flag di funzionalità sono una tecnica di sviluppo software che consente di attivare o disattivare determinate funzionalità o funzionalità e testare nuove funzionalità in produzione.

Senza entrare in un sacco di dettagli tecnici, ti consentono di testare le funzionalità in produzione o di distribuirle lentamente a sottoinsiemi più piccoli di utenti, pur mantenendo la possibilità di ridimensionare rapidamente o eliminare la funzionalità se non funziona.

In molti modi, sono una metodologia di garanzia della qualità. Ma poi di nuovo, in molti modi, lo sono anche i test A/B.

Il termine "flag di funzionalità" è in qualche modo un termine generico che include molte funzionalità di "attivazione/disattivazione" correlate, come versioni canary, test in produzione, sviluppo continuo, rollback e funzionalità.

Casi d'uso: testare nuove funzionalità o esperienze prima di distribuire il nuovo codice in produzione.

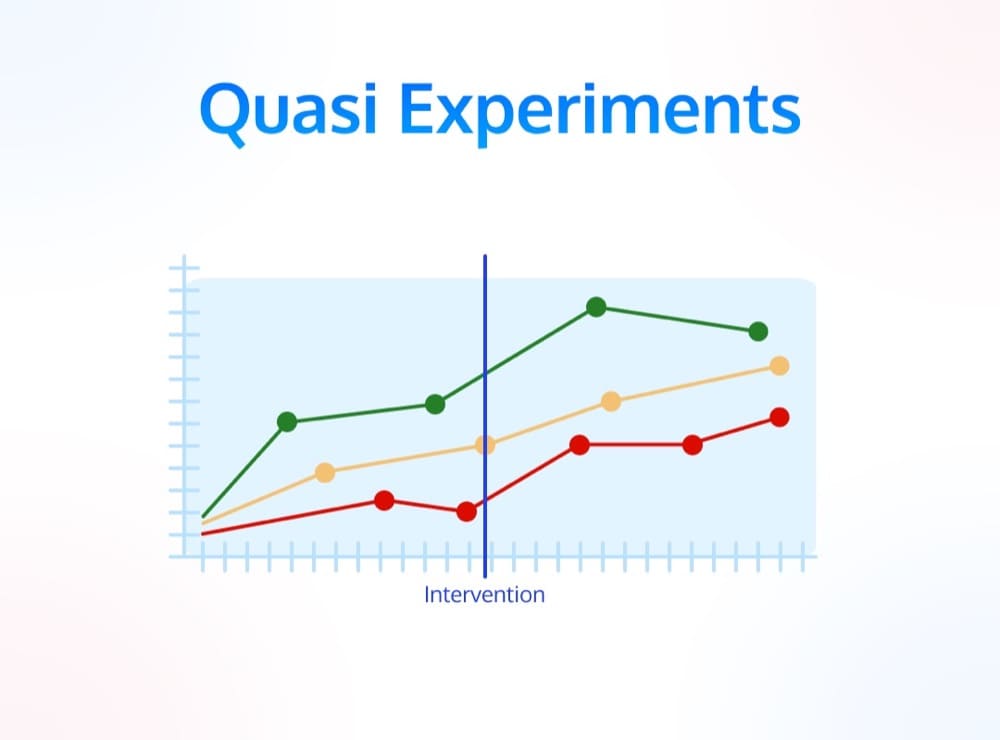

16. Quasi esperimenti

Infine, la categoria di esperimenti più complicata, ampia e più difficile da definire: i quasi-esperimenti.

I quasi-esperimenti vengono spesso utilizzati quando non è possibile assegnare casualmente gli utenti ai gruppi di test.

Ad esempio, se stai testando una nuova funzionalità sul tuo sito Web, puoi eseguire un test A/B, un flag di funzionalità o persino un braccio di personalizzazione.

Ma cosa succede se vuoi testare un sacco di modifiche SEO e vedere i loro effetti sul traffico? O ancora, il loro impatto sulle conversioni del blog? E se volessi testare l'efficacia degli annunci pubblicitari all'aperto?

In un numero sorprendentemente elevato di casi, è difficile se non impossibile avviare un esperimento strettamente organizzato e veramente controllato.

In questi casi, progettiamo quasi esperimenti per accontentarci di ciò che abbiamo.

Nel caso di modifiche SEO, possiamo utilizzare strumenti come Causal Impact per quantificare le modifiche su una serie temporale. Soprattutto se controlliamo il nostro esperimento sulla base di pagine o di qualche altra dimensione identificabile, questo ci darà una buona idea longitudinale se il nostro intervento ha funzionato o meno.

Nel caso di annunci radiofonici o cartelloni pubblicitari, possiamo provare a selezionare geolocalizzazioni rappresentative e quantificare l'effetto nel tempo utilizzando statistiche bayesiane simili.

Questo è un argomento complesso, quindi mi collegherò a due ottime risorse:

- Come Netflix esegue quasi esperimenti

- Come Shopify esegue quasi esperimenti

Casi d'uso: quantificazione dell'impatto quando uno studio randomizzato controllato non è possibile o fattibile.

Conclusione

Spero che questo ti abbia convinto che il test A/B va ben oltre la modifica del titolo o del pulsante CTA per ottimizzare i tassi di conversione.

Quando allarghi la tua apertura su ciò che la sperimentazione può realizzare, ti rendi conto che è uno strumento di apprendimento incredibile.

Possiamo mappare gli elementi di impatto su una landing page, identificare la combinazione ottimale di elementi, capire un nuovo e migliorato percorso della pagina utente, sviluppare nuove funzionalità ed esperienze senza rischiare debiti tecnici o una scarsa esperienza utente e persino testare nuovi canali di marketing e interventi al di fuori del nostro sito Web o al di fuori del nostro prodotto.