Statistiche sui test A/B: perché le statistiche contano nella sperimentazione

Pubblicato: 2020-11-16

Una guida rapida alle statistiche e ai test A/B: i termini che devi conoscere

È quasi impossibile condurre un ragionevole esperimento di test A/B senza avere un controllo sulle statistiche.

Mentre una piattaforma come Convert Experiences può occuparsi di tutte le misurazioni statistiche, ragionamenti e analisi per te, avere una comprensione di base di alcuni termini statistici ti aiuterà sicuramente.

Cominciamo con le basi.

Campione e popolazione

L'utilizzo di tutto il traffico del tuo sito Web per i test A/B, in teoria, ti darebbe un'idea generale della tua popolazione. Tuttavia, questo può essere un uso non ottimale delle risorse poiché la popolazione nella sua interezza è impossibile da catturare. È qui che i campioni tornano utili. Sebbene esistano diversi metodi di campionamento, l'utilizzo di un approccio di campionamento casuale aiuta a garantire che non vi siano distorsioni intrinseche nella selezione del campione. Questo approccio si ispira alla pratica medica-farmaceutica degli studi randomizzati controllati.

Media, mediana e moda

In termini più semplici, media sta per la media, mediana sta per i valori situati nel mezzo quando tutti i numeri sono allineati linearmente (il 50 ° percentile nella distribuzione) e moda è il valore più ripetuto. Questi tre termini sono utili quando si esaminano le statistiche riassuntive di un test A/B.

Varianza e Deviazione Standard

Questi sono concetti molto importanti che misurano la dispersione nei punti dati. In altre parole, quanto sono lontani i dati dalla media. La deviazione standard è la radice quadrata della varianza. Questo è il motivo per cui la deviazione standard è un miglior giudice della dispersione in quanto contiene la stessa unità di misura della media. Ad esempio, l'altezza media degli uomini adulti negli Stati Uniti è di 70 pollici con una deviazione standard di 3 pollici. Se dovessimo usare Varianza in questo esempio, il valore sarebbe 9 pollici quadrati, quindi è meno intuitivo. Pensa alla deviazione standard come alla deviazione "normale" dei dati.

Ipotesi nulla e alternativa

UN Null Hypothesis fa appello allo status quo. La tua ipotesi nulla affermerebbe che qualsiasi cambiamento che hai osservato nei dati, ad esempio l'incremento, è dovuto alla pura casualità. Un'ipotesi alternativa sarebbe che la modifica non sia casuale, ma che indichi un effetto causale, il che significa che le modifiche hanno avuto un impatto sui tuoi utenti.

Ad esempio, supponiamo che tu stia cercando di arricchire il miglior titolo per la tua pagina di destinazione. Hai una variante di controllo e una variante alternativa. Esegui un test A/B e ottieni tassi di conversione diversi per entrambi, quindi c'è un aumento (positivo o negativo). L'ipotesi nulla qui sarebbe che la differenza è dovuta alla casualità. L'ipotesi alternativa affermerebbe che il cambiamento è attribuibile a una certa variante.

Quando esegui un test A/B, otterrai uno dei seguenti quattro risultati:

- Rifiuti l'ipotesi nulla.

- Non riesci a respingere l'ipotesi nulla.

- Rifiuti falsamente l'ipotesi nulla.

- Non riesci a respingere falsamente l'ipotesi nulla.

Idealmente, i risultati aeb dovrebbero essere quelli a cui puntare poiché questi sono gli scenari da cui puoi imparare qualcosa. Questo è il modo in cui puoi migliorare il tuo prodotto e, in definitiva, aumentare i tuoi profitti. I risultati c e d corrispondono agli errori riportati di seguito.

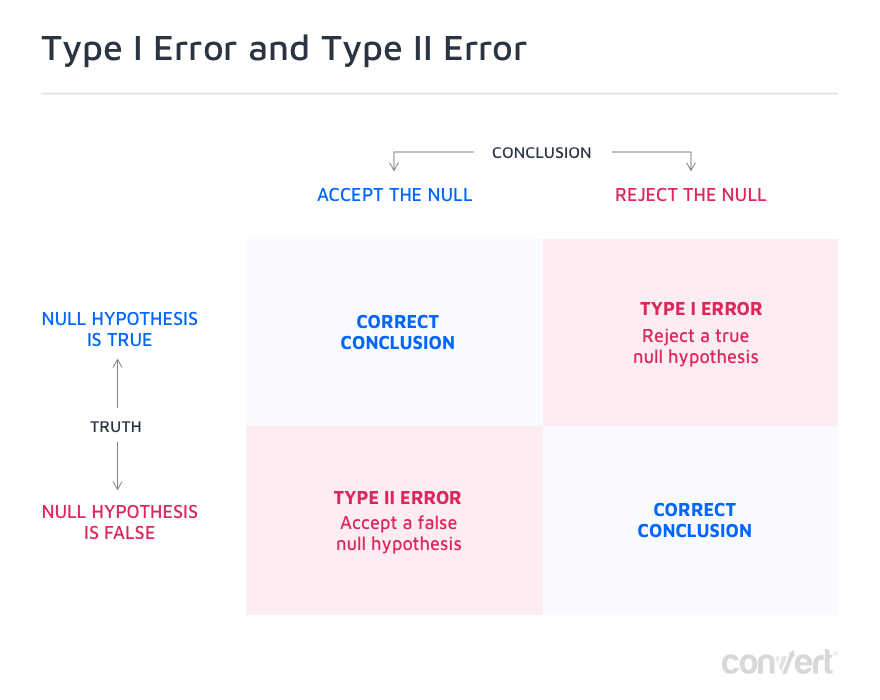

Errori di tipo I e di tipo II

Le ultime due opzioni nei possibili esiti del test A/B sono gli errori di tipo I e di tipo II, noti anche come falsi positivi e falsi negativi.

Un errore di tipo I è quando si rifiuta falsamente una vera ipotesi nulla. Cioè, il cambiamento che hai osservato è dovuto al caso ma hai concluso diversamente, quindi è un falso positivo. Nella maggior parte dei casi, tutto ciò che serve per diminuire i falsi positivi è aumentare il livello di confidenza richiesto per raggiungere la significatività statistica. Questo di solito è impostato su 95%, ma per esperimenti mission-critical, potresti voler impostarlo su una confidenza del 99%, il che ridurrà le possibilità di commettere un tale errore solo all'1%.

Gli errori di tipo II sono l'esatto opposto. Qui, non riesci a respingere una falsa ipotesi nulla. Ciò significa che c'è stato un impatto reale, positivo o negativo, sul tasso di conversione, ma non è sembrato statisticamente significativo e hai dichiarato falsamente che era dovuto al caso. Il più delle volte, ciò è dovuto alla mancanza di potere statistico.

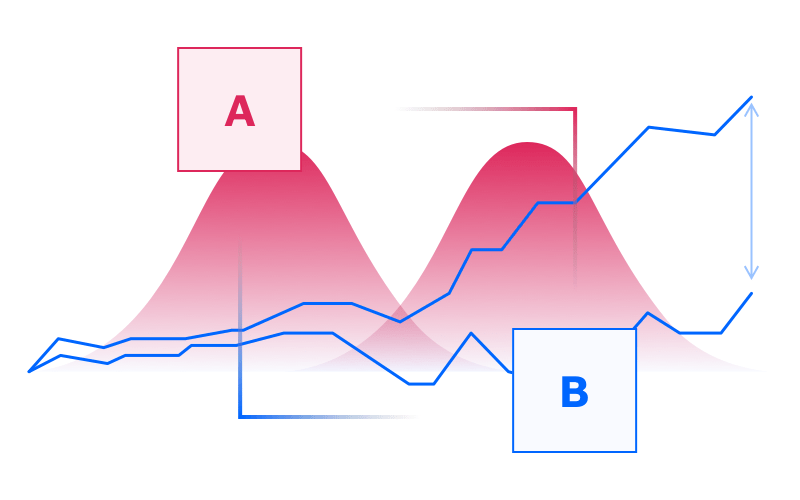

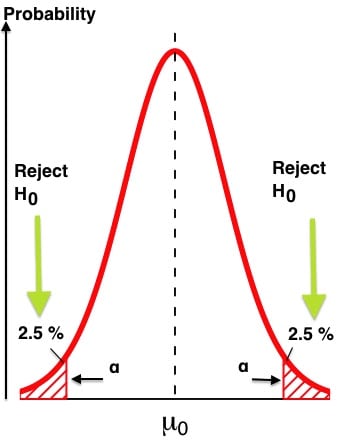

Nel gergo della potenza statistica, la lettera greca α rappresenta gli errori di tipo I e β rappresenta gli errori di tipo II. È facile confondersi tra potenza statistica e significatività statistica.

Questa tabella chiarisce:

Fiducia statistica

Più visitatori ottiene il tuo test, più aumenta la tua fiducia statistica, fino a raggiungere il 99% se lo lasci funzionare abbastanza a lungo. Ma di solito, a meno che non sia mission-critical, un livello di confidenza del 95% è considerato sufficientemente buono per la maggior parte dei test A/B (assicura che la possibilità di fare un falso positivo, ad esempio un errore di tipo I, sia al massimo del 5%).

Potenza statistica

La potenza statistica riguarda la probabilità di rilevare un effetto quando ce n'è uno.

Potenza statistica e fiducia statistica sono concetti correlati che lavorano insieme per misurare l'evoluzione di un test A/B. Idealmente, entrambi dovrebbero superare i valori di soglia prima di terminare il test (più su questo sotto).

Intervallo di confidenza e margine di errore

In genere, l'output del tuo esperimento di test A/B sarebbe qualcosa del tipo "Il tasso di conversione è del 3% +/- 1%". In questa affermazione, "1%" rappresenta il tuo margine di errore. In breve, questa è la deviazione nei risultati della conversione ragionevole per mantenere accettabili i risultati del test. Minore è il margine di errore, più affidabili diventano i risultati del test. Aumentando la dimensione del campione, noterai che il margine di errore diminuisce.

Se esegui test A/B con Convert Experiences, ottieni l'accesso al rapporto sull'esperienza che descrive in dettaglio la variazione, il tasso di conversione, il miglioramento, la sicurezza e le conversioni su visitatori mensili unici . Dovresti raggiungere almeno il 97% di fiducia per dichiarare un vincitore. Per impostazione predefinita, la piattaforma Convert è stata ottimizzata per iniziare a riportare l'analisi dell'esperimento solo dopo che sono state raggiunte cinque conversioni. Per garantire l'affidabilità dei test, Convert utilizza Z-Test a due code.

All'inizio dell'esperimento, se una delle varianti ha prestazioni significativamente migliori, dovresti comunque continuare con la durata stabilita del test. I primi risultati potrebbero essere causati da rumore o casualità.

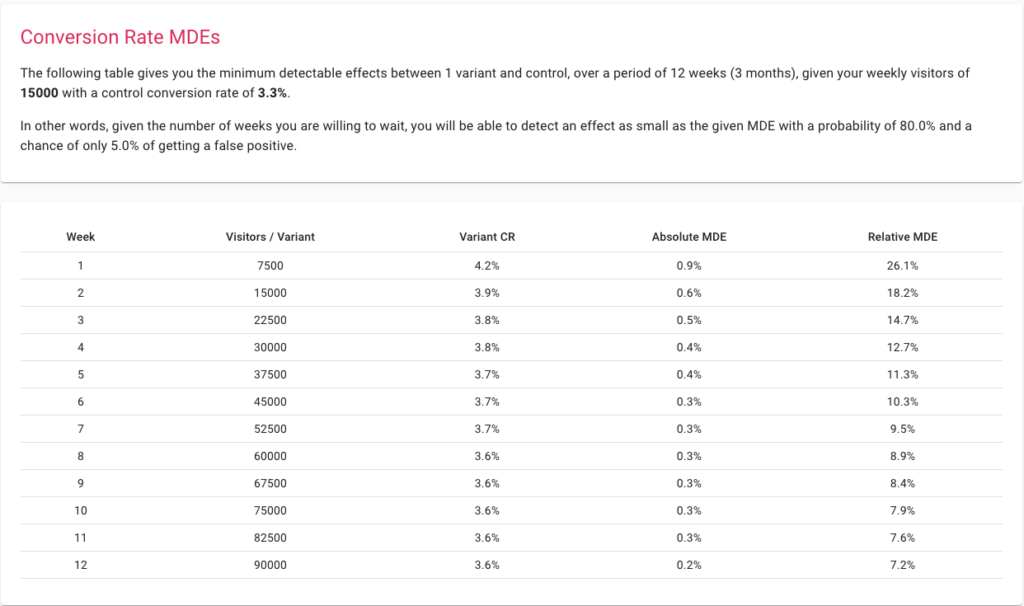

Effetti minimi rilevabili

MDE è l'incremento minimo da raggiungere, al di sopra del quale vale la pena implementare il cambiamento. La preparazione per un test scegliendo un MDE basso consente all'esperimento di acquisire modifiche più granulari. L'impostazione di un MDE più elevato significa che l'esperimento può rilevare solo modifiche importanti e quindi funzionare anche con campioni di dimensioni inferiori. Il problema qui è che apportare una modifica drastica per generare un aumento sufficientemente grande, nella maggior parte dei casi, non sarà possibile a meno che il tuo sito Web non sia mai stato ottimizzato prima.

Il modo migliore per pensare a MDE è utilizzare il nostro calcolatore delle dimensioni del campione. Inizia inserendo il traffico settimanale e le conversioni e guarda cosa è possibile ottenere in un periodo di tempo.

Valore P

Cassie Kozyrkov, Chief Decision Scientist di Google ha coniato una definizione molto semplice per spiegare il valore P: "Più basso è il valore p, più ridicola appare l'ipotesi nulla!"

Qual è il valore P nel test A/B?

Il valore P è definito come la probabilità di osservare un risultato come estremo o più estremo di quello osservato, assumendo che l'ipotesi nulla sia vera. Quindi, il p-value è un dispositivo matematico per verificare la validità dell'ipotesi nulla. Più piccolo è il p-value, più siamo sicuri di dover rifiutare l'ipotesi nulla.

Il modo in cui lo usiamo è confrontandolo con il livello di significatività. Supponiamo di avere un livello di significatività del 5%, che corrisponde direttamente ad un livello di confidenza del 95%, quindi non appena il p-value diventa inferiore a 5/100 = 0,05, possiamo dire che il nostro test ha raggiunto la significatività statistica e noi può rifiutare l'ipotesi nulla.

Se vogliamo essere ancora più sicuri, impostiamo il nostro livello di significatività su 1% e quindi attendiamo che il valore p scenda al di sotto di 0,01. Ciò equivarrebbe a una fiducia del 99% nei nostri risultati.

Distribuzione del traffico

La distribuzione del traffico consente di allocare una determinata percentuale di traffico all'esperimento. Supponi di avere 100 visitatori al tuo sito web ogni mese. Da questo, puoi scegliere di allocare il 30% del traffico all'esperimento. Per impostazione predefinita, ogni variante nel tuo test A/B riceverà una quota uguale del traffico. Quindi, se hai due varianti, ognuna riceverà il 15% del traffico.

L'utilizzo di Convert Experiences ti aiuta a configurare questa allocazione del traffico in pochi clic. Man mano che il processo di sperimentazione evolve, puoi creare più varianti e ottimizzare l'allocazione in base alle tue esigenze.

In che modo le statistiche possono aiutare nei test A/B?

Perché non puoi semplicemente confrontare le prestazioni delle varianti A e B?

L'esecuzione di un esperimento di test A/B utilizzando anche una piattaforma conveniente come Convert Experiences richiede alcune risorse in termini di tempo ed energia. Quindi, non avrebbe senso creare solo due varianti, misurare i rispettivi tassi di conversione e scegliere quella con prestazioni migliori?

Sebbene sembri pragmatico e pieno di risorse, può portare a conclusioni errate e persino a risultati interpretati erroneamente, poiché non sono stati eseguiti test statistici sui dati. Quindi osservare un cambiamento non è sufficiente, bisogna sapere quanto tempo aspettare per essere sicuri di quel cambiamento e, per questo, è necessario eseguire un test statistico come Z-test, T-test o G-test.

Guardare la sola dimensione dell'effetto lifting o dell'effetto non ti aiuterà:

un. Determinare i probabili fattori causali associati alla vincita di una variante

Un test A/B, in base alla progettazione, ti costringerebbe a scegliere due varianti che presentano solo alcune differenze di materiale. Per un insieme più ampio di differenze, generalmente si sceglie un test multivariato più ampio.

Il test A/B si basa sulla regola che, fin dall'inizio, si conoscono le variabili dipendenti e indipendenti nell'esperimento. Ad esempio, se crei due set con CTA diversi inseriti nello stesso layout, sai che la differenza tra i CTA è il fattore causale se puoi confutare l'ipotesi e vedere un cambiamento nelle conversioni.

Se esegui semplicemente due varianti completamente diverse, anche se ottieni una trazione relativamente migliore su una, non ti aiuterebbe a ottenere informazioni sul tuo pubblico o determinare perché funziona.

b. Distinguere tra casualità e causalità

La struttura di un test A/B richiederebbe un'ipotesi nulla e un'ipotesi alternativa. L'ipotesi nulla generalmente approfondirebbe la casualità come fattore causale e non l'efficacia di una delle tue varianti, nel determinare i tassi di conversione. Un'ipotesi nulla non viene confutata quando la significatività statistica non viene raggiunta in tempo e si presume che qualsiasi successiva variabilità sia il risultato della casualità. D'altra parte, se puoi rifiutare l'ipotesi nulla, significa che c'è un'alta probabilità (al livello di confidenza impostato, ad esempio 95% o 99%) che tu abbia scoperto un fattore causale con un impatto positivo o negativo sul conversioni.

c. Allocare i costi solo alle modifiche con maggiore probabilità di conversioni migliorate

I test A/B condotti includerebbero anche misure statistiche come livelli di significatività, intervalli di confidenza e margini di errore. Tali concetti analitici non esistono nella maggior parte delle analisi ad hoc.

Prendi, ad esempio, un confronto tra due pagine di invio dei moduli con alcune differenze sostanziali nel layout e nella visualizzazione delle informazioni. Uno si comporta relativamente meglio dell'altro. Ora, come stabilisci che sarai in grado di replicare i risultati? Dal momento che non disponi di alcun dato che mostri quanto siano stati significativi i risultati dell'esperimento, non c'è modo di giudicare se i risultati dell'esperimento possono essere replicati o meno.

Valutazione ed eliminazione dell'esposizione agli errori di tipo I e di tipo II per i test A/B

Gli errori di tipo I (una vera ipotesi nulla viene rifiutata o un falso positivo) e gli errori di tipo II (una falsa ipotesi nulla non viene rifiutata o un falso negativo) possono avere gravi conseguenze sugli asset di mercato che stai ottimizzando con il test A/B.

Nessuno strumento può mostrarti esplicitamente un errore di Tipo I o di Tipo II, ma può aiutarti a minimizzarli, ad esempio assicurandoti che venga raggiunto un livello di confidenza del 95% o più e che la potenza statistica abbia raggiunto almeno l'80%

Supponi di creare due varianti della pagina finale nel ciclo di acquisto, mostrarla a circa 10.000 visitatori in 10 giorni e ottenere i risultati. Vedi prestazioni migliori per una variante e quindi la applichi sul tuo sito Web di e-commerce.

Il problema qui è che verrai a conoscenza di un errore di tipo I o di tipo II nel tuo esperimento di test A/B dopo che non avrai replicato i risultati del tuo esperimento nella realtà. Ci sono modi migliori per assicurarti di non avere errori di Tipo I e Tipo II nel tuo test A/B.

Innanzitutto, assicurati che la dimensione del tuo campione sia sufficientemente grande da garantire una solida sperimentazione statistica. Puoi utilizzare la calcolatrice di Convert per ottenere la giusta dimensione del campione.

Quindi, assicurati di avere un livello di significatività di almeno il 95% e non interrompere il test finché la tua potenza non ha raggiunto l'80%. Con la giusta MDE e la durata dell'esperimento fornite dalla calcolatrice, puoi essere praticamente certo di controllare gli errori di Tipo I o Tipo II. Il primo è direttamente influenzabile dal livello di significatività che hai impostato e il secondo dal potere statistico con cui sei disposto a convivere. Idealmente, il tuo livello di confidenza dovrebbe essere superiore o uguale al 95% e il tuo potere statistico dovrebbe essere accumulato almeno all'80%. In entrambi i casi, più è meglio è. Se entrambi i parametri raggiungono il 99%, si assicura che il rischio di errori di Tipo I o II sia ben controllato e inferiore all'1%.

Sia la scoperta che l'eliminazione di tali problemi sono possibili solo grazie al pensiero statistico su cui opera il test A/B.

Determinare se il tuo esperimento di test A/B è scalabile o meno

Nell'esempio sopra, anche se vedi una variante vincere sulla sua alternativa in un mese, non saresti in grado di scalare facilmente il tuo esperimento. Questo perché la dimensione del campione di 10.000 visitatori era piuttosto piccola.

Le statistiche dei test A/B forniscono molte guide euristiche per garantire che il test sia scalabile e lo siano anche i suoi risultati. I risultati di ogni esperimento di test A/B apriranno la strada a ulteriori test in futuro.

Innanzitutto, inizia assicurandoti di avere traffico sufficiente in entrata ogni mese per testare qualsiasi variante dell'interfaccia utente o degli elementi UX della tua piattaforma. Gli esperti di Convert consigliano un traffico di almeno 10.000 visitatori e 1.000 conversioni su ciascuna variante per ottenere risultati statisticamente validi. Una volta che li hai, assicurati di non testare più elementi contemporaneamente, di consentire al test di essere eseguito per una durata considerevole e di poter raggiungere un ragionevole livello di significatività.

Se hai un piccolo gruppo di visitatori, puoi comunque condurre test A/B su campagne e-mail, campagne sui social media e persino gruppi di annunci di Google. Oppure puoi optare per un MDE elevato per ottenere alcune informazioni generali sul tuo pubblico.

Rendere gli esperimenti convenienti

Allocare qualsiasi percentuale del tuo traffico per un test A/B è un costo. Stai mostrando una pagina o un elemento UX possibilmente non ottimale al tuo pubblico e quindi potresti perdere alcune potenziali entrate. Mentre il test A/B ti darà un'idea definitiva per ridimensionare un elemento o una pagina più ottimizzati in grado di recuperare queste probabili entrate perse, questo costo può essere utilizzato come vincolo per ottimizzare il processo di test.

Dopo aver condotto un test A/B, puoi passare a un test A/B/n in cui avrai molte altre varianti da testare.

Molti calcolatori gratuiti disponibili online ti mostrerebbero la dimensione del campione necessaria per risultati accurati di questo test. Questi calcolatori funzionano su un presupposto semplicistico: calcolare la dimensione del campione per un test A/B e quindi moltiplicarla per il numero di varianti dell'esperimento. Questo è un modo inefficiente di procedere. La nostra calcolatrice offre efficienti opzioni di correzione del confronto multiple come Šidak, quindi usa sempre gli strumenti giusti in ogni fase della tua sperimentazione per assicurarti di ottenere i risultati necessari senza perdere i soldi extra sostenuti da errori di calcolo.

Inizia a pianificare i tuoi test con il calcolatore di test A/B di Convert

Stima e controllo della casualità nel tuo campione

Sebbene esistano diversi principi matematici complessi di casualità, la maggior parte di essi indica la stessa caratteristica: l'imprevedibilità.

La casualità può essere percepita come l'opposto di una causalità chiaramente definita. Invece di sapere quali elementi erano responsabili della conversione più elevata, devi fare affidamento su alcuni fattori esterni indefiniti come probabili fattori causali per i risultati. Dal momento che non controlli questi fattori esterni, non puoi replicare i risultati dei test su larga scala.

Se non stai utilizzando un processo di test A/B statisticamente valido, non ti preoccuperai di esaminare l'impatto della casualità. Ma la casualità esisterà ancora. Potresti finire per distribuire capitale su una risorsa di marketing che si converte durante il test ma non funziona su larga scala. Peggio ancora, potresti finire per diluire l'impatto della tua canalizzazione di conversione esistente.

Le statistiche dei test A/B possono aiutarti a risolvere questo problema. Quando formuli un'ipotesi, stai creando uno scenario in cui la casualità potrebbe essere la ragione dei risultati modificati. Se puoi confutare questo scenario, in sostanza hai confutato la casualità come causa di conversioni migliori. Con più test in corso nel processo incentrati su altre aree nella canalizzazione di conversione, puoi eliminare ulteriormente lo spazio per la casualità nel processo di ottimizzazione della conversione.

L'ideale sarebbe definire un Criterio di valutazione globale (OEC) con una metrica principale e altre metriche del guardrail ed eseguire esperimenti per ottimizzare la prima assicurandosi che le ultime non si deteriorino. Ad esempio, vuoi aumentare i tassi di conversione (metrica principale), ma non vuoi che il coinvolgimento degli utenti diminuisca, perché ciò indicherebbe clienti insoddisfatti.

Un grande libro, probabilmente il libro più importante sulla sperimentazione fino ad oggi, è Trustworthy Online Controlled Experiments: A Practical Guide to A/B Testing, di Ron Kohavi, Diane Tang, Ya Xu.

Garantire che non sia necessario un test multivariato più completo

Strumenti completi come Converti esperienze possono aiutarti a eseguire più test A/B. Sebbene possa sembrare una funzionalità banale, può aiutarti a capire se hai bisogno di un test multivariato più completo o se i risultati del tuo test A/B sono sufficientemente soddisfacenti.

Tutto questo dipende da cosa fai subito dopo aver compreso i risultati del test. Inizi a distribuire la pagina o l'elemento vincente o fai ulteriori test? Se la dimensione del campione, il livello di significatività e l'MDE sono soddisfacenti, di solito è possibile implementare l'alternativa vincente. Se sei dall'altra parte, puoi utilizzare ulteriori test per trovare la causa dei diversi tassi di conversione.

Ad esempio, supponiamo che tu stia verificando se avere un determinato CTA sulla tua pagina di destinazione aiuta a ottenere conversioni migliori o meno. Esegui il tuo test A/B e hai un chiaro vincitore. Tuttavia, alcune misure statistiche come il livello di significatività non sono soddisfatte. Quindi, prendi la variante vincente e ne crei un'altra per condurre un altro test A/B.

Se i risultati vengono replicati, puoi avere maggiore fiducia nella variante vincente. Se non riesci a replicare i livelli di conversione del primo test, potresti aver bisogno di un test multivariato per trovare l'elemento responsabile dell'incremento nelle conversioni.

I test A/B possono aiutarti a evitare la dipendenza dai dati auto-segnalati

Anche la più piccola delle variabili può avere un impatto importante sul comportamento dell'utente rilevato. Ad esempio, l'effetto sfarfallio ha un notevole impatto sui tassi di conversione. Lo sfarfallio è la situazione in cui la pagina di destinazione predefinita viene mostrata prima della pagina variante quando un visitatore fa parte del traffico campione utilizzato per i test A/B. Ciò può portare a risultati inquinati, anche quando si esegue un processo analiticamente coerente.

Quando possono esserci possibili problemi con processi statistici e analitici come i test A/B, l'esecuzione di un processo auto-riferito può solo portare a risultati più subottimali o addirittura falsi. I processi di auto-segnalazione sono spesso inquinati da numerosi pregiudizi e dati rumorosi poiché l'intera responsabilità di ricordare le preferenze e segnalarle è lasciata all'utente, che non ha alcun incentivo ad essere onesto. Inoltre, ci sono distorsioni nell'ordine e altri fattori esterni che possono portare a dati errati.

Il test A/B ti mette sulla sedia di osservazione ed elimina la necessità di qualsiasi forma di segnalazione degli utenti. Con strumenti come Converti, non devi nemmeno preoccuparti dello sfarfallio.

Prendere decisioni organizzative basate sui dati

Un esperimento di test A/B non lascia spazio a congetture nel processo. Ad ogni passaggio, la tua piattaforma di test raccoglie osservazioni, registra dati ed esegue analisi. In questo modo, indipendentemente dalle preferenze dei tuoi superiori o degli investitori o delle agenzie, i risultati che otterrai sarebbero basati sui dati.

Quando ci sono diverse parti interessate coinvolte nel processo, è facile che il risultato finale non sia ottimale. Il test A/B è un processo analitico, che elimina lo spazio per qualsiasi processo decisionale gerarchico o pensiero distorto.

Ad esempio, la tua agenzia potrebbe consigliare una revisione dell'interfaccia utente per la tua pagina di destinazione perché si aggiungerà ai fatturabili del mese e, se eseguita correttamente, potrebbe non ostacolare nemmeno le tue conversioni. Tuttavia, con un test A/B, se la tua ipotesi nulla rimane forte, sapresti per certo che tali modifiche non sono necessarie per il momento. Dal momento che hai i dati per sostenere il tuo ragionamento, non devi soccombere alla posizione nemmeno per la leadership nella tua azienda. Questo può anche aiutarti a combattere HiPPO (Opinione della persona più pagata). I dati non mentono e un test A/B è la migliore prova che hai a tua disposizione.

Comprendere i risultati dell'esperimento con calcoli trasparenti

Comprendere i risultati del tuo test A/B è importante quasi quanto eseguire un test statisticamente rigoroso. Qualsiasi strumento può eseguire il test, confrontare le alternative e lanciarti un vincitore. Ciò di cui hai bisogno è un'indicazione di una relazione causale. Mentre le misure statistiche possono evidenziare questo, Convert Experiences è stato progettato per la trasparenza nei calcoli.

La piattaforma ha un tempo di attività del 99,99%, consente oltre 90 integrazioni di terze parti, consente il monitoraggio degli obiettivi di terze parti e supporta il controllo del codice e degli errori. In questo modo, alla fine del processo di test, avrai un'idea chiara di quale elemento è il vincitore, perché è più preferibile e se hai bisogno di più test per essere più sicuro di ridimensionarlo.

Mettere le statistiche A/B da utilizzare per passare alla maturità CRO

Che cos'è la maturità CRO e in che modo i test A/B possono essere statisticamente utili per arrivarci?

Sebbene l'ottimizzazione del tasso di conversione possa sembrare un modo di pensare isolato, richiede modifiche basate sui processi in tutta l'azienda che cercano di concentrarsi maggiormente sulle conversioni. La sfida è che il CRO è un campo relativamente nuovo. In un sondaggio del 2018, quasi il 62% dei marketer lavorava in CRO da meno di 4 anni.

Uno specialista CRO di Shopify ha creato una gerarchia di come le aziende tendono a trascendere verso la maturità CRO. Man mano che approfondisci questa gerarchia, scoprirai come una solida sperimentazione statistica sia fondamentale per far evolvere i tuoi processi organizzativi:

1. Condurre ricerche qualitative e quantitative per identificare punti di contatto non ottimali

La tua dashboard di Google Analytics ti aiuterà spesso a esplorare le pagine o i punti di contatto nell'esperienza del consumatore che richiedono un'attenzione immediata. La risoluzione di un problema specifico come frequenze di rimbalzo elevate sulla home page, carrelli abbandonati, compilazione incompleta dei moduli e abbonamenti e-mail ignorati può essere utilizzato come punto di partenza per ottimizzare la canalizzazione di conversione.

2. Formulazione di test e sperimentazioni di idee basate sulla ricerca eseguita in precedenza

Le statistiche dei test A/B possono aiutarti a comprendere le prestazioni del benchmark per il tuo sito Web e persino la concorrenza. Puoi usarlo per capire quali elementi sono in ritardo e avviare varianti di test A/B che possono funzionare meglio.

3. Esecuzione di test e sperimentazione di idee con priorità più alte

Quando imposti le tue idee per i test A/B in Converti esperienze, imposterai metriche come MDE. Tali metriche ti aiuteranno a stabilire la priorità dei test che avranno il massimo impatto sulla tua attività, per quanto riguarda l'allocazione delle risorse necessaria per eseguire l'esperimento.

4. Analisi e registrazione dei risultati dei test

Dopo aver condotto il test, diventa fondamentale capire perché hai ottenuto i risultati che stai vedendo. È qui che piattaforme come Convert Experiences possono aiutarti a filtrare tra casualità e causalità ad alta probabilità. Con i suoi calcoli trasparenti, Convert Experiences ti aiuterà a capire perché la tua variante vincente ha prestazioni migliori.

5. Creazione di test di follow-up

Una volta che hai condotto i test A/B e ottenuto i risultati, puoi passare a test multivariati più completi o condurre un test A/B con un'altra variante. Convert semplifica la conduzione di una serie variegata di test statistici che possono aiutarti ad aumentare la tua sicurezza nel sostenere la variante vincente.

Il modello di maturità CRO si concentra su un processo olistico attraverso la strategia e la cultura, gli strumenti e la tecnologia, le persone e le competenze e i processi e la metodologia di un'azienda in cui i progressi dell'impresa vengono monitorati attraverso livelli di maturità come: principiante, aspirante, progressista, strategico, e trasformativo.

Convert Experiences apporta un'analisi rigorosa dei dati al processo di test A/B, non richiede la codifica per condurre i test, fornisce risultati visivamente e analiticamente accessibili ed è trasparente sui risultati dei test. Con la piattaforma al centro dei tuoi piani di test A/B, la tua maturità CRO aziendale può passare alle fasi trasformative con maggiore facilità.

Test A/B in azione: casi di studio comparati

1. Utilizzo di Google Analytics e conversione di esperienze per la generazione di ipotesi

Google Analytics può essere un ottimo punto di partenza per comprendere le potenziali aree di miglioramento del tuo sito web. Il calo improvviso del traffico, le frequenze di rimbalzo elevate rispetto ai tempi di pagina, ecc. possono essere forti indicatori di potenziali problemi.

Traccia tutte le sfide che vedi nei rapporti di Google Analytics. Parallelamente, esegui un sondaggio qualitativo sul tuo sito Web, sugli handle dei social media e sulle campagne e-mail chiedendo al tuo pubblico cosa stanno cercando. In aggiunta a questo, puoi usare Hotjar per capire come i visitatori navigano tra gli elementi di ogni pagina.

Sulla base di tutti questi dati, puoi quindi creare varianti approfondite ed eseguire test A/B. Se stai già utilizzando Converti esperienze, puoi anche utilizzare lo strumento di generazione di ipotesi Converti bussola per accelerare ulteriormente il processo.

2. Aumentare le conversioni dai carrelli abbandonati tramite test A/B

I carrelli abbandonati sono costosi per il tuo sito Web e piuttosto scomodi per i tuoi visitatori poiché entrambi avete investito molto tempo e risorse per arrivare a questo punto, ma la conversione non ha funzionato.

Utilizzando Convert Experiences integrato con altre piattaforme, puoi formulare un approccio strutturato per affrontare questa sfida.

- Innanzitutto, inizia con l'integrazione di Convert Experiences nel tuo Shopify, WooCommerce, PrestaShop, BigCommerce o qualsiasi altra piattaforma di eCommerce che stai utilizzando.

- Quindi, utilizza Google Analytics per impostare obiettivi sulle tue piattaforme e utilizza strumenti come Hotjar o Crazy Egg per valutare il possibile problema.

- Con Convert Experiences, puoi utilizzare questi dati, formulare ipotesi ed eseguire test A/B in modo organizzato. I clienti hanno osservato un aumento dei ricavi di oltre il 26% utilizzando un approccio simile.

Convert Experiences si integra con oltre 100 strumenti. Dai un'occhiata al nostro database per scoprire se ci integriamo con gli strumenti nel tuo attuale stack tecnologico. In caso contrario, inviaci un messaggio e lo costruiremo!

3. Ottimizzazione della pagina di destinazione

Le pagine di destinazione sono piuttosto centrali per l'intero processo di conversione. Per estrarre il massimo valore dalle tue pagine di destinazione, puoi utilizzare una varietà di strumenti come Google Analytics, Adobe Analytics, Kissmetrics, Baidu Analytics o altri strumenti leader per il caso d'uso. Convert Experiences si integra perfettamente con queste piattaforme per aiutarti a filtrare le pagine di destinazione a bassa conversione.

Successivamente, puoi utilizzare l'integrazione Hotjar e Convert per capire quali elementi della tua pagina non funzionano. Con strumenti avanzati come le mappe di calore, puoi ottenere una comprensione visiva di come i visitatori accedono ai diversi elementi della tua pagina. Oltre a ciò, puoi utilizzare Converti bussola per generare ipotesi e quindi eseguire test sulla piattaforma.

Dopo aver condotto il test, puoi utilizzare l'integrazione tra Convert e le principali piattaforme di creazione di pagine di destinazione come LanderApp, Instapage o Hubspot CMS. Queste integrazioni ti aiuteranno a eseguire semplici esperimenti di test A/B sulle tue pagine di destinazione.

Utilizzando lo stesso flusso di lavoro, gli esperti CRO hanno riscontrato incrementi di conversione del 27% con tassi di aggiunta al carrello in aumento del 13%.

Raggiungere un ROI più elevato con il test A/B "igienico".

- Soglia di traffico del sito web : Convert consiglia di avere un traffico di almeno 10.000 visitatori e conversioni superiori a 1.000 disponibili per ciascuna variante in fase di test.

- Utilizzo dello strumento giusto per i test A/B : non avere la piattaforma di test giusta può darti risultati inquinati, farti eseguire test non ottimali o causare gravi vincoli alle tue risorse. Convert Experiences è stato progettato per eliminare questi parametri chiave garantendo al contempo che il processo di test sia accessibile, trasparente e senza interruzioni.

Ora puoi eseguire test in Converti esperienze gratuitamente per un massimo di 15 giorni. Avrai un'idea chiara di come si sente una piattaforma trasparente, senza sfarfallio e senza sfarfallio che si integra con gli altri tuoi strumenti di analisi delle conversioni.

- Definizione degli obiettivi di test : i tuoi obiettivi come azienda devono essere allineati. Ad esempio, mentre stai ottimizzando per il massimo delle iscrizioni, alcune altre unità del tuo team non dovrebbero ottimizzare i processi conseguenti per ottenere il massimo delle vendite. Un'esperienza utente incoerente può causare più danni di un'esperienza utente non ottimale.

Quindi, mantenere l'uniformità degli obiettivi tra l'intero gruppo di membri del team. A livello di test, assicurati di definire chiaramente la dimensione del campione, la durata, la significatività statistica, l'ipotesi e la MDE prima, durante e dopo l'esecuzione del test A/B.

- Esclusione del traffico interno: quando esegui un test A/B, molti membri del tuo team visitano le pagine o i punti del percorso del cliente per valutare obiettivamente la pagina. Questo può causare rumore ai risultati dei test.

Convert Experiences è stato progettato per filtrare tale traffico e concentrarsi solo sui segmenti di pubblico che hai definito, per la registrazione, l'aggregazione e l'analisi dei dati nel processo di test A/B.

Considerazioni finali sulle statistiche dei test A/B

Il test A/B è un rigoroso esercizio analitico che può essere eseguito solo con rigore statistico. Senza le statistiche costruite nel processo, il test A/B è pura congettura.

Convert Experiences ti consente di avere esperimenti di test A/B semplificati, accessibili, affidabili e allo stesso tempo efficienti in termini di risorse. While the process of A/B testing can seem a little overwhelming at first, it certainly unlocks value in the form of the right insight and analytical proven ideas it gives you. Make sure you never run an A/B test in isolation – it has to be followed up with more tests, and even multivariate tests.

With consistent optimization and unlimited tests made available by Convert Experiences, you can expect your enterprise to become a more analytical and data-driven operation in no time.