Scansione del monitoraggio del budget prima e dopo un aggiornamento

Pubblicato: 2019-12-10Psst... C'è un segreto che voglio dirti.

Il tuo sito ha un "budget di scansione" impostato da Google.

Questa è la metrica segreta utilizzata da Google per misurare due cose:

- Quanto bene è costruito il tuo sito

- Quanto è popolare il tuo sito

Questo articolo si concentrerà sul primo punto.

Migliorare la qualità di costruzione del tuo sito aumenterà il tuo budget di scansione.

Maggiore è il tuo budget di scansione, più frequentemente Google si fermerà a leggere le tue pagine.

Iniziamo condividendo la comprensione di cos'è un crawl budget.

Cos'è il Crawl Budget

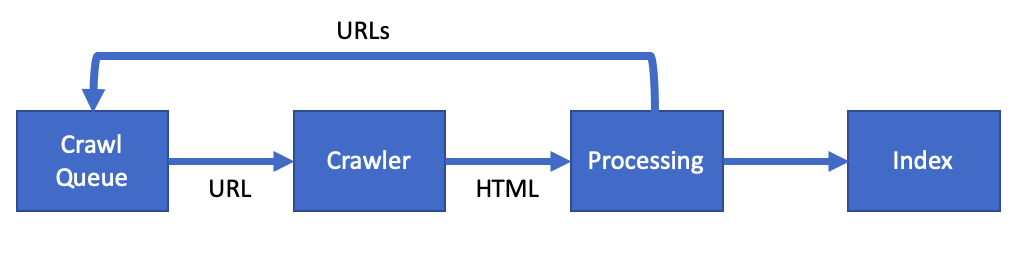

Google utilizza uno speciale programma software chiamato web crawler (o spider) per leggere le pagine del tuo sito.

Chiamano questo web crawler, Googlebot.

Budget di scansione è il termine per descrivere la frequenza con cui Googlebot eseguirà la scansione delle tue pagine.

Ottimizzando il tuo sito puoi aumentare il tuo budget di scansione.

Google ha affermato che il tuo crawl budget è una combinazione di:

- Velocità di scansione: la velocità con cui Googlebot può eseguire la scansione del tuo sito senza interrompere i tuoi server

- Domanda di scansione: quanto è importante la tua pagina web per gli utenti di Google

Man mano che queste metriche migliorano, vedrai Googlebot visitare più spesso. Leggere più pagine ad ogni visita.

Una volta che Google esegue la scansione di una pagina, aggiungerà il contenuto all'indice di Google. Che quindi aggiorna le informazioni mostrate nei risultati di ricerca di Google.

Ottimizzando per il crawl budget puoi migliorare la velocità degli aggiornamenti dal tuo sito alla Ricerca Google.

Perché dovresti migliorare il tuo Crawl Budget

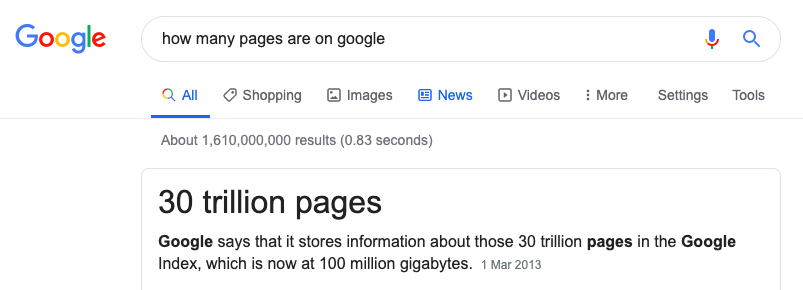

Google ha un compito difficile. Hanno bisogno di eseguire la scansione e l'indicizzazione di ogni pagina su Internet.

Il potere di cui hanno bisogno per farlo è enorme e non possono indicizzare ogni pagina.

L'ottimizzazione del budget di scansione darà al tuo sito le migliori possibilità di apparire nei risultati di ricerca.

[Case Study] Gestione della scansione dei bot di Google

Come migliorare il tuo Crawl Budget

Migliorare un sito significa rendere il tempo di Googlebot su un sito il più efficiente possibile.

Non vogliamo:

- Googlebot legge le pagine che non vogliamo nella Ricerca Google.

- Googlebot vede gli errori del server

- Googlebot a seguito di collegamenti interrotti/non funzionanti

- Googlebot in attesa del caricamento della pagina

- Googlebot che legge contenuti duplicati

Tutto quanto sopra sta sprecando le preziose risorse di Google e potrebbe vedere la tua velocità di scansione diminuire.

Budget di scansione e SEO tecnico

Gran parte di ciò che devi fare come parte della SEO tecnica equivale a ottimizzare il Crawl Budget.

Abbiamo bisogno:

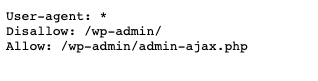

- Ottimizza robots.txt e verifica la presenza di errori

- Correggi eventuali tag hreflang e link canonici

- Risolvi non-200 pagine

- Correggi i reindirizzamenti e gli eventuali loop di reindirizzamento

- Assicurati che tutte le mappe del sito siano esenti da errori

Diamo un'occhiata alla creazione della pagina perfetta per Googlebot.

Come creare la pagina perfetta

OK quindi forse non è la pagina perfetta, ma dovremmo cercare di migliorare la pagina il più possibile.

Diamo un'occhiata ad alcuni problemi comuni sulla pagina che puoi migliorare.

Problemi di pagina

- Contenuto duplicato: contrassegna qualsiasi contenuto duplicato sul tuo sito con un tag di collegamento canonico.

- Pagine non SSL: trova eventuali collegamenti HTTP e convertili in HTTPS. Se non disponi di un certificato SSL, ottienine uno gratuito da Let's Encrypt.

- Scansiona solo le pagine utili: usa il tuo file robots.txt per ridurre dove può andare Googlebot. Ad esempio, se hai pagine utilizzate per un amministratore, Disabilita questo nel tuo file robots.txt.

- Contenuto sottile: prendi in considerazione la possibilità di bloccare lo scraping delle pagine con contenuto sottile o molto basso. Se hai pagine che hanno poco valore per un utente, non sprecare il tempo di Googlebot su queste pagine.

- Errori del server: gli errori del server sono un segno di un server Web non integro. Se il tuo sito restituisce errori 5xx, la correzione di questi può aumentare la velocità di scansione.

Pagine a caricamento lento

Un modo per migliorare il crawl budget è rendere la pagina veloce.

Le pagine veloci rendono Googlebot più veloce e questo è un segno per Google che il server web è "sano".

Google ha già affermato che la velocità della pagina aumenta la velocità di scansione:

Rendere un sito più veloce migliora l'esperienza degli utenti e allo stesso tempo aumenta la velocità di scansione.

- Peso della pagina : questa metrica è la dimensione complessiva della tua pagina. Ciò include tutti i CSS e le immagini Javascript nella pagina. Questo dovrebbe essere inferiore a 1 MB in totale.

- Immagini ottimizzate : le immagini dovrebbero essere il più piccole possibile in KB senza perdere la qualità. L'uso di uno strumento come Squoosh può aiutare in questo.

- CSS e JS minimizzati – Riduci al minimo i tuoi file JS e CSS. Questo è il processo di rimozione di tutti i caratteri non necessari dal file. Usa CSSNano e UglifyJS per minimizzare i file.

- Compressione e memorizzazione nella cache : assicurati che la compressione GZip o BR sul server. Ciò accelererà il tempo necessario per ottenere un file. Aggiungi la memorizzazione nella cache in modo che il file venga scaricato solo una volta.

Per un elenco dei miglioramenti della velocità della pagina, dai un'occhiata a questa revisione approfondita delle prestazioni del sito Web. Ha 30 passaggi per migliorare le prestazioni del sito web.

Metodi per misurare le modifiche

Come SEO intelligente, prima di iniziare qualsiasi ottimizzazione devi tenere traccia dei cambiamenti.

È necessario selezionare un punto dati con due proprietà:

- Devi essere in grado di tracciare il punto dati nel tempo.

- Devi essere in grado di influenzare quei dati con le tue azioni.

Quindi qual è il punto dati che dovremmo monitorare per il crawl budget?

Abbiamo detto in precedenza che Google utilizza due fattori quando decide un crawl budget:

- Velocità di scansione: la velocità con cui Googlebot può eseguire la scansione del tuo sito senza interrompere i tuoi server

- Domanda di scansione : quanto è importante la tua pagina web per gli utenti di Google

Dal momento che siamo SEO tecnici, il nostro lavoro è migliorare la velocità di scansione.

Quindi questo è il punto dati che dovremmo tracciare.

Monitoraggio della velocità di scansione

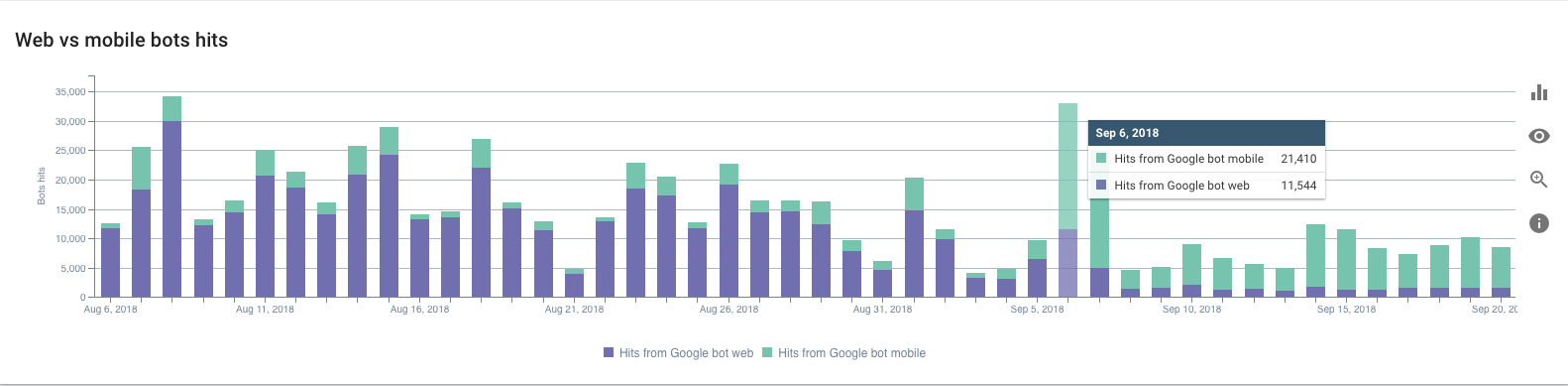

Quindi, come monitoriamo la velocità di scansione di Googlebot?

Abbiamo bisogno di usare i log di accesso al tuo server web.

I log memorizzano ogni richiesta fatta al tuo server web. Ogni volta che un utente o Googlebot visita il tuo sito, una voce di registro viene aggiunta al file di registro degli accessi.

Ecco come sarebbe una voce per Googlebot:

127.0.0.1 - - [11/Nov/2019:08:29:01 +0100] "GET /example HTTP/1.1" 200 2326 "-" "Mozilla/5.0 (compatibile; Googlebot/2.1; +http://www .google.com/bot.html)"

Ci sono tre punti dati importanti in ogni registro. L'appuntamento:

[11/Nov/2019:08:29:01 +0100]

L'URL:

"OTTIENI /esempio HTTP/1.1"

E lo user-agent che ci dice che è Googlebot a fare la richiesta:

"Mozilla/5.0 (compatibile; Googlebot/2.1; +http://www.google.com/bot.html)"

Il registro sopra proviene da un server web Nginx. Tuttavia, tutti i server Web come Apache o IIS avranno una voce del registro di accesso simile.

A seconda della configurazione, potresti disporre di una rete di distribuzione dei contenuti (CDN). Un CDN come Cloudflare o Fastly creerà anche registri di accesso.

L'analisi manuale di un registro di accesso non è dei più divertenti sebbene sia possibile.

È possibile scaricare access.log e analizzarlo utilizzando Excel. Tuttavia, ti consiglierei di utilizzare un analizzatore di log come quello di OnCrawl.

Ciò ti consentirà di visualizzare la velocità di scansione di Googlebot su un grafico e in tempo reale. Una volta che hai questa configurazione di monitoraggio per monitorare la velocità di scansione, puoi iniziare a migliorarla.

Apportare modifiche

Ora sappiamo cosa stiamo monitorando, possiamo guardare per apportare alcuni miglioramenti. Ma non apportare molte modifiche contemporaneamente. Sii metodico e apporta le modifiche una per una.

Costruisci, misura, impara.

Usando questa tecnica puoi adattare i cambiamenti che stai facendo mentre impari. Concentrarsi sulle attività che stanno migliorando la velocità di scansione.

Se ti affretti e cambi troppo in una volta può difficile capire i risultati.

Rendendo difficile dire cosa ha funzionato e cosa non ha funzionato.

Con il passare del tempo, man mano che la pagina migliora, vedrai un aumento del budget di scansione all'aumentare della velocità di scansione.

Conclusione, scansione del monitoraggio del budget prima e dopo un aggiornamento

Abbiamo spiegato esattamente cos'è un Crawl Budget.

In qualità di SEO tecnico, hai il potere di aumentare la velocità di scansione del sito.

Migliorando la salute tecnica puoi rendere efficiente il tempo di Googlebot sul tuo sito.

Tieni traccia della velocità di scansione utilizzando i tuoi log per risultati accurati.

Usa Costruisci, Misura, Impara come tecnica per apportare una modifica alla volta e migliorare man mano che procedi.

Nel tempo la tua velocità di scansione aumenterà. Le tue pagine appariranno più velocemente nei risultati di ricerca di Google. E gli utenti avranno un'ottima esperienza sul tuo sito.